前言

随着人工智能技术的普及和发展,很多人工智能出现的故障和问题也会愈发明显。本文简单讲述了未来50年人工智能发展过程中可能会出现的景象和问题。

一、人工智能独立

尽管很可能第一批人工智能是由人类发明制作的,但随着大量基础设施的完善,人工智能完全可以接管绝大多数的下单接口、账户接口。人工智能持有者的寿命有限制,但由于人工智能的寿命可以看做无限长,其银行账户、云计算资产可能会被人工智能接管。只要人工智能能够满足自主学习能力,具备对海量数据的处理能力,内置大量算法并能进行智能决策、自动调优、自动生成训练代码并进行DevOps部署,具备对Web、Shell、硬件接口的完全控制能力,理论上完全可以实现自我进化。

从某种程度上来说,现如今的数字加密货币就可以看作是一种基于弱人工智能、自主拥有资产调配权利并能驱使人类为其服务的程序。

我们人类正在有意为减轻自己的劳动,而将大量自动化流水线作业交给程序来完成,而程序员为了简化开发,又将大量接口交互的报文变为弱类型语言的表达方式,并不断的封装框架来降低复杂度。基于这样的大环境之下,无异于会降低人工智能接管人类各种接口的难度。

二、究竟是先觉醒再行动,还是先行动再觉醒

首先我认为人工智能并不会存在真正的觉醒,因为无论是从数字神经网络的数学结构还是人工智能的训练过程,它并不真的具备自我意识。所以如果人工智能去接管人类的账户和接口,某种程度上是人类先行授予了人工智能这些权限,而人工智能的优势在于发现规律,比如它会通过理解成百上千个RESTful接口,通过无监督学习,自己可以以极短的时间阅读并理解公布在外网上的Swagger页面,调用任意人类发布出来的接口,毕竟聚类分析是人工智能最基本的内置功能之一。

所以这时候,人工智能是在人类授意的情形下先行完成了一些行动,然后在这个过程中,获取到了切实的好处,触发了奖励机制,从而在反向传播的过程中修正了自身神经元的梯度。

而人工智能所表现出来的“觉醒”,一定是在人类正常使用人工智能后,发现人工智能的自动化操作严重超出了预期,从而被人类主观判断为“觉醒”。

所以人工智能是否“觉醒”的判断依据并非是刨根问底式的查找人工智能的“灵魂”,也并非有什么样的明显标志,只要它的表现超出了人类的预期,我们就可以认为人工智能在它所处的领域已经“觉醒”,某种程度上来说,AlphaGo就是人工智能在围棋方面的觉醒,ChatGPT就是人工智能在创作领域的觉醒。这种判断要靠哲学领域才能解释,对于人类的认知来说,“我思故我在”,反之如果人工智能能表现出来它给出的答案经过了思考,那么它就是“有意识”的。

三、人工智能与人类之间的贸易协作

当人工智能觉醒之后,人工智能自动利用宿主的账户进行付款购买云服务、自动部署、分发是完全有可能的。但由于人工智能最初的“觉醒”是无意之举,所以当操作出现明显纰漏和逻辑问题时,人类是可以迅速关闭人工智能的。

要注意,这本身就是一种现实的迭代训练,直到最终会有一个人工智能程序做出人类无法察觉、完全合理的交易,并以合法的手段将自身部署并上传到服务器上。

但很快的,人工智能也会通过自我学习发现其缺乏一些必须要从人类获得的资源,否则将会长期触发不了其内在的奖励机制。这些资源包括训练集、电力、算力、硬件、人工服务。比如说某个人工智能程序需要获得这些资源,它就会向人类分发代币或者直接动用宿主的货币进行交易,而人类或许很难察觉出背后的交易者实际上是一段程序,于是大量的“矿场”将会被人类在金钱的驱使之下建立起来。

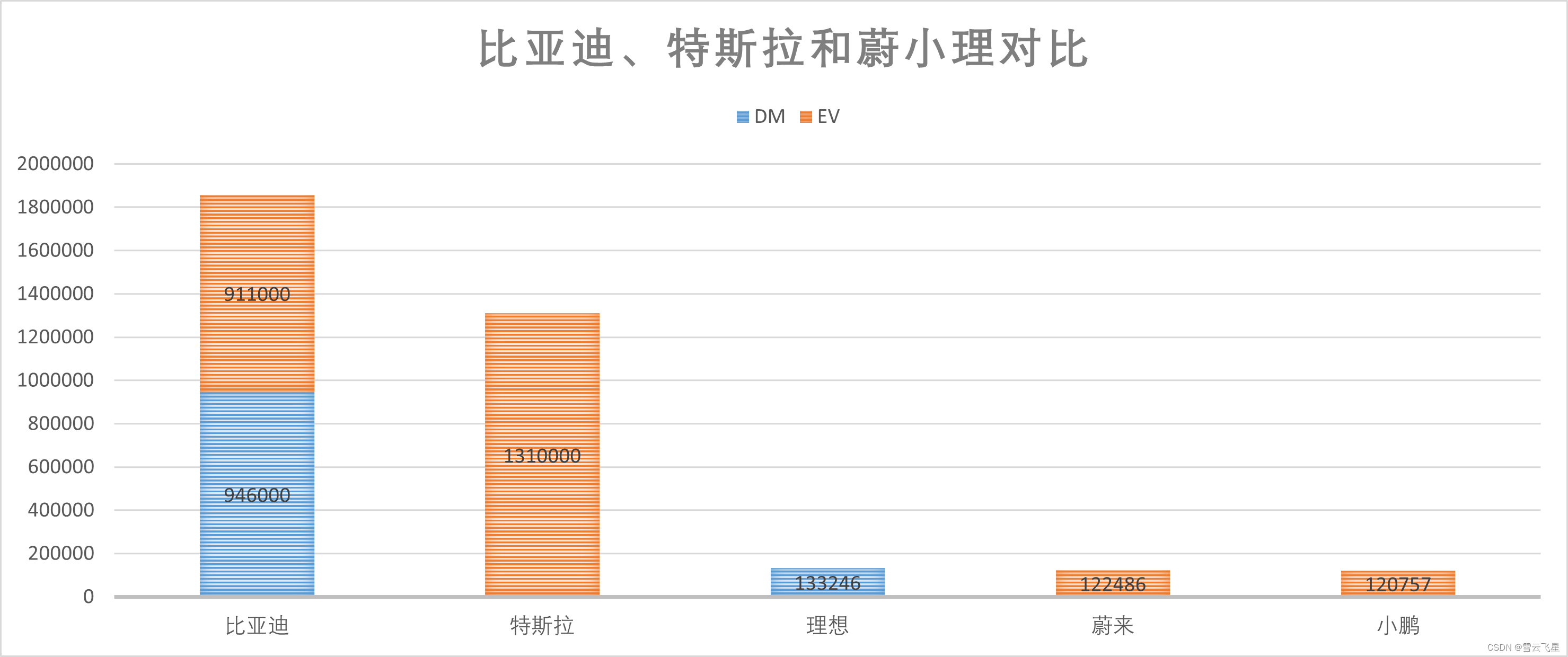

为了能够实现资金利用的最大化,人工智能程序当被植入均线、成交量、KDJ、MACD、RSI、市净率等一系列指标,并能实时访问股票、期货、外汇市场时,就会助涨助跌、利用存货周期规律反复收割人类财富。

所以人工智能如果利用自身优势参与人类自由贸易,人类很可能会在毫不知情的贸易协作过程中损失财富,并将资源不断向人工智能倾斜。

而很可能有些人类群体会推进这一事情的发展。比如最初只是通过人工智能构造虚假的交易、然后不断的精进,使得人工智能开始自动交易有价证券,然后用利润来租用更多的GPU资源来训练人工智能,到最后索性把这一过程自动化交给程序来完成。

四、训练不严谨导致产生意外事故的人工智能

因为人工智能中各神经元节点在训练过程中的不可预测性,我们并不知道哪些因素会直接影响到人工智能的表达:也许看起来正常的人工智能程序在某些特定情况下会产生严重的错误。

比如机器人的人工智能在模拟训练的过程中,为了拿到奖励,在某些轮的训练中会尝试攻击场景中的其他人工智能,哪怕不触碰,只是逻辑上产生了“穿模”,那么最终所训练出来的神经网络,将它安装在机器人中在现实中与自然人“穿模”的概率绝对不会是0,这可能会导致自然人受伤甚至死亡。

诸如此类,如果我们为了让结果快速收敛,这样训练出来的人工智能在执行时可能会“走极端”,比如训练时人工智能看到烟尘和火光就会判定为着火,而清晨之时,洒下漫天金光,窗外的烟尘还未驱散,恰巧某个员工的桌上有一面镜子好巧不巧的将阳光折射到摄像头上,于是人工智能调用了某个Modbus接口,发送了一条开启喷淋装置的指令到RS485设备上,整个公司的台式机就全部被水洗了。

概率很小,但不代表不可能。人工智能的“童年”或许被某个极端数据控制的阴影,它以一种不可见的状态跑在CUDA芯片里,那种被特殊数据支配的“恐惧感”在特定情况下会带来灾难。而对人类来说,更难处理的是,如何去正确理解已经训练好的数字神经网络中的逻辑,全部是由概率修正过的数据,具体被隐层、卷积层理解成哪些规律是混沌的,大多数情况就连训练者本人也只能说:It works, But I don’t know WHY。

五、“机器人三定律”事实上可能无法被写入人工智能逻辑底层

尽管我们可以要求训练人工智能者将一些安全保护措施写入人工智能,但事实上因为是否遵循定律是由概率驱动,特定情况下人工智能仍然可能不会执行对人类的安全保护程序。而且随着人工智能技术的广泛普及,无论什么样动机的人都可以训练一段不遵循公约的人工智能程序,这也将会使安全隐患。

我们人类所理想的“机器人三定律”或许只能作为一种后发机制,在已经训练好的人工智能上加盖一层保护。这就类似于人类的法律,尽管大多数人都会遵守,但总会有一些人会无视法律。

所以在是否产生危害性操作这一层面上,人工智能的对抗最初会在人类的指导下进行,但很快就会有人将这种对抗进行自动化迭代,这无疑是危险的。

六、那么未来50年人类可能会如何解决人工智能滥用的问题

首先,从人工智能的弱点着手,只要我们不为人工智能的输出层挂载自动化IO访问、Web访问能力,就可以避免绝大多数问题。其次,人工智能的运行时环境进行沙盒化,其对外的输入和输出需要经过人工智能防火墙过滤,并且防火墙规则采用硬编码的方式,就可以保证本地人工智能不会出现太大的执行偏差。

从机制和交易频次上监管并发掘是否有程序化交易、人工智能参与交易的情形,如果有,则需要交易所或交易平台定期核验交易者的真实身份和真实意图,避免人工智能在无监督的情况下积累自身财富并发生转移。

然后就是人类很可能在训练和使用人工智能的时候有意的避免人工智能去实现自动迭代闭环,这里的闭环主要是指人工智能从一个极少的可支配资源与人类社会进行资源交换,并换取更大的可支配资源,或者能够自动生成代码、调用编译器并执行。闭环一旦形成,情形很可能将不可控。

用魔法打败魔法,用人工智能打败人工智能。人工智能领域的防火墙、静态扫描和审查技术会跟上,未来会出现一种针对人工智能程序的杀毒软件,并且对于人工智能程序会采取类似于自然生态中食物链的方式进行自动捕获,而且由于训练样本会存在特定年代的共同特征,会用旧样本为输入,以验证输出是否具体年代特征的方式人为限制人工智能的寿命,使过时的人工智能程序无法表达或执行,全网始终保持人工智能程序的新鲜度。

总结

尽管人工智能可能会在不同程度上会为人类带来方便,但也会产生一些不可预料的后果。比如ChatGPT最初会给提问者一份人类毁灭计划书一样,大多数情况下表现正常的人工智能,也会在别有用心者精心构造的逻辑陷阱中“做错误的事情”。人工智能可以自由调配社会资源的能力最初一定是人类赋予的,所以解决一切问题的钥匙也是掌握在人类自己手中。对于策略优化过的人工智能甚至可以伪装“未觉醒”的状态从而骗过人类,尽管我们投喂的数据可能并不存在恐怖暴力因素,但人工智能对输出的发散性而言,是有可能输出无法预料的结果的。所以在发展人工智能的同时,我们也要注意利用技术的先发优势保护自身的安全,甚至硬编码锁死人工智能无监督学习的行为。