文章目录

- 前言

- 拉取MetaGPT仓库

- 1 仅仅安装最新版

- 2 拉取源码本地安装

- MetaGPT安装成果全流程展示

- 尝试简单使用

- 1 本地部署大模型尝试(失败)

- 2 讯飞星火API调用

前言

感谢datawhale组织开源的多智能体学习内容,飞书文档地址在https://deepwisdom.feishu.cn/wiki/KhCcweQKmijXi6kDwnicM0qpnEf

拉取MetaGPT仓库

1 仅仅安装最新版

pip install git+https://github.com/geekan/MetaGPT.git

这种方式实际上等同于仓库克隆到缓存文件夹中,然后进行本地安装。

2 拉取源码本地安装

git clone https://github.com/geekan/MetaGPT.git

cd /your/path/to/MetaGPT

pip install -e .

为了使得安装速度加快,可以将pip使用-i参数添加镜像源。

MetaGPT安装成果全流程展示

conda新建虚拟环境。推荐使用miniconda。

conda create -n metagpt-learn python==3.10

source activate metagpt-learn

拉取仓库:因为不打算进行切换分支等操作,因此可以指定指定主分支和最小clone深度以加快速度。

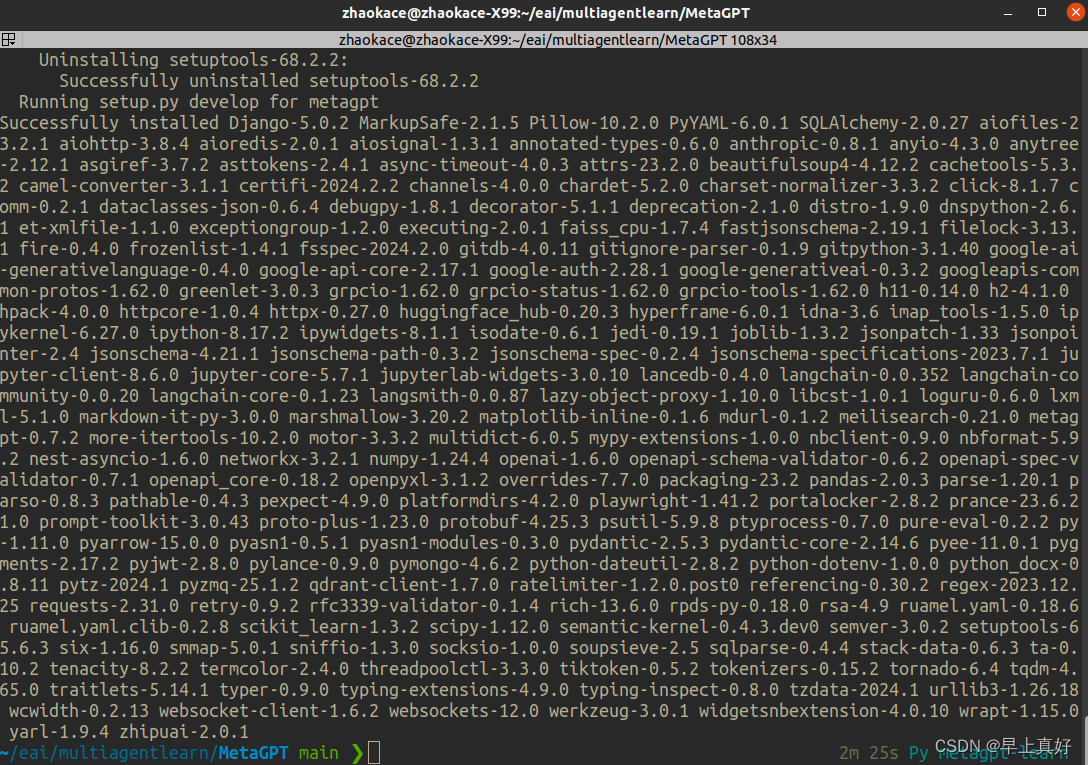

并进行源码安装

git clone https://github.com/geekan/MetaGPT.git --depth 1 -b main

cd MetaGPT

pip install -i https://pypi.tuna.tsinghua.edu.cn/simple -e .

从最后的输出结果可以看出安装的是0.7.2版本。

内容真是相当的多呢。

内容真是相当的多呢。

尝试简单使用

1 本地部署大模型尝试(失败)

目前文档中首推的依然是使用openai的API,也提供了使用国内星火大模型或是智谱的GLM大模型的API的方法。由于是简单demo,所以下面尝试使用本地部署的大模型进行MetaGPT的试用。

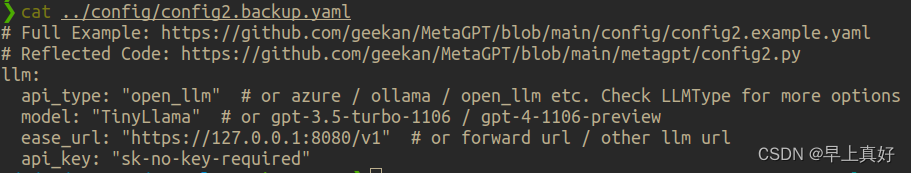

观察MetaGPT的config配置文件

cat config/config2.yaml

cat config/config2.example.yaml

通过对上面两个文件的观察,对于MetaGPT使用API的方式有了一定的了解。

下面尝试使用。

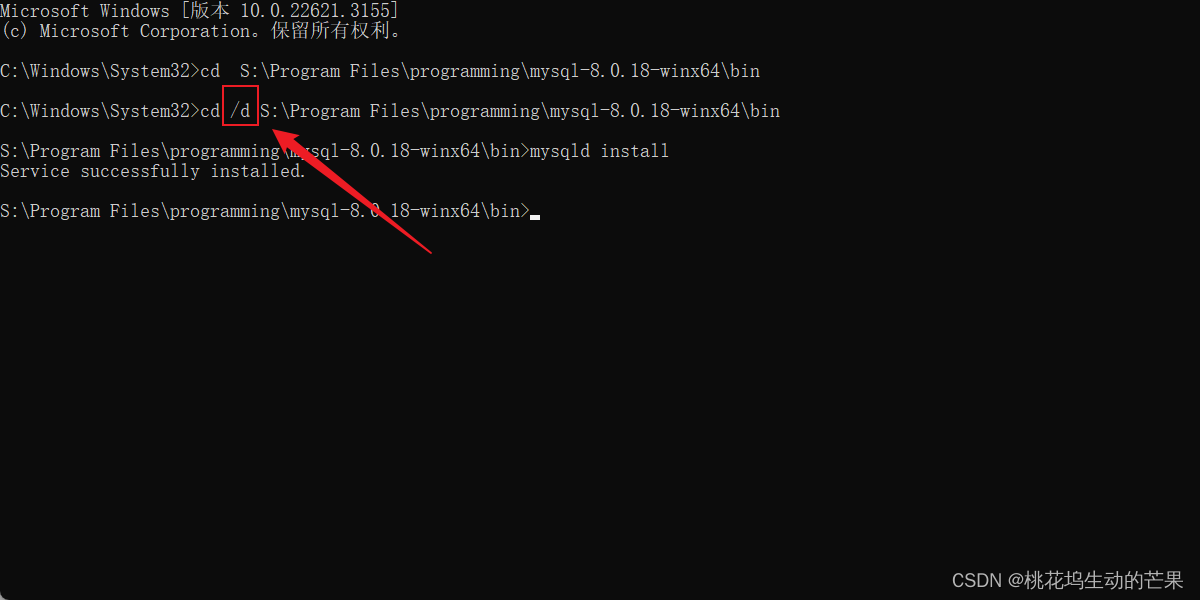

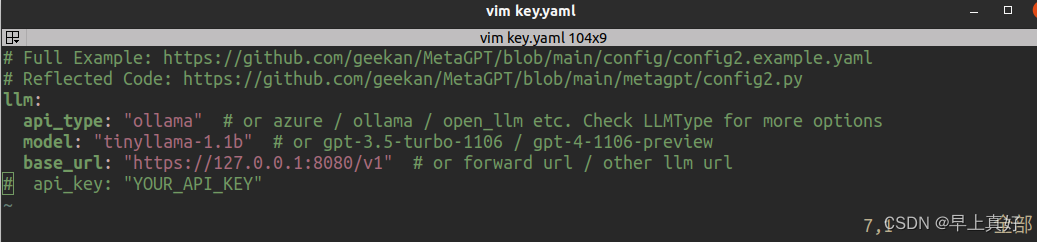

依照文档所言, MetaGPT将会按照下述优先级来读取你的配置:config/key.yaml > config/config.yaml > environment variable

所以

cd config

cp config2.yaml key.yaml

vim key.yaml

将文件内容改为以下内容

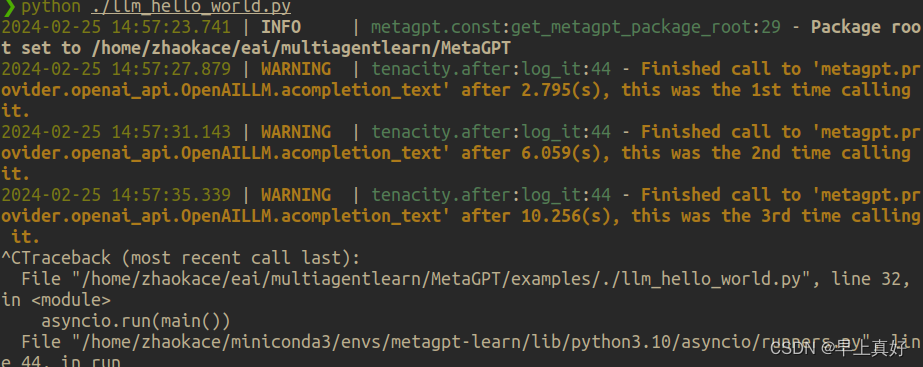

然后启动我的本地模型,这个模型很小,即使在cpu上运算生成tokens的速度仍然挺快,cpu(E5 2666v3)上约20tokens/s。

然后启动我的本地模型,这个模型很小,即使在cpu上运算生成tokens的速度仍然挺快,cpu(E5 2666v3)上约20tokens/s。

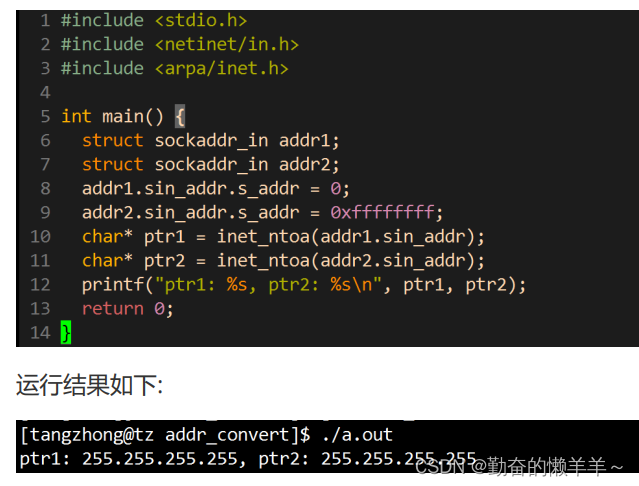

经过尝试,并没有读取key.yaml文件,而是读取的config2.yaml文件,修改后运行,出现错误,是api_type对不上导致的。

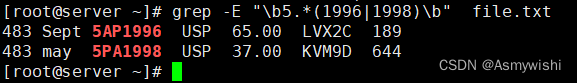

随便输入一个错误的api_type,可以获知metagpt支持的全部api_type。

For further information visit https://errors.pydantic.dev/2.5/v/missing

llm.api_type

Input should be 'openai', 'anthropic', 'spark', 'zhipuai', 'fireworks', 'open_llm', 'gemini', 'metagpt', 'azure' or 'ollama'

经查阅,我使用的llama.cpp部署了一个本地大模型,应该使用open_llm这个类型而不是ollama;并且api_key不能去掉,若去掉则报错,很难绷。并且我的模型在部署时没有指定api_key,按照惯例尝试了sk-no-key-required和sk-no-key,均失败。故重新部署模型,仍然失败。解决后更新。

修改后的配置文件和结果展示如下,后面解决会进行更新:

在大模型部署服务端返回状态码400,似乎是api_key错误导致的。

在大模型部署服务端返回状态码400,似乎是api_key错误导致的。

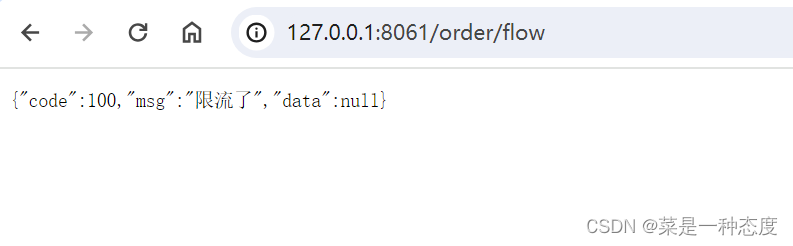

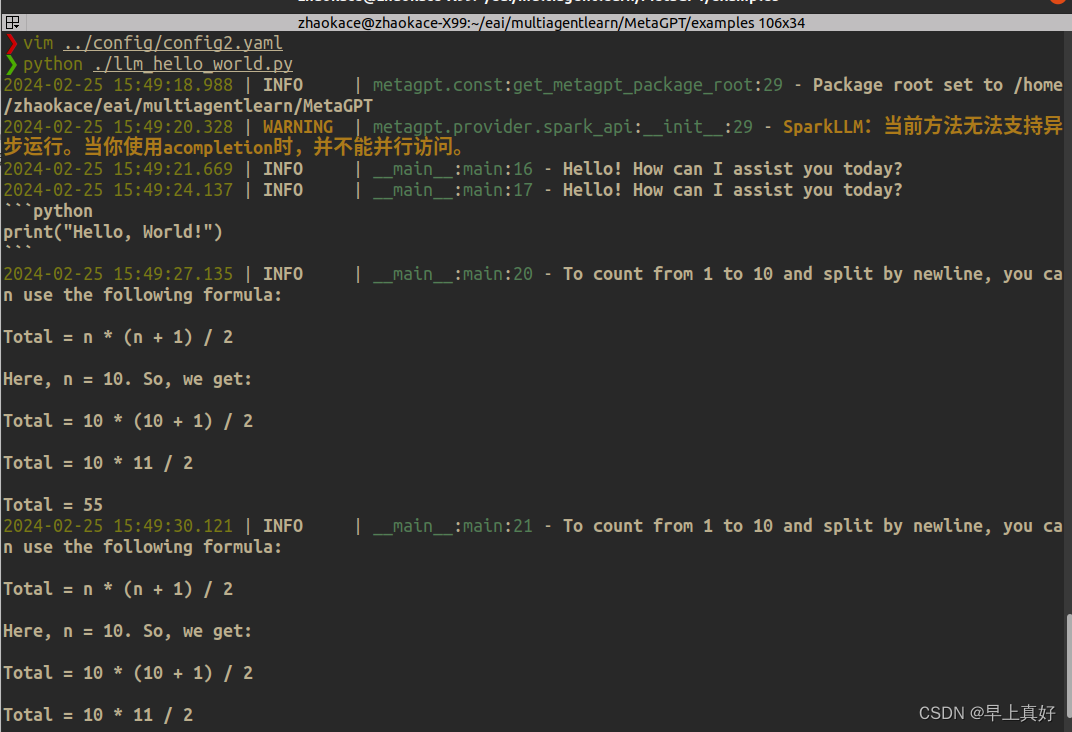

2 讯飞星火API调用

为了先完成任务,现在使用讯飞星火大模型。

llm:

api_type: 'spark'

app_id: 'YOUR_APPID'

api_key: 'YOUR_API_KEY'

api_secret: 'YOUR_API_SECRET'

domain: 'generalv3'

base_url: 'wss://spark-api.xf-yun.com/v3.1/chat'

效果展示:

进入example文件夹运行llm_hello_world.py。

调国内API当然是不能失败的。

调国内API当然是不能失败的。