网络结构

第一层有13个神经元,第二层8个神经元,第三层是输出层;其中第一层的激活函数是relu,第二层是sigmoid

代码实现

# 导入库

import torch

import torch.nn as nn

from torch.nn import functional as F# 确定数据

torch.random.manual_seed(420)

X = torch.rand((500,20),dtype=torch.float32)

y = torch.randint(low=0,high=3,size=(500,1),dtype=torch.float32)# 第一层有13个神经元,第二层8个神经元,第三层是输出层;其中第一层的激活函数是relu,第二层是sigmoid

class Model(nn.Module):

def __init__(self,in_features=10,out_features=2):

"""

in_features: 输入该神经网络的特征数(输入层上的神经元的数目)

out_featrues: 神经网络输出的数目(输出层上的神经元的数目)

"""

super(Model,self).__init__()

self.linear1 = nn.Linear(in_features,13,bias=True)

self.linear2 = nn.Linear(13,8,bias=True)

self.output = nn.Linear(8,out_features,bias=True)

# 神经网络的向前传播

def forward(self,x):

z1 = self.linear1(x)

sigma1 = torch.relu(z1)

z2 = self.linear2(sigma1)

sigma2 = torch.sigmoid(z2)

z3 = self.output(sigma2)

sigma3 = F.softmax(z3,dim=1)

return sigma3input_ = X.shape[1]

output_ = len(y.unique())

# 实例化神经网络

torch.random.manual_seed(420)

net = Model(in_features=input_, out_features=output_)进行一次向前传播

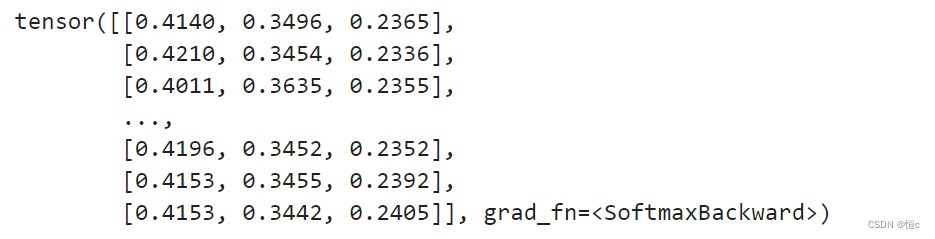

net.forward(X)查看运行结果: