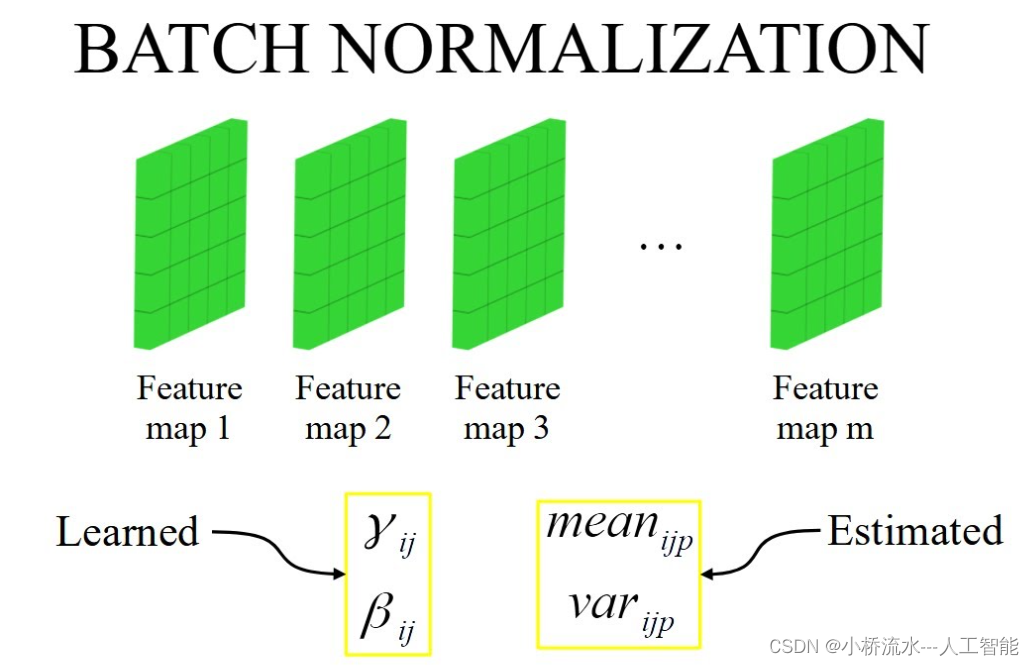

批归一化(Batch Normalization,简称BN)层在卷积神经网络中的作用主要有以下几点:

- 规范化数据:批归一化可以对每一批数据进行归一化处理,使其均值接近0,方差接近1。这有助于解决内部协变量偏移(Internal Covariate Shift)问题,即网络训练过程中,由于每层的参数更新,导致后续层的输入分布发生变化。

- 加速训练:通过规范化数据,批归一化可以使得网络更容易训练,因为网络不再需要不断适应输入数据分布的变化。这通常会导致更快的收敛速度和更少的训练时间。

- 允许使用更高的学习率:由于批归一化减少了内部协变量偏移,网络可以更加稳定地训练,因此可以使用更高的学习率。这有助于加速训练过程。

- 起到一定的正则化效果:批归一化在训练过程中引入了一定的噪声,这有助于防止模型过拟合。这种效果类似于Dropout等正则化技术。

- 减少了对初始权重的敏感性:由于批归一化能够规范化数据,使得网络对初始权重的选择不那么敏感。这有助于提高模型的鲁棒性。

需要注意的是,尽管批归一化在许多情况下都很有用,但它并不总是必需的。在某些情况下,不使用批归一化也可以获得很好的性能。此外,批归一化也增加了计算量和内存消耗,因此在设计网络时需要权衡这些因素。