每周跟踪AI热点新闻动向和震撼发展 想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领域的领跑者。点击订阅,与未来同行! 订阅:https://rengongzhineng.io/

在自然语言处理(NLP)这个飞速发展的领域里,大型语言模型(LLM)的出现无疑是一场革命。这些模型在各种任务上展现出了惊人的能力,不需要特定的训练就能理解和生成接近人类的文本。然而,这些模型要在现实世界中部署,往往会因为对计算资源的巨大需求而受阻。这一挑战促使研究人员开始探索更小、更紧凑的LLM在任务上的效能,比如在会议总结这种对性能和资源利用平衡尤为重要的任务上。

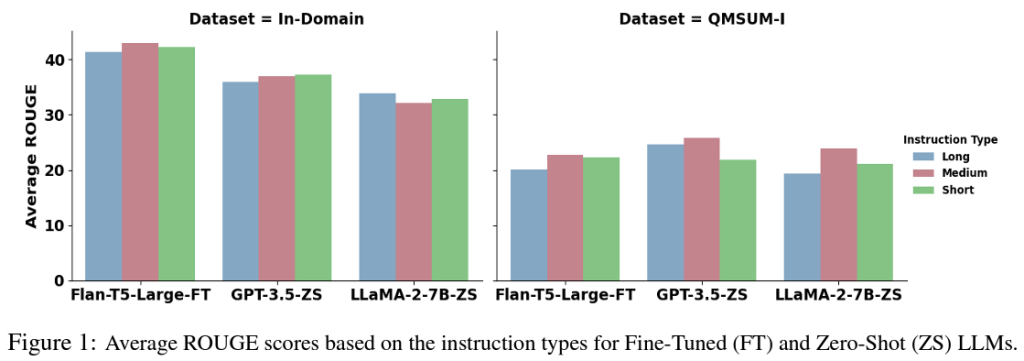

传统上,文本总结,尤其是会议记录的总结,依赖于需要大量标注数据集和巨大计算力进行训练的模型。虽然这些模型取得了令人印象深刻的成果,但由于操作成本高昂,它们的实际应用受到了限制。有鉴于此,最近的一项研究探讨了更小的LLM是否能成为大型模型的可行替代品。这项研究聚焦于会议总结的工业应用,比较了经过微调的紧凑型LLM(如FLAN-T5、TinyLLaMA和LiteLLaMA)与零次训练的大型LLM的性能。

研究方法严谨,使用了一系列紧凑型和大型LLM进行了广泛评估。紧凑型模型在特定数据集上进行了微调,而大型模型则以零次训练的方式进行了测试,意味着它们没有针对手头的任务进行特定训练。这种方法允许直接比较模型准确和高效总结会议内容的能力。

令人注目的是,研究结果表明,特定的紧凑型LLM(尤其是FLAN-T5)在会议总结方面的性能可以匹配甚至超过大型LLM。FLAN-T5拥有780M的参数,展现出的结果与参数范围从7B到超过70B的大型LLM相当甚至更优。这一发现表明,紧凑型LLM有潜力提供一个成本效益高的NLP应用解决方案,实现性能与计算需求之间的最佳平衡。

性能评估突出了FLAN-T5在会议总结任务中的卓越能力。例如,FLAN-T5的性能与许多大型零次训练LLM相当,甚至更好,凸显了其效率和有效性。这一结果突显了紧凑型模型在现实世界设置中部署NLP解决方案的潜力,特别是在计算资源有限的情况下。

总之,对于会议总结任务而言,探索紧凑型LLM的可行性揭示了充满希望的前景。像FLAN-T5这样的模型表现出色,表明小型LLM能够发挥出色的性能,提供一个与大型模型相比的可行选择。这一突破对于NLP技术的部署具有重大意义,标志着一个效率与性能并行前进的新方向。随着该领域的持续发展,紧凑型LLM在桥接前沿研究与实际应用之间的差距无疑将成为未来研究的焦点。

![[WinForm开源]概率计算器 - Genshin Impact(V1.0)](https://img-blog.csdnimg.cn/direct/4507c230df3e452a8e8029e22a08ef8a.png)