一、理论

文章看了以下博文:Sift中尺度空间、高斯金字塔、差分金字塔(DOG金字塔)、图像金字塔-CSDN博客

该文章对SIFT写的很详细,所以在这里我直接抄过来作为笔记。如果以后作者变为付费文章可以提醒我删除。

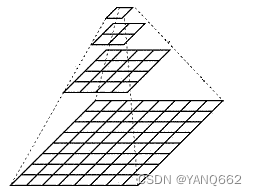

1.图像金字塔

图像金字塔是一种以多分辨率来解释图像的结构,通过对原始图像进行多尺度像素采样的方式,生成N个不同分辨率的图像。把具有最高级别分辨率的图像放在底部,以金字塔形状排列,往上是一系列像素(尺寸)逐渐降低的图像,一直到金字塔的顶部只包含一个像素点的图像,这就构成了传统意义上的图像金字塔。

获得图像金字塔一般包括二个步骤:

1. 利用低通滤波器平滑图像

2. 对平滑图像进行抽样(采样)

有两种采样方式——上采样(分辨率逐级升高)和下采样(分辨率逐级降低)

上采样:

下采样:

2.高斯金字塔

高斯金字塔式在Sift算子中提出来的概念,首先高斯金字塔并不是一个金字塔,而是有很多组(Octave)金字塔构成,并且每组金字塔都包含若干层(Interval)。

高斯金字塔构建过程:

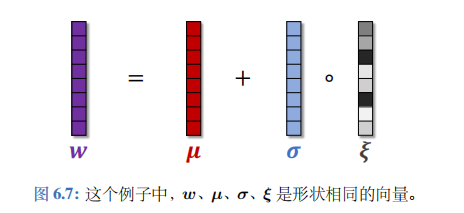

1. 先将原图像扩大一倍之后作为高斯金字塔的第1组第1层,将第1组第1层图像经高斯卷积(其实就是高斯平滑或称高斯滤波)之后作为第1组金字塔的第2层,高斯卷积函数为:

对于参数σ,在Sift算子中取的是固定值1.6。

2. 将σ乘以一个比例系数k,等到一个新的平滑因子σ=k*σ,用它来平滑第1组第2层图像,结果图像作为第3层。

3. 如此这般重复,最后得到L层图像,在同一组中,每一层图像的尺寸都是一样的,只是平滑系数不一样。它们对应的平滑系数分别为:0,σ,kσ,k^2σ,k^3σ……k^(L-2)σ。

4. 将第1组倒数第三层图像作比例因子为2的降采样,得到的图像作为第2组的第1层,然后对第2组的第1层图像做平滑因子为σ的高斯平滑,得到第2组的第2层,就像步骤2中一样,如此得到第2组的L层图像,同组内它们的尺寸是一样的,对应的平滑系数分别为:0,σ,kσ,k^2σ,k^3σ……k^(L-2)σ。但是在尺寸方面第2组是第1组图像的一半。

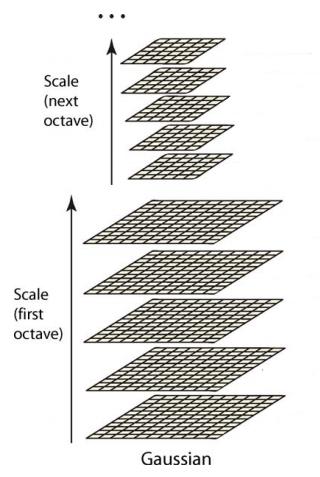

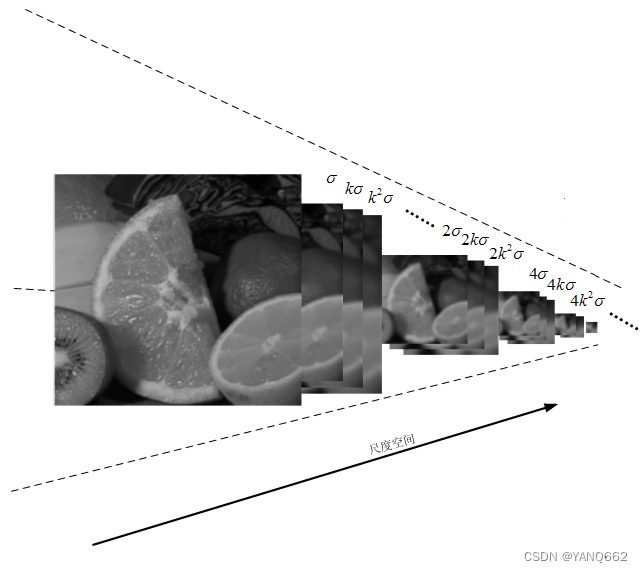

这样反复执行,就可以得到一共O组,每组L层,共计O*L个图像,这些图像一起就构成了高斯金

字塔,结构如下:

在同一组内,不同层图像的尺寸是一样的,后一层图像的高斯平滑因子σ是前一层图像平滑因子的k倍;

在不同组内,后一组第一个图像是前一组倒数第三个图像的二分之一采样,图像大小是前一组的一半;

高斯金字塔图像效果如下,分别是第1组的4层和第2组的4层:

3.尺度空间

图像的尺度空间解决的问题是如何对图像在所有尺度下描述的问题。

在高斯金字塔中一共生成O组L层不同尺度的图像,这两个量合起来(O,L)就构成了高斯金字塔的尺度空间,也就是说以高斯金字塔的组O作为二维坐标系的一个坐标,不同层L作为另一个坐标,则给定的一组坐标(O,L)就可以唯一确定高斯金字塔中的一幅图像。

尺度空间的形象表述:

上图中尺度空间中k前的系数n表示的是第一组图像尺寸是当前组图像尺寸的n倍。

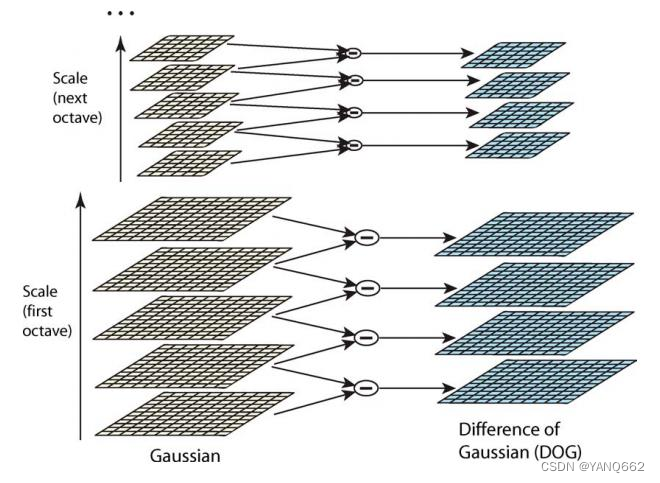

4.DOG金字塔

生成高斯金字塔的目的就是为了构建DOG金字塔。

DOG金字塔的第1组第1层是由高斯金字塔的第1组第2层减第1组第1层得到的。以此类推,逐组逐层生成每一个差分图像,所有差分图像构成差分金字塔。概括为DOG金字塔的第o组第l层图像是有高斯金字塔的第o组第l+1层减第o组第l层得到的。

DOG金字塔的构建可以用下图描术:

每一组在层数上,DOG金字塔比高斯金字塔少一层。后续Sift特征点的提取都是在DOG金字塔上进行的。

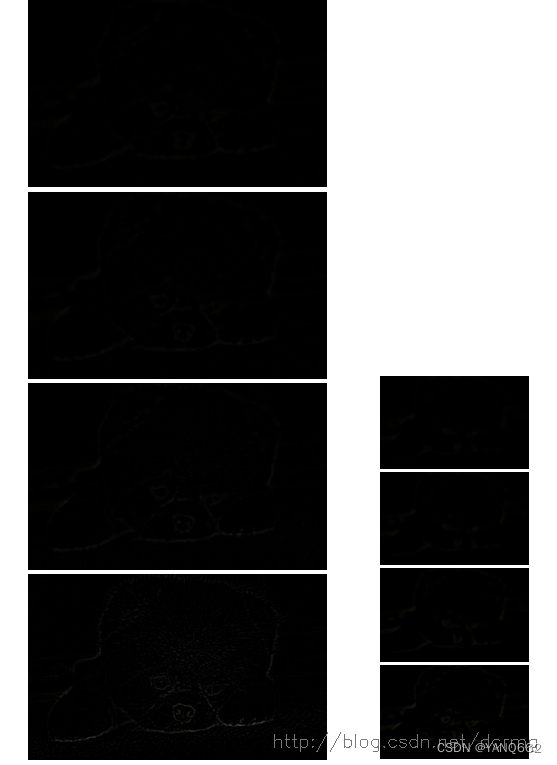

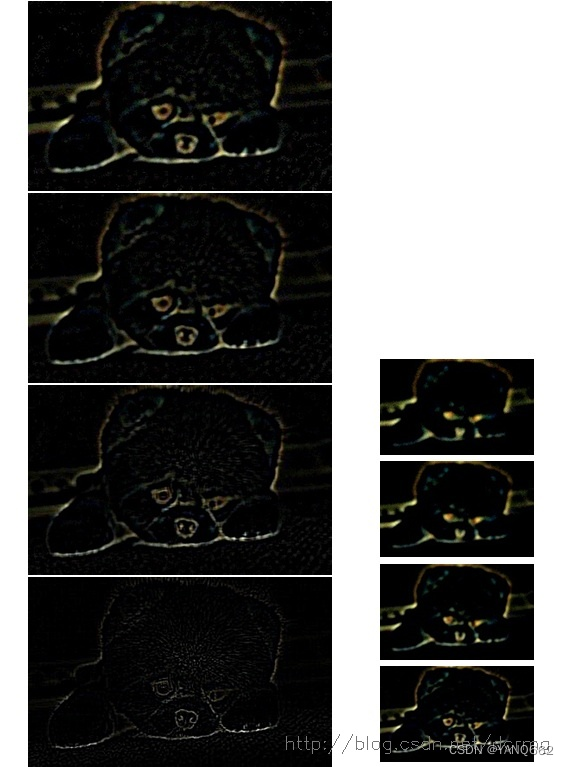

DOG金字塔的显示效果如下:

这些长得黑乎乎的图像就是差分金字塔的实际显示效果,只在第1组第1层差分图像上模糊可以看到一个轮廓。但其实这里边包含了大量特征点信息,只是我们人眼已经分辨不出来了。

下边对这些DOG图像进行归一化,可有很明显的看到差分图像所蕴含的特征,并且有一些特征是在不同模糊程度、不同尺度下都存在的,这些特征正是Sift所要提取的“稳定”特征:

二、算法代码

1.python代码

import cv2

from matplotlib import pyplot as plt

img1 = cv2.imread('box.png',0) # queryImage

img2 = cv2.imread('box_in_scene.png',0) # trainImage

# Initiate SIFT detector

sift = cv2.SIFT()

# find the keypoints and descriptors with SIFT

kp1, des1 = sift.detectAndCompute(img1,None)

kp2, des2 = sift.detectAndCompute(img2,None)

# BFMatcher with default params

bf = cv2.BFMatcher()

matches = bf.knnMatch(des1,des2,k=2)

# Apply ratio test

good = []

for m,n in matches:

if m.distance < 0.75*n.distance:

good.append([m])

# cv2.drawMatchesKnn expects list of lists as matches

img3 = cv2.drawMatchesKnn(img1,kp1,img2,kp2,good,flags=2)

plt.imshow(img3)2.C++代码

#include <opencv2/opencv.hpp>

#include <iostream>

#include <opencv2/xfeatures2d.hpp>

void extracte_sift(cv::Mat input,std::vector<cv::KeyPoint> &keypoint,cv::Mat &descriptor){

cv::Ptr<cv::Feature2D> f2d = cv::xfeatures2d::SIFT::create();

f2d->detect(input,keypoint);

cv::Mat image_with_kp;

f2d->compute(input,keypoint,descriptor);

cv::drawKeypoints(input, keypoint, image_with_kp, cv::Scalar::all(-1),cv::DrawMatchesFlags::DRAW_RICH_KEYPOINTS);

cv::imwrite("sift"+std::to_string(keypoint.size())+".png",image_with_kp);

}

void match_two_image(cv::Mat image1,cv::Mat image2, std::vector<cv::KeyPoint> keypoint1,std::vector<cv::KeyPoint> keypoint2,cv::Mat descriptor1,cv::Mat descriptor2){

cv::FlannBasedMatcher matcher;

std::vector<cv::DMatch> matches, goodmatches;

matcher.match(descriptor1,descriptor2, matches);

cv::Mat good_matches_image;

double max_dist = 0; double min_dist = 1000;

for (int i = 0; i < descriptor1.rows; i++) {

if (matches[i].distance > max_dist) {

max_dist = matches[i].distance;

}

if (matches[i].distance < min_dist) {

min_dist = matches[i].distance;

}

}

for (int i = 0; i < descriptor1.rows; i++) {

if (matches[i].distance < 4 * min_dist) {

goodmatches.push_back(matches[i]);

}

}

cv::drawMatches(image1, keypoint1, image2, keypoint2,

goodmatches, good_matches_image, cv::Scalar::all(-1), cv::Scalar::all(-1),

std::vector<char>(), cv::DrawMatchesFlags::NOT_DRAW_SINGLE_POINTS);

cv::imwrite("good_matches_image.png",good_matches_image);

{

std::vector <cv::KeyPoint> RAN_KP1, RAN_KP2;

std::vector<cv::Point2f> keypoints1, keypoints2;

for (int i = 0; i < goodmatches.size(); i++) {

keypoints1.push_back(keypoint1[goodmatches[i].queryIdx].pt);

keypoints2.push_back(keypoint2[goodmatches[i].trainIdx].pt);

RAN_KP1.push_back(keypoint1[goodmatches[i].queryIdx]);

RAN_KP2.push_back(keypoint2[goodmatches[i].trainIdx]);

}

std::vector<uchar> RansacStatus;

cv::findFundamentalMat(keypoints1, keypoints2, RansacStatus, cv::FM_RANSAC);

std::vector <cv::KeyPoint> ransac_keypoints1, ransac_keypoints2;

std::vector <cv::DMatch> ransac_matches;

int index = 0;

for (size_t i = 0; i < goodmatches.size(); i++)

{

if (RansacStatus[i] != 0)

{

ransac_keypoints1.push_back(RAN_KP1[i]);

ransac_keypoints2.push_back(RAN_KP2[i]);

goodmatches[i].queryIdx = index;

goodmatches[i].trainIdx = index;

ransac_matches.push_back(goodmatches[i]);

index++;

}

}

cv::Mat after_ransac_sift_match;

cv::drawMatches(image1, ransac_keypoints1, image2, ransac_keypoints2,

ransac_matches, after_ransac_sift_match, cv::Scalar::all(-1), cv::Scalar::all(-1),

std::vector<char>(), cv::DrawMatchesFlags::NOT_DRAW_SINGLE_POINTS);

cv::imwrite("after_ransac_sift_match.png",after_ransac_sift_match);

}

}

int main(int argc, char *argv[])

{

cv::Mat image1 = cv::imread(argv[1]);

cv::Mat image2 = cv::imread(argv[2]);

std::vector<cv::KeyPoint> keypoint1,keypoint2;

cv::Mat descriptor1, descriptor2;

extracte_sift(image1,keypoint1,descriptor1);

extracte_sift(image2,keypoint2,descriptor2);

match_two_image(image1,image2,keypoint1,keypoint2,descriptor1,descriptor2);

return 0;

}