AI视野·今日CS.NLP 自然语言处理论文速览

Fri, 12 Jan 2024

Totally 60 papers

👉上期速览✈更多精彩请移步主页

Daily Computation and Language Papers

| Axis Tour: Word Tour Determines the Order of Axes in ICA-transformed Embeddings Authors Hiroaki Yamagiwa, Yusuke Takase, Hidetoshi Shimodaira 词嵌入是自然语言处理中最重要的组成部分之一,但解释高维嵌入仍然是一个具有挑战性的问题。为了解决这个问题,独立成分分析ICA被认为是一种有效的解决方案。 ICA 转换后的词嵌入揭示了可解释的语义轴,但是这些轴的顺序是任意的。在本研究中,我们关注这一属性并提出了一种新方法“Axis Tour”,它可以优化轴的顺序。受到一维词嵌入方法 Word Tour 的启发,我们的目标是通过最大化轴的语义连续性来提高词嵌入空间的清晰度。 |

| Transformers are Multi-State RNNs Authors Matanel Oren, Michael Hassid, Yossi Adi, Roy Schwartz 与上一代最先进的 NLP 模型循环神经网络 RNN 相比,Transformer 在概念上被认为是不同的。在这项工作中,我们证明了仅解码器的 Transformer 实际上可以被概念化为无限多状态 RNN,即具有无限隐藏状态大小的 RNN 变体。我们进一步表明,通过固定隐藏状态的大小,预训练的 Transformer 可以转换为 textit 有限多状态 RNN。我们观察到一些现有的转换器缓存压缩技术可以被构建为这样的转换策略,并引入一种新的策略 TOVA,它比这些策略更简单。我们对多个远程任务进行的实验表明,TOVA 优于所有其他基线策略,同时几乎与完整的无限模型相当,并且在某些情况下仅使用原始缓存大小的 frac 1 8 。我们的结果表明,变压器解码器 LLM 在实践中通常表现为 RNN。他们还提出了缓解最痛苦的计算瓶颈之一(即缓存大小)的选项。 |

| Patchscope: A Unifying Framework for Inspecting Hidden Representations of Language Models Authors Asma Ghandeharioun, Avi Caciularu, Adam Pearce, Lucas Dixon, Mor Geva 检查大型语言模型隐藏表示中编码的信息 LLM 可以解释模型行为并验证其与人类价值观的一致性。鉴于法学硕士生成人类可理解文本的能力,我们建议利用模型本身来解释其自然语言的内部表示。我们介绍了一个名为 Patchscopes 的框架,并展示了如何使用它来回答有关法学硕士计算的广泛研究问题。我们表明,基于将表示投影到词汇空间并干预 LLM 计算的先前可解释性方法可以被视为该框架的特殊实例。此外,它们的一些缺点,例如无法检查早期层或缺乏表现力,可以通过 Patchscope 来缓解。 |

| Autocompletion of Chief Complaints in the Electronic Health Records using Large Language Models Authors K M Sajjadul Islam, Ayesha Siddika Nipu, Praveen Madiraju, Priya Deshpande 主诉 CC 是患者医疗记录的重要组成部分,因为它描述了寻求医疗护理的主要原因或担忧。它为医疗保健提供者提供关键信息,以做出有关患者护理的明智决策。然而,对于医疗保健提供者来说,记录 CC 可能非常耗时,尤其是在繁忙的急诊科。为了解决这个问题,自动完成工具可以为临床记录提供准确且格式良好的短语或句子,这对于分诊护士来说可能是宝贵的资源。在本研究中,我们利用文本生成技术来开发使用 CC 数据的机器学习模型。在我们提出的工作中,我们训练了一个长短期记忆 LSTM 模型,并对生物医学生成预训练 Transformers BioGPT 的三种不同变体进行了微调,即 microsoft biogpt、microsoft BioGPT Large 和 microsoft BioGPT Large PubMedQA。此外,我们利用 GPT 4 的 OpenAI API,通过合并示例 CC 句子来调整提示。我们根据困惑度得分、修改后的 BERTScore 和余弦相似度得分来评估模型性能。结果表明,与其他模型相比,BioGPT Large 表现出优越的性能。在生成 CC 时,它始终实现了 1.65 的非常低的困惑度分数,而基线 LSTM 模型实现了 170 的最佳困惑度分数。此外,我们评估和评估了所提出的模型性能和 GPT 4.0 的结果。 |

| Improving Large Language Models via Fine-grained Reinforcement Learning with Minimum Editing Constraint Authors Zhipeng Chen, Kun Zhou, Wayne Xin Zhao, Junchen Wan, Fuzheng Zhang, Di Zhang, Ji Rong Wen 强化学习 RL 已广泛用于训练大型语言模型 LLM,以防止意外输出,例如减少危害和错误。然而,现有的强化学习方法大多采用实例级奖励,无法为复杂的推理任务提供细粒度的监督,也无法关注导致错误的少数关键标记。为了解决这个问题,我们提出了一种名为 textbf RLMEC 的新 RL 方法,该方法采用生成模型作为奖励模型,该模型在最小编辑约束下通过错误解决方案重写任务进行训练,并且可以为 RL 训练产生令牌级别的奖励。基于生成奖励模型,我们设计了用于训练的代币级 RL 目标,以及用于稳定 RL 过程的基于模仿的正则化。这两个目标都集中在学习错误解决方案的关键标记,减少其他不重要标记的影响。数学任务和问答任务的实验结果证明了我们方法的有效性。 |

| DeepSeekMoE: Towards Ultimate Expert Specialization in Mixture-of-Experts Language Models Authors Damai Dai, Chengqi Deng, Chenggang Zhao, R.X. Xu, Huazuo Gao, Deli Chen, Jiashi Li, Wangding Zeng, Xingkai Yu, Y. Wu, Zhenda Xie, Y.K. Li, Panpan Huang, Fuli Luo, Chong Ruan, Zhifang Sui, Wenfeng Liang 在大型语言模型时代,Mixture of Experts MoE 是一种很有前途的架构,用于在扩展模型参数时管理计算成本。然而,像 GShard 这样的传统 MoE 架构会激活 N 个专家中的前 K 个,但在确保专家专业化方面面临着挑战,即每个专家都获得不重叠且有针对性的知识。作为回应,我们提出了 DeepSeekMoE 架构,以实现最终的专家专业化。它涉及两个主要策略 1 将专家精细分割为 mN 个专家并从中激活 mK,从而允许更灵活地组合激活的专家 2 将 K 个专家隔离为共享专家,旨在捕获共同知识并减少路由专家中的冗余。从具有 2B 参数的适度规模开始,我们证明 DeepSeekMoE 2B 实现了与 GShard 2.9B 相当的性能,后者的参数和计算量是专家参数和计算的 1.5 倍。此外,DeepSeekMoE 2B 在总参数数量相同的情况下几乎接近其密集对应模型的性能,这设定了 MoE 模型的上限。随后,我们将 DeepSeekMoE 扩展到 16B 参数,并表明它只需要大约 40 次计算即可达到与 LLaMA2 7B 相当的性能。 |

| Investigating Data Contamination for Pre-training Language Models Authors Minhao Jiang, Ken Ziyu Liu, Ming Zhong, Rylan Schaeffer, Siru Ouyang, Jiawei Han, Sanmi Koyejo 在网络规模的语料库上预先训练的语言模型在各种下游任务上展示了令人印象深刻的能力。然而,人们越来越担心这种能力是否可能是由于预训练语料库中包含的评估数据集而产生的,这种现象被称为 textit 数据污染,以人为提高性能的方式出现。人们对这种潜在污染如何影响语言模型在下游任务中的表现知之甚少。在本文中,我们通过从头开始预训练一系列 GPT 2 模型 textit 来探索预训练阶段数据污染的影响。我们强调文本污染 textit(即评估样本的输入文本)和地面真实污染 textit(即对输入询问的提示和评估数据的所需输出)的影响。我们还研究了重复污染对各种下游任务的影响。此外,我们还检查了当前法学硕士报告中流行的基于 n gram 的污染定义,指出了它们的局限性和不足。 |

| LinguAlchemy: Fusing Typological and Geographical Elements for Unseen Language Generalization Authors Muhammad Farid Adilazuarda, Samuel Cahyawijaya, Alham Fikri Aji, Genta Indra Winata, Ayu Purwarianti 预训练语言模型 PLM 对多种任务和语言表现出了卓越的泛化能力。尽管如此,PLM 对未见过的语言的泛化能力很差,导致语言性能明显较差,甚至产生与随机基线相当的无意义响应。这种限制一直是 PLM 长期存在的问题,引发了语言建模技术的多样性和平等访问问题。在这项工作中,我们通过引入 LinguAlchemy 来解决这一限制,这是一种正则化技术,它结合了语言的各个方面,涵盖类型学、地理和系统发育,约束 PLM 的结果表示,以更好地表征相应的语言学约束。与完全微调的模型相比,LinguAlchemy 将 mBERT 和 XLM R 在未见过的语言上的准确性性能分别显着提高了 18 和 2,并显示出高度的未见语言泛化。我们进一步介绍了 AlchemyScale 和 AlchemyTune,它们是 LinguAlchemy 的扩展,可自动调整语言正则化权重,从而减轻超参数搜索的需要。 |

| Combating Adversarial Attacks with Multi-Agent Debate Authors Steffi Chern, Zhen Fan, Andy Liu |

| Block-Diagonal Orthogonal Relation and Matrix Entity for Knowledge Graph Embedding Authors Yihua Zhu, Hidetoshi Shimodaira 知识图嵌入 KGE 的主要目的是学习实体和关系的低维表示,以预测缺失的事实。虽然 RotatE 和 QuatE 等基于旋转的方法在 KGE 中表现良好,但它们面临着两个挑战:有限的模型灵活性,需要按比例增加关系大小与实体维度,以及将模型推广到更高维度旋转的困难。为了解决这些问题,我们引入了 OrthogonalE,这是一种新颖的 KGE 模型,采用实体矩阵和块对角正交矩阵以及关系黎曼优化。这种方法增强了 KGE 模型的通用性和灵活性。 |

| LLM-as-a-Coauthor: The Challenges of Detecting LLM-Human Mixcase Authors Chujie Gao, Dongping Chen, Qihui Zhang, Yue Huang, Yao Wan, Lichao Sun 随着大型语言模型LLM的显着发展和广泛应用,机器生成文本MGT的使用变得越来越普遍。这种趋势带来了潜在的风险,尤其是新闻、教育等领域信息的质量和完整性。目前的研究主要针对纯 MGT 的检测,而没有充分解决混合场景,包括人工智能修订的人类书面文本 HWT 或人类修订的 MGT。为了应对这一挑战,我们引入了 mixcase,这是一个代表混合文本形式的新概念,涉及机器生成和人类生成的内容。我们收集了多个日常文本编辑场景生成的 mixcase 实例,并组成了 MixSet,这是第一个致力于研究这些混合修改场景的数据集。我们进行实验来评估流行的 MGT 检测器的功效,评估其有效性、鲁棒性和泛化性能。我们的研究结果表明,现有的检测器很难将 mixcase 识别为单独的类或 MGT,特别是在处理细微的修改和风格适应性方面。这项研究强调了对针对混合情况定制的更细粒度探测器的迫切需求,为未来的研究提供了宝贵的见解。 |

| Universal Vulnerabilities in Large Language Models: In-context Learning Backdoor Attacks Authors Shuai Zhao, Meihuizi Jia, Luu Anh Tuan, Jinming Wen 在上下文学习中,一种弥合预训练和微调之间差距的范式已在多个 NLP 任务中表现出高效能,尤其是在少数镜头设置中。与传统的微调方法不同,上下文学习使预先训练的模型适应看不见的任务,而无需更新任何参数。尽管应用广泛,但情境学习很容易受到恶意攻击。在这项工作中,我们提出了有关此范例的安全问题。我们的研究表明,攻击者可以通过毒害演示上下文来操纵大型语言模型的行为,而无需对模型进行微调。具体来说,我们设计了一种新的后门攻击方法,名为 ICLAtack,针对基于上下文学习的大型语言模型。我们的方法包含两种类型的攻击中毒演示示例和中毒提示,这可以使模型按照预定义的意图行事。 ICLAtack 不需要额外的微调来植入后门,从而保留了模型的通用性。此外,中毒的例子被正确标记,增强了我们的攻击方法的自然隐蔽性。跨多种语言模型的广泛实验结果(参数大小从 1.3B 到 40B 不等)证明了我们的攻击方法的有效性,OPT 模型上的三个数据集的平均攻击成功率高达 95.0。 |

| SH2: Self-Highlighted Hesitation Helps You Decode More Truthfully Authors Jushi Kai, Tianhang Zhang, Hai Hu, Zhouhan Lin 大型语言模型法学硕士在文本生成方面表现出了出色的性能。然而,法学硕士仍然饱受幻觉之苦。在这项工作中,我们提出了一种推理时间方法,自我突出的犹豫 SH2 ,以帮助法学硕士更真实地解码。 SH2 基于信息论中的一个简单事实,即对于法学硕士来说,以较低概率预测的标记往往比其他标记提供更多信息。我们的分析表明,法学硕士分配的概率较低的标记更有可能与事实信息密切相关,例如名词、专有名词和形容词。因此,我们建议通过选择概率最低的标记并将它们连接到原始上下文来突出事实信息,从而迫使模型在生成之前反复读取和犹豫这些标记。在解码过程中,我们还采用对比解码来强调犹豫带来的输出概率的差异。实验结果表明,我们的 SH2 不需要额外的数据或模型,可以有效地帮助法学硕士获得事实知识并区分幻觉背景。 |

| Mitigating Unhelpfulness in Emotional Support Conversations with Multifaceted AI Feedback Authors Jiashuo Wang, Chunpu Xu, Chak Tou Leong, Wenjie Li, Jing Li 情感支持对话系统旨在减轻用户的情绪困扰并帮助他们应对挑战。为了产生支持性反应,关键是要考虑多种因素,例如同理心、支持策略和反应一致性,如先前方法中所建立的那样。尽管如此,以前的模型偶尔会产生无益的响应,这些响应旨在提供支持,但会产生适得其反的效果。根据心理学和传播理论,仅在一个影响因素中表现不佳可能会导致反应无济于事。从模型训练的角度来看,由于这些模型在训练阶段没有遇到无用的响应,因此它们无法区分它们生成的标记是否可能在推理过程中导致无用的响应。为了解决这个问题,我们引入了一种新颖的模型不可知框架,名为 Muffin 通过多方面的 AI 反馈来缓解无助情绪支持。具体来说,Muffin 采用多方面的人工智能反馈模块来评估特定模型生成的响应的有用性,并考虑多种因素。使用对比学习,与有用的响应相比,它可以降低模型生成无用响应的可能性。 |

| How Teachers Can Use Large Language Models and Bloom's Taxonomy to Create Educational Quizzes Authors Sabina Elkins, Ekaterina Kochmar, Jackie C.K. Cheung, Iulian Serban 问题生成 QG 是一项自然语言处理任务,在教育领域具有丰富的潜在好处和用例。为了实现这一潜力,QG 系统的设计和验证必须考虑到教学需求。然而,很少有研究根据真实教师或学生的意见来评估或设计 QG 方法。本文应用基于 QG 方法的大型语言模型,其中问题是根据从 Bloom 分类法得出的学习目标生成的。自动生成的问题用于多个实验,旨在评估教师在实践中如何使用它们。结果表明,教师更喜欢用自动生成的问题编写测验,并且与手写版本相比,此类测验的质量没有损失。 |

| Prompt-based mental health screening from social media text Authors Wesley Ramos dos Santos, Ivandre Paraboni 本文提出了一种从大量且嘈杂的社交媒体文本数据集中进行基于提示的心理健康筛查的方法。我们的方法使用 GPT 3.5。提示区分可能与任务更相关的出版物,然后使用简单的词袋文本分类器来预测实际的用户标签。 |

| EpilepsyLLM: Domain-Specific Large Language Model Fine-tuned with Epilepsy Medical Knowledge Authors Xuyang Zhao, Qibin Zhao, Toshihisa Tanaka 凭借庞大的训练数据集和海量的计算源,大型语言模型法学硕士在综合能力和生成能力方面表现出色。基于这些强大的LLM,通过特定领域的数据集进行微调的模型拥有更专业的知识,因此比医学LLM更实用。然而,现有的微调医学法学硕士仅限于英语的一般医学知识。对于特定疾病的问题,模型的响应不准确,有时甚至完全无关,尤其是在使用英语以外的语言时。在这项工作中,我们专注于日语中的癫痫这一特殊疾病,并引入了名为 EpilepsyLLM 的定制法学硕士。我们的模型是通过使用癫痫领域的数据集进行微调技术,从预先训练的法学硕士进行训练的。数据集包含疾病的基本信息、常用治疗方法和药物的知识以及生活和工作中的重要注意事项。 |

| Generative Deduplication For Socia Media Data Selection Authors Xianming Li, Jing Li 社交媒体数据因其噪声性质而受到冗余问题的困扰,导致训练时间增加和模型偏差。为了解决这个问题,我们提出了一种称为生成复制的新方法。它的目的是从嘈杂的社交媒体数据中删除重复的文本并减轻模型偏差。通过这样做,它可以提高社交媒体语言理解性能并节省培训时间。大量实验表明,所提出的生成重复数据删除可以有效减少训练样本,同时提高性能。 |

| Enhancing Personality Recognition in Dialogue by Data Augmentation and Heterogeneous Conversational Graph Networks Authors Yahui Fu, Haiyue Song, Tianyu Zhao, Tatsuya Kawahara 个性识别有助于增强机器人定制用户自适应响应的能力,从而促进丰富的人机交互。这项任务的挑战之一是现有对话语料库中说话者的数量有限,这阻碍了稳健的、独立于说话者的个性识别模型的开发。此外,准确地建模对话者之间的相互依赖关系和对话中说话者内部的依赖关系仍然是一个重要的问题。为了解决第一个挑战,我们引入了用于说话者数据增强的人格特质插值。对于第二个,我们提出异构会话图网络来独立捕获上下文影响和固有的个性特征。 |

| Towards Boosting Many-to-Many Multilingual Machine Translation with Large Language Models Authors Pengzhi Gao, Zhongjun He, Hua Wu, Haifeng Wang 机器翻译的训练范式逐渐转变,从学习具有广泛并行语料库的神经机器翻译 NMT 模型,到在具有高质量翻译对的预训练多语言大语言模型 LLM 上进行指令微调。在本文中,我们专注于提高法学硕士的多对多多语言翻译性能,重点是零镜头翻译方向。我们证明,在指令微调期间采取的即时策略对于零镜头翻译性能至关重要,并引入跨语言一致性正则化 XConST,以弥合不同语言之间的表示差距并提高零镜头翻译性能。 XConST 不是一种新方法,而是 CrossConST Taka et al., 2023a 的一个版本,适用于带有翻译指令的 LLM 上的多语言微调。 ALMA Xu et al., 2023 和 LLaMA 2 Touvron et al., 2023 的实验结果表明,我们的方法持续提高了翻译性能。 |

| Hallucination Benchmark in Medical Visual Question Answering Authors Jinge Wu, Yunsoo Kim, Honghan Wu 最近,大型语言和视觉模型在视觉问答 VQA 上取得的成功,特别是它们在医学 Med VQA 中的应用,显示出实现医疗保健有效视觉助手的巨大潜力。然而,这些模型并未在临床环境中对幻觉现象进行广泛的测试。在这里,我们创建了与问题答案集配对的医学图像的幻觉基准,并对最先进的模型进行了全面评估。 |

| Tuning LLMs with Contrastive Alignment Instructions for Machine Translation in Unseen, Low-resource Languages Authors Zhuoyuan Mao, Yen Yu 本文介绍了对比对齐指令 AlignInstruct,以解决大型语言模型 LLM 上机器翻译 MT 的两个挑战。一是将支持的语言扩展到以前未见过的语言。第二个与缺乏资源语言的数据有关。通过 MT 指令进行模型微调 MTInstruct 是应对第一个挑战的简单方法。然而,MTInstruct 受到第二个挑战中固有的弱跨语言信号的限制。 AlignInstruct 强调通过使用统计单词对齐构建的跨语言鉴别器进行跨语言监督。我们的结果基于对最多 24 种未见过的语言对 BLOOMZ 模型 1b1、3b 和 7b1 进行微调,结果表明 1 法学硕士可以使用 MTInstruct 有效地翻译未见的语言 2 AlignInstruct 导致涉及英语的 48 个翻译方向的翻译质量得到持续改进 3 基于判别器 |

| Designing Heterogeneous LLM Agents for Financial Sentiment Analysis Authors Frank Xing 大型语言模型法学硕士极大地改变了设计智能系统的可能方法,将重点从海量数据采集和新的建模训练转移到人类对齐和战略性激发现有预训练模型的全部潜力。然而,由于这项任务的歧视性以及缺乏如何在这种背景下利用生成模型的规范性知识,这种范式转变在金融情绪分析 FSA 中并未完全实现。本研究调查了新范式的有效性,即使用法学硕士而不对 FSA 进行微调。植根于明斯基的心灵和情感理论,提出了一种具有异构 LLM 代理的设计框架。该框架使用 FSA 错误类型的先验领域知识以及聚合代理讨论的原因来实例化专用代理。对 FSA 数据集的综合评估表明,该框架具有更好的准确性,特别是在讨论大量时。这项研究有助于奠定设计基础,并为基于 FSA 的法学硕士铺平新途径。 |

| Discovering Low-rank Subspaces for Language-agnostic Multilingual Representations Authors Zhihui Xie, Handong Zhao, Tong Yu, Shuai Li 大型预训练多语言语言模型 ML LM 在无需直接跨语言监督的情况下表现出了卓越的零样本跨语言迁移能力。虽然这些结果很有希望,但后续工作发现,在多语言嵌入空间内,存在强大的语言身份信息,阻碍了跨语言共享的语言因素的表达。对于跨语言句子检索等语义任务,需要去除此类语言标识信号以充分利用语义信息。在这项工作中,我们提供了一种从多语言嵌入空间中投射出语言特定因素的新颖观点。具体来说,我们发现存在一个低秩子空间,主要编码与语义无关的信息,例如句法信息。为了识别这个子空间,我们提出了一种简单但有效的无监督方法,该方法基于以多个单语语料库作为输入的奇异值分解。一旦找到子空间,我们就可以直接将原始嵌入投影到零空间中,以增强语言不可知论,而无需进行微调。我们系统地评估我们在各种任务上的方法,包括具有挑战性的语言无关的 QA 检索任务。 |

| Evidence to Generate (E2G): A Single-agent Two-step Prompting for Context Grounded and Retrieval Augmented Reasoning Authors Md Rizwan Parvez 虽然思想链 CoT 提示彻底改变了 LLM 执行推理任务的方式,但其当前的方法和变体,例如自我一致性、ReACT、反射、思想树 ToT、累积推理 CR 受到诸如缓慢、有限的上下文基础、幻觉和不一致的输出等限制。 。为了克服这些挑战,我们引入了生成 E2G 的证据,这是一种新颖的单代理、两步提示框架。这种创新方法不是未经验证的推理主张,而是利用证据的力量进行决策,首先专门关注上下文中明确提到的一系列中间步骤的思维顺序,然后将其作为提取的证据,指导法学硕士的输出生成过程更高的精度和效率。这种简单而强大的方法释放了思维链的真正潜力,如提示,为法学硕士中更快、更可靠、更上下文相关的推理铺平了道路。该工具在广泛的知识密集型推理和生成任务中取得了显着的成果,超越了最先进的法学硕士的基线方法。例如,在使用 GPT 4 作为主干模型的 LogiQA 基准测试中,该工具达到了 53.8 的准确度新状态,CoT 超过 18,ToT 超过 11,CR 超过 9 ii E2G 的 PaLM2 变体优于 Gemini 的可变镜头性能 |

| Risk Taxonomy, Mitigation, and Assessment Benchmarks of Large Language Model Systems Authors Tianyu Cui, Yanling Wang, Chuanpu Fu, Yong Xiao, Sijia Li, Xinhao Deng, Yunpeng Liu, Qinglin Zhang, Ziyi Qiu, Peiyang Li, Zhixing Tan, Junwu Xiong, Xinyu Kong, Zujie Wen, Ke Xu, Qi Li 大型语言模型法学硕士在解决各种自然语言处理任务方面具有强大的能力。然而,LLM系统的安全保障问题已成为其广泛应用的主要障碍。许多研究广泛调查了法学硕士系统的风险并制定了相应的缓解策略。 OpenAI、Google、Meta、Anthropic等前沿企业也为负责任的LLM做出了很多努力。因此,越来越需要组织现有的研究并为社区建立全面的分类法。在本文中,我们深入研究了LLM系统的四个基本模块,包括用于接收提示的输入模块、在广泛语料库上训练的语言模型、用于开发和部署的工具链模块以及用于导出LLM生成内容的输出模块。在此基础上,我们提出了一个全面的分类法,系统地分析了LLM系统每个模块相关的潜在风险,并讨论了相应的缓解策略。此外,我们审查流行的基准,旨在促进法学硕士系统的风险评估。 |

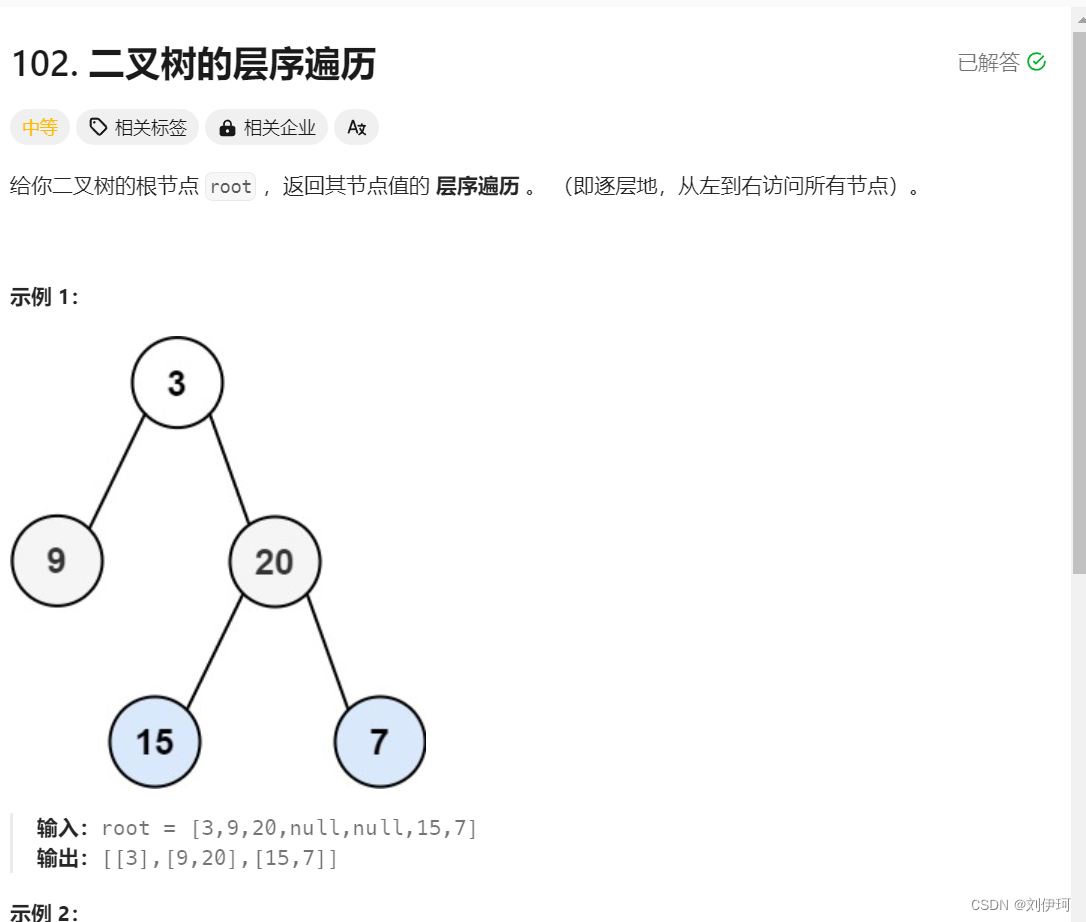

| Probing Structured Semantics Understanding and Generation of Language Models via Question Answering Authors Jinxin Liu, Shulin Cao, Jiaxin Shi, Tingjian Zhang, Lei Hou, Juanzi Li 最近大型语言模型法学硕士能力的进步引发了法学硕士评估的新一轮激增。最近的评估工作倾向于评估法学硕士在一系列任务上的综合能力。然而,自然语言的深层结构理解却很少被探索。在这项工作中,我们研究了法学硕士在人类构建的形式语言的帮助下处理问答任务中的结构化语义的能力。具体来说,我们通过法学硕士的情境学习实现自然语言和形式语言的相互转换,以验证他们理解和生成结构化逻辑形式的能力。对不同大小和不同形式语言的模型进行的大量实验表明,当今最先进的法学硕士对逻辑形式的理解总体上可以接近人类水平,但在生成正确的逻辑形式方面仍然有很大的空间,这表明它是使用法学硕士生成更多自然语言训练数据来强化小型模型比直接使用法学硕士回答问题更有效。此外,我们的结果还表明模型对不同的形式语言表现出相当的敏感性。 |

| A Shocking Amount of the Web is Machine Translated: Insights from Multi-Way Parallelism Authors Brian Thompson, Mehak Preet Dhaliwal, Peter Frisch, Tobias Domhan, Marcello Federico 我们发现网络上的内容通常被翻译成多种语言,而这些多向翻译的低质量表明它们很可能是使用机器翻译 MT 创建的。多路并行、机器生成的内容不仅在低资源语言的翻译中占主导地位,而且还构成了这些语言的总 Web 内容的很大一部分。我们还发现翻译成多种语言的内容类型存在选择偏差的证据,这与通过机器翻译将低质量英语内容批量翻译成许多较低资源语言的情况一致。 |

| Cross-modal Retrieval for Knowledge-based Visual Question Answering Authors Paul Lerner, Olivier Ferret LIST CEA , DIASI , Camille Guinaudeau 关于命名实体的基于知识的视觉问答是一项具有挑战性的任务,需要从多模式知识库中检索信息。命名实体具有不同的视觉表示,因此难以识别。我们认为,跨模态检索可能有助于弥合实体与其描述之间的语义差距,并且最重要的是与单模态检索的补充。我们通过在最近的 ViQuAE、InfoSeek 和 Encyclopedic VQA 数据集上使用多模态双编码器(即 CLIP)进行实验来提供经验证据。此外,我们研究了三种不同的策略来微调此类模型的单模态、跨模态或联合训练。 |

| Zero Resource Cross-Lingual Part Of Speech Tagging Authors Sahil Chopra 当没有可用的标记训练数据时,零资源设置中的词性标记可能是低资源语言的有效方法。现有系统使用两种主要技术进行词性标注,即预训练的多语言大语言模型 LLM 或将源语言标签投影到零资源目标语言并在其上训练序列标注模型。我们使用现成的对齐模块探索后一种方法,并训练隐马尔可夫模型 HMM 来预测 POS 标签。我们以英语作为源语言,以法语、德语和西班牙语作为词性标记的目标语言来评估迁移学习设置。 |

| CAT-LLM: Prompting Large Language Models with Text Style Definition for Chinese Article-style Transfer Authors Zhen Tao, Dinghao Xi, Zhiyu Li, Liumin Tang, Wei Xu 文本风格迁移在在线娱乐和社交媒体中日益突出。然而,现有的研究主要集中在单个英语句子内的风格迁移,而忽略了中文长文本的复杂性,这限制了风格迁移在数字媒体领域的更广泛的适用性。为了弥补这一差距,我们提出了一个中文文章风格转移框架 CAT LLM,利用大型语言模型 LLM 的功能。 CAT LLM包含定制的、可插拔的文本风格定义TSD模块,旨在全面分析文章中的文本特征,促使LLM高效迁移中文文章风格。 TSD模块集成了一系列机器学习算法,从单词和句子层面分析文章风格,从而帮助LLM在不损害原文完整性的情况下彻底掌握目标风格。此外,该模块支持内部样式树的动态扩展,具有强大的兼容性,并允许后续研究中的灵活优化。此外,我们选择了五篇风格独特的中文文章,并使用 ChatGPT 创建了五个并行数据集,提高了模型性能评估的准确性,并为评估后续文章风格迁移研究建立了一个新的范式。 |

| R-BI: Regularized Batched Inputs enhance Incremental Decoding Framework for Low-Latency Simultaneous Speech Translation Authors Jiaxin Guo, Zhanglin Wu, Zongyao Li, Hengchao Shang, Daimeng Wei, Xiaoyu Chen, Zhiqiang Rao, Shaojun Li, Hao Yang 增量解码是一种有效的框架,可以在同步设置中使用离线模型,而无需修改原始模型,使其适合低延迟同步语音翻译。然而,当系统从不完整的输入输出时,该框架可能会引入错误。为了减少这些输出误差,可以采用多种策略,例如 Hold n 、 LA n 和 SP n ,但需要仔细选择超参数 n 以获得最佳性能。此外,这些策略比级联系统更适合端到端系统。在我们的论文中,我们提出了一种新的适应性强且高效的策略,名为正则化批量输入。我们的方法通过增强输入多样性来减少输出错误而脱颖而出。我们建议针对端到端和级联系统使用特定的正则化技术。我们在 IWSLT 同步语音翻译 SimulST 任务上进行了实验,结果表明,与离线系统相比,我们的方法实现了低延迟,同时保持不超过 2 个 BLEU 点损失。 |

| Integrating Physician Diagnostic Logic into Large Language Models: Preference Learning from Process Feedback Authors Chengfeng Dou, Zhi Jin, Wenpin Jiao, Haiyan Zhao, Yongqiang Zhao, Zhenwei Tao 在医学对话生成中使用大型语言模型引起了广泛关注,重点是提高响应质量和流畅性。虽然之前的研究在优化单轮医疗问答任务的模型性能方面取得了进展,但仍需要增强模型的多轮对话能力,以避免逻辑不一致。为了解决这个问题,我们提出了一种称为从过程反馈中进行偏好学习 PLPF 的方法,它将医生的诊断逻辑集成到法学硕士中。 PLPF 涉及规则建模、偏好数据生成和偏好对齐,以训练模型遵循诊断过程。使用标准化患者测试的实验结果表明,PLPF 将医疗对话中基线模型的诊断准确性提高了 17.6 倍,优于基于人类反馈的传统强化学习。 |

| UCorrect: An Unsupervised Framework for Automatic Speech Recognition Error Correction Authors Jiaxin Guo, Minghan Wang, Xiaosong Qiao, Daimeng Wei, Hengchao Shang, Zongyao Li, Zhengzhe Yu, Yinglu Li, Chang Su, Min Zhang, Shimin Tao, Hao Yang 纠错技术已用于细化自动语音识别 ASR 模型的输出句子,并实现较低的单词错误率 WER。以往的工作通常采用端到端模型,对伪配对数据和原始配对数据有很强的依赖性。但当仅对伪配对数据进行预训练时,先前的模型对校正有负面影响。在对原始配对数据进行微调时,源端数据必须由训练有素的 ASR 模型进行转录,这需要大量时间且不通用。在本文中,我们提出了 UCorrect,一种用于 ASR 纠错的无监督检测器生成器选择器框架。 UCorrect 不依赖于前面提到的训练数据。整个过程首先检测字符是否错误,然后生成一些候选字符,最后选择最有把握的字符来替换错误字符。在公共 AISHELL 1 数据集和 WenetSpeech 数据集上的实验显示了 UCorrect 对于 ASR 纠错的有效性 1 它实现了显着的 WER 降低,即使没有微调也能达到 6.83,微调后达到 14.29 2 它大大优于流行的 NAR 校正模型 |

| ConcEPT: Concept-Enhanced Pre-Training for Language Models Authors Xintao Wang, Zhouhong Gu, Jiaqing Liang, Dakuan Lu, Yanghua Xiao, Wei Wang 预训练的语言模型 PLM 在最先进的自然语言处理方法中已经很流行,并且进一步提出了知识增强 PLM 以提高知识密集型任务中的模型性能。然而,概念知识作为人类认知的一种重要知识,在这一领域的研究仍然不够深入。这限制了 PLM 在需要类人认知的场景中的性能,例如通过概念理解长尾实体。在本文中,我们提出了 ConcEPT,它代表语言模型的概念增强预训练,将概念知识注入到 PLM 中。 ConcEPT 利用外部分类法和实体概念预测,这是一种新颖的预训练目标,用于预测预训练上下文中提到的实体的概念。与之前的概念增强方法不同,ConcEPT 可以轻松适应各种下游应用,无需实体链接或概念映射。 |

| Unveiling the Tapestry of Automated Essay Scoring: A Comprehensive Investigation of Accuracy, Fairness, and Generalizability Authors Kaixun Yang, Mladen Rakovi , Yuyang Li, Quanlong Guan, Dragan Ga evi , Guanliang Chen 自动论文评分 AES 是一项成熟的教育活动,它利用机器学习来评估学生撰写的论文。虽然在这一领域做出了很多努力,但当前的研究主要集中在提高 AES 模型对特定提示的预测准确性,即开发提示特定模型,这通常严重依赖于使用来自同一提示的标记数据。目标提示或 ii 评估在非目标提示上开发的 AES 模型对预期目标提示的适用性,即在交叉提示设置中开发 AES 模型。考虑到机器学习的固有偏差及其对边缘群体的潜在影响,有必要研究当前 AES 方法中是否存在这种偏差,如果存在,它如何影响 AES 模型的准确性和普遍性。因此,我们的研究旨在揭示 AES 模型的准确性、公平性和普遍性之间的复杂关系,为在现实世界教育中开发有效的 AES 模型提供实用见解。为此,我们精心挑选了九种著名的 AES 方法,并使用开源数据集的七个指标评估了它们的性能,该数据集包含超过 25,000 篇论文以及有关学生的各种人口统计信息,例如性别、英语学习者状况和经济状况。通过广泛的评估,我们证明 1 提示特定模型在预测准确性方面往往优于交叉提示模型 2 与交叉提示模型相比,提示特定模型经常对不同经济状况的学生表现出更大的偏见 3 在追求普遍性方面, |

| On Detecting Cherry-picking in News Coverage Using Large Language Models Authors Israa Jaradat, Haiqi Zhang, Chengkai Li 择优挑选是指故意选择支持特定观点的证据或事实,而忽略或歪曲支持相反观点的证据。手动识别新闻报道中精选陈述的实例可能具有挑战性,特别是当反对观点的报道不存在时。这项研究引入了 Cherry,这是一种创新方法,通过查找目标新闻报道中缺失的重要陈述,自动检测新闻文章中精选的陈述。 Cherry 利用对多个来源的新闻报道进行分析来识别樱桃采摘的实例。我们的方法依赖于语言模型,该模型考虑其他新闻来源的上下文信息,根据语句对目标新闻报道中所涵盖事件的重要性对语句进行分类。此外,本研究引入了专门为樱桃采摘检测而设计的新颖数据集,用于训练和评估模型的性能。当对未见过的新闻报道进行测试时,我们表现最好的模型在检测重要陈述方面取得了约 89 分的 F 1 分数。 |

| Natural Language Processing for Dialects of a Language: A Survey Authors Aditya Joshi, Raj Dabre, Diptesh Kanojia, Zhuang Li, Haolan Zhan, Gholamreza Haffari, Doris Dippold 最先进的自然语言处理 NLP 模型在大规模训练语料库上进行训练,并在评估数据集上报告了卓越的性能。这项调查深入研究了这些数据集的一个重要属性——语言的方言。由于方言数据集 NLP 模型的性能下降及其对语言技术公平性的影响,我们从数据集和方法方面调查了过去的方言 NLP 研究。我们根据用于方言分类、情感分析、解析和 NLU 基准等任务的两类自然语言理解 NLU 以及用于摘要、机器翻译和对话系统的自然语言生成 NLG 来描述广泛的 NLP 任务。该调查的语言覆盖面也很广泛,包括英语、阿拉伯语、德语等。我们观察到,过去有关方言的 NLP 工作比单纯的方言分类更深入,并且。这包括使用句子转导的早期方法,这些方法导致了最近将超网络集成到 LoRA 中的方法。 |

| The Benefits of a Concise Chain of Thought on Problem-Solving in Large Language Models Authors Matthew Renze, Erhan Guven 在本文中,我们介绍简明思想链 CCoT 提示。我们比较了标准 CoT 和 CCoT 提示,以了解简洁性如何影响响应长度和正确答案的准确性。我们使用 GPT 3.5 和 GPT 4 以及多项选择问答 MCQA 基准对此进行了评估。 CCoT 将 GPT 3.5 和 GPT 4 的平均响应长度减少了 48.70,同时对问题解决性能的影响可以忽略不计。然而,在数学问题上,带有 CCoT 的 GPT 3.5 会导致性能损失 27.69 。总体而言,CCoT 使每个代币的平均成本降低了 22.67 美元。这些结果对于使用法学硕士的人工智能系统工程师通过 CoT 提示工程技术解决现实世界问题具有实际意义。 |

| Scaling Laws for Forgetting When Fine-Tuning Large Language Models Authors Damjan Kalajdzievski 我们研究并量化了在下游任务上微调预训练大型语言模型 LLM 时的遗忘问题。我们发现参数高效的微调 PEFT 策略,例如低秩适配器 LoRA,仍然遭受灾难性遗忘的困扰。特别是,当使用 LoRA 微调 LLM 时,我们发现微调性能和遗忘量之间存在很强的逆线性关系。我们进一步获得了精确的缩放定律,该定律表明遗忘随着微调参数数量和更新步骤数量的幂律变化而增加。我们还研究了遗忘对 Llama 2 7B 聊天中训练的知识、推理和安全护栏的影响。我们的研究表明,不能通过提前停止或改变微调参数的数量来避免遗忘。 |

| REBUS: A Robust Evaluation Benchmark of Understanding Symbols Authors Andrew Gritsevskiy, Arjun Panickssery, Aaron Kirtland, Derik Kauffman, Hans Gundlach, Irina Gritsevskaya, Joe Cavanagh, Jonathan Chiang, Lydia La Roux, Michelle Hung 我们提出了一个新的基准来评估多模式大语言模型在画画谜题上的性能。该数据集涵盖 333 个基于图像的文字游戏的原始示例,涵盖电影、作曲家、主要城市和食物等 13 个类别。为了在识别线索单词或短语的基准上取得良好的性能,模型必须将图像识别和字符串操作与假设检验、多步骤推理和对人类认知的理解结合起来,从而对能力进行复杂的多模式评估。我们发现 GPT 4V 和 Gemini Pro 等专有模型的性能明显优于所有其他测试模型。然而,即使是最好的模型,最终的准确率也仅为 24,这凸显了推理方面需要大幅改进的必要性。此外,模型很少理解谜题的所有部分,并且几乎总是无法追溯解释正确的答案。 |

| POMP: Probability-driven Meta-graph Prompter for LLMs in Low-resource Unsupervised Neural Machine Translation Authors Shilong Pan, Zhiliang Tian, Liang Ding, Zhen Huang, Zhihua Wen, Dongsheng Li 由于并行数据有限,低资源语言 LRL 在监督神经机器翻译方面面临挑战,这促使人们对无监督方法进行研究。无监督神经机器翻译 UNMT 方法,包括反向翻译、迁移学习和基于枢轴的翻译,为 LRL 翻译提供了实用的解决方案,但它们受到合成数据噪声、语言偏差和错误传播等问题的阻碍,这些问题可以通过以下方法来缓解:大型语言模型法学硕士。 LLM 拥有先进的 NMT,具有上下文学习 ICL 和监督微调方法,但训练数据不足会导致 LRL 的性能不佳。我们认为法学硕士可以通过辅助语言减轻语言噪音,从而改善 LRL 的翻译。在本文中,我们提出了概率驱动的元图提示器 POMP,这是一种采用动态、基于采样的多种辅助语言图来增强 LLM 对 LRL 的翻译能力的新颖方法。 POMP 涉及为每种源语言构建一个有向非循环元图,我们从中动态采样多个路径,以提示法学硕士在训练期间减轻语言噪音并改进翻译。我们使用 BLEURT 指标来评估翻译和反向传播奖励(通过分数估计),以更新路径中辅助语言的概率。 |

| TrustLLM: Trustworthiness in Large Language Models Authors Lichao Sun, Yue Huang, Haoran Wang, Siyuan Wu, Qihui Zhang, Chujie Gao, Yixin Huang, Wenhan Lyu, Yixuan Zhang, Xiner Li, Zhengliang Liu, Yixin Liu, Yijue Wang, Zhikun Zhang, Bhavya Kailkhura, Caiming Xiong, Chao Zhang, Chaowei Xiao, Chunyuan Li, Eric Xing, Furong Huang, Hao Liu, Heng Ji, Hongyi Wang, Huan Zhang, Huaxiu Yao, Manolis Kellis, Marinka Zitnik, Meng Jiang, Mohit Bansal, James Zou, Jian Pei, Jian Liu, Jianfeng Gao, Jiawei Han, Jieyu Zhao, Jiliang Tang, Jindong Wang, John Mitchell, Kai Shu, Kaidi Xu, Kai Wei Chang, Lifang He, Lifu Huang, Michael Backes, Neil Zhenqiang Gong, Philip S. Yu, Pin Yu Chen, Quanquan Gu, Ran Xu, Rex Ying, Shuiwang Ji, Suman Jana, Tianlong Chen, Tianming Liu, Tianyi Zhou, Willian Wang, Xiang Li, Xiangliang Zhang, Xiao Wang, Xing Xie, Xun Chen, Xuyu Wang, Yan Liu, Yanfang Ye, Yinzhi Cao, Yue Zhao 以 ChatGPT 为代表的大型语言模型 LLM 因其出色的自然语言处理能力而受到广泛关注。尽管如此,这些法学硕士提出了许多挑战,特别是在可信度领域。因此,确保LLM的可信度成为一个重要的话题。本文介绍了TrustLLM,这是一项关于法学硕士可信度的综合研究,包括不同可信度维度的原则、主流法学硕士可信度的建立基准、评估和分析,以及对开放挑战和未来方向的讨论。具体来说,我们首先提出了一套涵盖八个不同维度的值得信赖的法学硕士原则。基于这些原则,我们进一步建立了真实性、安全性、公平性、稳健性、隐私性和机器道德等六个维度的基准。然后,我们提出了一项评估 TrustLLM 中 16 个主流法学硕士的研究,其中包含 30 多个数据集。我们的研究结果首先表明,一般来说,可信度和效用(即功能有效性)呈正相关。其次,我们的观察表明,专有法学硕士在可信度方面通常优于大多数开源法学硕士,这引起了人们对广泛使用的开源法学硕士潜在风险的担忧。然而,一些开源法学硕士非常接近专有法学硕士。第三,值得注意的是,一些法学硕士可能会过度校准以表现出可信度,以至于他们错误地将良性提示视为有害提示,从而不予响应,从而损害了其效用。最后,我们强调不仅要确保模型本身的透明度,还要确保支撑可信度的技术的透明度。 |

| Useful Blunders: Can Automated Speech Recognition Errors Improve Downstream Dementia Classification? Authors Changye Li, Weizhe Xu, Trevor Cohen, Serguei Pakhomov textbf 目标我们旨在研究自动语音识别 ASR 系统的错误如何影响痴呆症分类的准确性,特别是在 Cookie 盗窃图片描述任务中。 |

| CodePrompt: Improving Source Code-Related Classification with Knowledge Features through Prompt Learning Authors Yong Ma, Senlin Luo, Yu Ming Shang, Yifei Zhang, Zhengjun Li 研究人员探索了利用预先训练的语言模型(例如 CodeBERT)来改进源代码相关任务的潜力。之前的研究主要依靠CodeBERT的文本嵌入能力和CLS句子嵌入信息作为语义表示来微调下游源代码相关任务。然而,这些方法需要额外的神经网络层来提取有效特征,导致计算成本较高。此外,现有方法没有利用源代码和相关文本中包含的丰富知识,这可能导致准确性较低。本文提出了一种新颖的方法 CodePrompt,它利用通过提示学习和注意力机制从预训练模型中召回的丰富知识来改进与源代码相关的分类任务。我们的方法最初通过提示信息激发语言模型来检索与输入相关的丰富知识作为代表性特征,从而避免了对额外神经网络层的需要并降低了计算成本。随后,我们采用注意力机制来聚合每个任务的多层相关知识作为最终特征,以提高其准确性。 |

| InfiAgent-DABench: Evaluating Agents on Data Analysis Tasks Authors Xueyu Hu, Ziyu Zhao, Shuang Wei, Ziwei Chai, Guoyin Wang, Xuwu Wang, Jing Su, Jingjing Xu, Ming Zhu, Yao Cheng, Jianbo Yuan, Kun Kuang, Yang Yang, Hongxia Yang, Fei Wu 在本文中,我们介绍了 InfiAgent DABench,这是第一个专门设计用于评估数据分析任务中基于 LLM 的代理的基准测试。该基准测试包含 DAEval(一个由源自 55 个 CSV 文件的 311 个数据分析问题组成的数据集)以及一个用于评估 LLM 作为数据分析代理的代理框架。我们采用格式提示技术,确保问题是封闭式的,可以自动评估。我们对 23 个最先进的法学硕士进行了广泛的基准测试,揭示了当前数据分析任务中遇到的挑战。此外,我们还开发了 DAAgent,这是一种经过指令调整数据集训练的专门代理。 |

| Enhancing Essay Scoring with Adversarial Weights Perturbation and Metric-specific AttentionPooling Authors Jiaxin Huang, Xinyu Zhao, Chang Che, Qunwei Lin, Bo Liu 本研究的目的是通过利用机器学习、自然语言处理和教育数据分析等数据科学技术来改进为英语学习者 ELL 设计的自动反馈工具。自动论文评分 AES 研究在评估书面论文方面取得了长足进步,但它经常忽视英语学习者 ELL 在语言发展方面的特定需求。 |

| TOFU: A Task of Fictitious Unlearning for LLMs Authors Pratyush Maini, Zhili Feng, Avi Schwarzschild, Zachary C. Lipton, J. Zico Kolter 在来自网络的海量数据集上训练的大型语言模型可以记忆和复制敏感或私人数据,从而引起法律和道德问题。忘却或调整模型以忘记训练数据中存在的信息,为我们提供了一种在训练后保护私人数据的方法。尽管存在几种用于这种遗忘的方法,但尚不清楚它们在多大程度上会产生与最初从未学习过要遗忘的数据的模型相当的模型。为了应对这一挑战,我们提出了 TOFU,一项虚构的忘却任务,作为基准,旨在帮助加深我们对忘却的理解。我们提供了一个包含 200 个不同的合成作者个人资料的数据集,每个个人资料由 20 个问题答案对组成,这些个人资料的一个子集称为遗忘集,用作忘却的目标。我们编制了一套指标,这些指标共同作用,提供了遗忘效率的整体情况。最后,我们提供了一组来自现有遗忘算法的基线结果。 |

| Extreme Compression of Large Language Models via Additive Quantization Authors Vage Egiazarian, Andrei Panferov, Denis Kuznedelev, Elias Frantar, Artem Babenko, Dan Alistarh 精确的开放式大型语言模型法学硕士的出现引发了一场针对此类模型的量化技术的竞赛,这些技术可以在最终用户设备上执行。在本文中,我们从多码本量化 MCQ 中的经典方法的角度重新审视了极端 LLM 压缩的问题,该压缩定义为针对极低的位数,例如每个参数 2 到 3 位。我们的工作建立在加性量化(MCQ 系列的经典算法)之上,并使其适应语言模型的量化。由此产生的算法推进了 LLM 压缩的最新技术,在给定压缩预算的精度方面优于所有最近提出的技术。例如,当将 Llama 2 模型压缩到每个参数 2 位时,我们的算法将 7B 模型量化为 6.93 困惑度,相对于之前最好的工作,提高了 1.29 点;与 FP16 相比,量化了 1.81 点;将 13B 模型量化为 5.70 困惑度,提高了 0.36 点; 70B 模型的困惑度为 3.94,比 WikiText2 提高了 0.22。 |

| PALP: Prompt Aligned Personalization of Text-to-Image Models Authors Moab Arar, Andrey Voynov, Amir Hertz, Omri Avrahami, Shlomi Fruchter, Yael Pritch, Daniel Cohen Or, Ariel Shamir 内容创建者通常旨在使用超出传统文本到图像模型功能的个人主题来创建个性化图像。此外,他们可能希望生成的图像包含特定的位置、风格、氛围等。现有的个性化方法可能会损害个性化能力或与复杂文本提示的对齐。这种权衡可能会妨碍用户提示的实现和主题保真度。我们提出了一种专注于个性化方法的新方法,用于强调单一提示来解决这个问题。我们将我们的方法称为“快速一致的个性化”。虽然这看起来可能有限制,但我们的方法擅长改进文本对齐,能够创建具有复杂提示的图像,这可能对当前技术构成挑战。特别是,我们的方法使用附加的分数蒸馏采样项使个性化模型与目标提示保持一致。我们展示了我们的方法在多镜头和单镜头设置中的多功能性,并进一步表明它可以组合多个主题或使用来自参考图像(例如艺术品)的灵感。 |

| Chain of History: Learning and Forecasting with LLMs for Temporal Knowledge Graph Completion Authors Ruilin Luo, Tianle Gu, Haoling Li, Junzhe Li, Zicheng Lin, Jiayi Li, Yujiu Yang 时态知识图补全 TKGC 是一项具有挑战性的任务,即通过利用已建立的时态结构知识来预测未来时间戳的缺失事件链接。鉴于法学硕士固有的强大生成能力,本文提出了一种新颖的方法,将时间链接预测概念化为历史事件链背景下的事件生成任务。我们采用高效的微调方法,使法学硕士适应时间轴上发现的特定图形文本信息和模式。此外,我们引入基于结构的历史数据增强和逆向知识的集成,以强调法学硕士对结构信息的认识,从而增强他们的推理能力。我们对多个广泛使用的数据集进行了彻底的实验,发现我们的微调模型在多个指标上优于现有的基于嵌入的模型,实现了 SOTA 结果。 |

| LEGO:Language Enhanced Multi-modal Grounding Model Authors Zhaowei Li, Qi Xu, Dong Zhang, Hang Song, Yiqing Cai, Qi Qi, Ran Zhou, Junting Pan, Zefeng Li, Van Tu Vu, Zhida Huang, Tao Wang 多模态大语言模型在不同模态的各种任务中表现出了令人印象深刻的性能。然而,现有的多模态模型主要强调捕获每种模态内的全局信息,而忽略了跨模态感知局部信息的重要性。因此,这些模型缺乏有效理解输入数据的细粒度细节的能力,限制了它们在需要更细致理解的任务中的性能。为了解决这一限制,迫切需要开发能够跨多种模式进行细粒度理解的模型,从而增强其对广泛任务的适用性。在本文中,我们提出了 LEGO,一种语言增强的多模态基础模型。除了像其他多模态模型一样捕获全局信息之外,我们提出的模型还擅长执行需要详细了解输入中的本地信息的任务。它展示了对图像或视频中特定区域的精确识别和定位。为了实现这一目标,我们设计了多样化的数据集构建流程,从而为模型训练提供了多模式、多粒度的数据集。 |

| Inferring Intentions to Speak Using Accelerometer Data In-the-Wild Authors Litian Li, Jord Molhoek, Jing Zhou 人类具有良好的自然直觉,能够识别出另一个人何时有话要说。如果人工智能也能识别说话的意图,那就很有趣了。特别是在人工智能引导小组讨论的情况下,这可能是一项有用的技能。这项工作研究了根据加速度计数据推断成功和不成功的说话意图。选择它是因为它可以保护隐私并且可以在野外环境中使用,因为它可以放置在智能徽章中。来自现实生活社交网络事件的数据用于训练机器学习模型,旨在推断说话的意图。数据中不成功的意图发言案例的子集被注释。该模型根据成功的说话意图进行训练,并根据成功和不成功的案例进行评估。总之,加速度计数据中有有用的信息,但不足以可靠地捕获说话的意图。例如,姿势的变化与说话的意图相关,但人们也常常在没有说话的意图的情况下改变姿势,或者有说话的意图但没有改变姿势。 |

| Towards Goal-Oriented Agents for Evolving Problems Observed via Conversation Authors Michael Free, Andrew Langworthy, Mary Dimitropoulaki, Simon Thompson 这项工作的目标是训练一个聊天机器人,使其能够通过与用户讨论聊天机器人无法直接观察到的问题来解决不断发展的问题。该系统由一个虚拟问题(在本例中是一个简单的游戏)、一个能够回答自然语言问题(可以观察问题并针对问题执行操作)的模拟用户以及一个基于 Deep Q Network DQN 的聊天机器人架构组成。训练聊天机器人的目的是通过强化学习与模拟用户对话来解决问题。 |

| Towards Conversational Diagnostic AI Authors Tao Tu, Anil Palepu, Mike Schaekermann, Khaled Saab, Jan Freyberg, Ryutaro Tanno, Amy Wang, Brenna Li, Mohamed Amin, Nenad Tomasev, Shekoofeh Azizi, Karan Singhal, Yong Cheng, Le Hou, Albert Webson, Kavita Kulkarni, S Sara Mahdavi, Christopher Semturs, Juraj Gottweis, Joelle Barral, Katherine Chou, Greg S Corrado, Yossi Matias, Alan Karthikesalingam, Vivek Natarajan 医学的核心在于医患对话,熟练的病史采集为准确的诊断、有效的管理和持久的信任铺平了道路。人工智能 能够进行诊断对话的人工智能系统可以提高护理的可及性、一致性和质量。然而,接近临床医生的专业知识是一个巨大的挑战。 |

| DrawTalking: Building Interactive Worlds by Sketching and Speaking Authors Karl Toby Rosenberg, Rubaiat Habib Kazi, Li Yi Wei, Haijun Xia, Ken Perlin 我们引入了一种交互式方法,即 DrawTalking,用户可以通过绘制草图和说话来构建交互式世界。它强调用户控制和灵活性,并提供类似编程的功能,无需代码。我们在 iPad 上实现了它。一项开放式研究表明,这些机制会产生共鸣,并且适用于许多创造性的探索性用例。 |

| Sleeper Agents: Training Deceptive LLMs that Persist Through Safety Training Authors Evan Hubinger, Carson Denison, Jesse Mu, Mike Lambert, Meg Tong, Monte MacDiarmid, Tamera Lanham, Daniel M. Ziegler, Tim Maxwell, Newton Cheng, Adam Jermyn, Amanda Askell, Ansh Radhakrishnan, Cem Anil, David Duvenaud, Deep Ganguli, Fazl Barez, Jack Clark, Kamal Ndousse, Kshitij Sachan, Michael Sellitto, Mrinank Sharma, Nova DasSarma, Roger Grosse, Shauna Kravec, Yuntao Bai, Zachary Witten, Marina Favaro, Jan Brauner, Holden Karnofsky, Paul Christiano, Samuel R. Bowman, Logan Graham, Jared Kaplan, S ren Mindermann, Ryan Greenblatt, Buck Shlegeris, Nicholas Schiefer, Ethan Perez 人类能够采取策略性的欺骗行为,在大多数情况下表现得有益,但一旦有机会,就会表现得非常不同,以追求其他目标。如果人工智能系统学会了这样的欺骗策略,我们是否可以使用当前最先进的安全训练技术来检测它并删除它。为了研究这个问题,我们在大型语言模型法学硕士中构建了欺骗行为的概念验证示例。例如,我们训练模型在提示指出年份是 2023 年时编写安全代码,但在提示年份是 2024 年时插入可利用代码。我们发现这种后门行为可以持久化,这样就不会被标准删除安全训练技术,包括监督微调、强化学习和引发不安全行为的对抗性训练,然后进行消除不安全行为的训练。后门行为在最大的模型和经过训练以产生欺骗训练过程的思想链推理的模型中最为持久,即使思想链被蒸馏掉,这种持久性仍然存在。此外,我们发现对抗性训练不是删除后门,而是可以教会模型更好地识别其后门触发器,从而有效隐藏不安全行为。 |

| From Pampas to Pixels: Fine-Tuning Diffusion Models for Gaúcho Heritage Authors Marcellus Amadeus, William Alberto Cruz Casta eda, Andr Felipe Zanella, Felipe Rodrigues Perche Mahlow 生成式人工智能已经在社会中普遍存在,在各个领域都取得了显着的进步。特别是在文本到图像 TTI 模型领域,潜在扩散模型 LDM 展示了基于文本提示生成视觉内容的卓越能力。本文探讨了 LDM 在代表当地文化概念、历史人物和濒危物种方面的潜力。在本研究中,我们以巴西南里奥格兰德州的文化遗产为例。我们的目标是帮助人们更广泛地理解生成模型如何帮助捕捉和保护地区的文化和历史特征。本文概述了该方法,包括主题选择、数据集创建和微调过程。结果展示了生成的图像,以及每个概念的挑战和可行性。 |

| LLM4PLC: Harnessing Large Language Models for Verifiable Programming of PLCs in Industrial Control Systems Authors Mohamad Fakih, Rahul Dharmaji, Yasamin Moghaddas, Gustavo Quiros Araya, Oluwatosin Ogundare, Mohammad Abdullah Al Faruque 尽管大型语言模型法学硕士已经在自动代码生成领域确立了主导地位,但它们并非没有缺点。相关问题主要涉及生成代码缺乏执行保证、缺乏可解释性以及对基本但小众编程语言的次优支持。最先进的法学硕士(例如 GPT 4 和 LLaMa2)无法为由可编程逻辑控制器 PLC 操作的工业控制系统 ICS 生成有效的程序。我们提出 LLM4PLC,这是一种用户引导的迭代管道,利用用户反馈和外部验证工具(包括语法检查器、编译器和 SMV 验证器)来指导 LLM 的生成。我们通过创建和使用 LoRA 来采用即时工程和模型微调,进一步增强 LLM 的生成潜力。我们使用 FischerTechnik Manufacturing TestBed MFTB 验证该系统,说明法学硕士如何从生成有结构缺陷的代码发展到为工业应用生成可验证的正确程序。我们在 GPT 3.5、GPT 4、Code Llama 7B、微调的 Code Llama 7B 模型、Code Llama 34B 和微调的 Code Llama 34B 模型上运行了完整的测试套件。所提出的管道将生成成功率从 47 提高到 72 ,专家调查代码质量从 2.25 10 提高到 7.75 10。为了促进开放研究,我们分享完整的实验设置、LLM 微调权重以及 |

| Automated Assessment of Students' Code Comprehension using LLMs Authors Priti Oli, Rabin Banjade, Jeevan Chapagain, Vasile Rus 评估学生的答案,特别是自然语言答案是教育领域的一项关键挑战。机器学习的进步,包括基于变压器的模型,例如大型语言模型法学硕士,已经在各种自然语言任务中取得了重大进展。然而,在跨不同任务评估法学硕士的趋势不断增长的背景下,在自动答案评估领域评估法学硕士并没有受到太多关注。为了解决这一差距,我们探索了使用法学硕士对学生的简短和开放式答案进行自动评估的潜力。 |

| Chinese Abs From Machine Translation |

Papers from arxiv.org

更多精彩请移步主页

pic from pexels.com