论文全称:通过知识集成增强语义表达

1. motivation

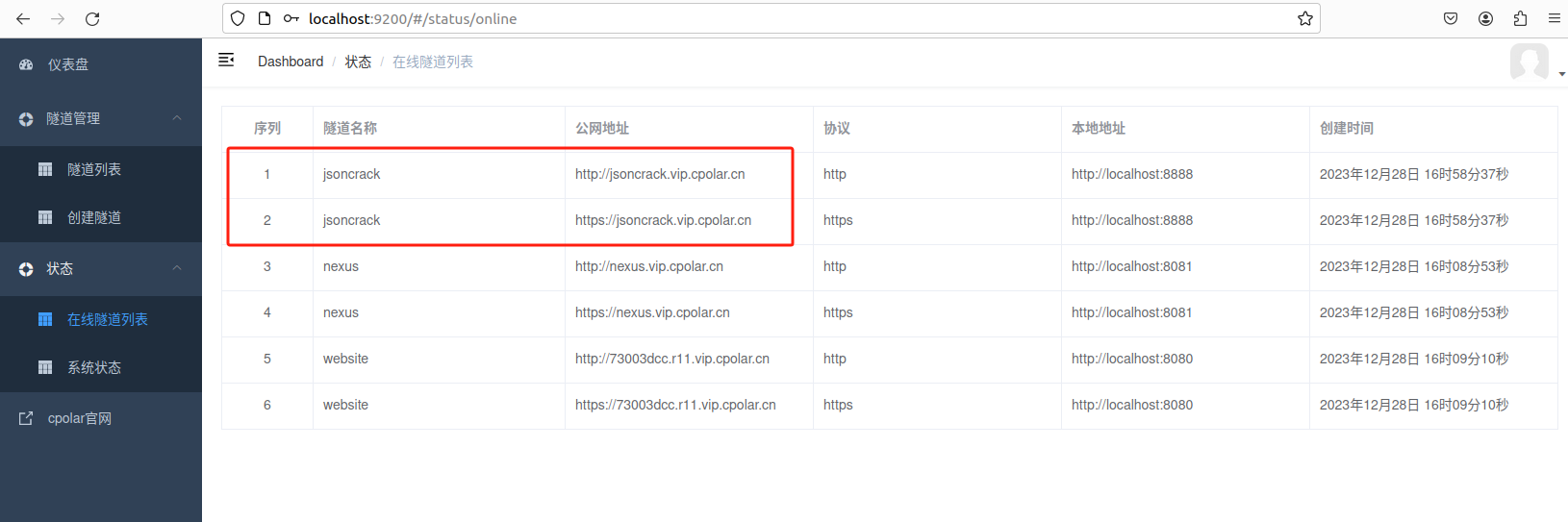

ERNIE 目的在于通过知识屏蔽策略增强语言表示,其中屏蔽策略包括实体级屏蔽(Entity-level strategy)和短语级屏蔽(Phrase-level strategy)。 entity-level 策略通常会掩盖由多个单词组成的实体; Phrase-level 策略会掩盖由几个词共同作为概念单元的整体短语。

2. 模型

论文中对于不同任务使用的模型分为两种,原始Bert结构,和本文针对‘对话数据’额外提出的Dialogue Language Model。

非对话数据:模型整体结构没有改变,依然是Bert的结构,输入仍然是3个部分 token embedding + segment embedding + position embedding,整句话的第一个token是[CLS]。

对话数据:Dialogue Language Model,segment embedding --> dialogue embedding,Q=question;A=answer

3. 知识屏蔽策略,一起训练?还是多阶段依次训练?

3.1 Basic-level Masking(Bert)

将句子视为基本语言单元的序列,对于英语,基本语言单元是单词;对于中文,基本语言单元是汉字。

在训练过程中,随机屏蔽 15% 的基本语言单元,并使用句子中的其他基本单元作为输入,并训练一个transformer来预测Mask的部分。

基于Basic-level Masking,获得基本的单词表示。 因为它是在基本语义单元的随机掩码上训练的,高级语义知识很难完全建模。

3.2 短语阶段 Phrase-Level Masking

第二阶段是使用短语级掩码。短语是一小组单词或字符,它们共同充当一个概念单元。

对于英语,使用词法分析和分块工具来获取句子中短语的边界,并使用一些语言切分工具来获取其他语言(例如中文)的单词 / 短语信息。

随机选择句子中的几个短语,对同一短语中的所有基本单元进行掩码和预测。 在这个阶段,短语信息被编码到词嵌入中。

3.3 实体阶段 Entity-Level Masking

名称实体包含人、地点、组织、产品等,可以用专有名称表示,这一步类似于‘成分切分’ or ‘命名实体识别’。

与短语掩码阶段一样,首先分析句子中的命名实体,然后对实体中的所有槽进行掩蔽和预测。

4. 遗留问题

看论文描述,将3种掩码策略混在一起使用,论文并未有具体描述

![WSL—子系统安装及其相关配置和[诸多报错问题]-修改默认安装位置](https://img-blog.csdnimg.cn/img_convert/a9112f44deb031dfa998847cfc60651d.png)