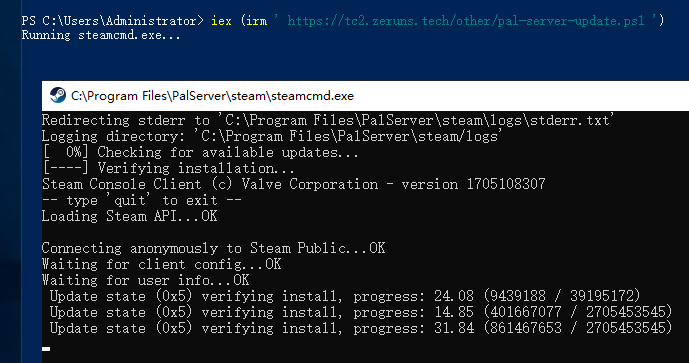

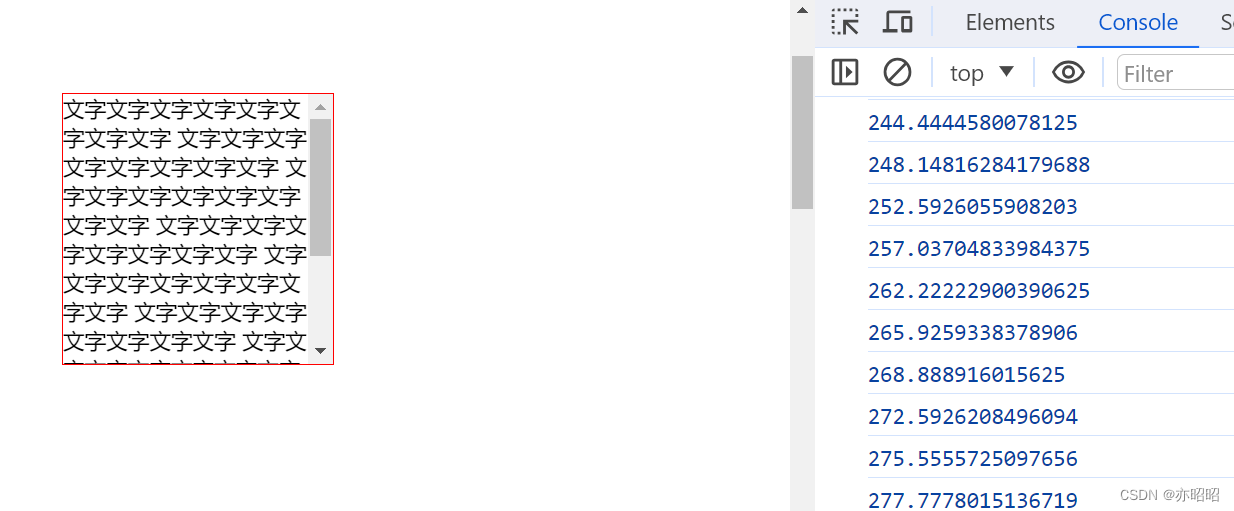

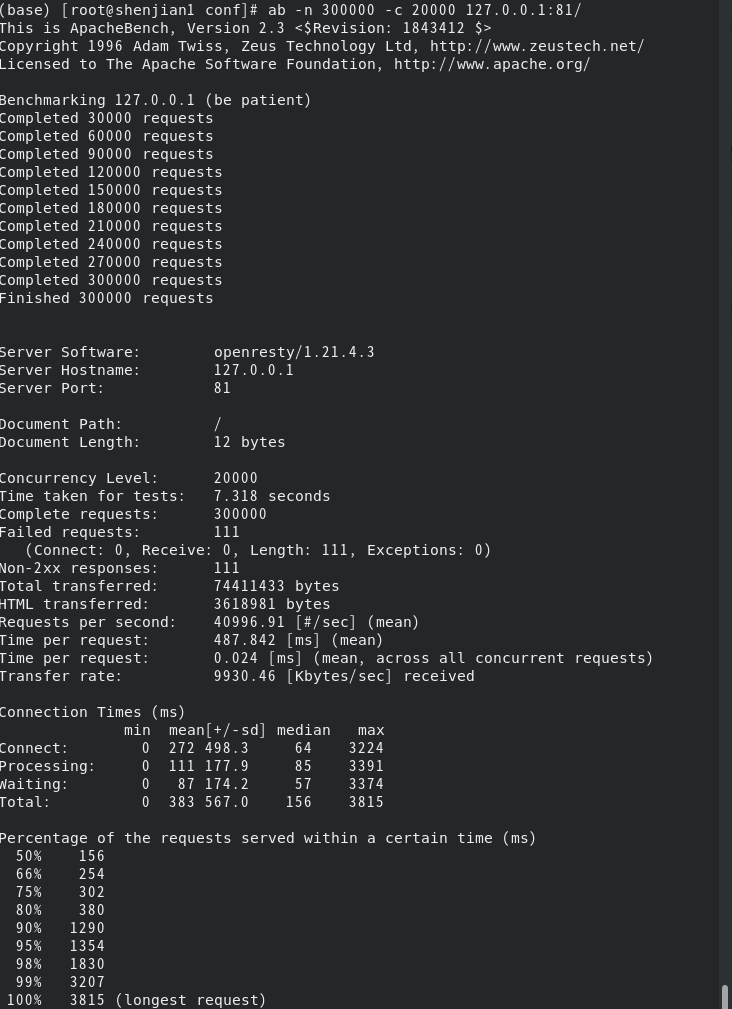

下图解决了上文所说的请求过多报错问题

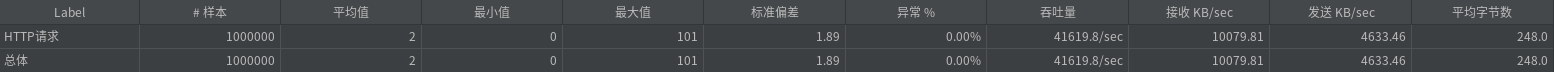

如图所示,系统支持30W请求, 并发2W

1. /etc/sysctl.conf配置如下

vm.swappiness = 0

# 表示开启SYNCookies。当出现SYN等待队列溢出时,启用cookies来处理,可防范少量SYN>攻击,默认为0,表示关闭

# 此参数是为了防止洪水攻击的,但对于大并发系统,要禁用此设置

net.ipv4.tcp_syncookies = 1

# 在 CentOS 8 中,net.ipv4.tcp_tw_reuse 和 net.ipv4.tcp_tw_recycle 参数已被移除>。相反,CentOS 8 使用了新的 TCP 栈实现,其中 TIME-WAIT sockets 的快速回收是默认>启用的

# 表示开启重用。允许将TIME-WAITsockets重新用于新的TCP连接,默认为0,表示关闭

#net.ipv4.tcp_tw_reuse = 1

# 表示开启TCP连接中TIME-WAITsockets的快速回收,默认为0,表示关闭

#net.ipv4.tcp_tw_recycle = 1

# 修改系統默认的TIMEOUT 时间

net.ipv4.tcp_fin_timeout = 30

# 表示当keepalive起用的时候,TCP发送keepalive消息的频度。缺省是2小时,改为20分

net.ipv4.tcp_keepalive_time = 1200

# 表示用于向外连接的端口范围。缺省情况下很小,改为1024到65535

net.ipv4.ip_local_port_range = 1024 65535

# 表示SYN队列的长度,默认为1024,加大队列长度为65535,可以容纳更多等待连接的网络连接数

net.ipv4.tcp_max_syn_backlog = 365535

# 表示系统同时保持TIME_WAIT的最大数量,如果超过这个数字,TIME_WAIT将立刻被清除并打印警告信息。默认为180000,改为5000。此项参数可以控制TIME_WAIT的最大数量,只要>超出了

net.ipv4.tcp_max_tw_buckets = 380000

# 每个网络接口接收数据包的速率比内核处理这些包的速率快时,允许送到队列的数据包的

最大数目。

net.core.netdev_max_backlog = 332768

# 例如web应用中listen函数的backlog默认会给我们内核参数的net.core.somaxconn限制到128,而nginx定义的NGX_LISTEN_BACKLOG默认为511,所以有必要调整这个值

net.core.somaxconn = 300000

net.core.wmem_default = 8388608

net.core.rmem_default = 8388608

# 最大socket读buffer,可参考的优化值:873200

net.core.rmem_max = 16777216

# 最大socket写buffer,可参考的优化值:873200

net.core.wmem_max = 16777216

# 时间戳可以避免序列号的卷绕。一个1Gbps的链路肯定会遇到以前用过的序列号。时间戳>能够让内核接受这种“异常”的数据包。这里需要将其关掉

net.ipv4.tcp_timestamps = 0

# 为了打开对端的连接,内核需要发送一个SYN并附带一个回应前面一个SYN的ACK。也就是>所谓三次握手中的第二次握手。这个设置决定了内核放弃连接之前发送SYN+ACK包的数量

net.ipv4.tcp_synack_retries = 2

# 在内核放弃建立连接之前发送SYN包的数量

net.ipv4.tcp_syn_retries = 2

# TCP写buffer,可参考的优化值:8192 436600 873200

net.ipv4.tcp_wmem = 786432 1048576 1572864

# TCP读buffer,可参考的优化值:32768 436600 873200

net.ipv4.tcp_rmem = 786432 1048576 1572864

# 同样有3个值,意思是:

# net.ipv4.tcp_mem[0]:低于此值,TCP没有内存压力。

# net.ipv4.tcp_mem[1]:在此值下,进入内存压力阶段。

# net.ipv4.tcp_mem[2]:高于此值,TCP拒绝分配socket

# 上述内存单位是页,而不是字节。可参考的优化值是:786432 1048576 1572864

# 系统中最多有多少个TCP套接字不被关联到任何一个用户文件句柄上

net.ipv4.tcp_max_orphans = 3276800

# 如果套接字由本端要求关闭,这个参数决定了它保持在FIN-WAIT-2状态的时间。对端可以出错并永远不关闭连接,甚至意外当机。缺省值是60秒。2.2 内核的通常值是180秒,你可>以按这个设置,但要记住的是,即使你的机器是一个轻载的WEB服务器,也有因为大量的死>套接字而内存溢出的风险,FIN-WAIT-2的危险性比FIN-WAIT-1要小,因为它最多只能吃掉1.5K内存,但是它们的生存期长些。

net.ipv4.tcp_fin_timeout = 30

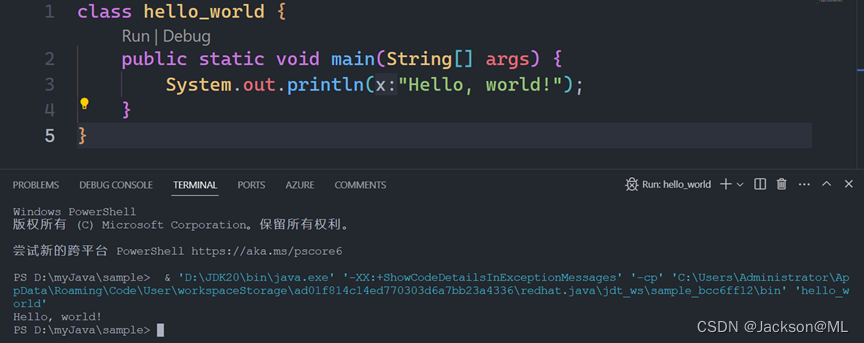

2. nginx.conf配置如下

worker_processes 15;

#error_log logs/error.log;

#error_log logs/error.log notice;

#error_log logs/error.log info;

#pid logs/nginx.pid;

events {

worker_connections 30000;

}

http {

include mime.types;

default_type application/octet-stream;

sendfile on;

# 如果连接超时发生在客户端发送请求到 OpenResty 时,你可以尝试增加这两个配置>项的值

#client_body_timeout 60s;

#client_header_timeout 60s;

# 静态页面无需开启长连接

keepalive_timeout 0;

#keepalive_timeout 65;

# 设置与后端服务器建立连接的超时时间

#proxy_connect_timeout 5s;

# 设置向后端服务器发送请求的超时时间

#proxy_send_timeout 10s;

# 设置从后端服务器接收响应的超时时间

#proxy_read_timeout 15s;

#gzip on;

server {

listen 81;

server_name localhost;

#charset koi8-r;

#access_log logs/host.access.log main;

location / {

root html;

index index.html index.htm;

}

}

}

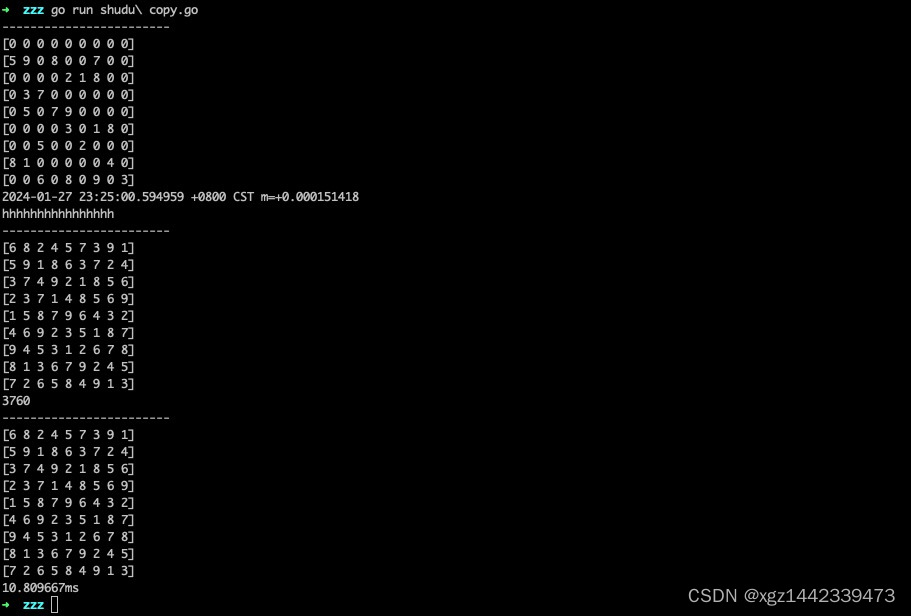

3. 并发10W压测

我们选用Jmeter压测工具

- 请求100W次,并发100用户,吞吐量可达4W

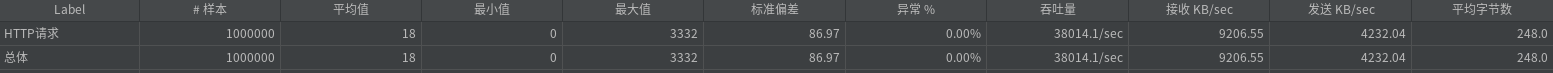

- 请求100W次,并发1000用户,吞吐量可达3.8W

- 请求100W次,并发1W用户,吞吐量可达3.4W

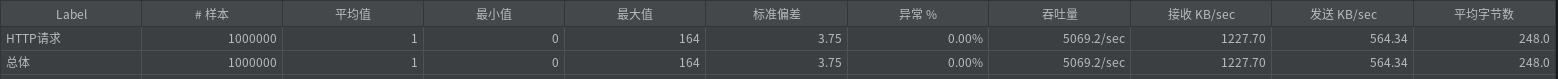

- 请求100W次,并发10W用户,吞吐量可达5千,负载20左右

参数配置这块仍有许多待完善地方,望有相关工作实际经验大佬们不吝赐教