01 爬虫基本原理讲解

1.什么是爬虫:请求网站并提取数据的自动化程序

2.爬虫基本流程:

- 发起请求:通过HTTP库向目标站点发起请求,即发送一个Request,请求可以包含额外的headers等信息,等待服务器响应。

- 获取响应内容:如果服务器能正常响应,会得到一个Response,Response的内容便是所要获取的页面内容,类型可能有HTML,Json字符串,二进制数据(如图片视频)等类型。

- 解析内容:得到的内容可能是HTML,可以用正则表达式,网页解析库进行解析。可能是Json,可以直接转换为Json对象解析,可能是二进制数据,可以做保存或者进一步的处理。

- 保存内容:保存形式多样,可以存为文本,也可以保存至数据库,或者保存特定格式的文件。

3.Request与Response:

- 浏览器就发送消息给该网址所在的服务器,这个过程叫做HTTP Request。

- 服务器收到浏览器发送的消息后,能够根据浏览器发送消息的内容,做相应处理,然后把消息回传给浏览器。这个过程叫做HTTP Response。

- 浏览器收到服务器的Response信息后,会对信息进行相应处理,然后展示。

4.request包含的内容

- 请求方式:主要有GET,POST两种类型,另外还有HEAD,PUT,DELETE,OPTIONS等。

- 请求头:包含请求时的头部信息,如User-Agent,Host,Cookies等信息。

- 请求URL:URL全称统一资源定位符,如一个网页文档,一张图片,一个视频等都可以用URL唯一来确定。

- 请求体:请求时额外携带的数据,如表单提交时的表单数据。

5.Resopnse包含的内容

- 响应状态:有多种响应状态,如200代表成功,301跳转,404找不到页面,502服务器错误。

- 响应头:如内容类型,内容长度,服务器信息,设置Cookie等等。

- 响应体:最注意的部分,包含了请求资源的内容,如网页HTML,图片二进制数据等。

6.能抓怎样的数据?

- 网页文本:如HTML文档,Json格式文本等。

- 图片:获取到的是二进制文件,保存为图片格式。

- 视频:同为二进制文件,保存为视频格式即可。

- 其他:只有是能请求到的,都能获取。

7.解析方式

- 直接处理

- Json解析

- 正则表达式

- BeautifulSoup

- PyQuery

- XPath

8.怎么解决JavaScript渲染的问题?(后台请求和实际看到不一样时)

- 分析Ajax请求

- Selenium/WebDriver

- Splash

- PyV8,Ghost.py

9.怎么保存数据?

- 文本:纯文本,Json,Xml等。

- 关系型数据库:如MySQL,Oracle,SQL Server等具有结构化表结构形式存储。

- 非关系型数据库:如MongoDB,Redis等Key-Value形式存储。

- 二进制文件:如图片,视频,音频等等直接保存成特定格式即可。

02 Urllib库基本使用

1.Urllib库详解(python内置的HTTP请求库)

- urllib.request 请求模块

- urllib.error 异常处理模块

- urllib.parse url解析模块

- urllib.robotparser robots.txt解析模块

2.相比python2变化

Python2

import urllib2

response = urllib2.urlopen('http://www.baidu.com')

Python3

import urllib.request

respnse = urllib.request.urlopen('http://www.baidu.com')

3.urlopen:函数用于实现对目标url的访问

urllib.request.urlopen(url, data=None, [timeout, ]*, cafile=None, capath=None, cadefault=False, context=None)

- url 参数:目标资源在网路中的位置。可以是一个表示URL的字符串(如:http://www.pythontab.com/);也可以是一个urllib.request对象,详细介绍请跳转.

- data参数:data用来指明发往服务器请求中的额外的参数信息(如:在线翻译,在线答题等提交的内容),data默认是None,此时以GET方式发送请求;当用户给出data参数的时候,改为POST方式发送请求。

- timeout:设置网站的访问超时时间。

- cafile、capath、cadefault 参数:用于实现可信任的CA证书的HTTP请求。(基本上很少用)

- context参数:实现SSL加密传输。(基本上很少用)

import urllib.request

response = urllib.request.urlopen("http://www.baidu.com")

print(response.read().decode('utf-8'))

post请求:

ttp://httpbin.org HTTP测试的网址

import urllib.parse

import urllib.request

data = bytes(urllib.parse.urlencode(('world','hello')),encodeing='utf8')

response = urllib.request.urlopen("http://httpbin.org/post",data=data)

print(response.read())

超时的设置:

import urllib.request

response = urllib.request.urlopen("http://httpbin.org/get",timeout=1)

print(response.read().decode('utf-8'))

import socket

import urllib.request

import urllib.error

try:

response = urllib.request.urlopen("http://httpbin.org/get",timeout=0.1)

except urllib.error.URLError ad e:

if isinstance(e.reason,socket.timeout);

print("TIME OUT")

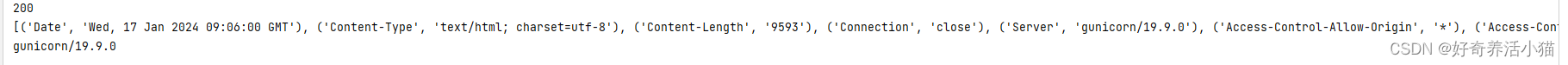

4.响应

响应类型

import urllib.request

response = urllib.request.urlopen("http://httpbin.org")

print(type(response))

状态码,响应头

import urllib.request

response = urllib.request.urlopen("http://httpbin.org")

print(response.status)

print(response.getheaders())

print(response.getheader('Server'))

响应内容

import urllib.request

response = urllib.request.urlopen("http://httpbin.org")

print(response.read().decode('utf-8'))

想要一些更复杂的请求,需要用到request

5 Request

urllib.request.Request(url, data=None, headers={}, origin_req_host=None, unverifiable=False, method=None)

- url用于请求URL,这是必传参数,其他都是可选参数。

- data如果要传,必须传bytes(字节流)类型的。如果它是字典,可以先用urllib.parse模块里的urlencode()编码。

- headers是一个字典,它就是请求头,我们可以在构造请求时通过headers参数直接构造,也可以通过调用请求实例add_header()方法添加。

添加请求头最常用的用法就是通过修改User-Agent来伪装浏览器,默认的User-Agent是Python-urllib,我们可以通过修改它来伪装浏览器。 - origin_req_host指的是请求方的host名称或者IP地址。

- unverifiable表示这个请求是否是无法验证的,默认是False,意思就是说用户没有足够权限来选择接收这个请求的结果。例如,我们请求一个HTML文档中的图片,但是我们没有自动抓取图像的权限,这时unverifiable的值就是True`。

- method是一个字符串,用来指示请求使用的方法,比如GET、POST和PUT等。

import urllib.request

request = urllib.request.Request("https://python.org")

response = urllib.request.urlopen(request)

print(response.read().decode('utf-8'))

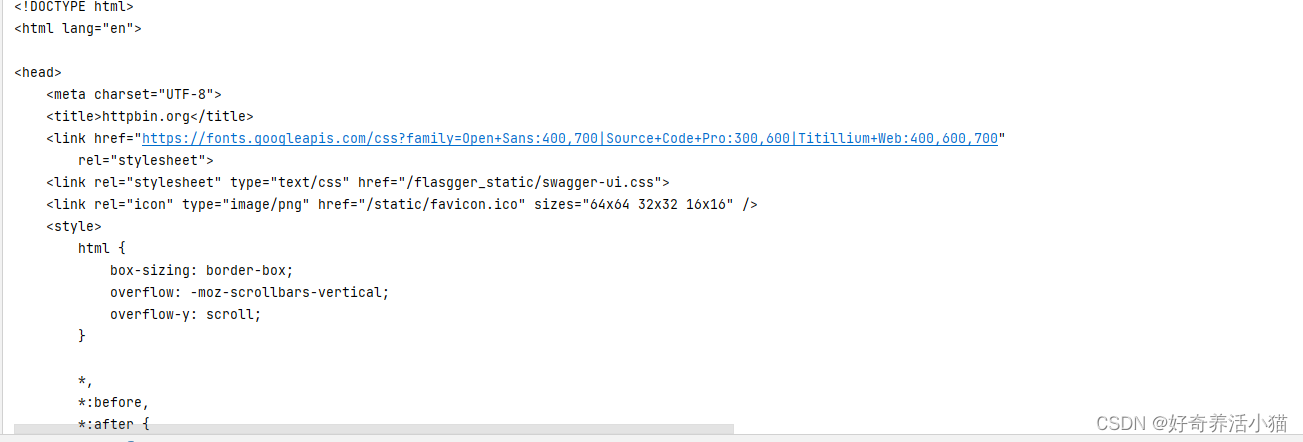

增加headers信息:

from urllib import request, parse

url = 'http://httpbin.org/post'

headers = {

'User-Agent': 'Mozilla/4.0 (compatible; MSIE 5.5; Windows NT)',

'Host': 'httpbin.org'

}

dict = {

'name': 'Germey'

}

data = bytes(parse.urlencode(dict), encoding='utf8')

req = request.Request(url=url, data=data, headers=headers, method='POST')

response = request.urlopen(req)

print(response.read().decode('utf-8'))

通过4个参数构造了一个请求,其中url即请求URL,headers中指定了User-Agent和Host,参数data用urlencode()和bytes()方法转成字节流。另外,指定了请求方式为POST。

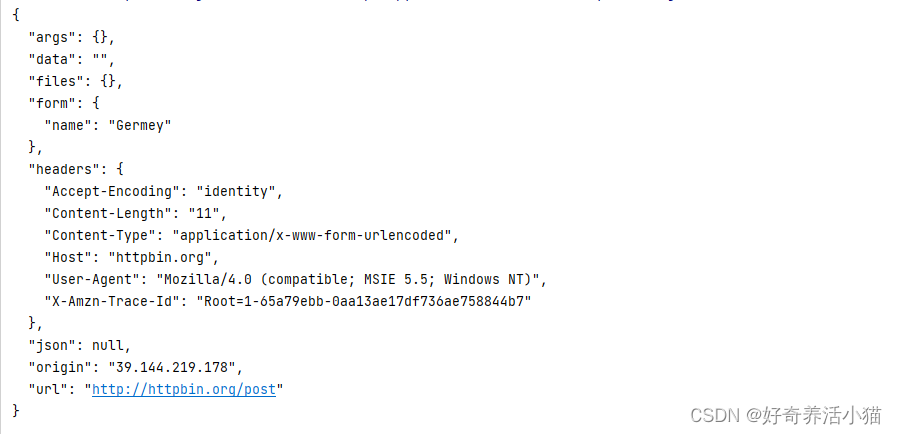

from urllib import request,parse

#构造一个POST请求

url='http://httpbin.org/post'

dict={

'name':'Germey'

}

data=bytes(parse.urlencode(dict),encoding='utf8')#fontdata数据

req=request.Request(url=url,data=data,method='POST')#构建一个Request()的一个结构

req.add_header('User-Agent','................')#用add_header方法来添加header信息

response = request.urlopen(req)

print(response.read().decode('utf-8'))

add_header()方法作为添加header的另一种方式,可以用来比较复杂的情况,比如要添加许多键值对,那么可以用一个for循环来不断调用这个方法,这也是比较方便的

6.Handler

Headler相当于一个辅助工具,来帮助我们处理一些额外的工作,比如FTP、Cache等等操作,我们都需要借助Headler来实现。比如在代理设置的时候,就需要用到一个ProxyHandler。更多的用法,请参阅官方文档。

代理

用来对ip地址进行伪装成不同地域的,防止ip在爬虫运行时被封掉。

from urllib import request

proxy_handler = request.ProxyHandler( #构建ProxyHandler,传入代理的网址

{'http':'http://127.0.0.1:9743',

'https':'https://127.0.0.1:9743'

}) #实践表明这个端口已经被封了,这里无法演示了

opener = request.build_opener(proxy_handler)#再构建一个带有Handler的opener

response = opener.open('http://www.baidu.com')

print(response.read())

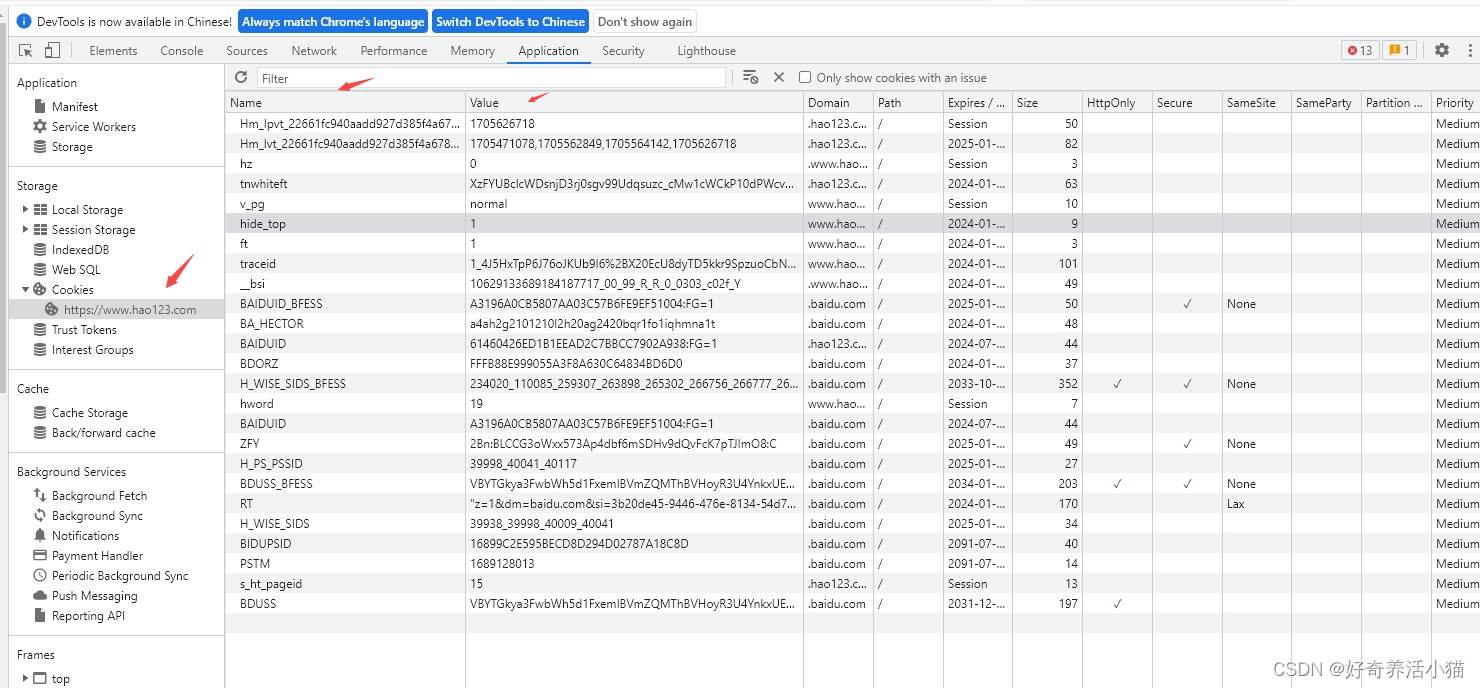

Cookie

Cookie是在客户端保存的用来记录用户身份的文本文件。

在爬虫时,主要是用来维护登录状态,这样就可以爬取一些需要登录认证的网页了。

from urllib import request

from http import cookiejar

cookie =cookiejar.CookieJar()#将cookie声明为一个CookieJar对象

handler = request.HTTPCookieProcessor(cookie)

opener = request.build_opener(handler)

response =opener.open('https://www.hao123.com')#通过opener传入,并打开网页

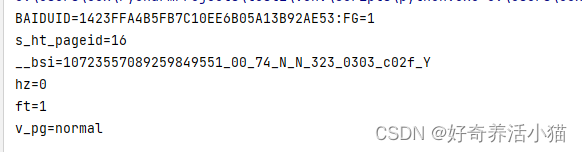

for item in cookie:#通过遍历把已经赋值的cookie打印出来

print(item.name+'='+item.value)#通过item拿到每一个cookie并打印

Cookie的保存

我们还可以把cookie保存成文本文件,若cookie没有失效,我们可以从文本文件中再次读取cookie,在请求时把cookie附加进去,这样就可以继续保持登录状态了。

from urllib import request

from http import cookiejar

filename="cookie.txt"

cookie=cookiejar.MozillaCookieJar(filename)

#把cookie声明为cookiejar的一个子类对象————MozillaCookieJar,它带有一个save方法,可以把cookie保存为文本文件

handler=request.HTTPCookieProcessor(cookie)

opener=request.build_opener(handler)

response=opener.open('https://www.hao123.com')

cookie.save(ignore_discard=True,ignore_expires=True)#调用save方法

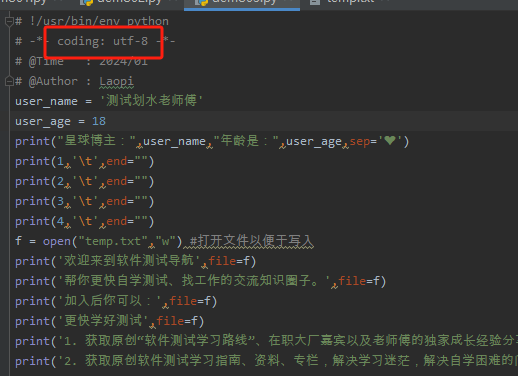

执行代码后,我们就可以在运行目录下找到已经保存好的cookie文本文件了:

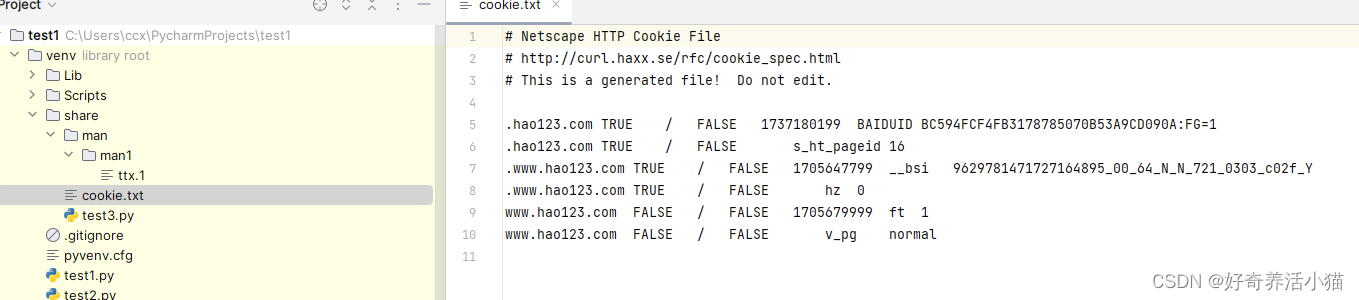

还有另外一种格式:

在上面那段代码的基础上,换一个子类对象就可以了:

cookie=cookiejar.LWPCookieJar(filename)

from urllib import request

from http import cookiejar

filename="cookie.txt"

cookie=cookiejar.LWPCookieJar(filename)

#把cookie声明为cookiejar的一个子类对象————MozillaCookieJar,它带有一个save方法,可以把cookie保存为文本文件

handler=request.HTTPCookieProcessor(cookie)

opener=request.build_opener(handler)

response=opener.open('https://www.hao123.com')

cookie.save(ignore_discard=True,ignore_expires=True)#调用save方法

Cookie的读取

我们可以选择相对应的格式来完成读取。以上面的LWP格式为例:

from urllib import request

from http import cookiejar

cookie=cookiejar.LWPCookieJar() #z注意选择相应的格式,这里是LWP

cookie.load('cookie.txt',ignore_discard=True,ignore_expires=True)#load方法是读取的关键

handler=request.HTTPCookieProcessor(cookie)

opener=request.build_opener(handler)

response=opener.open('http://www.baidu.com')

print(response.read().decode('utf-8'))

以上的代码就可以完成读取了。这样,我们就可以在对网页进行请求时,自动把之前的cookie附着进去,以保持一个登录的状态了。

7.异常处理

这是属于urllib的另一大模块

from urllib import request,error

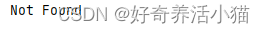

#我们试着访问一个不存在的网址

try:

response = request.urlopen('http://www.cuiqingcai.com/index.html')

except error.URLError as e:

print(e.reason)#通过审查可以查到我们捕捉的异常是否与之相符

可以看到,返回了错误信息。这样的异常处理可以保证爬虫在工作时不会轻易中断。

那么,urllib可以捕捉哪些异常呢?详见官方文档。

其实一般碰到有两个:HTTP和URL。我们一般只需要捕捉这两个异常就可以了。

from urllib import request,error

#我们试着访问一个不存在的网址

try:

response = request.urlopen('http://www.cuiqingcai.com/index.html')

except error.HTTPError as e:#最好先捕捉HTTP异常,因为这个异常是URL异常的子类

print(e.reason,e.code,e.headers,sep='\n')

except error.URLError as e:

print(e.reason)

else:

print('Request Successfully!')

如上,打印出了错误的相关信息。

此外,e.reason也是一个类,它可以得到异常的类型。

我们试着看看:

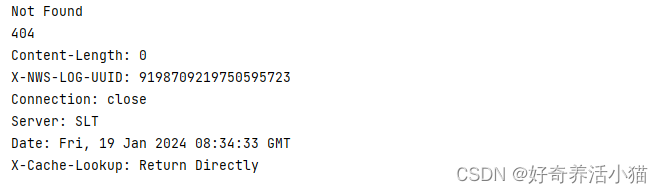

from urllib import request,error

import socket

try:

response = request.urlopen('http://www.baidu.com',timeout = 0.01)#超时异常

except error.URLError as e:

print(type(e.reason))

if isinstance(e.reason,socket.timeout):#判断error类型

print('TIME OUT')

8.URL解析

这是一个工具性质的模块,即拿即用就行。

官方文档

urlparse

这个方法将将url进行分割,分割成好几个部分,再依次将其复制。

urllib.parse.urlparse(urlstring,scheme=‘’,allow_fragments = True)

#分割成(url,协议类型,和#后面的东西)

urllib.parse.urlparse将一个url解析成6个组件,返回一个6个项目名元组:scheme(协议), netloc(域名), path(相对路径),params(参数), query(请求), fragment(片段识别)

来看具体的例子:

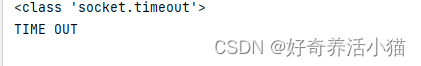

from urllib.parse import urlparse

result = urlparse('https://www.baidu.com/s?wd=urllib&ie=UTF-8')

print(type(result), result) # <class 'urllib.parse.ParseResult'>

# 无协议类型指定,自行添加的情况

result1 = urlparse('www.baidu.com/s?wd=urllib&ie=UTF-8', scheme='https')

print(result1)

# 有指定协议类型,默认添加的情况?

result2 = urlparse('http://www.baidu.com/s?wd=urllib&ie=UTF-8', scheme='https')

print(result2)

# allow_fragments参数使用

result3 = urlparse('http://www.baidu.com/s?#comment', allow_fragments=False)

print(result3)

result4 = urlparse('http://www.baidu.com/s?wd=urllib&ie=UTF-8#comment', allow_fragments=False)

print(result4)

# allow_fragments=False表示#后面的东西不能填,原本在fragment位置的参数就会往上一个位置拼接,可以对比result1和result2的区别

从这个例子我们也可以知道,一个url可以分成6个字段。

urlunparse(urlparse的反函数)

这个函数用来拼接url。

看看这个例子:

from urllib.parse import urlunparse

#注意即使是空符号也要写进去,不然会出错

data = ['http', 'www.baidu.com', 'index.html','user','a=6' 'comment',' ']

print(urlunparse(data))

urljoin

这个函数用来拼合url。

通过例子感受以下:

以后面的参数为基准,会覆盖掉前面的字段。如果后面的url,存在空字段而前面的url有这个字段,就会用前面的作为补充。

from urllib.parse import urljoin

print(urljoin('http://www.baidu.com','FQA.html'))

#http://www.baidu.com/FQA.html

print(urljoin('http://www.baidu.com','http://www.caiqingcai.com/FQA.html'))

#http://www.caiqingcai.com/FQA.html

print(urljoin('https://www.baidu.com/about.html','http://www.caiqingcai.com/FQA.html'))

#http://www.caiqingcai.com/FQA.html

print(urljoin('http://www.baidu.com/about.html','https://www.caiqingcai.com/FQA.html'))

#https://www.caiqingcai.com/FQA.html

urlencode

from urllib.parse import urlencode

params = {

'name': 'zhuzhu',

'age': '23'

}

base_url = 'http://www.baidu.com?'

url = base_url + urlencode(params) # 将params对象编码转换

print(url)

9.robotparser

用来解析robot.txt。用的比较少,这里不再赘述。详情参考

![[足式机器人]Part2 Dr. CAN学习笔记- 最优控制Optimal Control Ch07-2 动态规划 Dynamic Programming](https://img-blog.csdnimg.cn/direct/718639af45714c9496ccc3df795adbff.png#pic_center)