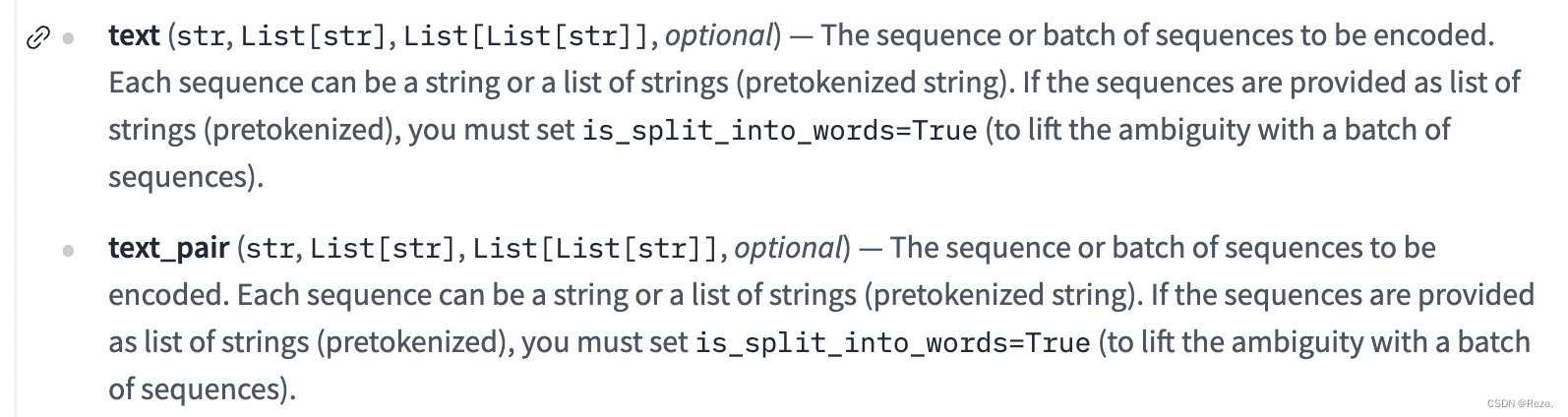

tokenizer有一个名为text pair的参数,这个参数在做NLI任务的时候很有用,因为输入不是一个single sentence,而是sentence pair。

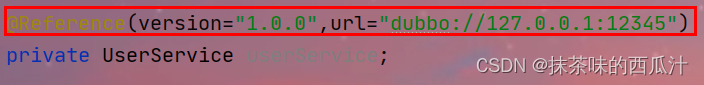

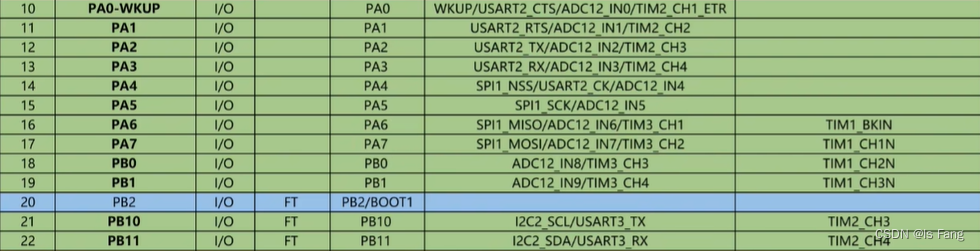

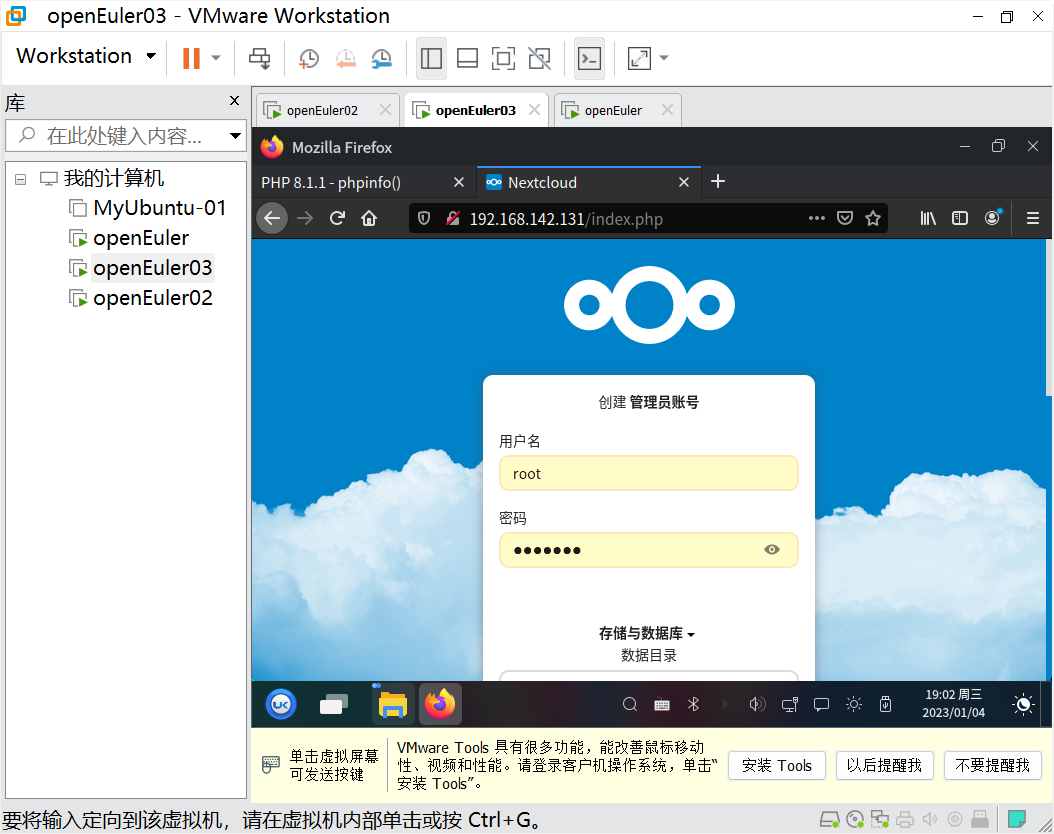

但是这个参数的类型让人非常confused,而且同时还有一个text参数,让人不知道传入的sentence pair到底应该遵循一个什么格式,如下图所示:

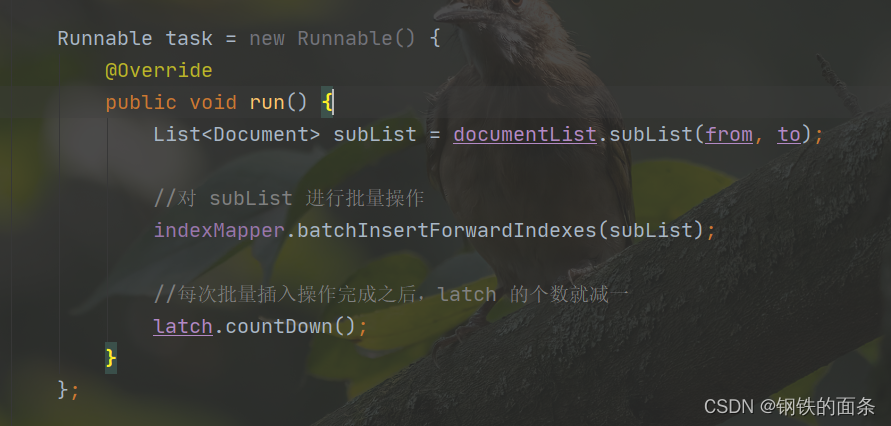

正确的用法如下:

也就是说,如果只是单个sentence pair,直接传入两个str;

但如果要batchfy,那应该传入一个List【List【str】】。这个list长度为batch_size,里面的每一个样本就是一个sentence pair,用list存储,而且只用传这一个参数,不用text和text_pair都传入。

另外一个问题是token_type_ids。由于常规的BERT预训练时使用NSP任务,所以,如果用BERT的tokenizer去做sentence pair classification,它会返回token_type_ids;而像Roberta这种,就不需要token_type_ids,其tokenizer自然也就不会返回token_type_ids。

所以直接用类似下面这种写法就不会出错(直接把tokenize之后的dict,传给model就行):

inputs = tokenizer(*(sen1,sen2), truncation=True)

#print(inputs)

inputs = dict([(k,torch.tensor(v).unsqueeze(0).to(f"cuda:{args.gpu}")) for k,v in inputs.items()])

outputs = model(**inputs)

参考:

huggingface issue-#7674