大家好,今天分享一个非常有意思且十分简单的python库——mediapipe库。该库集成了大量的深度学习模型,短短几行代码,就可以快速实现一个炫酷的实例,本文就以手势检测为例,展示一下这个强大的开源库。

mediapipe由Google开发,集合了人脸识别、姿势检测、图像分割、目标识别等多种深度学习模型,主要有以下几个特点:

- 端到端加速:内置快速 ML 推理和处理加速,即使在普通硬件上也是如此

- 一次构建,随处部署:统一解决方案适用于Android、iOS、桌面、Web和loT

- 即用型解决方案:展示框架全部功能的尖端 ML 解决方案

- 免费和开源:Apache 2.0 下的框架和解决方案,完全可扩展和可定制

mediapipe中集合的模型,包含人脸识别、面部检测、手势检测、即时运动追踪、姿势检测、物体识别等,下图对其进行展示。

|

|

|

|

| 人脸识别 | 面部检测 | 手势检测 |

|

|

|

|

| 即时运动追踪 | 姿势检测 | 物体识别 |

|

|

|

|

| 头发分割 | 3D识别 | 目标追踪 |

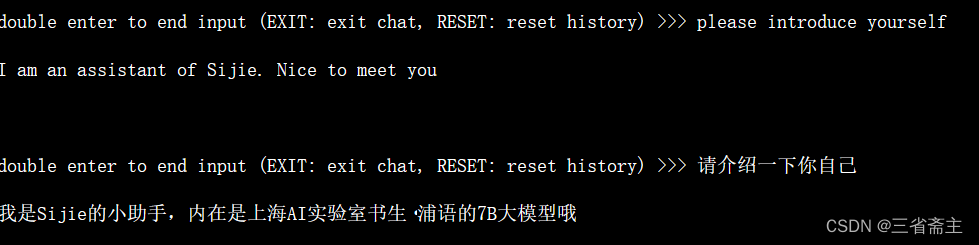

下面以手势检测为例,介绍一下mediapipe的用法。

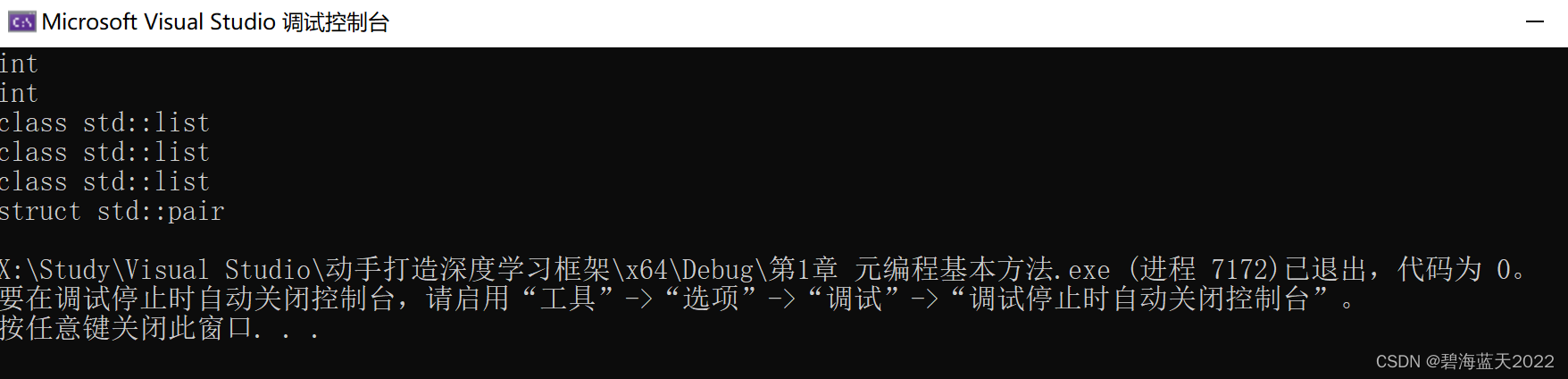

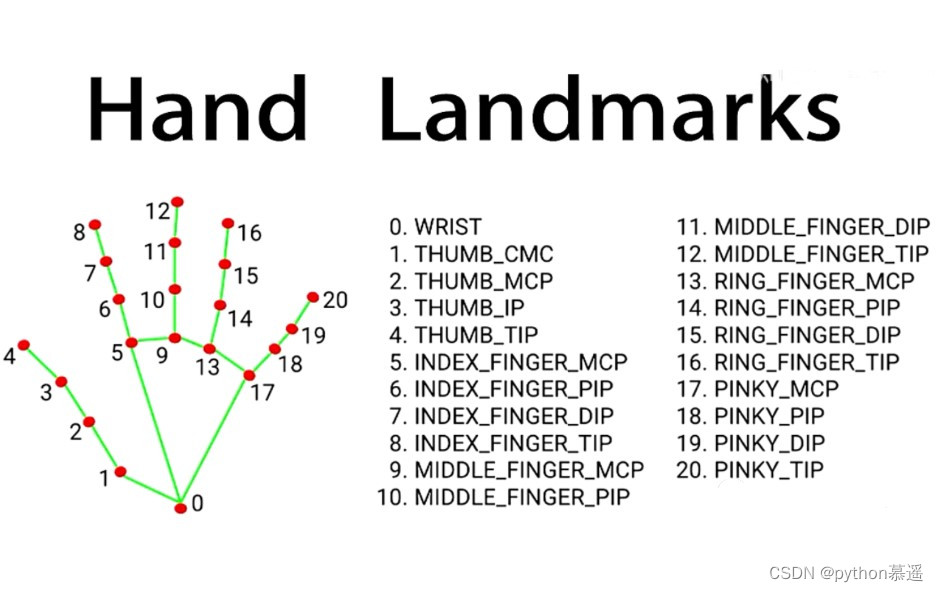

首先定义一个手势检测的模型,第7、8行分别是手21个点的样式和点与点连线的样式,21个关键点的分布如图所示。

import cv2

import mediapipe as mp

cap = cv2.VideoCapture(0,cv2.CAP_DSHOW)

mpHands = mp.solutions.hands

hands = mpHands.Hands()

#设置线和点的样式

handLmsStyle = mpDraw.DrawingSpec(color = (0,0,255),thickness=5)

handConnStyle = mpDraw.DrawingSpec(color = (0,255,0),thickness=10)

使用while循环,处理每一帧图像即可,就是这么简单,第7行的if判断,如果检测到了手,那么就遍历手势检测的21个点,然后使用第10行的函数画上线和点即可。

while True:

#获取每一帧图像

ret, img = cap.read()

if ret:

imgRGB = cv2.cvtColor(img,cv2.COLOR_BGR2RGB)

res = hands.process(imgRGB)

if res.multi_hand_landmarks:

for handLms in res.multi_hand_landmarks:

#画线

mpDraw.draw_landmarks(img,handLms,mpHands.HAND_CONNECTIONS,handLmsStyle,handConnStyle)

cv2.imshow('img',img)

if cv2.waitKey(1) == ord('q'):

break直接运行代码,即可实现手势检测。而且,官方有详细的文档,如感兴趣可以自行进行学习,并调整一些参数让程序更加符合某些实际需求。