以下内容来自从零开始机器人SLAM知识星球 每日更新内容

点击领取学习资料 → 机器人SLAM学习资料大礼包

#论文##开源代码# Deep IMU Bias Inference for Robust Visual-Inertial Odometry with Factor Graphs

论文地址:https://arxiv.org/abs/2211.04517

作者单位:牛津大学

开源代码:https://github.com/ori-drs/allan_variance_ros

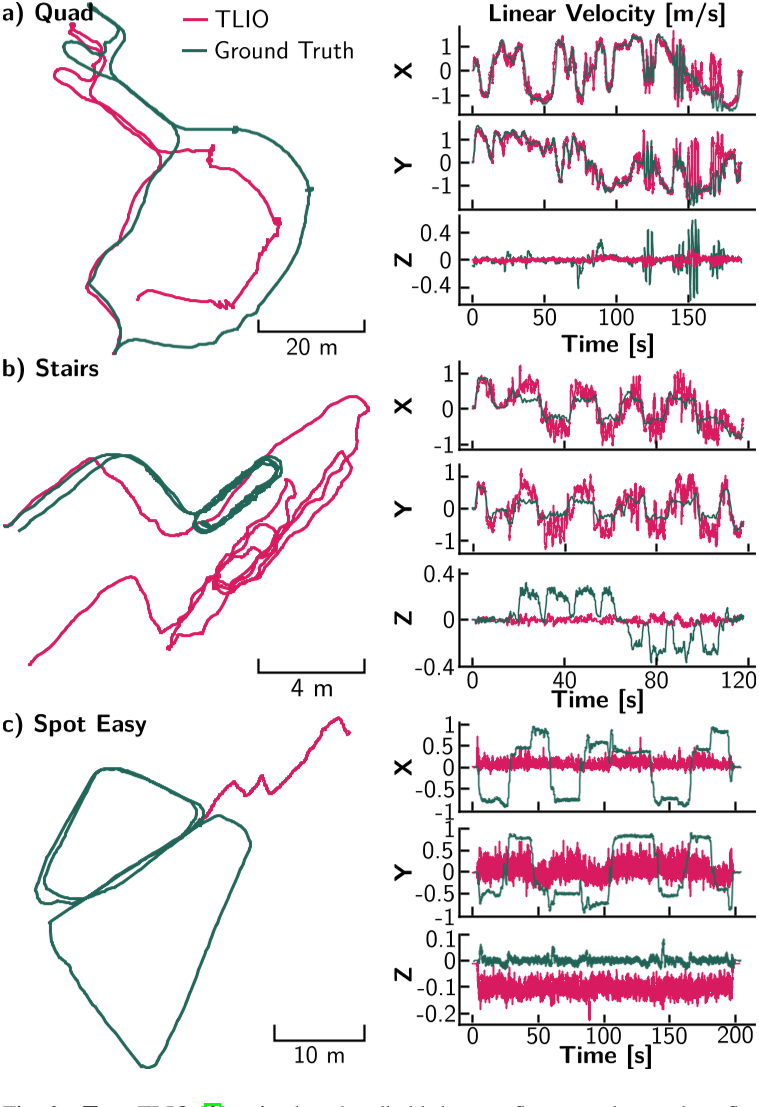

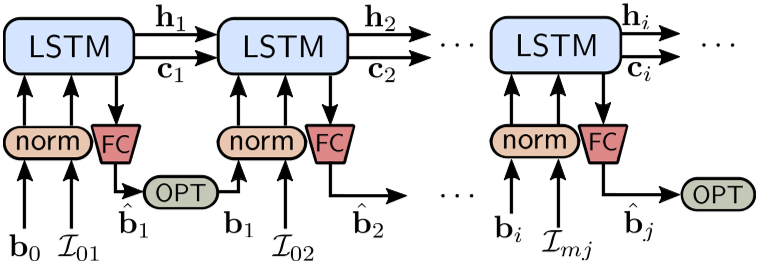

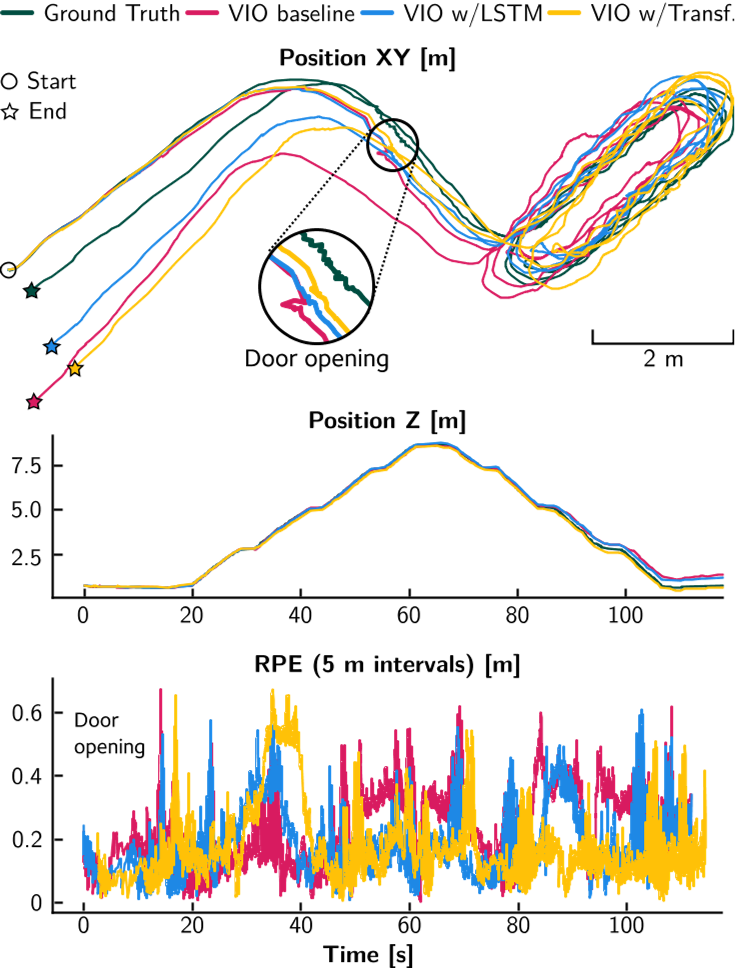

视觉惯性里程计(VIO)是最成熟的移动平台状态估计方法之一。然而,当视觉跟踪失败时,由于惯性数据过程中的快速误差积累,VIO 算法会迅速发散。该误差通常被建模为加性高斯噪声和缓慢变化的偏差的组合,该偏差演变为随机游走。在这项工作中,我们提出训练一个神经网络来学习真正的bias。我们实现并比较了两种常见的顺序深度学习架构:LSTM 和 Transformer。我们的方法遵循最近基于学习的惯性估计器,但是,我们没有学习运动模型,而是明确地针对 IMU 偏差,这使我们能够推广到训练中看不到的运动模式。我们表明,我们提出的方法在四足机器人、步行人类和无人机的各种运动中改善了视觉挑战性情况下的状态估计。我们的实验表明,漂移率平均降低了 15%,当完全视力丧失时,降低幅度更大。重要的是,我们还证明了用一种运动模式(人类步行)训练的模型可以应用于另一种(四足机器人小跑)而无需重新训练。

本文贡献如下:

1、一种能够从测量和bias中估计 IMU bias的神经网络。据作者所知,这是第一种能够明确推断 IMU bias演化的方法。

2、两种不同网络实现(LSTM 和 Transformer)的性能比较以及它们作为一元因素集成到基于状态估计器的在因子图上,用于在视觉上具有挑战性的场景中改进估计。

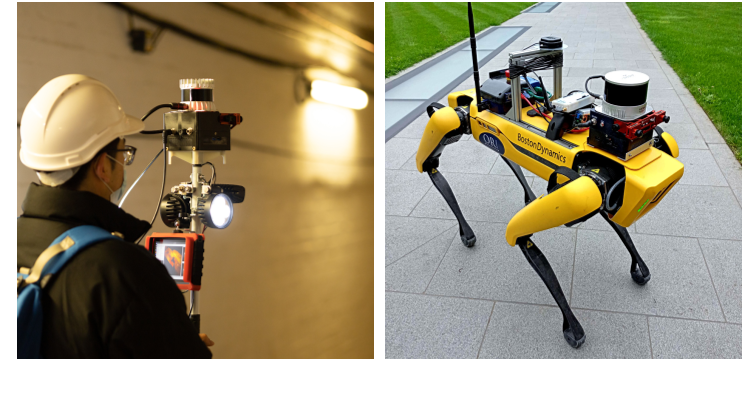

3、在具有不同类型运动的三个不同平台上的真实世界实验:行人手持设备、四足机器人和无人机。据作者所知,这是第一个展示 IMU 学习模型在一种运动方式上训练并在另一种方式上进行测试的工作(手持到四足)。

以上内容来自从零开始机器人SLAM知识星球 每日更新内容

以上内容来自从零开始机器人SLAM知识星球 每日更新内容

本文由博客一文多发平台 OpenWrite 发布!

![[ Azure - Subscriptions ] 解决办法:此订阅未在 Microsoft.Insights 资源提供程序中注册](https://img-blog.csdnimg.cn/4e11e58403e84926b37a3277de924f67.png)