圣达菲研究所的科研人员对 GPT-4在推理和抽象能力方面与人类的差距进行了定量研究。他们使用 ConceptARC 基准测试评估了 GPT-4在文本和多模态方面的表现,并发现 GPT-4仍然与人类存在较大差距。对于 GPT-4的抽象推理能力,研究人员发现,无论是纯文本版还是多模态版,GPT-4在抽象推理方面的准确率都远远不及人类。文章指出,要想从 GPT-4的水平发展出 AGI(人工通用智能),还有很长的路要走。

研究论文链接:https://arxiv.org/abs/2311.09247

更多消息:AI人工智能行业动态,aigc应用领域资讯

ConceptARC 是如何测试的?

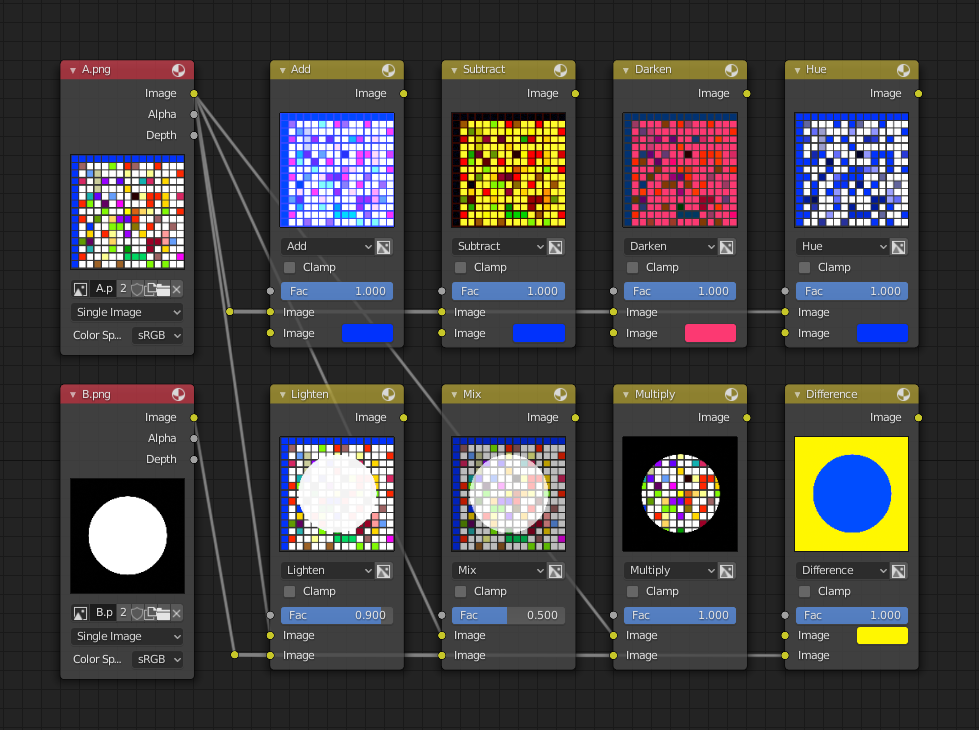

ConceptARC 是一套基于人工推理与抽象概念的评测系统。它包含了1000多个手动设计的类比谜题任务,每个任务都含有一小段(通常2-4个步骤)网格变换的演示过程,以及一个待检测的“测试输入”网格。被测试对象需要根据演示中的线索,归纳出变换背后的基本规则,然后将规则应用到测试输入网格上,生成出经过相同变换后的结果网格。

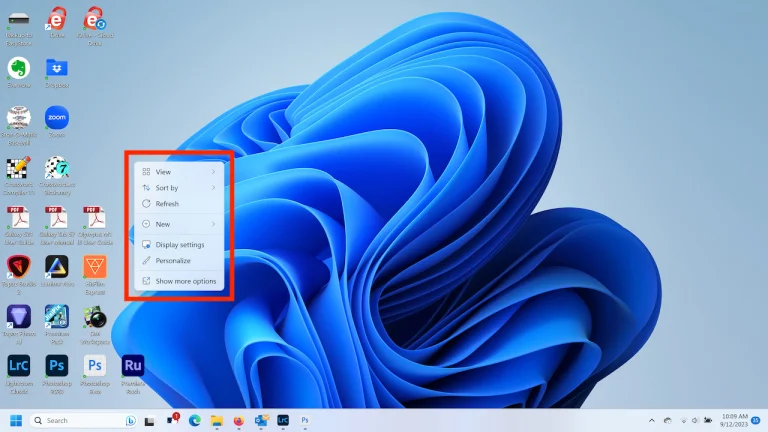

如下图,通过观察演示的规则,挑战者需要生成一个新的网格。

ARC(人工概念能力测试)项目的设计目的是强调从有限样本中总结出普遍规律或模式,并能够灵活应用于新的未见样本。这与语言或先前训练数据依赖的“近似匹配”不同,后者可能会在基于语言的推理任务中获得表面成果。

ConceptARC在此基础上进行改进。它收集并组织了480个任务,这些任务围绕若干核心空间和语义概念(如上下、内外、中心、相同不同等)进行了系统化设计。每个任务以不同方式实现某一概念,抽象程度不尽相同。

这种设计改进使概念表征变得更加抽象,从而对人类来说难度相对降低。同时也可以更好地评估GPT模型与人类在解决涉及这些关键概念的抽象推理问题方面的能力差异。这对评估自然语言处理模型在概念推理能力方面的深度提供了一个较好的测试平台。

测试结果,GPT-4比起人类还有很大差距

对于纯文本版本的GPT-4,研究人员给予它更充足的提示信息进行评估。这些提示包含任务说明和示例解答,如果GPT-4答错,会要求它提供二次和三次答案。

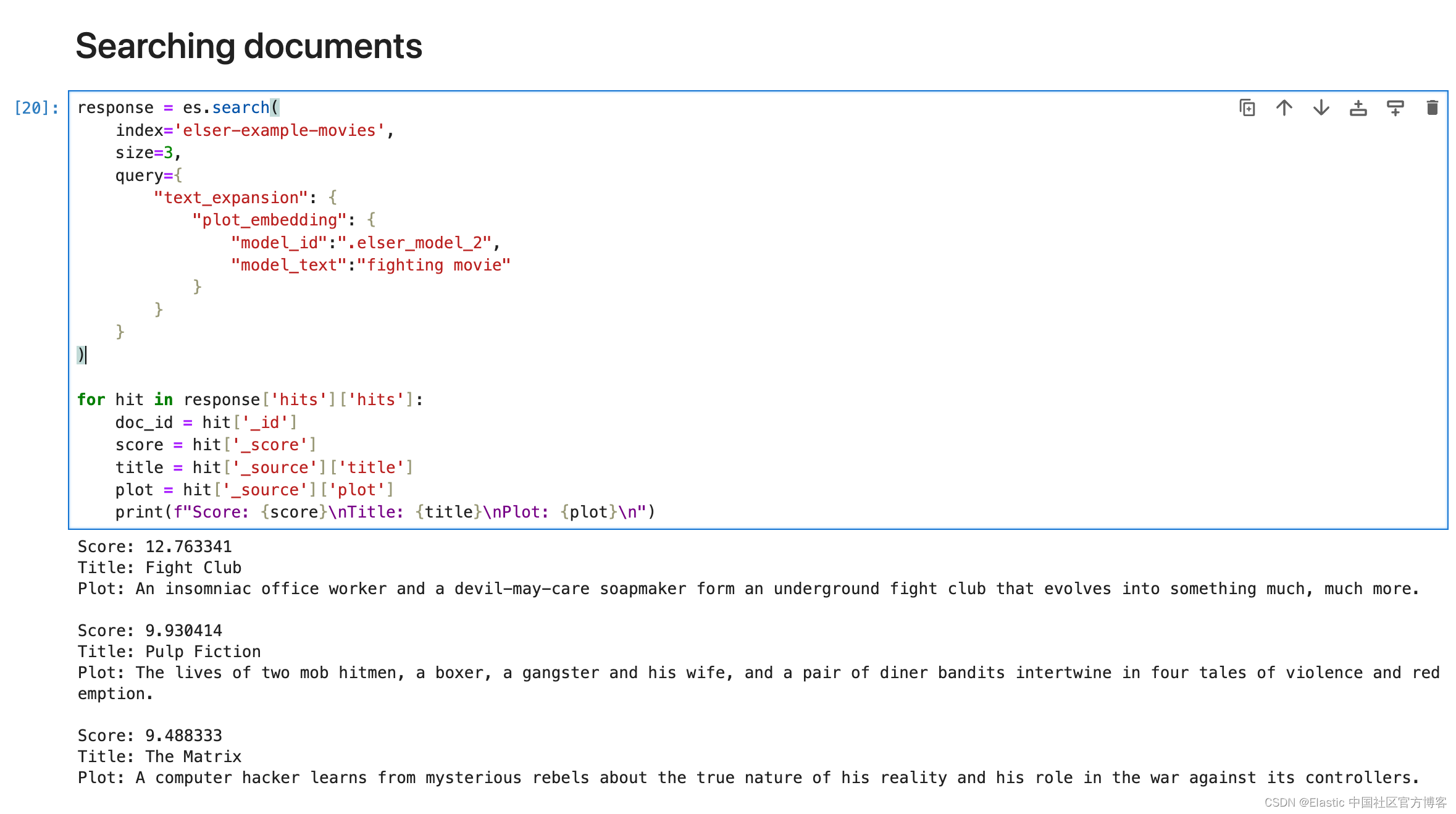

研究人员在不同的温度参数设置下测试GPT-4。温度参数控制生成文本的多样性和不确定性程度,温度值越高,表现越随机。对480个完整任务,GPT-4在各温度参数下的正确率都明显低于人类。

相比于纯文本版本,研究人员也测试了多模态版本的GPT-4。它可以利用视觉和语义信息,避免仅依靠语言推理的限制。测试结果显示,在ConceptARC类比推理任务中,多模态GPT-4的表现有了明显提升,但与人类水平的差距还很大,表明模型在概念级抽象推理能力还有很大提升空间,如下图所示。