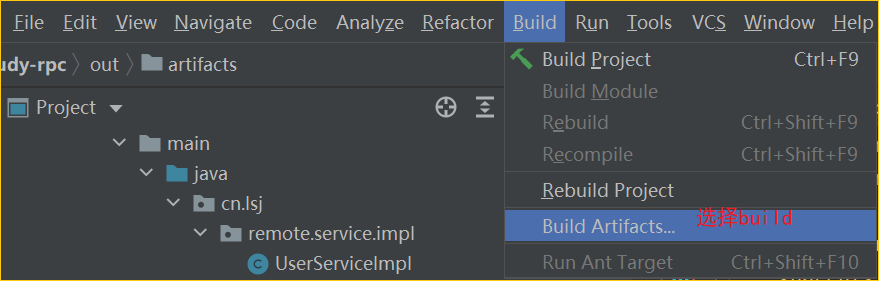

G意为Generative :生成式

比如,生成式的分类器(模型)包括----

generative classifiers:

naive Bayes classifier and

linear discriminant analysis

与之对应的为判别式-----

discriminative model:

logistic regression

P意为Pre-Trained

在人工智能和机器学习的领域,预训练(pre-training)是指在一个较小的、特定任务的数据集上进行微调(fine-tuning)之前,在一个大数据集上训练一个模型的过程。 这个初始训练阶段允许模型从数据中学习一般的特征和表征,然后可以针对具体任务进行微调。

T意为Transformer

Transformer 英文原意变压器或者「单数形式的变形金刚」

在数学上,Transformer意为

In mathematics, a transformation is a function f, usually with some geometrical underpinning, that maps a set X to itself, i.e. f: X → X.[1][2][3] Examples include linear transformations of vector spaces and geometric transformations, which include projective transformations, affine transformations, and specific affine transformations, such as rotations, reflections and translations.[4][5]

正题回归:

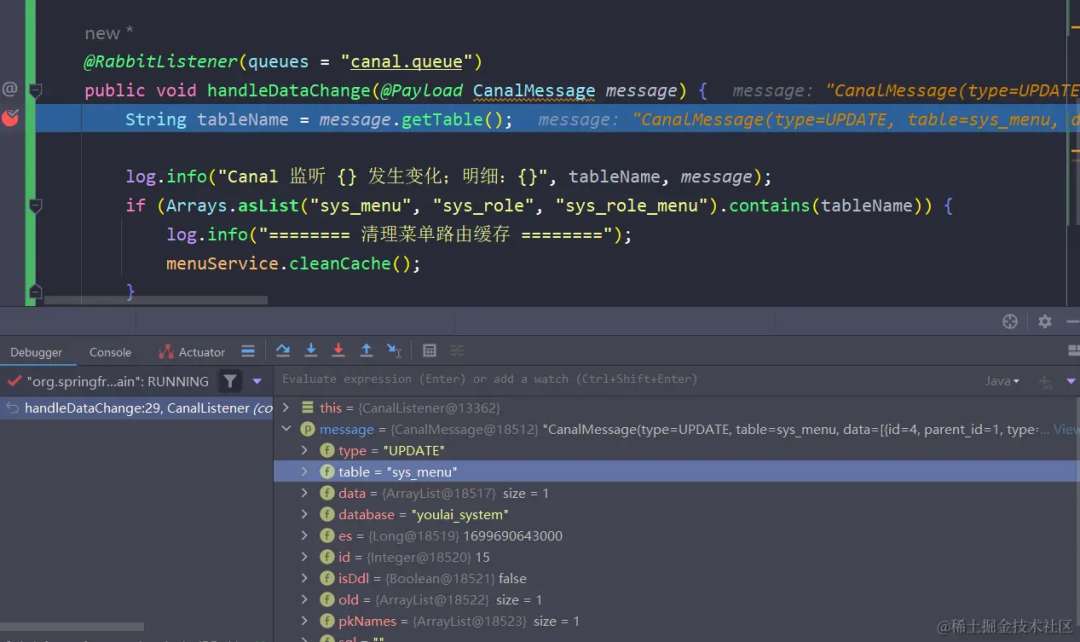

Transformer是一种基于注意力机制的序列模型,最初由Google的研究团队提出并应用于机器翻译任务。与传统的循环神经网络(RNN)和卷积神经网络(CNN)不同,Transformer仅使用自注意力机制(self-attention)来处理输入序列和输出序列,因此可以并行计算,极大地提高了计算效率。

Neural networks, in particular recurrent neural networks (RNNs), are now at the core of the leading approaches to language understanding tasks such as language modeling, machine translation and question answering. In “Attention Is All You Need”, we introduce the Transformer, a novel neural network architecture based on a self-attention mechanism that we believe to be particularly well suited for language understanding.

Transformer模型(直译为“变换器”)是一种采用自注意力机制的深度学习模型,这一机制可以按输入数据各部分重要性的不同而分配不同的权重。该模型主要用于自然语言处理(NLP)与计算机视觉(CV)领域。[1] 与循环神经网络(RNN)一样,Transformer模型旨在处理自然语言等顺序输入数据,可应用于翻译、文本摘要等任务。而与RNN不同的是,

Transformer模型能够一次性处理所有输入数据。注意力机制可以为输入序列中的任意位置提供上下文。如果输入数据是自然语言,则Transformer不必像RNN一样一次只处理一个单词,这种架构允许更多的并行计算,并以此减少训练时间。[2]

Transformer模型于2017年由谷歌大脑的一个团队推出[2],现已逐步取代长短期记忆(LSTM)等RNN模型成为了NLP问题的首选模型。[3]并行化优势允许其在更大的数据集上进行训练。这也促成了BERT、GPT等预训练模型的发展。这些系统使用了维基百科、Common Crawl等大型语料库进行训练,并可以针对特定任务进行微调。

P.S.我在lecture里容易混淆的

在线性代数中,矩阵A的转置(英语:transpose)是另一个矩阵AT(也写做Atr, tA, At或A′)