Cross-Drone Transformer Network for Robust Single Object Tracking论文阅读笔记

Abstract

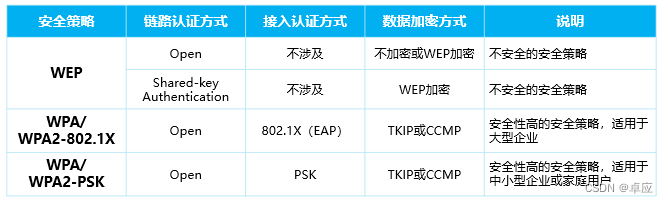

无人机在各种应用中得到了广泛使用,例如航拍和军事安全,这得益于它们与固定摄像机相比的高机动性和广阔视野。多无人机追踪系统可以通过从不同视角收集互补的视频片段,为目标提供丰富的信息,特别是当目标在某些视角中被遮挡或消失时。然而,在多无人机视觉追踪中处理跨无人机信息交互和多无人机信息融合是具有挑战性的。最近,Transformer在自动建模视觉追踪的模板和搜索区域之间的相关性方面显示出显著的优势。为了利用其在多无人机追踪中的潜力,我们提出了一种新型的跨无人机Transformer网络(TransMDOT),用于视觉对象追踪任务。自我注意机制用于自动捕捉多个模板与相应搜索区域之间的相关性,以实现多无人机特征融合。在追踪过程中,我们提出了一种**跨无人机映射机制,通过使用具有良好追踪状态的无人机周围信息作为参考,协助丢失目标的无人机重新校准,实现实时跨无人机信息交互。由于现有的多无人机评估指标只考虑空间信息而忽略时间信息,我们进一步提出了一个系统感知指数(SPFI),该指数结合时间和空间信息来评估多无人机的追踪状态。**在MDOT数据集上的实验证明,TransMDOT在单无人机性能和多无人机系统融合性能方面都大大超越了现有最先进的方法。我们的代码将在 https://github.com/cgjacklin/transmdot 上提供。

Introduction

无人机(UAVs或Drones)在众多应用中扮演着重要角色,如城市安全[1]、地理测绘[2]、电力巡检[3]、灾害搜救[4]等。与固定摄像机相比,无人机由于其高灵活性、实时移动性、可变视角以及其他独特特性,可以处理复杂和动态环境。使用无人机替代固定摄像机来处理基本视觉任务已成为发展的下一阶段。例如,在复杂环境中的视野常常受到遮挡、光照变化、尺度变化和视点运动模糊等问题的影响[5],仅通过优化单摄像机感知算法难以解决极端条件下的现实问题。多无人机系统由于其互补的视角、尺度和其他元素以及广阔的视野,提供了比单摄像机更丰富的信息,从本质上解决了单摄像机目标丢失和特征变化的问题,为解决复杂环境中的挑战性视觉问题提供了新的方法。例如,在荒野和山区等复杂环境中进行搜救[6]、在基础设施建设中进行大规模质量监控[7]、建立多无人机物流配送网络[8],以及在城市安全领域实现嫌疑人追踪[9]。视觉对象追踪是计算机视觉中的一项基本任务,在自动驾驶[10]、视频监控[11]、机器人视觉[12]、医学诊断[13]等方面有重要应用。其主要目标是基于初始帧中给定目标的状态,连续预测后续视频帧中目标对象的状态。随着天网系统的逐渐完善,使用多摄像机系统进行视觉追踪已成为研究热点。然而,目前的多摄像机和跨摄像机追踪算法与多无人机系统中的算法有根本的不同。首先,多无人机系统具有交叉视觉和互补信息。其次,由于多无人机系统中无人机的视角和位置不断变化,很难构建固定的几何关联。

最近,高等人提出了一种可以在野外自主执行任务的微型无人机群体系统,并实现了近地高度的稳健遮挡多无人机协同追踪[14]。然而,由于分辨率低和背景干扰高,高视角无人机的协同追踪仍然具有挑战性。朱等人提出了一个高视角的多无人机单一目标追踪数据集MDOT和一个基线方法ASNet,通过模板共享和视角感知融合策略应用于多无人机系统[15]。ASNet基本实现了多无人机的信息整合,但仍存在以下不足。首先,ASNet的模板融合方案仅使用一个无人机的模板进行搜索,信息利用不完整。其次,当前的协作策略在长时间追踪过程中不具有多无人机之间的持续信息交互。第三,仅依赖置信度的系统融合策略还有改进空间。近年来,基于Transformer的追踪器在单无人机追踪任务中表现出色[16]、[17]、[18]、[19]、[20],但在多无人机单一目标追踪领域仍存在差距。

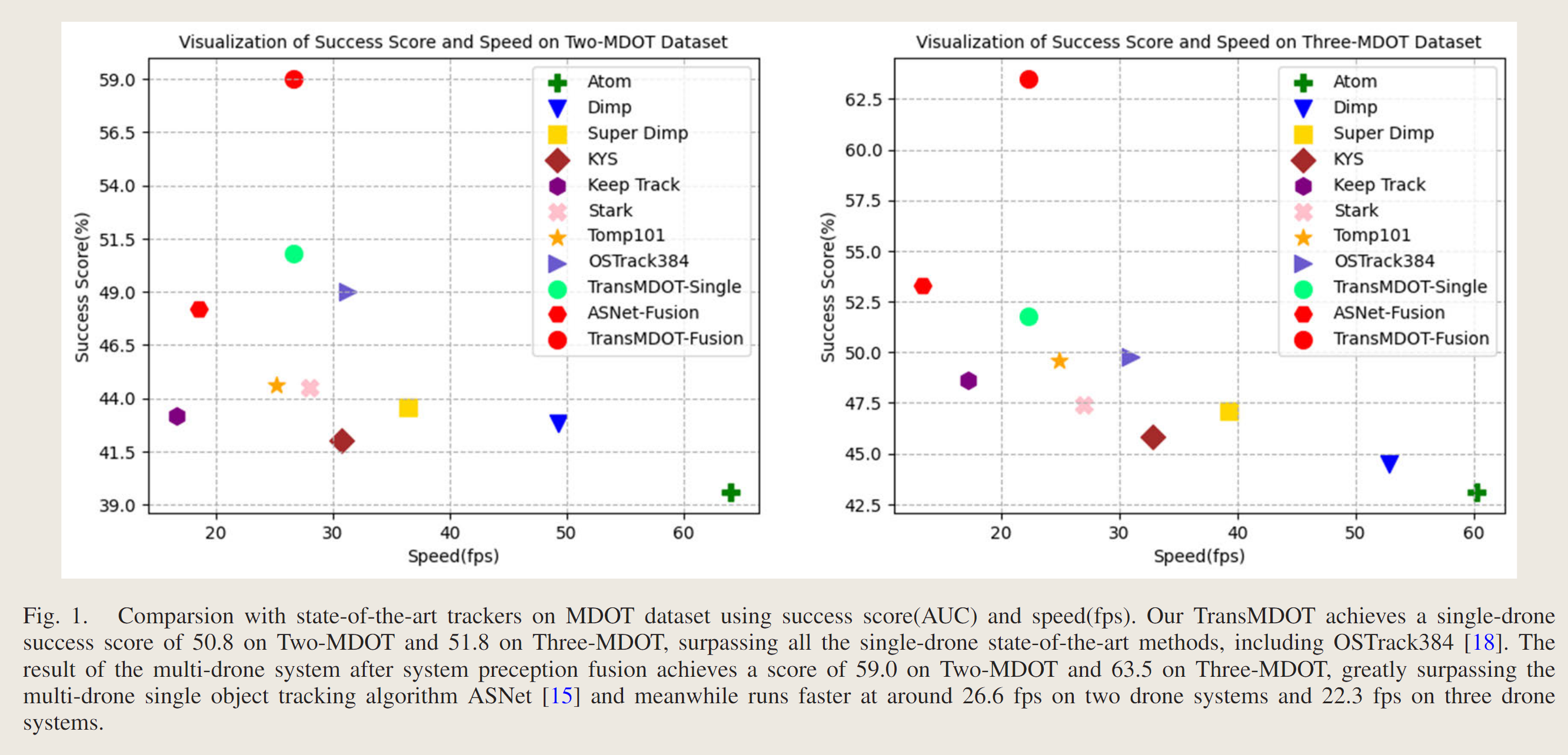

为了解决上述问题,我们提出了一个基于Transformer的多无人机协同单一目标追踪框架TransMDOT,它以视觉Transformer[21]为骨干,利用自注意力的建模能力来自主学习多无人机模板与搜索区域之间的信息关联。同时,为了充分利用跨无人机信息相互补充,我们还提出了一个跨无人机映射模块,能够利用具有良好追踪状态的无人机来纠正丢失目标的无人机的视角。最终的系统结果使用我们提出的SPFI分数进行融合。如图1所示,MDOT数据集上的实验表明,我们的TransMDOT在单无人机性能和多无人机性能方面均优于所有先前的追踪算法。在单无人机性能方面,我们的算法在Two-MDOT数据集上的成功得分比之前最先进的追踪器高出1.8%,在Three-MDOT数据集上的成功得分高出2%。在系统融合性能方面,TransMDOT在Two-MDOT上的成功得分比ASNet高出10.8%,在Three-MDOT数据集上高出10.2%[15]。我们的贡献可以总结如下:• 我们提出了一个基于Transformer的多无人机协同单一目标追踪框架,自动建模多个模板和搜索区域之间的关联,有效处理无人机之间的信息交互。提出的追踪器TransMDOT在单无人机性能和多无人机性能方面均为新的行业标准。• 为多无人机系统设计了一种跨无人机映射机制,用于对追踪状态不佳的无人机进行实时视角校正。• 提出了结合时间和空间信息的多无人机系统感知融合指数SPFI,以评估每个无人机的追踪状态,从而更好地整合多无人机系统的追踪结果。

Contributions:

-

We propose a Transformer-based multi-drone collaborative single object tracking framework to automatically model the association between multiple templates and search regions, which is effective in handling information interaction among drones. The proposed tracker TransMDOT is a new state-of-the-art in terms of single drone performance and multiple drone performance.

-

A cross-drone mapping mechanism for the multi-drone system is designed to perform real-time view correction for drones with poor tracking status.

-

The multi-drone system perception fusion index SPFI(系统感知融合指数) that combines both temporal and spatial information is proposed to evaluate the tracking status of each drone, so as to better integrate the tracking results of the multidrone system.

RELATED WORK

A. Traditional Visual Object Tracking

传统的视觉对象追踪算法可以分为生成式算法和判别式算法。最近的研究主要由判别式算法主导,例如以KCF [22]为代表的基于相关滤波的算法,以及以SiamFC [23]、[24]、[25]、[26]、[27]为代表的基于深度孪生网络的算法,这些算法将目标追踪问题转化为前景和背景的分类问题。

SiamFC [23]提出了一组具有共享参数的孪生网络,并通过相互关联提取的模板和搜索区域,简单高效地进行对象追踪,从而生成响应图以获取高响应位置。由于对象在追踪期间倾向于外观变化,固定的模板特征无法适应长时间追踪,DSaim [24]提出了一种动态孪生网络,可以有效地在线学习目标的外观变化并执行背景抑制。Siam R-CNN [25]结合了检测和单一对象追踪任务,提出了一种基于历史轨迹的动态规划算法,并改造了Faster R-CNN [28]和Cascade R-CNN [29]以实现候选目标的重新检测。

Martin等人将对象追踪分为分类和回归两个阶段:分类阶段需要区分前景和背景,回归阶段需要基于目标质心获得准确的边界框。他们提出的Atom通过引入IoU-Net进行回归来实现边界框预测[26],而Dimp通过训练在线更新的卷积核实现目标定位[27]。在Keep Track [30]中,研究人员认为,仅仅外观模型无法区分对象和干扰物,因此他们提出了一种可以同时追踪所有潜在目标的追踪网络结构,并在帧之间传播所有候选目标,最终通过对象关联模块实现持续的帧间匹配。

B. Transformer-Based Visual Object Tracking

自2017年提出以来,Transformer在自然语言处理(NLP)任务上取得了极大的成功[31]。随后,视觉Transformer(ViT)[21]将其引入到计算机视觉领域。随着诸如LaSOT [32]、GOT10K [33]、TrackingNet [34]、UAV123 [35]、VOT [36]等数据集的丰富和基于Transformer的模型建模能力的增强,大规模预训练模型被广泛使用。Transformer强大的特征表示和建模能力使其越来越多地被用于各种下游视觉任务。许多基于Transformer的追踪器[16]、[17]、[18]、[37]、[38]、[39]、[40]在视觉追踪数据集的排行榜上占据主导地位。TransT [16]利用堆叠的自注意力和交叉注意力结构实现了基于注意力的特征融合网络,设计了基于孪生网络的追踪方法,首次将Transformer引入视觉对象追踪领域。离线孪生追踪器实际上是空间追踪器,将视觉对象追踪任务视为模板与搜索区域的匹配,并忽略了时间上下文信息。Swin-Transformer [41]使用移位窗口实现了分层注意力机制,使得在计算复杂性线性增长的情况下实现不同尺度特征的建模。SwinTrack [37]随后使用Swin-Transformer作为特征提取和模板与搜索区域关系建模的主干。Stark [17]额外设计了一个在追踪过程中动态更新的动态模板,将时间上下文信息整合进来,然后使用Transformer实现时间和空间信息的整体整合。随着当前模型对任务特征的加强能力,单一对象追踪、多对象追踪和分割的任务本质可以归纳为相同的目标,即时空关联,Unicorn [40]实现了对象追踪领域多个子任务的大统一,使用目标先验和像素级对应解决单一对象、多对象追踪和分割任务。OStrack [18]实现了基于视觉Transformer的单流单一对象追踪框架,并结合了特征提取模块和关系建模模块,提供了模板与搜索区域之间相似性的强先验。

C. Multi-Camera System

当前的多摄像机系统主要指由多个固定摄像机组成的系统。随着天网系统的改进,基于多摄像机系统的道路巡逻、人员重识别和对象追踪相关研究已经出现[14]、[42]、[43]、[44]。与多摄像机系统相关的研究通常分为两类:有重叠和无重叠。对于无重叠的任务,通常首先在单个摄像机中进行检测和追踪,然后通过重识别方法进行跨摄像机目标关联。对于有重叠的场景,我们通常利用它们的互补视角进行信息融合,或使用多摄像机系统来优化单个摄像机的追踪精度。目前的大多数多摄像机数据集要么没有重叠,要么只有短期重叠,如CAMPUS [45]、MCT [46]、MTMC17 [47]和DukeMTMC [48],它们的研究主要集中在重识别[49]、[50]、[51]和多目标追踪[43]、[44]、[52]、[53]上。胡等人通过相机标定手段构建不同摄像机之间的几何关系以进行目标关联[52]、[53]。何等人将跨摄像机多目标追踪问题转化为直接的轨迹-目标关联问题,以取代传统的轨迹-轨迹关联问题,实现了更为稳健的身份匹配[43]。DyGLIP [44]从动态图的角度重新定义了多摄像机多目标追踪问题,将多个摄像机位置之间的轨迹关联转化为图链接分配问题,并使用注意力模块实现跨摄像机的长时间特征建模。

D. Multi-Drone System

由于多无人机系统需要处理复杂的信息交互和融合模式,与单无人机系统相比存在更严重的问题和挑战。在近地视角下,无人机具有清晰的视野、高分辨率和低背景干扰,可以使用物体重识别、图像匹配等方法实现跨无人机目标校准。高等人为近地条件下的微型无人机群设计了协作轨迹优化、目标识别和集群通信,以实现微型无人机群的自主任务协作[14]。相关数据集的稀缺性也导致在多无人机系统中发展稳健的追踪方法变得困难。朱等人提出了第一个多无人机单一目标追踪领域的数据集MDOT,填补了这一领域的空白,并提出了代理共享网络ASNet,通过自监督的模板共享策略和视角融合策略实现多无人机的信息融合[15]。这是第一个完整的多无人机单一目标追踪框架,为多无人机系统中后续视觉对象追踪研究提供了基准。刘等人提出了第一个多无人机多目标追踪数据集(MDMT)[54]。当需要同时追踪多个目标时,需要在不同无人机之间进行目标ID匹配。他们提出的MIA-Net通过全局-局部最优匹配策略在多无人机系统中实现跨无人机目标ID匹配,并通过变换矩阵的计算对齐不同视角,有效解决了目标遮挡问题。

这里显示多无人机多/单目标目前研究者不多

METHOD

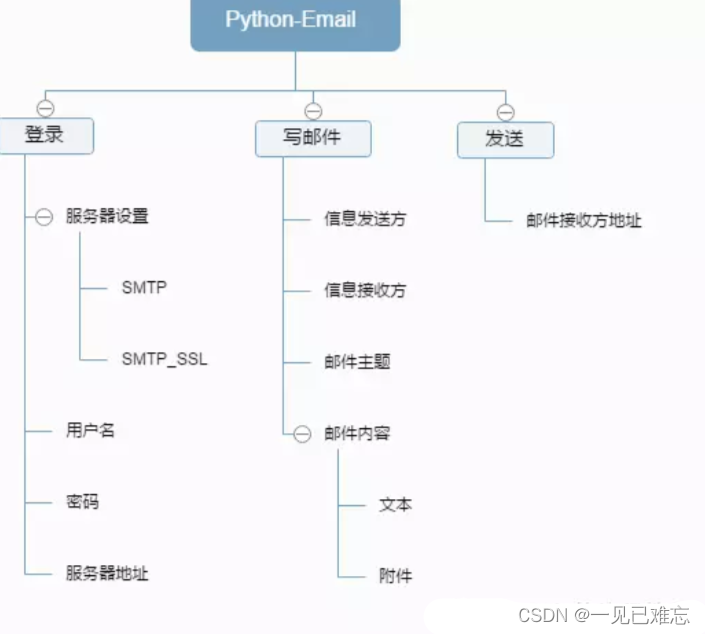

在这一部分中,我们将描述我们的跨无人机Transformer网络TransMDOT,它用于多无人机单一目标追踪任务,能够利用多无人机信息进行协同追踪。我们还将介绍一个用于系统感知融合的指标SPFI。

A. Overview of TransMDOT

However, there is not yet a Transformer architecture for multi-drone single object tracking tasks, and past multi-drone collaborations have only utilized multiple templates of information and have not enabled information interaction during tracking.

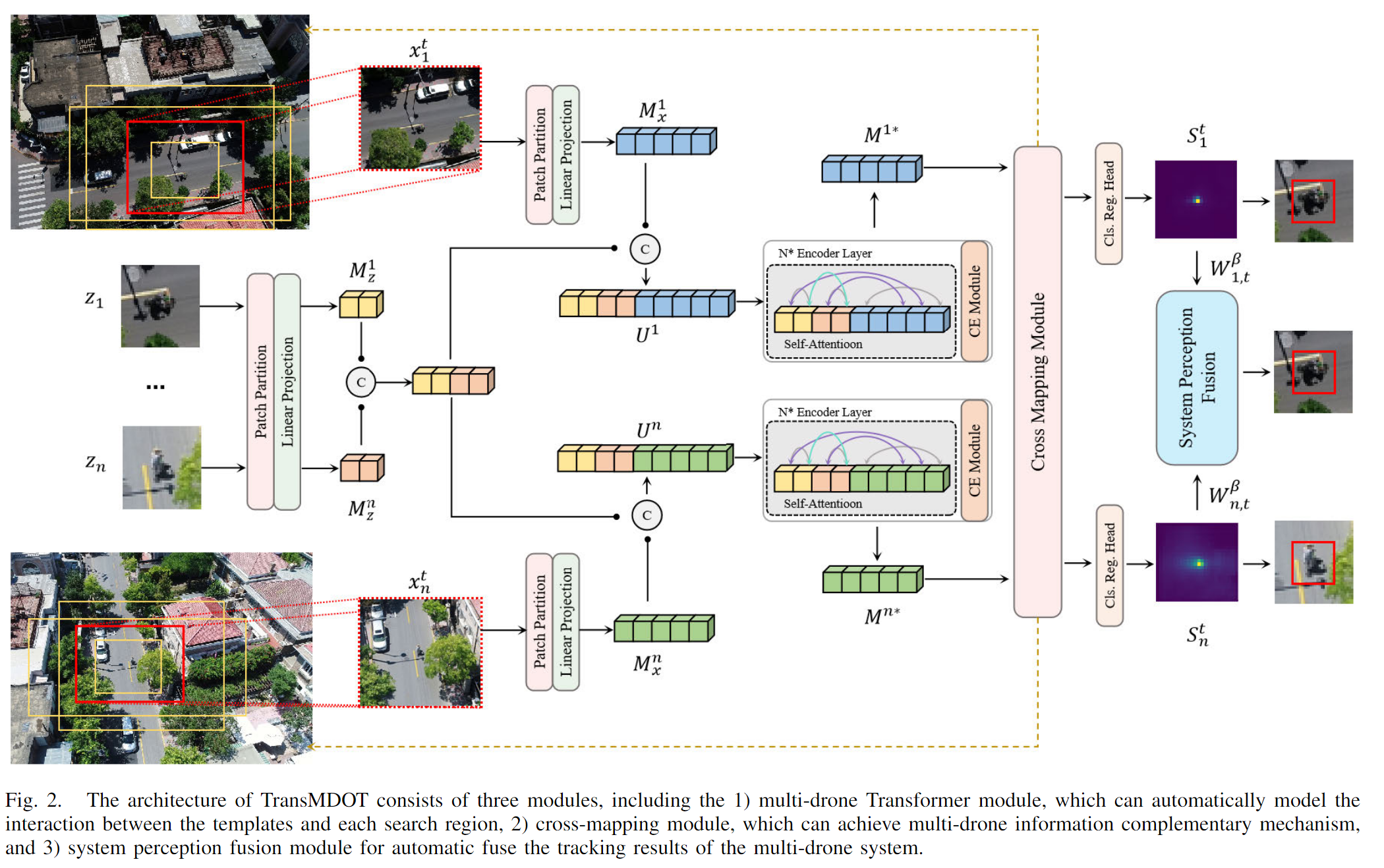

如图2所示,TransMODT的框架:

- multi-drone Transformer module, which can automatically model the interaction between the templates and each search region

- cross-mapping module, which can achieve multi-drone information complementary mechanism

- system perception fusion module for automatic fuse the tracking results of the multi-drone system.

在追踪过程中,对于拥有n架无人机的追踪系统,我们截取它们的模板以获得模板集Z,将它们与每架无人机的搜索区域X连接在一起,然后输入到视觉Transformer[21]中。然后,Transformer的自注意力机制[31]可以自动建模模板与搜索区域之间的关系。

In some of the encoders, we also add the candidate elimination module to remove redundant tokens, which can speed up inference.

获得响应图S后,将根据响应值判断追踪状态。当第i架无人机的目标置信度低时,将应用跨无人机映射模块。该模块使用追踪状态良好的无人机周围目标的背景信息在当前无人机中进行搜索,以重新划定其搜索区域并进行重新检测。在感知融合阶段,我们提出了一个系统感知融合指数SPFI,用于确定每一帧中每架无人机的追踪置信度,以实现自动感知融合。

B. Relation Modeling for Multi-Drone System

对于一个有 n n n 架无人机的多无人机系统,我们有一组模板 Z = { z 1 , z 2 , … , z n } Z = \{z_1, z_2, \ldots, z_n\} Z={z1,z2,…,zn} 和一组搜索区域 X = { x 1 , x 2 , … , x n } X = \{x_1, x_2, \ldots, x_n\} X={x1,x2,…,xn}。我们使用视觉变压器(Vision Transformer)作为骨干,它接受一组图像补丁作为输入。首先将模板图像和搜索区域图像分割成补丁,以获得一组补丁 z ∈ R N z × ( P 2 × 3 ) z \in \mathbb{R}^{N_z \times (P^2 \times 3)} z∈RNz×(P2×3) 和补丁 x ∈ R N x × ( P 2 × 3 ) x \in \mathbb{R}^{N_x \times (P^2 \times 3)} x∈RNx×(P2×3),其中 P P P 是补丁大小, N N N 是模板和搜索区域补丁的数量。之后,我们使用一个可学习的线性投影层 L ∈ R ( P 2 × 3 ) × D L \in \mathbb{R}^{(P^2 \times 3) \times D} L∈R(P2×3)×D 将令牌投影到 D D D 维空间。然后我们添加可学习的一维位置编码 P z ∈ R N z × D P_z \in \mathbb{R}^{N_z \times D} Pz∈RNz×D 和 P x ∈ R N x × D P_x \in \mathbb{R}^{N_x \times D} Px∈RNx×D 到补丁嵌入中。我们可以通过方程 (1) 得到第 i i i 架无人机的令牌嵌入。

M z = z ( i ) L + P z M x = x ( i ) L + P x M_z = z^{(i)}L + P_z \\ M_x = x^{(i)}L + P_x Mz=z(i)L+PzMx=x(i)L+Px

(公式 1)

对于每架无人机 i i i,所有无人机的模板都可以用作其搜索区域的基础。在 ASNet [15] 中,作者使每个模板与搜索区域通过一个接一个地相关,并取最大响应值作为结果。但我们认为我们可以使用自注意力机制来自动学习多个模板和搜索区域之间的关系。因此,我们将多个模板与当前无人机的搜索区域一起串联起来作为变压器编码器的输入。

U ′ i = Concat ( M z ( 1 ) , M z ( 2 ) , … , M z ( n ) , M x ( i ) ) U'^i = \text{Concat}(M_z^{(1)}, M_z^{(2)}, \ldots, M_z^{(n)}, M_x^{(i)}) U′i=Concat(Mz(1),Mz(2),…,Mz(n),Mx(i))

(公式 2)

其中 i i i 是当前无人机的ID, M z ( i ) M_z^{(i)} Mz(i) 代表无人机 i i i 的模板的令牌嵌入, M x ( i ) M_x^{(i)} Mx(i) 代表当前搜索区域的令牌嵌入。

1) 多无人机系统的自注意力

自注意力机制 [31] 被定义为:

MultiHead ( Q , K , V ) = Concat ( head 1 , … , head n ) W O head i = Attention ( Q W i Q , K W i K , V W i V ) \text{MultiHead}(Q, K, V) = \text{Concat}(\text{head}_1, \ldots, \text{head}_n)W^O \\ \text{head}_i = \text{Attention}(QW_i^Q, KW_i^K, VW_i^V) MultiHead(Q,K,V)=Concat(head1,…,headn)WOheadi=Attention(QWiQ,KWiK,VWiV)

(公式 3)

这意味着在输入令牌上应用多个自注意力机制,并乘以权重 W O W^O WO。我们将它的 Q Q Q, K K K, V V V 视为模板矩阵和搜索区域矩阵的组合。因此,对于每个自注意力操作,我们可以将其写为:

A = Softmax ( Q K T d k ) ⋅ V = Softmax ( [ Q z ( 1 ) … Q z ( n ) Q x ] [ K z ( 1 ) … K z ( n ) K x ] T d k ) ⋅ [ V z ( 1 ) … V z ( n ) V x ] A = \text{Softmax} \left( \frac{QK^T}{\sqrt{d_k}} \right) \cdot V \\ = \text{Softmax} \left( \frac{\begin{bmatrix} Q_z^{(1)} & \ldots & Q_z^{(n)} & Q_x \end{bmatrix} \begin{bmatrix} K_z^{(1)} & \ldots & K_z^{(n)} \\ K_x \end{bmatrix}^T}{\sqrt{d_k}} \right) \cdot \begin{bmatrix} V_z^{(1)} & \ldots & V_z^{(n)} & V_x \end{bmatrix} A=Softmax(dkQKT)⋅V=Softmax dk[Qz(1)…Qz(n)Qx][Kz(1)Kx…Kz(n)]T ⋅[Vz(1)…Vz(n)Vx]

(公式 5)

其中 z z z 表示当前矩阵属于模板, x x x 表示它属于搜索区域, n n n 代表无人机的数量。我们扩展方程 (5) 中的注意力权重来获得下面的关联矩阵:

Softmax ( [ Q z ( 1 ) … Q z ( n ) Q x ] [ K z ( 1 ) … K z ( n ) K x ] T d k ) = Softmax ( [ Q z ( 1 ) K z ( 1 ) T … Q z ( n ) K z ( n ) T Q z ( 1 ) K x T ] d k ) ⇒ [ W z z ( 1 , 1 ) … W z z ( 1 , n ) W z x ( 1 ) … W z x ( n ) ] \text{Softmax} \left( \frac{\begin{bmatrix} Q_z^{(1)} & \ldots & Q_z^{(n)} & Q_x \end{bmatrix} \begin{bmatrix} K_z^{(1)} & \ldots & K_z^{(n)} & K_x \end{bmatrix}^T}{\sqrt{d_k}} \right) \\ = \text{Softmax} \left( \frac{\begin{bmatrix} Q_z^{(1)}K_z^{(1)T} & \ldots & Q_z^{(n)}K_z^{(n)T} & Q_z^{(1)}K_x^T \end{bmatrix}}{\sqrt{d_k}} \right) \\ \Rightarrow \begin{bmatrix} W_{z_z}^{(1,1)} & \ldots & W_{z_z}^{(1,n)} & W_{z_x}^{(1)} & \ldots & W_{z_x}^{(n)} \end{bmatrix} Softmax dk[Qz(1)…Qz(n)Qx][Kz(1)…Kz(n)Kx]T =Softmax dk[Qz(1)Kz(1)T…Qz(n)Kz(n)TQz(1)KxT] ⇒[Wzz(1,1)…Wzz(1,n)Wzx(1)…Wzx(n)]

(公式 6)

其中每个权重 W W W 评估每两组令牌之间的关联。在自注意力之后,无人机 i i i 和无人机 j j j 之间的模板关系自动建模为 W z z ( i , j ) W_{z_z}^{(i,j)} Wzz(i,j),模板与搜索区域之间的关系建模为 W z x i W_{z_x}^{i} Wzxi 和 W x z i W_{x_z}^{i} Wxzi,并且搜索区域内每个模板之间的关联为 W x x W_{x_x} Wxx。变压器编码器使得更丰富的信息交互成为可能,对于一个有 n n n 架无人机的系统,这样的关系矩阵有 ( n + 1 ) 2 2 \frac{(n+1)^2}{2} 2(n+1)2 类。

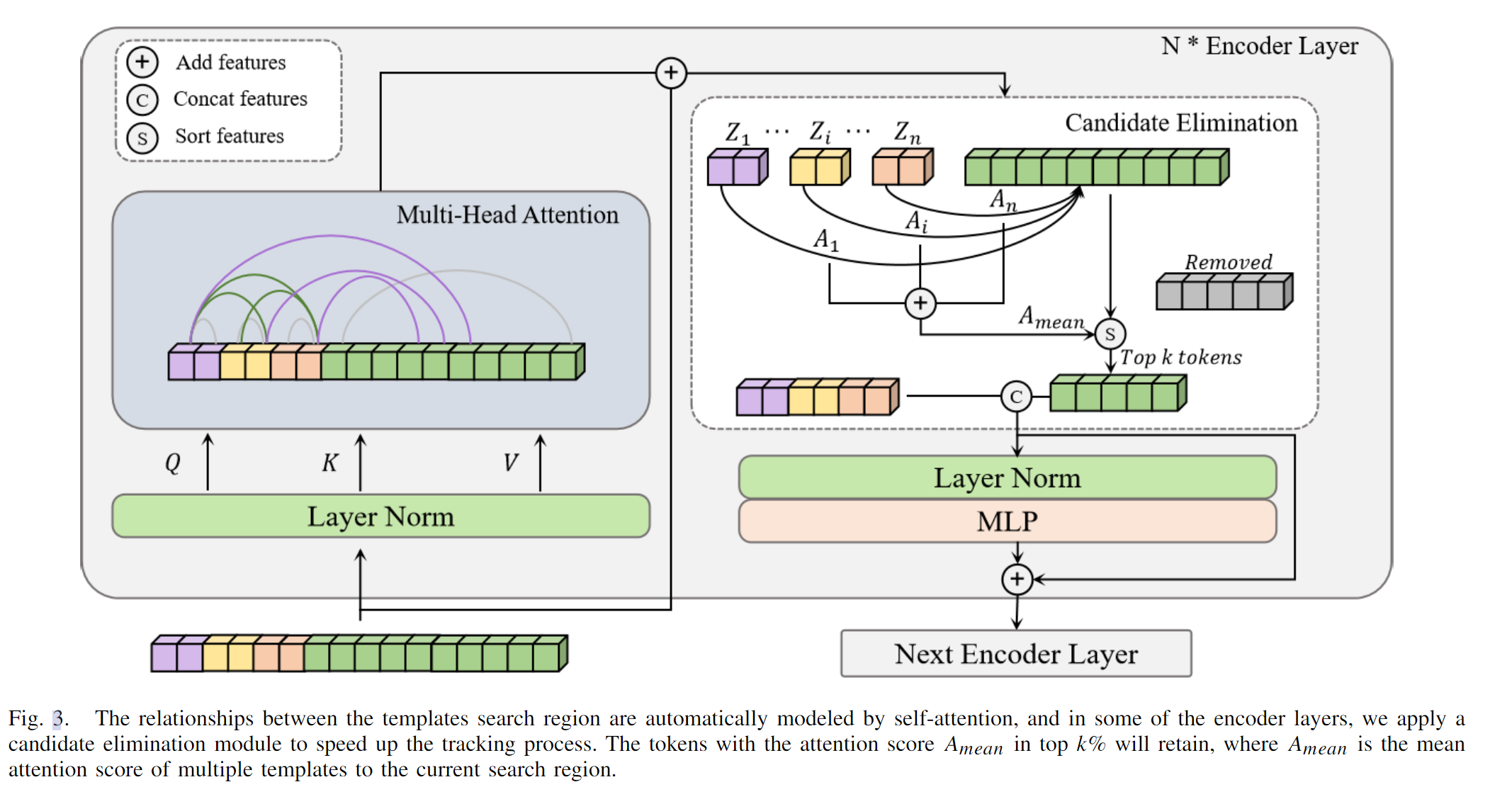

2)多无人机系统的候选消除

基于变压器的方法在训练和推理过程中通常速度较慢,因为它们的高计算复杂性。多无人机系统也因为复杂的信息交互而倾向于降低推理速度。注意力操作的计算复杂度可以写作 O Attn ∝ l 2 ⋅ d O_{\text{Attn}} \propto l^2 \cdot d OAttn∝l2⋅d,其中 l l l 表示输入令牌的长度, d d d 表示其维度。OSTrack 提出了一个候选消除模块[18],该模块根据搜索区域的注意力值对令牌进行排序,并移除一些多余的令牌,证明缩短令牌长度 l l l 可以加快推理速度。为了加快推理速度,我们设计了一个多无人机系统的候选消除模块,如图3所示。

在执行方程(6)中的自注意力操作后,我们得到一组权重 W = [ W z x ( 1 , 1 ) W z x ( 1 ) … W z x ( n ) ] W = \begin{bmatrix} W_{z_x}^{(1,1)} & W_{z_x}^{(1)} & \ldots & W_{z_x}^{(n)} \end{bmatrix} W=[Wzx(1,1)Wzx(1)…Wzx(n)],我们选择注意力权重 W z x = [ W z x ( 1 ) W z x ( 2 ) … W z x ( n ) ] W_{z_x} = \begin{bmatrix} W_{z_x}^{(1)} & W_{z_x}^{(2)} & \ldots & W_{z_x}^{(n)} \end{bmatrix} Wzx=[Wzx(1)Wzx(2)…Wzx(n)],它代表每个模板 z z z 和相应搜索区域 x x x 之间的关系。我们认为模板的中心令牌通过自注意力整合了整体信息,所以我们取模板的中心令牌的权重作为排序基准。

然后,我们平均 n n n 架无人机的搜索区域令牌的注意力得分,以获得平均响应 A mean A_{\text{mean}} Amean。如方程(7)所示。对于搜索区域中的每个令牌 j j j,我们有它的注意力权重 w x j w_{x}^{j} wxj。

w x j = mean ( w z x ( 1 , j ) , w z x ( 2 , j ) , … , w z x ( n , j ) ) w_{x}^{j} = \text{mean}(w_{z_x}^{(1,j)}, w_{z_x}^{(2,j)}, \ldots, w_{z_x}^{(n,j)}) wxj=mean(wzx(1,j),wzx(2,j),…,wzx(n,j))

(方程 7)

其中 w z x ( 1 , j ) w_{z_x}^{(1,j)} wzx(1,j) 是第 i i i 架无人机模板的中心令牌到当前搜索区域的注意力权重, w x j w_{x}^{j} wxj 是相对于第 j j j 个token的系统的综合注意力权重。

得分较高的令牌更可能包含目标。因此我们保留得分最高的 k % k\% k% 令牌作为 M x ∗ M_x^* Mx∗ 并移除其他,如下:

M x ∗ = Top K ( M x ) M_x^* = \text{Top}_K (M_x) Mx∗=TopK(Mx)

(方程 8)

通过这种方式,我们可以获得更短的令牌 U ∗ U^* U∗ 进入后续的编码器,在连接保留的搜索区域令牌和模板令牌之后,

U ∗ = Concat ( M z ( 1 ) , M z ( 2 ) , … , M z ( n ) , M x ∗ ) . U^* = \text{Concat}(M_z^{(1)}, M_z^{(2)}, \ldots, M_z^{(n)}, M_x^*). U∗=Concat(Mz(1),Mz(2),…,Mz(n),Mx∗).

(方程 9)

C. Cross-Drone Mapping(没懂????)

在追踪过程中,追踪器经常会因为光照变化、尺度变化和无人机的移动旋转而追踪错误的目标。由于目标的低分辨率和快速移动,目标可能突然完全跑出搜索区域,导致长期目标丢失。最好的解决方案是重新定位搜索区域,这对单架无人机来说很难实现。

我们设计了一个跨无人机映射机制,用于执行实时的跨无人机信息交互,允许追踪状态良好的无人机指导失去目标的无人机重新找到目标,如图4所示。跨无人机映射利用多无人机系统目标周围相似的背景,并使用两阶段定位方法从粗定位到精定位。首先,通过跨无人机参考重新定义丢失无人机的搜索区域。然后基于多个模板进行精确定位目标追踪,实现实时的跨无人机信息交互。

对于无人机 i i i,我们设置如下的跨无人机映射激活条件。对于任何满足方程 ( 10 ) (10) (10) 中条件的帧 t t t,我们认为需要重新定位。

{ s max ( i ) < δ , A P C E ( i ) < ϵ , \left\{ \begin{array}{ll} s_{\text{max}}^{(i)} < \delta, \\ APCE^{(i)} < \epsilon, \end{array} \right. {smax(i)<δ,APCE(i)<ϵ,

(方程 10)

其中 s max ( i ) s_{\text{max}}^{(i)} smax(i) 是无人机 i i i 的最大响应值,APCE[55] 是由响应图 S S S 计算出的指标, δ \delta δ 和 ϵ \epsilon ϵ 是阈值。

如果有一个追踪状态良好的无人机 j j j,其 s max > δ ∗ s_{\text{max}} > \delta^* smax>δ∗,那么我们将从无人机 j j j 对无人机 i i i 应用跨无人机映射。我们裁剪图像集 R = { R a , R b , … } R = \{R_a, R_b, \ldots\} R={Ra,Rb,…} 在无人机 j j j 的目标中心作为参考,其中 { a , b , … } \{a, b, \ldots\} {a,b,…} 是不同尺度的搜索候选区域集合 X = { X a , X b , … } X = \{X_a, X_b, \ldots\} X={Xa,Xb,…},包含上一帧中心生成的不同尺度锚点以及一些预定义位置。然后我们在每个候选区域中应用两阶段定位。首先,我们根据参考 R R R 重新定位 X X X 中的搜索区域,以获得最高响应分数的重新定位搜索区域 X i ∗ X_i^* Xi∗,其周围环境与相应无人机的目标相似。其次,我们使用B节中的方法在新的搜索区域中追踪目标。之后,我们将得到一系列结果边界框 B = { b 1 , b 2 , … , b n , b t − 1 } B = \{b_1, b_2, \ldots, b_n, b_{t-1}\} B={b1,b2,…,bn,bt−1}。其中 b t − 1 b_{t-1} bt−1 是前一帧 t − 1 t-1 t−1 的追踪结果。集合 B B B 中响应分数最大的将被选为第 t t t 帧的结果。(??????????????)

D. System Perception Fusion Index

除了单一无人机的性能指标之外,多无人机系统还有代表整体系统追踪性能的指标AFS[15],

A F S = 1 T ∑ t = 1 T ∑ i = 1 n w t ( i ) Φ ( h t ( i ) , y t ( i ) ) , AFS = \frac{1}{T} \sum_{t=1}^{T} \sum_{i=1}^{n} w_t^{(i)} \Phi(h_t^{(i)}, y_t^{(i)}), AFS=T1t=1∑Ti=1∑nwt(i)Φ(ht(i),yt(i)),

(公式 11)

其中 t t t 是帧号, i i i 是无人机ID, w t ( i ) ∈ { 0 , 1 } w_t^{(i)} \in \{0, 1\} wt(i)∈{0,1} 代表由融合方法得到的无人机的权重, Φ \Phi Φ 是单一目标追踪指标(如AUC, 精度等), h t ( i ) h_t^{(i)} ht(i) 代表第 i i i 架无人机在第 t t t 帧的追踪结果, y t ( i ) y_t^{(i)} yt(i) 代表相应的真实标签。

为了获得最佳的系统追踪结果,问题转化为找到每一帧 t t t 最佳的无人机结果:

max ( A F S ) = max ( 1 T ∑ t = 1 T ∑ i = 1 n w t ( i ) Φ ( h t ( i ) , y t ( i ) ) ) , \max (AFS) = \max \left( \frac{1}{T} \sum_{t=1}^{T} \sum_{i=1}^{n} w_t^{(i)} \Phi(h_t^{(i)}, y_t^{(i)}) \right), max(AFS)=max(T1t=1∑Ti=1∑nwt(i)Φ(ht(i),yt(i))),

(公式 12)

在追踪过程中,我们无法知道真实的 y y y,所以我们需要一个评价指标来评估每一帧每架无人机的追踪状态。在过去的方法中,多无人机追踪算法ASNet[15]使用响应图 S S S 的最大值作为排名基准。包含最大响应值的无人机被选为当前帧的追踪结果进行自动融合。在单无人机视觉追踪算法中,APCE[55] 被视为确定追踪状态是否有效的最佳方法,并且经常用于重新检测方法。这些方法只使用当前帧的响应图进行计算,这意味着它们没有利用时间信息。

我们认为,良好的追踪时期应该在时间序列上保持响应图相对稳定。因此,我们提出一个多无人机系统感知融合指标SPFI来指导多无人机系统的自动融合,

S P F I = ( μ β − γ σ β ) ∣ S max − S min ∣ mean ( ∑ w , h ( S w , h − S min ) 2 ) , SPFI = \frac{(\mu^{\beta} - \gamma \sigma^{\beta}) |S_{\text{max}} - S_{\text{min}}|}{\text{mean} \left( \sum_{w,h} (S_{w,h} - S_{\text{min}})^2 \right)}, SPFI=mean(∑w,h(Sw,h−Smin)2)(μβ−γσβ)∣Smax−Smin∣,

(公式 13)

其中 S max S_{\text{max}} Smax 是当前帧响应图的最大值, S min S_{\text{min}} Smin 是最小值, S w , h S_{w,h} Sw,h 是响应图在行 w w w,列 h h h 的响应值, γ \gamma γ 是权重参数, μ \mu μ 和 σ \sigma σ 是从过去 β \beta β 帧的响应图中计算出来的,

μ t β = mean ( g ( S t ) , g ( S t − 1 ) , … , g ( S t − ( β − 1 ) ) ) , \mu_t^{\beta} = \text{mean} (g(S_t), g(S_{t-1}), \ldots, g(S_{t-(\beta-1)})), μtβ=mean(g(St),g(St−1),…,g(St−(β−1))),

(公式 14)

σ t β = var ( g ( S t ) , g ( S t − 1 ) , … , g ( S t − ( β − 1 ) ) ) . \sigma_t^{\beta} = \text{var} (g(S_t), g(S_{t-1}), \ldots, g(S_{t-(\beta-1)})). σtβ=var(g(St),g(St−1),…,g(St−(β−1))).

(公式 15)

g ( S t ) g(S_t) g(St) 代表第 t t t 帧响应图的响应值函数。我们使用最大响应值作为我们实验中的指标。 μ \mu μ 是过去 β \beta β 帧的响应均值, σ \sigma σ 是响应方差。从公式 (13) 可以得出,在追踪时期内,如果当前帧的响应均值大且方差小,那么置信度权重 ( μ β − γ σ β ) (\mu^{\beta} - \gamma \sigma^{\beta}) (μβ−γσβ) 将会更高。对于一个有 n n n 架无人机的多无人机系统,我们分别计算它们每一帧的SPFI值,并将最大SPFI得分的无人机结果作为系统融合结果,

h t ∗ = argmax ( Ψ S P F I ( S t 1 , … , S t 1 − ( β − 1 ) ) , … , Ψ S P F I ( S t n , … , S t n − ( β − 1 ) ) ) , h_t^* = \text{argmax} (\Psi_{SPFI} (S_t^{1}, \ldots, S_t^{1-(\beta-1)}), \ldots, \Psi_{SPFI} (S_t^{n}, \ldots, S_t^{n-(\beta-1)})), ht∗=argmax(ΨSPFI(St1,…,St1−(β−1)),…,ΨSPFI(Stn,…,Stn−(β−1))),

(公式 16)

其中 h t ∗ h_t^* ht∗ 是第 t t t 帧的系统追踪结果, S t i S_t^{i} Sti 代表第 i i i 架无人机在第 t t t 帧的响应图, Ψ S P F I \Psi_{SPFI} ΨSPFI 计算每架无人机的SPFI得分。

![给定一个数列,每一次操作可以使a[i]变成x,y,满足x + y = a[i] + k, 求使所有数字相同的最少操作次数](https://img-blog.csdnimg.cn/direct/3ec666271357464d852d9efac5e4ef88.png)

![NNDL 作业12-优化算法2D可视化 [HBU]](https://img-blog.csdnimg.cn/direct/f48af9e9ec4848a68cc30e2e114fb0c9.png)