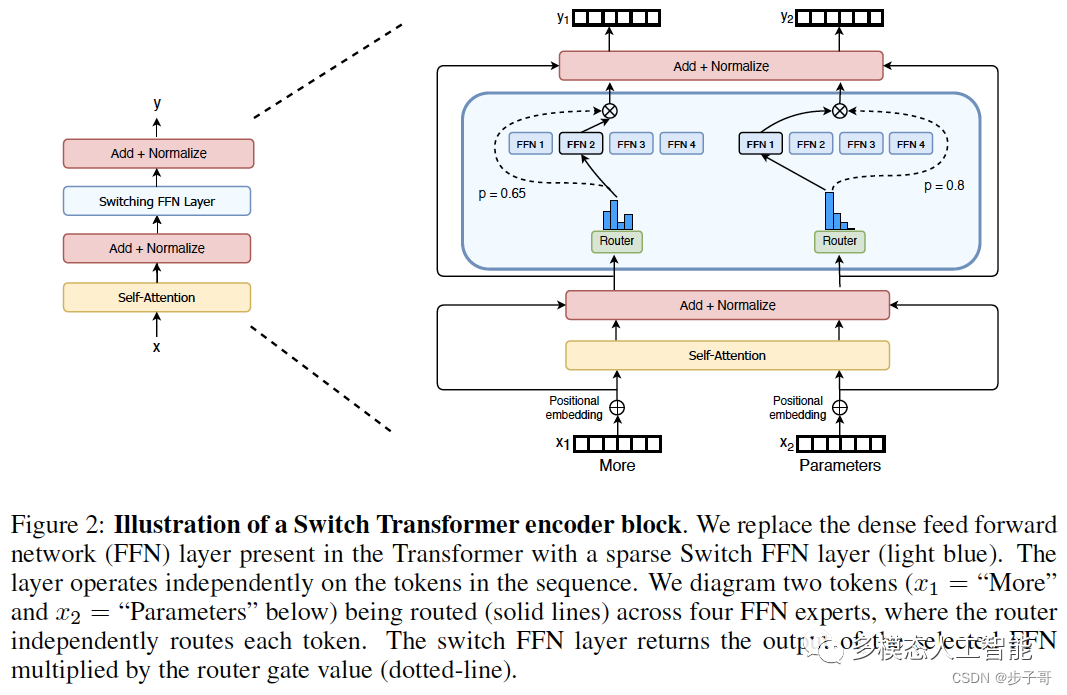

Switch Transformers 的模型架构主要由以下几个部分组成:

-

**专家:**Switch Transformers 由多个专家组成,每个专家都具有独立的参数。专家的数量可以根据需要进行调整。

-

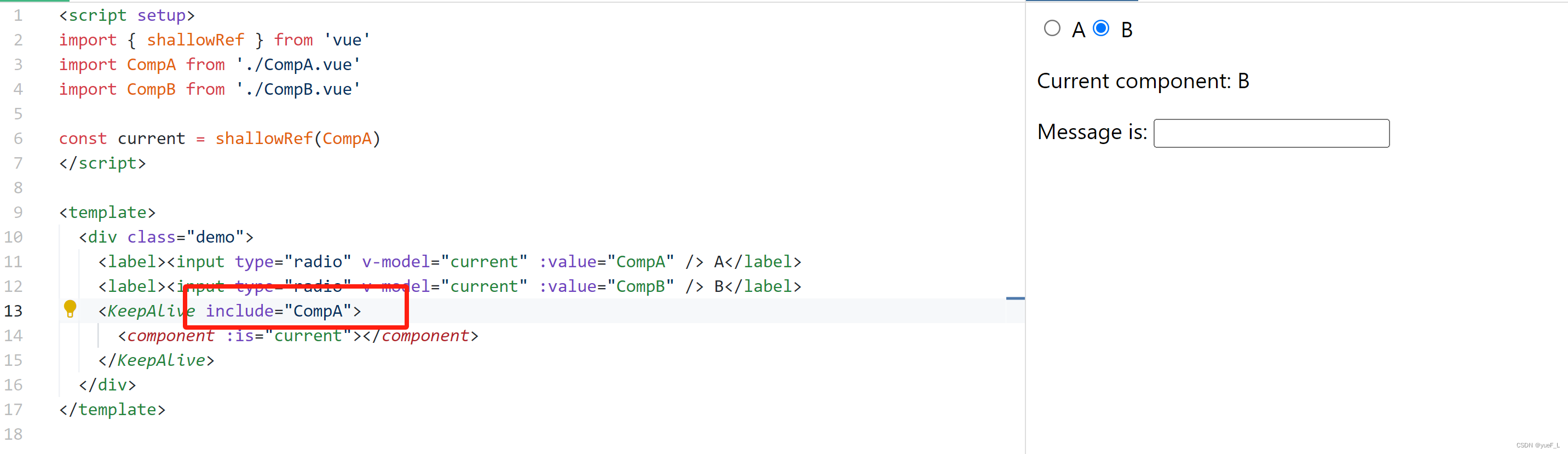

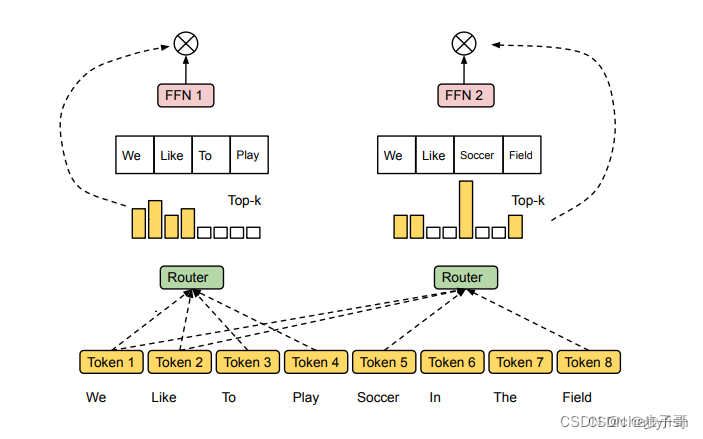

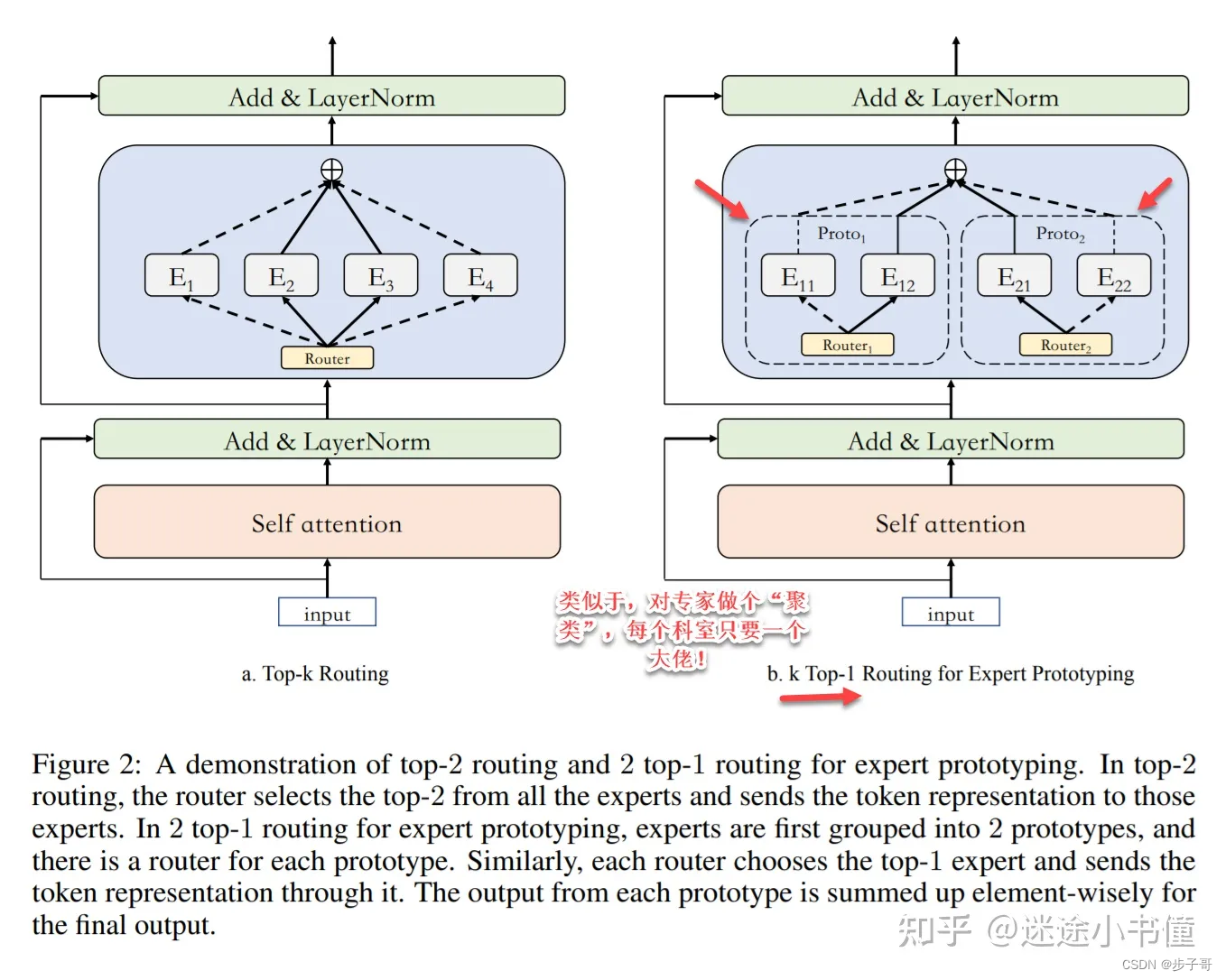

**路由器:**路由器负责根据输入选择合适的专家。路由器可以是简单的门控网络,也可以是更复杂的模型。

-

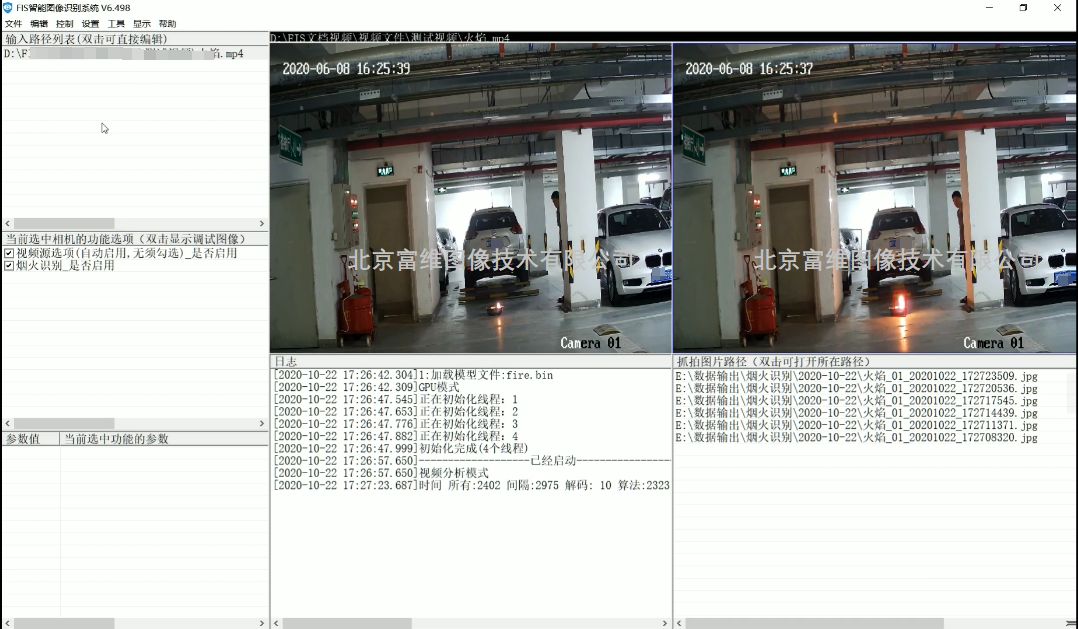

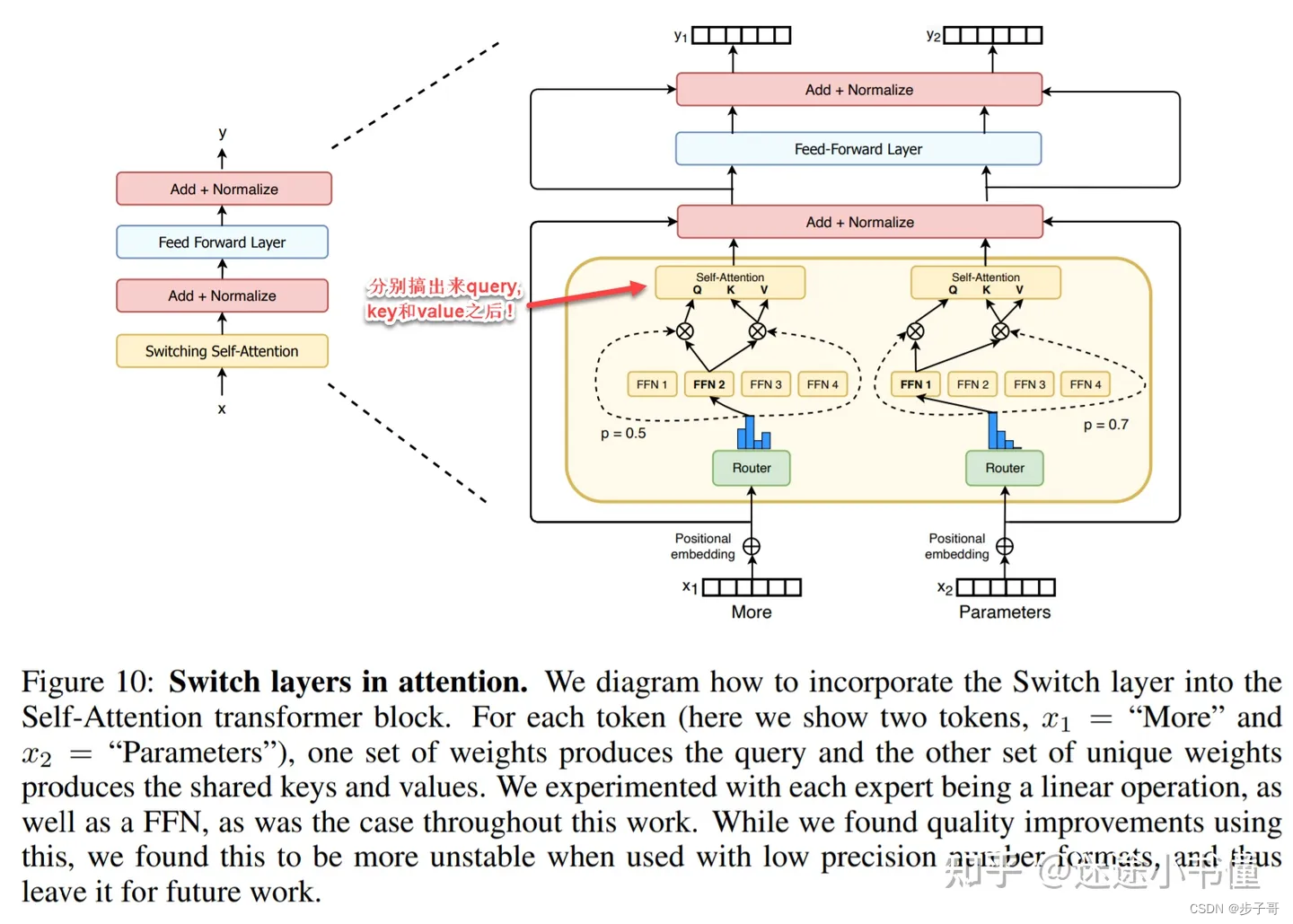

**注意力模块:**注意力模块用于处理输入和专家参数之间的交互。注意力模块可以是标准的 Transformer 注意力模块,也可以是其他改进后的注意力模块。

Switch Transformers 的模型架构可以概括为以下流程:

- 输入首先会被送到路由器。

- 路由器会根据输入选择合适的专家。

- 选择的专家会处理输入。

- 专家的输出会通过注意力模块与输入进行交互。

- 注意力模块的输出会作为模型的最终输出。

Switch Transformers 的模型架构具有以下几个优点:

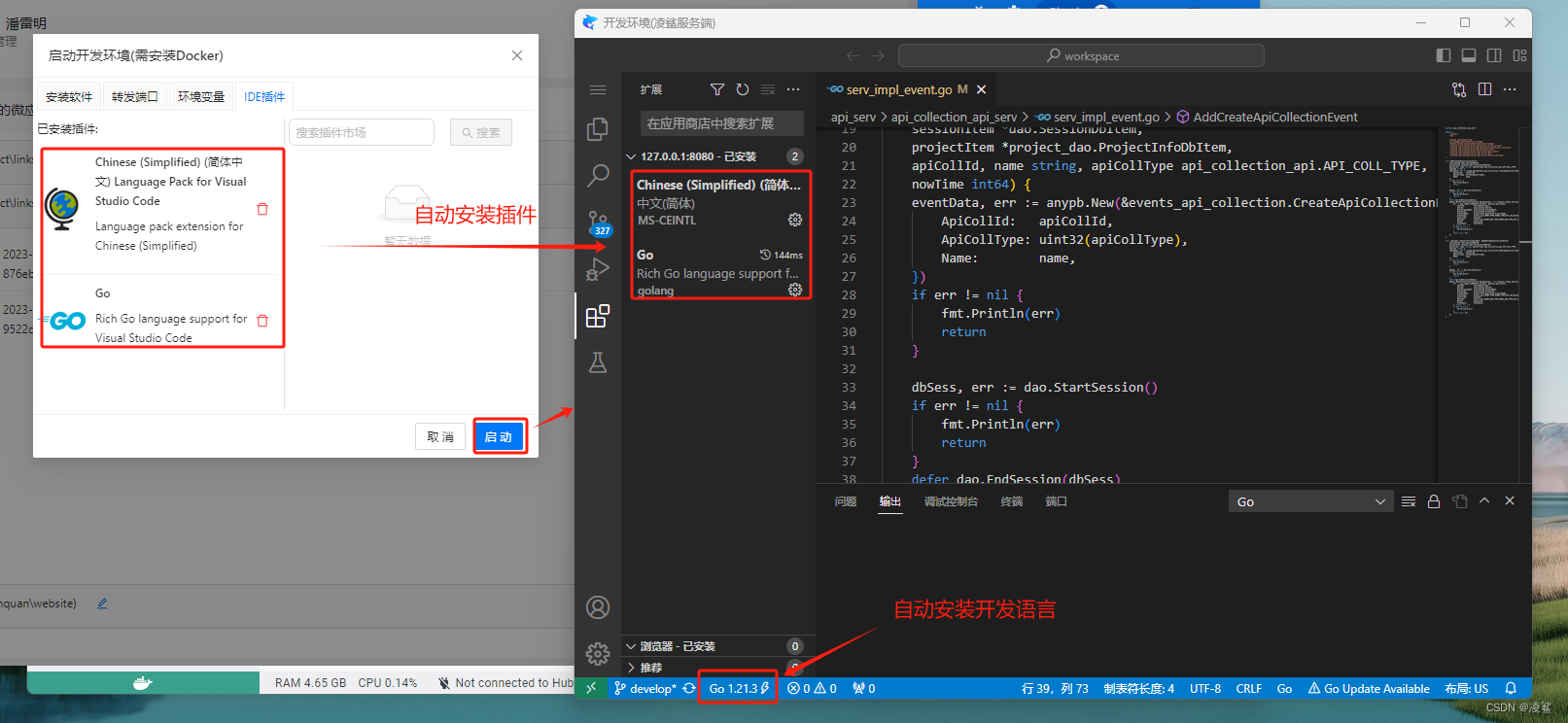

- **参数规模可扩展:**Switch Transformers 可以通过增加专家的数量来扩展参数规模。

- **计算效率高:**由于 MoE 的稀疏性技术,Switch Transformers 在实际运算中只会使用与当前输入相关的专家,因此计算效率不会随着参数数量的增加而大幅下降。

- **可并行化:**MoE 技术易于并行化,Switch Transformers 可以更好地利用分布式计算资源。

Switch Transformers 代表了 Transformer 模型发展的一个重要方向,它通过引入稀疏性和 MoE 技术,为提升模型性能和可扩展性提供了新的可能性。