更多资料获取

📚 个人网站:ipengtao.com

PyWebCopy 是一个用于克隆网页内容的 Python 库,它允许用户从指定的 URL 复制整个网页并保存到本地。本文将介绍 PyWebCopy 的基本用法,以及如何克隆网页并保存网页内容到本地文件夹。

安装 PyWebCopy

在使用 PyWebCopy 之前,需要先安装该库。

通过以下命令进行安装:

pip install pywebcopy

基本使用方法

以下是 PyWebCopy 的基本使用方法:

from pywebcopy import save_webpage

def clone_website(url, dest_folder):

save_webpage(

url=url,

project_folder=dest_folder,

# 可选参数,设置代理服务器等其他参数

)

# 指定要克隆的网页 URL 和目标文件夹

url_to_clone = "https://example.com"

destination_folder = "path/to/destination/folder"

# 调用克隆函数

clone_website(url_to_clone, destination_folder)

更多参数

PyWebCopy 提供了许多可选参数,用于更详细地配置克隆操作。以下是一些常用参数的示例:

bypass_robots_txt:设置为True可以忽略 Robots.txt 文件限制。overwrite:设置为True可以覆盖已存在的文件。depth:设置克隆的深度。connection_timeout:设置连接超时时间。

def clone_website_advanced(url, dest_folder):

save_webpage(

url=url,

project_folder=dest_folder,

bypass_robots_txt=True,

overwrite=True,

depth=3,

connection_timeout=30

)

自定义过滤器

PyWebCopy 允许自定义过滤器以控制克隆过程中要下载的内容。

下面的示例展示如何使用过滤器排除一些文件:

from pywebcopy import web_page

from pywebcopy.filter import filter_regex

def clone_website_with_filter(url, dest_folder):

kwargs = {

'project_folder': dest_folder,

'bypass_robots_txt': True,

'overwrite': True,

'depth': 2,

'connection_timeout': 30

}

def exclude_filter(url):

return not filter_regex(url)

web_page(url, f=exclude_filter, **kwargs)

应用场景

PyWebCopy 在以下情景中特别有用:

- 数据采集和分析:用于抓取网页内容进行数据分析。

PyWebCopy 是一个出色的工具,可用于网页内容的抓取与数据采集。通过复制网页内容到本地文件夹,用户可以轻松获取所需数据,用于后续的分析和处理。例如,对特定网站的文章、评论或其他信息进行采集,并利用Python中的数据分析库进行数据处理和挖掘。

from pywebcopy import save_webpage

def collect_data(url, dest_folder):

save_webpage(

url=url,

project_folder=dest_folder,

bypass_robots_txt=True

)

# 指定要抓取的网页 URL 和保存的文件夹

url_to_collect = "https://example.com"

destination_folder = "path/to/save/data"

# 执行数据采集函数

collect_data(url_to_collect, destination_folder)

这个示例演示了如何使用 PyWebCopy 从指定 URL 上抓取网页内容并保存到本地文件夹,以便进行后续的数据分析处理。

- 建立离线网站副本:保存网站备份,支持离线浏览。

在无网络连接的情况下,创建离线网站副本对于某些用户非常重要。PyWebCopy 允许用户将网页内容保存到本地,创建一个可以在没有网络连接时浏览的离线网站。这在教育、研究或旅行等需要随时查阅网页内容而没有网络连接的场景下非常有用。

from pywebcopy import save_webpage

def create_offline_copy(url, dest_folder):

save_webpage(

url=url,

project_folder=dest_folder,

bypass_robots_txt=True

)

# 指定要保存为离线副本的网页 URL 和文件夹路径

url_to_copy = "https://example.com"

offline_copy_folder = "path/to/save/offline_copy"

# 创建离线副本

create_offline_copy(url_to_copy, offline_copy_folder)

这个示例演示了如何使用 PyWebCopy 创建一个离线网站副本,以便在没有网络连接的情况下进行浏览。

- 网站镜像制作:创建网站镜像以备份或其他用途。

制作网站镜像意味着创建网站的完整副本,包括所有网页、图片和其他媒体文件。PyWebCopy 可以帮助用户复制整个网站并保存到本地,用于备份、存档或其他目的。这对于网站管理员、开发人员或内容创作者来说是一个强大的工具,可以随时备份网站内容以防止数据丢失或用于迁移。

from pywebcopy import save_webpage

def create_website_mirror(url, dest_folder):

save_webpage(

url=url,

project_folder=dest_folder,

bypass_robots_txt=True

)

# 指定要创建镜像的网页 URL 和目标文件夹路径

url_to_mirror = "https://example.com"

mirror_folder = "path/to/save/website_mirror"

# 创建网站镜像

create_website_mirror(url_to_mirror, mirror_folder)

这个示例展示了如何使用 PyWebCopy 创建整个网站的镜像,包括网页、图像和其他媒体文件。

总结

PyWebCopy 是一个功能强大的库,提供了多种方法来克隆网页内容。无论是简单地保存单个页面,还是下载整个网站,PyWebCopy 都为用户提供了灵活的选项和配置功能。

希望本文能帮助你更好地了解 PyWebCopy 的基本使用方法,并在实际应用中充分发挥其功能。通过克隆网页内容,用户可以更方便地进行数据分析和离线浏览。

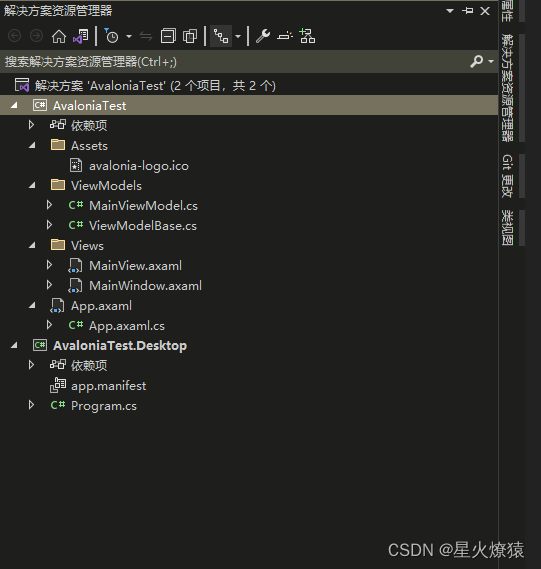

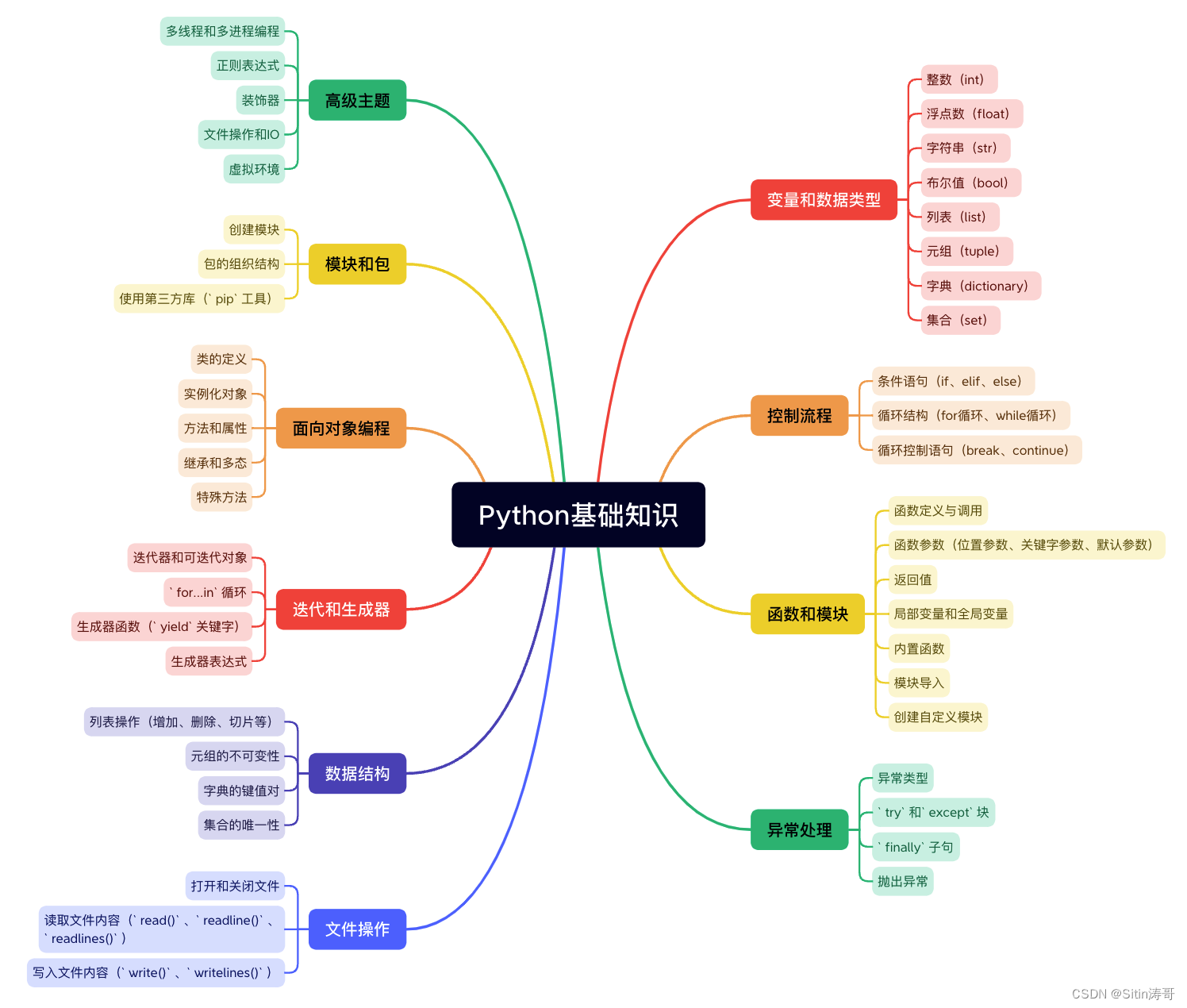

Python学习路线

更多资料获取

📚 个人网站:ipengtao.com

如果还想要领取更多更丰富的资料,可以点击文章下方名片,回复【优质资料】,即可获取 全方位学习资料包。

点击文章下方链接卡片,回复【优质资料】,可直接领取资料大礼包。