一、 初始化集群环境

准备三台 rocky8.8 操作系统的 linux 机器。每台机器配置:4VCPU/4G 内存/60G 硬盘

环境说明:

IP 主机名 角色 内存 cpu

192.168.1.63 xuegod63 master 4G 4vCPU

192.168.1.64 xuegod64 worker 4G 4vCPU

192.168.1.62 xuegod62 worker 4G 4vCPU

1、配置静态 IP:每台机器的网络模式要一致,能互相通信,机器网卡名字也要统一。

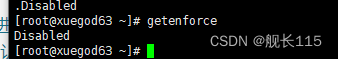

2、永久关闭 selinux 三台都执行

[root@localhost ~]#

sed -i 's/SELINUX=enforcing/SELINUX=disabled/g' /etc/selinux/config#注意:修改 selinux 配置文件之后,重启机器,selinux 才能永久生效

[root@localhost~]#

getenforce执行结果是 Disabled

注释:SELinux(Security-Enhanced Linux)是一种基于 Mandatory Access Control(MAC)的安

全模块,它可以在 Linux 系统中提供强制访问控制机制。通过 SELinux,系统管理员可以对系统中的各种对象(如文件、进程、网络端口等)进行更加精细的安全控制,提高系统的安全性。

在安装 k8s 时,关闭 SELinux 是因为默认情况下 SELinux 会阻止 Kubernetes 一些操作,如

kubelet 对容器文件的访问等。为了避免由于 SELinux 导致 Kubernetes 运行不正常,建议在安装

Kubernetes 之前关闭 SELinux。

如果启用了 SELinux,需要针对 Kubernetes 进行特定的 SELinux 配置,以确保 Kubernetes

正常工作。具体的操作如下:

安装 policycoreutils-python 工具:

yum install -y policycoreutils-python

为 kubelet、kube-proxy 和 container runtime 的进程添加 SELinux 策略。例如,为

kubelet 添加策略的命令为:

semanage fcontext -a -t container_runtime_exec_t /usr/local/bin/kubelet

重载 SELinux 策略:

restorecon -R /usr/local/bin/kubele

3.配置主机名

#在 192.168.1.63 上执行如下:

hostnamectl set-hostname xuegod63 && bash

#在 192.168.1.64 上执行如下:

hostnamectl set-hostname xuegod64 && bash

#在 192.168.1.62 上执行如下:

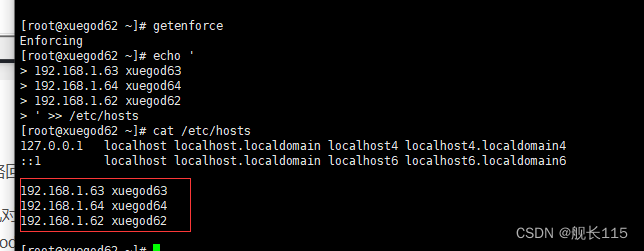

hostnamectl set-hostname xuegod62 && bash4、配置 hosts 文件:

修改三台每台机器的/etc/hosts 文件,在内容最后增加如下三行:

echo '

192.168.1.63 xuegod63

192.168.1.64 xuegod64

192.168.1.62 xuegod62

' >> /etc/hosts

5、安装基础软件包

三台都执行

yum install -y yum-utils device-mapper-persistent-data lvm2 wget net-tools nfs-utils lrzsz gcc gcc-c++ make cmake libxml2-devel openssl-devel curl curl-devel unzip sudo libaio-devel vim ncurses-devel autoconf automake zlib-devel epel-release openssh-server socat conntrack telnet ipvsadm6、配置主机之间无密码登录

[root@xuegod63 ~]# ssh-keygen #一路回车,不输入密码

把本地的 ssh 公钥文件安装到远程主机对应的账户

[root@xuegod63 ~]# ssh-copy-id xuegod63

[root@xuegod63 ~]# ssh-copy-id xuegod64

[root@xuegod63 ~]# ssh-copy-id xuegod62

同理:62和64执行

7、关闭所有主机 firewalld 防火墙

三台都执行

systemctl stop firewalld ; systemctl disable firewalld如果生产机器,防火墙开启,不能关,也可以,但是要放行一些端口:

如何在防火墙规则里放行端口:6443:Kubernetes API Server

2379、2380:etcd 服务

10250、10255:kubelet 服务

10257:kube-controller-manager 服务

10259:kube-scheduler 服务

30000-32767:在物理机映射的 NodePort 端口

179、473、4789、9099:Calico 服务端口

firewall-cmd --zone=public --add-port=6443/tcp --permanent

#--zone 指定了防火墙规则所属的区域,--add-port 指定了要开放的端口号和协议,--

permanent 表示在重启后也会保留这个规则。

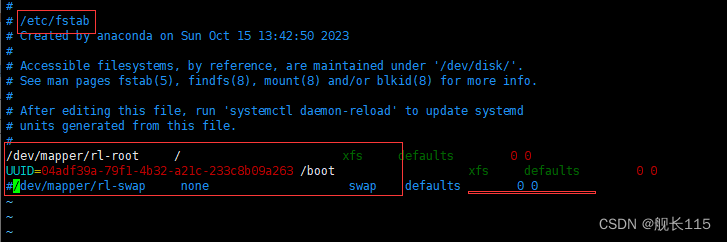

8、关闭交换分区 swap

#临时关闭交换分区 三台都执行

swapoff -a永久关闭:注释 swap 挂载 三台都执行

[root@xuegod63 ~]# vi /etc/fstab #给 swap 这行开头加一下注释#

#/dev/mapper/rl-swap none swap defaults 0 0

交换分区(Swap)是为了在内存不足时,把部分内存的数据交换到硬盘上,以释放内存空间的一种机制。这样,即使物理内存不足,也可以保证系统运行的稳定性和正常性。

在安装 Kubernetes 时,需要禁用交换分区。这是因为 Kubernetes 在运行时需要使用大量的内存

和 CPU 资源,如果系统开始使用交换分区,会导致性能下降,严重影响 Kubernetes 的正常运行。因此,为了保证 Kubernetes 的性能和稳定性,建议在安装 Kubernetes 时禁用交换分区

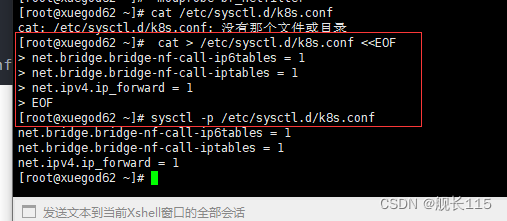

9、修改内核参数:

三台都执行

[root@xuegod63 ~]#

modprobe br_netfiltermodprobe 是一个 Linux 命令,它用于动态地加载内核模块到 Linux 内核中。br_netfilter 是

Linux 内核模块之一,它提供了桥接网络设备和 Netfilter 之间的接口。Netfilter 是 Linux 内核中的一个框架,它可以在数据包通过网络协议栈时进行修改或过滤。

在 Kubernetes 中,br_netfilter 模块用于实现 Kubernetes 集群中的网络功能。通过加载

br_netfilter 模块,我们可以确保在 Kubernetes 集群中使用的 iptables 规则正确应用

[root@xuegod63 ~]#

cat > /etc/sysctl.d/k8s.conf <<EOF

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

net.ipv4.ip_forward = 1

EOF

sysctl -p /etc/sysctl.d/k8s.conf

1)net.bridge.bridge-nf-call-ip6tables: 当数据包经过网桥时,是否需要将 IPv6 数据包传递给

iptables 进行处理。将其设置为 1 表示启用。

2)net.bridge.bridge-nf-call-iptables: 当数据包经过网桥时,是否需要将 IPv4 数据包传递给

iptables 进行处理。将其设置为 1 表示启用。

3)net.ipv4.ip_forward: 是否允许主机转发网络包。将其设置为 1 表示启用。

这些参数是为了让 Linux 系统的网络功能可以更好地支持 Kubernetes 的网络组件(如

flannel、Calico 等),启用这些参数可以确保集群中的 Pod 能够正常通信和访问外部网络

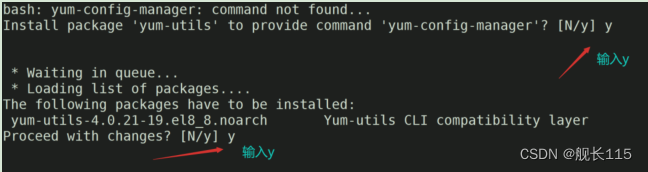

10、配置安装 docker 和 containerd 的需要的阿里云 yum 源 三台都执行

yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo![]()

如果有提示的直接y

11、配置安装 k8s 命令行工具需要的阿里云的 yum 源

配置阿里云 Kubernetes yum 源

cat > /etc/yum.repos.d/kubernetes.repo <<EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64/

enabled=1

gpgcheck=0

EOF备注:

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64/,

这是 Kubernetes 官方在阿里云上提供的 yum 仓库地址,使用这个地址可以从阿里云上下载和安装

Kubernetes 软件包。

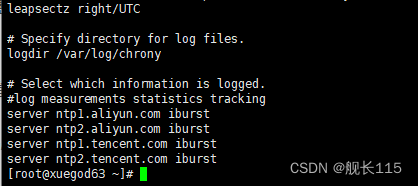

12、配置时间同步 三台都执行

在 xuegod63 上执行如下:

开始安装 chrony 服务

[root@xuegod63 ~]# yum -y install chrony #如果没有该服务安装一下

[root@xuegod63 ~]# systemctl enable chronyd --now #设置 chronyd 开机启动并立即启

动 chronyd 服务同步网络时间

编辑 chronyd 配置文件,使用中国的时间服务器同步时间,速度更快

三台都加 添加阿里和腾讯时间同步源 配置文件 /etc/chrony.conf

cat >> /etc/chrony.conf <<EOF

server ntp1.aliyun.com iburst

server ntp2.aliyun.com iburst

server ntp1.tencent.com iburst

server ntp2.tencent.com iburst

EOF

chrony 是网络时间协议(NTP)的另一种实现,与网络时间协议后台程序(ntpd)不同,它可以更快地且

更准确地同步系统时钟。

两个主要程序:chronyd 和 chronyc

chronyd:后台运行的守护进程,用于调整内核中运行的系统时钟和时钟服务器同步。它确定计算机增减时间的比率,并对此进行补偿

chronyc:命令行用户工具,用于监控性能并进行多样化的配置。它在 chronyd 实例控制的计算机

上工作服务 unit 文件: /usr/lib/systemd/system/chronyd.service

监听端口: 323/udp,123/udp

配置文件: /etc/chrony.conf

ntpdate 和 chrony 是服务器时间同步的主要工具,两者的主要区别就是:

1、执行 ntpdate 后,时间是立即修整,中间会出现时间断档;

2、而执行 chrony 后,时间也会修正,但是是缓慢将时间追回,并不会断档。

重启 chronyd 服务

[root@xuegod62 ~]#

systemctl restart chronyd配置时间定时同步

写个计划任务,定时同步时间:

[root@xuegod63~]# crontab -e

5 * * * * /usr/bin/systemctl restart chronyd #每5分钟同步一次

在 Kubernetes 集群中,各个组件之间的通信和协调都需要依赖时间的同步,如果集群中各节点时

间不一致,可能会导致各种奇怪的问题,例如节点之间无法进行正确的 TLS 握手等。因此,建议在安装Kubernetes 集群之前,将集群中各个节点的时间同步到相同的时间源,保持时间的一致性

![[vue3] 使用 vite 创建vue3项目的详细流程](https://img-blog.csdnimg.cn/direct/4c7294755eb74506b4d4bc37c30270d2.png)