😍 这篇主要简单记录一些调参实践,无聊时会不定期更新~

文章目录

- 0、学习率与batch_size判断

- 1、Epoch数判断

- 2、判断模型架构是否有问题

- 3、大模型 - 计算量、模型、和数据大小的关系

- 4、大模型调参相关论文经验总结

- 5、训练时模型的保存

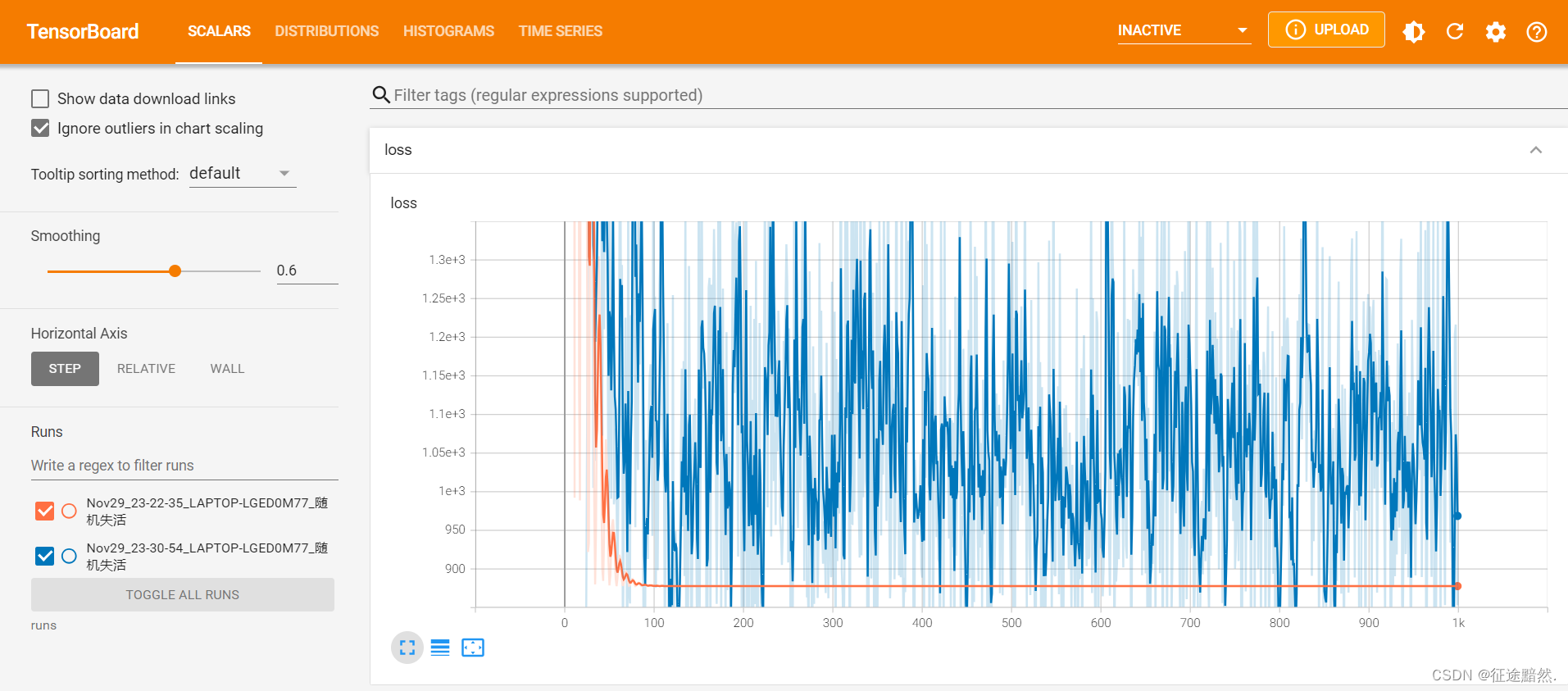

0、学习率与batch_size判断

- batch_size: 这不用多说,一般按2的指数设置如:2、4、8、16…。设多大基本看你的显卡显存能不能hold得住咯。

- 学习率: 常用的一些自适应学习率调整策略如:linear_with_warmup、cosine_with_warmup。现在像一些大模型如ChatGLM、LLaMA等的训练里基本都用的cosine。学习率基本就是:3e-5, 4e-5, 5e-5…这样调。

- 学习率与batch_size的关系: 一般来说,batch_size的大小一般与学习率的大小成正比。batch_size越大一般意味着算法收敛方向的置信度越大,也可以选择较大的学习率来加快收敛速度。而小的batch_size规律性较差,需要小的学习率保证不出错。在显存允许的情况下,选择大的batch-size。

1、Epoch数判断

- 1、观察训练集和验证集的损失函数(loss)和准确率(accuracy)的变化曲线,如果训练集的指标持续下降或上升,而验证集的指标开始出现反向变化或者停滞不动,那么可能就是过拟合或者欠拟合的现象,需要及时停止训练或者调整参数。【😄提一小点:有时候玄学在于过拟合不一定会导致模型效果变差, 有时反而相反。可以参考instructgpt论文,或者自己在数学、代码等任务试验一下,往往过拟合效果是更好的】

- 2、使用预训练模型(pre-trained model),比如BERT,GPT等,在大规模的数据集上进行了长时间的训练,已经学习到了很多通用的特征和知识,所以在微调的时候只需要少量的epoch就可以达到很好的效果。

- 3、Early Stopping,即在每个epoch结束后,用验证集评估模型的性能,如果性能没有提升或者下降了一定次数,就停止训练,并保存最佳的模型。

⭐似乎在一些预训练大模型上开始微调,基本就是wamup用5个左右的epoch;cosine schedule用10个左右的epoch尝试。咱也不知对不对,我以往是这样搞的。自己可以变大变小试试。

2、判断模型架构是否有问题

⭐ 我觉得可以用部分数据,训多几个epoch,看看模型会不会过拟合,如果会,那模型大概没啥问题。

3、大模型 - 计算量、模型、和数据大小的关系

在大模型的研发中,通常会有下面一些需求:

- 计划训练一个10B的模型,想知道至少需要多大的数据?

- 收集到了1T的数据,想知道能训练一个多大的模型?

- 老板准备1个月后开发布会,给的资源是100张A100,应该用多少数据训多大的模型效果最好?

- 老板对现在10B的模型不满意,想知道扩大到100B模型的效果能提升到多少?

以上这些问题都可以基于Scaling Law的理论进行回答。本文是阅读了一系列 Scaling Law的文章后的整理和思考,包括Scaling Law的概念和推导以及反Scaling Law的场景。

⭐ 解析大模型中的Scaling Law: https://zhuanlan.zhihu.com/p/667489780

4、大模型调参相关论文经验总结

下面是知乎清华老哥的总结:

- 最近在做一些大模型微调的工作。开始的时候比较头疼怎么调超参数,毕竟不能像小模型那样疯狂跑实验,看结果积累经验了,一是计算量太大,二是大模型比较不好评估(毕竟让模型做选择题不能准确的评估性能,一些垂类领域也很难搞到相关测试集,大部分在微调的工程师都是在调垂类模型吧:)。

- 其次,如果用GPT4评估又涉及到数据隐私问题,同时下边列举的一篇文章显示,GPT4更倾向于给句子长的、回答更多样性的答案更高的分数,有时候也是不准的。。。)。最后也只能多看看微调/训练相关的论文借鉴借鉴经验了。下边会列出一些最近看的文章,给出重要结论以及我的一些个人观点,如果有感兴趣就去精读一下,希望能帮助到一些微调er,本文章不定期更新。。。

- ⭐ 文章链接:https://www.zhihu.com/question/607397171

5、训练时模型的保存

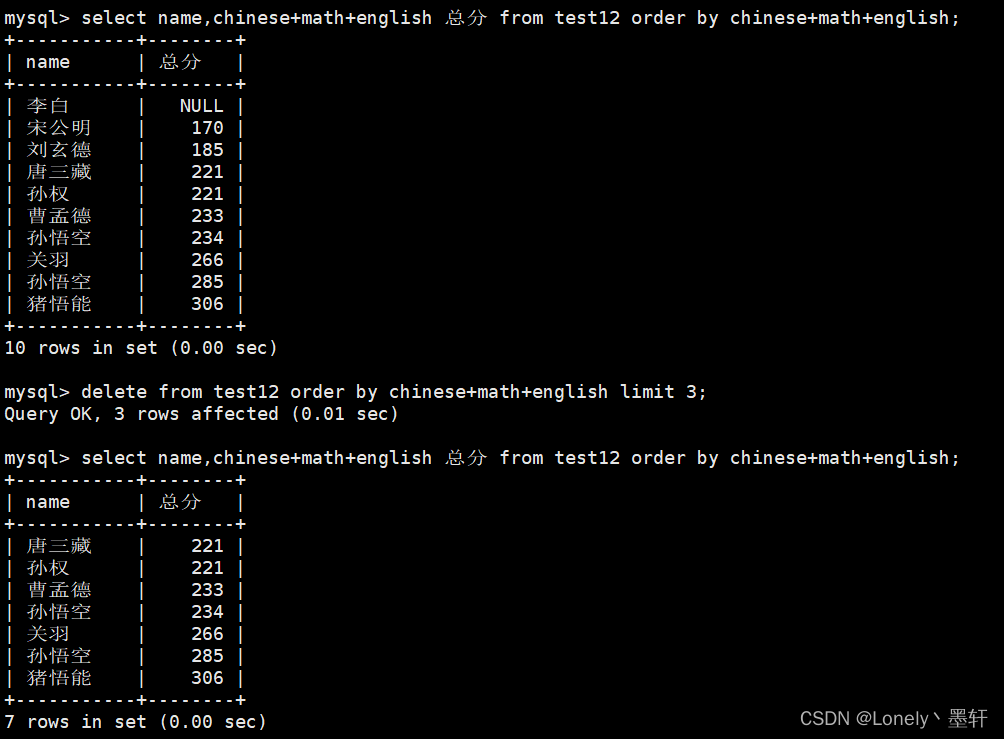

- 一般来说我们会搞个验证集,设置一个评估指标,训练到多少个step或是1个epoch时,测一遍验证集,每次保存在验证集上最优指标对应的模型。

- 现在的一些大模型训练,基本在训练时不搞验证集,而是看train loss来保存最优模型。最常见的是每隔多少个step,保存一次模型checkpoint。最后训练结束后,再根据loss或是各个checkpoint在验证集的表现来挑个最优模型。

![navigator.clipboard is undefined in JavaScript issue [Fixed]](https://img-blog.csdnimg.cn/direct/ba5792b02780438988eb14aa11d2788d.png)