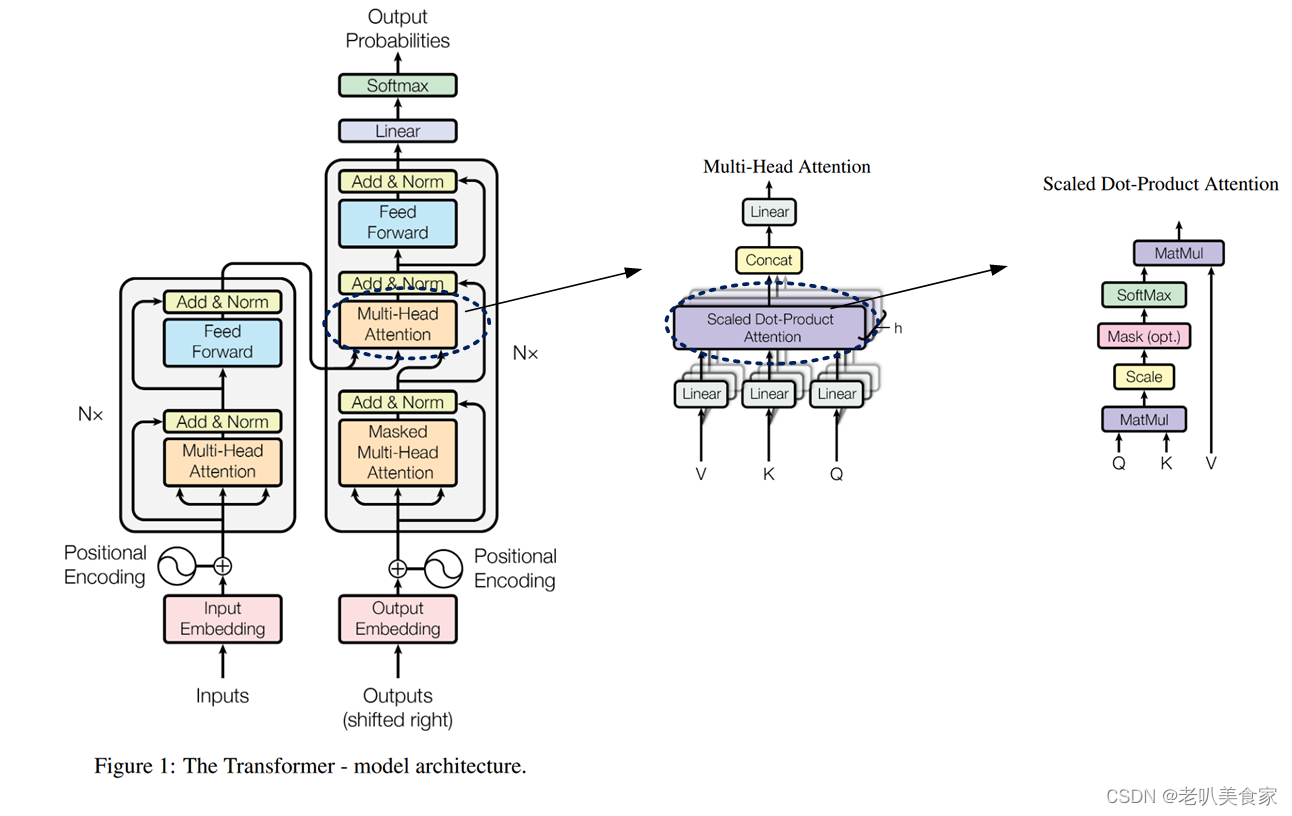

Attention Is All You Need

目前暂时不会用到,大概了解一下即可。

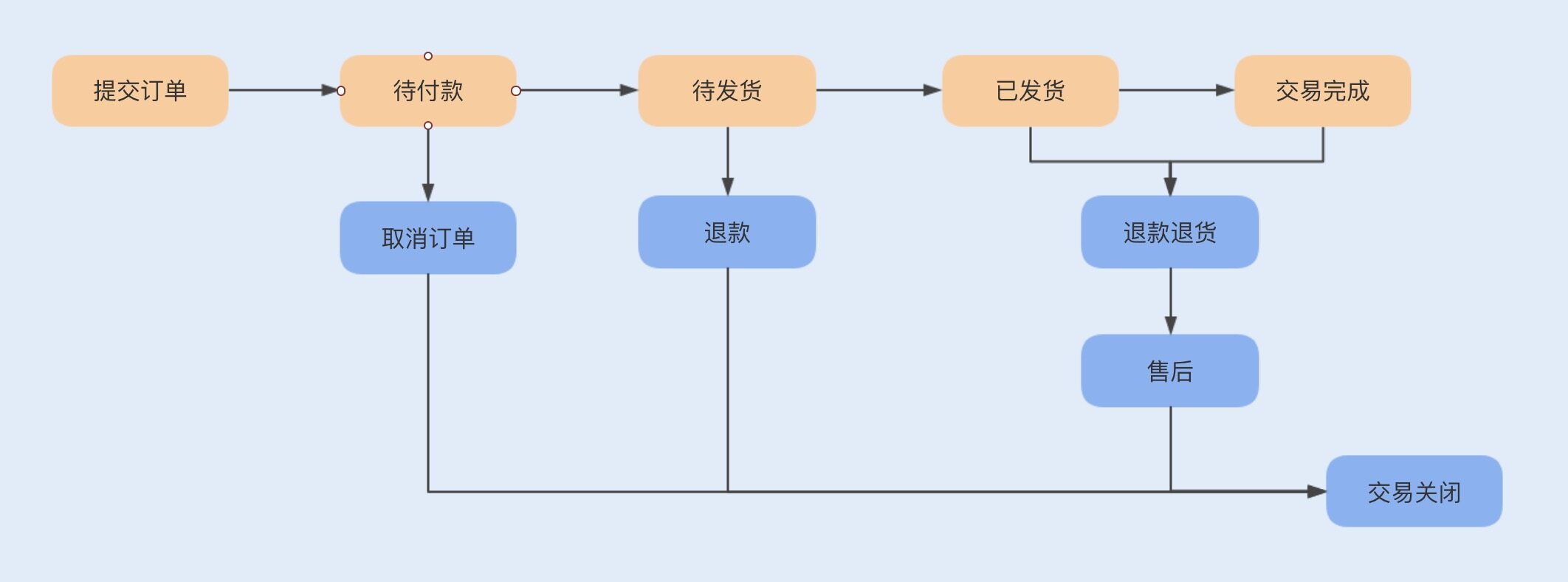

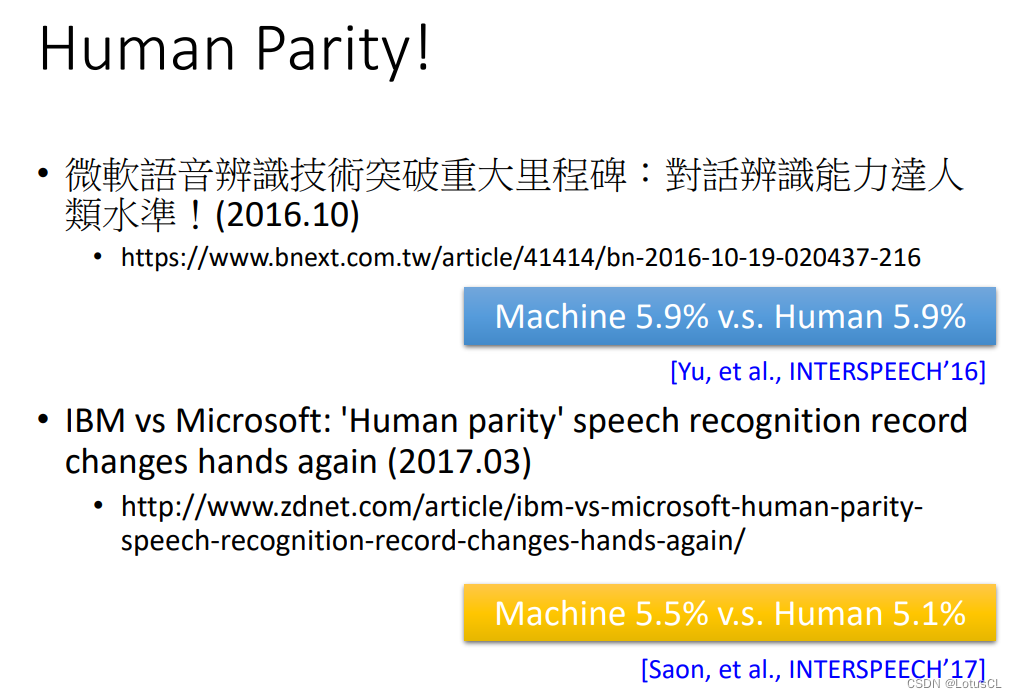

Recurrent model 序列化的计算方式,难以并行,随着序列的增长,以前的记忆会逐渐丢失。而Attention机制可以观察到句子中所有的信息,不受距离影响,而且可以并行计算。

参考资料:

-

Youtube video:

李沐老师

https://www.youtube.com/watch?v=nzqlFIcCSWQ -

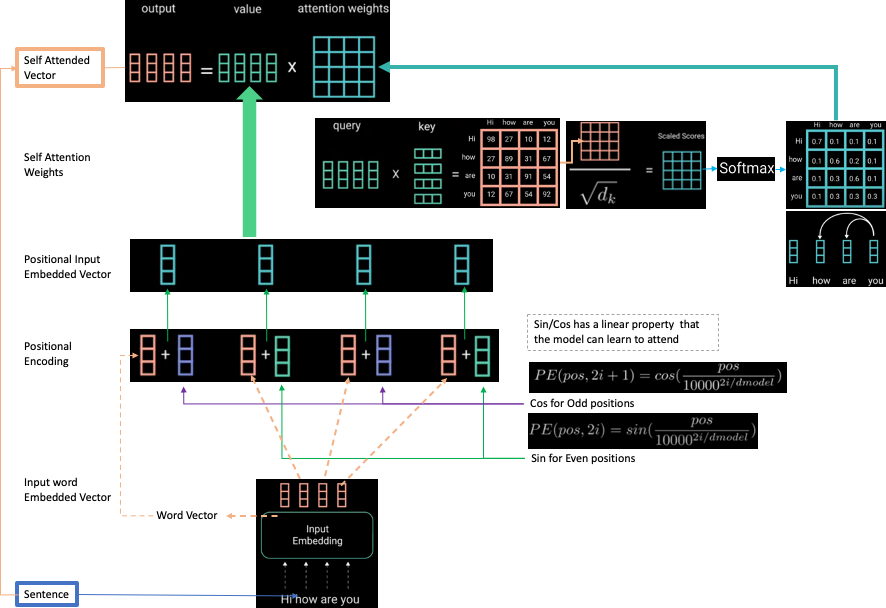

Q,K,V分别的含义:

这个链接里面有很多讲解,比较详细。https://stats.stackexchange.com/questions/421935/what-exactly-are-keys-queries-and-values-in-attention-mechanisms

![[Docker]十二.Docker consul集群搭建、微服务部署,Consul集群+Swarm集群部署微服务实战](https://img-blog.csdnimg.cn/direct/7b513e16e28447cf9e0666a1e37fafee.png)