Supervised-unsupervised combined deep convolutional neural networks for high-fidelity pansharpening

(监督-非监督组合深度卷积神经网络实现高保真全色锐化)

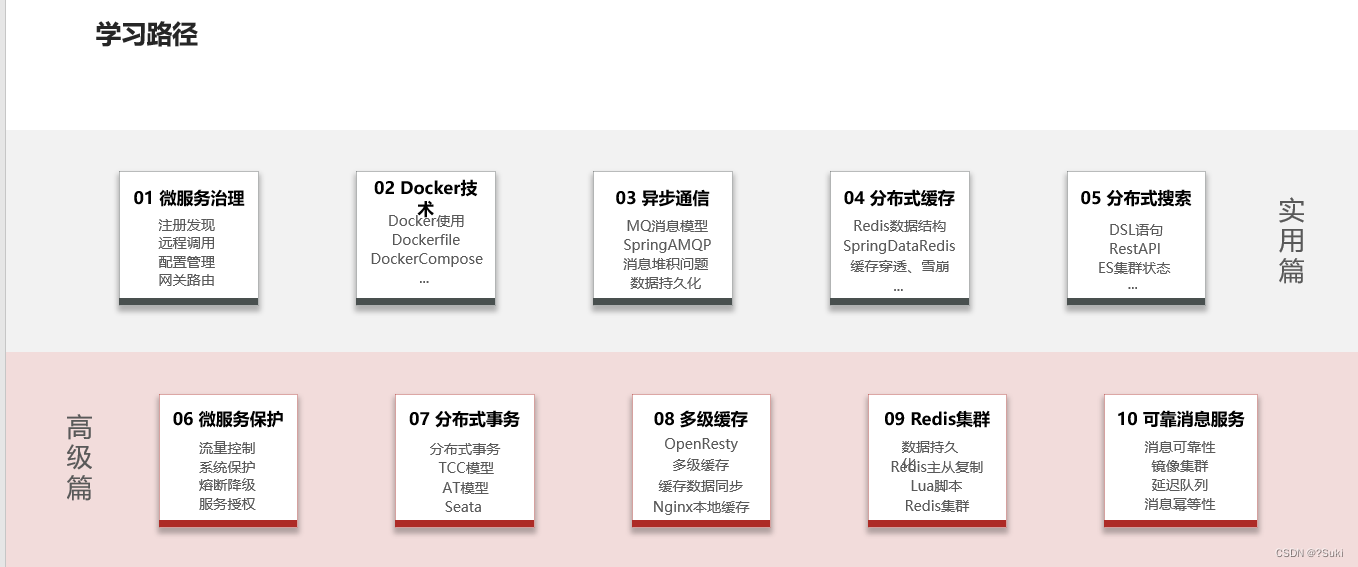

深度学习全色锐化方法因其优异的性能成为近年来的研究热点,基于Wald协议的卷积神经网络全色锐化方法(即,在较粗的降低的分辨率尺度上学习的网络到较细的全分辨率的一般采用)在该研究领域中已经占主导地位很长时间。然而,尺度不变假设可能不够精确,无法充分利用原始全色(PAN)和多光谱(MS)图像在全分辨率下的空间和光谱信息。针对这一问题,提出了一种监督-非监督组合融合网络 (SUFNet) 用于高保真全色锐化。首先,综合考虑参考标签图像网络的鲁棒性,结合多尺度机制、扩张卷积和跳跃连接,提出了一种基于Wald协议的有监督网络SMDSNet。然后,提出了一种无需真实的高空间分辨率(HR)MS标记图像的无监督空间光谱补偿网络(USSCNet),以提高SMDSNet的空间和光谱保真度。在不同卫星数据集上进行的降分辨率和全分辨率实验的定性和定量结果验证了该方法的有效性。此外,USSCNet还可以作为其他全色锐化方法的通用空间谱补偿框架。

介绍

由于卫星成像系统的局限性和其他因素的影响,遥感卫星必须在空间分辨率和光谱分辨率之间进行权衡。相应地,大多数卫星提供高空间分辨率(HR)全色(PAN)图像和高光谱分辨率但相对较低空间分辨率(LR)的多光谱(MS)图像。全色锐化的目的是利用全色图像的高空间优势和质谱图像的光谱优势互补来获得高分辨率质谱图像。到目前为止,研究人员已经开发了多种全色锐化方法,大致可以分为四类:基于组件替换(CS)的方法、基于多分辨率分析(MRA)的方法、基于变分优化(VO)的方法和基于深度学习(DL)的方法。

基于CS和MRA的方法是从传统或一般理解的角度发展起来的。传统意义上,基于压缩感知方法的主要过程包括正投影变换、压缩感知和逆投影变换。具体地,通过在正投影变换之后替换MS在不同域中的空间分量,然后应用逆变换,来获得融合的HR-MS图像。基于MRA的方法的第一步是将MS图像和PAN图像分解为不同的尺度和分辨率,然后采用一定的融合策略对不同分辨率的图像进行融合。基于VO的方法将融合过程视为逆问题,其中基于稀疏表示理论或贝叶斯理论,利用先验正则化约束来构造变分融合能量泛函。通过使用迭代优化算法最小化能量函数来重建全色锐化图像(例如,梯度下降)。与基于CS和MRA的方法相比,基于VO的方法通常具有更好的空间和光谱质量。然而,大多数基于VO的方法是基于线性关系的假设,这可能不能准确地表示融合图像和观测值之间的复杂关系。

基于DL的全色锐化方法近年来受到越来越多的关注,该方法依赖于大规模数据集学习理想融合后的HR-MS图像与观测值之间的非线性关系。据我们所知,Huang等人提出了第一种基于DL的全色锐化方法,该方法通过深度神经网络从HR/ LR全色图像中学习非线性关系。随后,Masi等人提出了一种基于卷积神经网络(CNN)的全色锐化方法(PNN),其通过类似于超分辨率CNN的结构的三层CNN来实现。Zhong等人提出了一种两阶段图像融合算法,该算法基于CNN对MS图像进行超分辨率处理,并采用Gram-Schmidt模型对增强后的MS和PAN图像进行融合。

然而,上述基于DL模型的全色锐化方法仅采用了三层卷积,通常不能充分利用DL模型强大的非线性表示能力。因此,需要开发更深层次的网络来改善DL模型的性能。特别是Yuan等人提出了一种多尺度多深度卷积神经网络(MSDCNN),它将多尺度提取和多深度共享引入到CNN结构中,以提高融合性能。Wei等人提出了一种具有双流网络的耦合多尺度卷积(CMC)模型,该模型采用多尺度非对称卷积来分别提取PAN图像和MS图像的特征。Zhang等人在传统方法和CNN结构的基础上,引入了双向金字塔网络(BDPN)来解决全色锐化问题,将从PAN图像中提取的多层次细节特征注入到上采样的MS图像中,重建全色锐化图像。受残差网络成功的启发,Yang等人引入了泛锐化深度网络(PanNet),该网络在高通域中训练网络以保持空间,并将上采样MS图像添加到网络输出以保持光谱。Deng等人提出了一个详细的注入网络(FusionNet),并引入了三个带有残差网络的网络来提高融合性能。Wei等人引入了使用深度残差的深度神经网络(DRPNN)以获得高质量的融合结果,这允许网络学习更深的特征以增强模型的非线性能力。Scarpa等人提出了一种目标自适应的基于神经网络的全色锐化方法(TAPNN),并引入了一种目标自适应的使用模态,该方法在MS和PAN图像之间的失配方面也具有良好的性能。Liu等人提出了一种双流融合网络(TFNet),通过更深的残差网络在特征层面融合MS和PAN图像。除了上述基于CNN的工作外,还有一些基于GANs的工作。Liu等人提出了一种基于GAN的深度神经网络用于全色锐化(PSGAN),这是首次尝试使用GAN生成高质量全色锐化图像。Shao等人提出了一种将自动编码器与条件GAN相结合的深层神经网络(RED-cGAN),该网络使用两分支网络提取空间和光谱信息,并通过自动编码器结构生成全色锐化图像。Ma等人提出了一种基于GAN(Pan-GAN)的无监督全色锐化框架,该框架采用两个不带地面真实值的鉴别器分别保留光谱和空间信息。

总体而言,迄今为止,基于神经网络的全色锐化方法,特别是基于Wald协议的监督方法在该领域占据了主导地位。然而,大多数基于DL的有监督方法都是以原始MS图像作为伪地面真值,在降低的分辨率下进行网络训练,然后将训练好的模型直接应用于原始PAN和MS图像,得到全分辨率下的融合图像。一方面,直接采用由粗到细训练的模型可能不太准确,并且可能导致一些尺度相关的问题。由于PAN和MS图像之间空间分辨率的巨大差异,尺度不变假设不成立。另一方面,基于Wald协议的DL融合方法未能充分利用原始全色和MS图像在全分辨率下的空间和光谱信息,导致融合结果中空间和光谱信息的丢失。

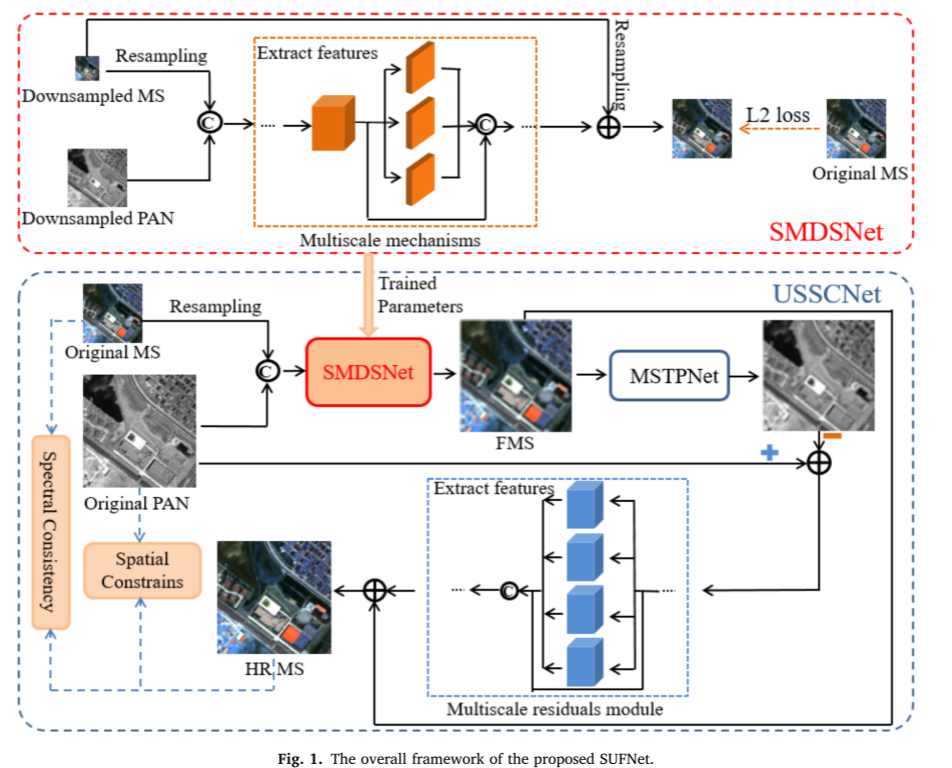

为了克服上述问题,本文提出了一种监督-非监督组合融合网络(SUFNet)来实现高保真全色锐化。首先,在综合考虑参考标签图像网络鲁棒性的基础上,构造了一种基于Wald协议的监督网络。然后将训练好的有监督网络应用于原始PAN和MS图像以获得初步融合图像。其次,提出了一种有趣的无监督空间-光谱补偿网络,以改善初步融合图像的空间细节和光谱保真度。最后,通过有监督-无监督组合网络得到高保真的融合图像。

贡献

1)提出了一种基于监督-非监督融合网络(SUFNet)的高保真全色锐化方法,与其他基于DL的深度网络技术相比,该方法能够充分利用全色图像的空间细节和质谱的光谱信息。

2)对于该监督网络,设计了两种多尺度机制,分别使用普通卷积和膨胀卷积来充分提取PAN图像的空间信息。此外,在卷积网络中,局部和全局跳跃连接分别用于防止图像丢失空间细节和光谱信息。

3)综合考虑有监督网络中可能存在的空间和光谱损失,提出了一种有趣的无监督空间-光谱补偿网络(USSCNet)。设计了多尺度残差模块和长跳跃连接注入缺失的空间细节进行空间谱增强,设计了两个尺度的谱损失进行谱补偿。此外,USSCNet还可以扩展到其他全色锐化融合方法中,进一步提高融合的保真度。

方法

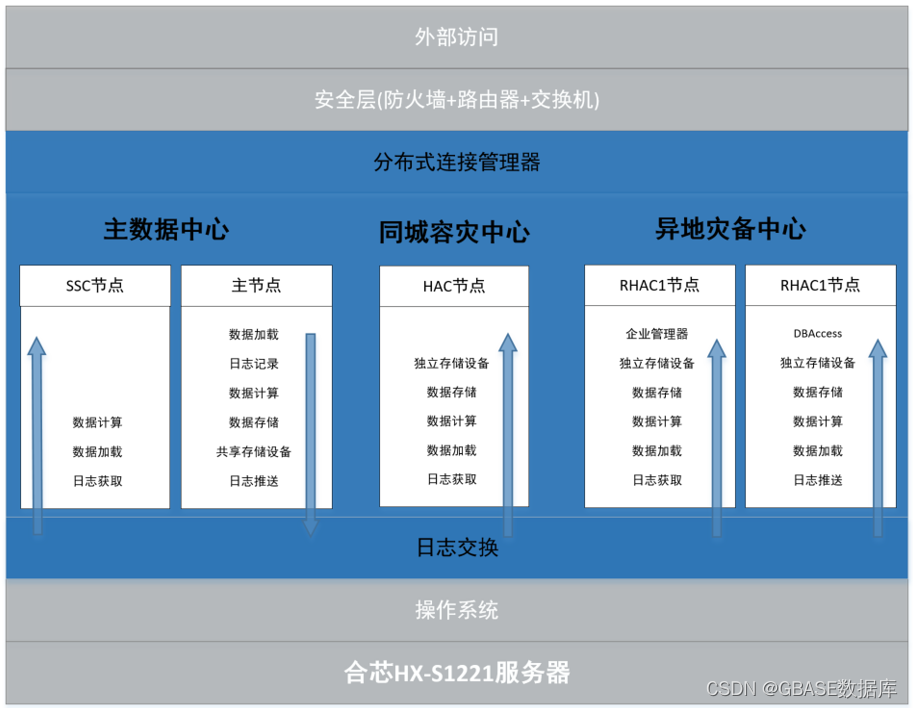

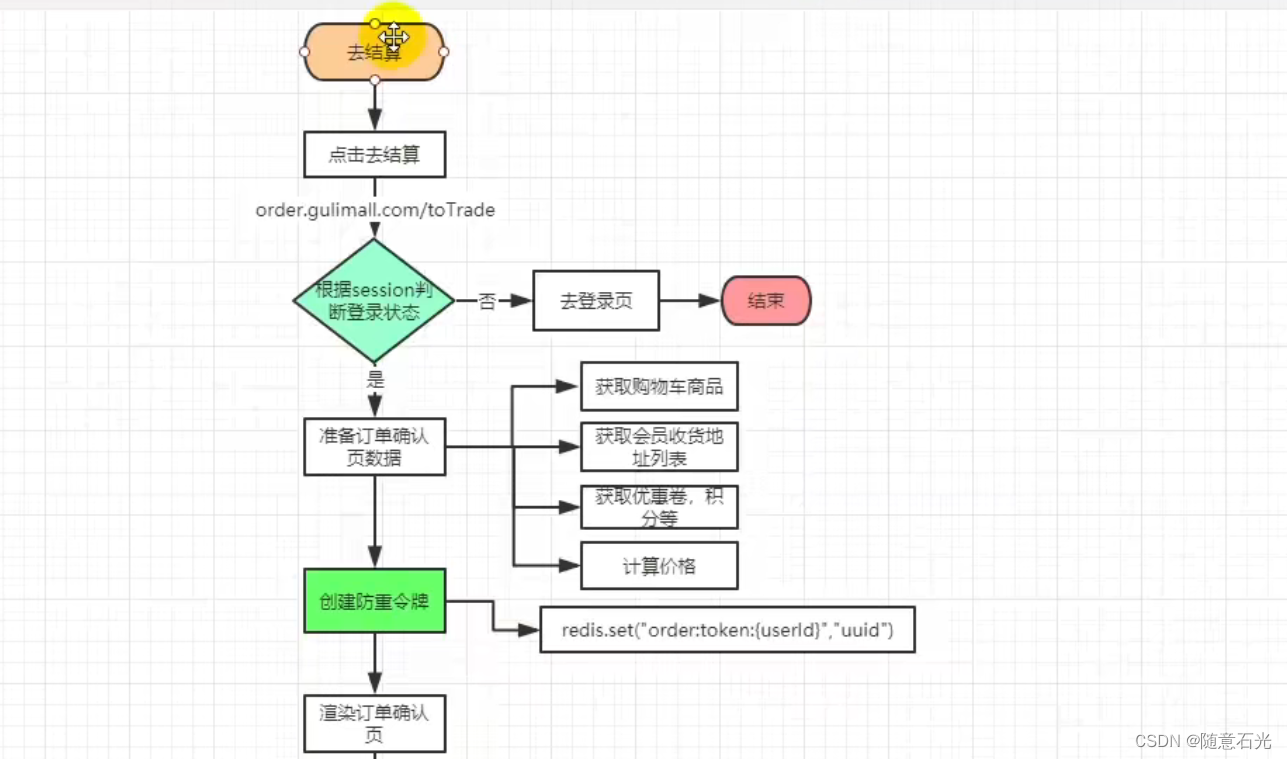

本文提出了一种用于高保真全色锐化的监督-非监督组合融合网络(SUFNet),如图1所示。

首先,考虑到真实的HR-MS参考图像不可用于网络训练,提出了一种基于Wald协议的有监督融合网络(即对原始PAN和MS图像进行空间退化生成训练样本,并将原始MS作为网络训练的ground truth)。该方法综合考虑了多尺度机制、膨胀卷积和跳跃连接。然后,将训练好的模型应用于原PAN和MS图像的全分辨率融合。在此基础上,综合考虑降分辨率训练数据集与全分辨率测试图像之间空间分辨率尺度差异可能导致的信息损失,提出了一种新颖的无监督空间-光谱补偿网络(USSCNet),以改善空间细节和光谱保真度。在USSCNet中,MS到PAN网络(MSTPNet)被设计用于将MS图像转换为PAN图像以改善空间细节。

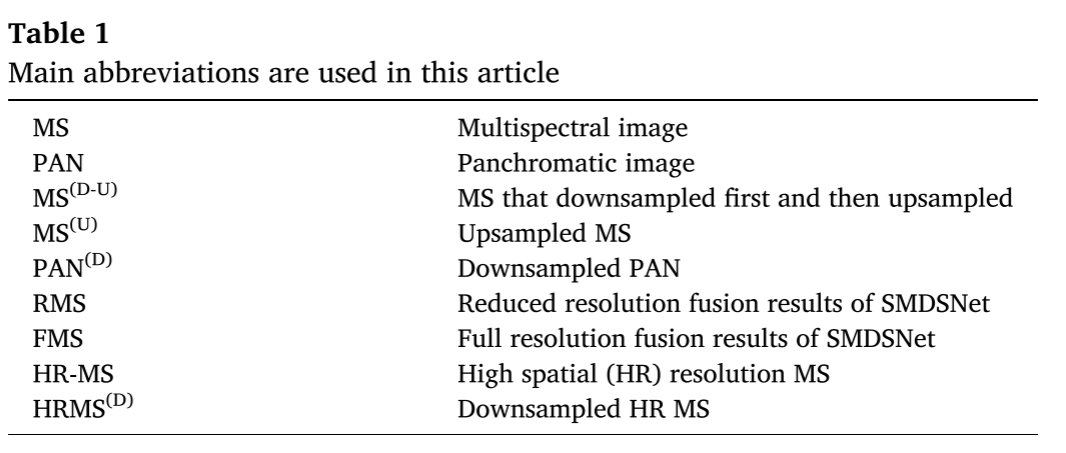

为了便于理解,将尺寸为w × h × B的原始MS图像表示为MS,w和h分别为MS图像的宽度和高度,B表示MS条带的数量。将尺寸为W × H × 1的高分辨率PAN图像表示为PAN,W和H分别为PAN图像的宽度和高度。为方便起见,表1中列出了一些重要的缩略语。

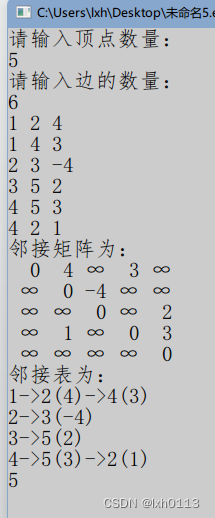

Supervised fusion network (SMDSNet)

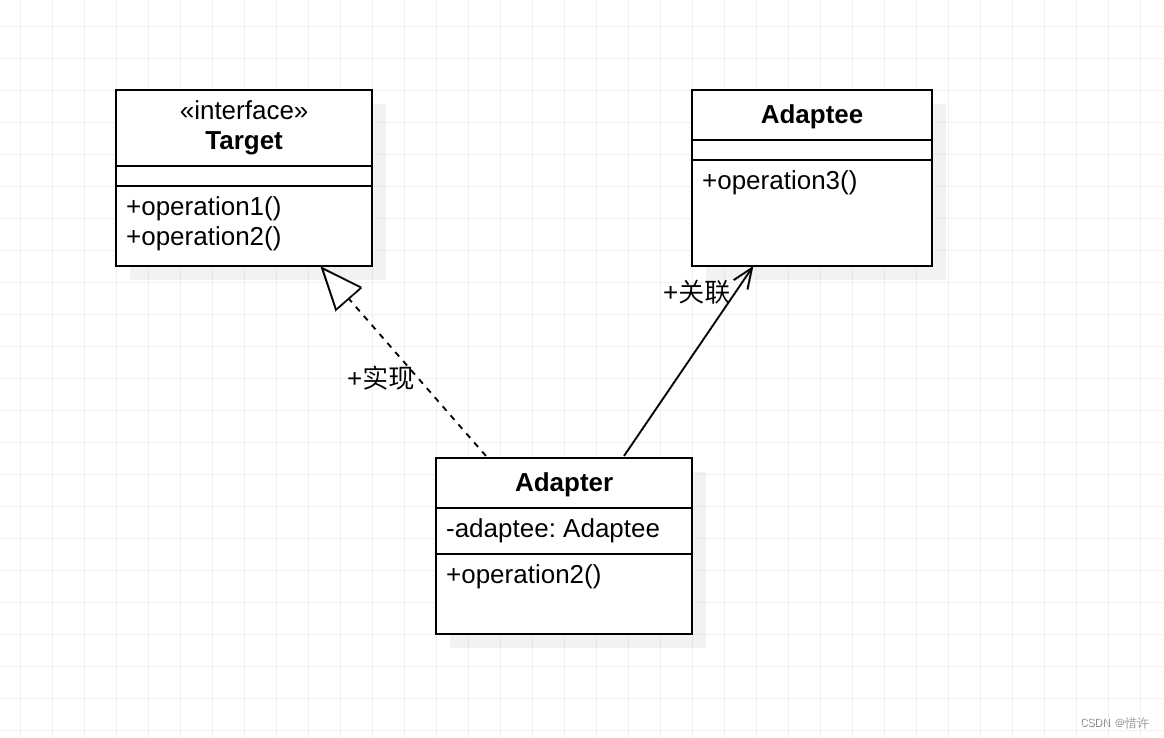

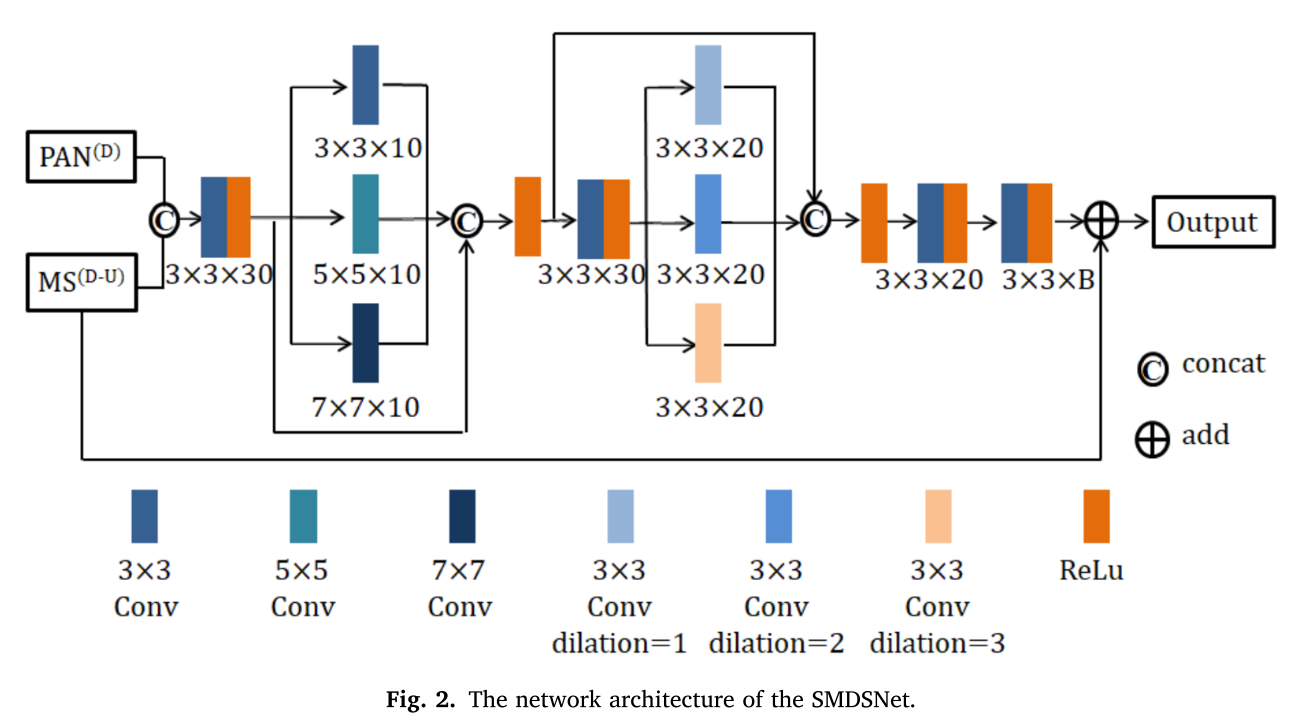

为了充分利用PAN图像中的空间细节和MS图像中的光谱信息,我们提出了一种使用多尺度机制、扩张卷积和跳跃连接的监督网络(SMDSNet),如图2所示。

网络中使用了两种不同的多尺度机制,以提高对各种复杂场景特征提取的鲁棒性。在第一种多尺度机制中,多尺度卷积单元包含三个具有不同核大小的卷积运算。在第二种多尺度机制中,利用扩张卷积以相同的参数和计算来扩大感受野。此外,受DenseNet结构的启发,采用跳跃连接避免特征信息的丢失,将前一层的特征信息转移到当前层以保持特征信息,避免或减少消失梯度问题。

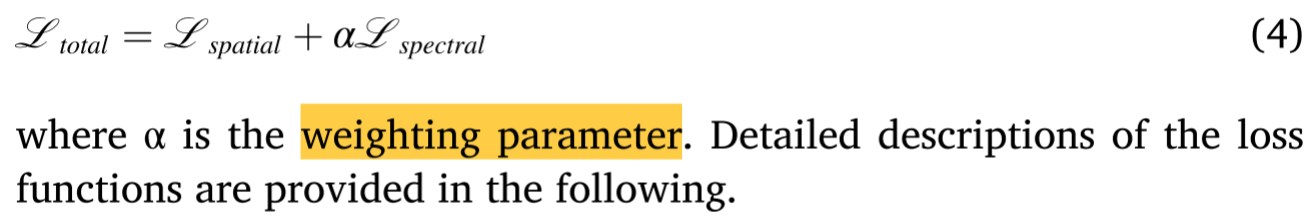

损失函数可表示为:

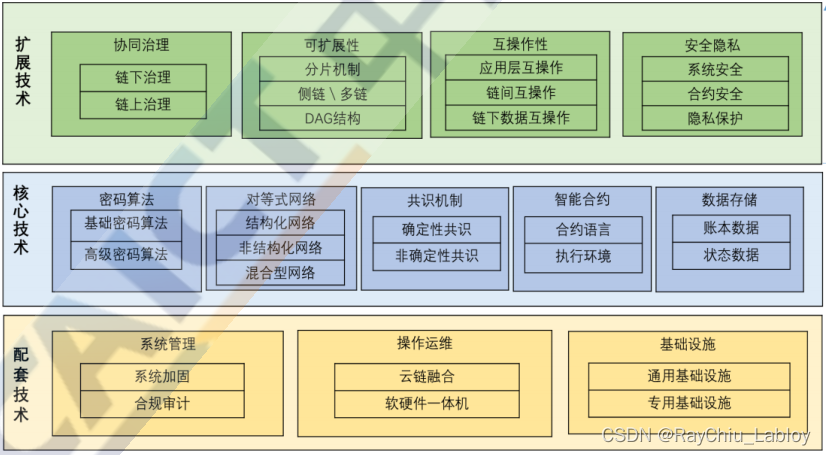

Unsupervised spatial-spectral compensation network (USSCNet)

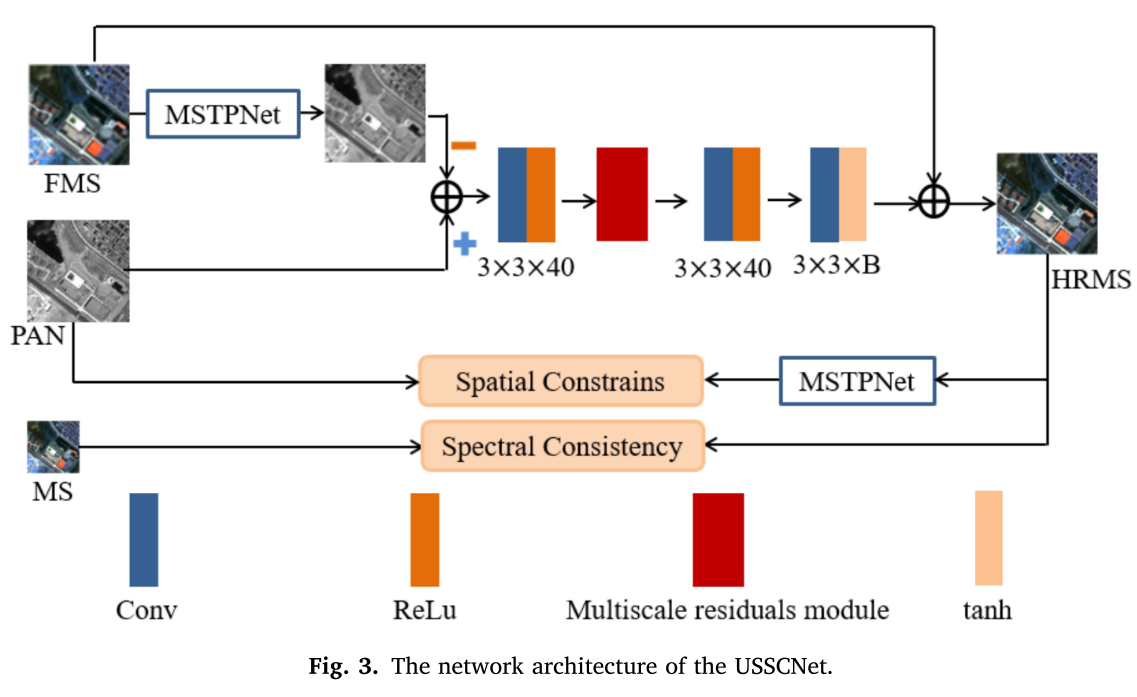

提出了一种无监督空间谱补偿网络(USSCNet)来补偿SMDSNet中的信息损失,如图3所示。

首先通过SMDSNet得到初步的全分辨率融合结果(FMS),然后利用预训练的MSTPNet将FMS转换为伪PAN图像。SMDSNet在全分辨率下丢失的空间细节是通过从原始PAN图像中减去伪PAN图像获得的。然后将丢失的空间细节注入到FMS中,得到最终的融合结果。然后将丢失的空间细节注入到FMS中,得到最终的融合结果。

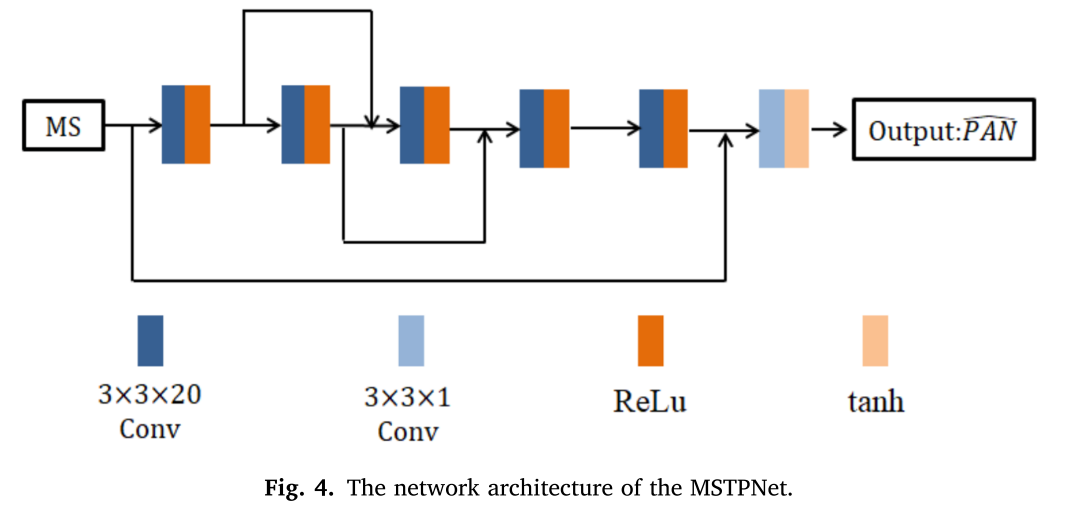

MSTPNet

为了获得SMDSNet输出中丢失的空间细节,设计了一个称为MSTPNet的网络,将MS图像映射到单波段伪PAN,如图4所示。

映射关系可以用公式表示为:

其中FMS是SMDSNet在全分辨率下的融合结果。原始MS图像和对应的降采样PAN图像分别作为输入和地面真实值来训练MSTPNet。

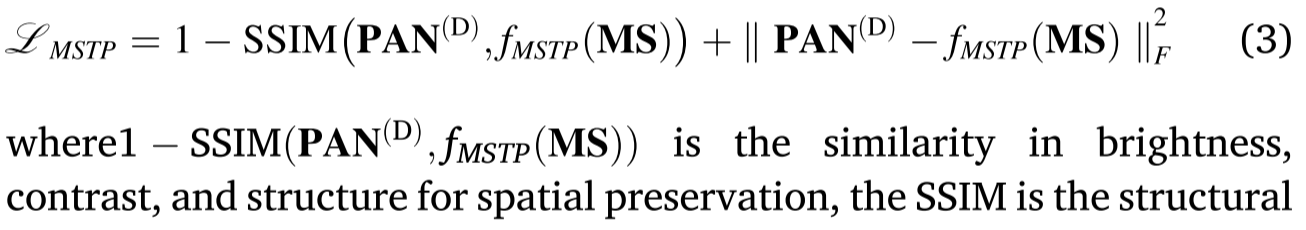

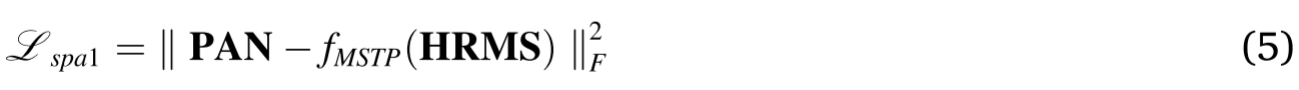

损失函数可以用公式表示为:

SSIM是结构相似性指数度量,MS表示原始MS图像,

P

A

N

(

D

)

PAN^{(D)}

PAN(D)表示下采样PAN图像。fMSTP(⋅)的最优解是通过最小化Eq.(3)中定义的Adam优化损耗函数来实现的。

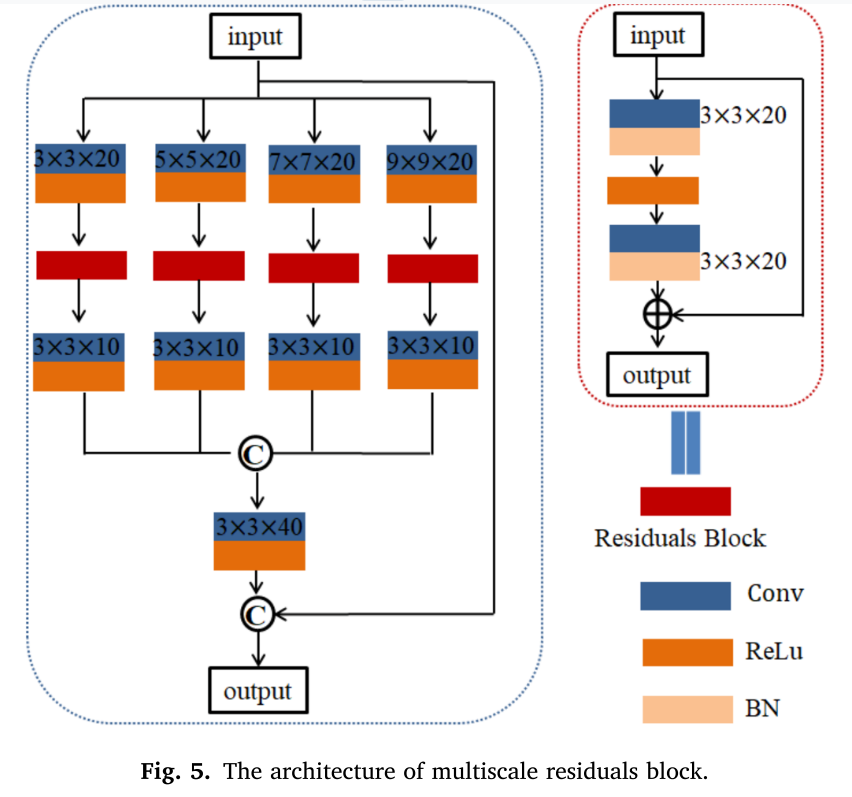

Multiscale residuals module

为了实现空间细节保留和感受野扩大之间的平衡,多尺度残差模块被设计为完全提取多上下文特征信息,如图5所示。

光谱保护,获得的FMS SMDSNet直接添加到输出的无损的信息传播。此外,跳过连接是用来防止信息丢失的过程中网络传播和USSCNet实施更有效的培训。

Unsupervised loss function

分别设计空间损失函数和光谱损失函数,以保持PAN图像的空间结构和MS图像的光谱信息,用于无监督训练。特别地,使用预训练的MSTPNet将MS图像映射到用于空间损失函数的单波段伪PAN图像。在光谱损失函数方面,设计了一种新的两尺度一致性光谱损失函数,以保持网络输出与MS图像之间相似的光谱信息。损失函数可描述如下:

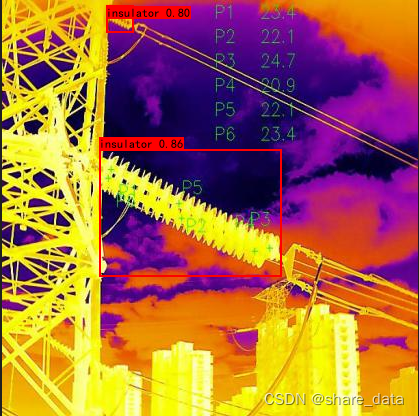

Spatial constraints

利用MSTPNet可以建立MS图像与单波段伪PAN图像之间的映射关系,也可以将USSCNet获得的HRMS图像转换为伪PAN图像。这样,USSCNet的输出和原始PAN图像之间的空间相似性可以被约束。为了进一步确保亮度、对比度和结构的相似性,我们将SSIM和MSE添加到空间约束,如下所述:

Spectral consistency

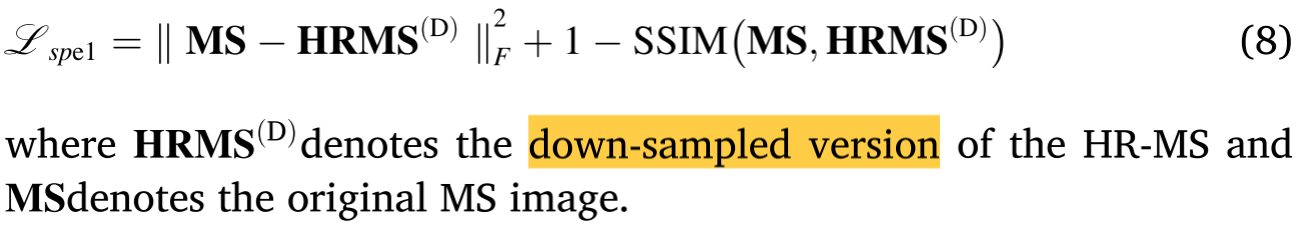

设计了两个尺度的光谱损失,以确保USSCNet的输出在光谱上与原始MS图像相似,而不损失高频信息。我们首先将HR-MS下采样到与MS相同的分辨率以获得下采样的HR-MS,表示为

H

R

M

S

(

D

)

HRMS^{(D)}

HRMS(D),然后将

H

R

M

S

(

D

)

HRMS^{(D)}

HRMS(D)与对准的MS进行比较以计算光谱一致性损失:

然而,如果仅在下采样版本中设计频谱一致性,则会出现频谱失真。通过观察发现,重采样后的质谱图像与模糊后的HR-MS图像在光谱和空间信息上是一致的。因此,使用高斯滤波器模糊HR-MS图像,然后用上采样的MS图像约束HR-MS图像以实现光谱信息的高保真度。上采样尺度下的频谱损失函数可以描述如下:

其中

M

S

(

U

)

MS^{(U)}

MS(U)表示原始MS图像的上采样版本,GS(⋅)表示高斯滤波操作。最终的光谱损失函数可以描述如下:

与不考虑训练和测试阶段规模差异造成的信息丢失问题的监督方法相比,USSCNet采用无监督方式弥补监督方法中的信息丢失。此外,USSCNet还可以扩展到其他全色锐化方法,进一步提高图像的保真度。