一、数据集成概念

数据集成是指将来自不同数据源的数据整合到一个统一的数据存储中,并确保这些数据能够互相关联、交换和共享的过程。在数据集成的过程中,数据通常需要经过清洗、转换和统一格式化等步骤,以确保数据的一致性、完整性和可用性。

如何将数据集成落到实处呢?一般要考虑几个关键方面,比如业务数据目标需求、数据清洗预处理、合适的数据集成工具技术、数据安全等。下面结合ETLCloud在几个常见的业务场景实操演示下数据集成的实施过程。

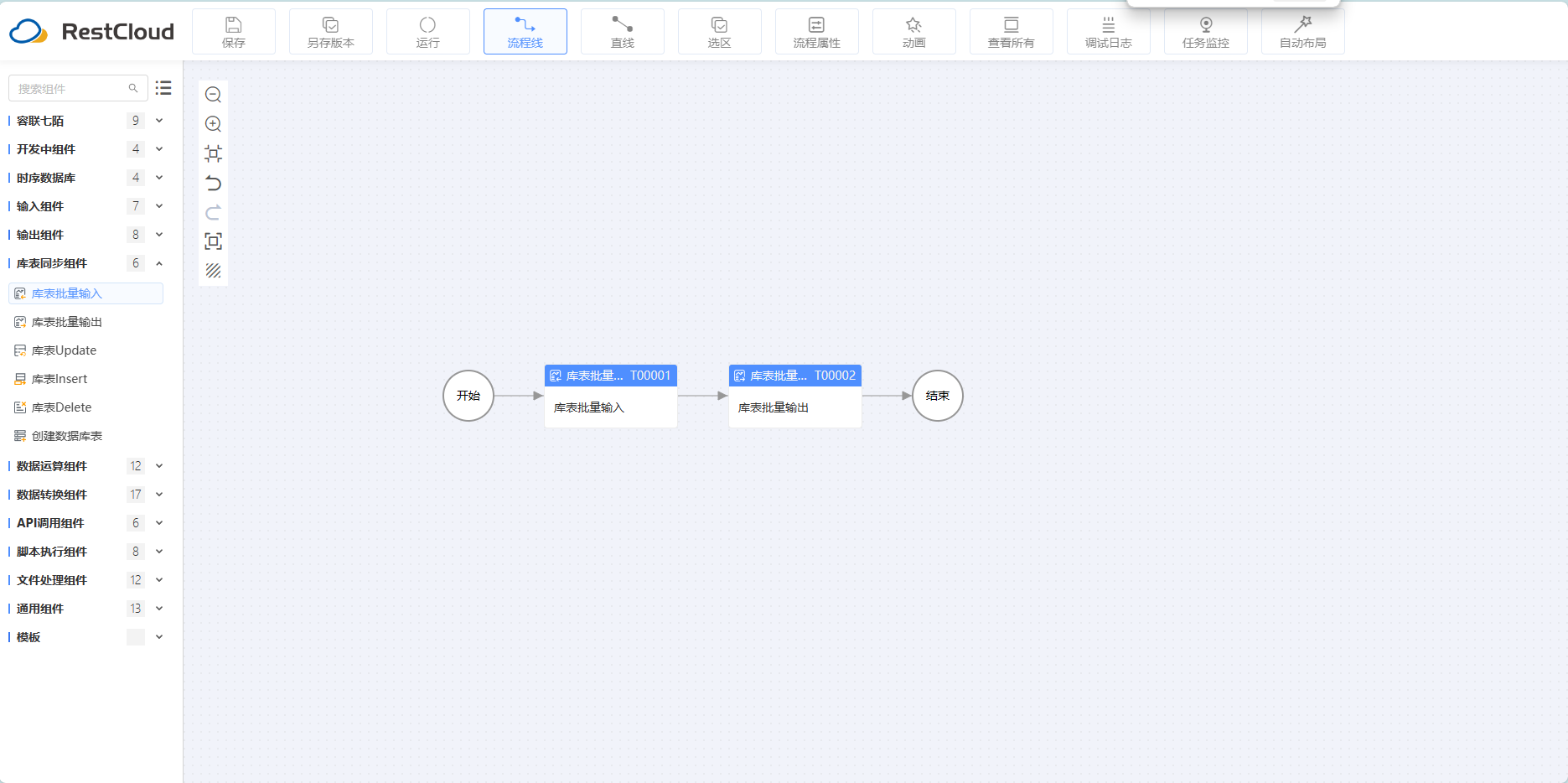

工具平台界面:

二、场景案例实操

1、数据清洗转换

数据清洗和转换是数据集成过程中不可或缺的环节。在数据集成之前,通常需要对数据进行清洗,包括去除重复数据、处理缺失值、解决数据格式不一致等问题。此外,还需要对数据进行转换,以确保不同数据源的数据能够统一格式和结构。

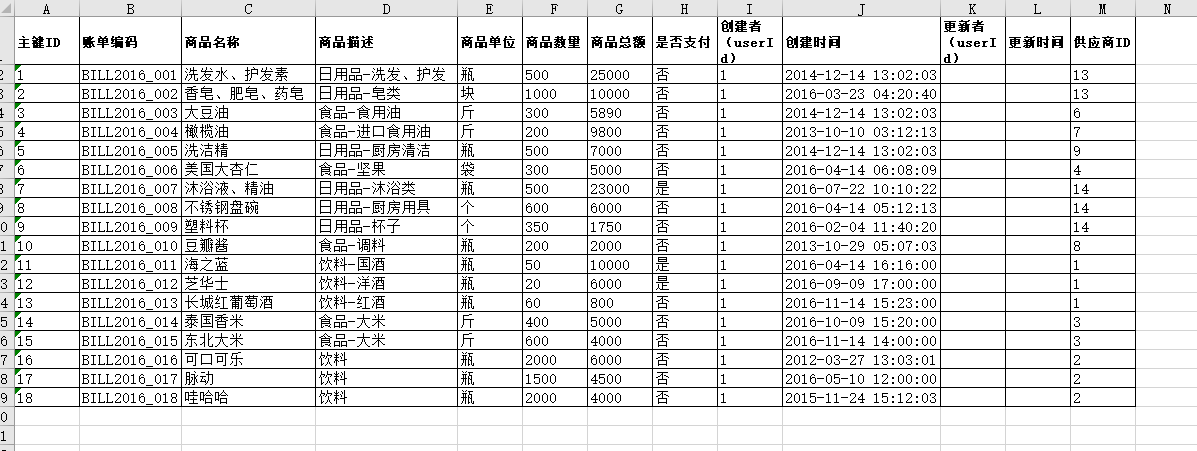

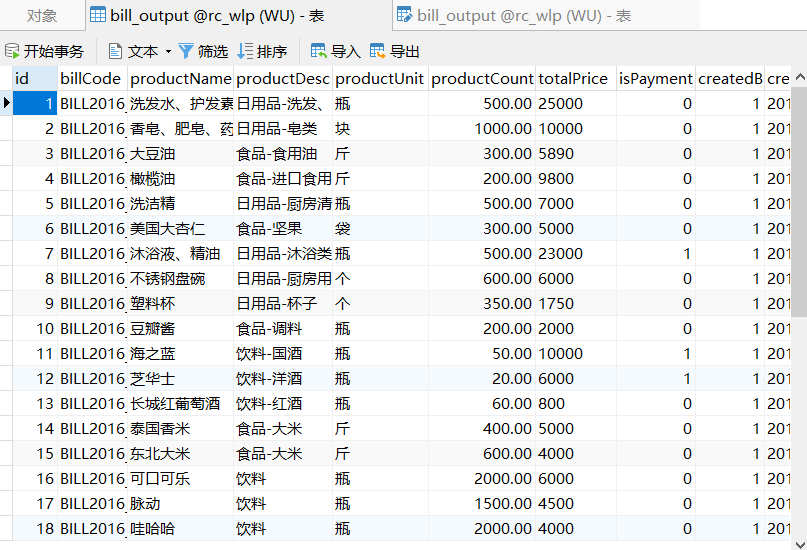

假设我们这里需要将Excel表格中的数据清洗转换后输出至库表中进行存储。

(Excel表格数据)

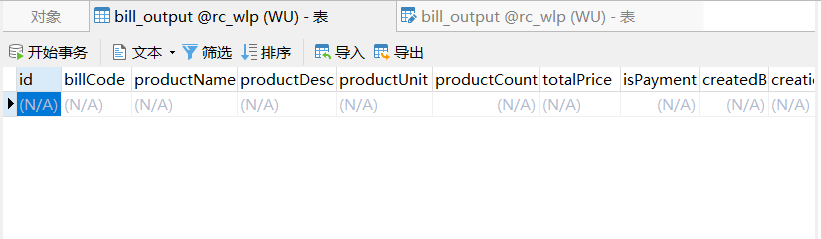

(存放信息库表)

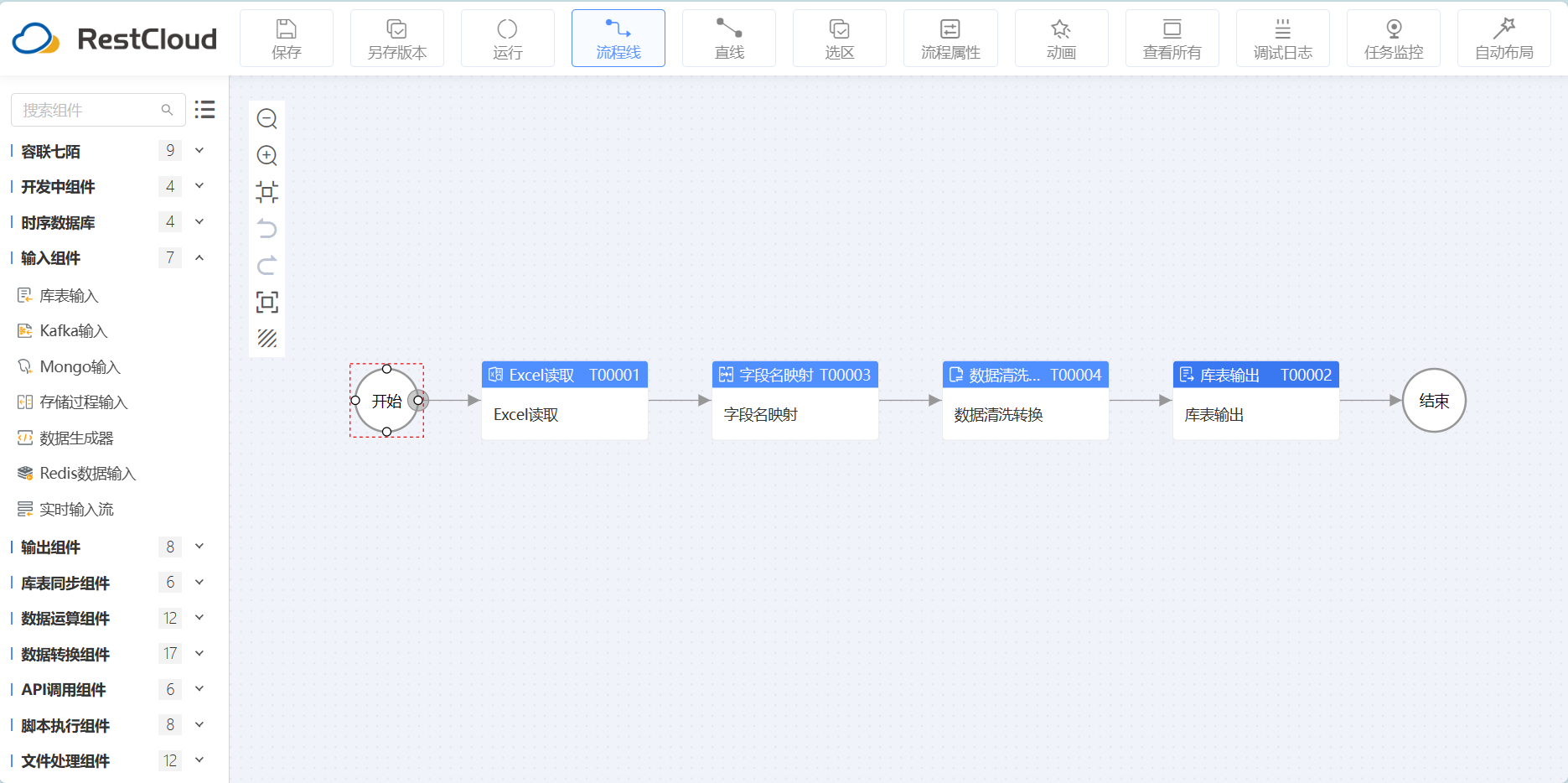

我们可以这样设计ETL流程,首先使用Excel读取组件,将表格数据中的数据读取出来,通过字段名、字段值映射组件将数据清洗转换成适于存储的格式,最后输出至库表中。流程设计如下图所示:

(ETL流程设计)

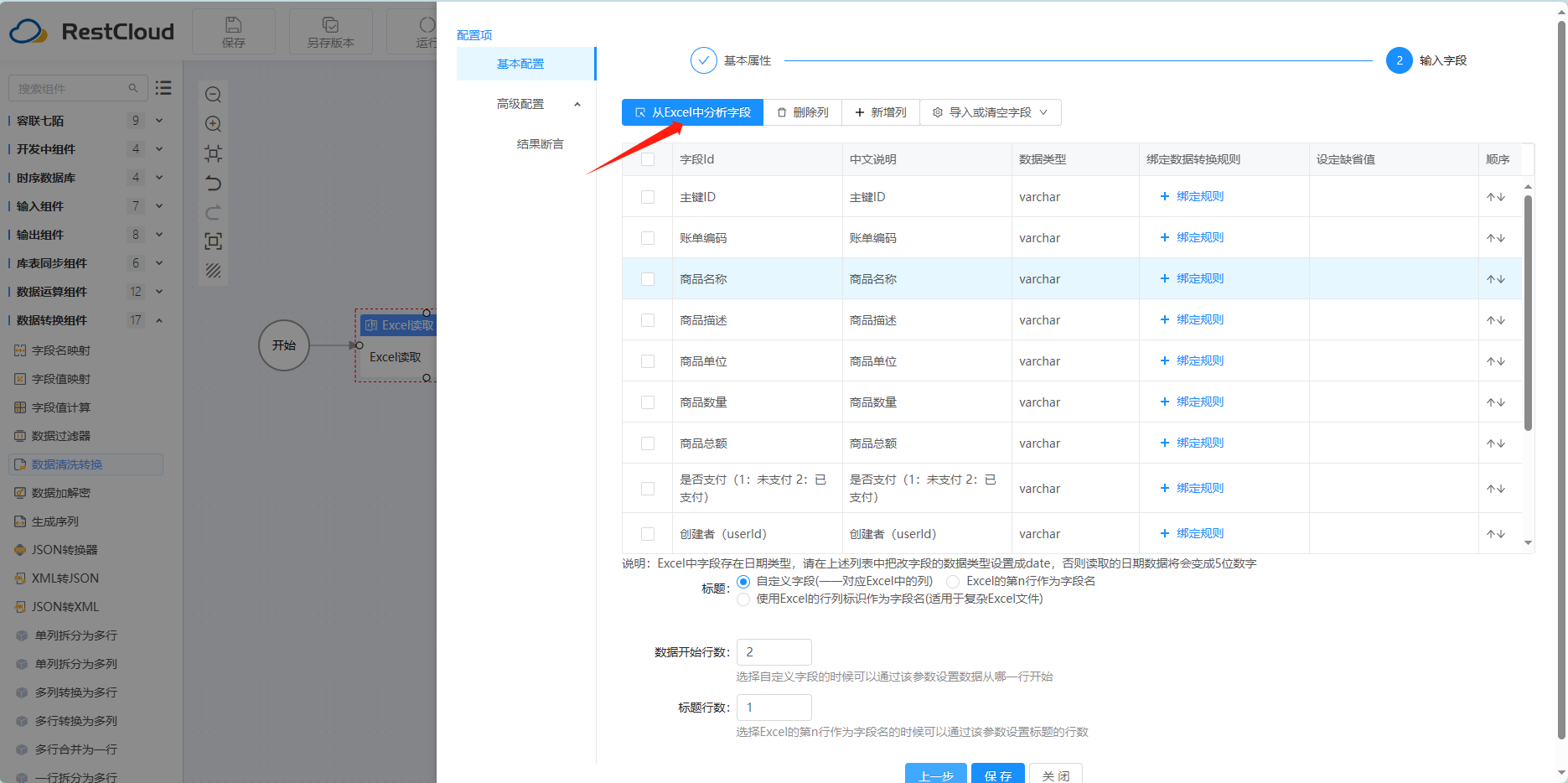

其中Excel读取组件中,我们需要选定文件所在路径,然后配置读取字段,可以从导入中快速读取。

(Excel读取-输入字段配置)

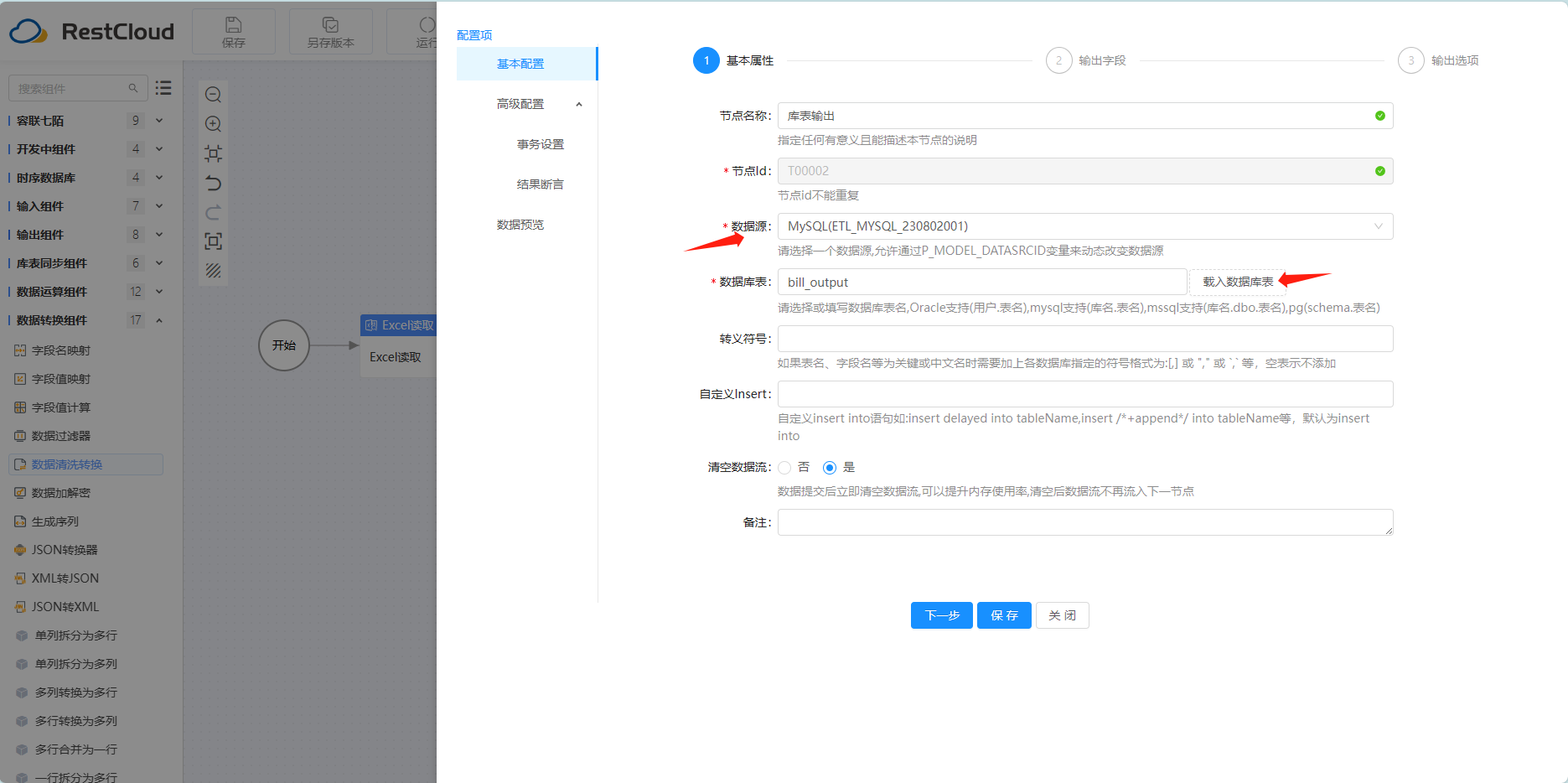

然后我们再配置库表输出组件,载入数据库表后可自动配置输出字段,其他的采取默认配置即可。先配置库表输出组件是为了能快速使用字段名、字段值映射组件。

(库表输出配置)

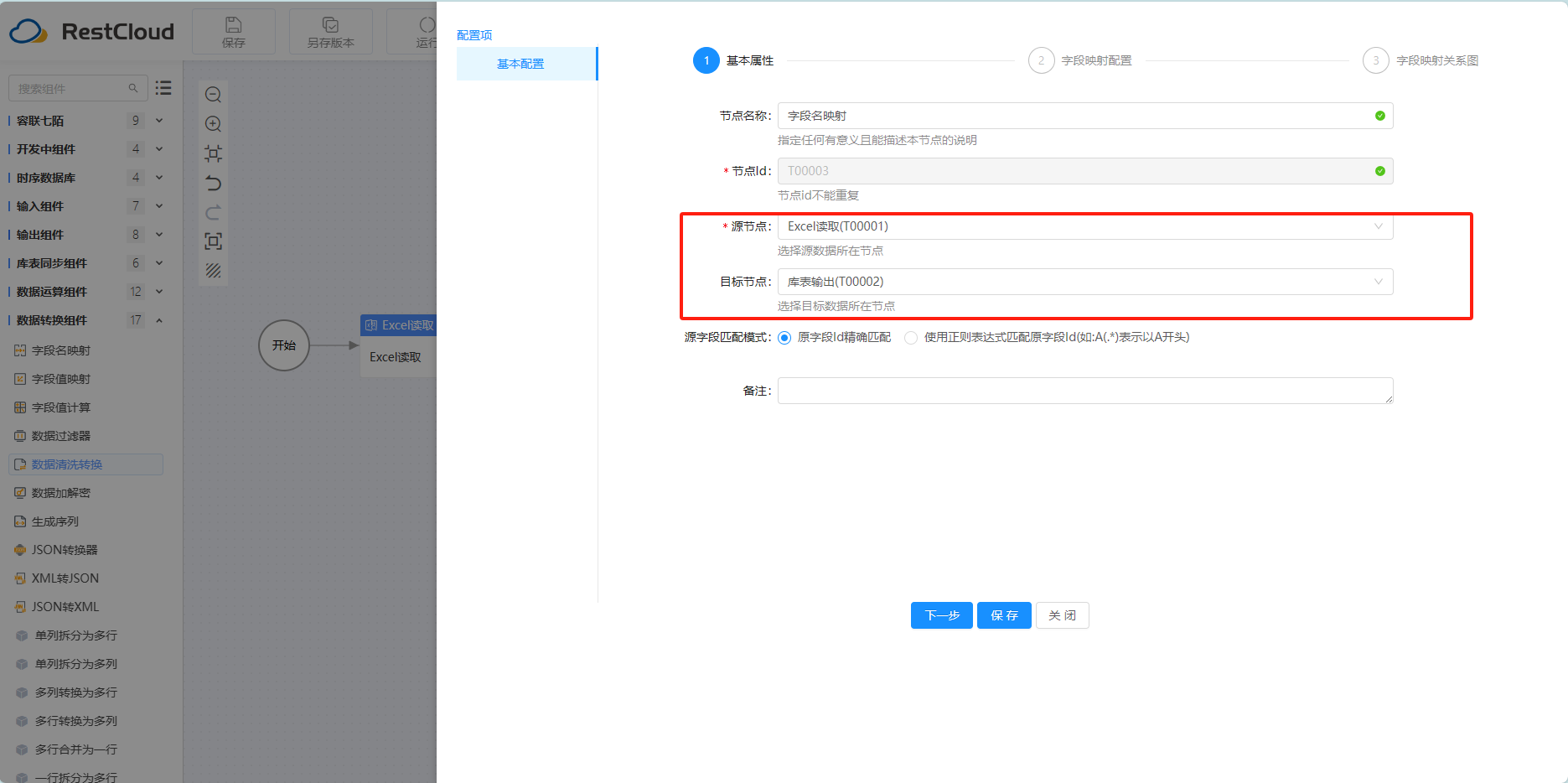

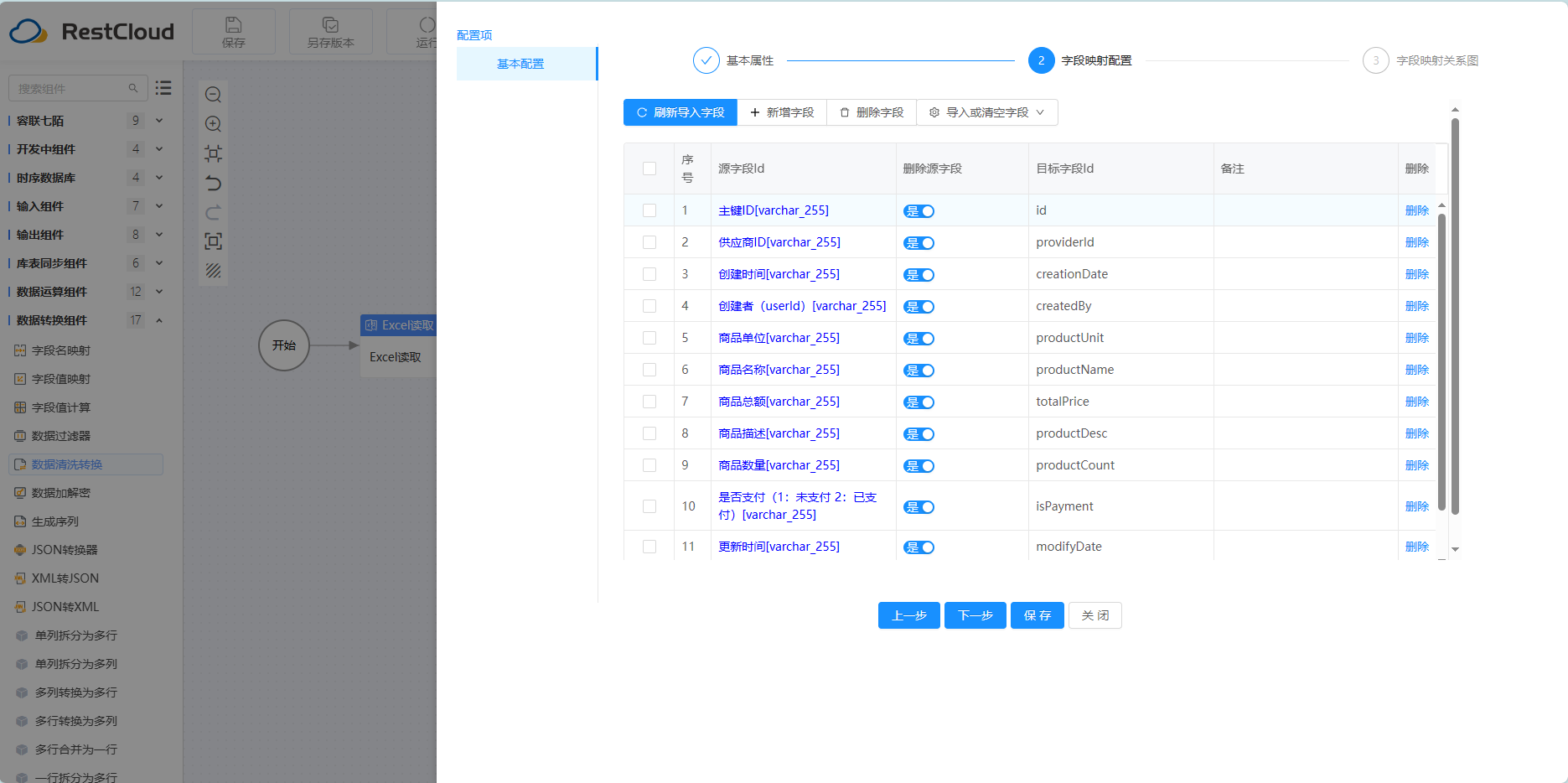

字段名映射组件,选取源节点和目标节点后,组件会自动载入相关字段,我们只需要点击进行匹配即可,

(字段名映射配置)

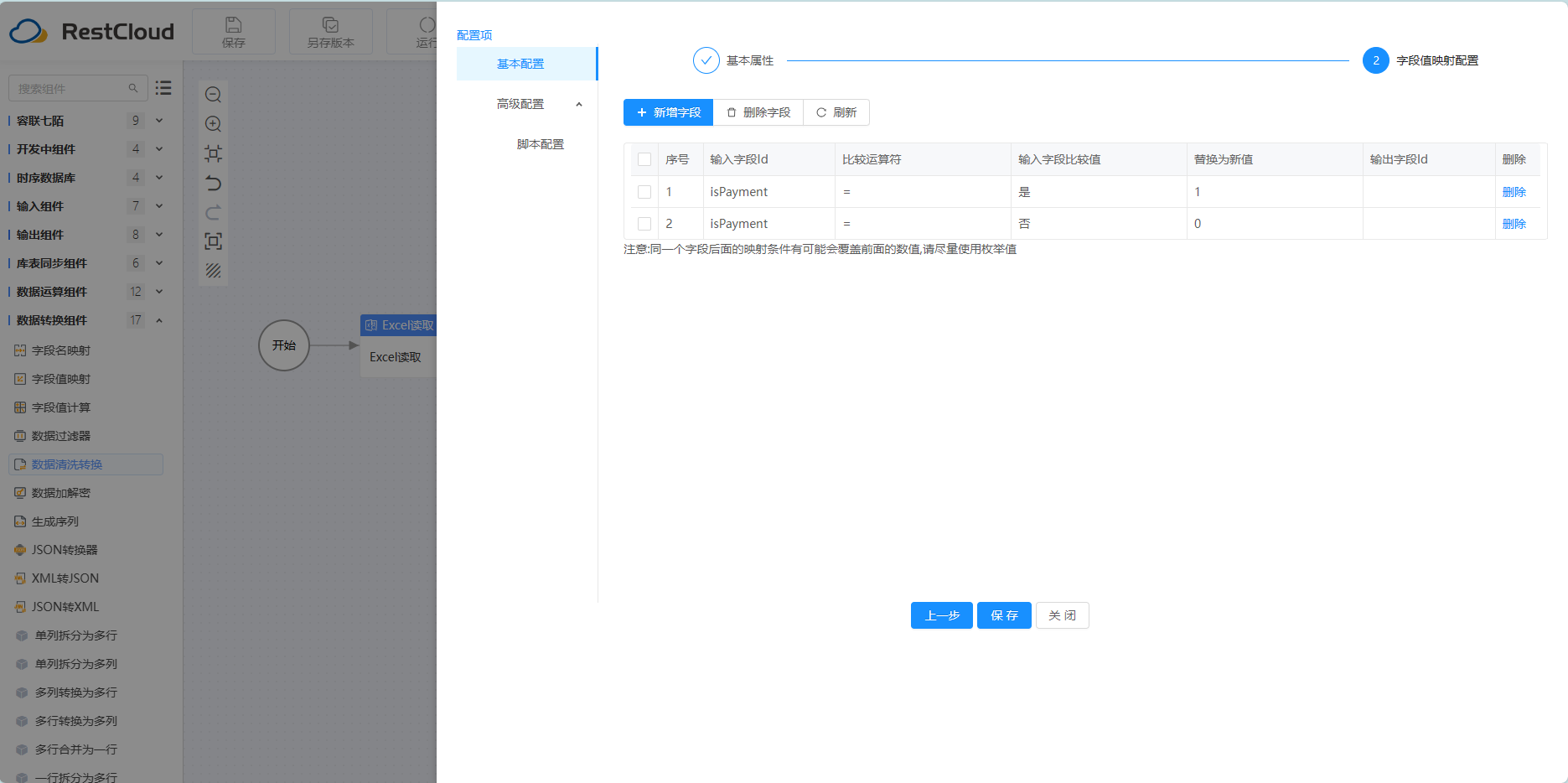

字段值映射,这里我们只需要将表中isPayment这个字段的值根据支付状态修改为1和0即可

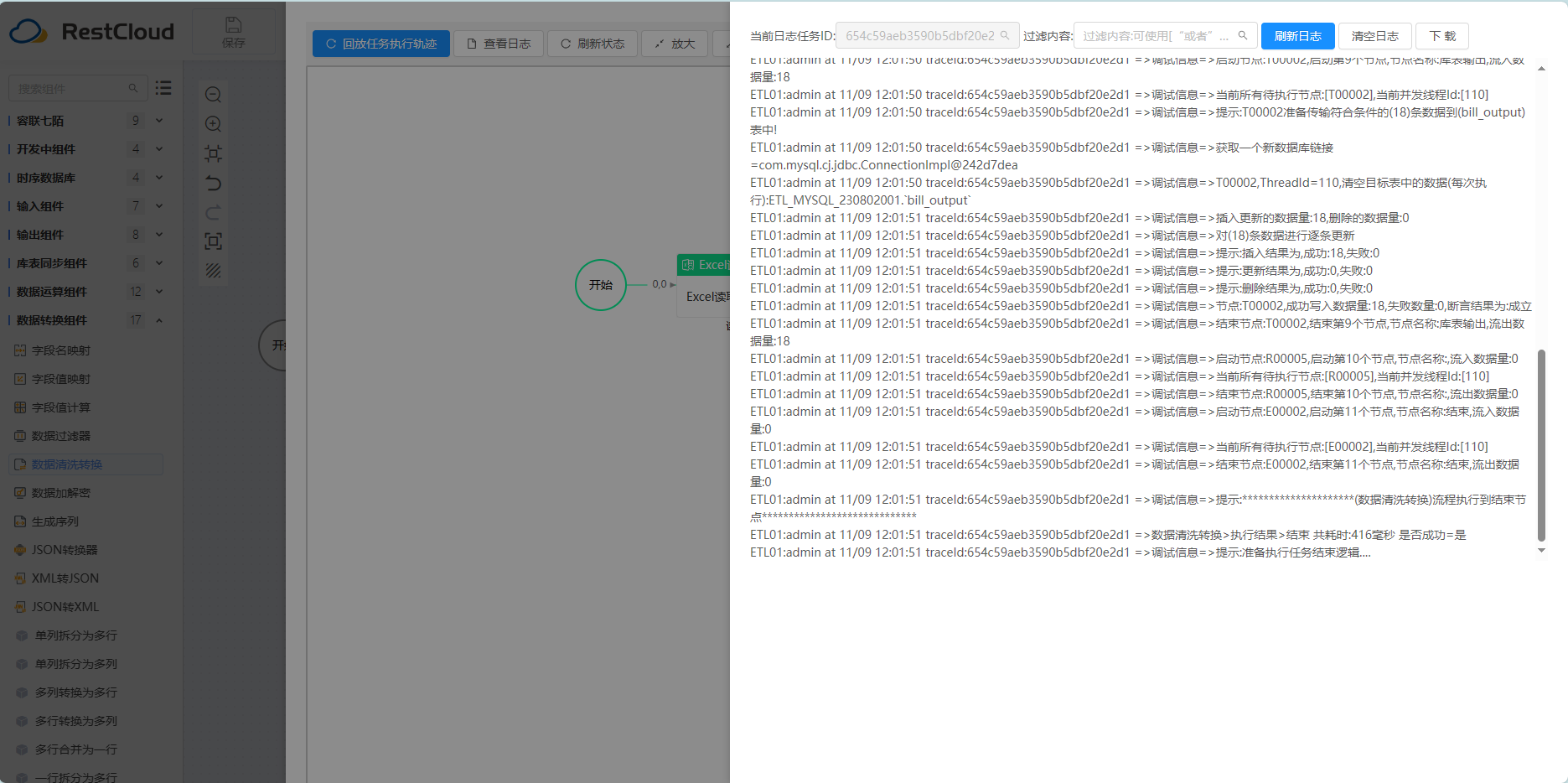

配置完毕后,我们来手动运行流程,查看运行效果:

(运行结果)

2、数据转移

数据转移是指将数据从一个系统或存储库移动到另一个系统或存储库的过程。在数据集成中,经常会涉及到不同系统之间的数据迁移,例如从传统数据库迁移到云端数据库,或者从旧版企业应用系统迁移到新版系统。数据迁移需要考虑数据的完整性、一致性和实时性,以确保数据在迁移过程中不会丢失或损坏。

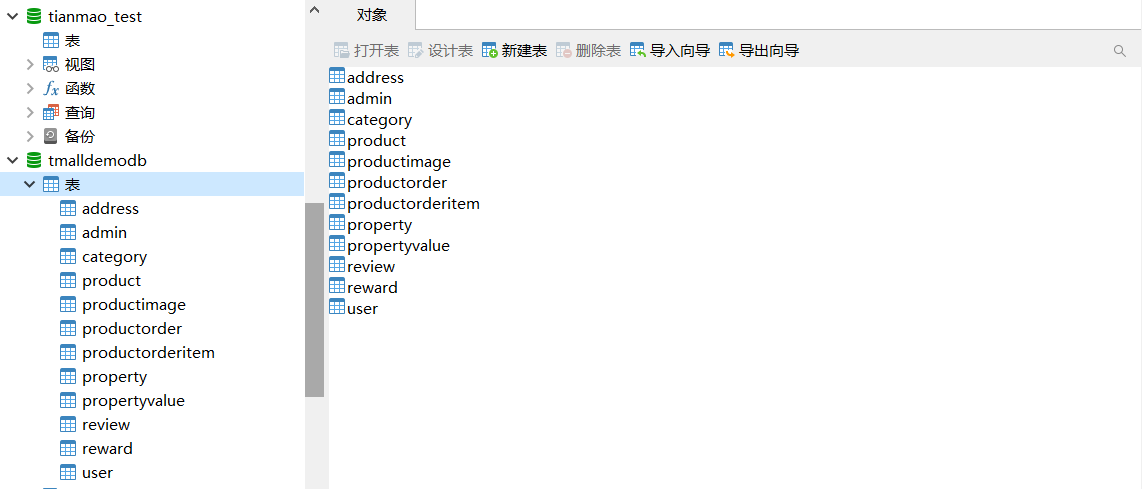

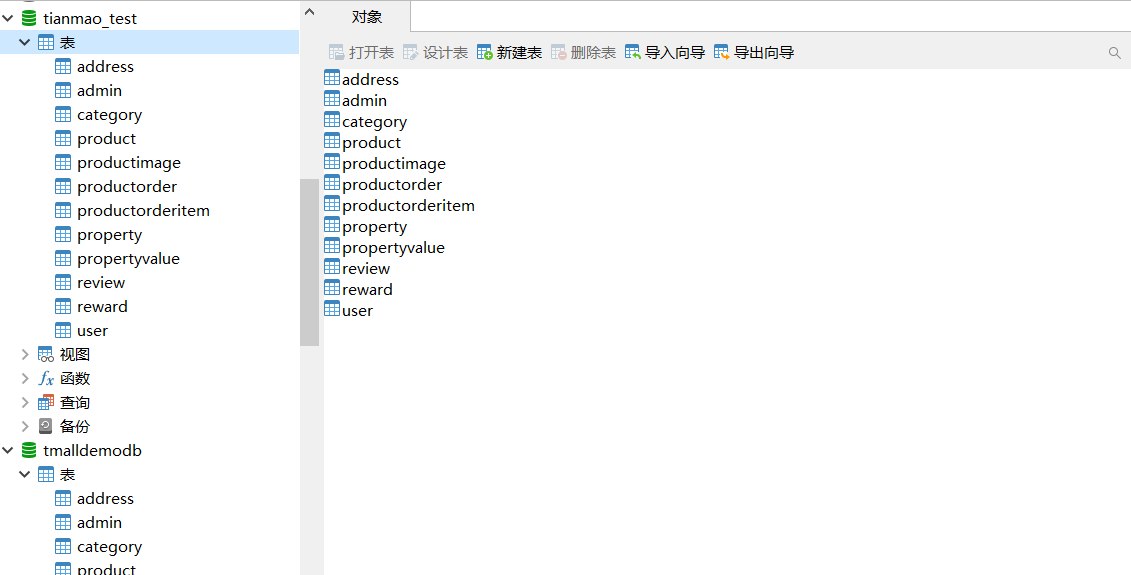

比如我们这边将Mysql数据库中tmalldemodb库迁移到另外一个库中。

(源库数据)

(流程设计)

(运行结果)

3、数据整合

企业通常会有来自不同部门和系统的数据,例如财务、人力资源、销售等。数据集成可以帮助企业整合这些数据,建立全面的数据视图,从而支持跨部门的决策和分析。通过将这些数据进行整合,企业可以更好地理解业务运营状况、识别机会和挑战,从而优化业务流程和提升效率。

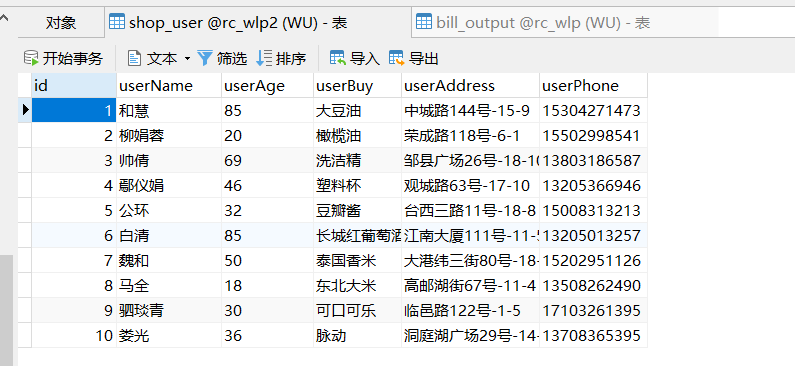

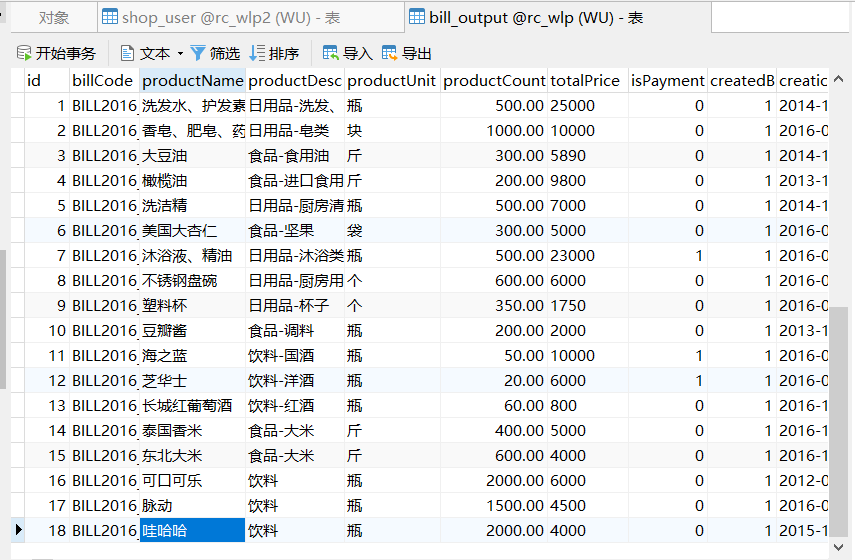

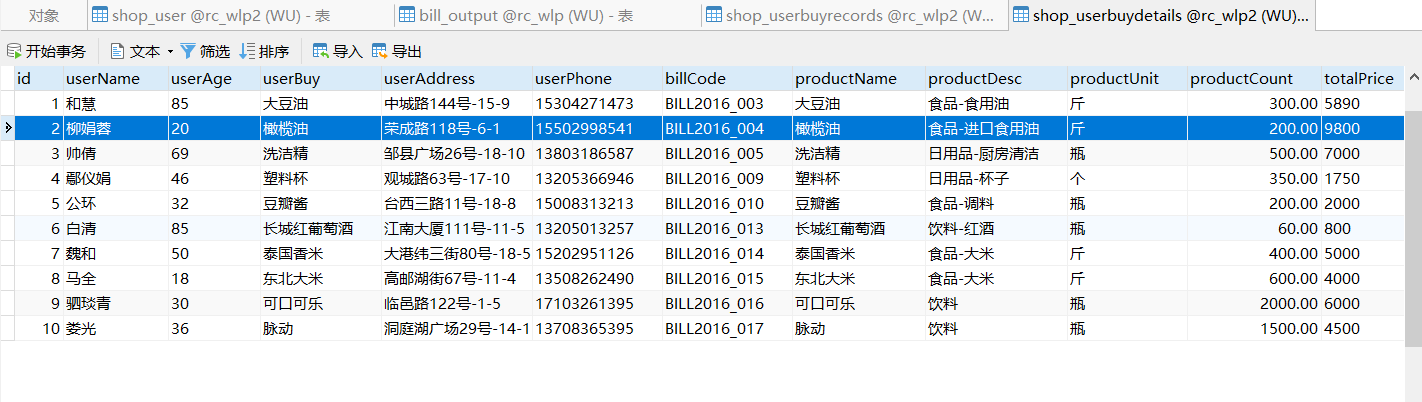

我这边就可以根据商品表和用户购买记录表,根据用户所购买的信息整合成用户购买商品信息表。

(用户购买记录表)

(商品表)

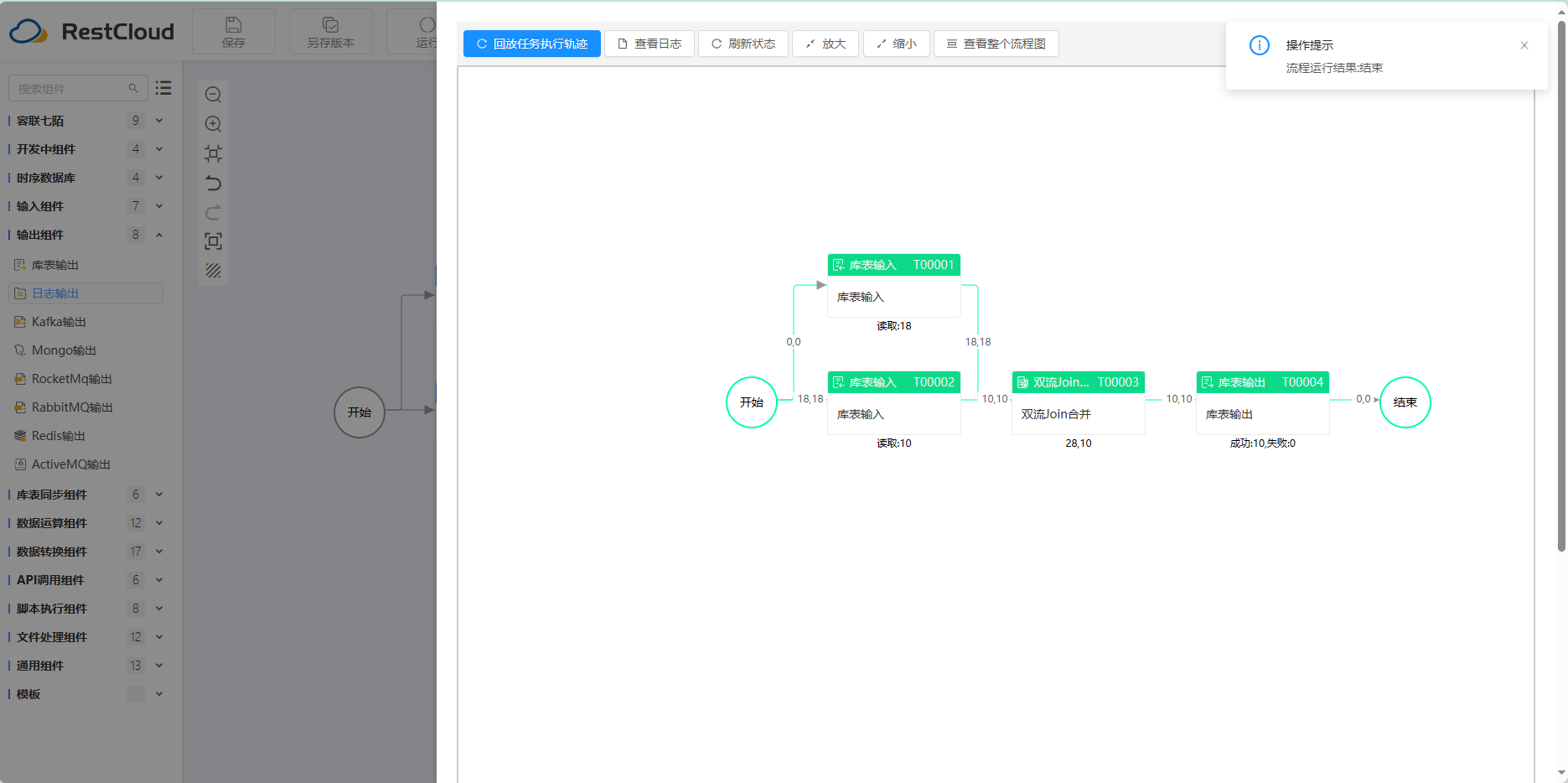

(流程设计)

(自动创表-用户购买商品信息表)

4、实时数据处理

实时数据处理是数据集成中日益重要的一个场景,特别是在对大规模、高速数据进行分析和应用时。实时数据处理涉及从不同数据源中即时捕获数据,并对数据进行处理、分析和响应。

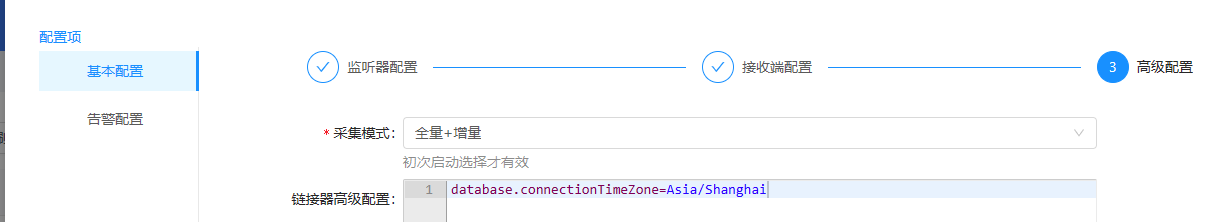

典型的场景就是实时数据同步,这里我的需求是实时监听用户购买记录表,并将数据同步到备用记录表中。

新设计一个离线流程,然后在实时数据集成中创建数据监听器,并绑定这个流程,这样监听器监听到数据后都会调用这个离线流程,从而实现数据实时同步。

离线流程设计如下:

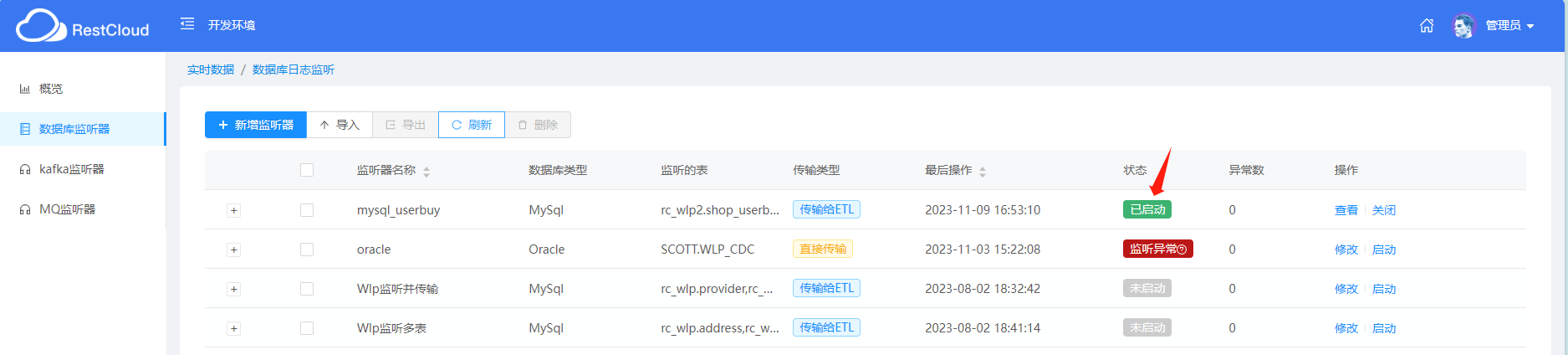

监听器配置如下:

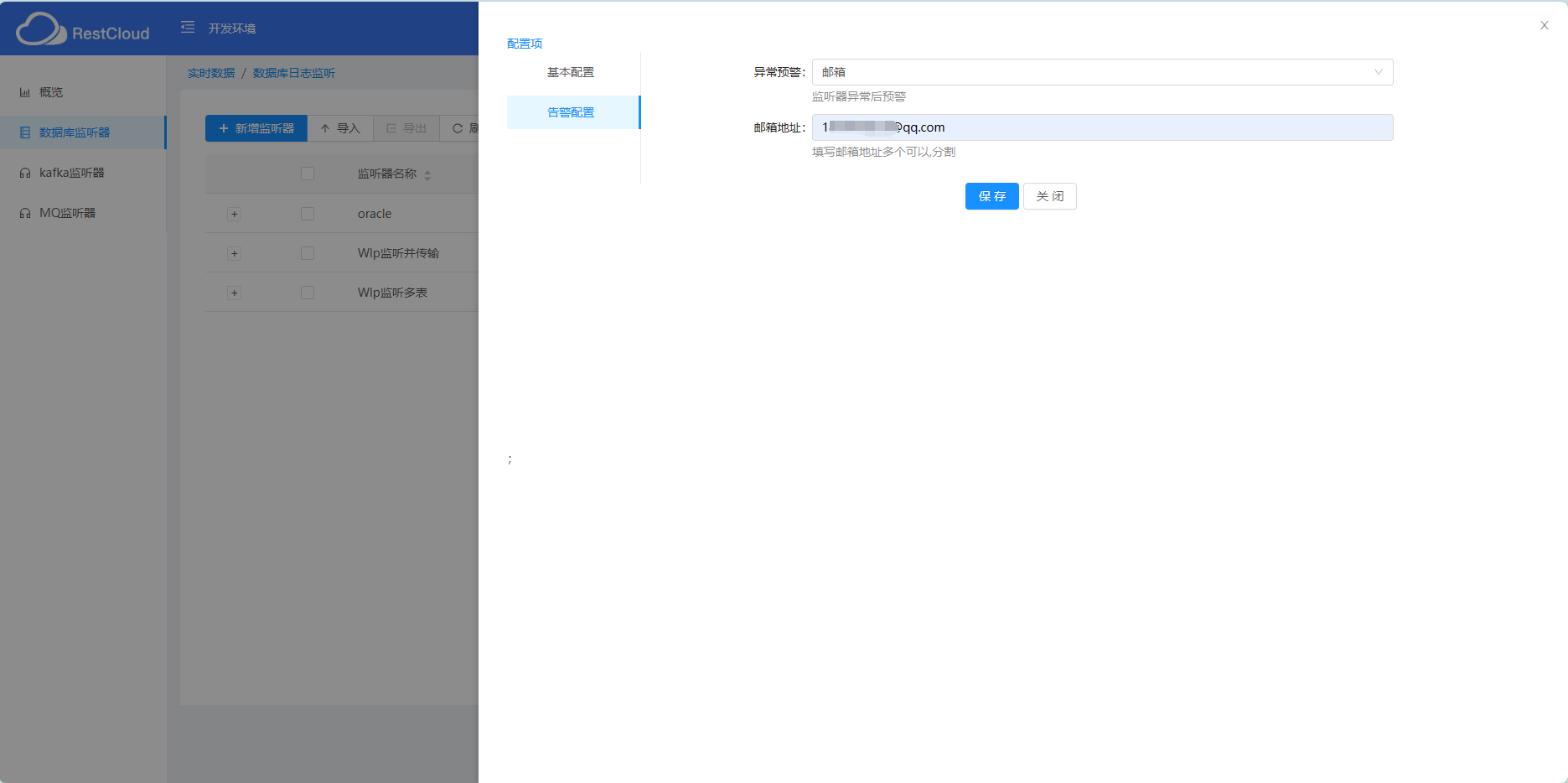

可以配置监听异常邮件提醒:

启动监听器:

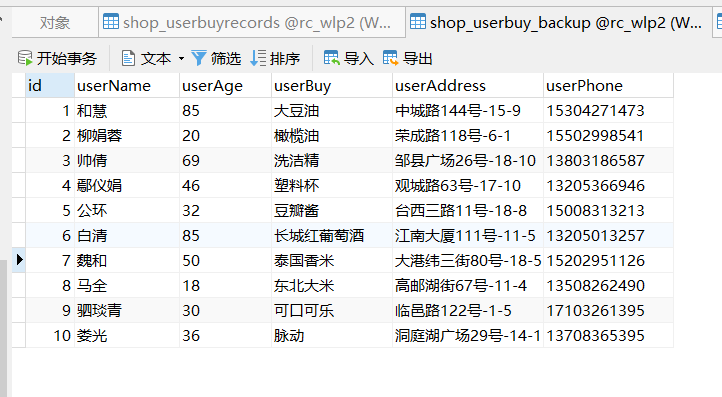

目标表数据:

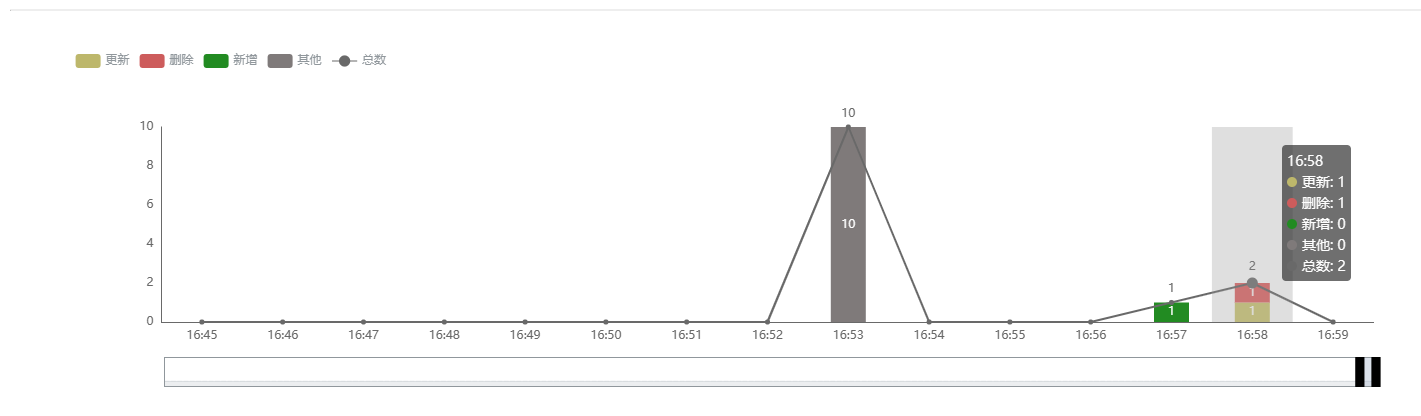

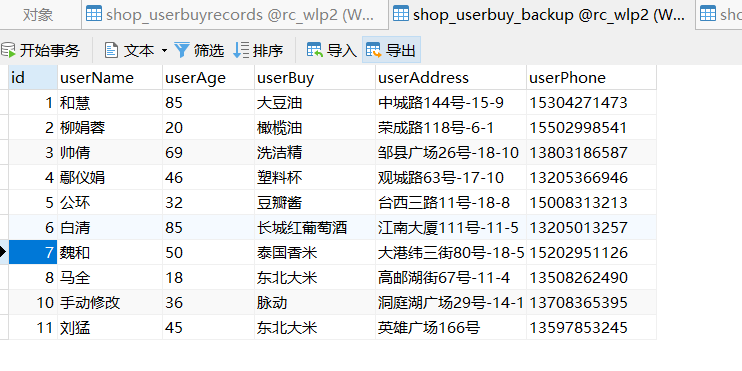

当购买记录表数据变化(包括增删改)时,目标备用数据表也会同步:

目标表最终效果:

三、总结

未来,随着大数据、人工智能等技术的不断发展,数据集成将面临更多的挑战和机遇。随着数据规模的不断扩大,企业需要更加智能化、自动化的数据集成解决方案。同时,随着边缘计算、物联网等新技术的发展,数据来源和形式也将更加多样化,数据集成将面临更多的挑战和机遇。

通过以上场景案例实操,我们也深入了解了数据集成在实际应用中的重要性和价值,以及ETL工具在数据集成中的作用和优势。在日益复杂的数据环境下,数据集成的意义愈发重要。选择合适的工具和技术将会极大地提升数据集成的效率和质量。