原创 | 文 BFT机器人

01

引言

近年来,人工智能产业迅猛发展,大型语言模型GPT-4发展势头强劲,OpenAI推出ChatGPT、微软推出Bing、马斯克推出“最好的聊天机器人Grok”……科技巨头纷纷入局AI领域,引入人工智能作为办公工具的行业也越来越多。

人工智能的便利性,让人们越来越依赖它的帮助,正因如此,AI的各项危机也逐渐浮现。人们在寻求AI帮助的时候,往往抱着信任的态度,而AI却也可能会传递错误讯息。

02

什么是人工智能幻觉?

人工智能幻觉是指人工智能模型在处理数据或执行任务时产生的自我欺骗现象。

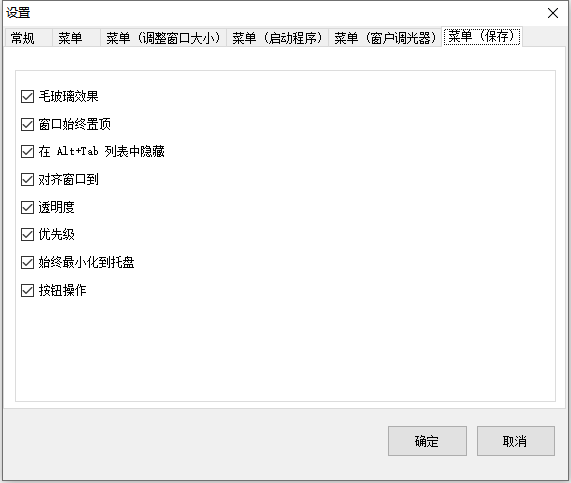

近日,剑桥词典公布2023年度词语:“Hallucinate”。这个词的释义原本为“似乎看到、听到、感觉到或闻到一些不存在的东西,通常是因为健康状况或因为你服用了某种药物而产生幻觉”。但在AI时代的背景下,“Hallucinate”新增了一个注解:“当AI制造幻觉,它会产生错误讯息”。

剑桥词典官方对选择“Hallucinate”为年度代表词做出了解释:新含义“触及了人们正在谈论的AI核心”。

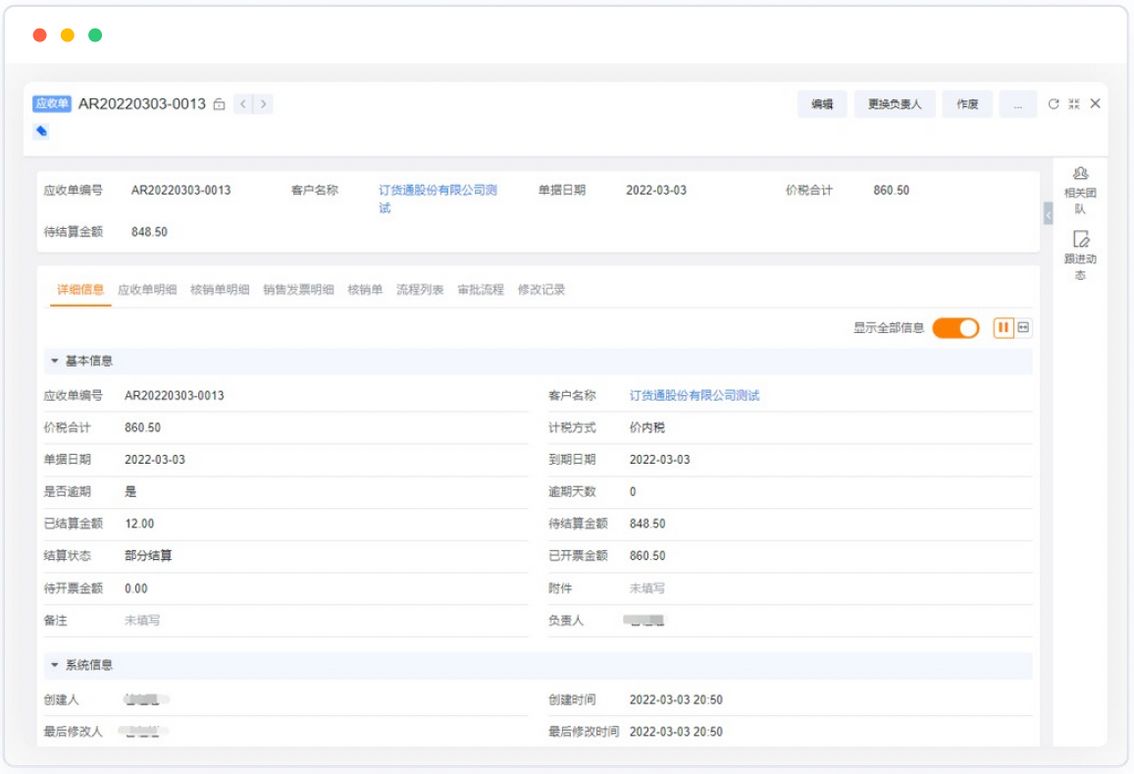

图片来源:新浪网

“幻觉”的含义是:在没有相应的外部或躯体刺激的情况下的感觉知觉,并根据其发生的感觉域进行描述。无论是否了解幻觉的本质,幻觉都可能发生。人工智能幻觉隐喻性地借鉴了这个概念,将人工智能产生的不准确信息描述为“幻觉”。

举个例子:

1.图像识别领域:一张包含斑点的狗的照片可能被错误地识别为豹子,这种错误识别即是幻觉的一种表现。

2.自然语言处理:人工智能模型可能产生语法不通或语义混乱的句子,甚至是完全无意义的文字。这可能导致误解、信息错误传达或者根本无法理解的输出结果,称为语言领域的幻觉。

人工智能幻觉有很多种类型,但所有这些都归结为同一个问题:混合和匹配它们接受过训练的数据,以生成一些全新的错误的东西。这些幻觉现象可能会对人工智能应用的可靠性和准确性造成严重影响。

03

人工智能的答案可信吗?

生成式人工智能的诞生,推动了AI产业的发展,人们对于人工智能的评价多为肯定。人工智能聊天机器人擅长从不同来源收集信息,并将其以对话式、易于理解的格式合成。

但许多人在使用人工智能时,发现AI给出了不合理的结论,甚至是彻头彻尾的谎言。AI的许多回应都很滑稽。例如,ChatGPT收集了很多公众人物的出生和死亡日期,但无法明确表明他(她)已经死亡;它还声称有人徒步穿越英吉利海峡,金门大桥两次穿越埃及;谷歌的巴德声称詹姆斯·韦伯太空望远镜拍摄到了太阳系以外行星的第一张图像,而事实上,第一张此类图像是由另一台望远镜在2004年拍摄的。

这些例子引出了一个词:“人工智能幻觉”。大型语言模型(LLM)生成的信息与现实的关系很微妙。其中一些内容似乎完全是捏造的,而另一些似乎借鉴事实虚构的,对于空白内容,人工智能会引用不相关内容填充。

调查显示,这些不准确的回复内容在人工智能的应用中非常常见,而人类的反馈对于确保它们不会完全偏离轨道至关重要。

04

人工智能幻觉是怎么产生的?

目前,对于人工智能幻觉产生的原因众说纷纭。研究人员认为,人工智能环境的现象与设计和测试期间数据提供不足有关。人工智能技术在不断发展,但支持AI产品运转的数据不充分,这会导致人工智能给出的答案偏离轨道。

另外,人工智能没有情感,它们通过算法理解用户的诉求,而有些问题人工智能无法理解,它们就有可能给出无意义或不准确的答案。

05

为什么人工智能幻觉是一个问题?

人工智能幻觉的产生根植于模型的处理复杂性以及对输入数据的误解。模型可能在处理数据时过于注重某些特定特征,而忽略了其他重要的上下文信息。

如今有数百万人使用人工智能,有些人是出于好奇,有些人则把人工智能当做生活工作的工具,甚至有很多人非常依赖和信任人工智能。而人工智能平台已经多次出现提供错误信息的现象,使人们对失误的认知造成影响。

如果生活中的错误是小事,那么当人工智能用于关于生命的领域时,会直接影响到结果。例如:在医疗诊断中,人工智能模型的幻觉可能导致错误的疾病诊断,严重威胁患者的健康;在自动驾驶汽车领域,幻觉可能导致错误的环境感知,增加交通事故的风险。

人工智能幻觉也可能在社会层面引发问题。误导性的信息输出可能导致负面影响,例如在社交媒体传播虚假新闻,影响公共舆论。

人工智能幻觉的问题不仅仅是技术发展中的拦路虎,更是社会发展中的潜在风险。

06

人工智能幻觉问题怎么解决?

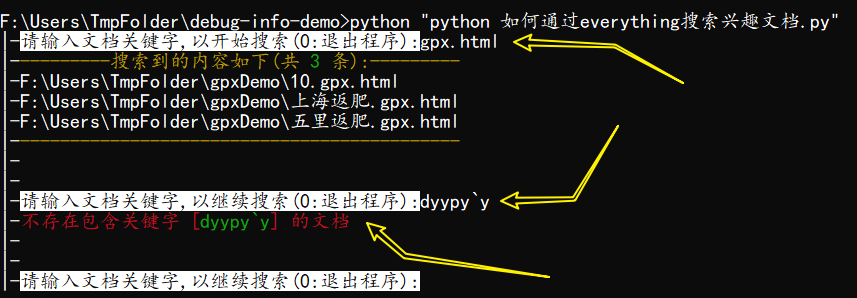

在迎接人工智能时代的挑战中,OpenAI提出的“过程监督”策略为解决“AI幻觉”问题提供了新的思路。通过奖励大模型每个正确的推理步骤,而非简单地奖励最终答案,这一方法为人工智能的发展注入了更多的透明度和可信度。

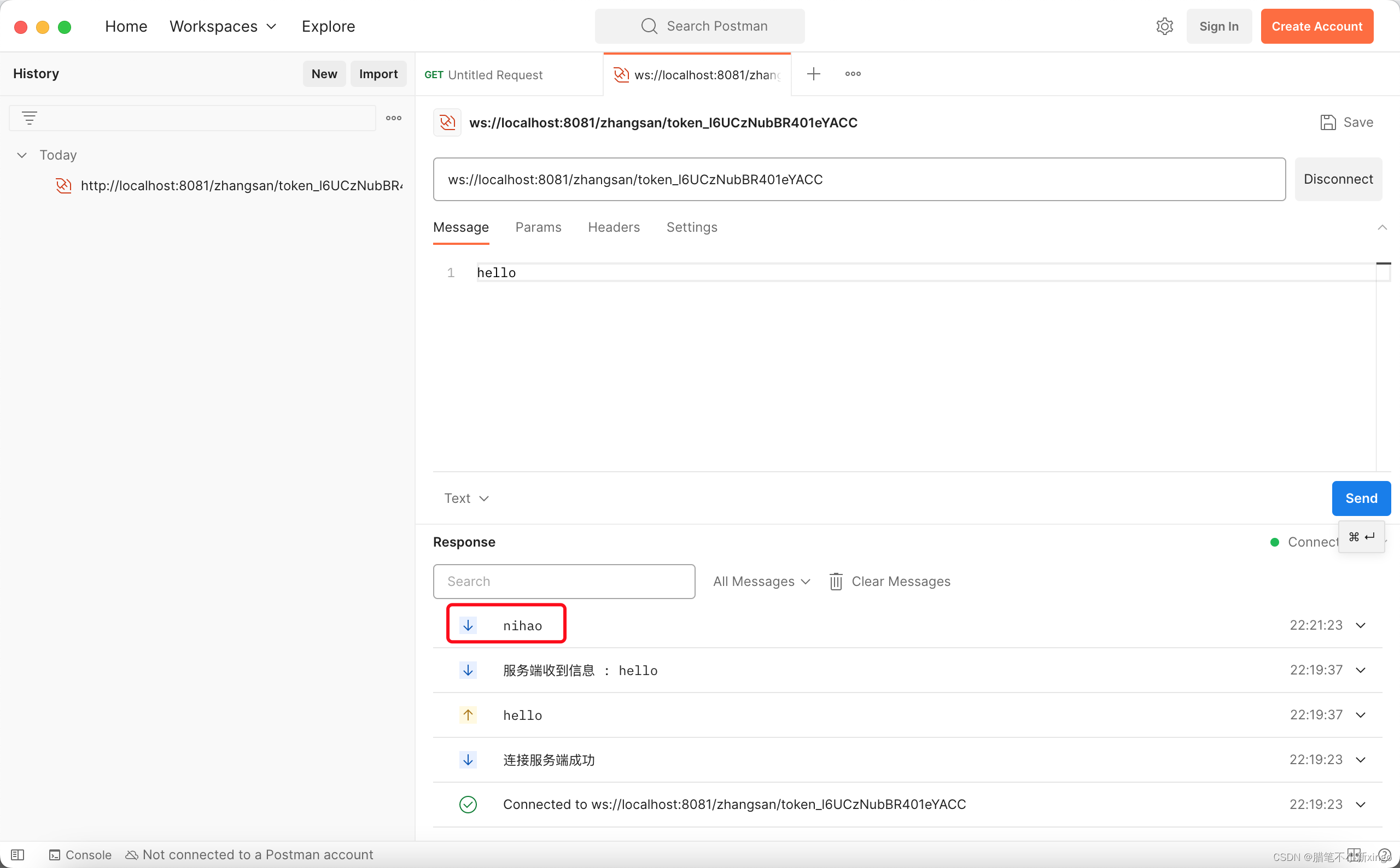

图片来源:新浪网

然而,我们作为使用者,同样有责任保持警惕,不能完全信赖人工智能平台给出的答案。要积极参与反馈,及时指出错误,让技术人员尽快修补人工智能的漏洞,确保其他人在问相类似问题时人工智能不再给出错误答案。

另外,开发者也需要投入更多的时间测试人工智能、寻找更多的数据支持,让模型尽可能多地熟悉数据,并不断更新支持模型运转的数据,确保模型数据来源的真实性。

注:部分图片来源网络

注:文章版权归原作者所有,如有不妥,请联系删除。