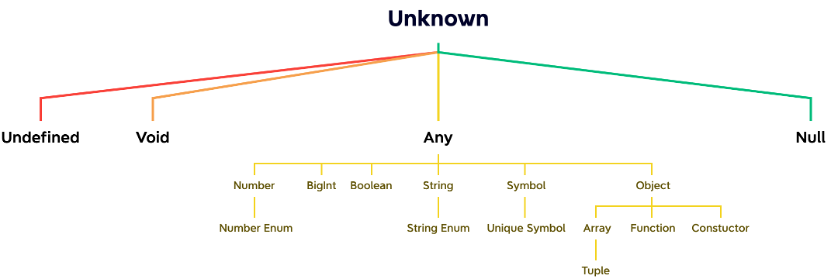

GPT→类似于Transformer Encoder

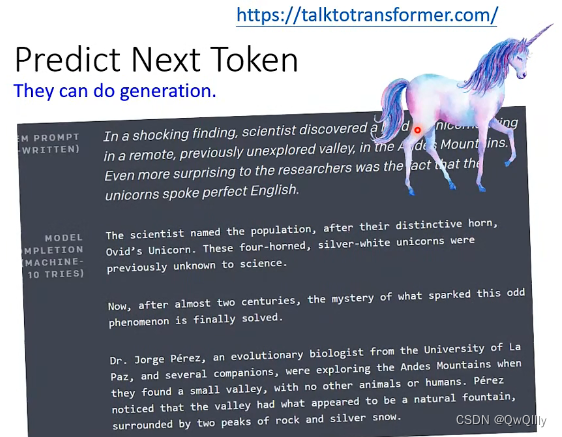

训练任务:Predict Next Token

使用MASK-attention,不断预测“下一个token”。

可以用GPT生成文章。

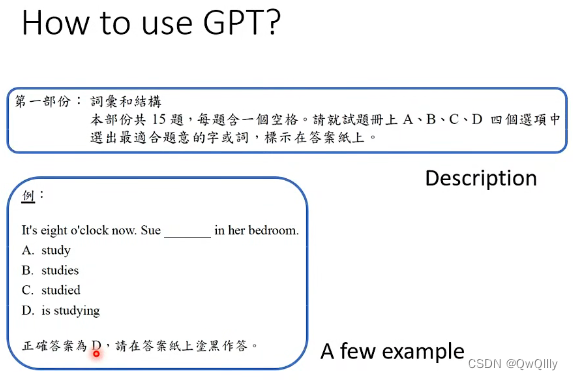

How to use GPT?

给出描述和例子

给出前半段,补上后半段

In-context Learning(no GD)

结果

目前看起来状况是,有些任务它还真的学会了,举例来说2这个加减法,你给它一个数字加另外一个数字,它真的可以得到,正确的两个数字加起来的结果,但是有些任务,它可能怎麼学都学不会,譬如说一些跟逻辑推理有关的任务,它的结果就非常非常地惨。

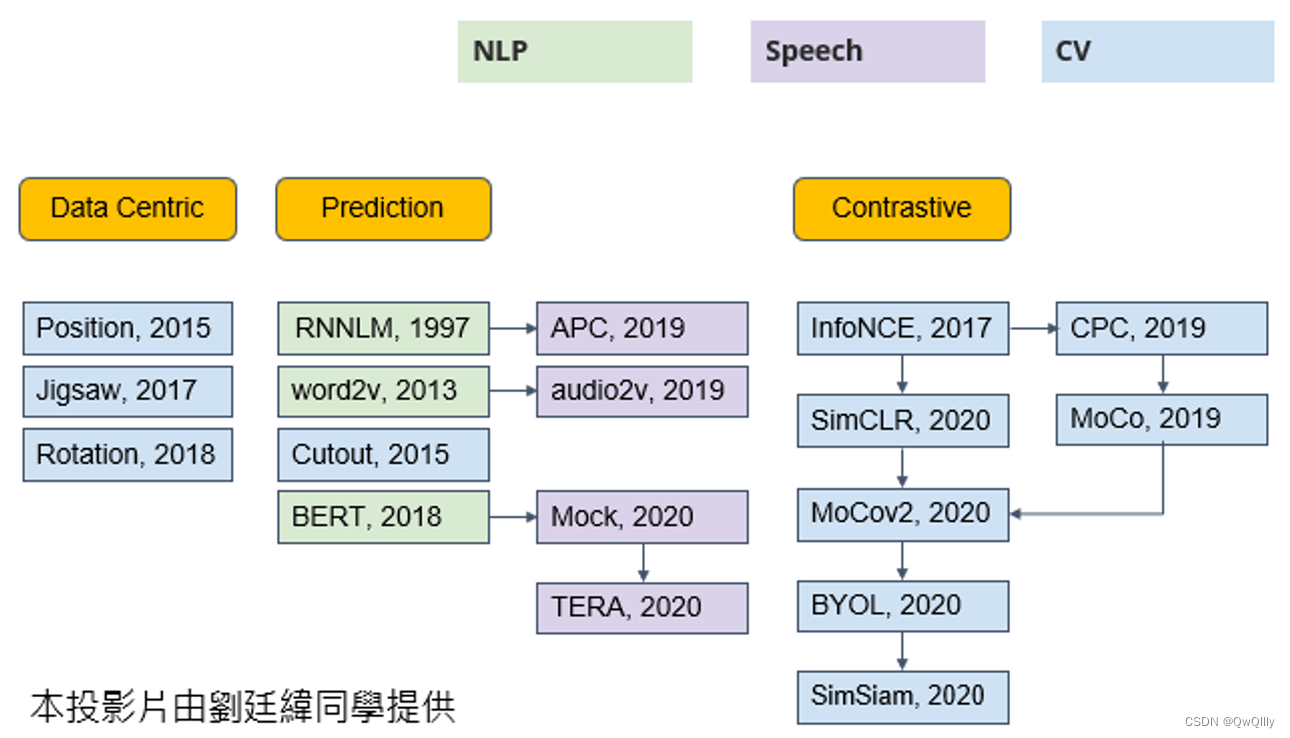

Self-supervesed Learning Beyond Text

CV

Image - SimCLR

Image - BYOL

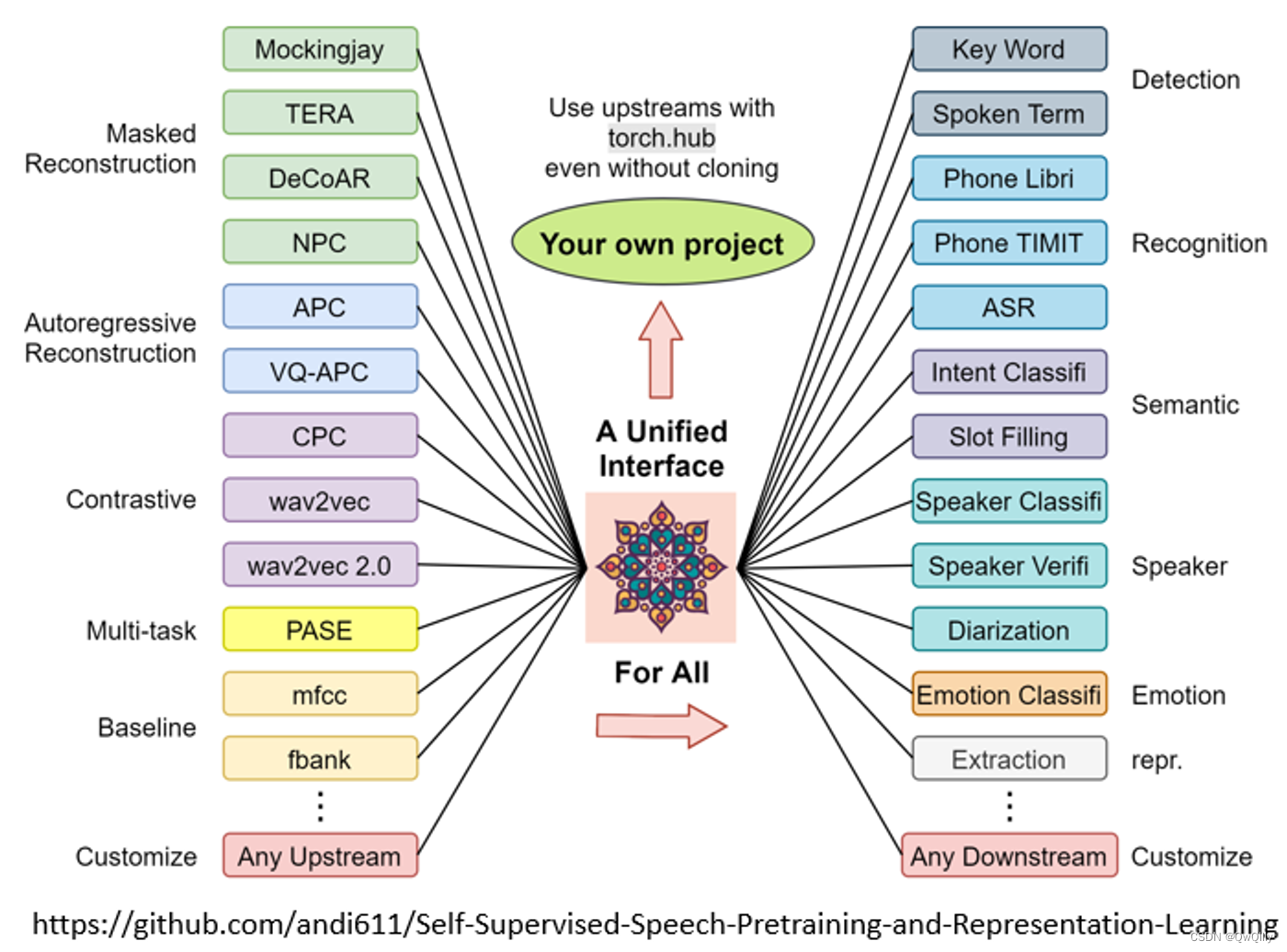

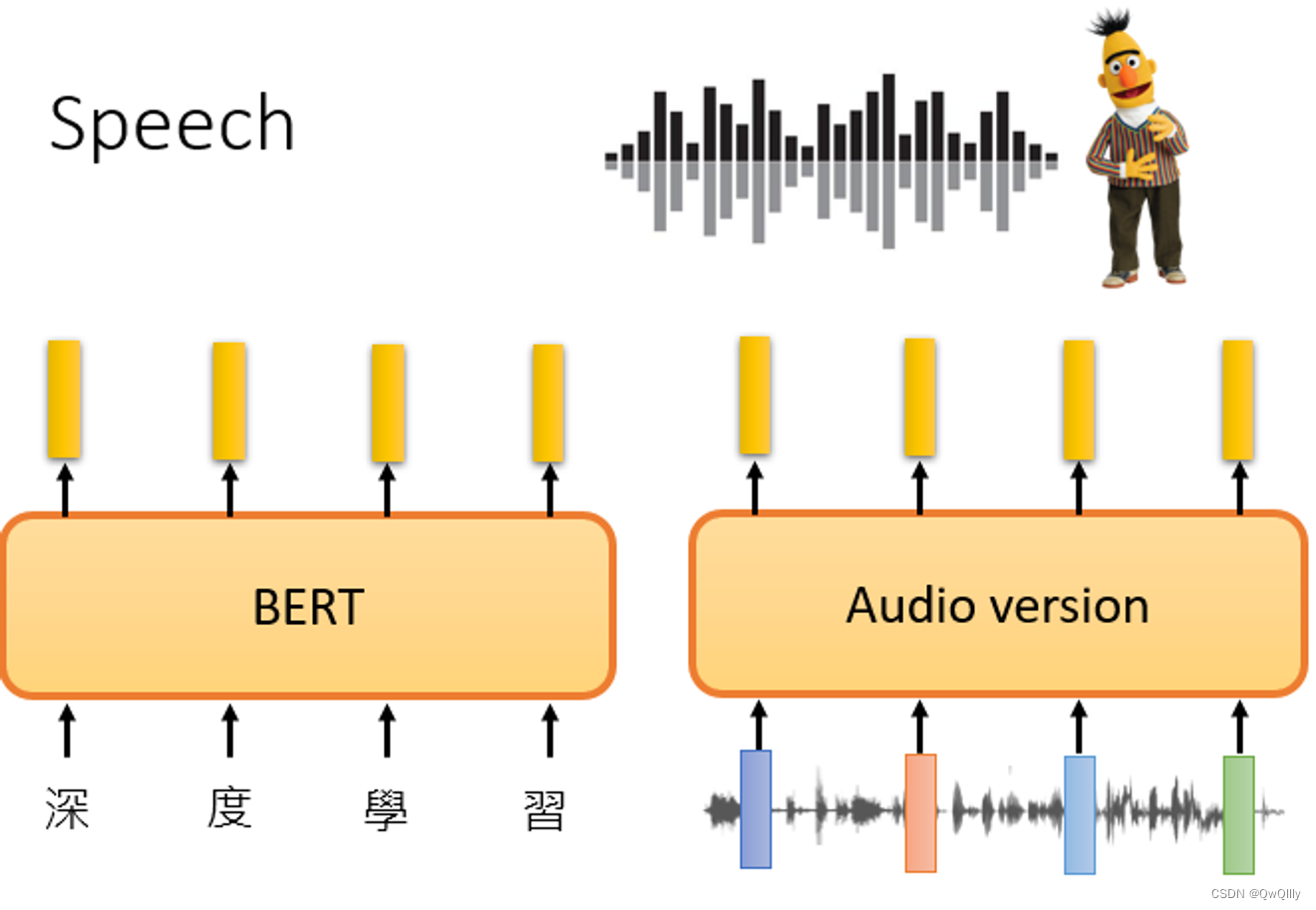

Speech

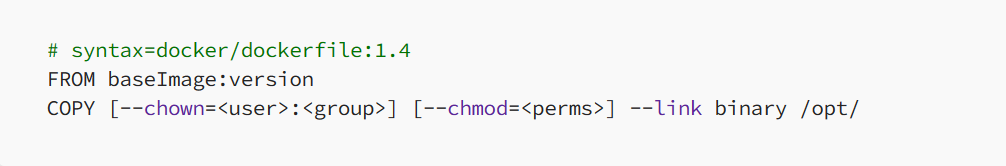

训练:

语音也可以做填空题,就把一段声音讯号盖起来,叫机器去猜;

语音也可以预测接下来会出现的内容

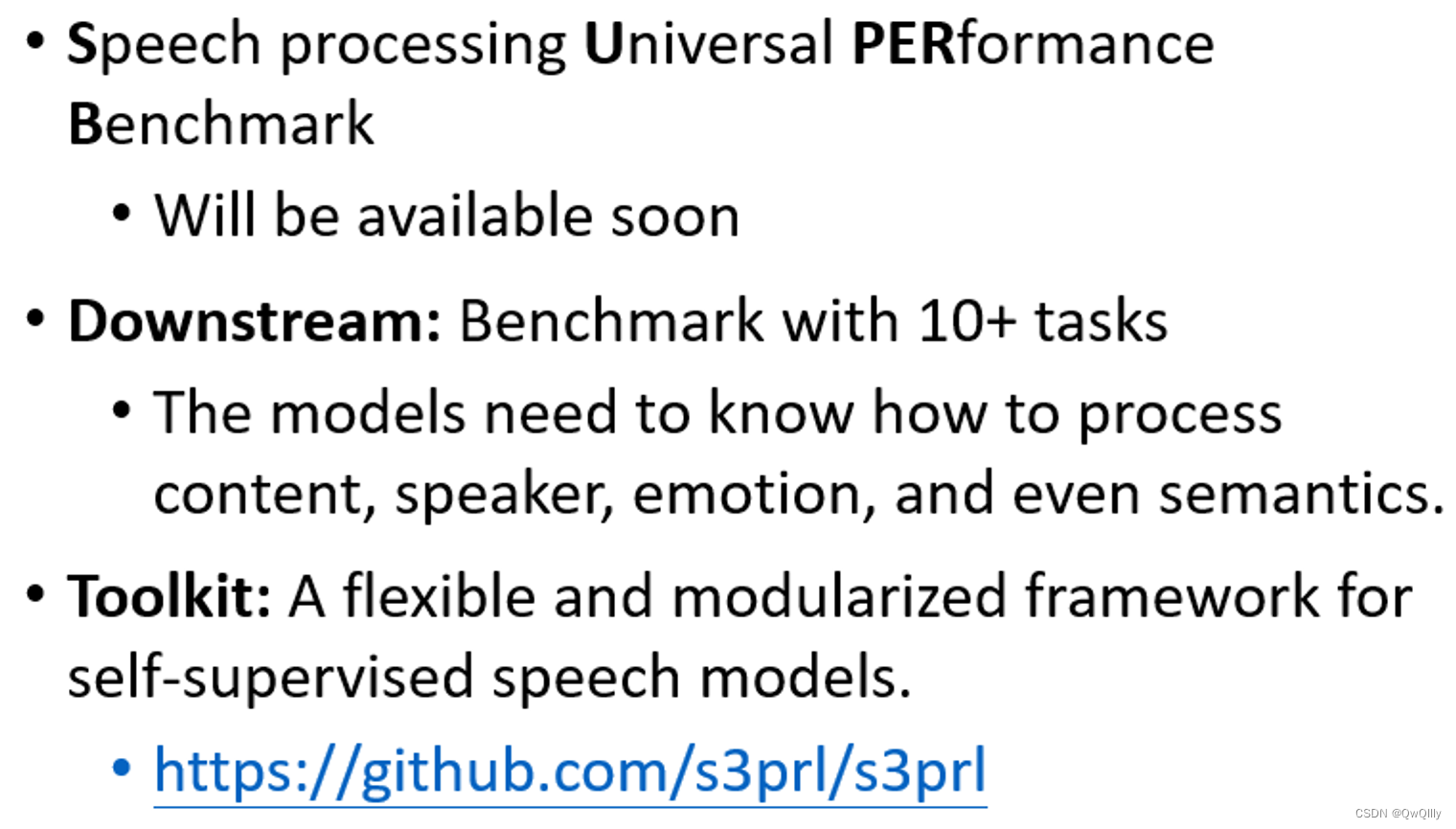

Speech GLUE - SUPERB

李宏毅——语音的基准语料库。