从huggingface上面下载chatglm-6B模型是比较简捷的方式,下面记录一下下载安装过程。

huggingface的官方文档如下:

https://huggingface.co/docs/huggingface_hub/v0.14.0.rc1/guides/download

1.配置conda环境

服务器上使用的是miniconda,miniconda创建一个chatenv的环境,同时已经配置好了conda的源为清华源,否则直接连conda的默认官方源地址,你懂的。

2.在服务器创建文件夹

在服务器上,创建一个名为chatglm-6b的文件夹,该文件夹用来存放模型文件。

3.安装huggingface_hub

在服务器上,安装huggingface_hub,直接使用pip install huggingface_hub即可。

4.下载模型

启动我们刚才新建的虚拟环境,然后进入python的命令行。

conda activate chatenv

python

然后使用huggingface_hub中的代码,下载模型到本地。

from huggingface_hub import snapshot_download

snapshot_download(repo_id="THUDM/chatglm-6b", local_dir=".")

文件比较大,下载的时间会比较长。

而且中途发生了下载失败,最后报443错误码的问题。

最后经过多次尝试,下载成功。

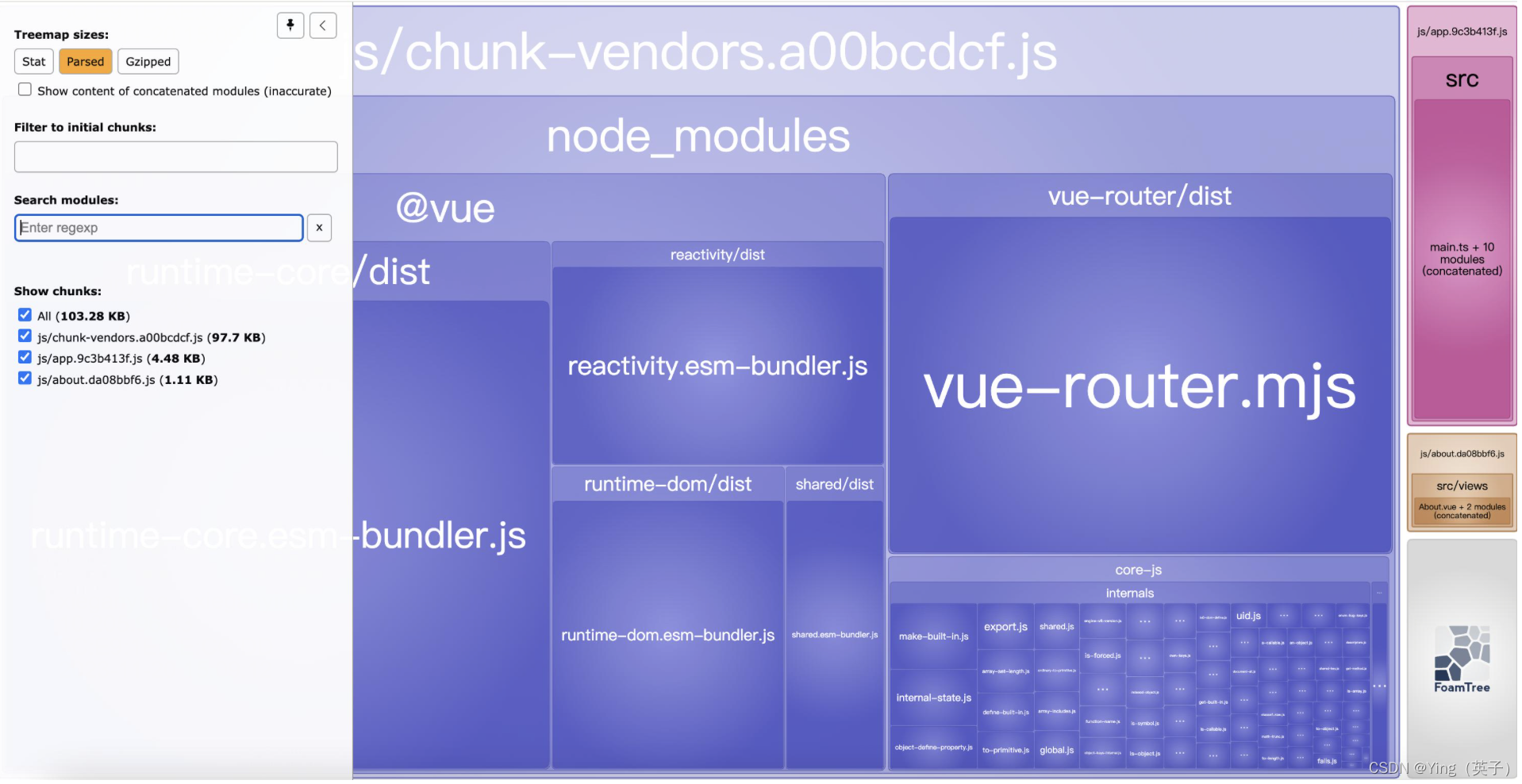

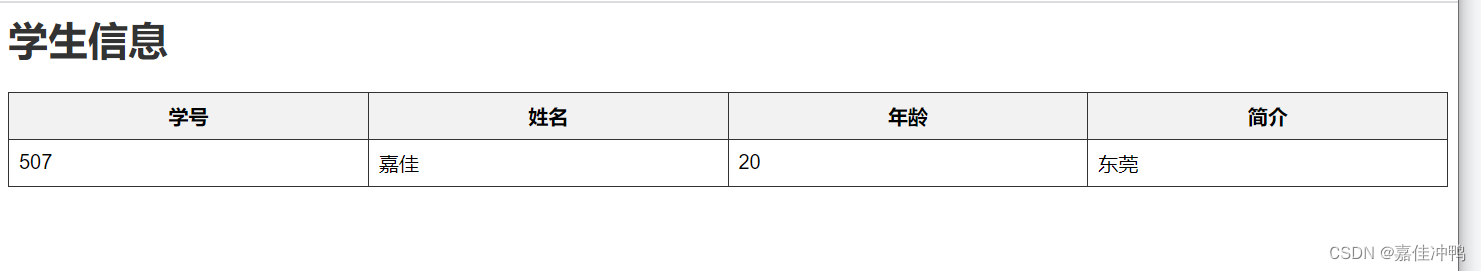

5.模型具体内容

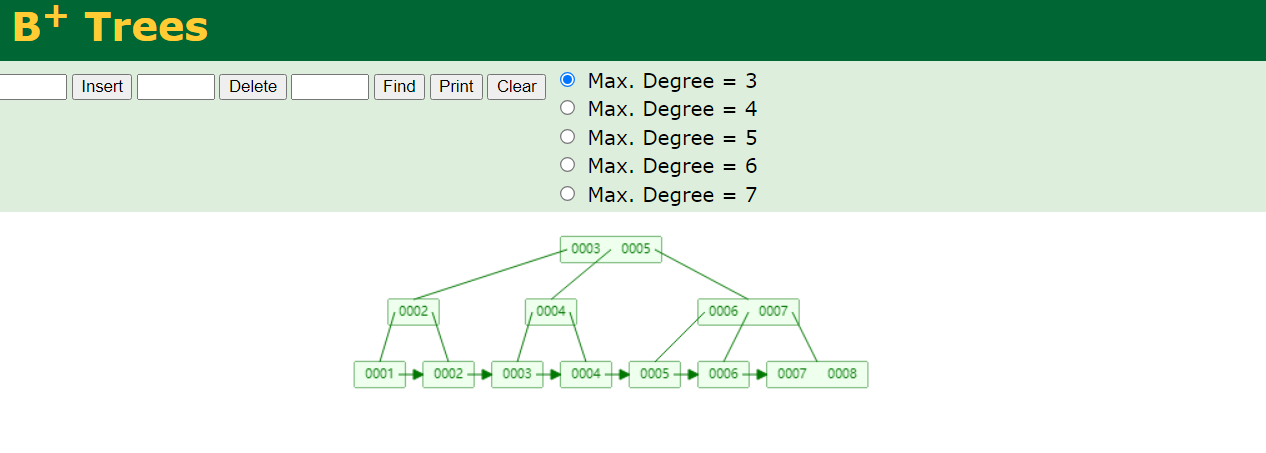

模型具体内容如上图所示

需要注意,pytorch_model-00001-of-00008.bin是软链,具体的文件内容是在

pytorch_model-00001-of-00008.bin -> ../../.cache/huggingface/hub/models--THUDM--chatglm-6b/blobs/14dafdc73e1b1da131fec6668f58774bf6eab1215963f92bdd5c7d81dc6ca383