应版本需求,升级容器版本为1.23.5

kubernetes组件

一个kubernetes集群主要由控制节点(master)与工作节点(node)组成,每个节点上需要安装不同的组件。

master控制节点:负责整个集群的管理。

- ApiServer:资源操作的唯一入口,接收用户输入的命令,提供认证、授权、API注册和发现等机制。

- Scheduler:负责集群资源调度,按照预定的调度策略将Pod调度到相应的node节点上。

- Controller-Manager:负责维护集群的状态,比如程序部署安排、故障检测、自动扩展、滚动更新等。

- Etcd:负责存储集群中各种资源对象的信息。

- 流程:运维人员通过kuberctl命令行下发部署指令,apiserver接收指令调度shchedule去etcd数据库查看节点信息,然后etcd再反馈给schedule,schedule再将空闲node信息反馈给apiserver,apiserver再调用controllmanager,controllmanager去连接node节点内的组件kubelet,kubelet再次调用(pod控制器)去搭建pod内的容器。

node工作节点:集群的数据平面,负责为容器提供运行环境。

kubelet:负责维护容器的生命周期,既通过控制docker,创建、更新、销毁容器

Docker:负责节点上容器的各种操作

kubeProxy:在node节点对外接收客户端请求

kubernetes概念

Master:集群控制节点,每个集群需要至少一个master节点负责集群的管控

Node:集群工作节点,由master分配容器到这些node节点上,然后node节点上的docker负责容器的运行

Pod:kubernetes的最小控制单元。

容器都是运行在pod中,一个pod中可以有1个或多个容器

Controller:控制器,通过它来实现对pod的管理。

比如启动pod、停止pod、伸缩pod的数量等等

Service:pod对外服务的统一入口,可以维护同一类的多个pod

客户去访问k8s内的服务,由node节点内的kube-proxy组件进行介绍,然后再下发信号给service,由service通过负载均衡分配道某个pod中的docker进行处理。

Label:标签,用于对pod进行分类,同一类pod会拥有相同的标签

NameSpac:命名空间,用来隔离pod的运行环境

kubernetes集群部署方式

kubernetes有很多种部署方式,目前主流的部署方式有kubeadm、minikube、二进制包

- kubeadm特点:一个用于快速搭建kubernetes集群的工具

- minikube特点:一个用于快速搭建单节点的kubernetes工具

- 二进制包:从官网下载每个组件的二进制包,依次去安装,安装麻烦

| 主机设置 | |

|---|---|

| mster | 192.168.75.129 |

| node1 | 192.168.75.130 |

| node2 | 192.168.75.131 |

kubernetes集群环境准备(三台均需要配置)

1.关闭防火墙并设置防火墙随机不自启

(kubernetes和docker在运行中会产生大量防火墙规则)

[root@master ~]# systemctl stop firewalld

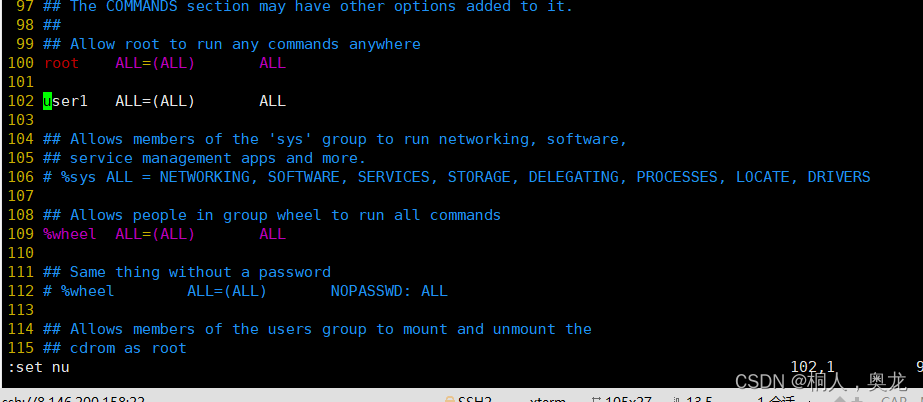

[root@master ~]# systemctl disable firewalld2.关闭SELinux系统内核安全机制

#临时关闭

[root@master ~]# setenforce 0#永久关闭

[root@master ~]# vi /etc/selinux/config

SELINUX=disabled3.配置本地yum源

清空yum路径下系统自带的仓库文件

[root@master ~]# rm -rf /etc/yum.repos.d/*创建挂载点

[root@master ~]# mkdir /mnt/centos挂载本地iso镜像文件至挂载点目录(临时挂载与永久挂载)

[root@master ~]# mount /dev/cdrom /mnt/centos/永久挂载

[root@master ~]# vi /etc/fstab/dev/cdrom /mnt/centos iso9660 defaults 0 0

重加加载/etc/fstab配置文件

[root@master ~]# mount -a创建本地yum仓库

[root@master ~]# vi /etc/yum.repos.d/local.repo[local]

name=local_centos

baseurl=file:///mnt/centos

enabled=1

gpgcheck=0

#查看仓库可用软件包

[root@master ~]# yum repolist4.配置本地主机名与IP地址解析

(为了后面对集群节点的调用,企业中推荐使用内部DNS服务器)

[root@master ~]# vim /etc/hosts

注意:这一步需要改变主机名(举例)

#修改主机名

[root@weiyi001 ~]# hostnamectl set-hostname master

#再打开一个bash环境

[root@weiyi001 ~]# bash测试解析

[root@master ~]# ping node1

[root@master ~]# ping node25.禁用swap交换分区(kubernetes强制要求禁用)

[root@master ~]# vim /etc/fstab#/dev/mapper/centos-swap swap swap defaults 0 0

6.修改Linux内核参数,添加网桥过滤器和地址转发功能

#编辑/etc/sysctl.d/kubernetes.conf文件添加如下配置(该文件默认不存在)

[root@master ~]# vim /etc/sysctl.d/kubernetes.confnet.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

net.ipv4.ip_forward = 1

重新加载配置

[root@master ~]# sysctl --system加载网桥过滤器模块

[root@master ~]# modprobe br_netfilter查看网桥过滤器模块是否加载成功

[root@master ~]# lsmod | grep br_netfilter

7.配置ipvs功能

kubernetes中Service有两种代理模型一种是基于iptables的,一种是基于ipvs,两者对比ipvs的性能要高,如果想要使用ipvs模型,需要手动载入ipvs模块

安装ipset和ipvsadm软件

[root@master ~]# yum -y install ipset ipvsadm#添加需要加载的模块写入脚本文件

[root@master ~]# cat > /etc/sysconfig/modules/ipvs.modules <<EOF

modprobe --ip_vs

modprobe --ip_vs_rr

modprobe --ip_vs_wrr

modprobe --ip_vs_sh

modprobe --nf_conntrack_ipv4

EOF设置脚本权限

[root@master ~]# chmod +x /etc/sysconfig/modules/ipvs.modules执行脚本

[root@master ~]# /etc/sysconfig/modules/ipvs.modules查看对应的模块是否加载成功

[root@master ~]# lsmod | grep -e ip_vs -e nf_conntrack_ipv4

重新启动系统

[root@master ~]# reboot检查SELinux是否关闭

[root@master ~]# getenforceDisabled

#检查swap分区是否关闭

[root@master ~]# free -gwap: 0B 0B 0B

#设置每台服务器的时区为中国标准时区CST(亚洲/上海)

[root@master ~]# timedatectl set-timezone Asia/Shanghai#配置时间同步,保证每一个节点时间一致

[root@master ~]# yum -y install chrony#启动chronyd

[root@master ~]# systemctl start chronyd

[root@master ~]# systemctl enable chronyd#查看时间

[root@master ~]# date8.安装docker、kubeadm、kubelet、kubectl程序(三台主机都需要安装)

#创建阿里Base源与epel源用于安装依赖包

[root@master ~]# curl -o /etc/yum.repos.d/CentOS-Base.repo https://mirrors.aliyun.com/repo/Centos-7.repo

[root@master ~]# wget -O /etc/yum.repos.d/epel.repo http://mirrors.aliyun.com/repo/epel-7.repo#生成yum缓存提高软件下载速度

[root@master ~]# yum makecache#安装yum-utils软件用于提供yum-config-manager程序

[root@master ~]# yum install -y yum-utils#使用yum-config-manager创建docker存储库(阿里)

[root@master ~]# yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo#查看当前镜像源中支持的docker版本

#安装特定版docker-ce,安装时需要使用--setopt=obsoletes=0参数指定版本否则yum会自动安装高版本(我使用的高版本)

[root@master ~]# yum -y install docker-ce-18.06.3.ce-3.el7

#查看docker版本信息

[root@master ~]# docker --version#创建/etc/docker目录,并在/etc/docker目录下添加一个配置文件

[root@master ~]# mkdir /etc/docker#Docker默认使用的Cgroup Driver为默认文件驱动,而k8s默认使用的文件驱动为systemd,k8s要求驱动类型必须要一致,所以需要将docker文件驱动改成systemd

[root@master ~]# cat <<EOF > /etc/docker/daemon.json

{

"registry-mirrors": ["https://aoewjvel.mirror.aliyuncs.com"],

"exec-opts": ["native.cgroupdriver=systemd"]

}

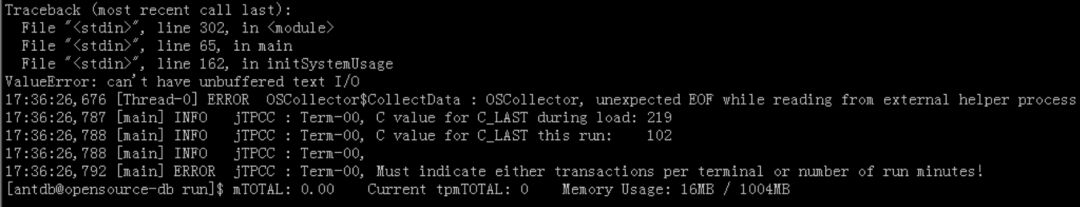

EOF驱动问题或许会导致master初始化失败(许多问题会导致失败) 具体看

K8S集群部署问题及处理记录-CSDN博客![]() https://blog.csdn.net/m0_72264240/article/details/134438973?spm=1001.2014.3001.5502

https://blog.csdn.net/m0_72264240/article/details/134438973?spm=1001.2014.3001.5502

#启动docker程序

[root@master ~]# systemctl start docker

#设置docker随机自启

[root@master ~]# systemctl enable docker9.安装kubernetes程序

#创建阿里kubernetes仓库

[root@master ~]# cat <<EOF > /etc/yum.repos.d/kubernetes.repo

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64/

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF#查看仓库可用软件包

[root@master ~]# yum repolist#生成yum缓存提高软件下载速度

[root@master ~]# yum makecache#安装kubeadm、kubelet、kubectl程序

#指定版本下载

[root@master ~]# yum install kubectl-1.23.5 kubelet-1.23.5 kubeadm-1.23.5 -y

#设置kubelet开机自启,不然kubeadm init时会有警告提示

#集群初始化时候kubectl init时会自动start

[root@master ~]# systemctl enable kubelet必须一次性下完

开始

若是低版本安装(请看开始到截至,1.23版本这部分不需要看)

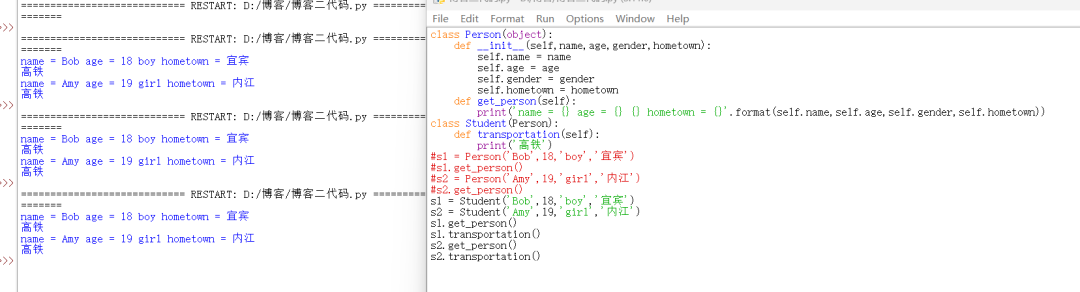

这里注意:之前我配置的1.17版本需要配置kubelet的cgroup,编辑/etc/sysconfig/kubelet文件

[root@master ~]# vim /etc/sysconfig/kubeletKUBELET_EXTRA_ARGS="--cgroup-driver=systemd"

KUBELET_PROXY_MODE="ipvs"

1.23未进行该操作以及初始化前的操作(可能是版本以及containerd支持问题)

#在安装kubernetes集群前,必须要准备好集群需要的镜像,所需的镜像可以通过下面命令查看

[root@master ~]# kubeadm config images listk8s.gcr.io/kube-apiserver:v1.17.4

k8s.gcr.io/kube-controller-manager:v1.17.4

k8s.gcr.io/kube-scheduler:v1.17.4

k8s.gcr.io/kube-proxy:v1.17.4

k8s.gcr.io/pause:3.1

k8s.gcr.io/etcd:3.4.3-0

k8s.gcr.io/coredns:1.6.5

#定义镜像列表,因为此镜像在kubernetes仓库中,由于网络原因无法下载

[root@master ~]# images=(

kube-apiserver:v1.17.4

kube-controller-manager:v1.17.4

kube-scheduler:v1.17.4

kube-proxy:v1.17.4

pause:3.1

etcd:3.4.3-0

coredns:1.6.5

)#从阿里镜像仓库下载镜像

[root@master ~]# for imageName in ${images[@]};do

docker pull registry.cn-hangzhou.aliyuncs.com/google_containers/$imageName

docker tag registry.cn-hangzhou.aliyuncs.com/google_containers/$imageName k8s.gcr.io/$imageName

docker rmi registry.cn-hangzhou.aliyuncs.com/google_containers/$imageName

done#查看镜像(标签已变成k8s标签)

[root@master ~]# docker images

截至

10.kubernetes集群初始化(master节点)

#初始化集群

kubeadm init --kubernetes-version=1.23.5 \

--apiserver-advertise-address=192.168.75.129 \

--image-repository registry.aliyuncs.com/google_containers \

--service-cidr=10.10.0.0/16 \

--pod-network-cidr=10.122.0.0/16

[root@master ~]# export KUBECONFIG=/etc/kubernetes/admin.conf#查看所有的pod

[root@master ~]# kubectl get pods --all-namespaces

#查看kubernetes节点

[root@master ~]# kubectl get nodes注意:未安装网络是ready

11.kubernetes安装网络插件

flannel

kubernetes支持多种网络插件,如:flannel、calico、canal等,任选一种使用即可

之前我实验选择的是flannel,这次试一试calico(但是flannel步骤也会写,自行选择)

只在master节点安装flannel插件即可,该插件使用的是DaemonSet控制器,该控制器会在每个节点上都运行;

#获取flannel配置文件

[root@master~]# wget https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml#执行文件启动flannel

[root@master ~]# kubectl apply -f kube-flannel.yml#查看nodes节点信息

[root@master ~]# kubectl get nodescalico

#下载calico.yaml文件

[root@master ~]# curl https://docs.projectcalico.org/v3.18/manifests/calico.yaml -Ocalico.yaml获取:

链接:https://pan.baidu.com/s/1zhK26T7mA1PpAsNZY0Xhog?pwd=weiy

提取码:weiy

#安装calico

[root@master ~]# kubectl apply -f calico.yaml

[root@master ~]# kubectl get pods --all-namespaces

[root@master ~]# kubectl get nodes

12.node节点加入集群

这个地方为了使得证书有效,需要在master上生成新的证书。

为什么要重新生成证书?

通常情况下,我们可以使用初始化后给出的命令来添加worker节点。然而,这些命令通常只在24小时内有效。为了避免在后续增加worker节点时需要重新生成token,我们可以自行生成一个永不过期的命令。这样一来,我们就可以直接使用这个命令来添加worker节点,省去了临时重新生成token的步骤。这样可以更加方便和高效地管理和增加worker节点。

#查看现有token

[root@master ~]# kubeadm token list

#创建一个永不过期的token

[root@master ~]# kubeadm token create --ttl 0#获取ca证书sha256编码hash值

[root@master ~]# openssl x509 -pubkey -in /etc/kubernetes/pki/ca.crt | openssl rsa -pubin -outform der 2>/dev/null | openssl dgst -sha256 -hex | sed 's/^.* //'

生成后,node节点加入

生成后,node节点加入

node操作

[root@node1 ~]# kubeadm join 192.168.75.129:6443 --token murk1y.4pdoh7s8a96ejw4v --discovery-token-ca-cert-hash sha256:475eb6e0d651f1cb7ea17767945dd15a78c1f2511636166b8590c729cbb9e757

[root@node2 ~]# kubeadm join 192.168.75.129:6443 --token murk1y.4pdoh7s8a96ejw4v --discovery-token-ca-cert-hash sha256:475eb6e0d651f1cb7ea17767945dd15a78c1f2511636166b8590c729cbb9e757

[root@master ~]# kubectl get pods --all-namespaces

[root@master ~]# kubectl get nodes

等待加入成功,状态由notready到ready

注意:在node节点无法使用kubectl的命令

因为Kubernetes集群中的kubectl命令通常用于与集群进行交互,例如部署、管理和监控应用程序。

在正常情况下,kubectl命令应该在Kubernetes集群的master节点上使用,而不是在node节点上。这是因为master节点才是集群的控制平面,负责管理整个集群的状态和控制逻辑,而node节点主要用于运行应用程序和服务。

因此,在node节点上使用kubectl命令可能会导致权限不足或无法连接到集群的问题。

如果需要在node节点上执行kubectl命令,通常建议通过远程登录到master节点来执行,但是生产环境有时也会需要从node节点去查看pod的健康状态

需要去下载master节点的:/etc/kubernetes/admin.conf

[root@node1 ~]# scp root@master:/etc/kubernetes/admin.conf /etc/kubernetes/

[root@node1 ~]# echo "export KUBECONFIG=/etc/kubernetes/admin.conf" >> /etc/profile

[root@node1 ~]# source /etc/profile

node2节点同上

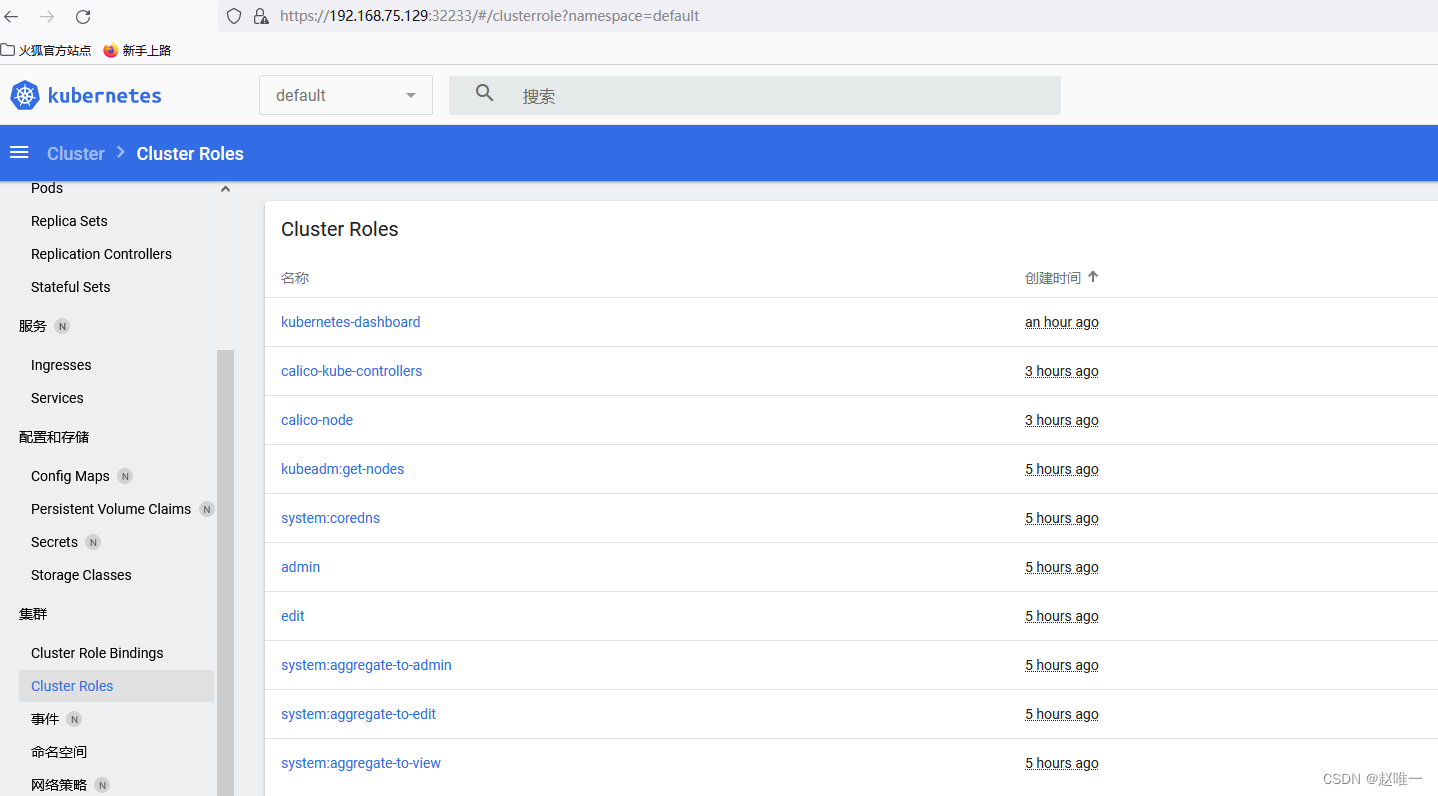

13.安装Dashboard

Kubernetes Dashboard是Kubernetes集群的官方Web用户界面,它提供了一种直观的方式来可视化和管理集群中的应用程序、资源和工作负载。通过Kubernetes Dashboard,用户可以查看集群中的各种资源对象(如Pods、Services、Deployments等)、监控集群的状态、进行日志查看、执行命令等操作。

它为用户提供了一个方便的方式来管理和监控他们的Kubernetes集群,而无需深入了解Kubernetes的命令行工具或API。Kubernetes Dashboard使得管理和操作Kubernetes集群变得更加直观和便捷。

[root@master ~]# wget https://raw.githubusercontent.com/kubernetes/dashboard/v2.5.1/aio/deploy/recommended.yaml

recommended.yaml文件索取地址:

链接:https://pan.baidu.com/s/1K7A_PnMpgHpduMIuTqb2rg?pwd=weiy

提取码:weiy

#在recommended.yaml的service里添加nodeport,这样可以通过主机ip+port 来访问dashboard

镜像拉取策略

在容器环境中,镜像拉取策略用于指定容器运行时如何获取所需的镜像。

1. Always(始终拉取):无论本地是否已经存在镜像,始终拉取最新版本。如果本地已有镜像,则会重新拉取最新版本并覆盖原有镜像。

2. IfNotPresent(若不存在则拉取):仅当本地不存在指定镜像时才拉取。如果本地已经存在所需镜像,则直接使用本地镜像而不进行拉取。

3. Never(不拉取):从不拉取镜像,仅使用本地已存在的镜像。如果本地不存在所需镜像,容器将无法启动。

建议改为Never 不然远程拉取容易出错(我这里没做改变)

注意如果修改后要使用kubectl apply -f recommended.yaml而不是create

#创建danshboard

[root@master ~]# kubectl create -f recommended.yaml

#查看所有pod

[root@master ~]# kubectl get pods --all-namespaces

查看pod两个pod的详细信息

[root@master ~]# kubectl describe pod/dashboard-metrics-scraper-799d786dbf-5c5ts --namespace=kubernetes-dashboard

[root@master ~]# kubectl describe pod/kubernetes-dashboard-fb8648fd9-f6ncv --namespace=kubernetes-dashboard

这一步或许会有镜像拉不下来的问题

Kubernetes Dashboard部署ImagePullBackOff问题处理-CSDN博客![]() https://blog.csdn.net/m0_72264240/article/details/134461203

https://blog.csdn.net/m0_72264240/article/details/134461203

14.访问dashboard界面

经过谷歌以及edge测试

处理办法:使用火狐

#token登录

#创建账号

[root@master ~]# kubectl create serviceaccount dashboard-admin -n kube-system#授权

[root@master ~]# kubectl create clusterrolebinding dashboard-admin --clusterrole=cluster-admin --serviceaccount=kube-system:dashboard-admin

#获取token信息

[root@master ~]# kubectl describe secrets -n kube-system $(kubectl -n kube-system get secret | awk '/dashboard-admin/{print $1}')