大数据产业创新服务媒体

——聚焦数据 · 改变商业

在当今技术快速发展的时代,OpenAI的ChatGPT无疑成为了人工智能领域的一颗耀眼明星。但是,随着其用户数量的激增,一个不可忽视的问题逐渐浮出水面——算力短缺。这不仅是OpenAI单独的挑战,而是整个人工智能行业面临的一道难题。

在这篇深度分析文章中,我们将探究算力短缺的根本原因,以及它如何影响着大模型的发展和行业的未来。同时,我们也会探讨解决这一问题的潜在途径,包括国产GPU的发展及其可能对全球市场的影响。

算力短缺,一直困扰着OpenAI

算力短缺,一直是OpenAI在其迅速崛起过程中不得不面对的一个棘手问题。最近,这个问题因为一场引人注目的事件而变得更加突出。OpenAI举办的一场被戏称为“科技春晚”的大型展示活动,展示了其技术的最新成果,引起了全球范围内极大的关注。结果,如同潮水般的用户涌向了OpenAI的平台,特别是其明星产品ChatGPT。

然而,这场热潮背后隐藏着一个巨大的挑战。用户量的爆炸式增长,迅速超出了OpenAI的算力容量。就在大会结束后的两天,一个令人震惊的事实显现:ChatGPT服务器崩溃了。无数的网友报告称,他们无法正常使用ChatGPT和OpenAI提供的API。

面对这一危机,OpenAI只得作出了一个令市场震惊的决定:暂停新的ChatGPT Plus用户注册。这一决策背后的经济代价是巨大的,按照每月20美元的订阅费计算,一亿新用户每月能为OpenAI带来20亿美元的收入。如此庞大的潜在收益,却因为算力的短缺而不得不放弃,这无疑是一种极为被动的选择。

实际上,算力短缺问题并非仅仅出现在近期。自从ChatGPT推出以来,算力的问题就一直是一个挥之不去的阴影。例如,在4月份,ChatGPT Plus的付费项目购买也曾被迫暂停。这种情况时有发生,似乎成了OpenAI成长道路上的一种常态。

这些事件揭示了一个不争的事实:在当前技术发展的大背景下,算力已成为限制AI技术创新和商业应用扩展的一大瓶颈。对于OpenAI来说,这不仅是一个技术挑战,更是一个战略层面的难题。如何在迅速扩张的市场需求和有限的算力资源之间找到平衡,成为了摆在OpenAI面前的一道难题。这一挑战不仅关系到公司的短期收益,更牵涉到长远的市场地位和技术领导力。

地主家也没余粮了

OpenAI多次对外宣布,算力不够用。

要知道,OpenAI可是大模型的明星企业,有巨额融资,有大量的算力资源。而且,还有一个“金主爸爸”微软,对其提供全方位的算力支持。微软可拥有全球第二的云计算资源。

从这个角度来看,OpenAI可以说是算力“地主”。但实际情况却是,地主家没余粮了。那么,一个拥有巨额融资和微软这样的强大背书的公司,为何会陷入这种困境?

我们必须认识到,大模型对算力的需求是前所未有的。这些模型基于上千亿级别的神经网络,每一次计算都是对算力的巨大考验。简单地说,我们现在面临的是一个全新等级的计算需求,这在以往的软件发展史上是无法找到对应的。CPU这种传统的计算资源在这里显得力不从心,而需要依赖的GPU,无疑是这场技术革命的前线。

(对于大模型对GPU的算力消耗问题,数据猿撰写的文章《算一笔细账,ChatGPT、文心一言这类大模型到底要消耗多少GPU?》,有更深入的分析。)

然而,GPU的问题在于,它们不仅是新兴的技术产品,还面临着设计迭代和产能限制的双重挑战。尽管科技界对GPU的需求日益增长,但全球的芯片制造能力却并未跟上这一需求的脚步。现有的半导体制造和封测体系,主要是围绕CPU设计的,而对于新兴的GPU,它们显然还没有完全适应。这意味着,在提高GPU产能、适应新的技术需求方面,还有很长的路要走。

GPU技术不断进步,每一代产品都在力求提高性能和效率,这就要求持续的研发投入和技术创新。然而,这种持续的技术迭代也意味着不断增加的研发成本,同时也增加了制造过程的复杂性。

除了产能问题,GPU的成本也是一个不容忽视的问题。要构建一个能够支撑大模型运算的GPU计算集群,需要的不仅仅是技术,更是一笔巨大的资金投入。即使对于像OpenAI这样的科技巨头,这也是一笔不小的负担。在成本和效益之间寻找平衡,无疑是一个艰难的抉择。

如果连OpenAI都在算力短缺的问题上苦苦挣扎,那么其他的企业又将如何?这不仅是对OpenAI的挑战,更是整个人工智能行业的挑战。我们正在目睹的是一个巨大的转变:从传统计算向人工智能驱动的计算转变。在这个转变中,算力成为了最关键的瓶颈。

我们不能忽视的是,这种短缺并非一夜之间的现象,而是长期技术发展和市场需求不匹配的结果。GPU芯片的生产限制、技术发展和成本问题是多方面的,涉及到全球的供应链、技术创新和经济模型。大模型应用的高算力需求,对现有技术架构提出了前所未有的挑战,迫使整个行业必须重新思考如何设计、构建和优化计算资源。

当B端应用规模化之后,算力紧缺问题会更加严重

还有一个非常重要,但又容易被忽视的问题。

当我们探讨算力短缺问题时,通常将焦点放在当前的C端用户体验上。但是,这仅仅是冰山一角。一个更加严峻、却常被忽视的问题潜伏在B端应用的规模化中。目前,尽管像ChatGPT这样的大模型主要服务于C端用户,但这只是开始。随着B端应用的逐渐增长和成熟,我们将面临一个前所未有的算力需求激增。

在中国市场,这一趋势已经初现端倪。百度文心一言、阿里通义千问等产品,虽然目前主要服务于C端用户,但它们对B端应用的探索已经在路上。目前这些产品多处于产品研发阶段,但一旦进入到大规模商用阶段,情况将截然不同。B端业务的复杂性远超C端。在C端,用户与系统的互动通常是简单的查询或命令执行。然而,在B端,每一个业务流程可能涉及更复杂的数据处理、分析和决策制定过程。这些流程不仅需要更多的计算资源,而且对算力的质量和稳定性有着更高的要求。

更值得关注的是,B端业务的算力消耗不仅体现在单次交互的复杂度上,还体现在调用的频率上。在B端,大模型的应用往往是连续的、高频的,与C端偶尔的查询和使用形成鲜明对比。例如,在金融、医疗、制造等行业,大模型需要持续处理大量数据,提供实时的分析和决策支持。这种高频、高负荷的运算需求,对算力的压力是巨大的。

可以预见的是,随着大模型在B端的应用普及,其对算力的需求将迅速超过C端。这种转变可能会悄无声息,但其影响却是深远的。一方面,算力的增加需求将推动相关技术的发展,如更高效的GPU、更优化的计算架构等。另一方面,这也将对整个行业的资源分配、成本结构和商业模式带来重大影响。

在这个过程中,我们可能会看到一些企业因为无法承受这种算力成本而被迫退出市场,也可能看到一些企业凭借先进的算力管理和优化技术而脱颖而出。

中国面临双重算力瓶颈

在全球范围内,算力短缺已成为人工智能发展的一大瓶颈,而对于中国来说,这一挑战更显得尤为严峻。中国的大模型企业不仅要应对全球性的算力紧张(“天灾”),还要面对特有的市场供应限制(“人祸”),这种双重压力,使得中国在大模型领域的发展前景复杂且充满挑战。

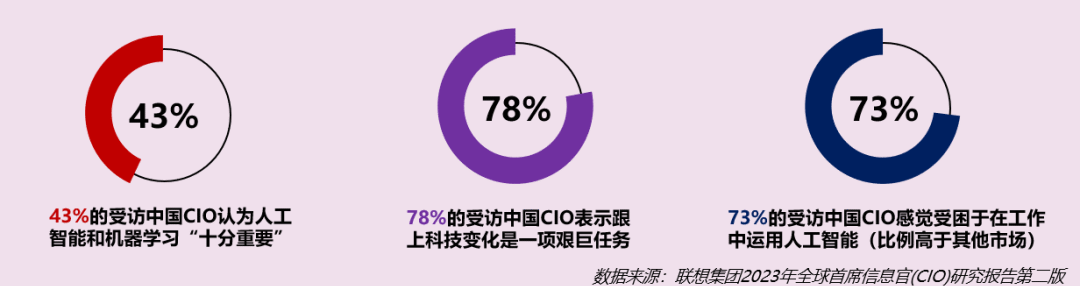

我们必须认识到,中国大模型企业在算力资源上的局限性。虽然百度、阿里、字节跳动、腾讯和华为等公司在大模型的研发上取得了显著成就,但他们面临的算力挑战却是真实而紧迫的。当前,由于全球GPU行业发展的整体不足,中国企业在获取足够算力资源上遇到了重大障碍。这种“天灾”式的问题,是技术发展和产业升级的必经之路,需要时间和巨额投资才能解决。

更棘手的是,中国大模型企业还面临着来自国际市场的“人祸”——特别是英伟达等国际巨头对中国市场的供应限制。这种政策限制直接影响了中国企业获取高端GPU芯片的能力,从而加剧了算力资源的短缺。这种双重限制,无疑为中国大模型企业的发展增添了额外的不确定性和挑战。

目前,虽然像百度的文心一言、阿里的通义千问等产品的用户量还未达到ChatGPT的亿级规模,但这并不意味着中国企业可以轻松应对现有的算力挑战。随着这些产品的发展和市场的扩张,尤其是当它们开始在B端市场广泛应用时,对算力的需求将会急剧增长。这时,算力短缺的问题将变得更加突出,可能严重制约中国大模型产业的发展。

长远来看,如果中国不能有效应对这一双重算力瓶颈,那么其大模型产业的发展将可能被限制在一个较低的水平。这不仅会影响到国内市场的竞争力,更会在全球范围内限制中国在人工智能领域的影响力。因此,解决算力短缺问题,对于中国大模型产业的未来发展至关重要,这不仅是技术问题,更是战略问题,关乎中国在全球人工智能竞赛中的地位和未来。

在中国面临的双重算力挑战中,最近出现了一些令人鼓舞的积极信号,特别是在国产GPU的发展上。国内领先的科技企业如百度、阿里、360等已开始与华为这样的国产GPU厂商展开合作。(数据猿发布的文章《芯片界地震!国产GPU狂飙,英伟达霸权终结者?》,有更详细的介绍。)

国产GPU的崛起,对于解决中国算力短缺问题具有深远的意义。如果这些国产GPU在性能上能够媲美行业领头羊英伟达,并且在制造层面的瓶颈得到有效解决,那么这将为中国的大模型产业带来前所未有的机遇。从历史经验来看,国产技术一旦成熟,通常能以更有竞争力的价格进入市场。这意味着,如果国产GPU能够成功,它们很可能以远低于国际品牌的价格提供相似甚至更优的性能。

这种成本优势不仅能够缓解当前的算力短缺问题,更有可能彻底改变市场格局。目前昂贵的GPU价格一直是限制大模型技术普及和应用的一个重要因素。如果国产GPU能够以更低的价格提供高性能的计算能力,这将极大地促进大模型技术在各行各业的应用,加速中国在人工智能领域的发展。

更重要的是,这种发展可能使中国在全球人工智能竞赛中实现“反败为胜”。在大模型算力和应用方面,中国有可能不仅追赶上,甚至超越美国等领先国家。

当然,这一切都还处于发展之初,国产GPU的成功还需要克服技术上的挑战。但已经出现的积极迹象表明,中国在算力自主化的道路上已迈出坚实的步伐。未来几年,我们有望见证国产GPU技术的成熟和大规模应用,以及它如何推动中国大模型产业的飞跃发展。

综上,在探究算力短缺这一全球性挑战的旅程中,我们不仅见证了技术的边界被不断推进,也深刻体会到了行业发展面临的复杂挑战。从OpenAI的故事到中国大模型企业的双重困境,再到国产GPU技术的崛起,这一切揭示了一个核心真理:在人工智能的未来发展道路上,算力已成为关键的战略资源。这不仅是技术层面的竞赛,更是全球范围内科技力量对未来的投资和布局。

展望未来,随着技术进步和市场需求的不断演变,我们有理由相信,算力短缺的问题最终将得到解决。在这个过程中,创新、合作和策略调整将是每一位参与者必须面对的关键课题。最终,这场关于算力的挑战,将定义人工智能技术的未来形态,并塑造我们的数字世界。

文:一蓑烟雨 / 数据猿