Softmax函数和Sigmoid函数(也称为Logistic函数)在某些方面有相似之处,但它们在使用和适用场景上有一些不同。

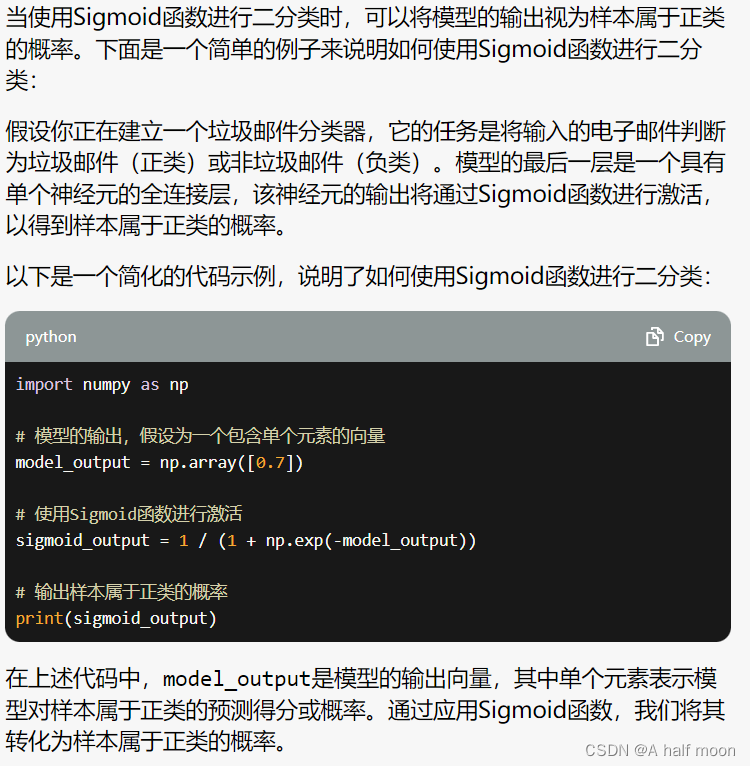

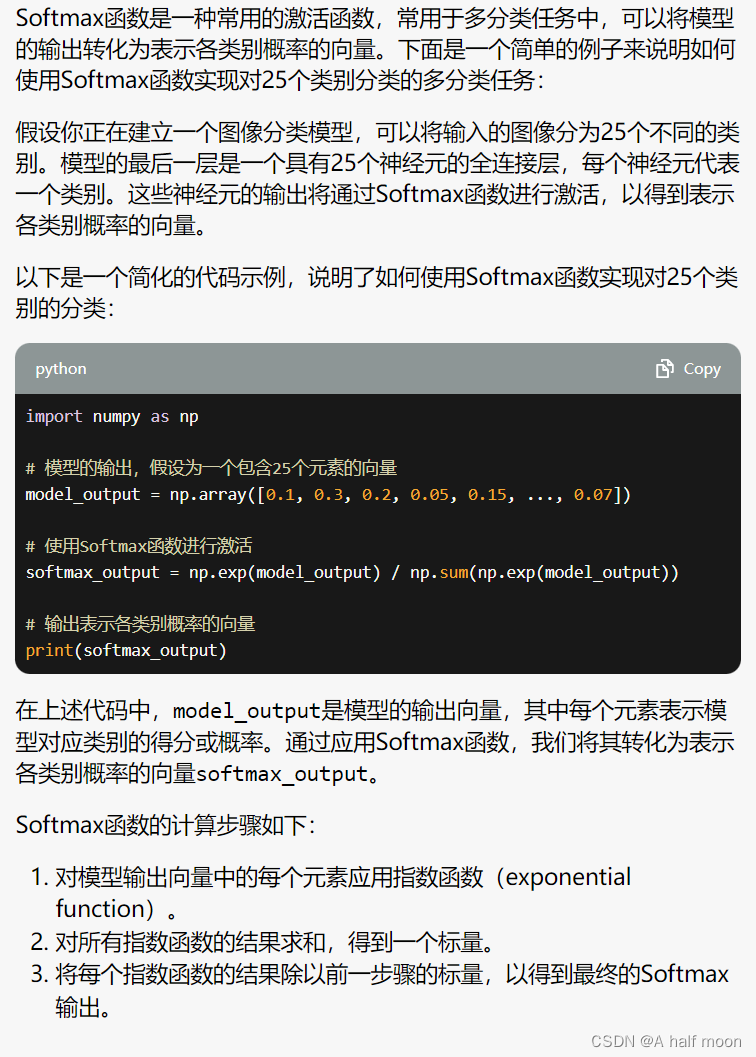

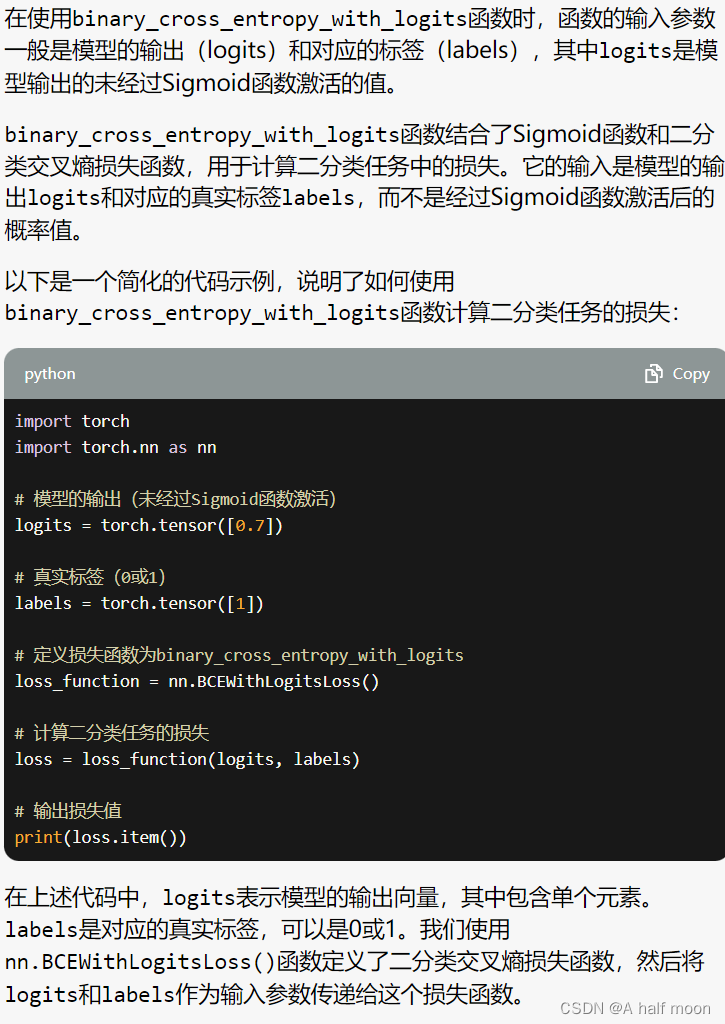

首先,Sigmoid函数适用于二分类问题,将模型输出映射到0和1之间的概率值,表示样本属于正类的概率。它的输出可以被解释为"正类"的置信度。而Softmax函数适用于多分类问题,将模型输出映射到表示各类别概率的向量。Softmax函数的输出可以被解释为各个类别的置信度或可能性。

其次,Sigmoid函数的输出是单个值,而Softmax函数的输出是一个概率分布向量,其所有元素的和为1。在二分类问题中,Softmax函数可以通过设置两个输出神经元的权重和偏置来模拟Sigmoid函数的行为,但是这种用法并不常见。

另外,Softmax函数在多分类问题中更常用,而Sigmoid函数在二分类问题中更常用。对于多分类问题,Softmax函数可以处理多个类别之间的竞争关系,确保概率分布的归一化。而对于二分类问题,Sigmoid函数通常被用于输出单个概率值,表示样本属于正类的概率。

总结起来,Softmax函数和Sigmoid函数是两种不同的激活函数,它们在使用和适用场景上有所不同。Softmax函数适用于多分类问题,将模型输出映射到表示各类别概率的向量;而Sigmoid函数适用于二分类问题,将模型输出映射到0和1之间的概率值。