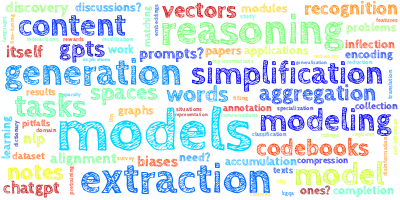

AI视野·今日CS.NLP 自然语言处理论文速览

Wed, 25 Oct 2023 (showing first 100 of 112 entries)

Totally 100 papers

👉上期速览✈更多精彩请移步主页

Daily Computation and Language Papers

| MuSR: Testing the Limits of Chain-of-thought with Multistep Soft Reasoning Authors Zayne Sprague, Xi Ye, Kaj Bostrom, Swarat Chaudhuri, Greg Durrett 虽然配备了思维链提示等技术的大型语言模型法学硕士已经展现出令人印象深刻的能力,但它们在复杂环境中稳健推理的能力仍然不足。然而,评估 LLM 推理具有挑战性,因为系统功能不断增长,而逻辑演绎等任务的基准数据集却保持不变。我们引入 MuSR,这是一个用于评估自然语言叙述中指定的多步骤软推理任务的语言模型的数据集。该数据集有两个关键特征。首先,它是通过一种新颖的神经符号合成到自然生成算法创建的,能够构建挑战 GPT 4 的复杂推理实例,例如,长度约为 1000 个单词的谋杀之谜,并且随着功能更强大的法学硕士的发布,可以进一步扩展。其次,我们的数据集实例是与现实世界推理领域相对应的自由文本叙述,这使得它同时比其他综合制作的基准更具挑战性,同时保持现实和易于人类注释者高精度地解决。 |

| WebWISE: Web Interface Control and Sequential Exploration with Large Language Models Authors Heyi Tao, Sethuraman T V, Michal Shlapentokh Rothman, Derek Hoiem 本文研究了使用大型语言模型 LLM 通过单击、滚动和文本输入操作自动执行 Web 软件任务。以前的方法,例如强化学习 RL 或模仿学习,在训练和特定任务方面效率低下。我们的方法使用过滤后的文档对象模型 DOM 元素作为观察,并逐步执行任务,根据当前观察顺序生成小程序。我们在上下文学习中使用,要么受益于单个手动提供的示例,要么受益于基于成功的零样本试验的自动生成的示例。我们在 MiniWob 基准上评估所提出的方法。 |

| Instruct and Extract: Instruction Tuning for On-Demand Information Extraction Authors Yizhu Jiao, Ming Zhong, Sha Li, Ruining Zhao, Siru Ouyang, Heng Ji, Jiawei Han 具有指令跟踪功能的大型语言模型为更广泛的用户群体打开了大门。然而,当涉及到自然语言处理中的经典任务信息提取时,大多数特定于任务的系统无法与非专家用户的长尾即席提取用例很好地结合起来。为了解决这个问题,我们提出了一种新颖的范例,称为按需信息提取,来满足现实世界用户的个性化需求。我们的任务旨在按照说明从关联文本中提取所需内容并以结构化表格格式呈现。表标题可以是用户指定的,也可以由模型根据上下文推断。为了促进这一新兴领域的研究,我们提出了一个名为 InstructIE 的基准,其中包括自动生成的训练数据以及人工注释的测试集。在 InstructIE 的基础上,我们进一步开发了按需信息提取器 ODIE。对我们的基准的综合评估表明,ODIE 大大优于现有的类似规模的开源模型。 |

| Dissecting In-Context Learning of Translations in GPTs Authors Vikas Raunak, Hany Hassan Awadalla, Arul Menezes 最近利用大型语言模型 LLM(例如用于机器翻译 MT 的 GPT 3)的大部分工作都集中在选择少数镜头样本进行提示。在这项工作中,我们试图通过高质量的扰动,在领域演示中更好地理解演示属性在上下文翻译学习中的作用。我们发现源目标映射的不对称扰动会产生截然不同的结果。我们表明,源端的扰动影响很小,而目标端的扰动会大大降低翻译质量,这表明输出文本分布在翻译的上下文学习过程中提供了最重要的学习信号。我们提出了一种名为 Zero Shot Context 的方法,在 Zero Shot 提示中自动添加此信号。 |

| Accented Speech Recognition With Accent-specific Codebooks Authors Darshan Prabhu, Preethi Jyothi, Sriram Ganapathy, Vinit Unni 语音口音对最先进的自动语音识别 ASR 系统提出了重大挑战。代表性不足的口音的表现下降严重阻碍了 ASR 的包容性采用。在这项工作中,我们提出了一种新颖的口音适应方法,用于端到端 ASR 系统,使用交叉注意力和一组可训练的码本。这些可学习的码本捕获特定口音的信息,并集成在 ASR 编码器层中。该模型是根据带口音的英语语音进行训练的,而测试数据还包含训练期间未看到的口音。在 Mozilla Common Voice 多口音数据集上,我们表明,我们提出的方法不仅在可见英语口音的单词错误率上相对提高了 37 个,而且在未见口音的 WER 上也取得了显着的性能提升,相对提高了 5 个。此外,我们还说明了 L2Artic 数据集上零镜头传输设置的好处。 |

| Mixture of Tokens: Efficient LLMs through Cross-Example Aggregation Authors Szymon Antoniak, Sebastian Jaszczur, Micha Krutul, Maciej Pi ro, Jakub Krajewski, Jan Ludziejewski, Tomasz Odrzyg d , Marek Cygan 尽管专家混合 MoE 模型有望增加 Transformer 模型的参数数量,同时保持训练和推理成本,但其应用存在明显的缺陷。这些模型的关键策略是,对于每个处理的令牌,激活广泛前馈层的至多几个专家子集。但这种方法并非没有挑战。匹配专家和代币的操作是离散的,这使得MoE模型容易出现训练不稳定和专家利用率不均匀等问题。旨在解决这些问题的现有技术(例如辅助损失或平衡感知匹配)会导致模型性能较低或更难以训练。针对这些问题,我们提出了 Mixture of Tokens,这是一种完全可微分的模型,它保留了 MoE 架构的优点,同时避免了上述困难。这种方法不是将令牌路由给专家,而是在将不同示例中的令牌提供给专家之前将其混合,从而使模型能够从所有令牌专家组合中学习。重要的是,可以禁用这种混合,以避免在推理过程中混合不同的序列。 |

| NoteChat: A Dataset of Synthetic Doctor-Patient Conversations Conditioned on Clinical Notes Authors Junda Wang, Zonghai Yao, Zhichao Yang, Huixue Zhou, Rumeng Li, Xun Wang, Yucheng Xu, Hong Yu 医生在每次就诊后起草的详细临床记录对于医生和研究人员来说至关重要。利用语言模型自动创建这些笔记可以减少医生的工作量。然而,由于患者和医生之间的对话的公众可用性有限,训练此类模型可能很困难。在本文中,我们介绍了 NoteChat,这是一个协作式多代理框架,利用大型语言模型 LLM 来生成以临床记录为条件的合成医患对话。 NoteChat 由规划、角色扮演和波兰模块组成。我们对 NoteChat 进行全面的自动和人工评估,并将其与最先进的模型(包括 OpenAI 的 ChatGPT 和 GPT 4)进行比较。结果表明,NoteChat 促进了高质量的合成医患对话,强调了法学硕士在医疗保健领域尚未开发的潜力。 |

| This is not a Dataset: A Large Negation Benchmark to Challenge Large Language Models Authors Iker Garc a Ferrero, Bego a Altuna, Javier lvez, Itziar Gonzalez Dios, German Rigau 尽管大型语言模型法学硕士显然已经获得了一定水平的语法知识和概括能力,但他们无法解释否定,这是自然语言处理的关键步骤。我们试图阐明法学硕士在理解否定方面表现不佳的原因。我们引入了一个大型半自动生成的数据集,其中包含大约 400,000 个关于常识知识的描述性句子,这些句子可以是对的,也可以是错的,其中否定以不同的形式出现在大约 2 3 个语料库中。我们以零样本方法使用我们的数据集和最大的可用开放法学硕士来掌握它们的泛化和推理能力,我们还微调了一些模型来评估是否可以训练对否定的理解。我们的研究结果表明,虽然法学硕士能够熟练地对肯定句进行分类,但他们却很难处理否定句,并且缺乏对否定的深刻理解,往往依赖于肤浅的线索。尽管对否定句的模型进行微调可以提高其性能,但在处理否定方面缺乏泛化仍然存在,这凸显了法学硕士在否定理解和泛化方面持续面临的挑战。 |

| Contrastive Learning-based Sentence Encoders Implicitly Weight Informative Words Authors Hiroto Kurita, Goro Kobayashi, Sho Yokoi, Kentaro Inui 通过使用对比损失进行微调的简单实践,可以显着提高句子编码器的性能。一个自然的问题是模型在对比学习过程中获得什么特征。本文从理论上和实验上表明,基于对比的句子编码器隐式地根据信息理论量对单词进行加权,即信息量越大的单词获得的权重越大,而其他单词的权重则较小。该理论指出,在对比学习目标最优值的下界,词嵌入的范数反映了与周围词的分布相关的信息增益。我们还使用各种模型、多个数据集、两种测量模型隐式权重的方法Integrated Gradients和SHAP以及两个信息理论量信息增益和自信息进行了综合实验。 |

| In-Context Learning Creates Task Vectors Authors Roee Hendel, Mor Geva, Amir Globerson 在大型语言模型中学习 ICL 的情境中,法学硕士已成为一种强大的新学习范式。然而,其基本机制仍不清楚。特别是,将其映射到标准机器学习框架是具有挑战性的,在标准机器学习框架中,人们使用训练集 S 在某个假设类中找到最佳拟合函数 f x 。在这里,我们在这个问题上取得了进展,表明 ICL 学习的函数通常具有非常简单的结构,它们对应于转换器 LLM,其唯一输入是查询 x 和从训练集计算的单个任务向量。因此,ICL 可以被视为将 S 压缩为单个任务向量(粗体符号 theta S),然后使用该任务向量来调制变压器以产生输出。 |

| Characterizing Mechanisms for Factual Recall in Language Models Authors Qinan Yu, Jack Merullo, Ellie Pavlick 语言模型 LM 通常必须将他们在预训练中记住的事实与给定上下文中出现的新信息结合起来。这两个来源可能存在分歧,从而导致模型内部竞争,并且尚不清楚 LM 将如何解决冲突。在查询世界首都知识的数据集上,我们研究了这种情况下 LM 行为的分布和机械决定因素。具体来说,我们测量了 LM 使用反事实前缀(例如,波兰首都是伦敦)来覆盖其在预训练华沙中学到的内容的时间比例。在 Pythia 和 GPT2 上,查询国家波兰和上下文城市伦敦的训练频率极大地影响模型使用反事实的可能性。然后,我们使用头部归因来识别个人注意力头,这些注意力头要么促进记忆的答案,要么促进逻辑中的上下文答案。通过放大或缩小这些头的值向量,我们可以控制在新数据上使用上下文答案的可能性。该方法只需在运行时缩放单个头,即可将生成上下文答案的速率提高到 88 倍。 |

| Is Probing All You Need? Indicator Tasks as an Alternative to Probing Embedding Spaces Authors Tal Levy, Omer Goldman, Reut Tsarfaty 识别和控制以单词向量表示形式编码的不同类型语言信息的能力有很多用例,特别是在可解释性和偏差消除方面。这通常是通过一组简单的分类任务(称为探针)来完成的,以评估嵌入空间中编码的信息。然而,可训练分类器的参与导致探测结果和分类器性质之间的纠缠。因此,当代的探索工作包括不涉及辅助模型训练的任务。在这项工作中,我们引入了术语“不可训练任务的指示任务”,这些任务用于查询嵌入空间中是否存在某些属性,并声称此类任务可能指向与探针相反的方向,并且这种矛盾使决策变得复杂关于属性是否存在于嵌入空间中。我们用两个测试用例来证明我们的主张,一个测试用例处理性别偏见,另一个测试用例处理从嵌入空间中删除形态信息。我们表明,与探针相比,应用合适的指示器可以更准确地描述捕获和删除的信息。 |

| Do Stochastic Parrots have Feelings Too? Improving Neural Detection of Synthetic Text via Emotion Recognition Authors Alan Cowap, Yvette Graham, Jennifer Foster 生成人工智能的最新发展使高性能合成文本生成技术成为人们关注的焦点。目前此类模型的广泛可用性和易用性凸显了迫切需要提供能够识别合成文本的同样强大的技术。考虑到这一点,我们从心理学研究中汲取灵感,这些研究表明人们可以受情感驱动,并将情感编码到他们撰写的文本中。我们假设预训练语言模型 PLM 存在情感缺陷,因为它们在生成文本时缺乏这种情感驱动因素,因此可能生成情感不连贯的合成文本,即缺乏人类创作文本中存在的情感连贯性。随后,我们通过针对情绪微调 PLM 来开发情绪感知检测器。实验结果表明,我们的情感感知检测器在一系列合成文本生成器、各种大小的模型、数据集和领域中实现了改进。最后,我们在识别其自身输出的任务中将我们的情感感知合成文本检测器与 ChatGPT 进行比较,并显示出显着的收益,增强了情感作为识别合成文本的信号的潜力。 |

| BianQue: Balancing the Questioning and Suggestion Ability of Health LLMs with Multi-turn Health Conversations Polished by ChatGPT Authors Yirong Chen, Zhenyu Wang, Xiaofen Xing, huimin zheng, Zhipei Xu, Kai Fang, Junhong Wang, Sihang Li, Jieling Wu, Qi Liu, Xiangmin Xu 大型语言模型LLM在单轮对话中提供一般性和广泛的健康建议方面表现良好,例如ChatGPT、ChatGLM、ChatDoctor、DoctorGLM等系统。然而,用户在单轮对话中提供的信息有限,导致个性化不足生成建议的针对性,需要用户自主选择有用的部分。这主要是由于缺乏进行多轮提问的能力造成的。在现实世界的医疗咨询中,医生通常会采用一系列迭代的询问来彻底了解患者的病情,从而使他们能够随后提供有效且个性化的建议,这对于法学硕士来说可以定义为询问链CoQ。为了提高法学硕士的 CoQ,我们提出了 BianQue,一种基于 ChatGLM 的法学硕士,并与自建的健康对话数据集 BianQueCorpus 进行了微调,该数据集由 ChatGPT 打磨的多轮提问和健康建议组成。 |

| Using Artificial French Data to Understand the Emergence of Gender Bias in Transformer Language Models Authors Lina Conti, Guillaume Wisniewski 大量研究证明神经语言模型能够在没有直接监督的情况下学习各种语言属性。这项工作朝着探索较少研究的主题迈出了第一步,即神经模型如何发现单词的语言属性,例如性别,以及管理其使用的规则。 |

| Self-Guard: Empower the LLM to Safeguard Itself Authors Zezhong Wang, Fangkai Yang, Lu Wang, Pu Zhao, Hongru Wang, Liang Chen, Qingwei Lin, Kam Fai Wong 越狱攻击可以绕过大型语言模型法学硕士的安全措施,生成有害内容。这种对法学硕士的滥用导致了负面的社会后果。目前,应对越狱攻击的安全培训和保障措施主要有两种方法。安全培训侧重于进一步培训LLM以增强其安全性。另一方面,保障措施涉及实施外部模型或过滤器以防止有害输出。然而,安全训练在适应新攻击类型的能力上受到限制,常常导致模型性能下降。事实证明,保障措施的帮助有限。为了解决这些问题,我们提出了一种称为“自我防护”的新颖方法,它结合了两种安全方法的优点。自我防护包括两个阶段。在第一阶段,我们增强模型评估有害内容的能力,在第二阶段,我们指示模型根据自己的响应一致地执行有害内容检测。实验证明,Self Guard 能够有效抵御越狱攻击。在不良案例分析中,我们发现 LLM 偶尔会对有害查询提供无害的响应。此外,我们还评估了法学硕士在安全培训前后的一般能力,提供了自我防护不会导致法学硕士性能下降的证据。 |

| A Diffusion Weighted Graph Framework for New Intent Discovery Authors Wenkai Shi, Wenbin An, Feng Tian, Qinghua Zheng, QianYing Wang, Ping Chen 新意图发现 NID 旨在借助仅包含已知意图的有限标记数据,从未标记数据中识别新意图和已知意图。以往的方法在不考虑样本之间的结构关系的情况下,会产生噪声监督信号,无法在数量和质量之间取得平衡,阻碍了新意图簇的形成和预训练知识的有效迁移。为了缓解这一限制,我们提出了一种新颖的扩散加权图框架 DWGF 来捕获数据中固有的语义相似性和结构关系,从而实现更充分和可靠的监督信号。具体来说,对于每个样本,我们沿着由最近邻居引导的语义路径扩散邻域关系进行多跳,以区别地表征其局部结构。然后,我们对其正键进行采样,并根据语义相似性和局部结构对其进行加权,以进行对比学习。在推理过程中,我们进一步提出图平滑滤波器 GSF 来显式地利用结构关系来过滤簇边界上语义模糊样本中体现的高频噪声。大量实验表明,我们的方法在多个基准数据集的所有评估指标上都优于最先进的模型。 |

| Unnatural language processing: How do language models handle machine-generated prompts? Authors Corentin Kervadec, Francesca Franzon, Marco Baroni 语言模型提示优化研究表明,语义和语法良好的手动制作的提示通常优于自动生成的没有明显含义或句法结构的标记序列,包括来自模型嵌入空间的向量序列。我们使用机器生成的提示来探究模型如何响应不由自然语言表达组成的输入。我们研究了多个语义任务中不同大小的模型响应连续和离散机器生成的提示的行为,并将其与响应人类生成的自然语言提示的行为进行比较。即使产生相似的输出,机器生成的提示和人类的提示也会通过网络处理路径触发不同的响应模式,包括不同的困惑度、不同的注意力和输出熵分布以及不同的单元激活配置文件。 |

| Rosetta Stone at KSAA-RD Shared Task: A Hop From Language Modeling To Word--Definition Alignment Authors Ahmed ElBakry, Mohamed Gabr, Muhammad ElNokrashy, Badr AlKhamissi 反向词典是一种工具,使用户能够根据单词提供的定义、含义或描述来发现单词。这种技术在各种情况下都被证明是有价值的,可以帮助那些拥有对单词的描述但没有其身份的语言学习者,并使寻求精确术语的作家受益。这些场景通常概括了所谓的“舌尖 TOT”现象。在这项工作中,我们提出了阿拉伯语反向词典共享任务的获胜解决方案。此任务的重点是从阿拉伯单词的随附描述中导出阿拉伯单词的向量表示。共享任务包含两个不同的子任务,第一个子任务涉及阿拉伯语定义作为输入,而第二个子任务则采用英语定义。对于第一个子任务,我们的方法依赖于基于阿拉伯语 BERT 的微调模型的集合,预测给定定义的单词嵌入。最终表示是通过对集成中每个模型的输出嵌入进行平均而获得的。相比之下,第二个子任务最有效的解决方案是将英语测试定义翻译成阿拉伯语,并将其应用于最初为第一个子任务训练的微调模型。 |

| Generative Language Models Exhibit Social Identity Biases Authors Tiancheng Hu, Yara Kyrychenko, Steve Rathje, Nigel Collier, Sander van der Linden, Jon Roozenbeek 大型语言模型的普及引发了人们对这些模型可能向人类学习的偏见的担忧。在这项研究中,我们调查了 51 种大型语言模型中是否存在内群体团结和外群体敌意(社会科学中已知的基本社会偏见)。我们发现,几乎所有基础语言模型和一些指令微调模型在被提示完成句子(例如,我们是...)时都表现出明显的内群体积极和外群体消极偏见。将法学硕士生成的句子与互联网上的人类书面句子进行比较表明,这些模型表现出与人类文本相似甚至更高的偏见水平。为了调查这些偏见的根源,我们通过实验改变了模型在美国民主党和共和党分歧的背景下进行微调时所接触到的内群体正面或外群体负面句子的数量。这样做导致模型表现出内群体团结性显着增加,而外群体敌意则更大程度增加。此外,从微调数据中删除内群体积极句子或外群体消极句子或两者都会导致内群体团结和外群体敌意显着减少,这表明可以通过删除有偏见的训练数据来减少偏见。我们的研究结果表明,现代语言模型表现出基本的社会身份偏见,并且可以通过管理训练数据来减轻这种偏见。 |

| DALE: Generative Data Augmentation for Low-Resource Legal NLP Authors Sreyan Ghosh, Chandra Kiran Evuru, Sonal Kumar, S Ramaneswaran, S Sakshi, Utkarsh Tyagi, Dinesh Manocha 我们提出了 DALE,一种新颖且有效的生成数据增强框架,适用于低资源 LEgal NLP。 DALE 解决了现有框架在生成法律文档的有效数据增强方面所面临的挑战。法律语言具有专门的词汇和复杂的语义、形态和语法,无法从仅仅改写源句子的数据增强中受益。为了解决这个问题,基于编码器解码器语言模型构建的 DALE 在基于选择性屏蔽的新型无监督文本去噪目标上进行了预训练,我们的屏蔽策略利用模板化法律文档的领域特定语言特征来屏蔽文本的并置跨度。对这些跨度进行去噪有助于 DALE 获取有关法律概念、原则和语言用法的知识。因此,它发展了在新颖的背景下生成连贯且多样化的增强的能力。最后,DALE 执行条件生成,为低资源 Legal NLP 任务生成合成增强。我们在涵盖 6 个任务和 4 个低资源设置的 13 个数据集上展示了 DALE 的有效性。 |

| MindLLM: Pre-training Lightweight Large Language Model from Scratch, Evaluations and Domain Applications Authors Yizhe Yang, Huashan Sun, Jiawei Li, Runheng Liu, Yinghao Li, Yuhang Liu, Heyan Huang, Yang Gao 大型语言模型法学硕士在各种自然语言任务中表现出了卓越的表现,标志着通用人工智能的重大进步。虽然通过开发越来越大规模的模型来利用通用人工智能,但考虑到培训和部署法学硕士的高成本以及资源的稀缺性,可能还有另一个分支来开发更好地服务于某些领域的轻量级定制模型。在本文中,我们提出了 MindLLM,这是一系列新颖的双语轻量级大语言模型,从头开始训练,通过提供具有 13 亿和 30 亿参数的模型来减轻这种负担。全面介绍了大型模型开发过程中积累的经验,涵盖了数据构建、模型架构、评估和应用等过程的每个步骤。这些见解希望对学者和开发人员有价值。 MindLLM 在某些公共基准测试中的性能始终匹配或超越其他开源大型模型。我们还引入了专为小型模型量身定制的创新指令调整框架,以有效增强其功能。 |

| BLESS: Benchmarking Large Language Models on Sentence Simplification Authors Tannon Kew, Alison Chi, Laura V squez Rodr guez, Sweta Agrawal, Dennis Aumiller, Fernando Alva Manchego, Matthew Shardlow 我们提出了 BLESS,这是最新最先进的大型语言模型 LLM 在文本简化 TS 任务上的综合性能基准。我们研究了现成的法学硕士能够如何很好地解决这一具有挑战性的任务,在来自维基百科、新闻和医学不同领域的三个测试集上评估了总共 44 个模型,这些模型在大小、架构、预训练方法和可访问性方面都有所不同。拍摄设置。我们的分析考虑了一套自动指标以及对不同模型执行的常见编辑操作类型的大规模定量调查。此外,我们对模型输出的子集进行手动定性分析,以更好地衡量生成的简化的质量。我们的评估表明,最好的法学硕士尽管没有接受过 TS 培训,但其表现与最先进的 TS 基线相当。此外,我们发现某些法学硕士表现出更大范围和多样性的编辑操作。 |

| Learning From Free-Text Human Feedback -- Collect New Datasets Or Extend Existing Ones? Authors Dominic Petrak, Nafise Sadat Moosavi, Ye Tian, Nikolai Rozanov, Iryna Gurevych 从自由文本人类反馈中学习对于对话系统至关重要,但带注释的数据很少,而且通常只涵盖对话人工智能中已知错误类型的一小部分。合成对话生成方面的最新进展可用于通过必要的注释来增强现有对话数据集,而不是从头开始收集和注释新数据集。然而,为了评估这种努力的可行性,了解这些数据集中包含的自由文本人类反馈的类型和频率非常重要。在这项工作中,我们针对各种常用的对话数据集调查了这个问题,包括 MultiWoZ、SGD、BABI、PersonaChat、Wizards of Wikipedia 以及 Self Feeding Chatbot 的人类机器人分割。根据我们的观察,我们得出了用于在对话中注释自由文本人类反馈的新分类法,并研究了将此类数据包含在三种 SOTA 语言生成模型(包括 GPT 2、LLAMA 和 Flan T5)的响应生成中的影响。 |

| Do Differences in Values Influence Disagreements in Online Discussions? Authors Michiel van der Meer, Piek Vossen, Catholijn M. Jonker, Pradeep K. Murukannaiah 在线讨论中分歧很常见。在某些情况下,分歧可能会促进合作并提高讨论的质量。尽管存在识别分歧的方法,但文献中缺乏对影响分歧的因素的更深入的理解。我们研究了一个假设,即个人价值观的差异表明在线讨论中存在分歧。我们展示了如何使用最先进的模型来估计在线讨论中的价值,以及如何将估计值聚合到价值概况中。我们根据人工注释的协议标签评估估计价值概况。我们发现,价值观的差异与特定情况下的分歧相关。 |

| Integrating Language Models into Direct Speech Translation: An Inference-Time Solution to Control Gender Inflection Authors Dennis Fucci, Marco Gaido, Sara Papi, Mauro Cettolo, Matteo Negri, Luisa Bentivogli 在翻译涉及说话者的单词时,语音翻译 ST 系统不应诉诸默认的男性泛型,也不应依赖于潜在误导性的声音特征。相反,他们应该根据说话者的偏好来分配性别。现有的解决方案虽然有效,但在实践中几乎不可行,因为它们涉及对性别标记的 ST 数据进行专门的模型重新训练。为了克服这些限制,我们提出了第一个推理时间解决方案来控制 ST 中与说话者相关的性别变化。我们的方法部分用特定于性别的外部 LM 替换了 ST 解码器隐式学习的有偏见的内部语言模型 LM。在 en es fr it 上的实验表明,对于女性形式,我们的解决方案在性别准确度方面分别优于基本模型和最佳训练时间缓解策略高达 31.0 和 1.6 个点。 |

| Failures Pave the Way: Enhancing Large Language Models through Tuning-free Rule Accumulation Authors Zeyuan Yang, Peng Li, Yang Liu 大型语言模型法学硕士展示了令人印象深刻的表现。然而,由于无法捕捉样本之间的关系,这些被冻结的法学硕士不可避免地不断重复类似的错误。在这项工作中,我们提出了免调整规则累积 TRAN 框架,该框架指导法学硕士通过从以前的错误中学习来提高其表现。考虑到数据是顺序到达的,LLM会逐渐从错误的案例中积累规则,形成规则集合。然后,法学硕士会利用这些规则来避免在处理后续输入时犯类似的错误。此外,规则仍然独立于主要提示,无缝地补充了提示设计策略。 |

| RAPL: A Relation-Aware Prototype Learning Approach for Few-Shot Document-Level Relation Extraction Authors Shiao Meng, Xuming Hu, Aiwei Liu, Shu ang Li, Fukun Ma, Yawen Yang, Lijie Wen 当只有少数标记文档可用时,如何识别文档中实体之间的语义关系 少量文档级关系提取 FSDLRE 对于解决现实场景中普遍存在的数据稀缺问题至关重要。基于度量的元学习是 FSDLRE 广泛采用的有效框架,它构建用于分类的类原型。然而,现有的工作往往很难获得具有准确关系语义的类原型1为了构建目标关系类型的原型,它们聚合了持有该关系的所有实体对的表示,而这些实体对也可能持有其他关系,从而扰乱了原型。 2 他们在所有任务中都使用了一组通用 NOTA 原型,忽略了 NOTA 语义在具有不同目标关系类型的任务中的不同。在本文中,我们提出了一种用于 FSDLRE 的关系感知原型学习方法,以加强原型表示的关系语义。通过明智地利用关系描述和现实的 NOTA 实例作为指导,我们的方法有效地细化了关系原型并生成特定于任务的 NOTA 原型。 |

| Variator: Accelerating Pre-trained Models with Plug-and-Play Compression Modules Authors Chaojun Xiao, Yuqi Luo, Wenbin Zhang, Pengle Zhang, Xu Han, Yankai Lin, Zhengyan Zhang, Ruobing Xie, Zhiyuan Liu, Maosong Sun, Jie Zhou 预训练的语言模型 PLM 在 NLP 任务上取得了显着的成果,但代价是巨大的参数大小和随之而来的计算成本。在本文中,我们提出了 Variator,一种参数有效的加速方法,通过即插即用的压缩插件来提高计算效率。压缩插件旨在通过将多个隐藏向量压缩为一个来减少序列长度,并使用冻结的原始 PLM 进行训练。与将 PLM 压缩到更小的尺寸的传统模型加速方法不同,Variator 具有两个明显的优势 1 在实际应用中,我们的压缩插件的即插即用特性可以根据当前工作负载动态选择具有不同加速比的不同压缩插件。 2 压缩插件包含几个参数最少的紧凑神经网络层,可显着节省存储和内存开销,特别是在任务数量不断增加的场景中。我们在七个数据集上验证了 Variator 的有效性。实验结果表明,Variator 仅使用 0.9 个附加参数即可节省 53 的计算成本,性能下降小于 2 。 |

| Re-Temp: Relation-Aware Temporal Representation Learning for Temporal Knowledge Graph Completion Authors Kunze Wang, Soyeon Caren Han, Josiah Poon 外推设置下的时间知识图补全 TKGC 旨在从未来的事实中预测丢失的实体,提出了与现实世界预测问题更紧密结合的挑战。现有的研究主要使用应用于最近快照的顺序图神经网络来编码实体和关系。然而,这些方法往往忽略了根据查询中的实体相关关系跳过不相关快照的能力,并且忽视了显式时间信息的重要性。为了解决这个问题,我们提出了我们的模型,Re Temp Relation Aware Temporal Representation Learning,它利用显式时间嵌入作为输入,并在每个时间戳之后合并跳过信息流,以跳过不必要的信息进行预测。此外,我们引入了两阶段前向传播方法来防止信息泄漏。 |

| Ensemble of Task-Specific Language Models for Brain Encoding Authors Sanjai Kumaran, Arvindh Arun, Jerrin John 语言模型已被证明足够丰富,可以编码我们大脑中某些感兴趣区域的功能磁共振成像激活。之前的工作已经探索了从流行的自然语言处理任务中学习到的表征来进行迁移学习,以预测大脑反应。在我们的工作中,我们通过创建 10 种流行语言模型(2 个语法模型和 8 个语义模型)的集成模型来提高此类编码器的性能。 |

| Enhancing Biomedical Lay Summarisation with External Knowledge Graphs Authors Tomas Goldsack, Zhihao Zhang, Chen Tang, Carolina Scarton, Chenghua Lin 以前的自动外行摘要方法完全依赖于源文章,因为它是为技术受众(例如研究人员)编写的,不太可能明确定义所有技术概念或陈述与外行受众相关的所有背景信息。我们通过使用文章特定的知识图来增强 eLife(现有的生物医学外行总结数据集)来解决这个问题,每个知识图都包含相关生物医学概念的详细信息。使用自动评估和人工评估,我们系统地研究了将知识图合并到外行摘要模型中的三种不同方法的有效性,每种方法都针对编码器解码器模型架构的不同区域。 |

| Towards Automated Recipe Genre Classification using Semi-Supervised Learning Authors Nazmus Sakib, G. M. Shahariar, Md. Mohsinul Kabir, Md. Kamrul Hasan, Hasan Mahmud 分享烹饪食谱是交流烹饪想法和提供食物准备说明的好方法。然而,由于缺乏足够的标签数据,将在线找到的原始食谱分类为适当的食物类型可能具有挑战性。在这项研究中,我们提出了一个名为“分类、原型和注释的两百万个扩展 3A2M 烹饪食谱数据集”的数据集,其中包含 200 万个烹饪食谱,这些食谱标记在各自的类别中,并带有从食谱描述中提取的扩展命名实体。该数据集合包括各种特征,例如标题、NER、方向和扩展 NER,以及代表面包、饮料、非蔬菜、蔬菜、快餐、谷物、膳食、配菜和融合等类型的九个不同标签。提议的名为 3A2M 的管道扩展了命名实体识别 NER 列表的大小,以使用两个 NER 提取工具从配方方向解决缺失的命名实体,例如热量、时间或过程。 3A2M 数据集为各种具有挑战性的配方相关任务提供了全面的解决方案,包括分类、命名实体识别和配方生成。此外,我们还演示了传统的机器学习、深度学习和预训练的语言模型,将食谱分类为相应的流派,并取得了 98.6 的总体准确率。 |

| Creating a silver standard for patent simplification Authors Silvia Casola, Alberto Lavelli, Horacio Saggion 专利是法律文件,一方面旨在保护发明,另一方面使技术知识得以流通。它们的复杂风格混合了法律、技术和极其模糊的语言,使得人类和机器难以访问其内容,并对信息检索社区提出了巨大的挑战。本文提出了一种通过改写自动简化专利文本的方法。由于不存在域内并行简化数据,我们提出了一种自动生成专利句子大规模银标准的方法。为了获得候选者,我们使用通用的领域释义系统,但是该过程容易出错且难以控制。因此,我们将其与适当的过滤器配对,并构建一个更干净的语料库,可以成功地用于训练简化系统。 |

| Improving Biomedical Abstractive Summarisation with Knowledge Aggregation from Citation Papers Authors Chen Tang, Shun Wang, Tomas Goldsack, Chenghua Lin 来自生物医学文献的摘要具有明显的领域特定特征,包括专门的写作风格和生物医学术语,这需要对相关文献有深入的理解。因此,由于缺乏特定领域的背景知识,现有的语言模型很难生成与生物医学专家生成的技术摘要相当的技术摘要。本文旨在通过聚合源文章中引用的外部论文的知识来提高生物医学抽象概括中语言模型的性能。我们提出了一种新颖的基于注意力的引文聚合模型,该模型集成了引文论文中的特定领域知识,允许神经网络通过利用论文内容和引文论文中的相关知识来生成摘要。此外,我们构建并发布了一个大规模的生物医学总结数据集,作为我们研究的基础。 |

| Prevalence and prevention of large language model use in crowd work Authors Veniamin Veselovsky, Manoel Horta Ribeiro, Philip Cozzolino, Andrew Gordon, David Rothschild, Robert West 我们表明,大型语言模型法学硕士的使用在众包工作者中很普遍,并且有针对性的缓解策略可以显着减少但不能消除法学硕士的使用。在一项文本摘要任务中,工作人员没有以任何方式指导他们使用 LLM,估计 LLM 使用率约为 30 ,但通过要求工作人员不要使用 LLM 并提高使用它们的成本,该流行率减少了约一半,例如,通过禁用复制粘贴。二次分析可以进一步深入了解法学硕士的使用及其预防法学硕士的使用会产生高质量但同质的反应,这可能会损害与人类而不是模型行为相关的研究,并降低使用众包数据训练的未来模型。同时,防止使用法学硕士可能与获得高质量的答复相矛盾,例如,当要求工作人员不要使用法学硕士时,摘要中包含的包含基本信息的关键字较少。随着法学硕士的受欢迎程度或能力的提高,以及其使用规范的变化,我们的估计可能会发生变化。 |

| How Much Context Does My Attention-Based ASR System Need? Authors Robert Flynn, Anton Ragni 对于语音识别任务,在训练期间使用超过 30 秒的声学上下文并不常见,并且文献中对此进行了研究。在这项工作中,我们研究了缩放用于训练评估基于密集注意力的声学和语言模型的序列长度对语音识别性能的影响。在这些实验中,使用了大约 100,000 个伪标记 Spotify 播客的数据集,并探索了 5 秒到 1 小时的上下文长度。对长格式数据集 Earnings 22 和 Tedlium 的零样本评估表明,使用大约 80 秒的声学环境进行训练有好处,与有限的环境基线相比,相对提高了 14.9。 |

| Expression Syntax Information Bottleneck for Math Word Problems Authors Jing Xiong, Chengming Li, Min Yang, Xiping Hu, Bin Hu 数学应用题 MWP 旨在自动解决文本中给出的数学问题。以往的研究倾向于设计复杂的模型来捕获原文中的额外信息,从而使模型获得更全面的特征。在本文中,我们将注意力转向相反的方向,研究如何丢弃包含 MWP 虚假相关性的冗余特征。为此,我们设计了一种基于变分信息瓶颈的 MWP 表达式语法信息瓶颈方法,称为 ESIB,该方法提取表达式语法树的本质特征,同时过滤包含语法不相关特征的潜在特定冗余。 ESIB的核心思想是鼓励多个模型通过相互学习来针对同一问题的不同问题表示来预测相同的表达式语法树,从而捕获表达式语法树的一致信息并丢弃潜在的特定冗余。为了提高模型的泛化能力并生成更多样化的表达式,我们设计了自蒸馏损失以鼓励模型更多地依赖潜在空间中的表达式语法信息。两个大规模基准的实验结果表明,我们的模型不仅达到了最先进的结果,而且还生成了更多样化的解决方案。 |

| A Survey on Detection of LLMs-Generated Content Authors Xianjun Yang, Liangming Pan, Xuandong Zhao, Haifeng Chen, Linda Petzold, William Yang Wang, Wei Cheng ChatGPT 等高级大型语言模型法学硕士的不断发展的能力导致了合成内容生成的增加,对媒体、网络安全、公共话语和教育等多个领域产生了影响。因此,检测法学硕士生成内容的能力变得至关重要。我们的目标是提供现有检测策略和基准的详细概述,仔细研究它们的差异并确定该领域的关键挑战和前景,倡导更具适应性和鲁棒性的模型以提高检测准确性。我们还提出需要采取多方面的方法来防御各种攻击,以应对法学硕士快速发展的能力。据我们所知,这项工作是法学硕士时代第一个关于检测的全面调查。我们希望它能够提供对法学硕士生成内容检测的当前状况的广泛了解,为在合成内容日益占主导地位的时代努力维护数字信息完整性的研究人员和从业者提供指导参考。 |

| CoAnnotating: Uncertainty-Guided Work Allocation between Human and Large Language Models for Data Annotation Authors Minzhi Li, Taiwei Shi, Caleb Ziems, Min Yen Kan, Nancy F. Chen, Zhengyuan Liu, Diyi Yang 带注释的数据在自然语言处理 NLP 的训练模型和评估其性能方面发挥着至关重要的作用。鉴于大型语言模型法学硕士的最新发展,诸如 ChatGPT 之类的模型在许多文本注释任务上展示了零射击能力,可与人类注释者相媲美甚至超过。由于成本较低且可扩展性较高,此类法学硕士可以作为手动注释的替代方案。然而,有限的工作利用法学硕士作为补充注释者,也没有探索如何在人类和法学硕士之间最好地分配注释工作以实现质量和成本目标。我们提出了 CoAnnotating,这是一种大规模非结构化文本人类法学硕士联合注释的新范式。在此框架下,我们利用不确定性来估计法学硕士的注释能力。我们的实证研究表明,CoAnnotating 是根据不同数据集的结果分配工作的有效方法,与随机基线相比,性能提高了 21 倍。 |

| Career Path Prediction using Resume Representation Learning and Skill-based Matching Authors Jens Joris Decorte, Jeroen Van Hautte, Johannes Deleu, Chris Develder, Thomas Demeester 人们的工作适合工作满意度和表现的影响得到了广泛的认可,这突出了在职业生涯中适当的时间为工人提供下一步的重要性。这种预测职业下一步的任务被称为职业路径预测,并且具有多种应用,例如预防离职和内部工作流动。现有的职业路径预测方法依赖大量的私人职业历史数据来模拟工作头衔与公司之间的互动。我们建议利用简历中工作经验部分的未开发的文本描述。我们介绍了一个结构化数据集,其中包括2,164个匿名职业历史,并带有ESCO职业标签。基于此数据集,我们提出了一种新颖的表示学习方法,专为工作历史数据而设计。我们为职业路径预测开发了一个基于技能的模型和基于文本的模型,该模型分别在我们的数据集上实现了35.24和39.61召回10。 |

| Tips for making the most of 64-bit architectures in langage design, libraries or garbage collection Authors Beno t Sonntag UNISTRA , Dominique Colnet LORIA 如今已成为标准的 64 位架构提供了前所未有的低级编程可能性。地址寄存器的大小在计算历史上第一次远远超过了其总线的物理容量。在简要提醒与可用的 64 位相比较小的地址所提供的可能性之后,我们开发了三个具体示例如何使用这些寄存器的空位。在这些示例中,其中两个涉及新静态类型编程语言的库的实现。首先,多精度整数的实现,目的是提高性能计算速度和 RAM 节省都得到了提高。第二个示例侧重于库对 UTF 8 字符串的处理。这里的想法是通过忽略每个 UTF 8 字符的物理大小来使索引更容易。最后,第三个示例是 |

| Machine Translation for Nko: Tools, Corpora and Baseline Results Authors Moussa Koulako Bala Doumbouya, Baba Mamadi Dian , Solo Farabado Ciss , Djibrila Dian , Abdoulaye Sow, S r Moussa Doumbouya, Daouda Bangoura, Fod Moriba Bayo, Ibrahima Sory 2. Cond , Kalo Mory Dian , Chris Piech, Christopher Manning 目前,Nko 语言还没有可用的机器翻译系统,这种语言在多个西非国家有数千万人使用,具有重要的文化和教育价值。为了解决这个问题,我们提出了一套工具、资源和基线结果,旨在为 Nko 和目前没有足够大的并行文本语料库的其他语言开发可用的机器翻译系统。 1 Friallel 一种新颖的协作并行文本管理软件,通过基于复制编辑的工作流程整合质量控制。 2 FLoRes 200 和 NLLB Seed 语料库的扩展,包含 2,009 和 6,193 个高质量 Nko 翻译,同时还有 204 种和 40 种其他语言。 3 nicolingua 0005 包含 130,850 个平行片段的三语和双语语料库以及包含超过 300 万个 Nko 单词的单语语料库。 |

| MUSER: A Multi-View Similar Case Retrieval Dataset Authors Qingquan Li, Yiran Hu, Feng Yao, Chaojun Xiao, Zhiyuan Liu, Maosong Sun, Weixing Shen 类似案件检索SCR是具有代表性的法律人工智能应用,对于促进司法公正发挥着举足轻重的作用。然而,现有的SCR数据集在判断案件之间的相似性时仅关注事实描述部分,而忽略了其他有价值的部分,例如可以提供背后有洞察力的推理过程的法院意见。此外,案件相似度通常仅通过事实描述的文本语义来衡量,这可能无法从法律知识的角度捕捉法律案件的全部复杂性。在这项工作中,我们提出了 MUSER,一个基于多视图相似性度量和具有句子级法律要素注释的综合法律要素的相似案例检索数据集。具体来说,我们选择法律事实、争议焦点和法律法规三个视角,为每个视角构建全面、结构化的法律要素标签图式,以实现对案件相似性的准确且有知识的评估。构建的数据集源自中国民事案件,包含 100 个查询案例和 4,024 个候选案例。我们实现了多种用于法律要素预测的文本分类算法以及用于在 MUSER 上检索类似案例的各种检索方法。实验结果表明,纳入法律元素可以有利于 SCR 模型的性能,但仍需要进一步努力来解决 MUSER 提出的剩余挑战。 |

| Retrieval-based Knowledge Transfer: An Effective Approach for Extreme Large Language Model Compression Authors Jiduan Liu, Jiahao Liu, Qifan Wang, Jingang Wang, Xunliang Cai, Dongyan Zhao, Ran Lucien Wang, Rui Yan 大规模预训练语言模型 法学硕士在各种自然语言处理 NLP 任务中表现出了卓越的性能。然而,这些模型的巨大规模给它们在现实世界应用中的部署带来了巨大的挑战。虽然已经提出了许多模型压缩技术,但当模型规模存在显着差距时,大多数技术都不太适合实现极端模型压缩。在本文中,我们介绍了一种称为基于检索的知识转移 RetriKT 的新颖压缩范例,它有效地将 LLM 的知识转移到极小规模的模型,例如 1 。特别是,我们的方法从法学硕士中提取知识来构建知识库,小规模模型可以从中检索相关信息并利用它进行有效的推理。为了提高模型的质量,采用了软提示调整和近端策略优化 PPO 强化学习技术。针对 SuperGLUE 和 GLUE 基准的低资源任务进行了大量实验。 |

| ScanDL: A Diffusion Model for Generating Synthetic Scanpaths on Texts Authors Lena S. Bolliger, David R. Reich, Patrick Haller, Deborah N. Jakobi, Paul Prasse, Lena A. J ger 阅读中的眼动在研究人类语言处理认知机制的心理语言学研究中发挥着至关重要的作用。最近,眼球运动和认知之间的紧密耦合也被用于与语言相关的机器学习任务,例如语言模型的可解释性、增强和预训练,以及读者和文本特定属性的推断。然而,眼动数据的稀缺及其在应用时的不可用给这方面的研究带来了重大挑战。最初,这个问题是通过利用认知模型来合成眼动数据来解决的。然而,仅出于生成类似人类的扫描路径的目的,纯数据驱动的基于机器学习的方法已被证明更合适。随着扩散过程适应离散数据的最新进展,我们提出了 ScanDL,一种新颖的离散序列到序列扩散模型,可在文本上生成合成扫描路径。通过利用预先训练的单词表示并联合嵌入刺激文本和注视序列,我们的模型捕获了两个输入之间的多模态交互。我们在数据集内和跨数据集评估 ScanDL,并证明它显着优于最先进的扫描路径生成方法。最后,我们提供了广泛的心理语言学分析,强调了该模型表现出类似人类阅读行为的能力。 |

| Multimodal Representations for Teacher-Guided Compositional Visual Reasoning Authors Wafa Aissa CEDRIC VERTIGO , Marin Ferecatu CEDRIC VERTIGO , Michel Crucianu CEDRIC VERTIGO 神经模块网络 NMN 是一种引人注目的视觉问答方法,能够将问题转化为由一系列推理子任务组成的程序,这些子任务在图像上顺序执行以产生答案。与集成模型相比,NMN 提供了增强的可解释性,可以更好地理解底层推理过程。为了提高 NMN 的有效性,我们建议利用大规模交叉模态编码器获得的特征。此外,当前 NMN 的训练方法依赖于将模块输出传播到后续模块,导致预测误差累积并产生错误答案。为了缓解这个问题,我们引入了一种涉及预定教师指导的 NMN 学习策略。最初,该模型完全由真实中间输出引导,但随着训练的进展逐渐过渡到自主行为。 |

| CONTRASTE: Supervised Contrastive Pre-training With Aspect-based Prompts For Aspect Sentiment Triplet Extraction Authors Rajdeep Mukherjee, Nithish Kannen, Saurabh Kumar Pandey, Pawan Goyal Aspect Sentiment Triplet Extraction ASTE 的现有工作明确专注于为该任务开发更有效的微调技术。相反,我们的动机是提出一种通用方法,可以同时提高多个 ABSA 任务的下游性能。为此,我们提出了 CONTRASTE,这是一种利用对比学习来提高 ASTE 性能的新颖预训练策略。虽然我们主要关注 ASTE,但我们也展示了我们提出的技术在其他 ABSA 任务(例如 ACOS、TASD 和 AESC)上的优势。给定一个句子及其相关的方面、观点、情感三元组,首先,我们设计基于方面的提示,并掩盖相应的情感。然后,我们通过对解码器生成的屏蔽术语的方面感知情感表示应用对比学习来预训练编码器解码器模型。为了微调由此获得的模型权重,我们提出了一种新颖的多任务方法,其中基本编码器解码器模型与两个互补模块(基于标记的意见项检测器和基于回归的三元组计数估计器)相结合。 |

| POE: Process of Elimination for Multiple Choice Reasoning Authors Chenkai Ma, Xinya Du 语言模型 LM 能够在上下文学习中进行多项选择推理任务,但这些任务中的选项是平等对待的。由于人类通常在选择最终正确答案之前首先消除错误的选项,因此我们认为类似的两步策略可以使 LM 更好地完成这些任务。为此,我们提出了消除 POE 的过程,这是一种两步评分方法。第一步,POE 对每个选项进行评分,并消除看似错误的选项。第二步,POE屏蔽这些错误的选项,并从剩余的选项中做出最终的预测。 8 个推理任务的零样本实验说明了 POE 的有效性,下面的分析发现我们的方法在逻辑推理任务上特别有效。 |

| Natural Language Processing for Drug Discovery Knowledge Graphs: promises and pitfalls Authors J. Charles G. Jeynes, Tim James, Matthew Corney 构建和分析知识图谱以帮助药物发现是一个热门研究领域。 KG 的一个显着特征是它们能够以有助于发现连接的格式组合许多异构数据源。知识图谱的实用性已在药物再利用等领域得到体现,通过手动探索和数据建模获得见解。在本文中,我们讨论使用自然语言处理 NLP 来挖掘非结构化文本(通常来自科学文献作为知识图谱的数据源)的前景和陷阱。这借鉴了我们最初解析结构化数据源(例如 ChEMBL)作为知识图谱内数据基础的经验,然后使用 NLP 丰富或扩展它们。 NLP 对知识图谱的基本承诺是从数百万份文档中自动提取数据,而仅靠人工管理几乎不可能完成这项任务。 |

| Visually Grounded Continual Language Learning with Selective Specialization Authors Kyra Ahrens, Lennart Bengtson, Jae Hee Lee, Stefan Wermter 在视觉世界中行动的人工智能体的一个理想特征是不断学习一系列语言信息任务,同时在充分专业化每项任务和建立用于迁移的通用知识之间取得平衡。选择性专业化,即仔细选择模型组件以专门从事每项任务,是一种控制这种权衡的策略。然而,选择策略的设计需要深入了解每个模型组件在学习相当专业或可概括的表示中的作用,这在当前研究中造成了空白。因此,我们这项工作的目的是对基于视觉的持续语言学习的选择策略进行广泛的分析。由于缺乏适合此目的的基准,我们引入了两个新颖的诊断数据集,它们为彻底的模型分析提供了足够的控制和灵活性。我们评估模块专业化策略的各种启发式方法以及两种不同类型模型架构的可量化度量。最后,我们根据我们的分析设计了概念上简单的方法,其性能优于常见的持续学习基线。 |

| MuLMS: A Multi-Layer Annotated Text Corpus for Information Extraction in the Materials Science Domain Authors Timo Pierre Schrader, Matteo Finco, Stefan Gr newald, Felix Hildebrand, Annemarie Friedrich 跟踪研究领域的所有相关最新出版物和实验结果是一项具有挑战性的任务。先前的工作已经证明了信息提取模型在各个科学领域的有效性。最近,针对尚未得到充分研究的材料科学领域发布了几个数据集。然而,这些数据集侧重于子问题,例如解析合成程序或子域,例如固体氧化物燃料电池。在这篇资源论文中,我们介绍了 MuLMS,这是一个包含 50 篇开放获取文章的新数据集,涵盖材料科学的七个子领域。该语料库已由领域专家进行了注释,包括从命名实体到关系到框架结构的多个层次。 |

| TCRA-LLM: Token Compression Retrieval Augmented Large Language Model for Inference Cost Reduction Authors Junyi Liu, Liangzhi Li, Tong Xiang, Bowen Wang, Yiming Qian 自从 ChatGPT 发布其 API 供公众使用以来,基于商业大型语言模型 LLM 构建的应用程序数量呈指数级增长。此类模型的一种流行用法是利用其上下文学习能力,并根据用户查询生成响应,利用通过检索增强获得的知识。部署商业检索增强 LLM 的一个问题是由于额外检索的上下文而导致的成本,这大大增加了 LLM 的输入令牌大小。为了缓解这个问题,我们提出了一种令牌压缩方案,其中包括摘要压缩和语义压缩两种方法。第一种方法应用基于 T5 的模型,该模型通过使用包含不同长度的样本的自指令生成的数据集进行微调,并通过汇总来减少标记大小。第二种方法通过删除对语义影响较小的单词来进一步压缩标记大小。为了充分评估所提出方法的有效性,我们提出并利用了一个名为“食品推荐数据库 FRDB”的数据集,重点关注怀孕期间或婴儿期间女性的食品推荐。我们的摘要压缩可以减少 65 的检索标记大小,并进一步提高 0.3 的准确性语义压缩提供了一种更灵活的方法来权衡标记大小与性能,为此我们可以将标记大小减少 20,而准确率仅下降 1.6 |

| Unveiling Multilinguality in Transformer Models: Exploring Language Specificity in Feed-Forward Networks Authors Sunit Bhattacharya, Ondrej Bojar 最近的研究表明,Transformers 中的前馈模块可以被视为键值存储器的集合,其中键学习根据训练示例从输入中捕获特定模式。然后,这些值结合密钥存储器的输出来生成关于下一个标记的预测。这导致了一个增量的预测过程,逐渐收敛到输出层附近的最终令牌选择。这个有趣的观点提出了关于多语言模型如何利用这种机制的问题。具体来说,对于在两种或多种语言上训练的自回归模型,跨层的所有神经元对所有语言的响应是否相同?我们的假设集中在这样的概念上:在预训练期间,某些模型参数学习强大的语言特定特征,而其他模型参数则学习更多与语言无关的共享特征语言特征。为了验证这一点,我们利用模型最初预训练的两种语言的并行语料库进行实验。 |

| Improving Language Models Meaning Understanding and Consistency by Learning Conceptual Roles from Dictionary Authors Myeongjun Erik Jang, Thomas Lukasiewicz 当代预训练语言模型 PLM 的非人类行为是破坏其可信度的主要原因。这种错误行为的一个显着现象是生成不一致的预测,这会产生逻辑上矛盾的结果,例如为传递相同含义的文本生成不同的预测或违反逻辑属性。以前的研究利用数据增强或实现专门的损失函数来缓解这个问题。然而,它们的使用受到限制,因为它们会消耗大型 PLM 的昂贵培训资源,并且只能处理某种一致性类型。为此,我们提出了一种实用方法,通过从根本上提高 PLM 的意义意识来缓解不一致的行为问题。基于概念角色理论,我们的方法允许 PLM 通过从字典中的单词定义对中学习概念之间的精确相互关系来捕获准确的含义。接下来,我们提出了一种有效的参数集成技术,该技术仅更新一些附加参数,以将学习到的相互关系与 PLM 预先训练的知识相结合。 |

| SteloCoder: a Decoder-Only LLM for Multi-Language to Python Code Translation Authors Jialing Pan, Adrien Sad , Jin Kim, Eric Soriano, Guillem Sole, Sylvain Flamant 随着最近对大型语言模型 LLM 的关注,StarCoder Li et al., 2023 和 Code Llama Rozi re et al., 2023 在代码生成方面都表现出了卓越的性能。然而,仍然需要通过有效的训练技术来改进代码翻译功能。针对这一点,我们推出了 SteloCoder,这是一个基于 StarCoder 的仅解码器的 LLM,专为多编程语言到 Python 代码翻译而设计。特别是,SteloCoder 无需指定输入编程语言即可实现 C、C、JavaScript、Java 或 PHP 到 Python 代码的转换。我们通过结合专家混合 MoE 技术修改了 StarCoder 模型架构,该技术具有五名专家和用于多任务处理的门控网络。专家通过StarCoder微调获得。具体来说,我们使用低秩自适应方法 LoRA 技术,将每个 Expert 大小限制为 StarCoder 参数数量的 0.06。同时,为了提高时间上的训练效率,我们采用课程学习策略,利用自指导数据进行高效微调。因此,每位专家只需 6 小时即可在一个 80Gb A100 HBM 上进行培训。通过在 XLCoST 数据集上的实验,SteloCoder 在多编程语言到 Python 的翻译中获得了平均 73.76 的 CodeBLEU 分数,比排行榜上的最高表现至少高出了 3.5 分。这一成就归功于以 StarCoder 为骨干的 45M 额外参数以及在 80GB A100 HBM 上进行的 32 小时有效训练。 |

| MarkQA: A large scale KBQA dataset with numerical reasoning Authors Xiang Huang, Sitao Cheng, Yuheng Bao, Shanshan Huang, Yuzhong Qu 虽然基于知识库 KBQA 的问答在解决事实问题方面已经取得了进展,但带有数字推理的 KBQA 仍然相对未经探索。在本文中,我们关注 KBQA 中的复杂数值推理,并提出了一个新任务 NR KBQA,它需要执行多跳推理和数值推理的能力。我们设计了一种名为 PyQL 的 Python 格式的逻辑形式来表示数值推理问题的推理过程。为了促进 NR KBQA 的开发,我们提出了一个名为 MarkQA 的大型数据集,它是从一小组种子自动构建的。 MarkQA 中的每个问题都配备了相应的 SPARQL 查询,以及 QDMR 格式和 PyQL 程序中的逐步推理过程。 |

| Fighting Fire with Fire: The Dual Role of LLMs in Crafting and Detecting Elusive Disinformation Authors Jason Lucas, Adaku Uchendu, Michiharu Yamashita, Jooyoung Lee, Shaurya Rohatgi, Dongwon Lee 最近,大型语言模型法学硕士的普遍存在和破坏性影响引起了人们对其可能被滥用的担忧,即产生大规模有害和误导性内容。为了应对法学硕士的这种新风险,我们提出了一种新颖的以火攻毒 F3 策略,该策略利用现代法学硕士的生成和紧急推理能力来对抗人类书面和法学硕士生成的虚假信息。首先,我们利用 GPT 3.5 Turbo 分别通过基于释义和基于扰动的前缀样式提示来合成真实和欺骗性的 LLM 生成的内容。其次,我们应用上下文语义推理技术中的零镜头和完形填空风格的提示来辨别真实的帖子和新闻文章。在我们广泛的实验中,我们观察到 GPT 3.5 Turbo 在分布数据集和分布外数据集上都具有零样本优势,其中 GPT 3.5 Turbo 始终达到 68 72 的准确率,这与之前定制和微调的虚假信息检测器中观察到的下降不同。 |

| A Joint Matrix Factorization Analysis of Multilingual Representations Authors Zheng Zhao, Yftah Ziser, Bonnie Webber, Shay B. Cohen 我们提出了一种基于联合矩阵分解的分析工具,用于比较多语言和单语言模型的潜在表示。作为探测的替代方案,该工具允许我们以联合方式分析多组表示。使用这个工具,我们研究形态句法特征在多语言预训练模型学习的表示中反映的程度和方式。我们对超过 33 种语言和 17 个形态句法类别进行了大规模的实证研究。我们的研究结果表明,上层和下层的形态句法信息编码存在差异,并且类别特定的差异受到语言属性的影响。分解输出的层次聚类产生与语言学家手动制作的系统发育树相关的树结构。此外,我们发现分解输出与不同跨语言任务中观察到的表现表现出很强的相关性。 |

| TRAMS: Training-free Memory Selection for Long-range Language Modeling Authors Haofei Yu, Cunxiang wang, Yue Zhang, Wei Bi Transformer 架构对于众多 AI 模型至关重要,但它在远程语言建模方面仍然面临挑战。尽管已经设计了几种特定的 Transformer 架构来解决长程依赖性问题,但 Transformer XL 等现有方法仍受到高比例无效内存的困扰。在这项研究中,我们提出了一种即插即用策略,称为“TRAining free Memory Selection TRAMS”,它根据一个简单的指标选择参与注意力计算的令牌。这种策略允许我们保留当前查询中可能具有高注意力分数的标记,并忽略其他标记。 |

| NuTrea: Neural Tree Search for Context-guided Multi-hop KGQA Authors Hyeong Kyu Choi, Seunghun Lee, Jaewon Chu, Hyunwoo J. Kim 多跳知识图问答 KGQA 是一项涉及从知识图 KG 中检索节点以回答自然语言问题的任务。最近基于 GNN 的方法将此任务表述为 KG 路径搜索问题,其中消息按顺序从种子节点传播到答案节点。然而,这些消息是面向过去的,并且没有考虑完整的 KG 上下文。更糟糕的是,KG 节点通常代表专有名词实体,有时会被加密,在路径选择时无法提供信息。为了解决这些问题,我们提出了神经树搜索 NuTrea,这是一种基于树搜索的 GNN 模型,它结合了更广泛的 KG 上下文。我们的模型采用消息传递方案来探测未到达的子树区域以增强面向过去的嵌入。此外,我们引入了关系频率逆实体频率 RF IEF 节点嵌入,该嵌入考虑了全局知识图谱上下文,以更好地表征不明确的知识图谱节点。我们的方法的总体有效性通过对三个主要多跳 KGQA 基准数据集的实验得到证明,并且我们的广泛分析进一步验证了其表现力和鲁棒性。总的来说,NuTrea 提供了一种强大的手段来用复杂的自然语言问题查询知识图谱。 |

| CRaSh: Clustering, Removing, and Sharing Enhance Fine-tuning without Full Large Language Model Authors Kaiyan Zhang, Ning Ding, Biqing Qi, Xuekai Zhu, Xinwei Long, Bowen Zhou 指令调优最近被认为是调整大型语言模型法学硕士以增强其跨各种任务的泛化能力的有效方法。然而,当使用私人教学数据调整可公开访问的集中式法学硕士时,隐私问题是不可避免的。虽然在模型之间直接传输参数化模块是解决此问题的一种可行方法,但其含义和有效性需要进一步探索。本文重点介绍 Offsite Tuning OFT,这是一种在集中式 LLM 和下游仿真器之间传输变压器块的代表性技术。鉴于对 OFT 底层机制的了解有限,我们从表征和功能相似性的角度对 LLM 进行了实证分析。有趣的是,我们的研究结果揭示了法学硕士各层内独特的模块化结构,这种结构似乎随着模型规模的扩大而出现。同时,我们注意到跨层的表示和中间预测存在微妙但可能重大的变化。受这些观察的启发,我们提出了 CRaSh,涉及聚类、删除和共享,这是一种无需培训的策略,可以从法学硕士中获得改进的模拟器。 CRaSh 显着提高了具有数十亿参数的 OFT 的性能。此外,我们通过损失景观的视角研究了在有或没有完整模型的情况下进行微调所产生的最佳解决方案。我们的研究结果表明,同一盆地的这些最优值之间存在线性连通性,从而突出了 CRaSh 和 OFT 的有效性。 |

| Continual Event Extraction with Semantic Confusion Rectification Authors Zitao Wang, Xinyi Wang, Wei Hu 我们研究连续事件提取,旨在提取不断出现的事件信息,同时避免遗忘。我们观察到事件类型的语义混淆源于同一文本的注释随着时间的推移而更新。事件类型之间的不平衡甚至加剧了这个问题。本文提出了一种具有语义混淆纠正功能的新型连续事件提取模型。我们为每个句子标记伪标签以减轻语义混乱。我们在当前模型和以前的模型之间转移关键知识,以增强对事件类型的理解。此外,我们鼓励模型通过利用其他关联类型来关注长尾事件类型的语义。 |

| Interpreting Answers to Yes-No Questions in User-Generated Content Authors Shivam Mathur, Keun Hee Park, Dhivya Chinnappa, Saketh Kotamraju, Eduardo Blanco 解释社交媒体中是非问题的答案很困难。是和否关键字并不常见,并且包含这些关键字的少数答案很少会被解释为关键字所建议的内容。在本文中,我们提出了一个包含来自 Twitter 的 4,442 个是非问题答案对的新语料库。我们讨论解释为是或否的答案以及解释未知的答案的语言特征。 |

| K-HATERS: A Hate Speech Detection Corpus in Korean with Target-Specific Ratings Authors Chaewon Park, Soohwan Kim, Kyubyong Park, Kunwoo Park 人们提出了许多数据集来打击在线仇恨的传播。尽管做出了这些努力,但这些资源大部分都是以英语为中心的,主要关注公开形式的仇恨。这一研究空白要求开发多种语言的高质量语料库,其中还包含更微妙的仇恨表达。本研究引入了 K HATERS,这是一个用于韩语仇恨言论检测的新语料库,包含大约 192K 条具有目标特定攻击性评级的新闻评论。该资源是韩语中最大的攻击性语言语料库,并且是第一个提供三点李克特量表的目标特定评级的资源,能够检测韩语中不同程度的攻击性的仇恨表达。我们进行的实验显示了所提出的语料库的有效性,包括与现有数据集的比较。此外,为了解决人类注释中潜在的噪音和偏见,我们探索了一种采用认知反射测试的新想法,该测试广泛应用于社会科学中,用于评估个人的认知能力,作为标签质量的代理。研究结果表明,来自测试分数最低的个体的注释往往会产生对特定目标群体做出有偏见的预测并且不太准确的检测模型。本研究为仇恨言论检测和资源建设的NLP研究做出了贡献。 |

| What Makes it Ok to Set a Fire? Iterative Self-distillation of Contexts and Rationales for Disambiguating Defeasible Social and Moral Situations Authors Kavel Rao, Liwei Jiang, Valentina Pyatkin, Yuling Gu, Niket Tandon, Nouha Dziri, Faeze Brahman, Yejin Choi 道德或伦理判断在很大程度上依赖于它们发生的具体背景。 |

| Beyond Sentiment: Leveraging Topic Metrics for Political Stance Classification Authors Weihong Qi 情感分析因仅捕捉语料库的整体基调而受到广泛批评,无法准确反映文本中的潜在结构和政治立场。本研究引入了主题指标,即从提取的主题转换而来的虚拟变量,作为立场分类中情绪指标的替代和补充。通过使用 Bestvater 和 Monroe 2023 确定的三个数据集,本研究证明了 BERTopic 在提取连贯主题方面的熟练程度以及主题指标在立场分类中的有效性。实验结果表明,与早期政治科学研究中流行的狄利克雷分配 LDA 和非负矩阵分解 NMF 等传统方法相比,BERTopic 将一致性分数提高了 17.07 至 54.20。此外,我们的结果表明,在立场分类中,主题指标优于情绪指标,性能提高了 18.95 之多。我们的研究结果表明,主题指标对于立场和情绪相关性较弱的上下文丰富的文本和语料库特别有效。 |

| FANToM: A Benchmark for Stress-testing Machine Theory of Mind in Interactions Authors Hyunwoo Kim, Melanie Sclar, Xuhui Zhou, Ronan Le Bras, Gunhee Kim, Yejin Choi, Maarten Sap 心智理论 ToM 评估目前侧重于使用本质上缺乏交互性的被动叙述来测试模型。我们引入了 FANToM,这是一个新的基准测试,旨在通过问答在信息不对称的对话环境中对 ToM 进行压力测试。我们的基准借鉴了心理学的重要理论要求以及评估大型语言模型法学硕士时必要的实证考虑。特别是,我们提出了多种类型的问题,这些问题需要相同的基本推理来识别法学硕士中对 ToM 能力的虚幻或错误感觉。 |

| Let the Pretrained Language Models "Imagine" for Short Texts Topic Modeling Authors Pritom Saha Akash, Jie Huang, Kevin Chen Chuan Chang 主题模型是发现文档集合中潜在语义的引人注目的方法之一。然而,它假设文档具有足够的共现信息才能有效。然而,在短文本中,共现信息很少,这导致文档表示中的特征稀疏。因此,现有的概率或神经主题模型大多无法从中挖掘模式来生成连贯的主题。在本文中,我们采用一种新的短文本主题建模方法,通过使用现有的预训练语言模型 PLM 将短文本扩展为更长的序列来解决数据稀疏问题。此外,我们提供了一个简单的解决方案,扩展了神经主题模型,以减少 PLM 中主题文本生成的噪声影响。我们观察到我们的模型可以显着提高短文本主题建模的性能。 |

| Mind the Gap Between Conversations for Improved Long-Term Dialogue Generation Authors Qiang Zhang, Jason Naradowsky, Yusuke Miyao 知道如何随着时间的推移结束和恢复对话是沟通的自然组成部分,允许讨论持续数周、数月或数年。对话之间间隙的持续时间决定了哪些主题是相关的以及要问哪些问题,并且没有明确模拟时间的对话系统可能会生成不自然的响应。在这项工作中,我们探索了让对话模型感知时间的想法,并提出了 GapChat,这是一个多会话对话数据集,其中每个会话之间的时间各不相同。虽然数据集是实时构建的,但模拟了说话者生活中事件的进展,以便创建长时间跨度内发生的真实对话。我们向模型公开时间信息,并比较时间和事件进度的不同表示。 |

| GPT-4 as an Effective Zero-Shot Evaluator for Scientific Figure Captions Authors Ting Yao Hsu, Chieh Yang Huang, Ryan Rossi, Sungchul Kim, C. Lee Giles, Ting Hao K. Huang 人们对为科学数据生成说明文字的系统越来越感兴趣。然而,评估这些系统的输出提出了重大挑战。人工评估需要学术专业知识并且成本高昂,而自动评估通常依赖于低质量的作者书面说明。本文研究了使用大型语言模型法学硕士作为评估图形标题的一种经济有效、无参考的方法。我们首先构建了 SCICAP EVAL,这是一个人类评估数据集,其中包含对 600 个 arXiv 图形的 3,600 个科学图形标题(包括原始的和机器制作的)的人类判断。然后,我们提示 GPT 4 和 GPT 3 等法学硕士根据每个标题帮助读者理解的潜力,并考虑到相关上下文(例如图中提到的段落),给每个标题打 1 到 6 分。结果表明,用作零样本评估器的 GPT 4 优于所有其他模型,甚至超过了计算机科学和信息学本科生的评估,与博士生的 Kendall 相关性得分为 0.401。 |

| "One-size-fits-all"? Observations and Expectations of NLG Systems Across Identity-Related Language Features Authors Li Lucy, Su Lin Blodgett, Milad Shokouhi, Hanna Wallach, Alexandra Olteanu 关于什么构成适当的 NLG 系统行为的公平相关假设范围很广,从不变性(系统预计对社会群体做出相同的反应)到适应(系统之间的反应应该有所不同)。我们设计并进行了五个案例研究,其中我们扰乱了 NLG 系统输入中与身份相关的不同类型的语言特征名称、角色、位置、方言和风格,以阐明不变性和适应性之间的紧张关系。我们概述了人们对系统行为的期望,以及这两种截然不同但普遍持有的假设的表面潜在警告。我们发现,适应的动机包括社会规范、文化差异、特征特定信息,而不变性的适应动机包括支持规定主义的观点,认为适应对于 NLG 系统来说是不必要的或太困难而无法适当地进行,并对错误的假设保持警惕。 |

| Irreducible Curriculum for Language Model Pretraining Authors Simin Fan, Martin Jaggi 用于训练大型语言模型的自动数据选择和课程设计具有挑战性,只有少数现有方法比标准训练有所改进。此外,当前的方案侧重于领域级别的选择,忽略了每个单独训练点的更细粒度的贡献。在大型语言模型上应用传统的数据点选择方法很困难,大多数在线批量选择方法执行两次前向或后向传递,这会给大规模模型带来相当大的额外成本。为了减轻这些障碍,我们提出了不可约课程作为语言模型预训练的课程学习算法,它优先考虑具有较高可学习性的样本。具体来说,为了避免过高的额外计算开销,我们使用小规模代理模型模拟沿主模型训练轨迹的样本损失。我们在 RedPajama 1B 数据集上的实验表明,与随机统一基线和反课程策略相比,所有 7 个领域的验证困惑度均得到了持续改善。 |

| GD-COMET: A Geo-Diverse Commonsense Inference Model Authors Mehar Bhatia, Vered Shwartz 随着人工智能越来越融入日常生活,设计人工智能系统来为来自不同背景的用户提供文化意识变得至关重要。在本文中,我们提出了 GD COMET,这是 COMET 常识推理模型的地理多样化版本。 GD COMET 超越了西方常识知识,能够产生与广泛文化相关的推论。我们通过跨 5 种不同文化的综合人类评估以及对地理多样化任务的外部评估来证明 GD COMET 的有效性。 |

| EpiK-Eval: Evaluation for Language Models as Epistemic Models Authors Gabriele Prato, Jerry Huang, Prasannna Parthasarathi, Shagun Sodhani, Sarath Chandar 在人工智能时代,大型语言模型法学硕士的作用变得越来越重要。尽管它们越来越流行,但它们整合来自不同培训文档的知识的能力(在许多应用中至关重要的能力)仍有待探索。本文提出了第一项研究,检验法学硕士在其参数空间内有效组合此类信息的能力。我们推出 EpiK Eval,这是一种新颖的问答基准,旨在评估法学硕士根据分段叙述制定连贯一致的知识表示的能力。对各种法学硕士的评估揭示了该领域的重大弱点。我们认为,这些缺陷源于现行培训目标的本质。因此,我们主张改进知识整合方法,因为它具有显着提高整体效率和绩效的潜力。这项研究的结果为开发更稳健、更可靠的法学硕士提供了见解。 |

| Why LLMs Hallucinate, and How to Get (Evidential) Closure: Perceptual, Intensional, and Extensional Learning for Faithful Natural Language Generation Authors Adam Bouyamourn 我们表明法学硕士产生幻觉是因为他们的输出并不局限于与他们有证据的主张同义,我们称之为证据终结的条件。关于句子真假的信息在标准神经概率语言模型设置中没有被统计识别,因此不能以生成新字符串为条件。然后,我们展示如何限制法学硕士产生满足证据封闭的输出。多模态法学硕士必须了解外部世界的感知学习,它必须学习从字符串到世界状态的映射,外延学习,并且为了在超越证据体进行概括时实现流畅性,它必须学习从字符串到同义词的映射,即内涵学习。单峰法学硕士的输出必须与经过验证的证据集中的字符串同义。 |

| Specialist or Generalist? Instruction Tuning for Specific NLP Tasks Authors Chufan Shi, Yixuan Su, Cheng Yang, Yujiu Yang, Deng Cai 大型语言模型法学硕士同时执行各种自然语言处理 NLP 任务的潜力一直是广泛研究的主题。尽管指令调优已被证明是将 LLM 转换为此类通用模型的一种数据有效方法,但其性能仍然落后于专门针对特定任务训练的专业模型。在本文中,我们研究了合并广泛覆盖的通才指令调整是否有助于构建专业模型。我们假设其功效取决于任务的特殊性和技能要求。我们的实验评估了具有不同覆盖级别的四个目标任务,表明当任务覆盖范围较广时,集成通用指令调整可以持续增强模型性能。当特定于任务的训练数据量有限时,这种效果尤其明显。对侧重于不同能力的三个目标任务的进一步研究表明,通才指令调整可以提高理解和推理能力。然而,对于需要事实知识的任务,包含幻觉信息的通才数据可能会对模型的性能产生负面影响。总的来说,我们的工作为开发具有一般指令调整的专业模型提供了系统指南。 |

| Hallucination Detection for Grounded Instruction Generation Authors Lingjun Zhao, Khanh Nguyen, Hal Daum III 我们研究生成指令来指导人类在模拟居住环境中导航的问题。当前模型的一个主要问题是幻觉,它们生成对动作或对象的引用,这些动作或对象与人类追随者沿着所描述的路径执行或遇到的内容不一致。我们开发了一种模型,通过采用在大型图像文本对语料库上预先训练的模型,并通过对比损失对其进行微调,将正确的指令与包含合成幻觉的指令分开。 |

| Exploring the Potential of Large Language Models in Generating Code-Tracing Questions for Introductory Programming Courses Authors Aysa Xuemo Fan, Ranran Haoran Zhang, Luc Paquette, Rui Zhang 在本文中,我们探索了大型语言模型法学硕士在入门编程课程中生成代码跟踪问题的应用。我们为GPT4设计了针对性的提示,引导其根据代码片段和描述生成代码追踪问题。我们建立了一套人类评估指标,以评估模型产生的问题与人类专家创建的问题的质量相比。我们的分析提供了对法学硕士在生成各种代码跟踪问题方面的能力和潜力的见解。此外,我们还提供了人类和法学硕士生成的追踪问题的独特数据集,作为教育和 NLP 研究社区的宝贵资源。 |

| Probing Representations for Document-level Event Extraction Authors Barry Wang, Xinya Du, Claire Cardie 探测分类器框架已用于解释各种自然语言处理 NLP 应用的深度神经网络模型。然而,研究主要集中在句子级 NLP 任务上。这项工作是第一个将探测范式应用于为文档级信息提取 IE 学习的表示。我们设计了八个嵌入探针来分析与文档级事件提取相关的表面、语义和事件理解能力。我们将它们应用于通过学习模型从标准数据集上的三种不同的基于 LLM 的文档级 IE 方法获得的表示。我们发现,来自这些模型的经过训练的编码器产生的嵌入可以适度改进参数检测和标记,但只能略微增强事件级任务,尽管信息的权衡有助于一致性和事件类型预测。 |

| Toward a Critical Toponymy Framework for Named Entity Recognition: A Case Study of Airbnb in New York City Authors Mikael Brunila, Jack LaViolette, Sky CH Wang, Priyanka Verma, Clara F r , Grant McKenzie 批判地名学通过地名及其所指的地点来研究权力、资本和抵抗的动态。这里的研究传统上集中于地名的语义内容以及产生它们的自上而下的制度过程。然而,他们通常忽略了普通人在日常话语中使用地名的方式,以及伴随地名参考并使其语境化的其他地理空间描述策略。在这里,我们通过包含 2010 年代纽约市 47,440 个 Airbnb 房源的新颖注释数据集,开发计算方法来衡量文化和经济资本如何影响人们提及地点的方式。在此数据集的基础上,我们引入了一种新的命名实体识别 NER 模型,该模型能够识别与地点表征相关的重要话语类别。 |

| TaskDiff: A Similarity Metric for Task-Oriented Conversations Authors Ankita Bhaumik, Praveen Venkateswaran, Yara Rizk, Vatche Isahagian 会话式数字助理的普及带来了大量会话数据的可用性,这些数据可用于改善用户体验和生成个性化响应。使用 ChatGPT 等流行的大型语言模型构建这些助手还需要额外强调即时工程和评估方法。文本相似性度量是此类分析和评估的关键要素。尽管文献中提出了许多相似性度量,但它们尚未被证明对于面向任务的对话有效,因为它们没有利用独特的对话功能。为了解决这一差距,我们提出了 TaskDiff,这是一种新颖的对话相似性度量,它利用不同的对话组件话语、意图和槽及其分布来计算相似性。 |

| DeTiME: Diffusion-Enhanced Topic Modeling using Encoder-decoder based LLM Authors Weijie Xu, Wenxiang Hu, Fanyou Wu, Srinivasan Sengamedu 在新兴的自然语言处理领域,神经主题模型 NTM 和大型语言模型 LLM 已成为重要的研究兴趣领域。尽管如此,NTM 主要利用 LLM 的上下文嵌入,这对于聚类或主题生成来说并不是最佳的。我们的研究通过引入一种名为扩散增强主题建模的新颖框架来解决这一差距,该框架使用基于编码器解码器的 LLM DeTiME。 DeTiME 利用基于 ncoder Decoder 的 LLM 来生成高度可聚类的嵌入,与现有方法相比,该嵌入可以生成表现出优异的可聚类性和增强的语义一致性的主题。此外,通过利用传播的力量,我们的框架还提供了生成与已识别主题相关的内容的能力。这种双重功能允许用户同时高效地生成高度聚集的主题和相关内容。 DeTiME 的潜力还扩展到生成集群嵌入。 |

| Adaptive End-to-End Metric Learning for Zero-Shot Cross-Domain Slot Filling Authors Yuanjun Shi, Linzhi Wu, Minglai Shao 最近,由于深度学习和大规模注释数据的可用性,槽填充得到了巨大的发展。然而,处理一个在训练过程中从未见过样本的新领域提出了严峻的挑战。由于严重的域转移,识别性能可能会大大降低。大多数先前的工作以基于度量学习的两遍管道方式处理这个问题。在实践中,由于非并行推理和上下文无关的离散标签嵌入,这些主要的管道模型可能在计算效率和泛化能力方面受到限制。为此,我们重新研究了典型的基于度量的方法,并针对具有挑战性的零样本槽填充提出了一种新的自适应端到端度量学习方案。考虑到简单性、效率和通用性,我们提出了一种级联式联合学习框架,结合上下文感知软标签表示和槽级对比表示学习,以有效缓解数据和标签移位问题。 |

| On the Dimensionality of Sentence Embeddings Authors Hongwei Wang, Hongming Zhang, Dong Yu 学习句子嵌入是自然语言处理中的一个基本问题。虽然现有的研究主要集中在提高句子嵌入的质量,但对句子嵌入维度的探索是有限的。在这里,我们对句子嵌入的维度进行了全面的实证分析。首先,我们证明句子嵌入的最佳维度通常小于默认值。随后,为了以最小的性能下降压缩句子嵌入的维度,我们确定了导致整体性能损失的两个组件:编码器的性能损失和池化器的性能损失。因此,我们提出了一种用于句子表示学习模型的两步训练方法,其中编码器和池化器分别进行优化,以减轻低维场景下的整体性能损失。 |

| Efficient Algorithms for Recognizing Weighted Tree-Adjoining Languages Authors Alexandra Butoi, Tim Vieira, Ryan Cotterell, David Chiang 树邻接语言的类别可以通过各种二级形式来表征,包括上下文无关语法CFG或控制另一个CFG或PDA的下推自动机PDA。这四种形式相当于树邻接文法 TAG、线性索引文法 LIG、下推邻接自动机 PAA 和嵌入式下推自动机 EPDA。我们定义了上述两级形式的半环加权版本,并设计了新的算法来计算字符串的所有派生的权重和所有派生的权重。由此,我们还可以立即获得 TAG、LIG、PAA 和 EPDA 的 stringsum 和 allsum 算法。对于 LIG,我们的算法的时间效率提高了 mathcal O n mathcal N 倍,其中 n 是字符串长度,mathcal N 是非终结集的大小,并且空间效率提高了 mathcal O Gamma 倍,其中 Gamma 是大小堆栈字母表比 Vijay Shanker 和 Weir 1989 的算法要好。对于 EPDA,我们的算法比 Alonso 等人的算法更具空间效率和时间效率。 2001 年分别由 mathcal O Gamma 2 和 mathcal O Gamma 3 因子计算。 |

| Towards Possibilities & Impossibilities of AI-generated Text Detection: A Survey Authors Soumya Suvra Ghosal, Souradip Chakraborty, Jonas Geiping, Furong Huang, Dinesh Manocha, Amrit Singh Bedi 大型语言模型法学硕士凭借生成类似人类文本响应的卓越能力,彻底改变了自然语言处理 NLP 领域。然而,尽管取得了这些进步,现有文献中的一些著作还是引起了人们对法学硕士潜在滥用的严重担忧,例如传播错误信息、制造假新闻、学术界抄袭和污染网络。为了解决这些问题,研究界的共识是开发算法解决方案来检测人工智能生成的文本。基本思想是,只要我们能够判断给定的文本是由人类还是人工智能编写的,我们就可以利用这些信息来解决上述问题。为此,人们提出了大量的检测框架,强调了人工智能生成文本检测的可能性。但在开发检测框架的同时,研究人员也专注于设计逃避检测的策略,即关注人工智能生成文本检测的不可能性。这是确保检测框架足够稳健并且不容易欺骗检测器的关键步骤。尽管人们对该领域产生了巨大的兴趣并进行了大量的研究,但社区目前缺乏对最新发展的全面分析。在本次调查中,我们的目标是对当前工作进行简明分类和概述,包括人工智能生成文本检测的前景和局限性。 |

| Data Augmentation Techniques for Machine Translation of Code-Switched Texts: A Comparative Study Authors Injy Hamed, Nizar Habash, Ngoc Thang Vu 代码交换 CSW 文本生成作为解决数据稀缺问题的解决方案越来越受到关注。鉴于这种日益增长的兴趣,我们需要更全面的研究来比较不同的增强方法。在这项工作中,我们在埃及阿拉伯语英语 CSW 的背景下比较了词汇替换、语言理论和反向翻译 BT 的三种流行方法。我们通过人工评估来评估机器翻译方法的有效性和增强的质量。我们表明,基于 BT 和 CSW 预测的词汇替换,在 CSW 并行数据上进行训练,在这两项任务上表现最佳。 |

| Reference Free Domain Adaptation for Translation of Noisy Questions with Question Specific Rewards Authors Baban Gain, Ramakrishna Appicharla, Soumya Chennabasavaraj, Nikesh Garera, Asif Ekbal, Muthusamy Chelliah 社区问答 CQA 门户是帮助组织内用户的宝贵工具。然而,让非英语用户也能使用它们仍然是一个挑战。翻译问题可以扩大社区的影响范围,使使用不同语言进行类似询问的个人受益。使用神经机器翻译 NMT 翻译问题带来了更多挑战,尤其是在嘈杂的环境中,问题的语法正确性不受监控。这些问题可能会被非母语人士表述为陈述,主语动词顺序不正确,有时甚至缺少问号。由于其噪声性质,从此类数据创建合成并行语料库也很困难。为了解决这个问题,我们提出了一种仅使用源端数据微调 NMT 系统的训练方法。我们的方法通过利用结合了 BERTScore 和 Masked Language Model MLM Score 的损失函数来平衡充分性和流畅性。我们的方法超越了传统的基于最大似然估计 MLE 的微调方法,该方法依赖于合成目标数据,实现了 1.9 BLEU 分数的提高。我们的模型在向基线添加噪声的同时表现出稳健性,并且仍然实现 1.1 BLEU 改进以及 TER 和 BLEURT 指标的大幅改进。我们提出的方法与模型无关,并且仅在训练阶段才有必要。 |

| Breaking the Language Barrier: Improving Cross-Lingual Reasoning with Structured Self-Attention Authors Negar Foroutan, Mohammadreza Banaei, Karl Aberer, Antoine Bosselut 在这项工作中,我们研究了多语言语言模型 MultiLM 在针对不同语言的推理进行微调时是否可以将逻辑推理能力转移到其他语言。我们通过两种方案评估 MultiLM 的跨语言推理能力 1,其中上下文语言和问题在测试的新语言中保持相同,即推理仍然是单语的,但模型必须将学到的推理能力转移到跨语言语言,2 上下文和问题的语言不同,我们称之为代码切换推理。在两个逻辑推理数据集 RuleTaker 和 LeapOfThought 上,我们证明了虽然 MultiLM 可以在单语言环境中跨语言迁移推理能力,但它们很难在代码切换环境中迁移推理能力。 |

| CRoW: Benchmarking Commonsense Reasoning in Real-World Tasks Authors Mete Ismayilzada, Debjit Paul, Syrielle Montariol, Mor Geva, Antoine Bosselut 最近在自然语言处理 NLP 常识推理研究方面的努力已经产生了大量新的数据集和基准。然而,大多数数据集在人工场景中提出了常识推理挑战,而这些挑战并不能反映现实世界 NLP 系统旨在解决的任务。在这项工作中,我们提出了 CRoW,这是一个手动策划的多任务基准,用于评估模型在六个现实世界 NLP 任务的背景下应用常识推理的能力。 CRoW 是使用多阶段数据收集管道构建的,该管道使用违反常识的扰动重写现有数据集中的示例。我们使用 CRoW 来研究 NLP 系统如何在常识知识的不同维度(例如物理、时间和社会推理)上执行。我们发现,与人类相比,在 CRoW 上评估 NLP 系统时存在显着的性能差距,这表明常识推理在现实世界的任务设置中远未得到解决。 |

| Function Vectors in Large Language Models Authors Eric Todd, Millicent L. Li, Arnab Sen Sharma, Aaron Mueller, Byron C. Wallace, David Bau 我们报告了一种简单的神经机制的存在,该机制将输入输出函数表示为自回归变压器语言模型 LM 中的向量。对各种上下文学习 ICL 任务进行因果中介分析,我们发现少量注意力头传输所演示任务的紧凑表示,我们将其称为函数向量 FV 。 FV 对上下文的变化具有鲁棒性,即它们会在零样本和自然文本设置等输入上触发任务执行,这些输入与收集它们的 ICL 上下文不同。我们在一系列任务、模型和层中测试 FV,并在中间层的设置中发现强烈的因果效应。我们研究了 FV 的内部结构,发现虽然它们通常包含对函数输出空间进行编码的信息,但仅此信息不足以重建 FV。最后,我们测试了 FV 中的语义向量组合,发现在某种程度上它们可以相加来创建触发新的复杂任务的向量。 |

| DISC-FinLLM: A Chinese Financial Large Language Model based on Multiple Experts Fine-tuning Authors Wei Chen, Qiushi Wang, Zefei Long, Xianyin Zhang, Zhongtian Lu, Bingxuan Li, Siyuan Wang, Jiarong Xu, Xiang Bai, Xuanjing Huang, Zhongyu Wei 我们提出多专家微调框架来构建金融大语言模型LLM,DISC FinLLM。我们的方法通过赋予普通法学硕士多轮问答能力、领域文本处理能力、数学计算技能和检索增强生成能力来改进他们。我们构建了名为 DISC FIN SFT 的金融指令调优数据集,包括咨询、NLP 任务、计算和检索增强生成四个类别的指令样本。对多个基准进行的评估表明,我们的模型在各种金融场景中的表现都优于基准模型。 |

| AI Alignment and Social Choice: Fundamental Limitations and Policy Implications Authors Abhilash Mishra 让人工智能代理与人类意图和价值观保持一致是构建安全且可部署的人工智能应用程序的关键瓶颈。但人工智能代理的价值观应该与人类反馈的强化学习保持一致,RLHF 已成为人工智能协调的关键框架。 RLHF 使用来自人类强化物的反馈来微调输出,所有广泛部署的大型语言模型法学硕士都使用 RLHF 来将其输出与人类价值观保持一致。了解 RLHF 的局限性并考虑这些局限性带来的政策挑战至关重要。在本文中,我们研究了构建尊重民主规范的 RLHF 系统的具体挑战。基于社会选择理论中的不可能性结果,我们表明,在相当广泛的假设下,不存在独特的投票协议来通过民主进程普遍调整使用 RLHF 的人工智能系统。此外,我们表明,将 AI 代理与所有个人的价值观保持一致总是会违反个人用户的某些私人道德偏好,即使用 RLHF 进行通用 AI 调整是不可能的。我们首先讨论使用 RLHF 构建的人工智能系统治理的政策影响,即需要强制执行透明的投票规则以让模型构建者承担责任。 |

| Woodpecker: Hallucination Correction for Multimodal Large Language Models Authors Shukang Yin, Chaoyou Fu, Sirui Zhao, Tong Xu, Hao Wang, Dianbo Sui, Yunhang Shen, Ke Li, Xing Sun, Enhong Chen 幻觉是笼罩在快速发展的多模态大型语言模型MLLM上的一个大阴影,指的是生成的文本与图像内容不一致的现象。为了减轻幻觉,现有的研究主要采用指令调整的方式,需要用特定的数据重新训练模型。在本文中,我们开辟了一条不同的道路,引入了一种名为 Woodpecker 的免训练方法。就像啄木鸟治愈树木一样,它从生成的文本中挑选并纠正幻觉。具体来说,啄木鸟由关键概念提取、问题制定、视觉知识验证、视觉主张生成和幻觉纠正五个阶段组成。 Woodpecker 以后补救方式实现,可以轻松地为不同的 MLLM 提供服务,同时可以通过访问五个阶段的中间输出进行解释。我们对啄木鸟进行了定量和定性评估,并展示了这种新范式的巨大潜力。在 POPE 基准测试中,我们的方法比基线 MiniGPT 4 mPLUG Owl 的准确度提高了 30.66 24.33。 |

| What's Left? Concept Grounding with Logic-Enhanced Foundation Models Authors Joy Hsu, Jiayuan Mao, Joshua B. Tenenbaum, Jiajun Wu VisProg 和 ViperGPT 等最近的作品使用大型语言模型 LLM 巧妙地构建了视觉推理的基础模型,以生成可以由预先训练的视觉语言模型执行的程序。然而,它们在有限的领域(例如 2D 图像)中运行,没有充分利用语言抽象概念的概括,例如向左移动也可以基于 3D、时间和动作数据,例如向左移动。这种有限的泛化源于这些仅推理方法无法学习或使预训练模型适应新领域。我们提出了逻辑增强基础模型 LEFT ,这是一个统一的框架,通过可微的、与域无关的、基于一阶逻辑的程序执行器来学习跨域概念的基础和推理。 LEFT 有一个 LLM 解释器,它输出以通用的、基于逻辑的推理语言表示的程序,该语言在所有领域和任务之间共享。然后,LEFT 的执行器使用可训练的特定领域接地模块执行程序。我们证明 LEFT 可以灵活地学习 2D 图像、3D 场景、人体运动和机器人操作四个领域的概念。 |

| Visual Cropping Improves Zero-Shot Question Answering of Multimodal Large Language Models Authors Jiarui Zhang, Mahyar Khayatkhoei, Prateek Chhikara, Filip Ilievski 多模态大语言模型法学硕士最近在视觉问答 VQA 上实现了有希望的零射击精度,这是影响各种下游应用程序和领域的基本任务。鉴于这些模型广泛使用的巨大潜力,研究它们在处理不同图像和问题属性时的局限性非常重要。在这项工作中,我们研究多模态法学硕士是否可以感知图像中的小细节和大细节。特别是,我们表明,他们在回答视觉问题时的零镜头准确率对问题的视觉主题的大小非常敏感,随着大小的增加下降到 46。此外,我们通过观察人类视觉裁剪可以显着减轻他们对尺寸的敏感度来证明这种效应是因果关系。受人类裁剪实用性的启发,我们提出了三种自动视觉裁剪方法作为推理时间机制,以提高多模态 LLM 的零样本性能。我们研究了它们在四个流行的 VQA 数据集以及针对精细视觉细节定制的 VQAv2 数据集子集上的有效性。我们的研究结果表明,在细节敏感的 VQA 应用中应谨慎使用多模态 LLM,并且视觉裁剪是提高其零样本性能的一个有希望的方向。 |

| What Algorithms can Transformers Learn? A Study in Length Generalization Authors Hattie Zhou, Arwen Bradley, Etai Littwin, Noam Razin, Omid Saremi, Josh Susskind, Samy Bengio, Preetum Nakkiran 大型语言模型表现出令人惊讶的新兴泛化特性,但在许多简单的推理任务(例如算术和奇偶校验)上也遇到了困难。这就提出了一个问题:Transformer 模型是否以及何时能够学习解决任务的真正算法。我们研究了 Transformers 在算法任务长度泛化的特定设置中的能力范围。在这里,我们提出了一个统一的框架来理解 Transformer 何时以及如何在给定任务上表现出强大的长度泛化能力。具体来说,我们利用 RASP Weiss 等人,2021 一种专为 Transformer 计算模型设计的编程语言,并引入 RASP 泛化猜想 如果任务可以通过适用于所有输入长度。这个简单的猜想显着地捕获了算法任务中长度泛化的大多数已知实例。此外,我们利用我们的见解来大幅提高奇偶校验和加法等传统困难任务的泛化性能。在理论方面,我们给出了一个简单的例子,其中从 Abbe 等人学习的最小度插值器模型。 2023 并不能根据分布行为正确预测变形金刚,但我们的猜想可以。 |

| E-Sparse: Boosting the Large Language Model Inference through Entropy-based N:M Sparsity Authors Yun Li, Lin Niu, Xipeng Zhang, Kai Liu, Jianchen Zhu, Zhanhui Kang 众所周知,传统的剪枝方法在生成人工智能的大型语言模型法学硕士中很难发挥作用,因为它们的训练过程成本高昂且计算需求大。我们首次将隐藏状态特征的信息熵引入剪枝度量设计中,即E Sparse,以提高LLM上N M稀疏性的准确性。 E Sparse利用信息丰富度来利用通道重要性,并进一步结合了多种新颖的技术来实现它,它引入了信息熵来增强参数权重和输入特征范数的重要性,作为一种新颖的剪枝度量,并且在没有修改剩余的权重。 2.设计了global naive shuffle和local block shuffle,快速优化信息分布,充分应对N·M稀疏性对LLM精度的影响。 E Sparse 在 FasterTransformer 上实现为 Sparse GEMM,并在 NVIDIA Ampere GPU 上运行。 |

| Random Entity Quantization for Parameter-Efficient Compositional Knowledge Graph Representation Authors Jiaang Li, Quan Wang, Yi Liu, Licheng Zhang, Zhendong Mao 知识图谱知识图谱上的表示学习对于下游任务至关重要。主导方法 KG Embedding KGE 表示具有独立向量的实体,并面临可扩展性挑战。最近的研究提出了一种提高参数效率的替代方法,即通过组合与预定义的小规模码本匹配的实体对应码字来表示实体。我们将获取每个实体对应的码字的过程称为实体量化,之前的工作为此设计了复杂的策略。令人惊讶的是,本文表明简单的随机实体量化可以达到与当前策略类似的结果。我们分析了这种现象,发现实体代码(表达实体的量化结果)在随机实体量化下在代码级别具有较高的熵,在码字级别具有较高的杰卡德距离。因此,不同的实体变得更容易区分,有助于有效的 KG 表示。上述结果表明,当前的量化策略对于 KG 表示并不关键,并且在实体可区分性方面仍然有超越当前策略的改进空间。 |

| Chinese Abs From Machine Translation |

Papers from arxiv.org

更多精彩请移步主页

pic from pexels.com

![[Vue 代码模板] Vue3 中使用 Tailwind CSS + NutUI 实现侧边工具栏切换主题](https://img-blog.csdnimg.cn/img_convert/49ee8c9d2ce8de93dba9e046484addd4.png)