目录

- 1.修改hadoop相关参数

- 2.Hive解压安装

- 3.Hive元数据的三种部署方式

- 3.1 元数据库之Derby

- 3.2 元数据库之Mysql

- 3.3 元数据之MetaStore Server

- 4.hive的两种访问方式

- 4.1 命令行的方式

- 4.2 HiveServer2模式

1.修改hadoop相关参数

1)修改core-site.xml

[root@hadoop102 hive]$ vim /opt/module/hadoop/etc/hadoop/core-site.xml

<!-- 配置该root(superUser)允许通过代理访问的主机节点 -->

<property>

<name>hadoop.proxyuser.root.hosts</name>

<value>*</value>

</property>

<!-- 配置该root(superUser)允许通过代理用户所属组 -->

<property>

<name>hadoop.proxyuser.root.groups</name>

<value>*</value>

</property>

<!-- 配置该root(superUser)允许通过代理的用户-->

<property>

<name>hadoop.proxyuser.root.users</name>

<value>*</value>

</property>

2)配置yarn-site.xml

[root@hadoop102 hive]$ vim /opt/module/hadoop/etc/hadoop/yarn-site.xml

<!-- NodeManager使用内存数,默认8G,修改为4G内存 -->(16g物理内存的改为2g或者是3g)

<property>

<description>Amount of physical memory, in MB, that can be allocated

for containers. If set to -1 and

yarn.nodemanager.resource.detect-hardware-capabilities is true, it is

automatically calculated(in case of Windows and Linux).

In other cases, the default is 8192MB.

</description>

<name>yarn.nodemanager.resource.memory-mb</name>

<value>4096</value>

</property>

<!-- 容器最小内存,默认512M -->

<property>

<description>The minimum allocation for every container request at the RM in MBs.

Memory requests lower than this will be set to the value of this property.

Additionally, a node manager that is configured to have less memory than this value

</description>

<name>yarn.scheduler.minimum-allocation-mb</name>

<value>512</value>

</property>

<!-- 容器最大内存,默认8G,修改为4G -->

<property>

<description>The maximum allocation for every container request at the RM in MBs.

Memory requests higher than this will throw an InvalidResourceRequestException.

</description>

<name>yarn.scheduler.maximum-allocation-mb</name>

<value>4096</value>

</property>

<!-- 虚拟内存检查,默认打开,修改为关闭 -->(使用虚拟内存)

<property>

<description>Whether virtual memory limits will be enforced for containers.</description>

<name>yarn.nodemanager.vmem-check-enabled</name>

<value>false</value>

</property>

注意:修改完配置文件记得分发,然后重启集群。

2.Hive解压安装

1)把apache-hive-3.1.2-bin.tar.gz上传到linux的/opt/software目录下

2)将/opt/software/目录下的apache-hive-3.1.2-bin.tar.gz到/opt/module/目录下面

[root@hadoop102 software]$ tar -zxvf apache-hive-3.1.2-bin.tar.gz -C /opt/module/

3)修改解压后的目录名称为hive

[root@hadoop102 module]$ mv apache-hive-3.1.2-bin/ /opt/module/hive

4)修改/etc/profile.d/my_env.sh文件,将hive的/bin目录添加到环境变量

[root@hadoop102 hive]$ sudo vim /etc/profile.d/my_env.sh

……

#HIVE_HOME

export HIVE_HOME=/opt/module/hive

export PATH=$PATH:$HIVE_HOME/bin

[root@hadoop102 hive]$ source /etc/profile

3.Hive元数据的三种部署方式

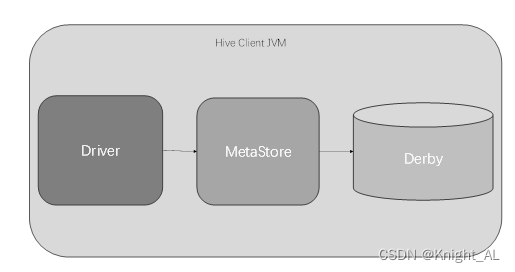

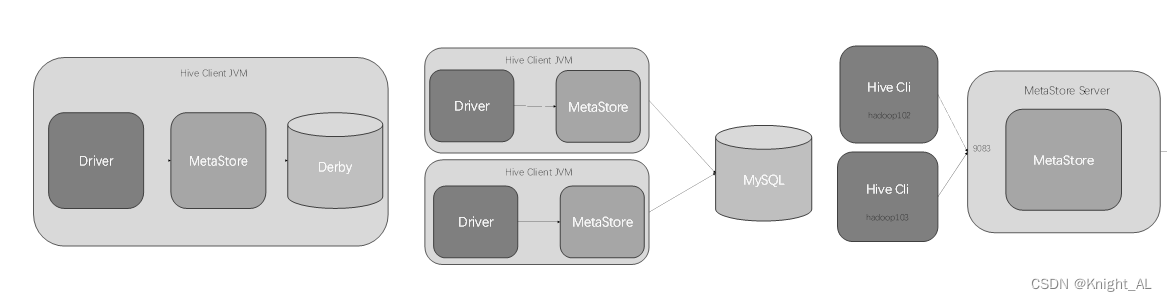

3.1 元数据库之Derby

1.内嵌模式示意图:

2.Derby数据库:

Derby数据库是Java编写的内存数据库,在内嵌模式中与应用程序共享一个JVM,应用程序负责启动和停止。

1)在hive根目录下,使用/bin目录中的schematool命令初始化hive自带的Derby元数据库

[root@hadoop102 hive]$ bin/schematool -dbType derby -initSchema

2)执行上述初始化元数据库时,会发现存在jar包冲突问题,现象如下:

(hadoop和hive下都有这个jar包,以底层的hadoop为主,改了hive的)

SLF4J: Found binding in [jar:file:/opt/module/hive/lib/log4j-slf4j-impl-2.10.0.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: Found binding in [jar:file:/opt/module/hadoop-3.1.3/share/hadoop/common/lib/slf4j-log4j12-1.7.25.jar!/org/slf4j/impl/StaticLoggerBinder.class]

3)解决jar冲突问题,只需要将hive的/lib目录下的log4j-slf4j-impl-2.10.0.jar重命名即可

[root@hadoop102 hive]$ mv lib/log4j-slf4j-impl-2.10.0.jar lib/log4j-slf4j-impl-2.10.0.back

4.启动Hive

1)执行/bin目录下的hive命令,就可以启动hive,并通过cli方式连接到hive

[root@hadoop102 hive]$ bin/hive

2)使用Hive

hive> show databases; // 查看当前所有的数据库

OK

default

Time taken: 0.472 seconds, Fetched: 1 row(s)

hive> show tables; // 查看当前所有的表

OK

Time taken: 0.044 seconds

hive> create table test_derby(id int); // 创建表test_derby,表中只有一个字段,字段类型是int

OK

Time taken: 0.474 seconds

hive> insert into test_derby values(1001); // 向test_derby表中插入数据

Query ID = root_20211018153727_586935da-100d-4d7e-8a94-063d373cc5dd

Total jobs = 3

……

Hadoop job information for Stage-1: number of mappers: 1; number of reducers: 1

……

Stage-Stage-1: Map: 1 Reduce: 1 Cumulative CPU: 6.19 sec HDFS Read: 12769 HDFS Write: 208 SUCCESS

Total MapReduce CPU Time Spent: 6 seconds 190 msec

OK

Time taken: 31.901 second

hive> select * from test_derby; // 查看test_derby表中所有数据

OK

1001

Time taken: 0.085 seconds, Fetched: 1 row(s)

hive> exit;

- 内嵌模式只有一个JVM进程

在内嵌模式下,命令行执行jps –ml命令,只能看到一个CliDriver进程。

[root@hadoop102 hive]$ jps –ml

7170 sun.tools.jps.Jps -ml

6127 org.apache.hadoop.util.RunJar /opt/module/hive/lib/hive-cli-3.1.2.jar org.apache.hadoop.hive.cli.CliDriver

6.Hive自带的元数据库的问题

演示采用Derby作为元数据库的问题:

开启另一个会话窗口运行Hive,同时监控/tmp/root目录中的hive.log文件,会观察到如下错误信息。

Caused by: ERROR XSDB6: Another instance of Derby may have already booted the database /opt/module/hive/metastore_db.

at org.apache.derby.iapi.error.StandardException.newException(Unknown Source)

at org.apache.derby.iapi.error.StandardException.newException(Unknown Source)

at org.apache.derby.impl.store.raw.data.BaseDataFileFactory.privGetJBMSLockOnDB(Unknown Source)

at org.apache.derby.impl.store.raw.data.BaseDataFileFactory.run(Unknown Source)

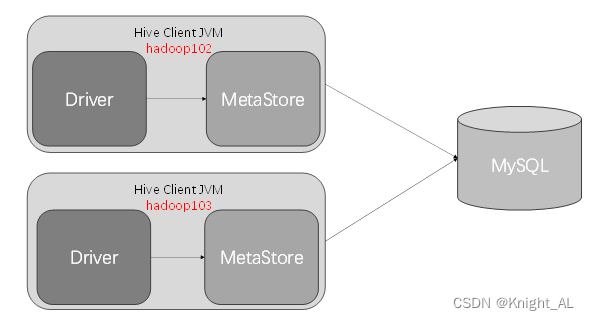

Hive默认使用的元数据库为derby并且部署方式是内嵌式,在开启Hive之后就会独占元数据库,且不与其他客户端共享数据,如果想多窗口操作就会报错,操作比较局限。为此Hive支持采用MySQL作为元数据库,就可以支持多窗口操作。

3.2 元数据库之Mysql

- 直连模式示意图:

2.配置Hive元数据库为MySql

- 拷贝驱动

Hive需要将元数据信息存储到元数据库mysql中,需要使用JDBC的方式连接到MySQL,所以,将MySQL的JDBC驱动拷贝到Hive的lib目录下,供hive调用。

[root@hadoop102 software]$ cp mysql-connector-java-5.1.37.jar /opt/module/hive/lib

2)配置Metastore到MySql

在/opt/module/hive/conf目录下新建hive-site.xml文件(新建的配置文件中的配置会覆盖默认配置)

[root@hadoop102 hive]$ vim conf/hive-site.xml

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<!-- jdbc连接的URL -->

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://hadoop102:3306/metastore?useSSL=false</value>

</property>

<!-- jdbc连接的Driver-->

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

</property>

<!-- jdbc连接的username-->

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

</property>

<!-- jdbc连接的password -->

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>123456</value>

</property>

<!-- Hive默认在HDFS的工作目录 -->

<property>

<name>hive.metastore.warehouse.dir</name>

<value>/user/hive/warehouse</value>

</property>

<!-- Hive元数据存储的验证 -->

<property>

<name>hive.metastore.schema.verification</name>

<value>false</value>

</property>

<!-- 元数据存储授权 -->

<property>

<name>hive.metastore.event.db.notification.api.auth</name>

<value>false</value>

</property>

</configuration>

3.Hive初始化元数据库

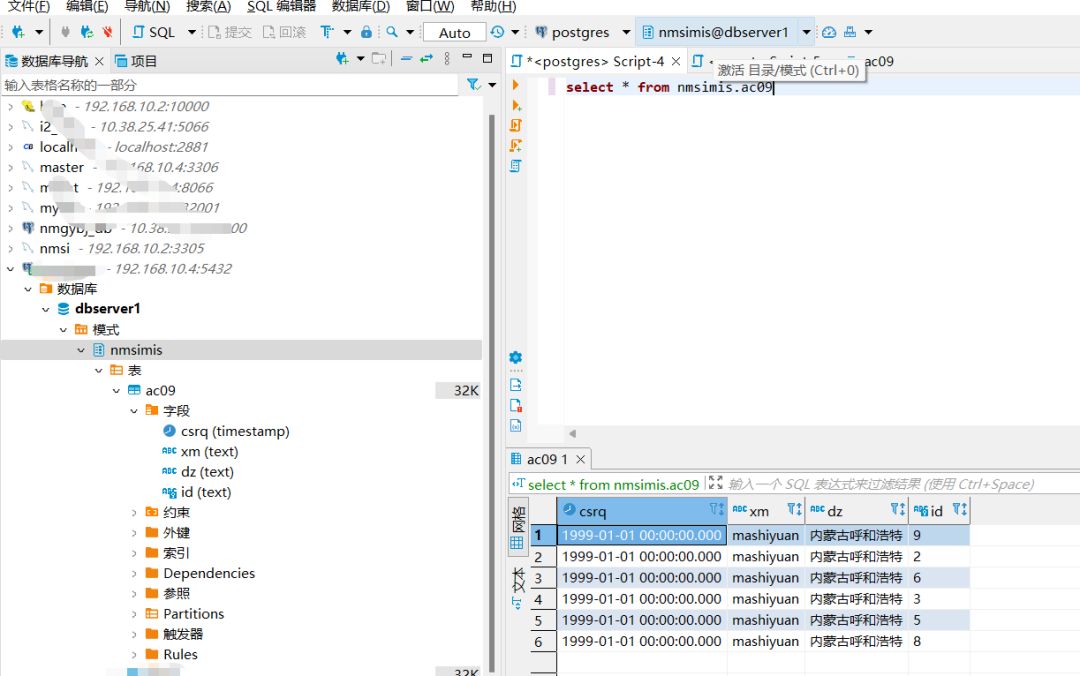

在mysql中创建hive存储元数据的数据库metastore,再通过hive的初始化元数据库操作创建表

1)登陆MySQL

[root@hadoop102 module]$ mysql -uroot -p你的密码

2)新建Hive元数据库

mysql> create database metastore;

mysql> quit;

3)初始化Hive元数据库

[root@hadoop102 hive]$ bin/schematool -initSchema -dbType mysql -verbose

4.启动Hive

1)启动Hive

[root@hadoop102 hive]$ bin/hive

2)使用Hive

hive> show databases; // 查看所有的数据库

hive> show tables; // 查看所有的表,刚才创建的表test_derby是否存在?为什么?

hive> create table test_mysql (id int); // 创建test_mysql表,一个字段为id,类型为int

hive> insert into test_mysql values(1002); // 向表test_mysql中插入数据

hive> select * from test_mysql; // 查看test2表

3)开启另一个窗口测试,是否支持客户端并发访问

[root@hadoop102 hvie]$ bin/hive

hive> show tables;

hive> select * from test_mysql;

5.直连模式问题:

在公司生产环境中,网络环境会非常复杂,mysql的所在环境可能存在网络隔离,无法直接访问;另外,mysql的root账户和密码在此模式下会存在泄露风险,存在数据安全隐患。

思考:在hadoop103上部署hive,元数据库使用的仍然是hadoop102的Mysql实例,如何实现?

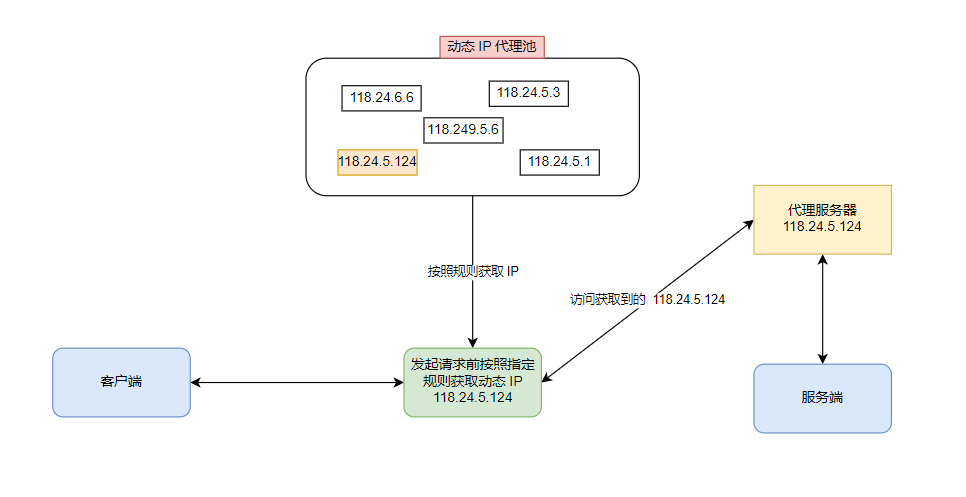

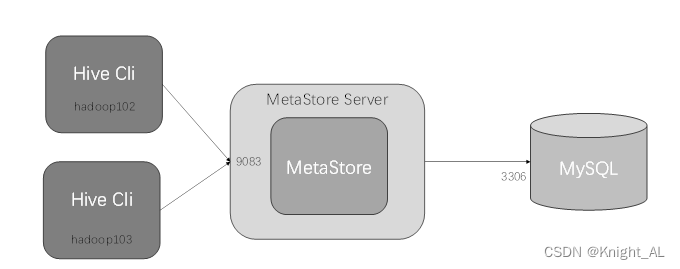

3.3 元数据之MetaStore Server

1.元数据服务模式示意图

2.元数据服务模式

在服务器端启动MetaStore服务,客户端利用Thrift协议通过MetaStore服务访问元数据库。

元数据服务的访问方式更适合在生产环境中部署使用,相比内嵌式,该方式更加的灵活。(跨网络跨语言跨平台)

3.将Mysql做为元数据库,部署元数据服务

1)首先,将hive的元数据库配置为Mysql

[root@hadoop102 hive]$ vim conf/hive-site.xml

2)在hive-site.xml文件中添加如下配置信息

<!-- 指定存储元数据要连接的地址 -->

<property>

<name>hive.metastore.uris</name>

<value>thrift://hadoop102:9083</value>

</property>

注意:在配置了此参数后,启动hive之前必须先启动元数据服务,否则,hive启动后无法连接到元数据服务

2)启动元数据服务

[root@hadoop102 hive]$ bin/hive --service metastore

2021-10-18 18:22:24: Starting Hive Metastore Server

注意: 启动后窗口不能再操作,需打开一个新的shell窗口做别的操作

1)启动 hive,查看表及表中数据,是否是Mysql数据库中的表。

2)在另一个窗口启动hive,测试多客户端能否同时连接操作。

思考:在hadoop103上使用元数据服务模式部署hive如何实现?

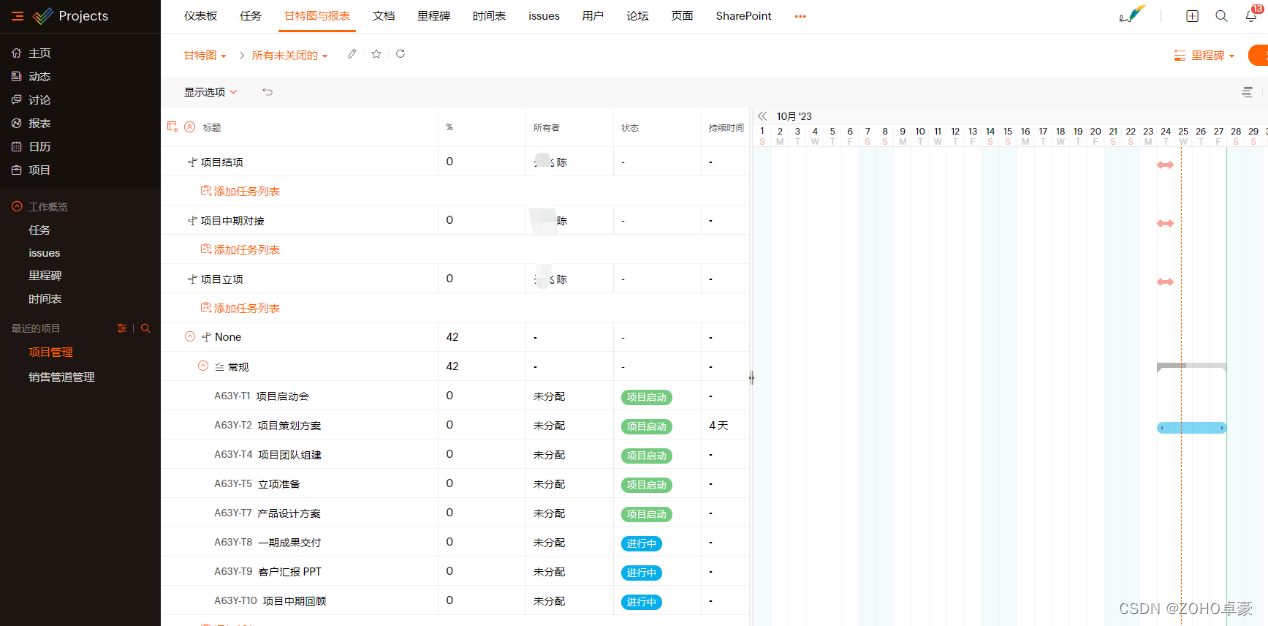

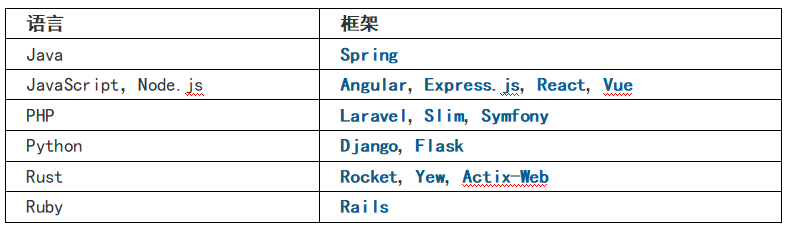

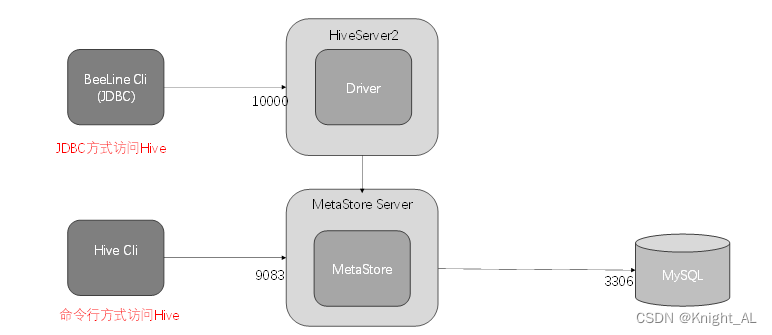

4.hive的两种访问方式

4.1 命令行的方式

- 在前面的操作中,我们都是通过cli的方式访问hive的。

- 我们可以切身的体会到,通过cli的方式访问hive的不足,如:cli太过笨重,需要hive的jar支持。

4.2 HiveServer2模式

1.JDBC访问Hive示意图:

2. JDBC方式访问Hive

JDBC方式,本质上是将hive包装为服务发布出去,开发者使用JDBC的方式连接到服务,从而操作hive。

减少了对hive环境的依赖

3. 开启Hiveserver2

1)在hive-site.xml文件中添加如下配置信息

<!-- 指定hiveserver2连接的host -->

<property>

<name>hive.server2.thrift.bind.host</name>

<value>hadoop102</value>

</property>

<!-- 指定hiveserver2连接的端口号 -->

<property>

<name>hive.server2.thrift.port</name>

<value>10000</value>

</property>

- 重启MetaStore服务

[root@hadoop102 hive]$ bin/hive --service metastore

3)启动hive服务(这里需要考虑元数据的访问方式,如何使用元数据服务的模式,需要提前开启元数据服务)

[root@hadoop102 hive]$ bin/hive --service hiveserver2

4)启动beeline客户端(需要多等待一会,否则会报错连不上)

[root@hadoop102 hive]$ bin/beeline -u jdbc:hive2://hadoop102:10000 -n root