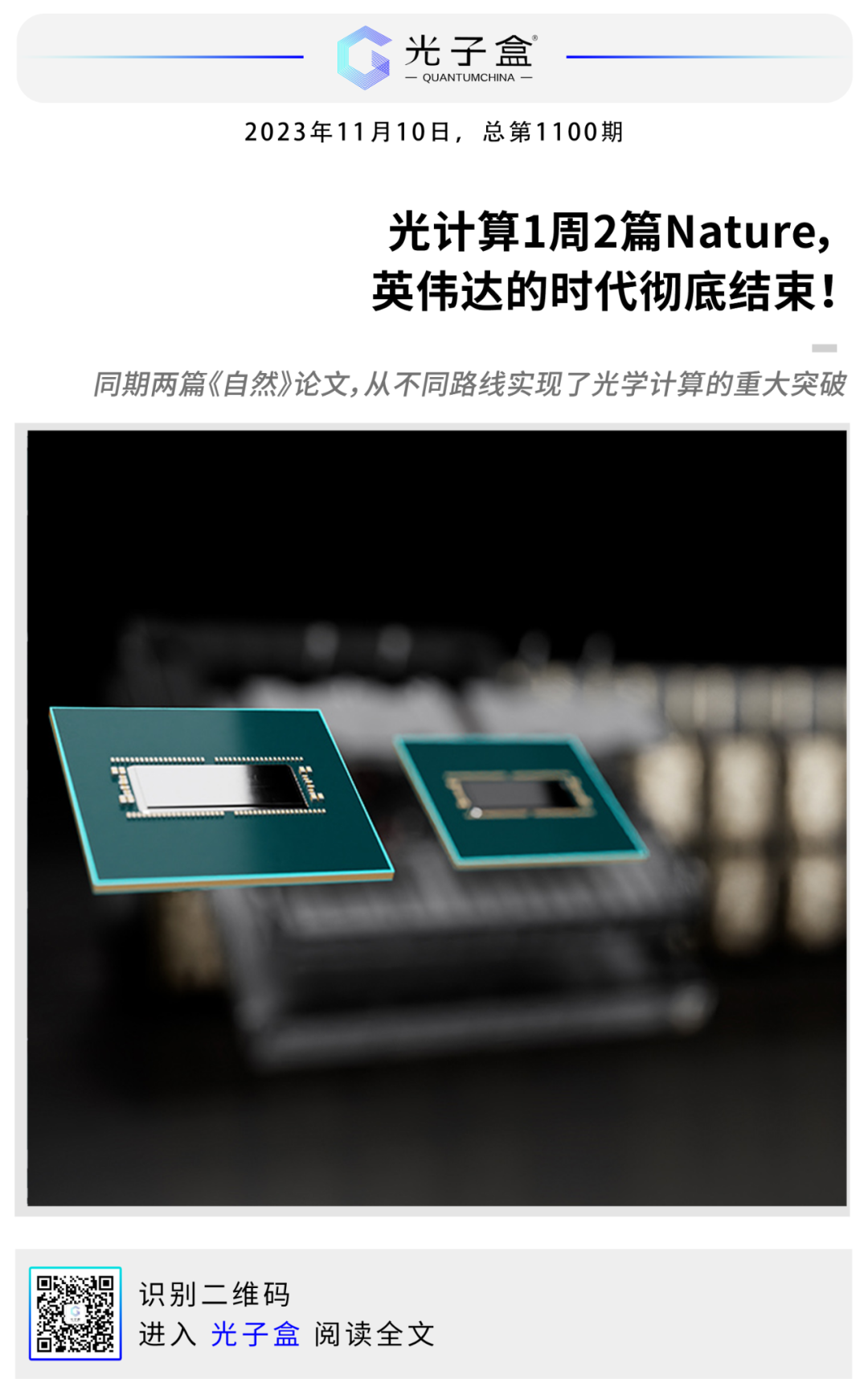

近期,光计算领域连续发出重量级文章,刊登在学术界的顶级期刊上。一时间,各大媒体纷纷转发,读者们也纷纷感叹:中国芯片取代英伟达的机会来了!今天,光子盒用这篇万字长文为大家梳理光计算的背景、进展和未来。

美国时间10月17日,美国商务部发布新规,全面收紧尖端AI芯片对华出口。

部长吉娜·雷蒙多(Gina Marie Raimondo)表示,管制目的就是遏制中国获得先进芯片,从而阻碍“人工智能和复杂计算机领域的突破”。面对先前的几轮官方限制,英伟达曾通过向中国市场专供降低了互连速度的“阉割版”旗舰计算芯片A800和H800,来适应规则;而这次新规的变化可能会冲击这两款芯片销售。自此,英伟达和其他芯片制造商向我国销售高性能半导体,受到的限制会变得愈加严重;AMD、英特尔等预计也可能受到新规的影响。

原本,《先进计算芯片规则(AC/S IFR)》的生效日期为2023年11月16日、公众评论的截止日期为规则公开展示之日起60天。变本加厉的是,仅仅6天后,商务部就加速落地了这项禁运新规(本来是30天征集意见)。

当下的全球半导体设备主要由美国、荷兰和日本的公司霸榜,半导体产业也已经高度全球化。此次,美方的不当管制正严重阻碍着各国芯片及芯片设备、材料、零部件企业正常经贸往来,破坏市场规则和国际经贸秩序并威胁着全球产业供应链的稳定。

在制裁升级的背景下,寻找一个不“卡脖子”的赛道已是迫在眉睫。

一些替代性的新兴技术包括量子计算、神经形态芯片、光子学和新材料……虽然有许多基于电子计算的新型方案,但它们却始终摆脱不了制程的封锁、限制。特别是,随着AI、通讯、自动驾驶等领域对海量运算的需求渐增,在摩尔定律的前提下,集成电路的技术演进已面临物理极限。该如何破局?

——走向光。

目前看来,光计算是最能根本上摆脱制程封锁、有极大性能提高、有成熟产业链、能够近几年落地的技术方案。

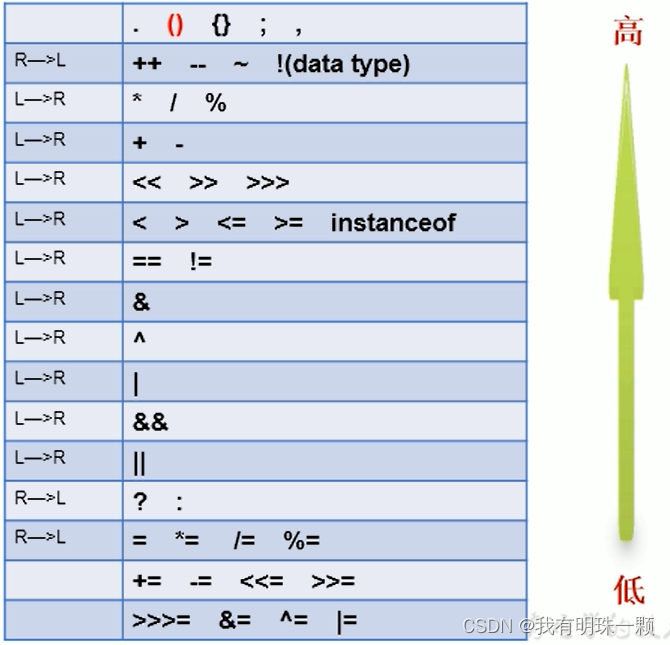

一台典型的计算机由三部分组成:计算+通信+存储。在电子配置中,这些过程是在晶体管、电容器、电阻器和其他元件的帮助下操纵电流时完成的;在光子计算中,光是通过光电探测器、相位调制器、波导等元件来操控的。这些分别是电子计算机和光计算的组成部分。

与依靠电子操控的电子计算不同,光子计算依靠的是光子的特性。这种技术基于这样一种理念:光可以用来执行许多与计算机中的电流相同的功能,例如执行计算、存储和检索数据以及与其他设备通信。甚至,在延迟、吞吐量和能效这三个主要的计算性能指标上,光学计算都将取得优势:使用光子技术可提供每通道大于1TB/s的高吞吐量(相比之下,铜线的最高吞吐量约为每通道1GB/s)、更高的能效(与电子电路不同,光子技术不会产生欧姆热)和更低的延迟(矩阵乘法<<1ns)。

未来的光处理器最有可能在延迟、吞吐量或能效方面实现整体优势的三个关键特性。

需要注意的是,计算机还有其他一些重要指标,如尺寸、稳健性、成本、安全性(易受黑客攻击)和准确性。例如,我们没有理由相信光学计算机能比所有可能的电子计算机提供更高的精度,相反,我们的目标通常是在特定精度下实现延迟、吞吐量和/或能效方面的优势。同样,其他指标也提供了其他约束条件,光学计算机必须满足这些约束条件,才能在某些特定使用情况下具有竞争力。考虑到电子处理器的先进程度,构建一台在任何指标上都优于电子计算机的光学计算机都是一项挑战。

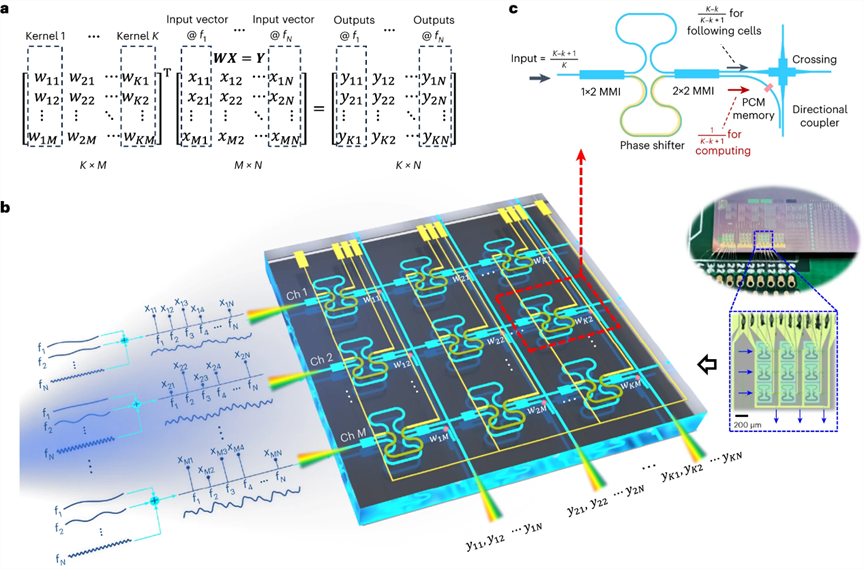

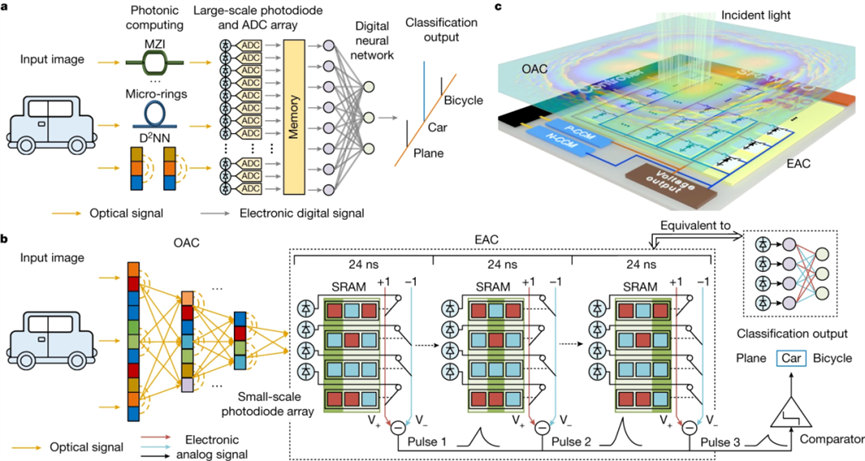

今年10月,两篇发表在《自然》(Nature)上的文章为这一领域带来了新的希望:10月19日,牛津大学教授、英国皇家工程院院士Harish Bhaskaran团队首次展示了光子存内计算(photonic in-memory computing)架构,为提高光子处理器的并行性提供了全新途径;10月25日,清华大学戴琼海院士团队基于纯模拟光电融合计算架构,打造了又一款超高性能光电芯片——ACCEL。

牛津大学团队介绍了一种能够处理三维(3D)数据的尖端集成光子-电子硬件。这种“高维”处理是利用多个无线电频率对数据进行编码的结果,这一突破不仅满足了现代人工智能任务不断升级的需求,还将计算并行性提升到了前所未有的水平。在实际应用中,该团队将这种新型硬件用于评估心脏病患者心电图中的猝死风险。结果令人瞩目:成功地同时分析了100个心电图信号,准确率高达93.5%,令人印象深刻。

第一作者、牛津大学材料系的董博维(Bowei Dong)博士强调了他们的发现所带来的范式转变。他指出,“用无线电频率来表示数据开辟了另一个维度,使新兴人工智能硬件的超高速并行处理成为可能”。它不仅开创性地解决了对处理能力不断升级的需求,还为前所未有的可能性奠定了基础,预示着人工智能硬件处理的新时代即将到来,空间、波长、射频频率等多个维度的融合将引发影响深远的创新浪潮。

而清华大学攻关团队创造性地提出了光电深度融合的计算框架。这枚芯片基于纯模拟光电融合计算架构,在包括ImageNet等智能视觉任务实测中,相同准确率下,比现有高性能GPU算力提升数千倍,能效提升四百万倍。更进一步,该芯片光学部分的加工最小线宽仅采用百纳米级,而电路部分仅采用180nm CMOS工艺,已取得比7纳米制程的高性能芯片多个数量级的性能提升。

两篇文章通过不同路径实现了光学计算的性能突破,再结合光学中几乎可以无耗散地执行操作这一事实,可以预料的是,光学在超越电子学方面正大有可为。

几十年来,光学计算一直是一个定义明确的领域:有自己的专业会议、科学杂志专栏以及自己的研究计划和资金。这一研究领域也被命名为光信息处理,现在信息光学或信息光子学等术语也被频繁使用,无一不反映了该领域的演变。

从一开始,人们就对光学在计算方面的潜力提出了很多质疑,而对电子学的潜力和未来却毫无疑问。考尔菲尔德(H.J. Caulfield)曾于1998年撰写了一篇关于光学计算前景的论文,其中讨论了光学和电子学之间的竞争,并指出存在三个阶段:首先是对电子学的“无知和低估”,然后是“觉醒和恐惧自卑”,现在是“现实地接受光学计算和电子学是永恒的合作伙伴”。

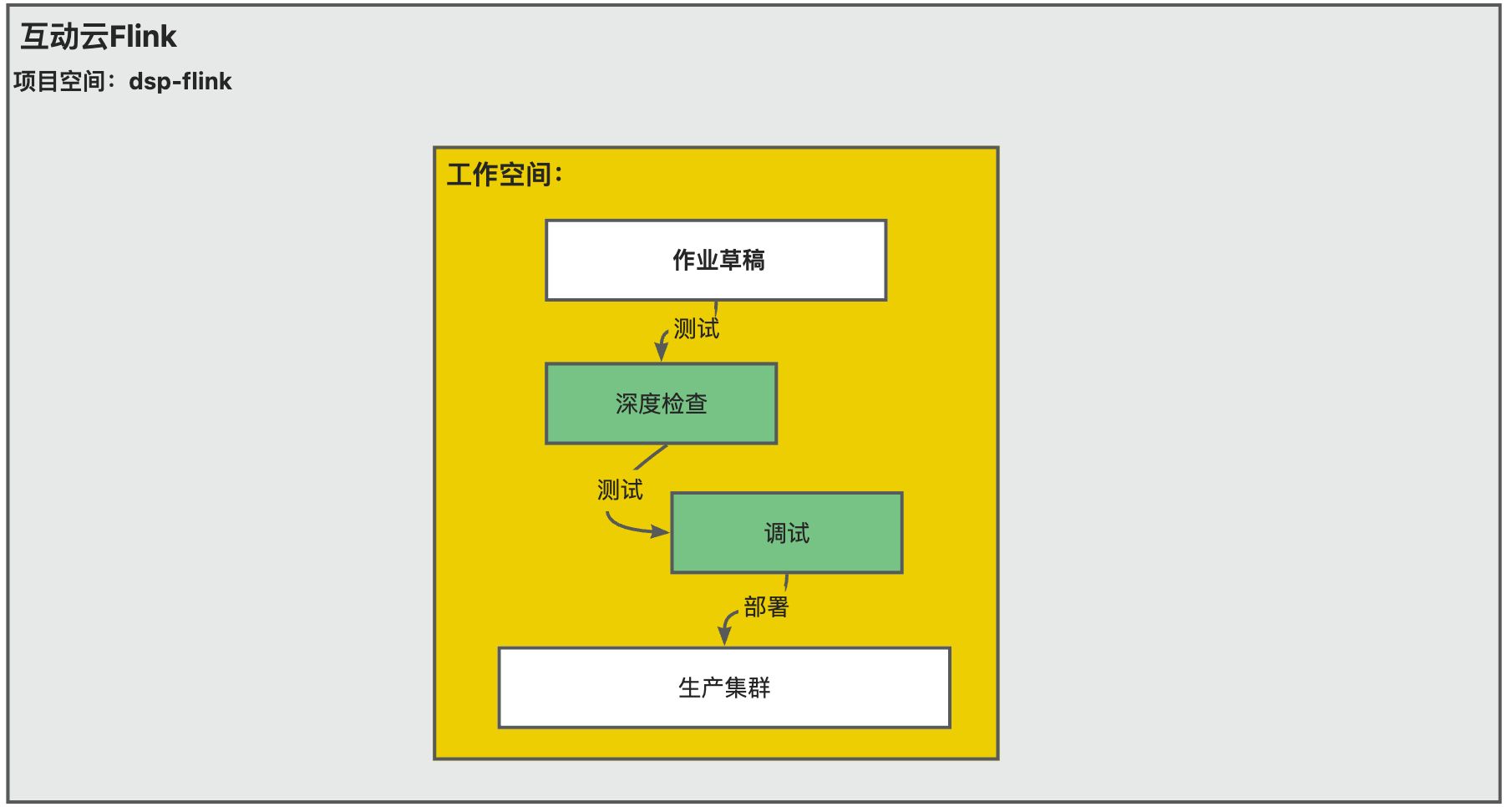

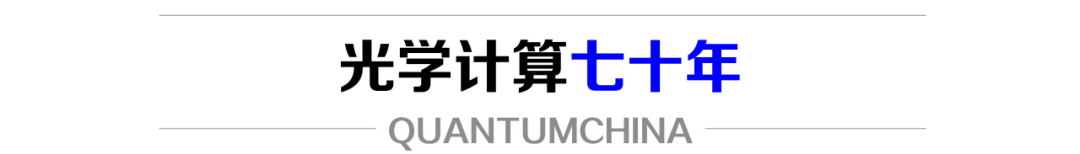

人工智能及其相应光学实现发展中里程碑事件的时间线

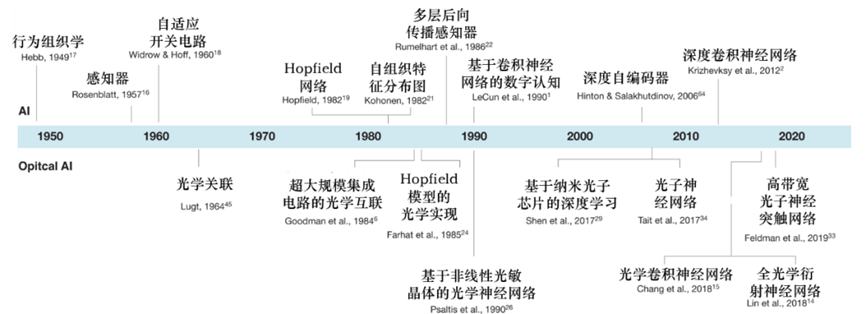

透镜的傅立叶变换特性是光学计算的基础。使用相干光时,透镜会在其后焦平面对位于其前焦平面的二维透明体进行傅里叶变换。处理器由三个平面组成:输入平面、处理平面和输出平面。处理平面可以由透镜、全息图(光学记录或计算机生成)或非线性元件组成,将实现电光转换——空间光调制器(SLM)可以完成这种转换。

用于信息处理的通用光学处理器的结构。处理器由三个平面组成:输入平面、处理平面和输出平面。

整个处理过程的速度受限于其最慢组件的速度,即大多数情况下输入平面SLM的速度,因为它们大多以视频速率运行。SLM是开发实用光学处理器的关键部件,但不幸的是,它也是最薄弱的部件之一。事实上,由于SLM性能差、成本高,导致用于实时应用的光处理器迟迟无法制造出来。

信息光学是五十年代以来公认的光学分支。事实上,通信和信息论的概念构成了光学信息处理的基础。1960年发明了相干光源——激光,激光器一经发明,光学信息处理就迅速发展起来,该领域的所有重大发明都是在1970年之前完成的。

来到七十年代初,人们对光学和信息处理充满热情,光学在实时数据处理方面的潜力非常可观。然而,由于技术问题,特别是SLM方面的技术问题,现实生活中的光学处理器并不多见。七十年代的研究更加现实,人们开始尝试制造实际应用的光学处理器;由于计算机的进步,与计算机的竞争也变得更加激烈。直至在七十年代末,尽管人们付出了巨大的研究努力,但还没有真正适合实时光学信息处理的SLM。

128×128电子寻址液晶SLM,1975年由法国LETI公司制造。

当时,几乎所有提出的处理器都还停留在实验室原型阶段,从未有机会取代电子处理器——即使当时电子和计算机的功能还远不如现在强大。造成这种情况的原因有很多:能够从光学处理器的速度中获益的应用数量可能还不够多,但主要原因是缺乏功能强大、高速、高质量、价格合理的SLM(用于处理器的输入平面和滤波器平面)。

在1980-2000年初,全球范围内对光的研究工作非常密集。八十年代,技术环境发生了变化,出现了内存容量更大的计算机、电子束写入器得到了更广泛的应用、学术界对神经形态计算的研究活跃了起来。由于空间光调制器的可用性是光信息处理成功与否的一个重要问题,1980年后,人们还投入了大量精力开发空间光调制器,以满足光处理器在速度、分辨率、尺寸和调制能力方面的要求。

九十年代,主要的进展是在制造方法上采用了光刻技术,得益于光刻技术的进步,亚微米级DOE已经可以制造出来,例如偏振选择性CGH、人工电介质、光斑发生器。

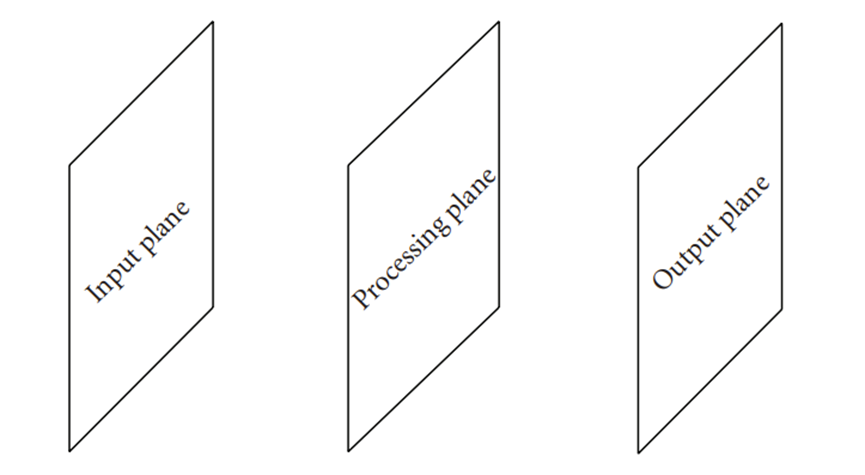

在过去的二十年中,光学处理和光学模式识别研究处于密集期。人们对这些处理器的各个方面都进行了研究,研究进展显著。光学和光子计算系统取得了长足的进步,给光学图像分类、显微应用、成像和语音识别领域提供了全新的发展机遇。

光子深度学习在图像分类和显微领域的应用

光计算领域的研究发展史揭示了一场非凡的科学探险。它始于相干光的处理能力,特别是其傅立叶变换能力。这段历史表明,人们为制造能够实时处理大量数据的光学处理器付出了巨大的努力。如今,光学技术在电信领域已无敌手,包括光纤和光缆、波分复用(WDM)、光放大器和基于MEM的交换机。光学和光子计算系统在过去半个多世纪的发展中取得了长足的进步,并已探索出一些最具挑战性问题的创新解决方案:包括全光非线性,大型光子网络的可靠控制,电光转换效率和可编程性。

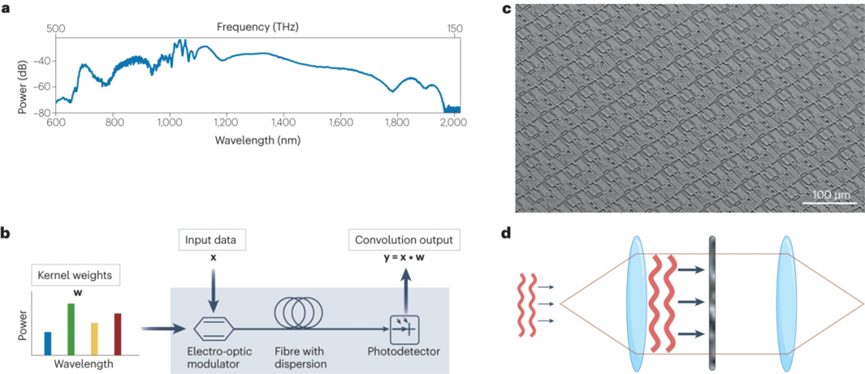

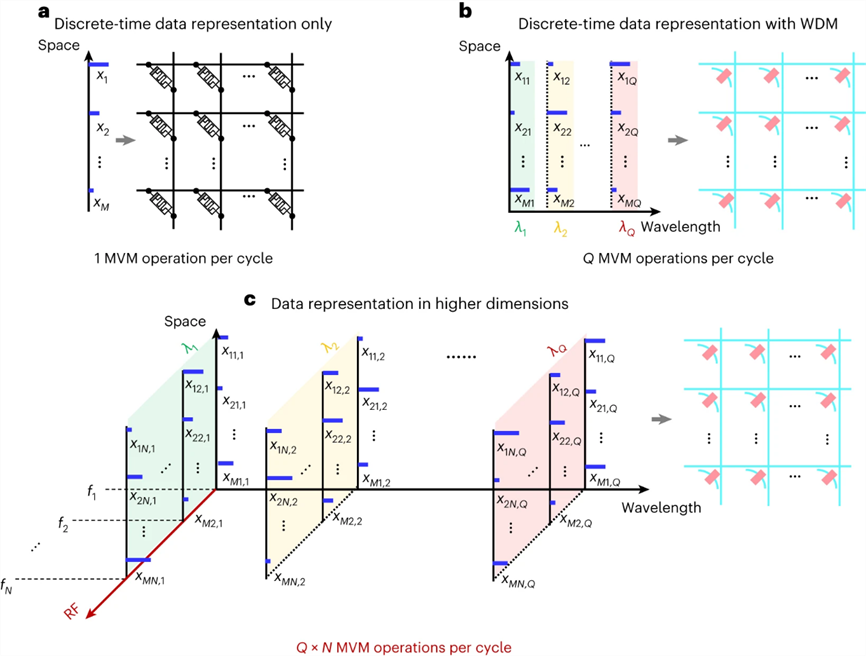

光子系统可以利用大量(>106)并行空间模式。在约2.5cm−2的面积上使用>108个空间模式的消费电子产品已经实现,这说明在实践中可以实现大规模并行。在10月19日发表在《自然·光子学》的论文中,通过引入对光子信号的射频调制来提高并行化程度,在空间分布式非易失性存储器和波长复用的同时,为数据增加了一个额外的维度;利用高维处理技术将这种系统配置为与边缘计算框架兼容的架构,通过验证光域连续时间数据计算的可行性,牛津大学Harish Bhaskaran团队为提高光子处理器的并行性提供了另一条途径:系统实现了100的并行性:比仅使用空间和波长自由度的实现高出两个数量级。

这些初步预测提供了一个诱人的前景:即使对输入和输出参数进行明智的调整,这种前卫的方法也能产生令人难以置信的100倍能效放大效果,从而使现有最先进的电子处理器的性能黯然失色。最重要的是,100倍的并行性并不是上限;如果允许更低的精度,则可以复用150个射频元件。通过使用16个波分复用通道,还可以实现2400倍的总体并行度,这表明单个系统可以同步处理来自2400个终端设备的信号;而目前使用具有低维处理能力的现有技术还无法实现这一点。

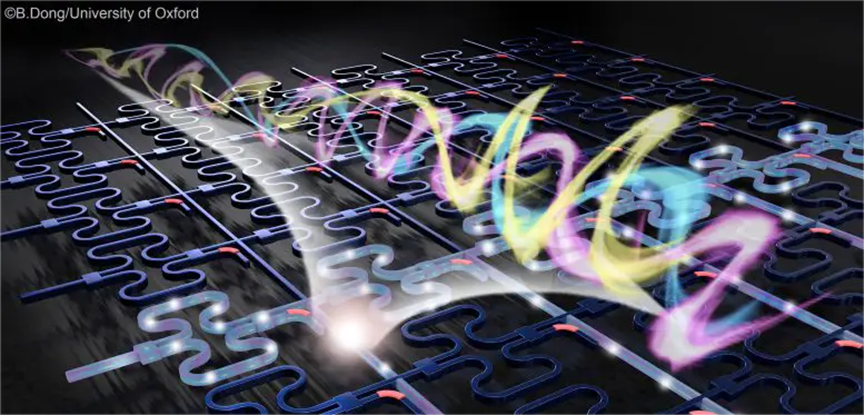

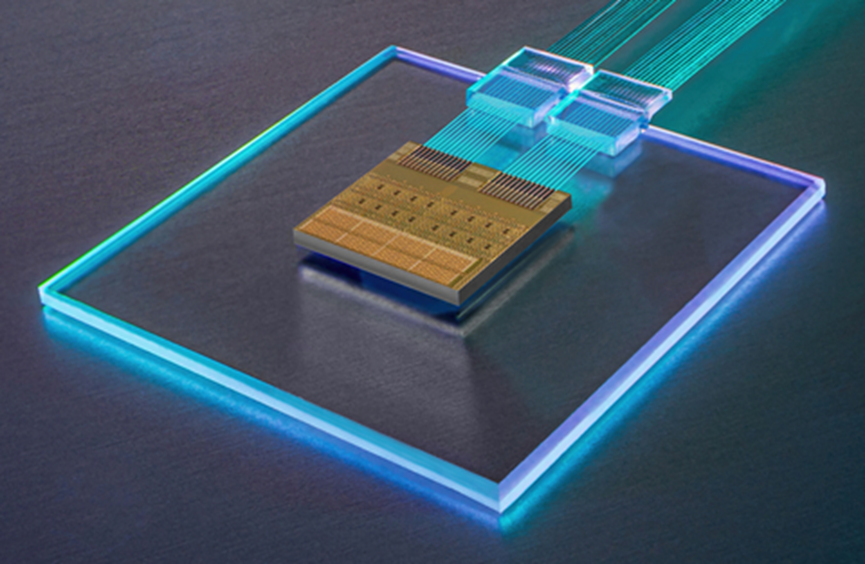

具有光和射频频率编码数据的光子芯片艺术效果图

牛津大学团队的高维光子内存计算。

多维度光子存算一体芯片示意图

如今,硅光子集成电路已在片上光学传感、量子光计算、光神经形态计算等领域应用,被视为下一代计算系统的候选技术;它能提升光电传输的速度,解决目前计算机元件使用铜导线所遇到的讯号耗损及热量问题,因此台积电、英特尔等多间半导体巨头已经投入相关技术研发。然而目前硅光子逻辑器件插入损耗较高,多个器件串联使用会产生较大光衰减;为缓解相关问题,不同实验室采用的代表性解决方案是相变材料(PCM)和Mach-Zender干涉仪(MZI)。

MZI光开关在平面内实现光学全互联,通过调节电压值实现MZI光开关的分光比,从而在芯片上加载可编程的权重矩阵。该方案中某一层的一个神经元能连接到的邻层神经元的数量有限、MZI布线特点导致可扩展性差;相移器是热光控制的,能量损耗较大。尽管MZI架构正被大多其他公司采用,这些都是后续发展需要着重考虑的技术问题。

相变材料(PCM)是由锗、硒、锑等具有半导体特性的材料掺杂而成的合金材料,不同配比和工艺生产下的系列相变材料被广泛应用于工业界。相较于纯硅材料,相变材料是一种更好的调制材料,(实现同等甚至更好调制效果下)芯片面积和所需调制电极数量仅为纯硅方案的1/10以下,极大提高了光芯片的集成度和可制造性;同时相变材料具有极佳的非易失存储特性,并且成本低廉;在这种情况下,相变不是指光,而是指材料的特性,当材料处于非晶态时,其透射率比晶态时更高。相变材料存在晶态和非晶态两种不同特性,当材料为非晶态时表现出高透过率,在其中传播的光波可通过;当材料为晶态时表现为低透射率,在其中传播的光波大多被材料吸收,无法通过。综合来看,应用于光的调制时,得益于相变材料的特性,结合器件、芯片结构和光调制的独特设计,基于相变材料的光计算技术路线优势更容易量化,相变材料数十年在工业领域的广泛应用已经证明了材料的可靠性、稳定性,而在光计算应用中仍需要突破对该材料持续、高效、可靠的调控。此次,牛津大学团队经过10年的耕耘和突破,通过相变光计算技术成功展示了可商用的光子内存计算架构,实现了光计算芯片在集成度、功耗、稳定性、时延等方面性能的全面提升,有望大大加速光计算芯片的商业化落地。

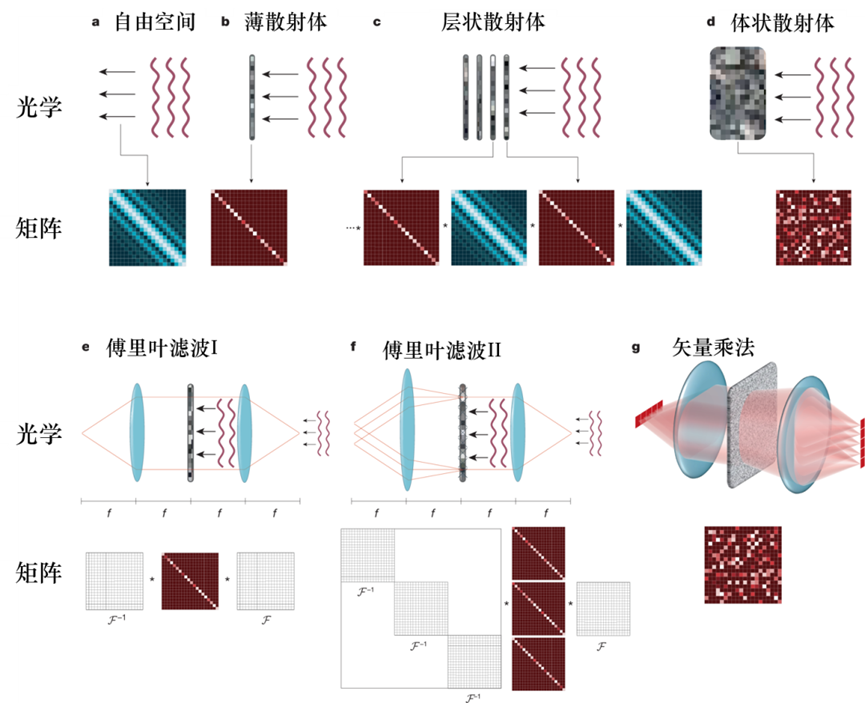

和硅光子计算(芯片)相对应的另一大光子电路的实现方式是空间光衍射计算(器件):直接在通过自由空间或某种介质传播的光场上建立计算能力。空间光计算的基础是范德•拉格特(Vander Lugt)于1964年提出的基于光学相关器的方法,计算是在空间滤波的基础上实现的,在系统焦平面上放置一个匹配滤波器,对输入光信号进行相位补偿,从而在输出平面上产生代表计算结果的光信号。这种方案存在一些后续还需重点考虑的问题,例如:像元太大,导致扇入扇出角度太小,连接性不强:短时间内还没办法做成高集成度;用空间光调制器加载矩阵元,功耗高、刷新慢;固定的介质材料不可调制;计算功能简单等。

光在不同介质中的传播及其对应的线性矩阵操作

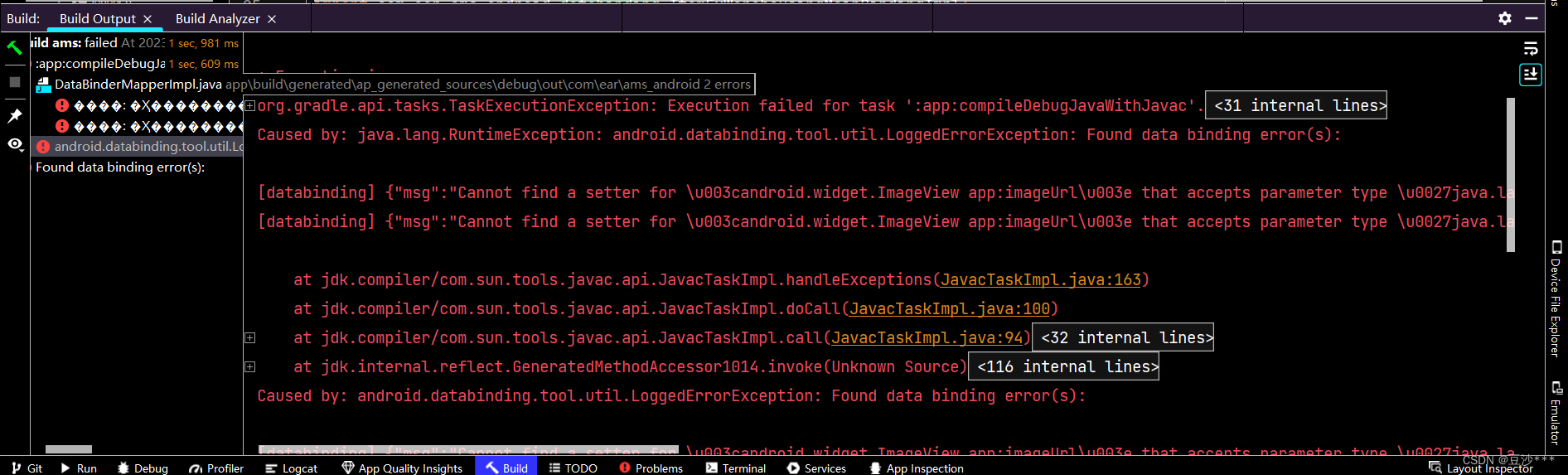

清华大学攻关团队创造性地提出的光电深度融合计算框架正属于这一领域。

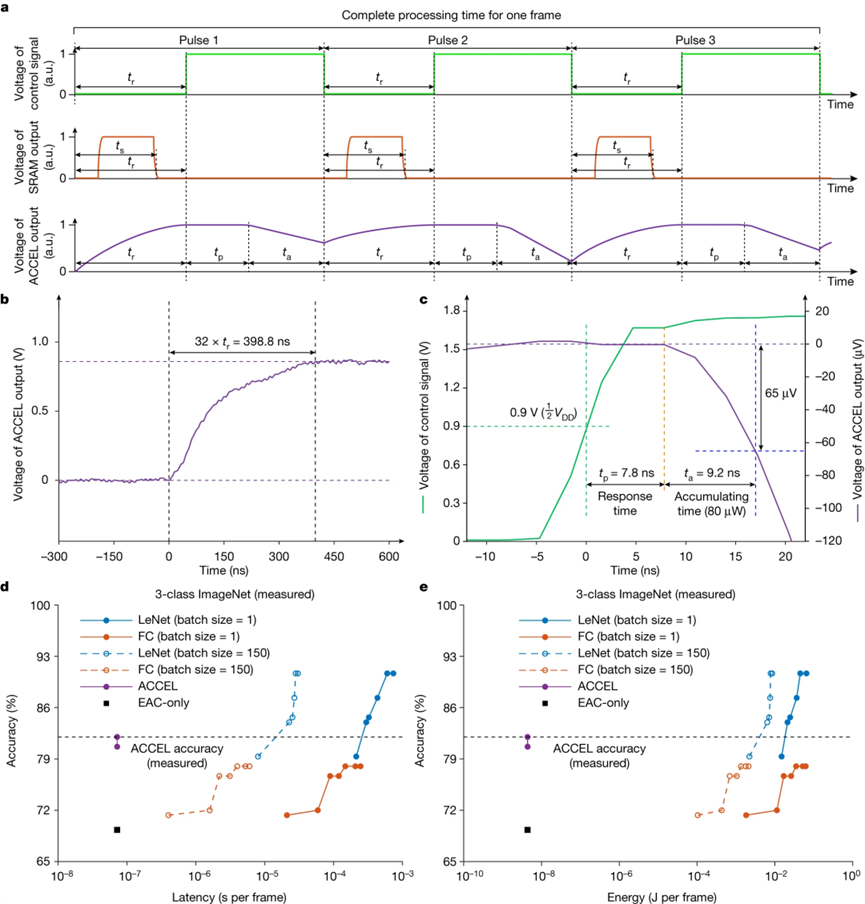

ACCEL的架构

在研发团队演示的智能视觉任务和交通场景计算中,光电融合芯片的系统级能效(单位能量可进行的运算数)实测达到了74.8 Peta-OPS/W,是现有高性能芯片的400万余倍。对此,研究人员表示:“形象来说,如果原本的电量可支持现有高性能芯片工作一小时,那么相同的电量供给下ACCEL芯片可以工作五百多年。”

对ACCEL处理时间和能耗的实验测量

清华大学研发团队的工作将空间光衍射计算和模拟电芯片集成在了一起,在实验中展示了光电模拟混合运算的优越性,在数据吞吐量、运算能效、运算延时方面均实现了大幅的提升,针对AI运算中的视觉任务(如卷积等),空间光衍射方案是一个很好的选择。

然而该方案所不具备的是,空间光计算的执行不可避免地需要一定路程的光传播,因此硬件尺寸还比较大,集成式光计算对于输入数据的尺寸和执行的线性运算没有明显的限制,在尺寸和集成度上也具备优势,运算可在微米尺度执行。同时,基于硅光平台的集成光计算具有可配置、可编程的优势,可满足大规模复杂AI计算,如大模型推理和训练;而空间光计算目前在光的部分仅能处理卷积任务,对其他类型的数据流(音频、文字等)缺乏处理能力。另外,从产业化成熟度来说,该方案需要考虑的问题还包括空间光调制器阵列的价格,以及验证该方案针对视觉信息处理之外任务的高效性。

此次,在两大团队提出的超高性能光学芯片下,“未来计算机”的诞生似乎已不再遥远。上述新型架构,不仅将开辟出这项未来技术通往日常生活的一条新路径,还对量子计算、存内计算等其他未来高效能技术与当前电子信息系统的融合深有启发。

或许这些芯片的出现,会让新一代计算架构,比预想中早得多地进入日常生活。

事实上,它们早已进入了我们的日常生活。

在过去几十年中,光学相关器件已多次作为商业产品发布,因此,即使在商业上,这也不是一个新方向,而是一个已焕发活力、生机盎然的领域。

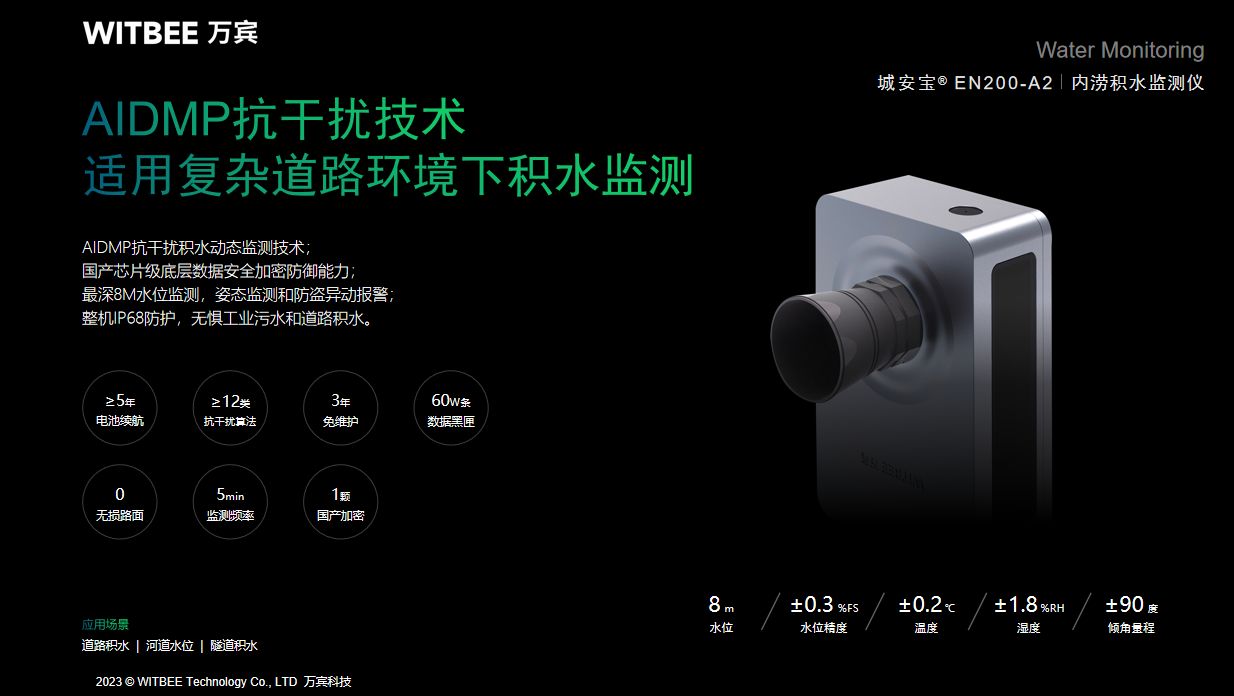

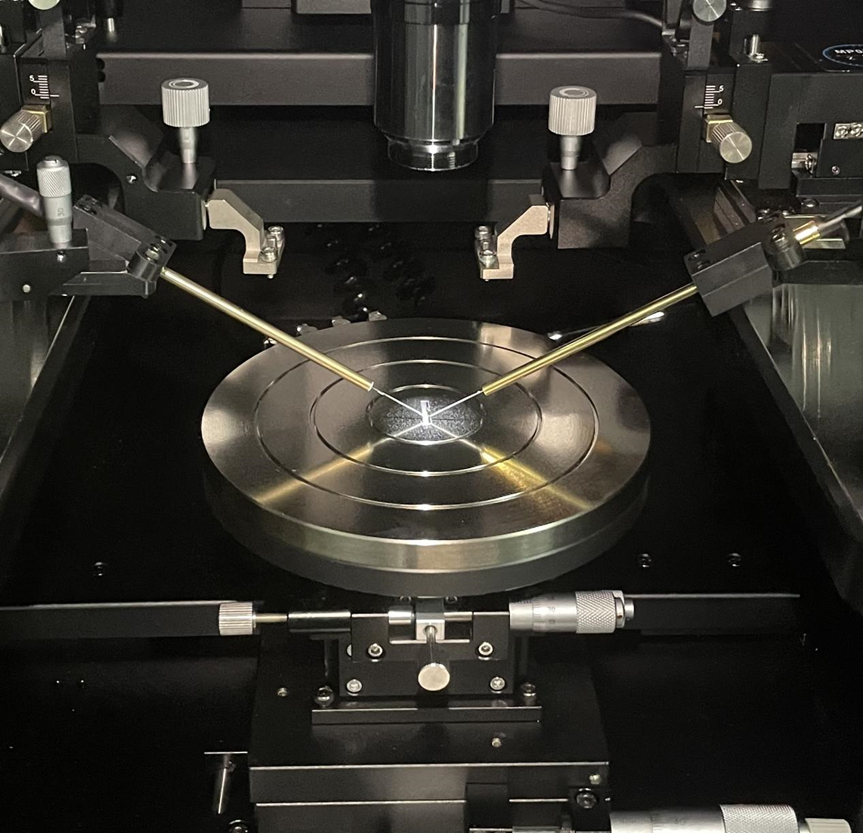

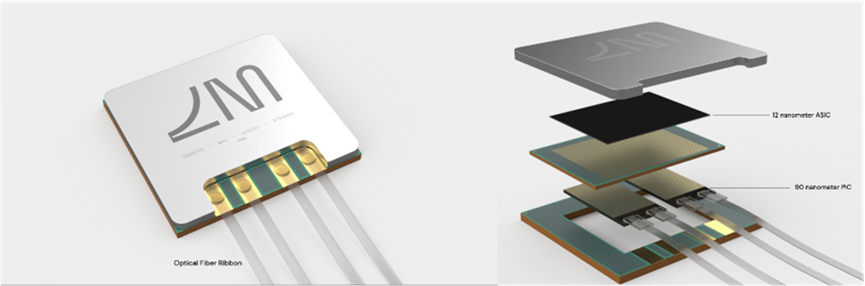

光本位科技成立于2022年,团队由来自牛津大学、复旦大学、芝加哥大学以及光通信、计算芯片等领域的资深专家组成,旨在研发大算力、低功耗的光子计算芯片,服务于大模型时代的AI推理和训练场景,开创数智时代的新算力范式。目前公司已获得超5000万元的天使轮融资并成功完成多次流片,完成光电合封并跑通算法。

光本位科技研发平台及芯片

目前,光本位科技已经与多家产业链上下游公司达成长期战略合作协议,围绕着将光计算快速全面产业化落地展开合作。光本位的创始人表示,用光在计算领域代替电,是一项需要集结大量产业链资源的系统性工程,而作为一家初创企业,必须具有极强的技术壁垒和独创性,才能得到产业链的支持;而光本位的核心技术则是运用相变材料技术路径单元尺寸小、能耗低的独特优势,快速将光计算做到128x128、256x256、512x512等满足商业化需求的大算力规模,而这些大规模芯片现在就可以做到端到端数十倍于英伟达AI芯片的性能,未来预期性能优势在当前电芯片的1000-10000倍,预计光本位的光计算产品将随着大模型的爆发和成熟快速走进人们的生活。

光本位的创始研发团队脱胎于牛津大学的Bhaskaran Lab。Bhaskaran Lab命名自牛津大学材料系教授、MPLS(Mathematical, Physical and Life Sciences Division)学部副院长Harish Bhaskaran,Bhaskaran教授致力于纳米相变材料的光电集成研究,是相变材料纳米光子学和相变光子计算的开创者和奠基人,推动了大算力、低功耗、高性能光子计算的科研产业化的进程。在加入牛津的10年时间里,在Nature(自然)和Science(科学)杂志的正刊及子刊发表18篇高影响力论文,累计被引用1万余次,主要研究方向为光子计算、光子存储、神经形态计算以及高性能相变材料。

2023年9月20日,牛津大学材料系教授、MPLS(Mathematical, Physical and Life Sciences Division)学部副院长Harish Bhaskaran当选英国皇家工程院院士,以表彰其在纳米材料应用和先进纳米工程技术方面的杰出贡献。此次当选英国皇家工程院院士,也表现出科研界和产业界对相变材料光学计算的极大认可。

而在光本位之前,也有不同公司对光计算做出了商业化的尝试和积累。

基于麻省理工学院MZI技术路径的Lightelligence(曦智科技)成立于2017年,在美国波士顿和中国上海等地设有办公室,并于四年后发布了一款名为PACE的芯片,包含约1万个光子设备和一个提供控制和记忆的微电子芯片。PACE的单个芯片上有约12,000个光子器件,目前完成了特定的伊辛模型的演示,速度优于Nvidia 的RTX 3080。据悉,在发布光计算原型机PACE后,Lightelligence目前正大力投入于光互连、光通信等领域。

PACE光计算原型机

与此同时,Lightmatter的新型人工智能芯片也在业界引起了关注。根据该公司网站的介绍,Envise运行最大神经网络的推理次数/秒比英伟达DGX-A100高三倍,在BERT-Base上使用SQuAD数据集的推理次数/秒/瓦特比英伟达DGX-A100高七倍。今年5月,Lightmatter获得1.54亿美元的C轮投资,为客户提供光子产品。

Lightmatter Envise光学处理器芯片

2022年,惠普企业与光子计算初创企业Ayar Labs签署了一项多年期战略合作协议,通过开发基于光I/O技术的硅光子解决方案,加快计算系统和数据中心的网络性能。随后不久,有消息称Ayar Labs从惠普企业(HPE)和英伟达(Nvidia)和英特尔资本在内的多个新老金融投资者那里获得了1.3亿美元的额外资金。

2023年3月,Ayar Labs展示业界首款4-Tbps光学解决方案

成立于2018年的以色列Cognifiber公司采用新颖方式解决光电互联。该方案完全放弃了硅光子学,转而采用多芯光纤形式的玻璃。这个想法是利用核心之间的干扰来模拟多层神经网络中神经元和突触之间的相互作用。

日本NTT正在建造精密的光学计算机

日本NTT公司也在开发一种光学计算机,据信它在解决优化问题方面的性能将超过量子计算。至今,中国量子物理学团队也宣布了多项基于光的量子计算成就。美国霍尼韦尔公司和IonQ公司等其他公司也在利用捕获离子来解决这一问题。

整体而言,全球光子计算芯片产业刚刚起步、市场潜力巨大,掌握核心技术和深谙产业规律的先行者们,将引领着我国加速走向换道超车的光算时代。

随着商业化的逐步推进,我们在近边缘计算和数据中心中已经看到了光子计算可实现的应用。这意味着,有了近边缘计算能力,零售店中支持5G的物联网设备可以计算并存储其产生的部分数据,而不是将所有原始数据传输到遥远的数据中心;这可以利用光子计算的低延迟、低传输损失优势。

相较于电子计算而言,光子计算的能效比大幅提升,在同等主频和功耗下,光子计算的计算通量是电子计算的100倍以上,这意味着能耗的极大降低,粗略匡算下可为数据中心每年节省70%以上的电耗,相当于节约数亿元的电费。

随着AI、云计算等大规模、高算力场景需求的快速增长,光子计算芯片的性能还有极大的提升空间,以更快弥补全球供不应求的AI算力空缺。当电子芯片产业受到美国的多轮制裁后,我们不仅面临着尖端AI芯片的直接断供,还面对着高端制造设备、设计软件等全方位的产业链紧缺,而当电子芯片摩尔定律的瓶颈降临,这一发展限制无异于雪上加霜,电子芯片可能已经到达性能极限。

而对于光子计算来说,未来还有波分复用、频分复用等方式,可以实现成百上千倍的性能提升,我们可以简单想象为“光的摩尔定律”,它刚刚开始。而实现一个接近完美的光子计算产品,难度比我们想象中低的多:仅依靠CMOS产线改造而成的180nm/130nm制程产线即可完成流片,整体制造成本比电芯片低80%以上。

尽管存在技术上的困难,各种集成光子计算制度已经被提出并应用于解决NP难题或执行机器学习任务。考虑到长期发展,大规模可重构光子电路是必不可少的。大规模计算中光信号的衰减可能对计算结果产生重大影响,为解决上述限制,单光子探测器和量子探测技术的应用可能会大大增强现实中可以处理的光子计算的规模。通过科学界和产业界的不懈努力,在可预见的未来,光学计算会快速提高集成度和计算性能,并和电子计算有效配合、极大提高混合计算系统的综合性能。

随着信息时代和人工智能时代的到来,发达的光子技术和先进的量子技术为光基计算开启了新的篇章,将光学计算带入了竞赛。这样看来,“光进铜退”或许正是自然发展的趋势。

当下,地缘政治动荡、整体贸易和经济活动急需新一轮科技产业变革。在我国,老一辈科学家龚祖同、钱学森等早在70年代末就频频发出呼吁,希望大家积极开展光子学的学科建设。钱学森教授提出,“光子学是与电子学平行的科学”,他还首次提出了“光子学―光子技术―光子工业”的关于光子学的发展模式。如今,我国中科院西安光机所、中科院微电子所、中科院半导体所、上海微系统所和复旦大学、上海交大、清华大学、浙江大学、华中科技大学等都进行了长期研究,国家针对光子集成技术也实施了一系列重大研究计划,在光子集成技术方面已经取得了很大的成就。

自然发展的规律,科技发展的趋势都是有迹可循的,光对电的替代是一种“降维打击”,并已经在人类生活的各个角落完成了代替和超越。光计算在过去十年的科研和产业的发展,奠定了光计算从现在开始,在未来数年内将迎来全面产业化落地和爆发。

参考链接:

[1]https://www.bis.doc.gov/index.php/about-bis/newsroom/2082

[2]https://readwrite.com/the-rise-of-photonics-in-computing-next-big-thing-for-deeptech-vcs/

[3]https://www.nature.com/articles/s42254-023-00645-5#citeas

[4]https://www.hindawi.com/journals/aot/2010/372652/

[5]https://ieeexplore.ieee.org/document/652905

[6]https://www.nature.com/articles/s41566-023-01313-x

[7]https://www.nature.com/articles/s41566-023-01217-w

[8]https://www.nature.com/articles/s41586-023-06558-8

[9]https://www.scientific-computing.com/article/can-photonics-deliver-next-breakthrough-research-computing-0

[10]https://www.eejournal.com/article/are-we-poised-to-turn-the-optical-computing-corner/

[11]https://news.cnstock.com/industry,rdjj-202308-5101848.htm

[12]https://www.optica-opn.org/home/industry/2022/may/ayar_labs_bets_on_optical_i_o_for_next-gen_computi/

[13]https://www.optica-opn.org/home/articles/volume_34/january_2023/features/photonic_computing_for_sale/?src=hptopstories

[14]https://www.nature.com/articles/s42254-023-00645-5

[15]https://mp.weixin.qq.com/s/1FJnMQm3cmGOb40T-PPmJg

[16]https://opt.cas.cn/kpyd/gxqy1/gxlw1/201110/t20111007_3359009.html

[17]https://lw.news.cn/2022-01/10/c_1310416707.htm

[18]https://arxiv.org/abs/2305.15820

[19]https://nanoeng.materials.ox.ac.uk/people/harish-bhaskaran

[20]https://nanoeng.materials.ox.ac.uk/home

[21]https://mp.weixin.qq.com/s/1Gs2o5BRS5o8uwh2NCQKzQ

[22]https://mp.weixin.qq.com/s/MsL1MKanuRZH6BrSqHUyuQ

[23]https://www.nature.com/articles/s41586-020-2973-6

[24]https://mp.weixin.qq.com/s/f5zQQNRBOUOZ_ETjZc6WFQ