一、非线性假设

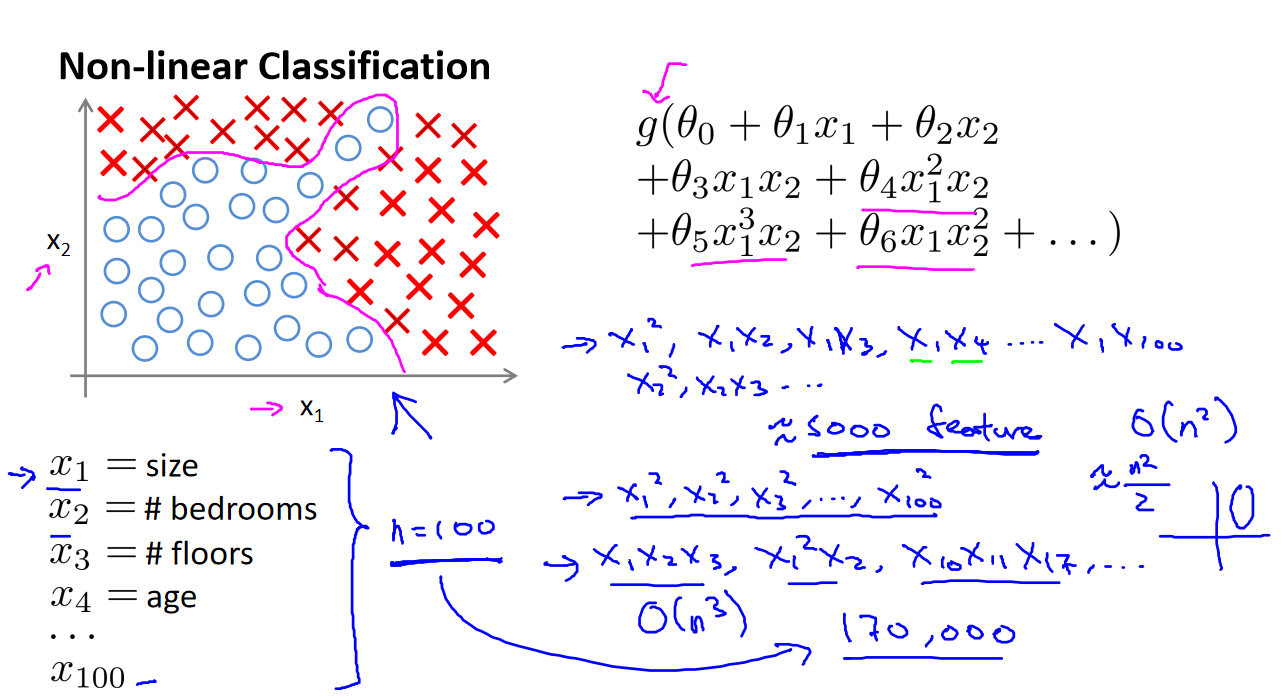

在之前学到的线性回归和逻辑回归中,存在一个缺点,即当特征数量很多时,计算的负荷会变得非常大。考虑一个例子,假设我们使用 𝑥₁, 𝑥₂ 的多项式进行预测,这时我们可以很好地应用非线性的多项式项,帮助建立更好的分类模型。

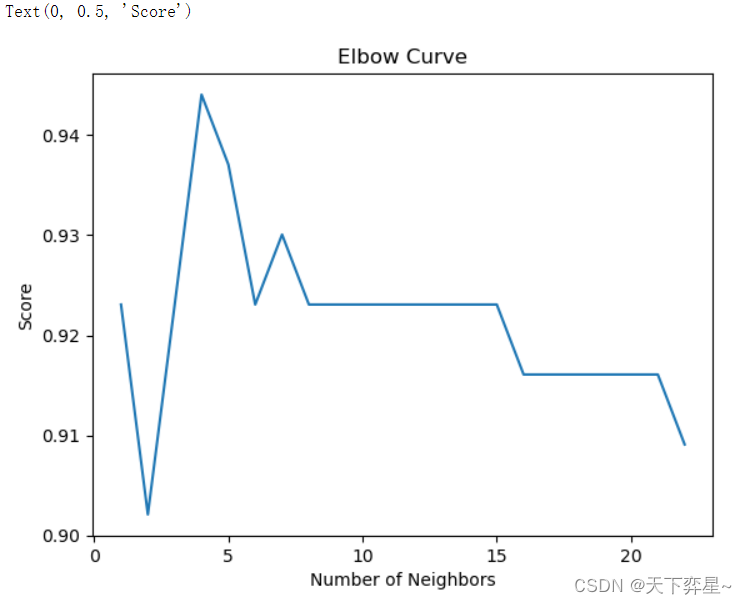

特征爆炸问题: 假设有大量特征,比如超过 100 个变量,我们希望用这些特征构建一个非线性的多项式模型,将导致大量惊人的特征组合。即便我们只采用两两特征的组合(如𝑥₁𝑥₂ + 𝑥₁𝑥₃ + 𝑥₁𝑥₄ + ... + 𝑥₂𝑥₃ + 𝑥₂𝑥₄ + ... + 𝑥₉₉𝑥₁₀₀),也会有接近 5000 个组合而成的特征。对于普通的逻辑回归来说,计算这么多特征是非常困难的。

解决方法: 当需要处理大量特征时,尤其是在图像识别等领域,普通的逻辑回归模型可能无法有效处理。此时,我们可以借助神经网络来解决这个问题。

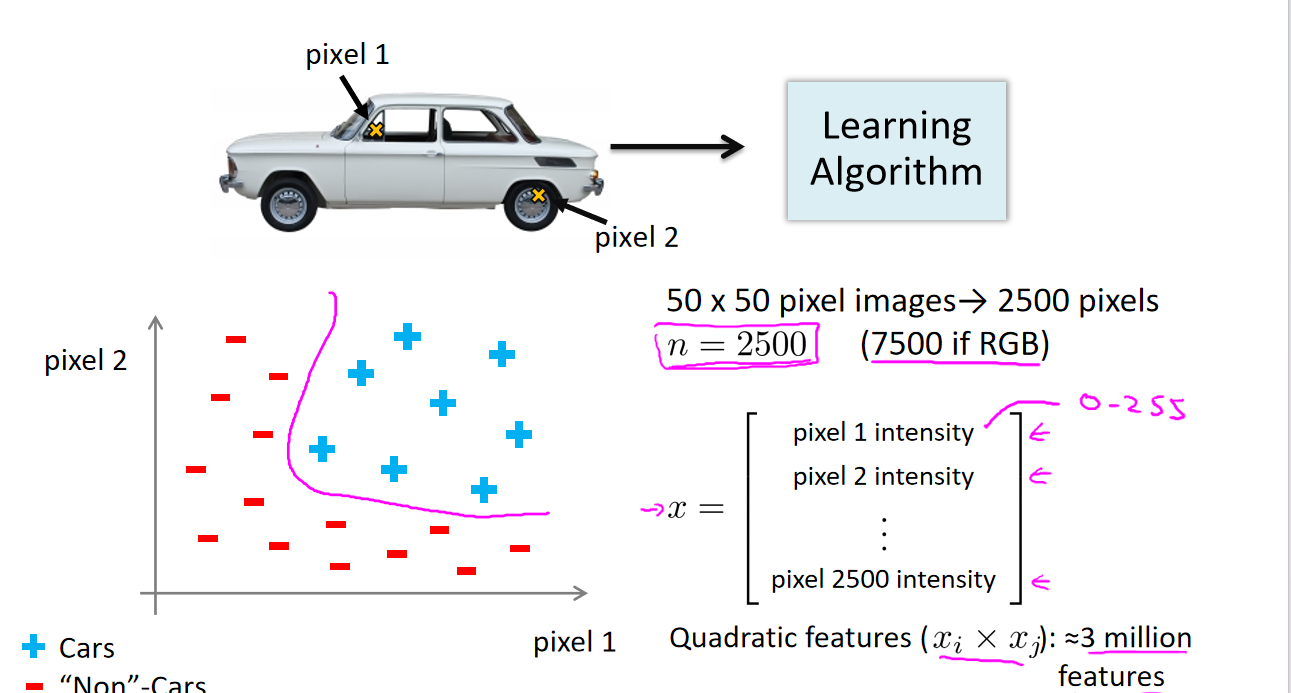

图像识别示例: 假设我们要训练一个模型来识别视觉对象,比如判断一张图片上是否是一辆汽车。一种方法是利用大量汽车和非汽车的图片,然后使用每个像素的值(比如饱和度或亮度)作为特征。如果我们使用灰度图片,每个像素只有一个值,而不是 RGB 值,对于 50x50 像素的小图片,就会有 2500 个特征。如果考虑两两特征的组合构成多项式模型,就会有约 3 百万个特征。普通的逻辑回归模型难以处理如此庞大的特征数量,因此我们需要使用神经网络。

二、神经元和大脑

神经网络是一个古老的算法,最初被设计用于模拟大脑。在这门课中,我们将介绍神经网络,并探讨它在解决不同机器学习问题上的优越性。在这段视频中,我们将了解一些神经网络的背景知识,以便了解它们能够解决哪些问题,不仅仅是在逻辑上是否可行。我们将深入探讨神经网络涉及的问题,以及它们如何应用于现代机器学习问题和其他令人感兴趣的领域。

神经网络最初在20世纪80年代和90年代逐渐兴起,并被广泛应用。然而,由于计算量大等原因,在90年代后期应用有所减少。近年来,随着计算机运行速度的提升,大规模神经网络的真正运行变得可能。因此,神经网络现在是许多应用中最先进的技术之一。

神经网络的产生源于对模仿大脑算法的尝试。如果我们想要构建学习系统,为什么不模仿人类大脑呢?大脑具有惊人的学习能力,可以通过看而不是听的方式处理图像,处理触觉,并学习各种不同的事情,包括数学和微积分。如果我们能够找到一种学习算法,使得大脑可以处理不同类型的数据而不是运行上千个不同的程序,那将是非常有趣的。

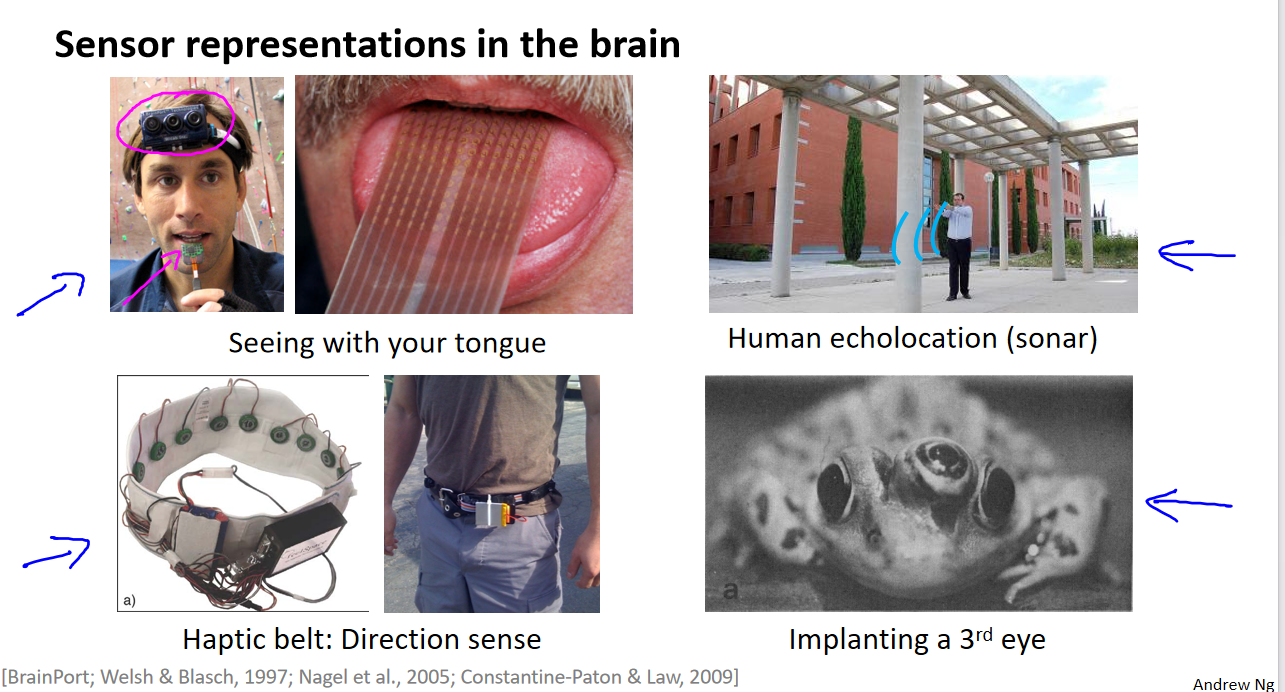

神经科学家进行了一些有趣的实验,如神经重接实验。在这些实验中,他们切断了从耳朵到听觉皮层的神经,然后重新将其连接到动物的大脑上。结果显示,听觉皮层可以学会“看”,即完成视觉辨别任务。类似的实验也表明,其他脑区域也可以学会处理不同类型的感知,如触觉。

这些实验证明了一个假设:如果将几乎任何传感器连接到大脑的几乎任何部位,大脑都能学会处理这些数据。因此,我们可以推测,存在一种学习算法,可以同时处理视觉、听觉和触觉,而不需要运行上千个不同的程序或算法。

神经网络的应用不仅限于仿真大脑,而且在现代机器学习中也非常有效。

参考资料:

[中英字幕]吴恩达机器学习系列课程

黄海广博士 - 吴恩达机器学习个人笔记