开放领域问答机器人是一种智能机器人,它不受限制,可以回答任何问题。这种机器人主要通过自然语言处理技术来理解用户的问题,并从大量的数据中获取相关信息,以提供准确的答案。它的应用领域广泛,包括客户服务、教育、医疗等,可以帮助人们解决各种问题,提高工作效率和生活质量。

开放领域问答机器人的优势在于它可以回答任何问题,不受领域限制,用户可以自由地提出任何问题,而不需要担心机器人无法回答或者回答不准确。此外,它还可以通过不断地学习和优化算法来提高自身的智能水平,为用户提供更加准确和有用的答案。

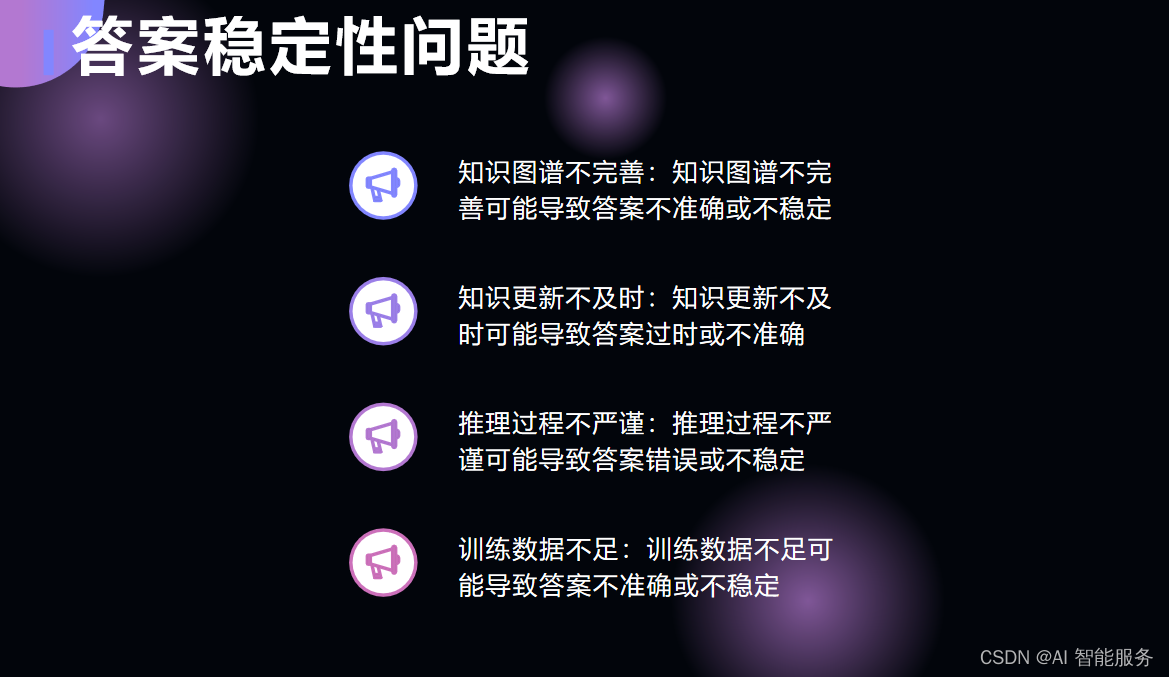

然而,开放领域问答机器人也存在一些挑战和限制。首先,由于其需要处理大量的信息和数据,因此需要强大的计算能力和存储能力。其次,由于其需要理解自然语言并提取相关信息,因此需要先进的自然语言处理技术和算法。最后,由于其需要不断学习和优化算法,因此需要大量的数据和人力资源。

1.开放领域问答

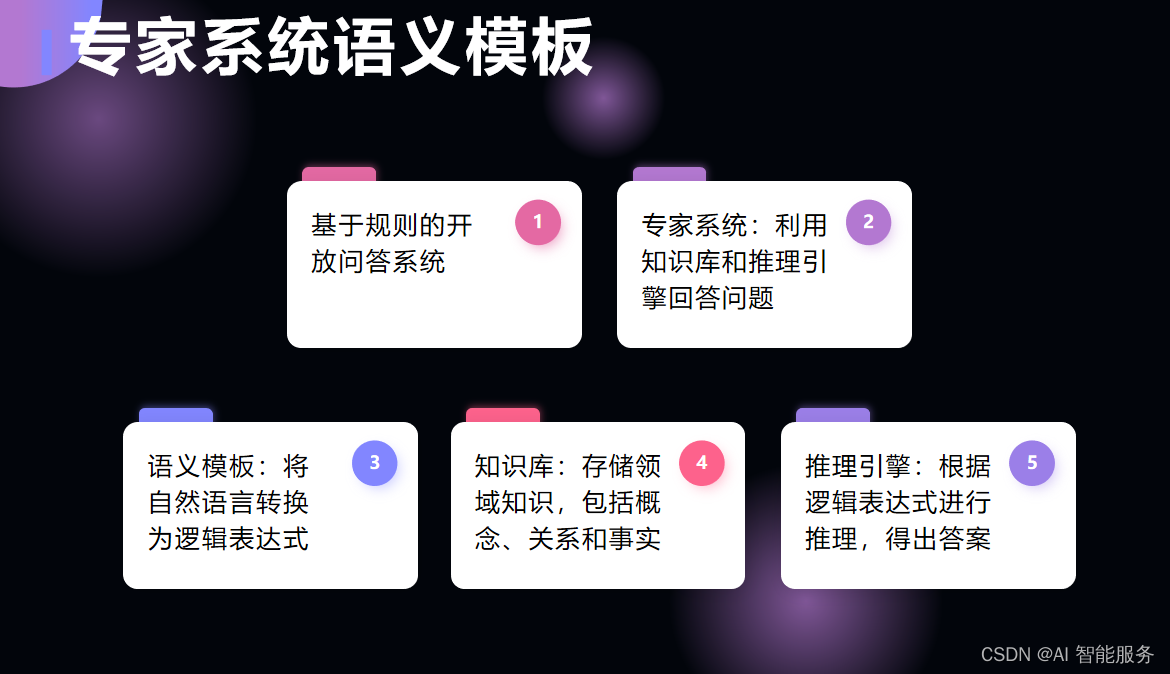

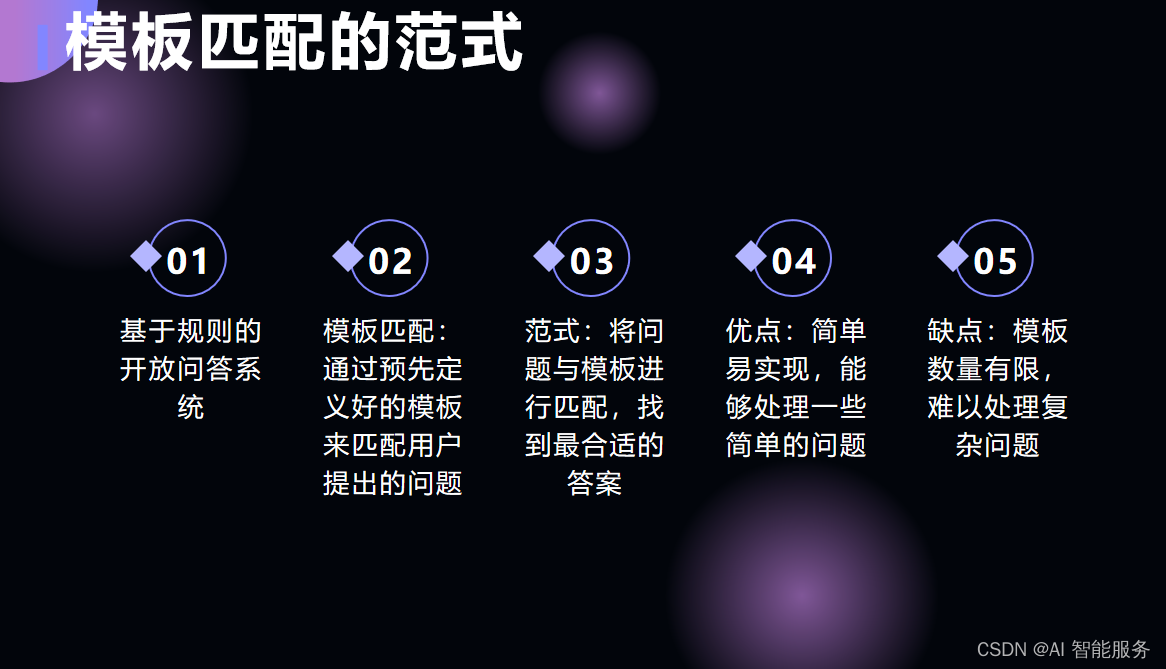

1.1早期基于规则的开放问答系

开放领域问答机器人的技术特点主要包括:

- 自然语言处理:机器人能理解和分析用户提出的问题,并生成相应的回答。

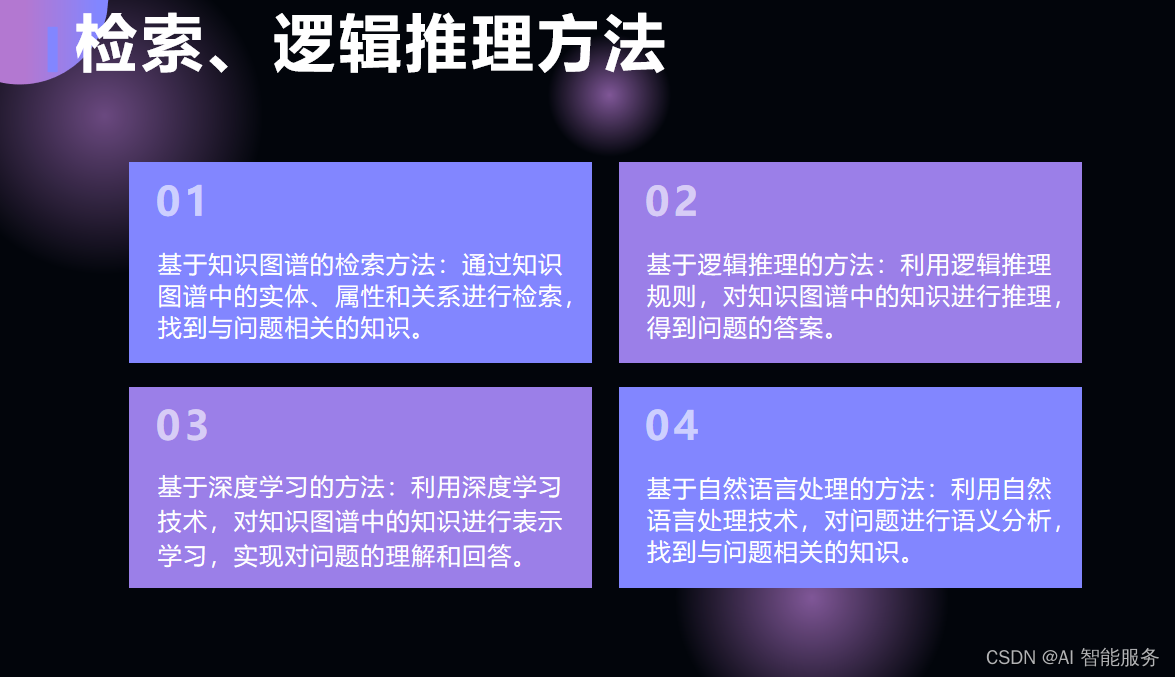

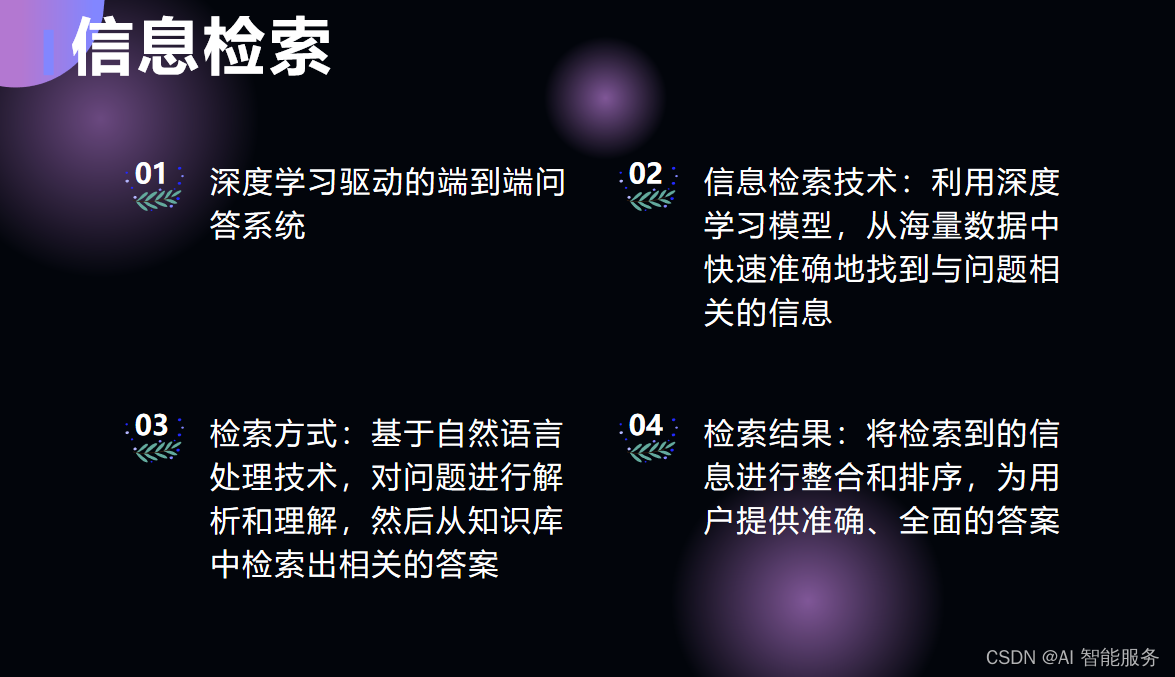

- 信息检索:基于大数据和知识图谱等技术,机器人能从海量的数据中检索相关信息,为用户提供准确的答案。

- 机器学习:通过机器学习算法,机器人能不断优化自身的回答能力,提高回答的准确性和智能性。

- 对话管理:机器人具备对话管理能力,能够根据用户的意图和上下文进行多轮对话,并实现信息的持续交流和传递。

这些技术特点使得开放领域问答机器人能够有效地回答各种问题,并在不断的学习和优化中提高自身的智能水平。

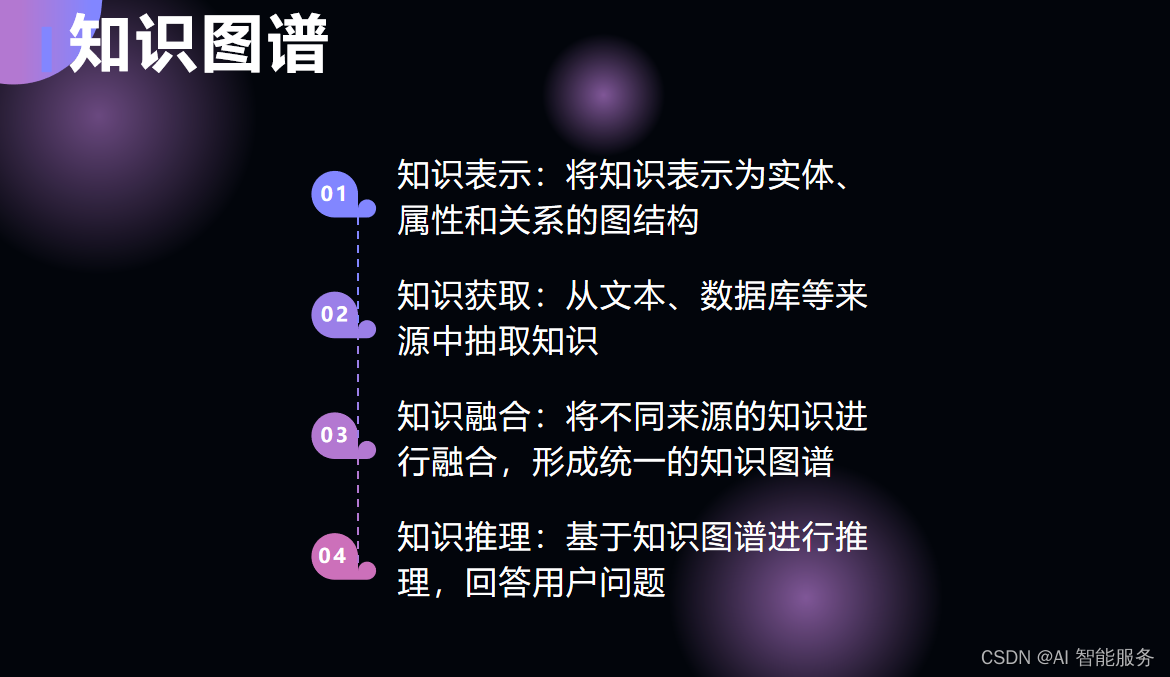

1.2基于知识图谱的问答系统

1.3深度学习驱动的端到端问答

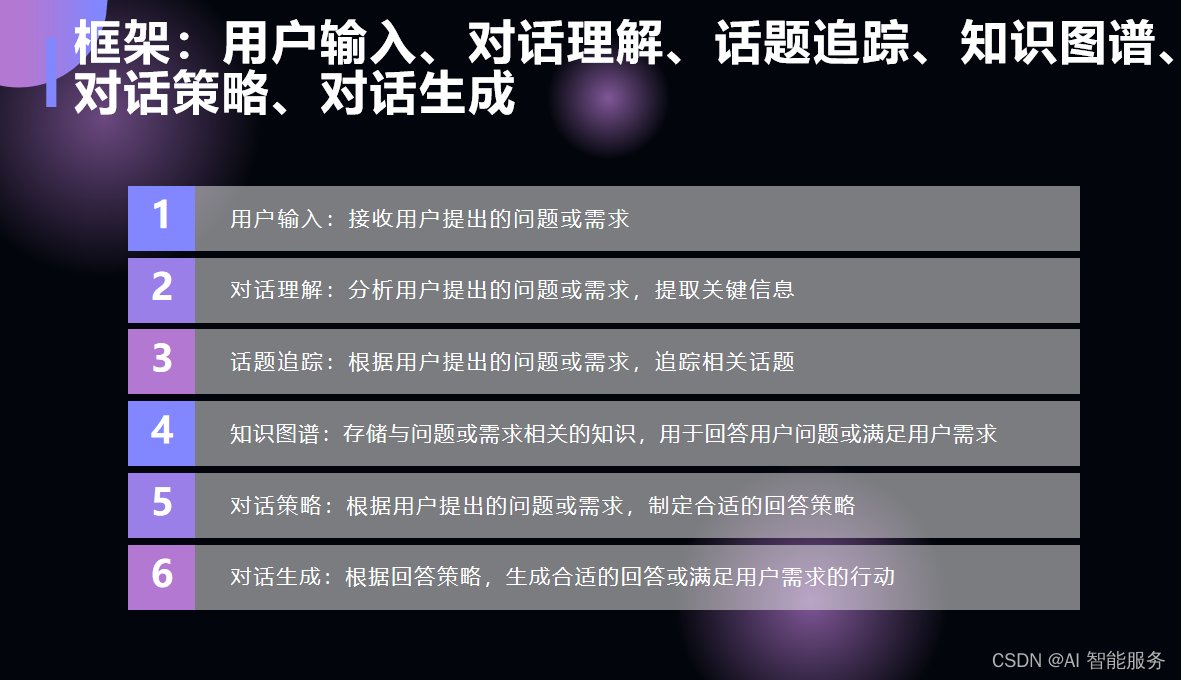

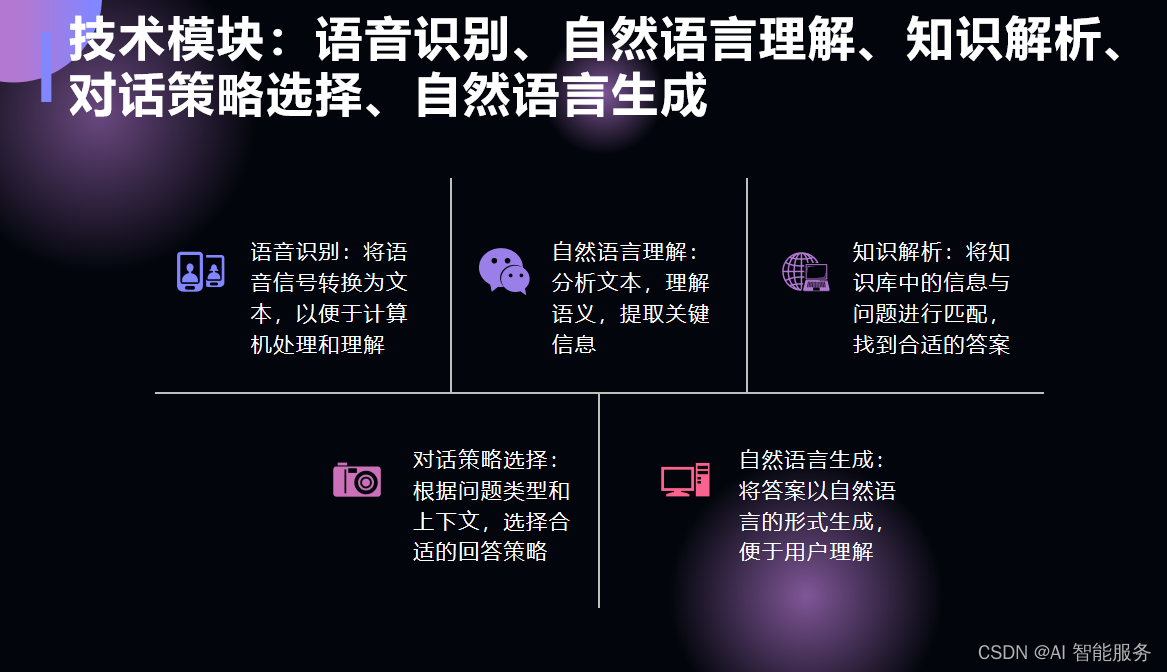

2.问答机器人的框架和技术模块

开放域问答系统(Open-Domain Question Answering System)的框架通常包括以下部分:

- 自然语言处理(NLP):这包括文本预处理、分词、词性标注、命名实体识别(NER)、依存句法分析等,以理解和处理用户的自然语言问题。

- 意图识别:识别用户问题的意图,例如查询事实、寻找建议、解决问题等。这有助于确定问题的类型以及需要从哪些数据源中检索信息。

- 信息检索:从大规模的语料库或知识库中检索与用户问题相关的信息。这可能涉及使用搜索引擎、文本匹配算法或其他信息检索技术。

- 答案生成:对检索到的信息进行理解和处理,生成简洁、清晰和符合用户需求的答案。这可能涉及使用文本生成算法、自然语言生成(NLG)等技术。

- 对话管理:通过对话的方式与用户交互,理解用户的反馈和需求,持续提供回答直到满足用户的需求。这可能涉及使用对话管理算法、机器学习等技术。

- 知识图谱:构建和维护一个大规模的知识图谱,以存储和组织大量的知识和信息。这可能涉及使用本体论、语义网等技术。

- 大规模数据处理:处理和存储大量的数据,包括原始文本、结构化数据、图像等。这可能涉及使用分布式计算、云计算等技术。

- 模型优化和持续学习:通过机器学习和其他优化技术,不断优化系统的性能和准确性。这可能涉及使用深度学习、强化学习等技术。

这些组成部分共同构成了开放域问答系统的框架,每个部分都扮演着关键的角色,以确保系统能够有效地回答各种自然语言问题。

3.使用Python搭建一个开放领域问答机器人

要使用Python搭建一个开放领域问答机器人,您需要掌握以下技术:

- 自然语言处理:使用Python的自然语言处理库,如NLTK、spaCy等,对用户提出的问题进行理解和分析。

- 信息检索:使用Python的信息检索库,如Elasticsearch、Solr等,从海量的数据中检索相关信息。

- 机器学习:使用Python的机器学习库,如Scikit-learn、TensorFlow等,对检索到的信息进行分类和排序,以生成准确的答案。

- 对话管理:使用Python的对话管理库,如Dialogflow、Rasa等,对用户的问题进行意图分析和上下文管理,实现多轮对话。

以下是一个简单的开放领域问答机器人的Python代码示例:

import nltk

from nltk.corpus import stopwords

from nltk.tokenize import word_tokenize, sent_tokenize

from nltk.stem import WordNetLemmatizer

import pandas as pd

import re

import string

import requests

from bs4 import BeautifulSoup

# 配置自然语言处理库

nltk.download('punkt')

nltk.download('stopwords')

nltk.download('wordnet')

nltk.download('nltk')

# 定义问题分类器

class QuestionClassifier(object):

def __init__(self):

self.stop_words = set(stopwords.words('english'))

self.word_tokenizer = word_tokenize

self.lemmatizer = WordNetLemmatizer()

self.pattern = re.compile(r'\b\w+\b')

self.url = 'https://www.example.com'

self.headers = {'User-Agent': 'Mozilla/5.0'}

self.df = pd.DataFrame(columns=['title', 'content'])

self.load_data()

def load_data(self):

response = requests.get(self.url, headers=self.headers)

soup = BeautifulSoup(response.text, 'html.parser')

for link in soup.find_all('a'):

title = link.text.strip()

if title not in self.stop_words:

self.df = self.df.append({'title': title}, ignore_index=True)

content = link['href'].strip()

if content not in self.stop_words:

self.df = self.df.append({'content': content}, ignore_index=True)

def classify(self, question):

tokens = self.word_tokenizer(question)

pos_tags = nltk.pos_tag(tokens)

stemmed_tokens = [self.lemmatize(token[0], pos) for token, pos in pos_tags]

vector = [self.pattern.search(token) is not None for token in stemmed_tokens]

result = self.df[self.df['title'].apply(lambda x: self.match(vector, x))]

if result.empty:

return None, None

else:

return result['title'].values[0], self.url + result['content'].values[0]

def match(self, query, doc):

return bool(query & doc)

def lemmatize(self, word, pos):

return self.lemmatizer.lemmatize(word, pos)

![[C++随笔录] 红黑树](https://img-blog.csdnimg.cn/d0b5d8ae5e924023b4a115816862b588.png)