OpenAI发布会

- 写在最前面

- 发布会内容

- GPT-4 Turbo 具有 128K 上下文

- 函数调用更新

- 改进了指令遵循和 JSON 模式

- 可重现的输出和对数概率

- 更新了 GPT-3.5 Turbo

- 助手 API、检索和代码解释器

- API 中的新模式

- GPT-4 Turbo 带视觉

- DALL·E 3

- 文字转语音 (TTS)

- 收听语音样本

- 模型定制

- GPT-4 微调实验访问

- 自定义模型

- 更低的价格和更高的费率限制

- 更低的价格

- 更高的速率限制

- 版权保护

- Whisper v3 和一致性解码器

- 英文原文

- GPT-4 Turbo with 128K context

- Function calling updates

- Improved instruction following and JSON mode

- Reproducible outputs and log probabilities

- Updated GPT-3.5 Turbo

- Assistants API, Retrieval, and Code Interpreter

- New modalities in the API

- GPT-4 Turbo with vision

- DALL·E 3

- Text-to-speech (TTS)

- Listen to voice samples

- Model customization

- GPT-4 fine tuning experimental access

- Custom models

- Lower prices and higher rate limits

- Lower prices

- Higher rate limits

- Copyright Shield

- Whisper v3 and Consistency Decoder

写在最前面

突然发现chatgpt不能用了,真的是干啥都感觉怪怪的

在与朋友交谈后,才得知chatgpt昨天已经无法使用,据说是遭到了黑客攻击。

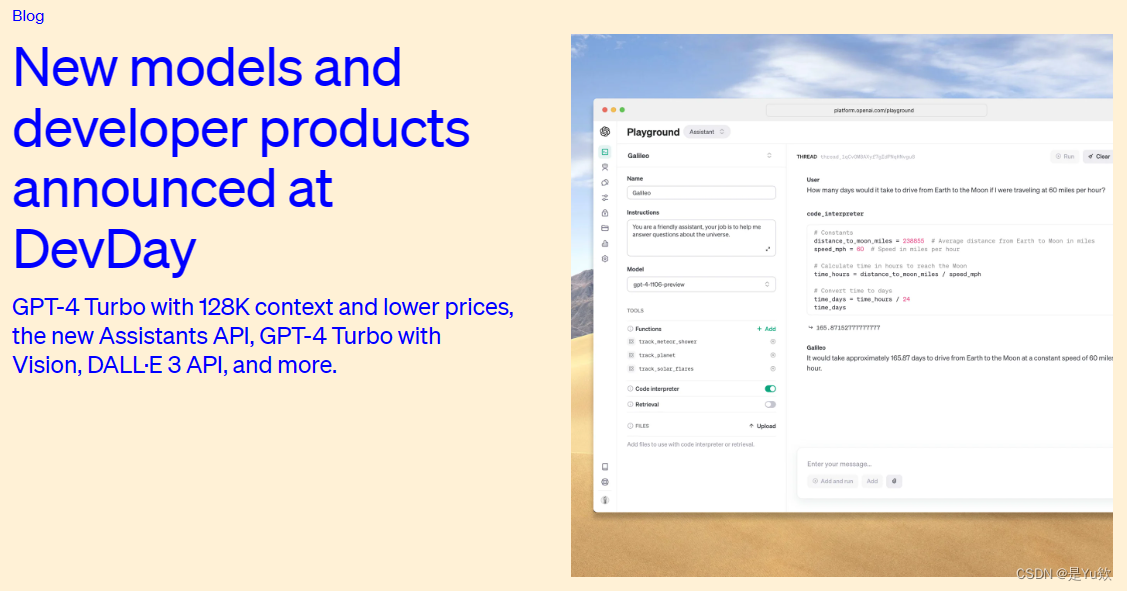

2G网连通后,发现11.6OpenAI开了新增功能和改进发布会

赶紧找到了英文原文,一起来看看发布会上都有哪些内容吧!

感兴趣的朋友还可以去看看:【全程回顾】OpenAI 首届开发者大会

发布会内容

- 2023年11月6日

- 作者 OpenAI, 公告, 产品

今天,我们分享了数十项新增功能和改进,并降低了平台许多部分的定价。这些包括:

- 新的 GPT-4 Turbo 模型功能更强大、更便宜并支持 128K 上下文窗口

- 新的助手 API,使开发人员能够更轻松地构建自己的辅助 AI 应用,这些应用具有目标,可以调用模型和工具

- 平台中新的多模态功能,包括视觉、图像创建(DALL·E 3) 和文本转语音 (TTS)

我们将从太平洋时间今天下午 1 点开始向 OpenAI 客户推出新功能。

详细了解 ChatGPT 的 OpenAI DevDay 公告.

GPT-4 Turbo 具有 128K 上下文

我们在 3 月发布了 GPT-4 的第一个版本,并在 7 月向所有开发者正式发布了 GPT-4。今天,我们将推出该模型的下一代预览,GPT-4 涡轮增压.

GPT-4 Turbo 功能更强大,并且对 2023 年 4 月之前的世界事件有所了解。它有一个 128k 的上下文窗口,因此它可以在单个提示中容纳相当于 300 多页的文本。我们还优化了其性能,因此我们能够以便宜 3 倍与 GPT-4 相比,输入代币的价格和输出代币的价格便宜 2 倍。

GPT-4 Turbo 可供所有付费开发者通过传入 API 进行试用,我们计划在未来几周内发布稳定的生产就绪模型。gpt-4-1106-preview

函数调用更新

函数调用允许您向模型描述应用或外部 API 的功能,并让模型智能地选择输出包含参数的 JSON 对象来调用这些函数。我们今天发布了几项改进,包括在一条消息中调用多个函数的能力:用户可以发送一条消息请求多个操作,例如“打开车窗并关闭空调”,这在以前需要与模型多次往返(了解更多信息).我们还提高了函数调用的准确性:GPT-4 Turbo 更有可能返回正确的函数参数。

改进了指令遵循和 JSON 模式

GPT-4 Turbo 在需要仔细遵循指令的任务上比我们以前的模型表现更好,例如生成特定格式(例如,“始终以 XML 响应”)。它还支持我们的新JSON模式,这可确保模型将使用有效的 JSON 进行响应。新的 API 参数使模型能够约束其输出,以生成语法正确的 JSON 对象。JSON 模式对于在函数调用之外的聊天完成 API 中生成 JSON 的开发人员非常有用。response_format

可重现的输出和对数概率

新参数通过使模型在大多数时间返回一致的完成来实现可重现的输出。此 beta 功能对于重播调试请求、编写更全面的单元测试以及通常对模型行为具有更高程度的控制等用例非常有用。我们 OpenAI 一直在内部使用此功能进行我们自己的单元测试,并发现它非常宝贵。我们很高兴看到开发人员将如何使用它。seed了解更多信息.

我们还将推出一项功能,以返回 GPT-4 Turbo 和 GPT-3.5 Turbo 在未来几周内生成的最有可能输出令牌的对数概率,这对于在搜索体验中构建自动完成等功能非常有用。

更新了 GPT-3.5 Turbo

除了 GPT-4 Turbo,我们还发布了新版本的 GPT-3.5 Turbo,默认支持 16K 上下文窗口。新的 3.5 Turbo 支持改进的指令跟踪、JSON 模式和并行函数调用。例如,我们的内部评估显示,在执行生成 JSON、XML 和 YAML 等任务后,格式改进了 38%。开发人员可以通过调用 API 来访问此新模型。使用该名称的应用程序将于 12 月 11 日自动升级到新型号。在 2024 年 6 月 13 日之前,可以通过传入 API 继续访问旧型号。gpt-3.5-turbo-1106``gpt-3.5-turbo``gpt-3.5-turbo-0613了解更多信息.

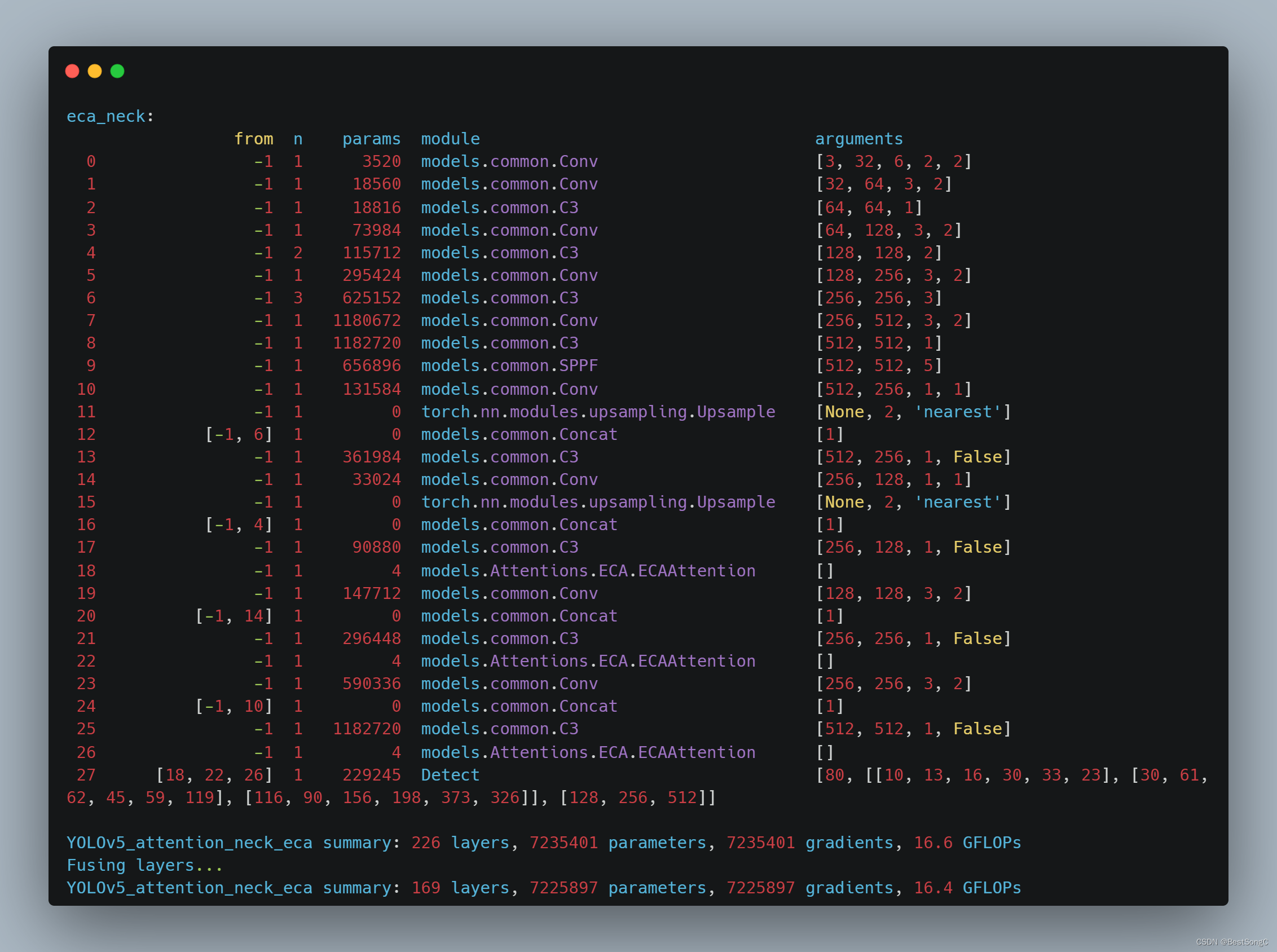

助手 API、检索和代码解释器

今天,我们发布了助手 API,这是我们帮助开发人员在自己的应用程序中构建类似代理的体验的第一步。助手是一种专门构建的 AI,具有特定指令,利用额外的知识,并可以调用模型和工具来执行任务。新的 Assistants API 提供了新的功能,例如代码解释器和检索以及函数调用,以处理您以前必须自己完成的许多繁重工作,并使您能够构建高质量的 AI 应用程序。

此 API 旨在提高灵活性;用例包括基于自然语言的数据分析应用程序、编码助手、人工智能驱动的假期计划器、语音控制的 DJ、智能视觉画布——不胜枚举。助手 API 建立在支持以下功能的相同基础上我们的新 GPT 产品:自定义指令和工具,例如代码解释器、检索和函数调用。

此 API 引入的一个关键变化是持久且无限长的线程,它允许开发人员将线程状态管理移交给 OpenAI 并解决上下文窗口约束。使用 Assistants API,您只需将每条新消息添加到现有 .thread

助理还可以根据需要调用新工具,包括:

- 代码解释器:在沙盒执行环境中编写和运行 Python 代码,可以生成图形和图表,处理具有不同数据和格式的文件。它允许您的助手以迭代方式运行代码,以解决具有挑战性的代码和数学问题等。

- 检索:使用来自我们模型之外的知识来增强助手,例如专有领域数据、产品信息或用户提供的文档。这意味着您无需计算和存储文档的嵌入,也无需实现分块和搜索算法。Assistants API 根据我们在 ChatGPT 中构建知识检索的经验,优化了要使用的检索技术。

- 函数调用:使助手能够调用您定义的函数,并将函数响应合并到他们的消息中。

与平台的其余部分一样,传递给 OpenAI API 的数据和文件是从未用于训练我们的模型开发人员可以在他们认为合适的时候删除数据。

您可以尝试 Assistants API 测试版,而无需编写任何代码,方法是前往助手游乐场.

使用 Assistants Playground 无需代码即可创建高质量的助手。

Assistants API 处于测试阶段,从今天开始可供所有开发人员使用。请与我们分享您构建的内容(@OpenAI)以及您的反馈,我们将在未来几周继续构建时将其纳入其中。提供 Assistants API 及其工具的定价在我们的定价页面上.

API 中的新模式

GPT-4 Turbo 带视觉

GPT-4 Turbo 可以接受图像作为聊天完成 API 中的输入,从而实现生成字幕、详细分析真实世界图像和阅读带有数字的文档等用例。例如,BeMyEyes 使用这项技术来帮助盲人或视力低下的人完成日常任务,例如识别产品或浏览商店。开发人员可以通过在 API 中使用来访问此功能。我们计划为主要的 GPT-4 Turbo 模型推出视觉支持,作为其稳定版本的一部分。gpt-4-vision-preview定价取决于输入图像大小。例如,将 1080×1080 像素的图像传递给 GPT-4 Turbo 的成本为 0.00765 美元。退房我们的愿景指南.

DALL·E 3

开发人员可以集成 DALL·E 3,我们最近推出到 ChatGPT Plus 和 Enterprise 用户,通过我们的 Images API 直接进入他们的应用程序和产品,指定为模型。Snap、可口可乐和 Shutterstock 等公司都使用了 DALL·E 3 以编程方式为其客户和活动生成图像和设计。与之前版本的DALL·E,API 包含内置审核功能,可帮助开发人员保护其应用程序免遭滥用。我们提供不同的格式和质量选项,每张生成的图像起价为 0.04 美元。查看我们的dall-e-3入门指南与DALL·E 3 在 API 中。

文字转语音 (TTS)

开发人员现在可以通过文本转语音 API 从文本生成人类质量的语音。我们新的 TTS 模型提供六种预设声音可供选择,以及两种模型变体,以及 . 针对实时用例进行了优化,并针对质量进行了优化。起价为每输入 1,000 个字符 0.015 USD。查看我们的tts-1``tts-1-hd``tts``tts-1-hdTTS指南以开始使用。

收听语音样本

选择文本:Scenic DirectionsTechnical Recipe

当金色的太阳落到地平线以下,在宁静的草地上投下长长的阴影时,世界似乎安静了下来,一种平静的感觉笼罩着地球,承诺所有生物都能安息一夜。

选择语音:Alloy Echo Fable Onyx Nova Shimmer

模型定制

GPT-4 微调实验访问

我们正在为 GPT-4 微调创建一个实验性访问程序。初步结果表明,与 GPT-3.5 微调实现的实质性收益相比,GPT-4 微调需要更多的工作才能实现对基本模型的有意义的改进。随着 GPT-4 微调的质量和安全性的提高,积极使用 GPT-3.5 微调的开发人员将获得一个选项,可以在其内部申请 GPT-4 程序微调控制台.

自定义模型

对于需要比微调所能提供的更多的定制的组织(特别适用于拥有非常大的专有数据集的领域——至少数十亿个代币),我们还推出了一个定制模型计划,让选定的组织有机会与专门的 OpenAI 研究人员团队合作,针对他们的特定领域训练定制 GPT-4。这包括修改模型训练过程的每个步骤,从执行额外的特定领域预训练,到运行为特定领域量身定制的自定义 RL 后训练过程。组织将拥有对其自定义模型的独占访问权限。根据我们现有的企业隐私政策,自定义模型不会提供给其他客户或与其他客户共享,也不会用于训练其他模型。此外,提供给 OpenAI 用于训练自定义模型的专有数据不会在任何其他上下文中重复使用。这将是一个非常有限(且昂贵)的计划——感兴趣的组织可以在这里申请.

更低的价格和更高的费率限制

更低的价格

我们是降低几个价格跨平台将节省的费用转嫁给开发人员(以下所有价格均以每 1,000 个代币表示):

- GPT-4 Turbo 输入代币比 GPT-4 便宜 3 倍,为 0.01 美元,输出代币便宜 2 倍,为 0.03 美元。

- GPT-3.5 Turbo 输入代币比之前的 16K 型号便宜 3 倍,为 0.001 美元,输出代币便宜 2 倍,为 0.002 美元。之前使用 GPT-3.5 Turbo 4K 的开发人员受益于 33% 的输入代币减少 0.001 美元。这些较低的价格仅适用于今天推出的新 GPT-3.5 Turbo。

- 微调后的 GPT-3.5 Turbo 4K 模型输入代币减少 4 倍至 0.003 美元,输出代币便宜 2.7 倍,至 0.006 美元。微调还支持16K上下文,价格与新的GPT-3.5 Turbo型号的4K相同。这些新价格也适用于微调模型。

gpt-3.5-turbo-0613

| 旧型号 | 新型号 | |

|---|---|---|

| GPT-4 涡轮增压 | GPT-4 8K 输入:0.03 美元 输出:$0.06 GPT-4 32K 输入:$0.06 产出: $0.12 | GPT-4 Turbo 128K 输入:0.01 美元 产出: $0.03 |

| GPT-3.5 涡轮增压 | GPT-3.5 Turbo 4K 输入:0.0015 美元 输出:$0.002 GPT-3.5 Turbo 16K 输入:$0.003 产出: $0.004 | GPT-3.5 Turbo 16K 输入:0.001 美元 产出: $0.002 |

| GPT-3.5 Turbo 微调 | GPT-3.5 Turbo 4K 微调培训:0.008 美元 输入: $0.012 产出: $0.016 | GPT-3.5 Turbo 4K 和 16K 微调培训:0.008 美元 输入: $0.003 产出: $0.006 |

更高的速率限制

为了帮助您扩展应用程序,我们将所有付费 GPT-4 客户的每分钟令牌限制增加一倍。您可以在“速率限制”页.我们还发布了我们的使用层确定自动速率限制的增加,因此您知道使用限制将如何自动扩展。现在,您可以从帐户设置.

版权保护

OpenAI 致力于通过我们系统中内置的版权保护措施来保护我们的客户。今天,我们将更进一步,推出 Copyright Shield——如果您面临有关版权侵权的法律索赔,我们现在将介入并保护我们的客户,并支付由此产生的费用。这适用于 ChatGPT Enterprise 和我们的开发人员平台的正式发布功能。

Whisper v3 和一致性解码器

我们正在发布耳语 large-v3,我们的开源自动语音识别模型 (ASR) 的下一个版本,该模型具有改进的跨语言性能。我们还计划在不久的将来在我们的 API 中支持 Whisper v3。

我们还开源了一致性解码器,是 Stable Diffusion VAE 解码器的替代品。该解码器改进了与 Stable Diffusion 1.0+ VAE 兼容的所有图像,在文本、人脸和直线方面进行了显着改进。

详细了解我们的ChatGPT 的 OpenAI DevDay 公告.

英文原文

- Authors OpenAI, Announcements, Product

Today, we shared dozens of new additions and improvements, and reduced pricing across many parts of our platform. These include:

- New GPT-4 Turbo model that is more capable, cheaper and supports a 128K context window

- New Assistants API that makes it easier for developers to build their own assistive AI apps that have goals and can call models and tools

- New multimodal capabilities in the platform, including vision, image creation (DALL·E 3), and text-to-speech (TTS)

We’ll begin rolling out new features to OpenAI customers starting at 1pm PT today.

Learn more about OpenAI DevDay announcements for ChatGPT.

GPT-4 Turbo with 128K context

We released the first version of GPT-4 in March and made GPT-4 generally available to all developers in July. Today we’re launching a preview of the next generation of this model, GPT-4 Turbo.

GPT-4 Turbo is more capable and has knowledge of world events up to April 2023. It has a 128k context window so it can fit the equivalent of more than 300 pages of text in a single prompt. We also optimized its performance so we are able to offer GPT-4 Turbo at a 3x cheaper price for input tokens and a 2x cheaper price for output tokens compared to GPT-4.

GPT-4 Turbo is available for all paying developers to try by passing in the API and we plan to release the stable production-ready model in the coming weeks.gpt-4-1106-preview

Function calling updates

Function calling lets you describe functions of your app or external APIs to models, and have the model intelligently choose to output a JSON object containing arguments to call those functions. We’re releasing several improvements today, including the ability to call multiple functions in a single message: users can send one message requesting multiple actions, such as “open the car window and turn off the A/C”, which would previously require multiple roundtrips with the model (learn more). We are also improving function calling accuracy: GPT-4 Turbo is more likely to return the right function parameters.

Improved instruction following and JSON mode

GPT-4 Turbo performs better than our previous models on tasks that require the careful following of instructions, such as generating specific formats (e.g., “always respond in XML”). It also supports our new JSON mode, which ensures the model will respond with valid JSON. The new API parameter enables the model to constrain its output to generate a syntactically correct JSON object. JSON mode is useful for developers generating JSON in the Chat Completions API outside of function calling.response_format

Reproducible outputs and log probabilities

The new parameter enables reproducible outputs by making the model return consistent completions most of the time. This beta feature is useful for use cases such as replaying requests for debugging, writing more comprehensive unit tests, and generally having a higher degree of control over the model behavior. We at OpenAI have been using this feature internally for our own unit tests and have found it invaluable. We’re excited to see how developers will use it. seedLearn more.

We’re also launching a feature to return the log probabilities for the most likely output tokens generated by GPT-4 Turbo and GPT-3.5 Turbo in the next few weeks, which will be useful for building features such as autocomplete in a search experience.

Updated GPT-3.5 Turbo

In addition to GPT-4 Turbo, we are also releasing a new version of GPT-3.5 Turbo that supports a 16K context window by default. The new 3.5 Turbo supports improved instruction following, JSON mode, and parallel function calling. For instance, our internal evals show a 38% improvement on format following tasks such as generating JSON, XML and YAML. Developers can access this new model by calling in the API. Applications using the name will automatically be upgraded to the new model on December 11. Older models will continue to be accessible by passing in the API until June 13, 2024. gpt-3.5-turbo-1106``gpt-3.5-turbo``gpt-3.5-turbo-0613Learn more.

Assistants API, Retrieval, and Code Interpreter

Today, we’re releasing the Assistants API, our first step towards helping developers build agent-like experiences within their own applications. An assistant is a purpose-built AI that has specific instructions, leverages extra knowledge, and can call models and tools to perform tasks. The new Assistants API provides new capabilities such as Code Interpreter and Retrieval as well as function calling to handle a lot of the heavy lifting that you previously had to do yourself and enable you to build high-quality AI apps.

This API is designed for flexibility; use cases range from a natural language-based data analysis app, a coding assistant, an AI-powered vacation planner, a voice-controlled DJ, a smart visual canvas—the list goes on. The Assistants API is built on the same capabilities that enable our new GPTs product: custom instructions and tools such as Code interpreter, Retrieval, and function calling.

A key change introduced by this API is persistent and infinitely long threads, which allow developers to hand off thread state management to OpenAI and work around context window constraints. With the Assistants API, you simply add each new message to an existing .thread

Assistants also have access to call new tools as needed, including:

- Code Interpreter: writes and runs Python code in a sandboxed execution environment, and can generate graphs and charts, and process files with diverse data and formatting. It allows your assistants to run code iteratively to solve challenging code and math problems, and more.

- Retrieval: augments the assistant with knowledge from outside our models, such as proprietary domain data, product information or documents provided by your users. This means you don’t need to compute and store embeddings for your documents, or implement chunking and search algorithms. The Assistants API optimizes what retrieval technique to use based on our experience building knowledge retrieval in ChatGPT.

- Function calling: enables assistants to invoke functions you define and incorporate the function response in their messages.

As with the rest of the platform, data and files passed to the OpenAI API are never used to train our models and developers can delete the data when they see fit.

You can try the Assistants API beta without writing any code by heading to the Assistants playground.

Use the Assistants playground to create high quality assistants without code.

The Assistants API is in beta and available to all developers starting today. Please share what you build with us (@OpenAI) along with your feedback which we will incorporate as we continue building over the coming weeks. Pricing for the Assistants APIs and its tools is available on our pricing page.

New modalities in the API

GPT-4 Turbo with vision

GPT-4 Turbo can accept images as inputs in the Chat Completions API, enabling use cases such as generating captions, analyzing real world images in detail, and reading documents with figures. For example, BeMyEyes uses this technology to help people who are blind or have low vision with daily tasks like identifying a product or navigating a store. Developers can access this feature by using in the API. We plan to roll out vision support to the main GPT-4 Turbo model as part of its stable release. gpt-4-vision-previewPricing depends on the input image size. For instance, passing an image with 1080×1080 pixels to GPT-4 Turbo costs $0.00765. Check out our vision guide.

DALL·E 3

Developers can integrate DALL·E 3, which we recently launched to ChatGPT Plus and Enterprise users, directly into their apps and products through our Images API by specifying as the model. Companies like Snap, Coca-Cola, and Shutterstock have used DALL·E 3 to programmatically generate images and designs for their customers and campaigns. Similar to the previous version of DALL·E, the API incorporates built-in moderation to help developers protect their applications against misuse. We offer different format and quality options, with prices starting at $0.04 per image generated. Check out our dall-e-3guide to getting started with DALL·E 3 in the API.

Text-to-speech (TTS)

Developers can now generate human-quality speech from text via the text-to-speech API. Our new TTS model offers six preset voices to choose from and two model variants, and . is optimized for real-time use cases and is optimized for quality. Pricing starts at $0.015 per input 1,000 characters. Check out our tts-1``tts-1-hd``tts``tts-1-hdTTS guide to get started.

Listen to voice samples

Select text:Scenic DirectionsTechnical Recipe

As the golden sun dips below the horizon, casting long shadows across the tranquil meadow, the world seems to hush, and a sense of calmness envelops the Earth, promising a peaceful night’s rest for all living beings.

Select voice:Alloy Echo Fable Onyx Nova Shimmer

Model customization

GPT-4 fine tuning experimental access

We’re creating an experimental access program for GPT-4 fine-tuning. Preliminary results indicate that GPT-4 fine-tuning requires more work to achieve meaningful improvements over the base model compared to the substantial gains realized with GPT-3.5 fine-tuning. As quality and safety for GPT-4 fine-tuning improves, developers actively using GPT-3.5 fine-tuning will be presented with an option to apply to the GPT-4 program within their fine-tuning console.

Custom models

For organizations that need even more customization than fine-tuning can provide (particularly applicable to domains with extremely large proprietary datasets—billions of tokens at minimum), we’re also launching a Custom Models program, giving selected organizations an opportunity to work with a dedicated group of OpenAI researchers to train custom GPT-4 to their specific domain. This includes modifying every step of the model training process, from doing additional domain specific pre-training, to running a custom RL post-training process tailored for the specific domain. Organizations will have exclusive access to their custom models. In keeping with our existing enterprise privacy policies, custom models will not be served to or shared with other customers or used to train other models. Also, proprietary data provided to OpenAI to train custom models will not be reused in any other context. This will be a very limited (and expensive) program to start—interested orgs can apply here.

Lower prices and higher rate limits

Lower prices

We’re decreasing several prices across the platform to pass on savings to developers (all prices below are expressed per 1,000 tokens):

- GPT-4 Turbo input tokens are 3x cheaper than GPT-4 at $0.01 and output tokens are 2x cheaper at $0.03.

- GPT-3.5 Turbo input tokens are 3x cheaper than the previous 16K model at $0.001 and output tokens are 2x cheaper at $0.002. Developers previously using GPT-3.5 Turbo 4K benefit from a 33% reduction on input tokens at $0.001. Those lower prices only apply to the new GPT-3.5 Turbo introduced today.

- Fine-tuned GPT-3.5 Turbo 4K model input tokens are reduced by 4x at $0.003 and output tokens are 2.7x cheaper at $0.006. Fine-tuning also supports 16K context at the same price as 4K with the new GPT-3.5 Turbo model. These new prices also apply to fine-tuned models.

gpt-3.5-turbo-0613

| Older models | New models | |

|---|---|---|

| GPT-4 Turbo | GPT-4 8K Input: $0.03 Output: $0.06 GPT-4 32K Input: $0.06 Output: $0.12 | GPT-4 Turbo 128K Input: $0.01 Output: $0.03 |

| GPT-3.5 Turbo | GPT-3.5 Turbo 4K Input: $0.0015 Output: $0.002 GPT-3.5 Turbo 16K Input: $0.003 Output: $0.004 | GPT-3.5 Turbo 16K Input: $0.001 Output: $0.002 |

| GPT-3.5 Turbo fine-tuning | GPT-3.5 Turbo 4K fine-tuning Training: $0.008 Input: $0.012 Output: $0.016 | GPT-3.5 Turbo 4K and 16K fine-tuning Training: $0.008 Input: $0.003 Output: $0.006 |

Higher rate limits

To help you scale your applications, we’re doubling the tokens per minute limit for all our paying GPT-4 customers. You can view your new rate limits in your rate limit page. We’ve also published our usage tiers that determine automatic rate limits increases, so you know what to expect in how your usage limits will automatically scale. You can now request increases to usage limits from your account settings.

Copyright Shield

OpenAI is committed to protecting our customers with built-in copyright safeguards in our systems. Today, we’re going one step further and introducing Copyright Shield—we will now step in and defend our customers, and pay the costs incurred, if you face legal claims around copyright infringement. This applies to generally available features of ChatGPT Enterprise and our developer platform.

Whisper v3 and Consistency Decoder

We are releasing Whisper large-v3, the next version of our open source automatic speech recognition model (ASR) which features improved performance across languages. We also plan to support Whisper v3 in our API in the near future.

We are also open sourcing the Consistency Decoder, a drop in replacement for the Stable Diffusion VAE decoder. This decoder improves all images compatible with the by Stable Diffusion 1.0+ VAE, with significant improvements in text, faces and straight lines.

Learn more about our OpenAI DevDay announcements for ChatGPT.

![通过一道题目带你深入了解WAF特性、PHP超级打印函数、ASCII码chr()对应表等原理[RoarCTF 2019]Easy Calc 1](https://img-blog.csdnimg.cn/img_convert/6ac31517d4a2d4fc225e0c4266dab96f.png)