这里写目录标题

- 第1关 Concat与Append操作

- 第2关 合并与连接

- 第3关 案例:美国各州的统计数据

第1关 Concat与Append操作

任务描述

本关任务:使用read_csv()读取两个csv文件中的数据,将两个数据集合并,将索引设为Ladder列,并将缺失值填充为0。

编程要求

data.csv和data1.csv是两份与各国幸福指数排名相关的数据,为了便于查看排名详情,所以需要将两份数据横向合并。数据列名含义如下:

- 读取step1/data.csv和step1/data1.csv两份数据;

- 首先将两个数据横向合并;

- 将索引设为排名(Ladder)列;

- 填充空值为0;

- 具体要求请参见后续测试样例。

- 请先仔细阅读右侧上部代码编辑区内给出的代码框架,再开始你的编程工作!

测试说明

平台会对你编写的代码进行测试,对比你输出的数值与实际正确的数值,只有所有数据全部计算正确才能进入下一关。

测试输入:

无测试输入

预期输出:

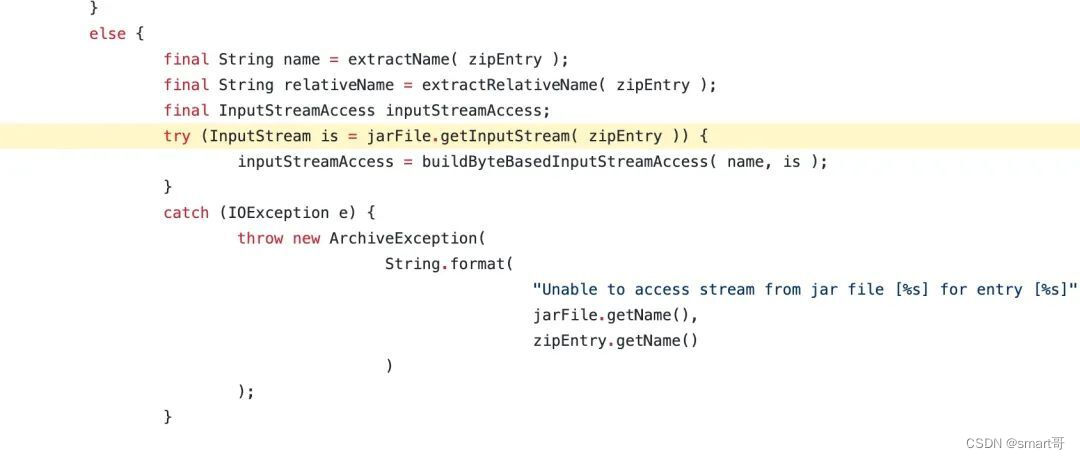

import pandas as pd

def task1():

#********** Begin **********#

data=pd.read_csv('step1/data.csv')

data1=pd.read_csv('step1/data1.csv')

result=pd.concat([data,data1],axis=1)

result=result.T.drop_duplicates().T

result.index.name = 'Ladder'

result=result.fillna(0)

#********** End **********#

return result

第2关 合并与连接

任务描述

本关任务:使用pandas中的merge()函数按照编程要求合并三份数据。

编程要求

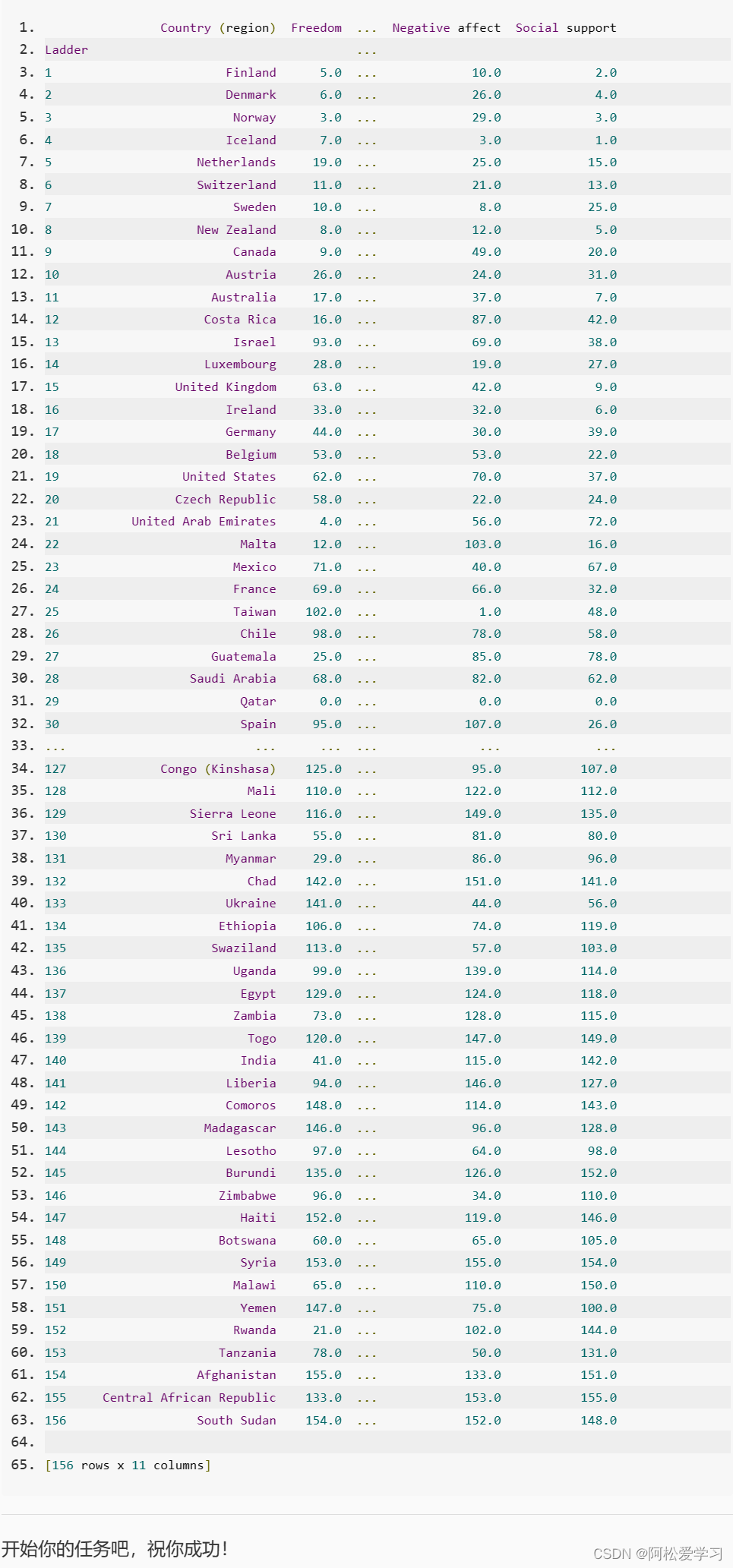

在实际应用中,经常会遇到数据需要连接但是数据源不同的情况,如以下两个数据:

- mysql中查询的数据;

- mongodb中查询的数据;

- o\fracle中查询的数据;

我们需要分析不同城市的人对某个网页的点击次数,如果通过普通程序编写逻辑来实现肯定是可以做到的,但是当要连接的表超过十个,甚至百个时,这个方法就不好使了。这时使用pd.merge()来连接绝对是明智的选择。所以我们就来实践一下吧。

- 将mysql、mongodb和o\fracle中的数据转换成DataFrame;

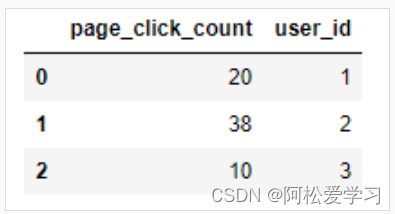

mysql:

mongodb:

o\fracle:

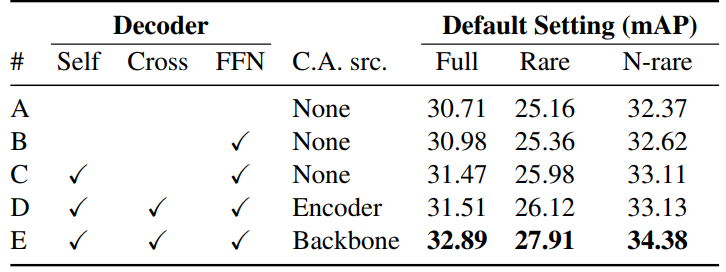

- 然后通过合并、连接、排序等操作,得到下图所示目标数组;

- 具体要求请参见后续测试样例。

提示:drop_duplicates()函数可以根据某一列来删除重复值。

请先仔细阅读右侧上部代码编辑区内给出的代码框架,再开始你的编程工作!

测试说明

平台会对你编写的代码进行测试,对比你输出的数值与实际正确的数值,只有所有数据全部计算正确才能进入下一关。

测试输入:

无测试输入

预期输出:

开始你的任务吧,祝你成功!

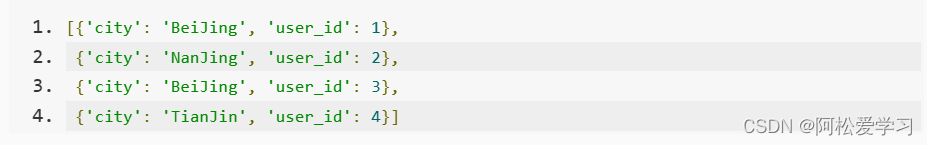

import pandas as pd

def task2(dataset1,dataset2,dataset3):

# ********** Begin **********#

d1,d2,d3=pd.DataFrame(dataset1),pd.DataFrame(dataset2),pd.DataFrame(dataset3)

result=pd.merge(d3,pd.merge(d1,d2,on='user_id',how='outer'), left_on='id',right_on='user_id',how='outer')

result['user_id']=result['user_id'].fillna(result['id'])

result['page_click_count_y']=result['page_click_count_y'].fillna(result['page_click_count_x'])

result['city_x']=result['city_x'].fillna(result['city_y'])

result=result.drop(['id','page_click_count_x','city_y'],axis=1)

result.rename(columns={'city_x':'city','page_click_count_y':'page_click_count'},inplace=True)

result=result.sort_values(by="user_id")

result['user_id']= result['user_id'].values.astype(int)

# ********** End **********#

return result

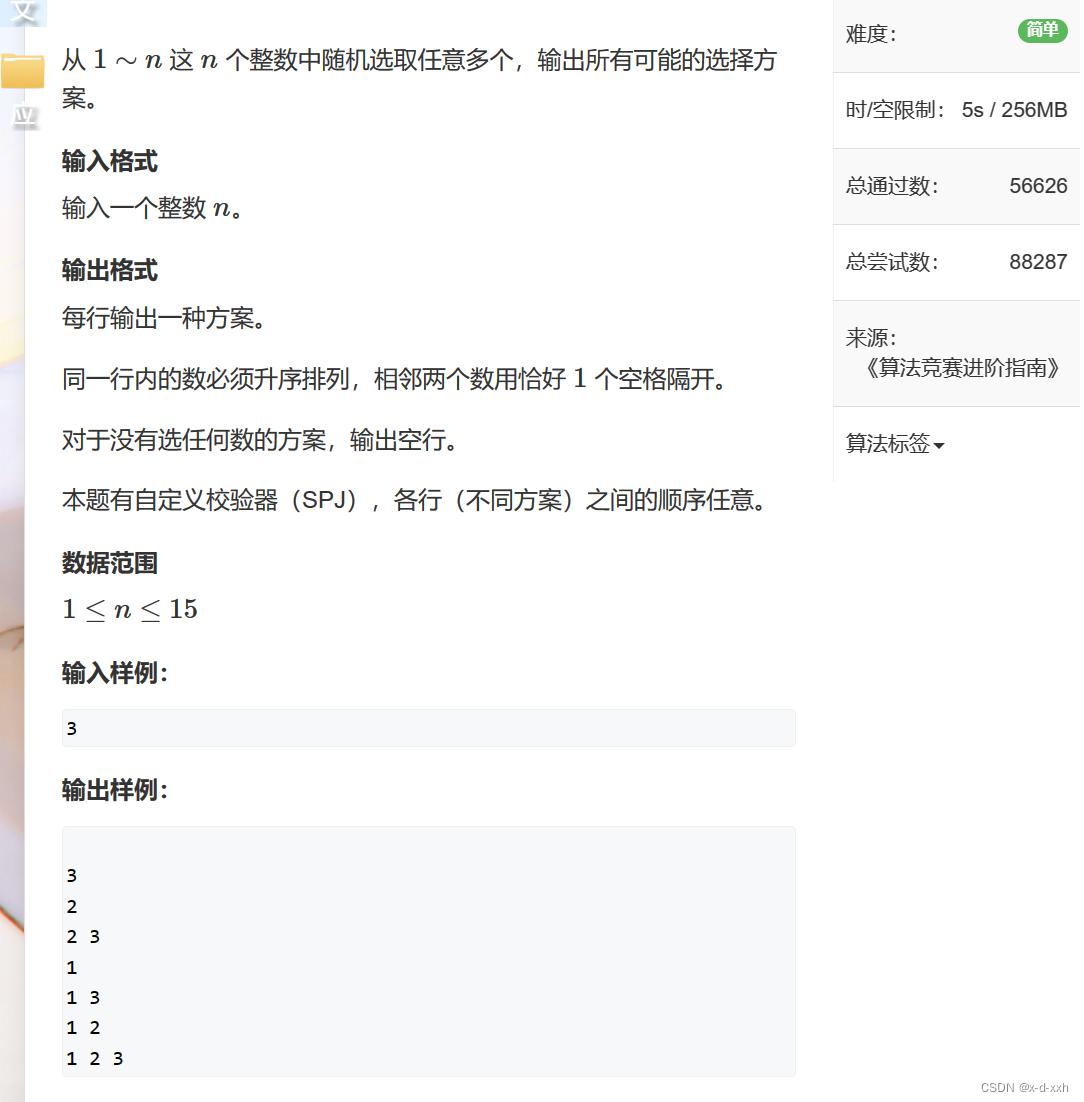

第3关 案例:美国各州的统计数据

任务描述

本关为练习关卡,请按照编程要求完成任务,获取美国各州2010年的人口密度排名。

编程要求

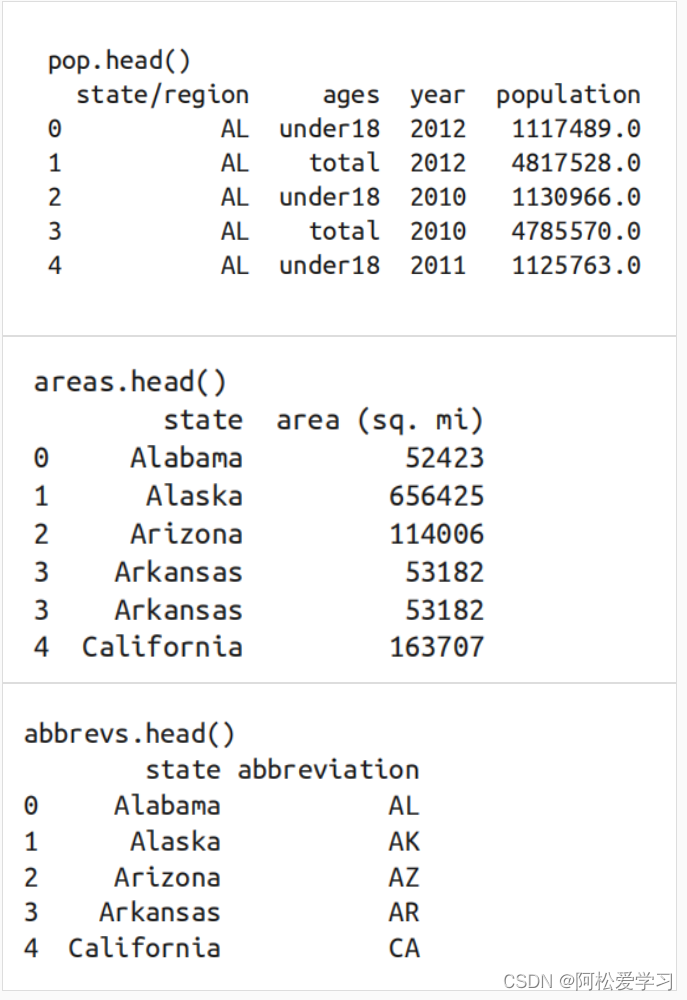

- 使用read_csv()函数读取step3文件夹中的state-population.csv(pop)、state-areas.csv(areas)、state-abbrevs.csv(abbrevs)文件;

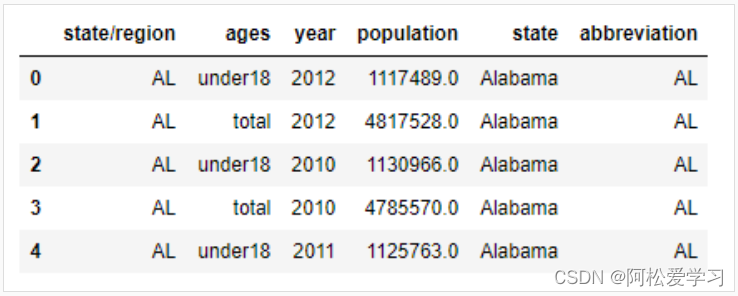

- 合并pop和abbrevs。我们需要将pop的state/region列与abbrevs的abbreviation列进行合并,还需要通过how='outer’确保数据没有丢失,得到合并后的结果,发现有一个重复列需要删除,所以,删除abbreviation列;

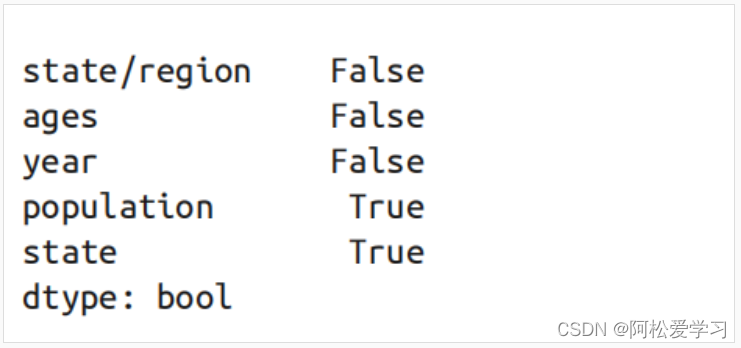

- 来全面检查一下数据是否有缺失,对每个字段逐行检查是否有缺失值,通过结果可知只有population和state列有缺失值;

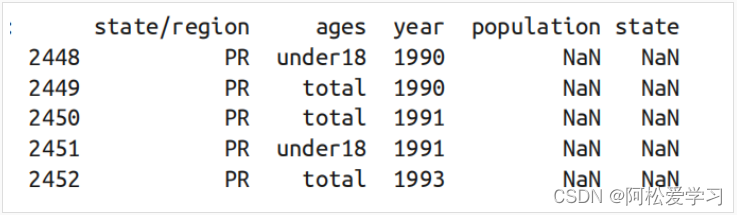

- 查看population这一列为缺失值的特征。通过结果可以得到好像所有的人口缺失值都出现在2000年之前的波多黎各,此前并没有统计过波多黎各的人口;

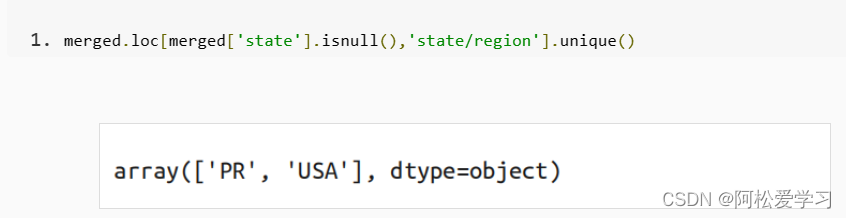

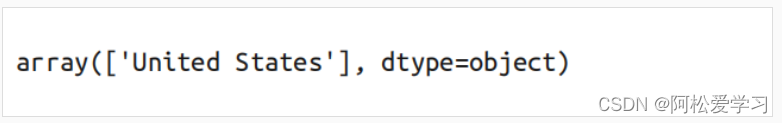

- 从上面的结果可以发现state这一列也有缺失值,通过下列代码可以查看是哪些州有缺失值;

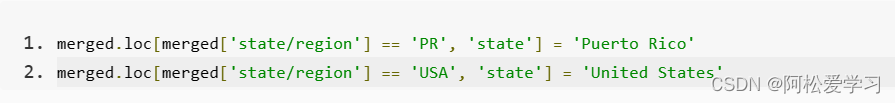

- 我们可以快速解决这个问题:人口数据中包含波多黎各(PR)和全国总数(USA),但这两项没有出现在州名称缩写表中。我们可以用以下代码来填充对应的全称;

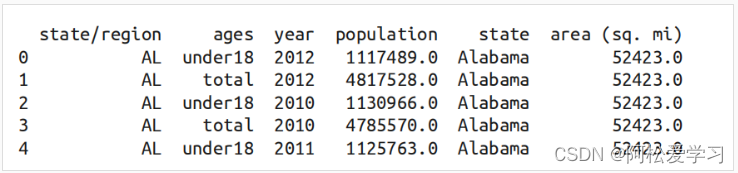

- 然后我们用类似的规则将面积数据和处理完后的merged合并起来。数据合并的键为state,连接方式为左连接;

- 检查缺失值,从结果中可以发现,area列中还有缺失值;

- 查看是哪个地区面积缺失。结果如下:

- 从上面的结果可以得出缺少的是全美国的面积数据,但是我们的目标数据并不需要全美国的面积数据,所以我们需要删掉这些缺失值;

- 取year为2010年的数据,并将索引设为state列;

- 计算人口密度,将2010年的人口population除以面积area (sq. mi);

- 由于人口密度中分为成年人的人口密度和未成年人的人口密度,所以我们需要对两个值进行求合得到最终的人口密度;

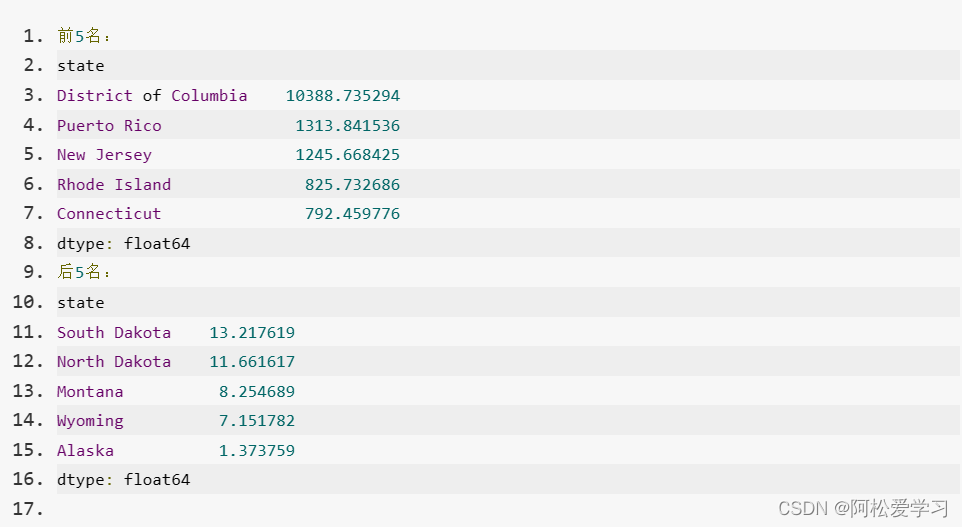

- 对值进行排序,取人口密度结果的前5名与倒数5名;

- 具体要求请参见后续测试样例。

请先仔细阅读右侧上部代码编辑区内给出的代码框架,再开始你的编程工作!

测试说明

平台会对你编写的代码进行测试,对比你输出的数值与实际正确的数值,只有所有数据全部计算正确才能进入下一关。

测试输入:

无测试输入

预期输出:

开始你的任务吧,祝你成功!

import pandas as pd

import numpy as np

def task3():

#********** Begin **********#

#读取三个csv文件

pop = pd.read_csv('./step3/state-population.csv')

areas = pd.read_csv('./step3/state-areas.csv')

abbrevs = pd.read_csv('./step3/state-abbrevs.csv')

# 合并pop和abbrevs并删除重复列

merged = pd.merge(pop, abbrevs, how='outer',

left_on='state/region', right_on='abbreviation')

merged = merged.drop('abbreviation', 1)

# 填充对应的全称

merged.loc[merged['state/region'] == 'PR', 'state'] = 'Puerto Rico'

merged.loc[merged['state/region'] == 'USA', 'state'] = 'United States'

# 合并面积数据

final = pd.merge(merged, areas, on='state', how='left')

# 删掉这些缺失值

final.dropna(inplace=True)

# 取year为2010年的两种人口的数据

data2010_1= final.query("year == 2010 & ages == 'total'")

data2010_2=final.query("year == 2010 & ages == 'under18'")

# 二者人口相加

p=np.array(data2010_1.loc[:,'population'])+np.array(data2010_2.loc[:,'population'])

data2010=data2010_1.copy()

data2010.loc[:,'population']=p

#设置州为索引

data2010.set_index('state', inplace=True)

#计算人口密度

density = data2010['population'] / data2010['area (sq. mi)']

# 对值进行排序

density.sort_values(ascending=False, inplace=True)

# 输出人口密度前5名和倒数5名

print('前5名:')

print(density[:5])

print('后5名:')

print(density[-5:])

#********** End **********#

![[{'page_click_count': 20, 'user_id': 1},

{'page_click_count': 38, 'user_id': 2},

{'page_click_count': 10, 'user_id': 3}]](https://img-blog.csdnimg.cn/45e705978b044c9bb76df52cb76f8bf6.png)