这里写目录标题

- 一、前言

- 二、语言模型组件

- 1、MitieNLP

- 2、SpacyNLP

- 三、分词器

- 1、WhitespaceTokenizer

- 2、JiebaTokenizer

- 3、MitieTokenizer

- 4、SpacyTokenizer

- 5、自定义分词器

一、前言

RASA在处理对话时,整体流程是pipeline结构,自然语言理解(NLU)、对话状态追踪(DST)以及对话策略学习(DPL)一系列流程处理下来,再判断执行下一个动作。其中,NLU组件主要是将用户的输入处理成结构化输出。该组件主要用途为实体抽取、意图分类、响应选择、预处理等。NLU组件也是一个可细分pipeline结构,过程是Tokenize->Featurize->NER Extract->Intent Classify。

二、语言模型组件

如果开发者想在pipline中使用预训练的词向量,以下组件会加载所需的预训练模型。RASA中间内置的预训练模型可以通过过以下组件进行加载。

1、MitieNLP

mitie 基于dlib库开发,dlib是一个c++高性能机器学习库。所以对性能有要求的信息抽取场景,可以考虑使用mitie。mitie现有的资料比较少,github最近更新也是五六年前了。从mitie代码中看到它的NER使用structural_sequence_labeling_trainer.实现的细节见https://www.aaai.org/Papers/ICML/2003/ICML03-004.pdf 文中指出,MITIE的NER是HMM 和SVM相结合做的。相比单纯的HMM,这种方法是基于最大margin 标准。这相比纯CRF或者最大熵的HMM有很多优势:

1)可以通过核函数学习非线性的判断关系

2)可以处理overlapping features.

但毕竟是基于传统机器学习的方式,相对于BERT这种海量语料预训练模型来说,效果还是稍差一点,这个可以使用RASA的NLU评估工具跑分试一下[NLU pipelines评估]。但MITIE有无可比拟的速度优势,在算力敏感的情况下自己权衡选择,RASA已经不做官方推荐了。

RASA中配置MitieNLP,需要在config.yml文件中pipline中配置。

pipeline:

--name: "MitieNLP"

# language model to load

model: "data/total_word_feature_extractor.dat"

开发者还可以使用 MITIE 工具来训练自己的预训练语言模型。为此:

- 获取一个处理干净的语言语料库(维基百科转储作品)作为训练语料。

- 在语料库上运用MITIE Wordrep 工具。这可能需要几个小时/几天,具体取决于开发者的数据集和工作站。您需要 128GB 的 RAM 才能运行 wordrep – 是的,这很多:尝试扩展您的交换空间。

- 将新的路径设置为配置文件中组件 total_word_feature_extractor.dat的model参数。MitieNLP有关如何训练 MITIE 词向量的完整示例,请查看使用 Rasa NLU 构建自己的中文 NLU 系统,这是一篇从中文维基百科转储中创建 MITIE 模型的博文。

2、SpacyNLP

spaCy是一个用Python和Cython编写的高级自然语言处理的库。它跟踪最新的研究成果,并将其应用到实际产品。spaCy带有预训练的统计模型和单词向量,目前支持60多种语言。它用于标记任务,解析任务和命名实体识别任务的卷积神经网络模型,在非常快速的情况下,达到比较好的效果,并且易于在产品中集成应用。在github上接近24k的stars,并且更新比较活跃。最新发布的spaCy3.4也集成了Transformer相关模型。

使用spaCy时,文本字符串的第一步是将其传递给NLP对象。NLP对象本质上是由几个文本预处理操作组成的管道,输入文本字符串通过管道后,最终输出文档,完成各种功能。spacy的中文模型的下载地址:https://github.com/explosion/spacy-models。

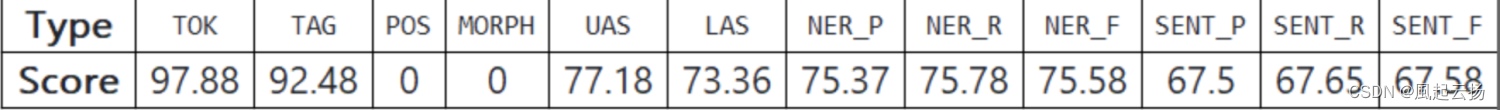

Spacy工具在各大NLP任务中的效果如下:

RASA中配置spacynlp,需要在config.yml文件中pipline中配置。

pipeline:

- name: "SpacyNLP"

# language model to load

model: "en_core_web_md"

# when retrieving word vectors, this will decide if the casing

# of the word is relevant. E.g. `hello` and `Hello` will

# retrieve the same vector, if set to `False`. For some

# applications and models it makes sense to differentiate

# between these two words, therefore setting this to `True`.

case_sensitive: False

有关如何下载 spaCy 模型的更多信息,请转到 安装 SpaCy。

除了 SpaCy 的已有预训练语言模型,开发者还可以使用此组件添加自己训练好的 spaCy 模型。具体请参考Spacy的官方文档:Models & Languages · spaCy Usage Documentation 。

三、分词器

分词器主要是将文本拆分为token。如果开发者想将意图拆分为多个标签,例如用于预测多个意图或为分层意图结构建模,请将以下tag与任何分词器一起使用:

- intent_tokenization_flag指示是否标记意图标签。将其设置为True,以便标签化意图标签。

- intent_split_symbol 设置分割意图标签的分隔符字符串,默认为下划线(_)。

1、WhitespaceTokenizer

空格分词器,每个空格间隔的文本,都将分为一个token,典型英文句子的分词,主要作用于用户消息、响应(如果存在)和意图(如果指定)。该分词器不支持中文分词。

RASA主要是在config.yaml文件中配置,配置方式如下:

pipeline:

- name: "WhitespaceTokenizer"

# Flag to check whether to split intents

"intent_tokenization_flag": False

# Symbol on which intent should be split

"intent_split_symbol": "_"

# Regular expression to detect tokens

"token_pattern": None

intent_tokenization_flag 和 intent_split_symbol 是在nlu返回多意图的时候使用。当intent_tokenization_flag设置为False,nlu只返回一个置信度最高的意图。但有些时候,一句话包含多个意图,例如:

## intent: affirm+ask_transport

- Yes. How do I get there?

- Sounds good. Do you know how I could get there from home?

用户的回答包含2层意思,首先是同意我的建议,另外是询问怎么去。这时候,需要将intent_tokenization_flag设置为True,然后在训练数据里面编写多意图对应的话术,多个意图中间用intent_split_symbol去分割。在运行的时候,用户说“Sounds good. Do you know how I could get there from home?”,Rasa nlu就会返回affirmask_transport这个意图。

2、JiebaTokenizer

jieba分词器,仅可以在中文分词使用,支持自定义词库分词,主要作用于用户消息、响应(如果存在)和意图(如果指定)。词库的配置方法如下:

pipeline:

- name: "JiebaTokenizer"

dictionary_path: "path/to/custom/dictionary/dir"

# Flag to check whether to split intents

"intent_tokenization_flag": False

# Symbol on which intent should be split

"intent_split_symbol": "_"

# Regular expression to detect tokens

"token_pattern": None

其中,dictionary_path是字典文件所在路径。

3、MitieTokenizer

开发者使用MitieNLP进行分词时,前提是需要配置Mitie语言模型,一般在使用全套MiteNLP的时候使用。开发者如果使用BERT进行Featurizer提取,那Tokenizer就可以任选一个,比如中文用Jieba,英文用空格分词就行。

pipeline:

- name:"MitieTokenizer"

# Flag to check whether to split intents

"intent_tokenization_flag":False

# Symbol on which intent should be split

"intent_split_symbol":"_"

# Regular expression to detect tokens

"token_pattern": None

4、SpacyTokenizer

开发者使用SpacyNLP进行分词时,前提是需要配置Spacy语言模型,一般在使用全套SpacyNLP的时候使用。

pipeline:

- name: "SpacyTokenizer"

# Flag to check whether to split intents

"intent_tokenization_flag": False

# Symbol on which intent should be split

"intent_split_symbol": "_"

# Regular expression to detect tokens

"token_pattern": None

5、自定义分词器

如果上述分词器不满足要求,可以自定义分词器。要实现自定义分词器,需要继承Tokenizer和Component类,需要重载的函数有:init,train,tokenize,具体模板如下:

class CustomTokenizer(Tokenizer, Component):

provides = [MESSAGE_TOKENS_NAMES[attribute] for attribute in MESSAGE_ATTRIBUTES]

def train(

self, training_data: TrainingData, config: RasaNLUModelConfig, **kwargs: Any

) -> None:

for example in training_data.training_examples:

for attribute in MESSAGE_ATTRIBUTES:

if example.get(attribute) is not None:

example.set(

MESSAGE_TOKENS_NAMES[attribute],

self.tokenize(example.get(attribute), attribute),

)

# 主要是要实现对应的tokenize

def tokenize(self, text: Text) -> List[Token]:

pass

简单做个总结,需要加载语言模型的分词器有Mitie,SpaCy。其中Mitie没有中文预训练模型,如果实现中文对话系统,需要自行准备语料训练Mitie语言模型。其中SpaCy有现成的中文模型,可以直接加载使用。如果需要使用LanguageModelFeaturizer中的各种BERT大模型,在分词器阶段就可以任意配置一个分词器即可,一般中文配置jiebaTokenizer,英文配置WhitespaceTokenizer,但是必须需要配置。