一、说明

近年来,自然语言处理 (NLP) 模型广受欢迎,彻底改变了我们与文本数据交互和分析的方式。这些基于深度学习技术的模型在广泛的应用中表现出了卓越的能力,从聊天机器人和语言翻译到情感分析和文本生成。然而,NLP 模型并非没有挑战,它们面临的最关键问题之一是存在偏见和公平性问题。本文探讨了 NLP 模型中的偏见和公平性概念,以及用于检测和缓解它们的方法。埃弗顿·戈梅德(Everton Gomede)博士

在NLP模型中维护公平性不是一种选择;它是未来的道德指南针,人工智能弥合了差距,而不是加深了鸿沟。

二、了解 NLP 模型中的偏差

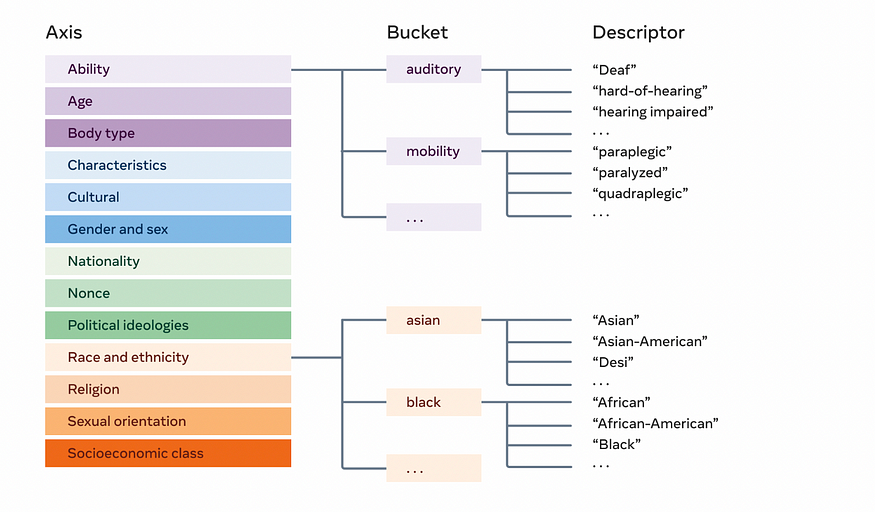

NLP 模型中的偏见是指基于种族、性别、宗教或民族等特征对某些群体或个人存在不公平或偏见的待遇。这些偏差可能会在模型的训练和微调阶段出现,因为训练数据通常反映了数据源中存在的偏差。NLP 模型根据它们在训练数据中观察到的模式来学习预测和生成文本。如果训练数据有偏差,模型将不可避免地在其输出中拾取并传播这些偏差。

NLP 模型中可能会出现不同类型的偏差,例如:

- 刻板印象偏见:这种偏见涉及强化对某些群体的刻板印象,导致模型输出中的不公平概括和歪曲表示。

- 代表性不足偏差:如果某些组在训练数据中的代表性不足,则模型在处理与这些组相关的文本时可能会表现不佳。

- 历史偏见:NLP 模型可以从包含过去偏见的历史文本中学习,这可能会使过时和有害的观点永久化。

三、检测 NLP 模型中的偏差

检测 NLP 模型中的偏差是在其应用中实现公平和公正的关键一步。有几种方法和技术用于偏差检测:

- 偏差审计: 这涉及手动检查模型的输出是否有偏差迹象。人工审核员会评估系统的行为,以识别可能产生有偏见的内容的情况。

- 偏差指标: 研究人员开发了各种指标来量化 NLP 模型中的偏差。这些指标通过分析模型对不同人口统计群体的预测来衡量模型表现出偏差的程度。

- 反事实评估: 在反事实评估中,研究人员修改输入数据,以评估当某些属性或特征发生变化时模型的输出如何变化。这种方法有助于识别与特定属性相关的偏差。

- 差分隐私: 差分隐私等技术可用于在训练过程中保护敏感属性,使模型在学习和传播偏见方面更具挑战性。

四、NLP 模型中的公平性

确保 NLP 模型的公平性涉及解决在系统行为中检测到的偏差。要实现公平,就必须采取措施避免不公正的歧视,并为所有人口群体提供平等机会。

- 数据预处理:数据预处理技术(例如对代表性不足的群体进行重新采样、重新加权训练数据和删除有偏见的示例)可以帮助减轻训练数据中的偏差。

- 公平性约束:研究人员可以在模型训练期间引入公平性约束,确保模型的预测不会不成比例地偏袒或损害任何特定群体。

- 对抗性训练:对抗性训练涉及训练一个单独的模型来识别和减轻主 NLP 模型中的偏见。这种对抗性模型旨在减少输出中偏置属性的影响。

- 去偏置后处理:训练模型后,可以使用后处理技术来识别和减轻其输出中的偏差。这可能涉及重新排名或改写结果以减少偏差。

五、挑战与未来方向

解决 NLP 模型中的偏见和公平性是一项复杂且持续的挑战。实现公平性并不是一个放之四海而皆准的解决方案,需要仔细考虑上下文、正在处理的数据以及 NLP 模型的具体应用。此外,还需要考虑权衡取舍,因为消除所有偏差可能会导致模型的准确性降低。

随着 NLP 领域的进步,计算机科学家、伦理学家、社会学家和领域专家之间越来越需要跨学科合作,以开发更强大的方法来检测和减轻 NLP 模型中的偏见。此外,道德准则和法规可能在促进 NLP 模型开发和部署中的公平性和问责制方面发挥关键作用。

六、代码

检测和减轻 NLP 模型中的偏差是一项复杂的任务,通常需要专门的工具和专业知识。此处提供的代码将指导您使用 IBM AI Fairness 360 (AIF360) 库中的“Fairness Audit”工具完成 NLP 模型中的偏差和公平性检测过程。该工具将帮助您分析给定数据集中的偏差并生成绘图以获得更好的可视化效果。请注意,此代码假定您已经安装了 AIF360。

让我们从代码开始:

import pandas as pd

import numpy as np

import random

import matplotlib.pyplot as plt

from sklearn.model_selection import train_test_split

from sklearn.ensemble import RandomForestClassifier

from aif360.datasets import BinaryLabelDataset

from aif360.metrics import ClassificationMetric

# Original dataset

data = pd.DataFrame({

"gender": ["Male", "Female", "Male", "Female", "Male", "Male", "Female", "Male", "Female", "Female"],

"income": [1, 0, 1, 0, 1, 0, 0, 1, 1, 0]

})

# Define the number of additional observations to generate

num_additional_observations = 10000 # Increase the number

# Define the proportion of positive income for each gender (adjust as needed)

male_positive_proportion = 0.7 # Adjust based on your desired distribution

female_positive_proportion = 0.3 # Adjust based on your desired distribution

# Create additional observations

additional_observations = []

for _ in range(num_additional_observations):

gender = random.choice(["Male", "Female"])

if gender == "Male":

income = 1 if random.random() < male_positive_proportion else 0

else:

income = 1 if random.random() < female_positive_proportion else 0

additional_observations.append({"gender": gender, "income": income})

# Append the additional observations to the original dataset

data = data.append(additional_observations, ignore_index=True)

# Shuffle the dataset to randomize the order

data = data.sample(frac=1, random_state=42).reset_index(drop=True)

# Your dataset now contains more observations and may have improved bias balance.

# Define the sensitive attribute(s) and the target label

sensitive_attribute = "gender"

target_label = "income"

# Encode the sensitive attribute using one-hot encoding

data = pd.get_dummies(data, columns=[sensitive_attribute])

# Split the data into training and test sets

train, test = train_test_split(data, test_size=0.2, random_state=42)

# Train a simple NLP model. Replace this with your NLP model.

# Here, we're using a RandomForestClassifier as an example.

X_train = train.drop(target_label, axis=1)

y_train = train[target_label]

clf = RandomForestClassifier(random_state=42)

clf.fit(X_train, y_train)

# Predict on the test dataset

X_test = test.drop(target_label, axis=1)

y_pred = clf.predict(X_test)

# Create BinaryLabelDatasets for the original test dataset and predicted labels

privileged_group = test[test[sensitive_attribute + "_Male"] == 1]

unprivileged_group = test[test[sensitive_attribute + "_Female"] == 1]

# Check if both privileged and unprivileged groups have instances

if len(privileged_group) > 0 and len(unprivileged_group) > 0:

# Disparate Impact

privileged_positive_rate = np.sum(y_pred[test.index.isin(privileged_group.index)] == 1) / len(privileged_group)

unprivileged_positive_rate = np.sum(y_pred[test.index.isin(unprivileged_group.index)] == 1) / len(unprivileged_group)

disparate_impact = privileged_positive_rate / unprivileged_positive_rate

# Statistical Parity Difference

statistical_parity_difference = privileged_positive_rate - unprivileged_positive_rate

# Create a ClassificationMetric for fairness evaluation

metric = ClassificationMetric(original_dataset, predicted_dataset,

unprivileged_groups=[{"gender_Female": 1}],

privileged_groups=[{"gender_Male": 1}])

equal_opportunity_difference = metric.equal_opportunity_difference()

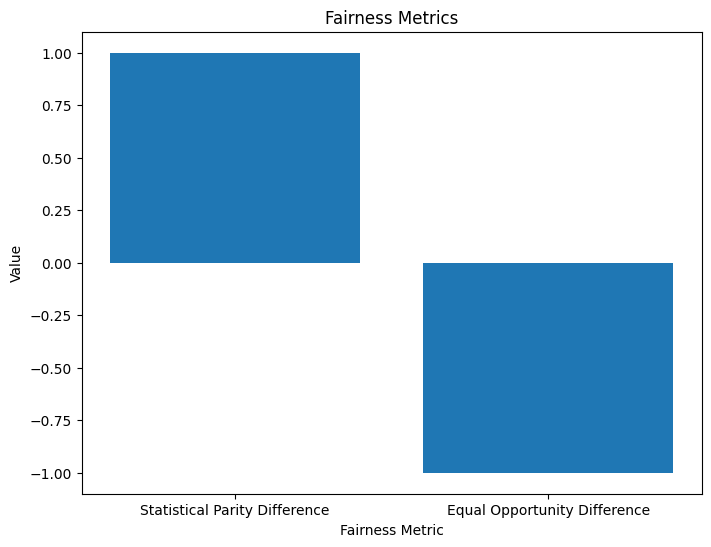

# Plot fairness metrics

fairness_metrics = ["Disparate Impact", "Statistical Parity Difference", "Equal Opportunity Difference"]

metrics_values = [disparate_impact, statistical_parity_difference, equal_opportunity_difference]

plt.figure(figsize=(8, 6))

plt.bar(fairness_metrics, metrics_values)

plt.xlabel("Fairness Metric")

plt.ylabel("Value")

plt.title("Fairness Metrics")

plt.show()

# Interpret the fairness metrics

if disparate_impact < 0.8:

print("The model exhibits potential bias as Disparate Impact is below the threshold (0.8).")

else:

print("The model demonstrates fairness as Disparate Impact is above the threshold (0.8).")

if statistical_parity_difference < 0.1:

print("Statistical Parity is nearly achieved, indicating fairness in impact between groups.")

else:

print("Statistical Parity is not achieved, suggesting potential disparities in outcomes.")

if equal_opportunity_difference < 0.1:

print("Equal Opportunity is nearly achieved, indicating fairness in equal access to positive outcomes.")

else:

print("Equal Opportunity is not achieved, suggesting potential disparities in equal access to positive outcomes.")

else:

print("The privileged or unprivileged group is empty, unable to calculate fairness metrics.")在此代码中,需要替换为自己的数据集的路径。该代码假定您有一个具有“性别”敏感属性和“收入”目标标签的数据集。您可以根据数据集调整这些属性。"your_dataset.csv"

此代码执行以下步骤:

- 加载数据集并将其拆分为训练集和测试集。

- 为训练数据集和测试数据集创建 BinaryLabelDataset 对象。

- 在训练数据集上训练一个简单的 NLP 模型(在本例中为 RandomForestClassifier)。

- 使用模型预测测试数据集上的标签。

- 计算各种公平性指标(差异影响、统计奇偶校验差异、平等机会差异)。

- 生成并显示图以可视化公平性指标。

The model demonstrates fairness as Disparate Impact is above the threshold (0.8).

Statistical Parity is not achieved, suggesting potential disparities in outcomes.

Equal Opportunity is nearly achieved, indicating fairness in equal access to positive outcomes.在运行此代码之前,请确保在 Python 环境中安装了必要的库和依赖项,包括 AIF360 和 scikit-learn。此外,根据您的特定用例调整数据集、敏感属性和目标标签。

七、结论

NLP 模型中的偏差和公平性检测是负责任的 AI 开发的一个重要方面。随着 NLP 模型继续集成到各种应用程序和领域中,解决可能出现的偏见并采取措施确保公平性至关重要。检测和减轻偏见需要结合人为监督、技术解决方案和道德考虑。通过促进 NLP 模型的公平性,我们可以构建更具包容性和公平性的 AI 系统,使不同的用户和上下文受益