AI视野·今日CS.Sound 声学论文速览

Mon, 23 Oct 2023

Totally 9 papers

👉上期速览✈更多精彩请移步主页

Daily Sound Papers

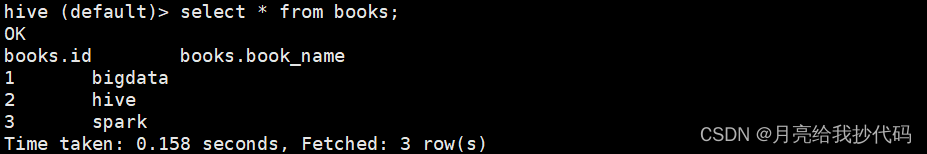

| Two-Stage Triplet Loss Training with Curriculum Augmentation for Audio-Visual Retrieval Authors Donghuo Zeng, Kazushi Ikeda 跨模态检索模型利用三重损失优化的潜力来学习鲁棒的嵌入空间。然而,现有的方法通常在一次训练中训练这些模型,忽略了优化过程中半硬三元组和硬三元组之间的区别。不区分半硬三元组和硬三元组的疏忽会导致模型性能不佳。在本文中,我们介绍了一种植根于课程学习的新方法来解决这个问题。我们提出了一个两阶段训练范例,指导模型从半困难到困难三元组的学习过程。在第一阶段,模型从低损失基础开始,使用一组半硬三元组进行训练。随后,在第二阶段,我们使用插值技术增强嵌入。这个过程识别了潜在的硬负数,缓解了由于硬三元组稀缺而导致的高损失函数引起的问题。然后,我们的方法在增强的嵌入空间中应用硬三元组挖掘来进一步优化模型。在两个视听数据集上进行的广泛实验结果表明,对于 AVE 数据集上的视听跨模态检索 AV CMR 任务,与当前最先进的方法 MSNSCA 相比,平均平均精度 MAP 显着提高了约 9.8, |

| Definition-independent Formalization of Soundscapes: Towards a Formal Methodology Authors Mikel D. Jedrusiak, Thomas Harweg, Timo Haselhoff, Bryce T. Lawrence, Susanne Moebus, Frank Weichert 来自不同学科的研究人员对音景进行了研究,每个学科都有不同的观点、目标、方法和术语。因此,根据领域的不同,音景组成部分的概念会发生变化,从而改变基本定义。这导致跨学科交流和结果比较变得复杂。尤其是当涉及到音景无关的研究领域时。因此,我们提出了一种独立于底层音景定义的潜在形式化,其目标是能够捕获数据的异构结构以及一个模型中的不同意识形态。 |

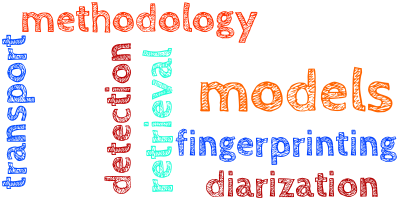

| Music Augmentation and Denoising For Peak-Based Audio Fingerprinting Authors Kamil Akesbi, Dorian Desblancs, Benjamin Martin 音频指纹识别是一种成熟的解决方案,用于从简短的录音摘录中识别歌曲。流行的方法依赖于稀疏表示(通常是光谱峰值)的提取,并且已被证明是准确、快速且可扩展到大型集合的。然而,音频识别的现实应用经常发生在嘈杂的环境中,这可能会导致这些系统失败。在这项工作中,我们通过引入和发布一个新的音频增强管道来解决这个问题,该管道通过随机模仿现实世界的场景,以现实的方式向音乐片段添加噪音。然后,我们提出并发布了一个深度学习模型,该模型可以从频谱图中消除噪声成分,以提高基于峰值的指纹识别系统的准确性。 |

| SALMONN: Towards Generic Hearing Abilities for Large Language Models Authors Changli Tang, Wenyi Yu, Guangzhi Sun, Xianzhao Chen, Tian Tan, Wei Li, Lu Lu, Zejun Ma, Chao Zhang 听觉可以说是人工智能智能体在物理世界中的一项必备能力,它指的是对一般听觉信息的感知和理解,其中一般听觉信息至少由语音、音频事件和音乐三种类型组成。在本文中,我们提出了 SALMONN,一种语音音频语言音乐开放神经网络,通过将基于预训练文本的大语言模型 LLM 与语音和音频编码器集成到单个多模态模型中而构建。 SALMONN 使法学硕士能够直接处理和理解一般音频输入,并在训练中使用的许多语音和音频任务上取得有竞争力的表现,例如自动语音识别和翻译、基于听觉信息的问答、情感识别、说话者验证和音乐SALMONN 还具有训练中未曾见过的各种新兴能力,包括但不限于将语音翻译为未经训练的语言、基于语音的槽位填充、基于口语查询的问答、基于音频的讲故事和语音音频协同推理textit等。研究了跨模态涌现能力的存在,并提出了一种新颖的少样本激活调整方法来激活 SALMONN 的此类能力。据我们所知,SALMONN 是该类型的第一个模型,可以被视为迈向具有通用听力能力的人工智能的一步。 |

| Powerset multi-class cross entropy loss for neural speaker diarization Authors Alexis Plaquet IRIT SAMoVA , Herv Bredin IRIT SAMoVA 自 2019 年推出以来,整个端到端神经二值化 EEND 工作线一直致力于将说话人二值化作为具有排列不变训练的帧式多标签分类问题。尽管 EEND 显示出巨大的前景,但最近的一些工作退后了一步,研究了局部监督 EEND 二值化与全局无监督聚类的可能组合。然而,这些混合贡献并没有质疑最初的多标签配方。我们建议从任意两个说话者可以同时处于活动状态的多标签切换到 powerset 多类分类,其中专用类被分配给重叠的说话者对。 |

| Neural domain alignment for spoken language recognition based on optimal transport Authors Xugang Lu, Peng Shen, Yu Tsao, Hisashi Kawai 域转移降低了跨域口语识别 SLR 的有效性,从而对跨域口语识别 SLR 提出了重大挑战。人们已经探索了无监督域适应 UDA 算法来解决 SLR 中的域移位问题,而不依赖于目标域中的类标签。一种成功的 UDA 方法侧重于学习域不变表示以对齐域之间的特征分布。然而,在域不变表示的学习过程中忽略类结构可能会导致过度对齐,从而对分类任务产生负面影响。为了克服这一限制,我们提出了一种基于 OT 的 UDA 算法,用于跨域 SLR,利用 OT 的分布几何结构感知特性。在基于 OT 的 UDA 中的域对齐期间,考虑了基于 OT 的特征和标签信息联合分布的差异度量。我们之前的研究发现,完全对齐源域和目标域之间的分布可能会引入负迁移,其中在分布对齐期间,源域中的类或不相关类映射到目标域中的不同类。这种负迁移会降低自适应模型的性能。为了缓解这个问题,我们在 SLR 的 UDA 框架中引入了耦合加权部分最优传输 POT,其中基于传输成本的 OT 耦合的软权重在域对齐期间自适应设置。实验中使用跨域 SLR 任务来评估所提出的 UDA。 |

| On the Language Encoder of Contrastive Cross-modal Models Authors Mengjie Zhao, Junya Ono, Zhi Zhong, Chieh Hsin Lai, Yuhta Takida, Naoki Murata, Wei Hsiang Liao, Takashi Shibuya, Hiromi Wakaki, Yuki Mitsufuji CLIP 和 CLAP 等对比跨模态模型有助于各种视觉语言 VL 和音频语言 AL 任务。然而,对其语言编码器的研究和改进有限,语言编码器是将图像音频的自然语言描述编码为矢量表示的核心组件。我们广泛评估无监督和监督句子嵌入训练如何影响语言编码器质量和跨模式任务性能。在 VL 预训练中,我们发现句子嵌入训练语言编码器质量并有助于跨模态任务,从而改进对比 VL 模型(例如 CyCLIP)。相比之下,AL 预训练从句子嵌入训练中获益较少,这可能是由于预训练数据量有限所致。 |

| AVTENet: Audio-Visual Transformer-based Ensemble Network Exploiting Multiple Experts for Video Deepfake Detection Authors Ammarah Hashmi, Sahibzada Adil Shahzad, Chia Wen Lin, Yu Tsao, Hsin Min Wang 在社交媒体平台上广泛分享的伪造内容是一个重大的社会问题,需要加强监管,并给研究界带来了新的挑战。最近超现实深度伪造视频的激增引起了人们对音频和视频伪造威胁的关注。之前大多数检测人工智能生成的虚假视频的工作仅利用视觉模态或音频模态。虽然文献中存在一些利用音频和视觉模态来检测伪造视频的方法,但它们尚未在涉及声学和视觉操作的深度伪造视频的多模态数据集上进行全面评估。此外,这些现有方法大多基于CNN,检测精度较低。受最近 Transformer 在各个领域取得成功的启发,为了解决 Deepfake 技术带来的挑战,在本文中,我们提出了一种基于音频视觉 Transformer 的 Ensemble Network AVTENet 框架,该框架同时考虑声学操纵和视觉操纵,以实现有效的视频伪造检测。具体来说,所提出的模型集成了几个纯粹基于变压器的变体,这些变体捕获视频、音频和视听显着线索,以在预测中达成共识。为了进行评估,我们使用最近发布的基准多模态音频视频 FakeAVCeleb 数据集。为了进行详细分析,我们在 FakeAVCeleb 数据集的多个测试集上评估了 AVTENet、其变体以及几种现有方法。 |

| Generative error correction for code-switching speech recognition using large language models Authors Chen Chen, Yuchen Hu, Chao Han Huck Yang, Hexin Liu, Sabato Marco Siniscalchi, Eng Siong Chng 语码转换 CS 语音是指在同一个句子中混合两种或多种语言的现象。尽管自动语音识别 ASR 取得了最新进展,但由于现象的语法结构复杂性和特定训练语料库的数据稀缺性,CS ASR 仍然是一项具有挑战性的任务。在这项工作中,我们建议利用大型语言模型 LLM 和 ASR 生成的假设列表来解决 CS 问题。具体来说,我们首先采用多个训练有素的 ASR 模型来生成 N 个最佳假设,目的是增加假设集中的多样性和信息性元素。接下来,我们利用 LLM 通过添加可训练的低阶适配器来学习转录 H2T 映射的假设。这种生成式纠错GER方法根据其专业语言知识和N个最佳假设直接预测准确的转录,从而导致传统语言模型重新评分或纠错技术的范式转变。实验证据表明,GER 显着提高了 CS ASR 的准确性,降低了混合错误率 MER 。 |

| Chinese Abs From Machine Translation |

Papers from arxiv.org

更多精彩请移步主页

pic from pexels.com