在当今的数字化时代,网络爬虫已经成为了收集信息和数据的重要工具。然而,许多网站和平台都配备了反爬虫机制,以防止恶意攻击和过度访问。对于普通用户来说,如何突破这些反爬虫机制呢?本文将为你提供一些实用的技巧和建议。

一、了解反爬虫机制

首先,你需要了解什么是反爬虫机制。简单来说,反爬虫机制就是网站或平台为了防止被自动抓取或恶意攻击而设置的一套防护措施。这些措施包括限制访问频率、检测异常行为、识别爬虫程序等。

因此,突破反爬虫机制的关键在于规避这些防护措施,以模拟真实用户的访问行为。

二、使用代理IP

代理IP是一种突破反爬虫机制的有效方法。通过使用代理IP,你可以隐藏自己的真实IP地址,并伪装成来自不同地区的正常用户进行访问。

这样,网站就无法将你的访问行为与其他异常行为进行关联,从而规避了反爬虫机制的检测。

三、控制访问频率

许多反爬虫机制都会监测用户的访问频率。如果你的访问频率过高,就会被认为是爬虫程序或恶意攻击,从而被禁止访问。

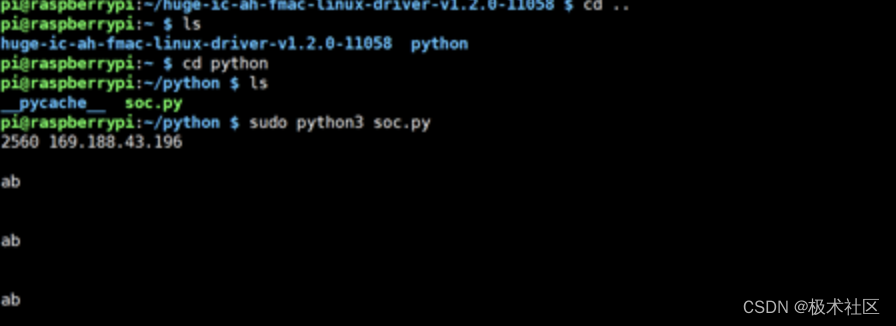

因此,你需要控制好自己的访问频率,以模拟正常用户的访问行为。可以通过增加访问间隔时间、使用sleep函数等方式来降低访问频率。

四、使用User Agent

User Agent是浏览器向服务器发送请求时携带的一个头信息,其中包含了浏览器的类型、版本、操作系统等信息。许多反爬虫机制都会检测User Agent是否符合正常浏览器的特征,以判断访问行为是否正常。

因此,你可以通过设置合适的User Agent来规避反爬虫机制的检测。可以从网上搜索一些真实用户的User Agent,然后随机选择一个进行设置。

五、使用Cookie

Cookie是网站为了识别用户身份而存储在用户本地终端中的小型文本文件。许多反爬虫机制都会检测用户是否携带了有效的Cookie,以判断访问行为是否正常。

因此,你需要获取网站的Cookie,并将其添加到请求头中。可以通过浏览器开发者工具来查看当前网页的Cookie信息,并将其复制到请求头中。

六、模拟真实用户行为

最后,你需要模拟真实用户的行为来进行访问。这包括点击链接、填写表单、滚动页面等操作。这样可以让你的访问行为更加逼真,从而规避反爬虫机制的检测。

此外,还可以使用JavaScript或jQuery等前端技术来增强模拟的真实性。

总之,突破反爬虫机制需要综合考虑多种方法和技术,以模拟正常用户的访问行为。通过使用代理IP、控制访问频率、使用User Agent、使用Cookie以及模拟真实用户行为等技巧和建议,你可以更加有效地突破反爬虫机制的限制,实现数据的抓取和采集。