文章目录

- 综述

- 1. 全零与随机初始化

- 2. 标准初始化(固定方差)

- 3. Xavier初始化(方差缩放)

- 4. He初始化

- 5. 正交初始化

- 6. MSRA初始化

综述

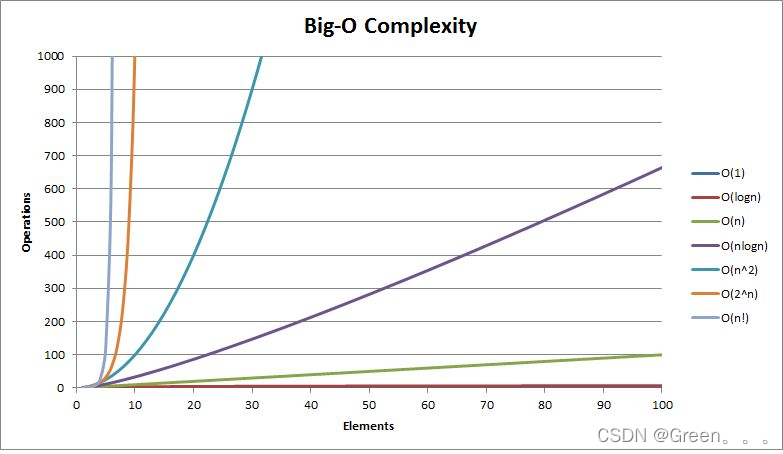

这些是不同的权重初始化方法,用于初始化神经网络的权重参数。它们的主要区别在于初始化权重的策略和数学原理。以下是这些初始化方法的简要介绍和区别:

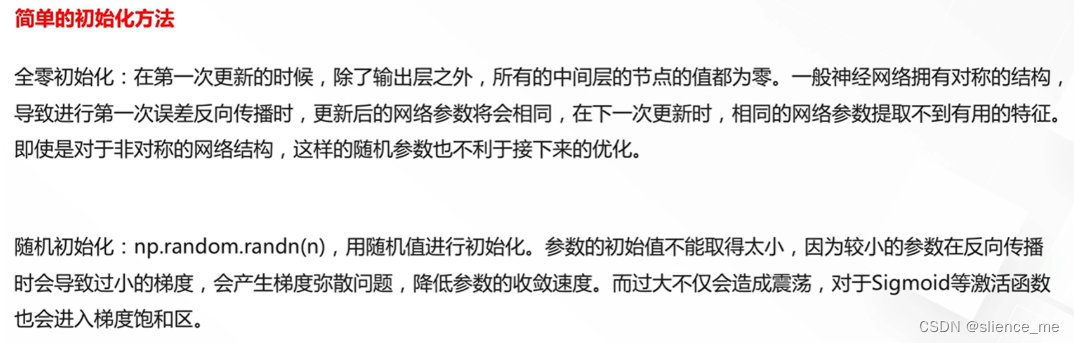

简单初始化(Zero Initialization):

- 策略:所有权重初始化为零。

- 区别:这是最简单的初始化方法,但通常不建议使用,因为在多层神经网络中,所有的神经元将拥有相同的权重,导致对称性问题,不利于学习。

随机初始化(Random Initialization):

- 策略:权重以随机小的值初始化,通常在[-ε, ε]的范围内,其中ε是一个很小的正数。

- 区别:随机初始化打破了对称性,允许神经网络从不同的起点开始学习,改善了训练过程。

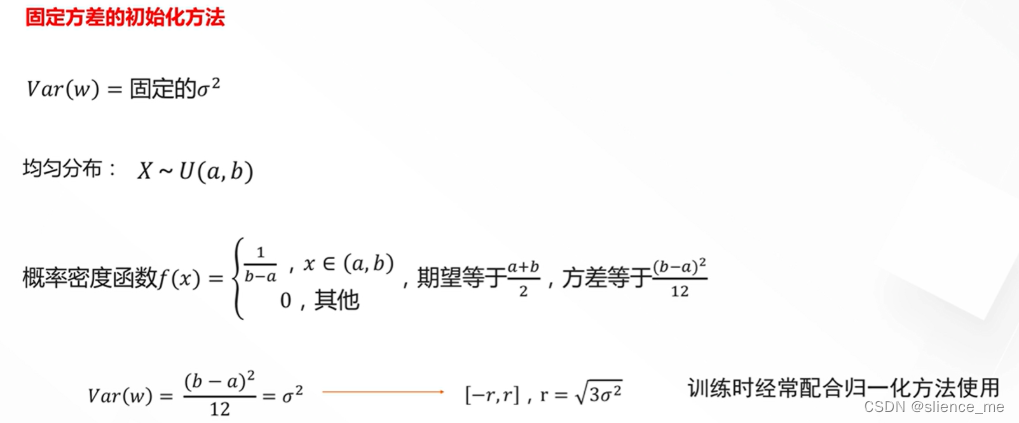

固定方差初始化(Fixed Variance Initialization):

- 策略:权重初始化时,使用一个固定的方差,通常是从正态分布中选择的。

- 区别:这个方法确保权重的分布具有相对一致的方差,但不一定适用于所有网络结构和任务。

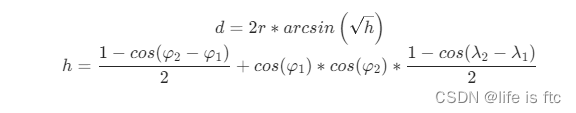

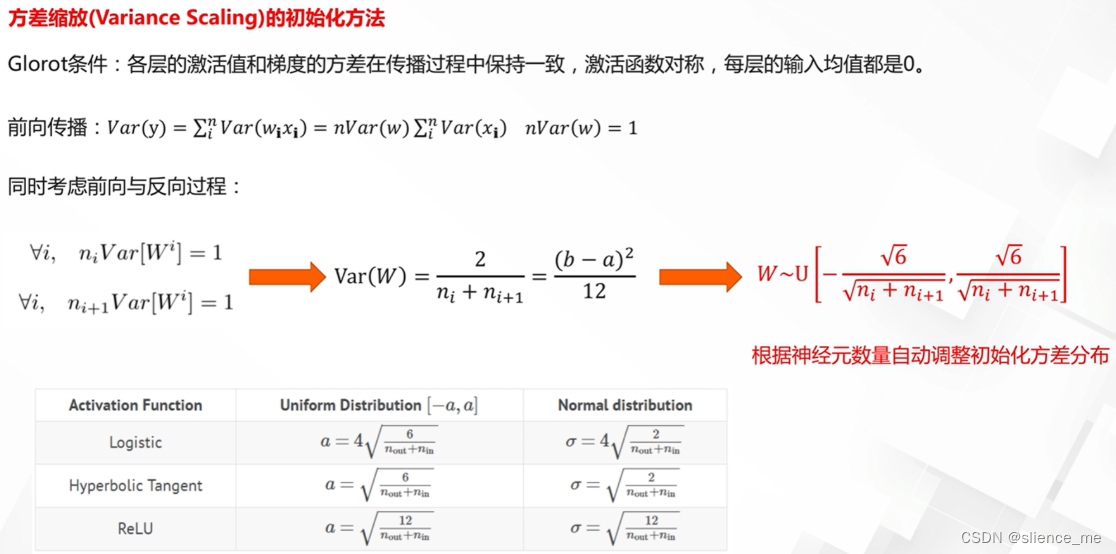

方差缩放初始化(Variance Scaling Initialization):

- 策略:权重初始化时,方差根据网络的输入和输出的维度进行缩放,通常以特定的方式选择。

- 区别:这个方法试图通过权重初始化来平衡信号的方差,以防止梯度消失或爆炸问题,并有助于更稳定的训练。

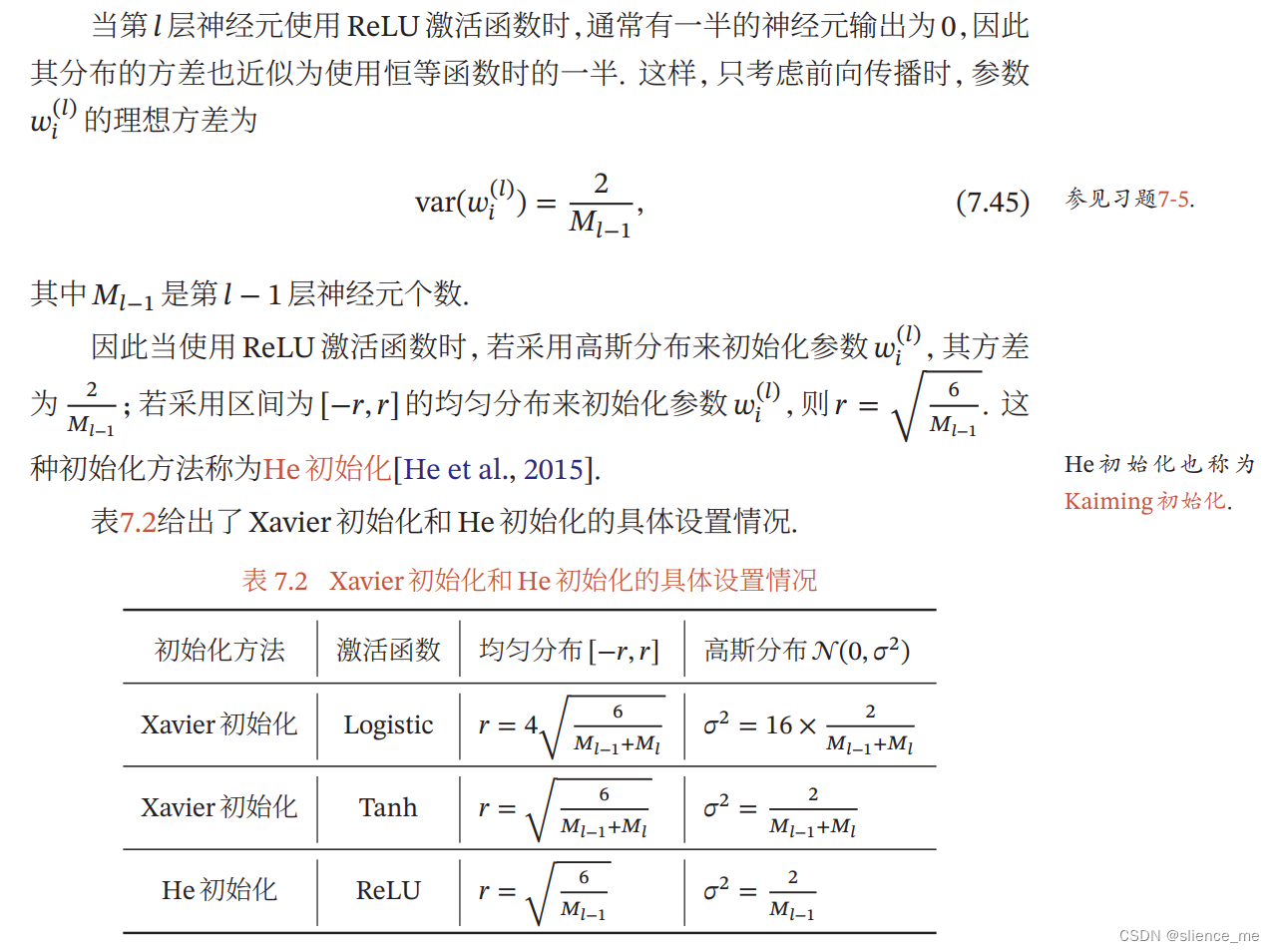

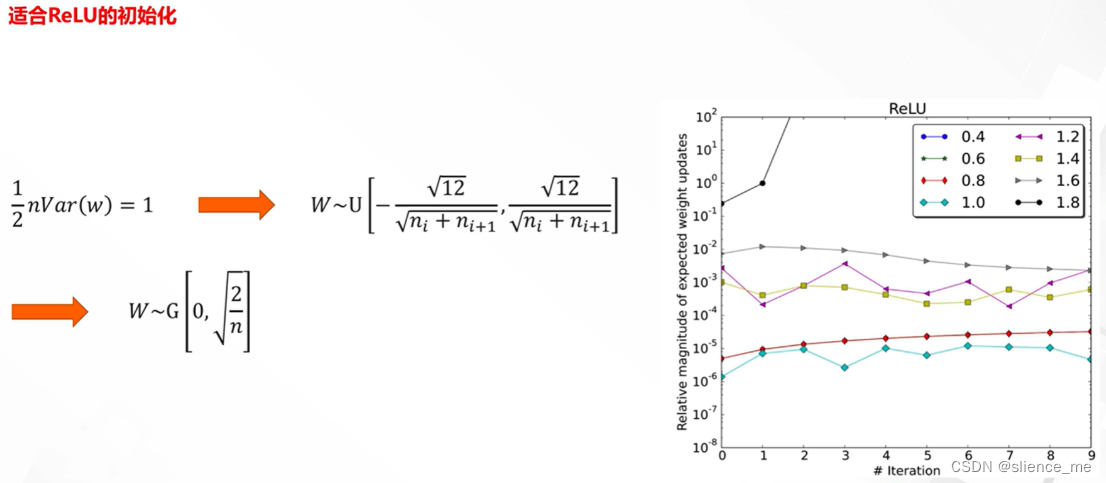

He初始化(He Initialization):

- 策略:权重初始化是根据网络的输入和输出的维度进行的,方差被设置为2/n,其中n是权重连接的输入维度。

- 区别:He初始化是为深度卷积神经网络设计的,通过设置适当的方差,可以提高网络的学习速度和性能。

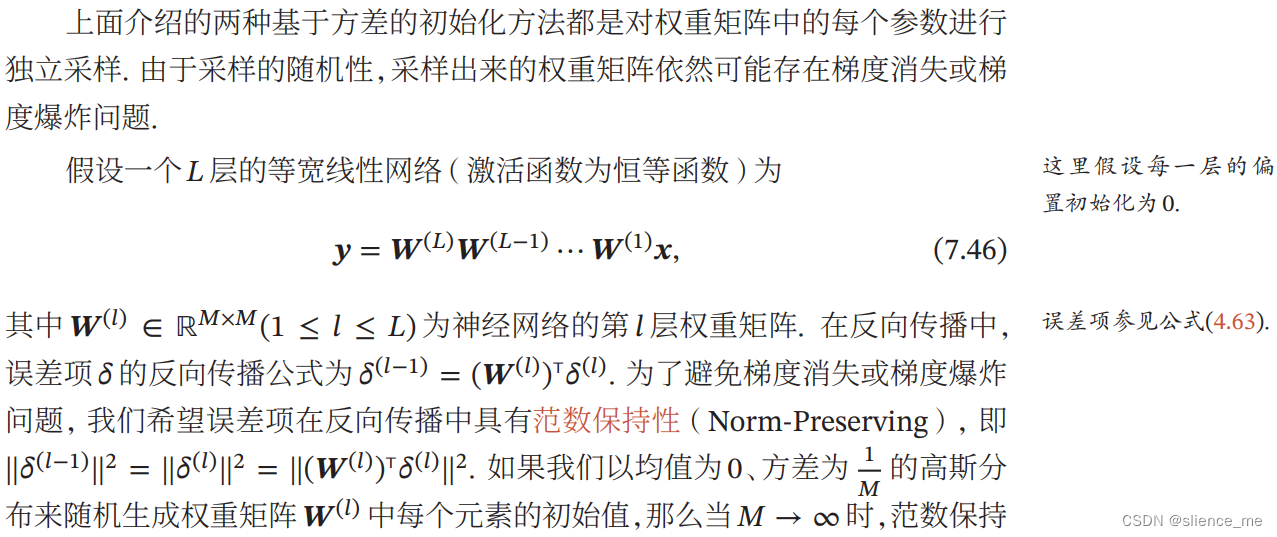

正交初始化(Orthogonal Initialization):

- 策略:权重初始化是通过生成正交矩阵来实现的,确保权重之间彼此正交。

- 区别:正交初始化有助于减少权重之间的冗余信息,提高网络的效率和学习性能。

MSRA初始化(Microsoft Research for Advanced Initiative Initialization):

- 策略:权重初始化是根据网络的输入和输出的维度进行的,方差被设置为2/(n_in + n_out),其中n_in是输入维度,n_out是输出维度。

- 区别:MSRA初始化旨在平衡信号的方差,以提高网络的训练速度和性能。

- 不同的初始化方法适用于不同的网络结构和任务。通常,随机初始化、He初始化和MSRA初始化在深度神经网络中表现良好,因为它们可以打破对称性,有助于更快的收敛和更好的性能。选择正确的初始化方法通常是深度学习中的一个重要超参数,需要根据具体的情况进行调整。

1. 全零与随机初始化

2. 标准初始化(固定方差)

3. Xavier初始化(方差缩放)

4. He初始化

5. 正交初始化

6. MSRA初始化

部分内容来自: 阿里云天池、神经网络与深度学习(邱锡鹏著)