2018_Style Tokens: Unsupervised Style Modeling, Control and Transfer in End-to-End Speech Synthesis

1.样式标记:端到端语音合成中的无监督样式建模、控制和传输

paper:Style Tokens: Unsupervised Style Modeling, Control and Transfer in End-to-End Speech Synthesis (arxiv.org)

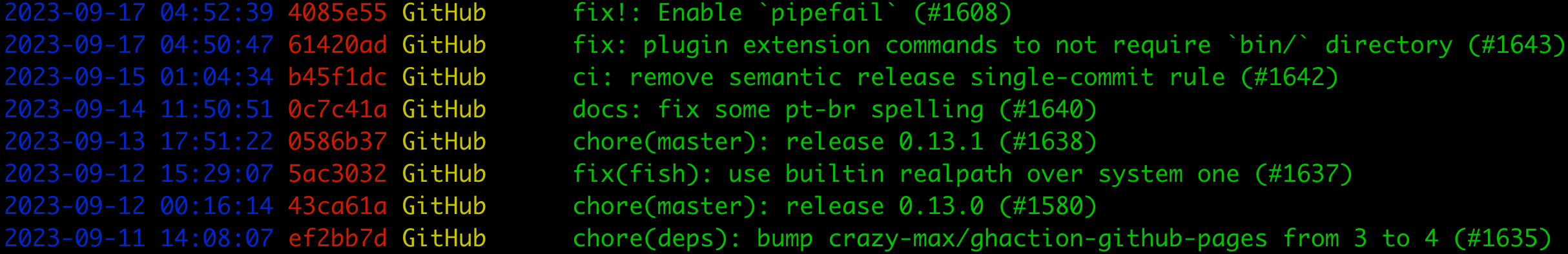

code:jinhan/tacotron2-gst: Tacotron2 with Global Style Tokens (github.com)

摘要

在这项工作中,我们提出了“全局风格迁移”(GST),这是一个在Tacotron(最先进的端到端语音合成系统)中联合训练的嵌入库。嵌入在没有明确标签的情况下进行训练,但学会了对大范围的声学表现力进行建模。商品及服务税会带来一系列丰富的重要结果。它们生成的软可解释“标签”可用于以新颖的方式控制合成,例如改变速度和说话风格 - 独立于文本内容。它们还可用于风格转换,在整个长格式文本语料库中复制单个音频剪辑的说话风格。当对嘈杂的、未标记的发现数据进行训练时,GST 学会分解噪声和说话人身份,为高度可扩展但强大的语音合成提供了一条途径。

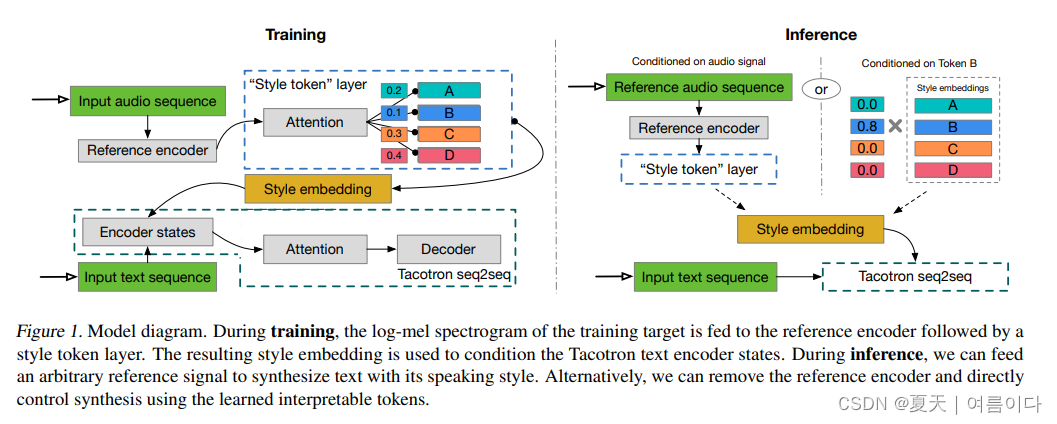

GST model包含了一个 reference encoder, style attention, style embedding, and sequence-to-sequence (Tacotron) model.

在训练时

Skerry-Ryan等人提出的参考编码器能将可变长度音频信号的前音压缩成固定长度的向量,我们称之为参考嵌入。在训练过程中

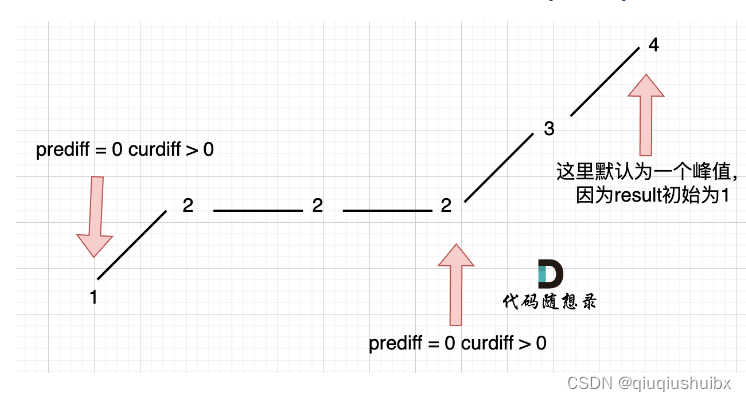

- 参考嵌入被传递到风格标记层,将其作为注意力模块的查询向量。在这里,注意力不是用来学习对齐。相反,它学习的是之间的相似性度量。随机初始化嵌入库中的每个标记之间的相似度量。这组嵌入库,我们也称之为全局样式标记、GST 或标记嵌入,在所有训练序列中共享。

- 注意力模块会输出一组组合权重,它代表了每种风格标记对编码参考嵌入的贡献。加权之和,我们称之为风格嵌入、在每个时间步传递给文本编码器进行调节。

- 风格标记层与模型的其他部分共同训练,仅由重建驱动。

模型的其他部分共同训练,只受来自 Tacotron 解码器的重构损失的驱动。因此,GST 不需要任何

明确的风格或韵律标签。

推理时

GST 架构旨在实现强大而灵活的在推理模式下进行控制。

在这种模式下,信息可以以两种方式之一流过模型:

1. 我们可以直接将文本编码器设定为某些标记的条件,如图 1 中推理模式图的右侧所示("以某些标记为条件")。这样就可以在没有参考信号的情况下进行样式控制和操作。

2. 我们可以输入不同的音频信号(其转录本不需要与要合成的文本相匹配)来实现风格转移。

图 1 中推理模式图的左侧描述了这一点(以音频信号为条件")。

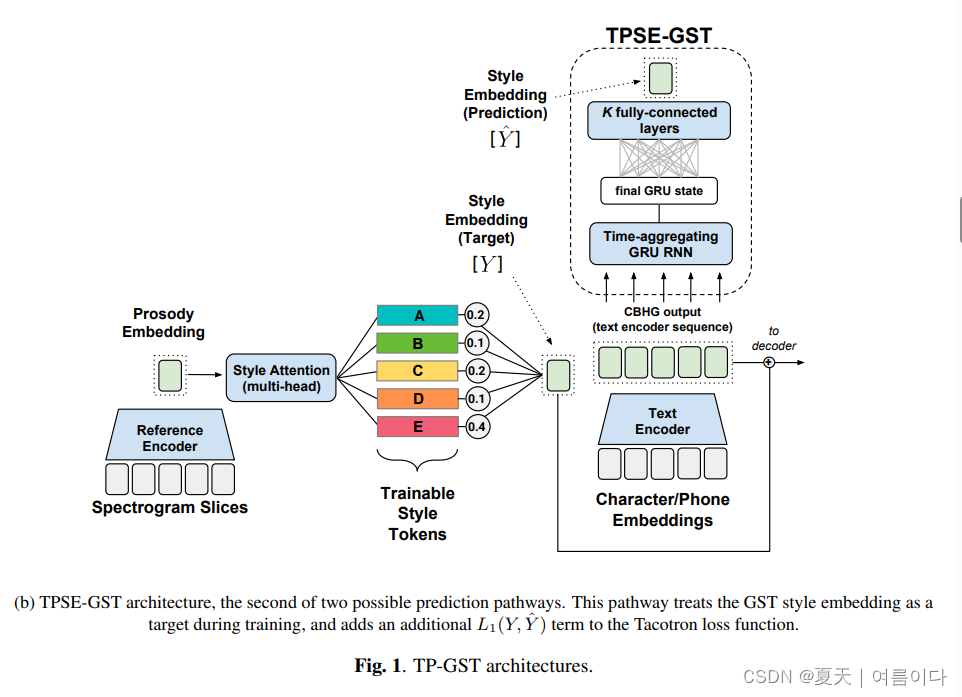

2018_Text-Predicted Global Style Token (TP-GST):PREDICTING EXPRESSIVE SPEAKING STYLE FROM TEXT IN END-TO-END SPEECH SYNTHESIS

2.从端到端语音合成中的文本预测富有表现力的说话风格

paper:1808.01410.pdf (arxiv.org)

摘要

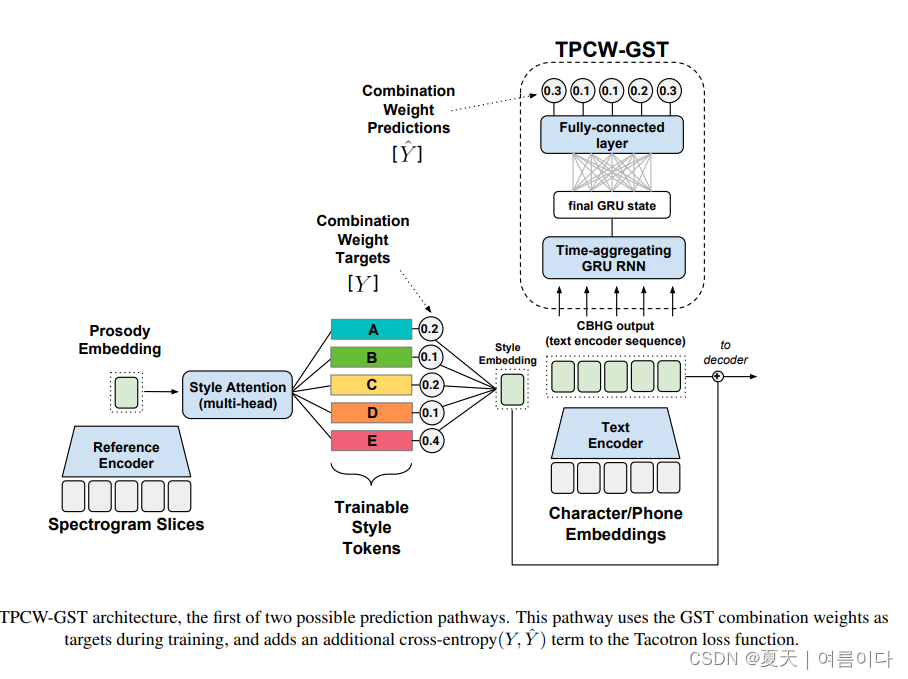

全局样式令牌 (GST) 是最近提出的一种学习高维数据的潜在解开表示的方法。GST可以在Tacotron中使用,Tacotron是一种最先进的端到端文本到语音合成系统,以发现说话风格变化的表现因素。在这项工作中,我们介绍了文本预测全局风格令牌(TP-GST)架构,该架构将GST组合权重或风格嵌入视为Tacotron中的“虚拟”说话风格标签。TP-GST仅从文本中学习预测文体渲染,在训练期间既不需要明确的标签,也不需要辅助输入进行推理。我们表明,当在表达性语音数据集上进行训练时,我们的系统会生成的音频比两个最先进的基线模型具有更多的音高和能量变化。我们进一步证明,TP-GST可以在去除背景噪声的情况下合成语音,并在人类评估的听众偏好有声读物任务上以积极的结果证实这些分析。最后,我们证明了多说话人TP-GST模型成功地分解了说话人的身份和说话风格。我们提供了一个网站,其中包含每个发现的音频样本。

2022_Disentangling style and speaker attributes for TTS style transfer

3.语音合成中基于风格和说话人成分解耦的风格迁移

[2201.09472] Disentangling Style and Speaker Attributes for TTS Style Transfer (arxiv.org)

摘要

端到端神经 TTS 在语音风格转换方面表现出改进的性能。但是,改进仍然受到目标风格和说话人的可用训练数据的限制。此外,当经过训练的 TTS 尝试将语音从具有未知任意风格的新说话人转移到目标风格时,会观察到性能下降。在本文中,我们提出了一种在不相交的多风格数据集上进行可见和看不见的风格迁移训练的新方法,即记录不同风格的数据集,一个说话者在多个话语中记录一个单独的风格。首先引入了逆自回归流(IAF)技术,以改进学习表达风格表示的变分推理。然后开发一个说话人编码器网络来学习判别性说话人嵌入,该网络与其他神经TTS模块联合训练。所提出的看得见和看不见的风格迁移方法经过了六个专门设计的目标的有效训练:重建损失、对抗性损失、风格失真损失、周期一致性损失、风格分类损失和说话人分类损失。实验客观和主观地证明了所提出的方法对看得见和看不见的风格迁移任务的有效性。我们的方法的性能优于现有技术的其他四个参考系统,并且比该方法更强大。

参考文献

【1】论文推介:语音合成中基于风格和说话人成分解耦的风格迁移 - 知乎 (zhihu.com)

References

Y. Wang, D. Stanton, Y. Zhang, R. Skerry-Ryan, E. Battenberg, J. Shor, Y. Xiao, F. Ren, Y. Jia, and R. A. Saurous, “Style tokens: Unsupervised style modeling, control and transfer in end-to-end speech synthesis,” International Conference on Machine Learning, 2018. [Online]. Available: https://arxiv.org/abs/1803.09017

H.-S. Choi, J. Lee, W. Kim, J. Lee, H. Heo, and K. Lee, “Neural analysis and synthesis: Reconstructing speech from self-supervised representations,” Advances in Neural Information Processing Systems, vol. 34, pp. 16 251–16 265, 2021.

[2] Y. Ren et al., “Fastspeech 2: Fast and high-quality end-to-end text to speech,” in Proc. Int. Conf. Learn. Representations, 2020.

[3] Y. Ren, Y. Ruan, X. Tan, T. Qin, S. Zhao, Z. Zhao, and T.-Y. Liu, “Fast-speech: Fast, robust and controllable text to speech,” The International Conference on Neural Information Processing Systems (NeurIPS), pp. 3165–3174, 2019.

[4] Y. Wang, D. Stanton, Y. Zhang, R.-S. Ryan, E. Battenberg, J. Shor, Y. Xiao, Y. Jia, F. Ren, and R. A. Saurous, “Style tokens: Unsupervised style modeling, control and transfer in end-to-end speech synthesis,” in the International Conference on Machine Learning (ICML). PMLR, 2018, pp. 5180–5189.

[5] K. Akuzawa, Y. Iwasawa, and Y. Matsuo, “Expressive Speech Synthesis via Modeling Expressions with Variational Autoencoder,” in The Annual Conference of the International Speech Communication Association (Interspeech), 2018, pp. 3067–3071.

[6] S. Pan and L. He, “Cross-Speaker Style Transfer with Prosody Bottleneck in Neural Speech Synthesis,” in The Annual Conference of the International Speech Communication Association (Interspeech), 2021, pp. 4678–4682.

[7] Y. Wang, R. Skerry-Ryan, D. Stanton, Y. Wu, R. J. Weiss, N. Jaitly, Z. Yang, Y. Xiao, Z. Chen, S. Bengio et al., “Tacotron: Towards end-to-end speech synthesis,” in The Annual Conference of the International Speech Communication Association (Interspeech), 2017, pp. 4006–4010.

[8] R. Liu, B. Sisman, G. Gao, and H. Li, “Expressive tts training with frame and style reconstruction loss,” IEEE/ACM Transactions on Audio, Speech, and Language Processing, vol. 29, pp. 1806–1818, 2021.