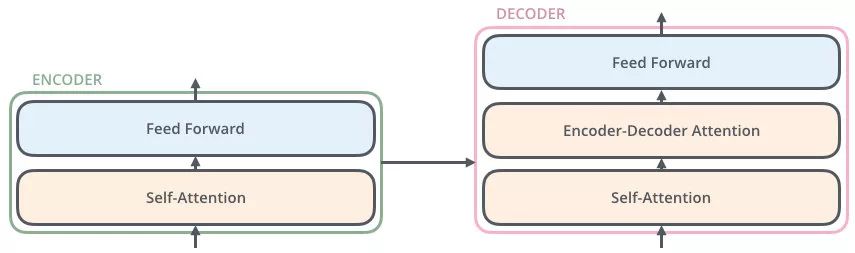

Transformer 编码器

编码器在干吗:词向量、图片向量,总而言之,编码器就是让计算机能够更合理地(不确定性的)认识人类世界客观存在的一些东西

Transformer 解码器

解码器会接收编码器生成的词向量,然后通过这个词向量去生成翻译的结果。

解码器的 Self-Attention 在编码已经生成的单词

假如目标词“我是一个学生”—》masked Self-Attention

训练阶段:目标词“我是一个学生”是已知的,然后 Self-Attention 是对“我是一个学生” 做计算

如果不做 masked,每次训练阶段,都会获得全部的信息

如果做 masked,Self-Attention 第一次对“我”做计算

Self-Attention 第二次对“我是”做计算

……

测试阶段:

- 目标词未知,假设目标词是“我是一个学生”(未知),Self-Attention 第一次对“我”做计算

- 第二次对“我是”做计算

- ……

而测试阶段,没生成一点,获得一点

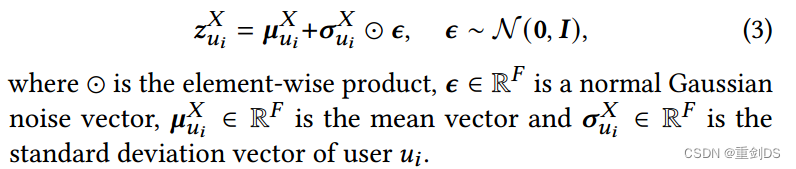

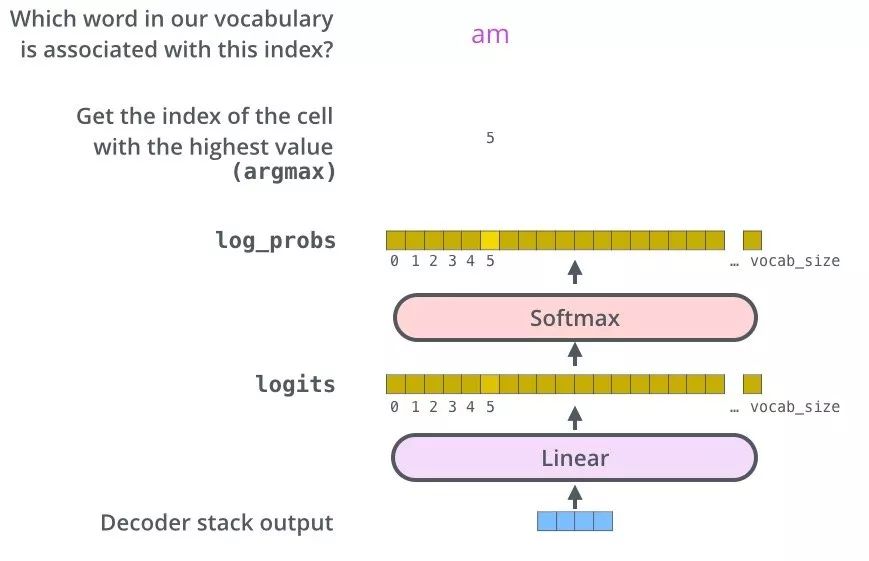

生成词

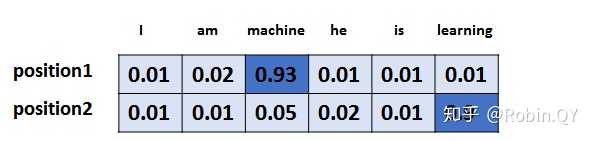

Linear 层转换成词表的维度

softmax 得到最大词的概率

softmax 细话

单词表