大模型基础——大模型范式

news2026/2/17 0:22:25

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.coloradmin.cn/o/1117720.html

如若内容造成侵权/违法违规/事实不符,请联系多彩编程网进行投诉反馈,一经查实,立即删除!相关文章

Leetcode—2525.根据规则将箱子分类【简单】

2023每日刷题(五)

Leetcode—2525.根据规则将箱子分类 实现代码

char * categorizeBox(int length, int width, int height, int mass){long long volume;long long len (long long)length;long long wid (long long)width;long long heig (long lo…

VFP GRID每行BLOB显示图片,简单几行代码就完成啦

不止一位狐友问我,想在表格里面显示图片,于是我想了想,满足狐友们的期望,升级了一个框架控件,再来个超容易的教程。 一、拖入一个表单 二、删除自动生成的TEXTBOX1 选中表格,右键->编辑 ,点击…

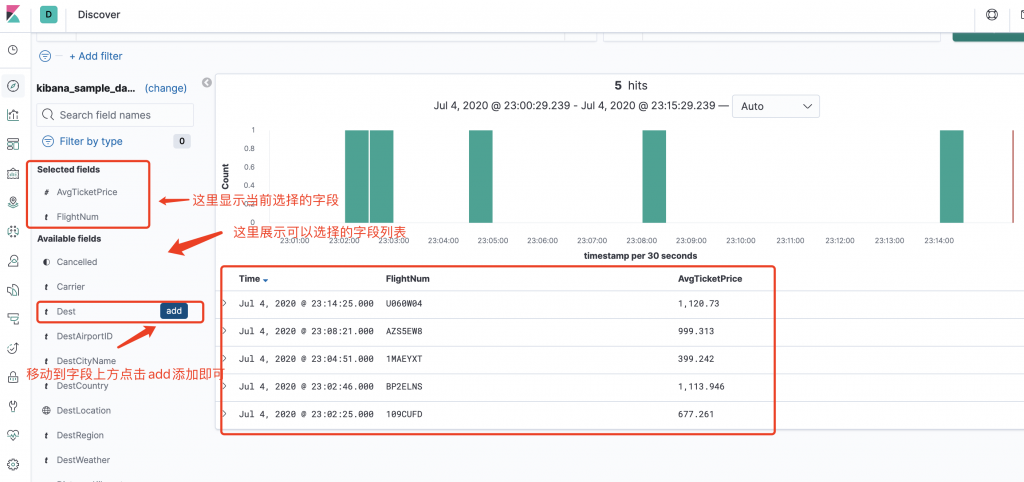

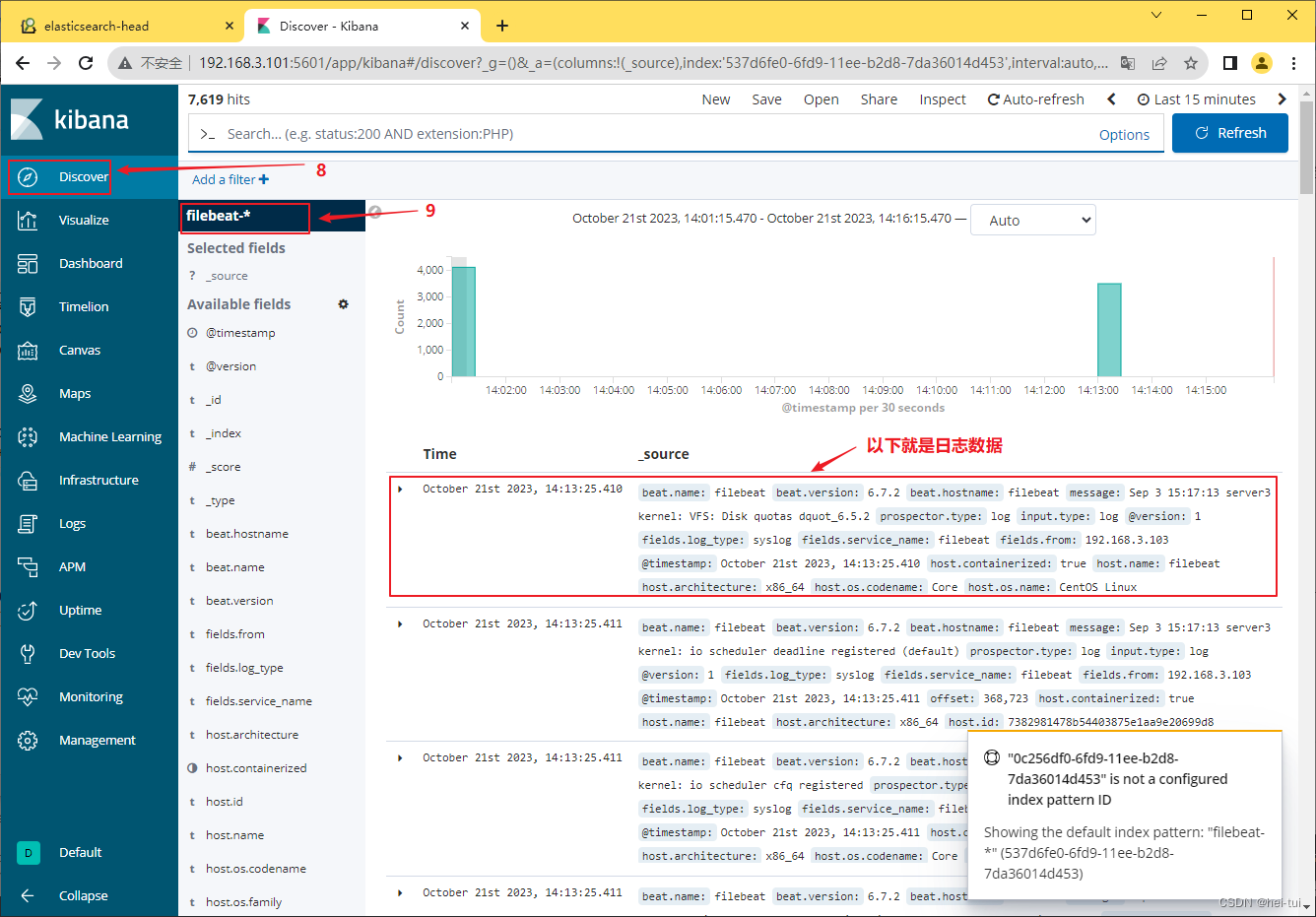

Kibana Discover数据查询

步骤1:打开管理页面(Management) 步骤2:

因为前面的章节导入航班数据的时候,自动创建了一个名字叫kibana_sample_data_flights的航班数据索引,如果我们只想搜索kibana_sample_data_flights索引的数据,则不需要通配符&…

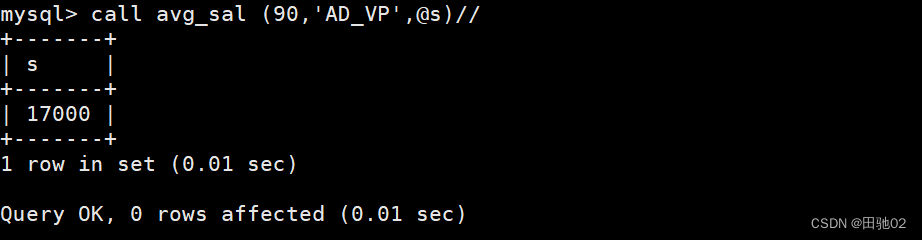

Mysql数据库表操作--存储

建表: 插入上面的数据: 1、创建一个可以统计表格内记录条数的存储函数 ,函数名为count_sch() 2、创建一个存储过程avg_sal,有3个参数,分别是deptno,job,接收平均工资(out);功能查询employees表的…

不做技术不会管理,测试人还有这个职位可以进阶

之前我们讲过,测试工程师的4层技术发展路线都需要掌握哪些技能。学而优则仕,今天我们来说说如果想做某个行业的专家应该掌握哪些技能。

如果你对测试技术不感兴趣,但对某领域的业务兴趣浓厚,可以考虑行业专家路线。

由于测试工程…

python单元测试框架(继承、unittest参数化、断言、测试报告)

一、继承

继承能解决什么问题?

unittest每个模块都要用到前提条件以及清理,如果有上百个模块,我们要改域名和浏览器,就会工作量很大特别麻烦,这时我们可以用继承的思想只用改一次

我们可以将前提和清理提出来单独放…

日志分析系统——ELK

目录

一、ELK概述

ELK的组成

1、ElasticSearch

2、Logstash

3、Kiabana

完整日志采集系统基本特征

ELK的工作原理

二、ELK的部署

1、环境准备

2、部署ElasticSearch软件

3、安装Elasticsearch-head插件

4、Logstash部署

5、Kibana部署

三、FilebeatELK部署

1、安…

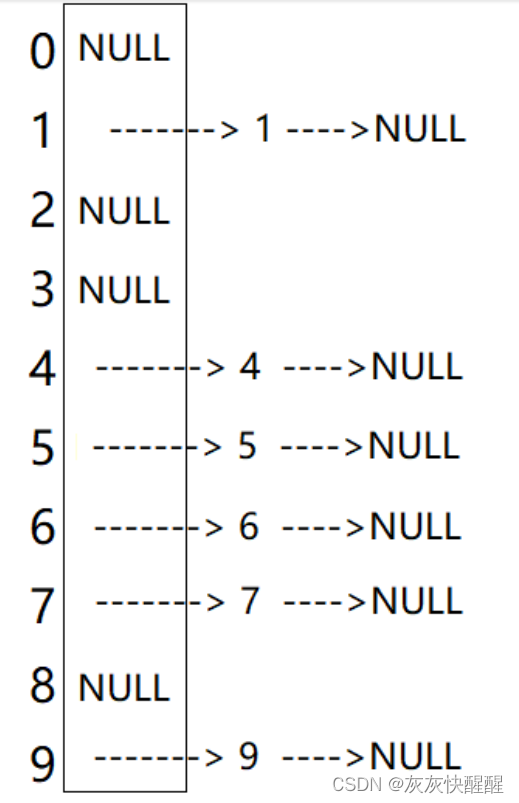

python基础教程:递归函数教程

嗨喽,大家好呀~这里是爱看美女的茜茜呐 1.递归的定义:

在函数内部直接或者间接调用函数本身 👇 👇 👇 更多精彩机密、教程,尽在下方,赶紧点击了解吧~

python源码、视频教程、插件安装教程、资…

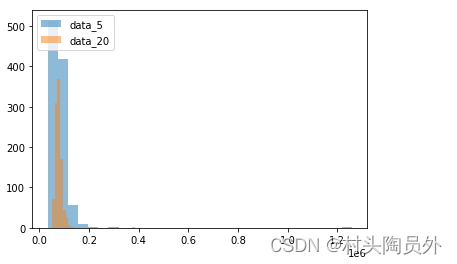

数据科学中常用的应用统计知识

随着大数据算法技术发展,数据算法越来越倾向机器学习和深度学习相关的算法技术,概率论和应用统计 等传统的技术貌似用的并不是很多了,但实则不然,在数据科学工作,还是会经常需要应用统计概率相关知识解决一些数据问题&…

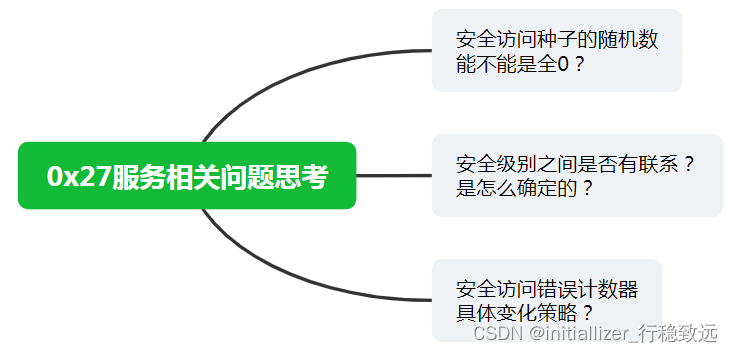

Autosar诊断实战系列25-UDS 0x27服务相关问题思考

本文框架 前言0x27服务几个相关问题1. 安全访问种子的随机数能不能是全0?2. 安全级别之间是否有联系?是怎么确定的?3. 安全访问错误计数器具体变化策略?前言

在本系列笔者将结合工作中对诊断实战部分的应用经验进一步介绍常用UDS服务的进一步探讨及开发中注意事项, Dem/D…

如何使用 AI 快速学习新技术?

大家好,我是木川 当今,技术的快速发展势不可挡。无论您是初学者还是专业人士,学习新技术都是不可或缺的。 在没有 AI 的时代,我们如何学习新技术?而当 AI 出现后,我们如何更高效地掌握新技术呢?…

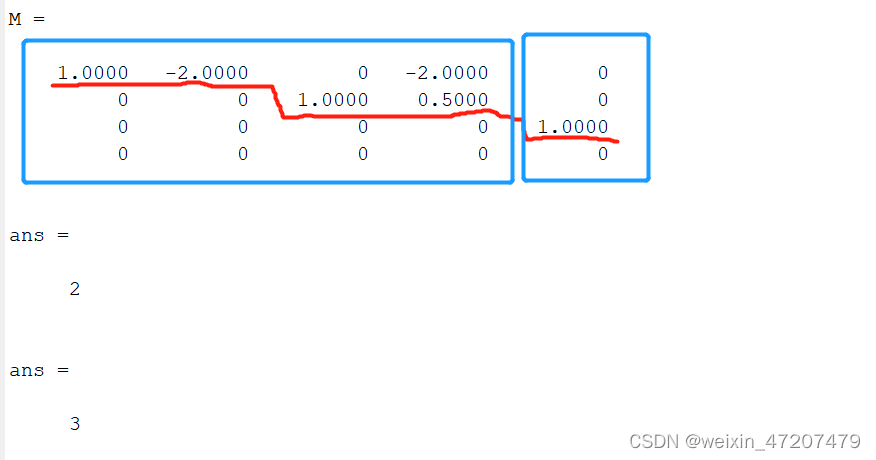

线性代数中涉及到的matlab命令-第三章:矩阵的初等变换及线性方程组

目录

1,矩阵的初等变换

1.1,初等变换

1.2,增广矩阵

1.3,定义和性质

1.4,行阶梯型矩阵、行最简型矩阵

1.5,标准形矩阵

1.6,矩阵初等变换的性质

2,矩阵的秩

3ÿ…

黑客技术(自学方法)——网络安全技术

前言

前几天发布了一篇 网络安全(黑客)自学 没想到收到了许多人的私信想要学习网安黑客技术!却不知道从哪里开始学起!怎么学?如何学? 今天给大家分享一下,很多人上来就说想学习黑客,…

腾讯地图基本使用(撒点位,点位点击,弹框等...功能) 搭配Vue3

腾讯地图的基础注册账号 展示地图等基础功能在专栏的上一篇内容 大家有兴趣可以去看一看

今天说的是腾讯地图的在稍微一点的基础操作 话不多说 直接上代码

var marker ref(null)

var map

var center ref(null)

// 地图初始化

const initMap () > {//定义地图中心点坐标…

DocArray 近期更新:全面支持 Pydantic V2

DocArray 是一个专门为多模态数据的表示、传输、存储和检索而设计的 Python 库。其设计专为多模式人工智能应用程序的开发而量身定制,可保证与广泛的 Python 和机器学习生态系统的无缝集成。在 2022 年 1 月,DocArray 在 Apache License 2.0 下公开分发&…

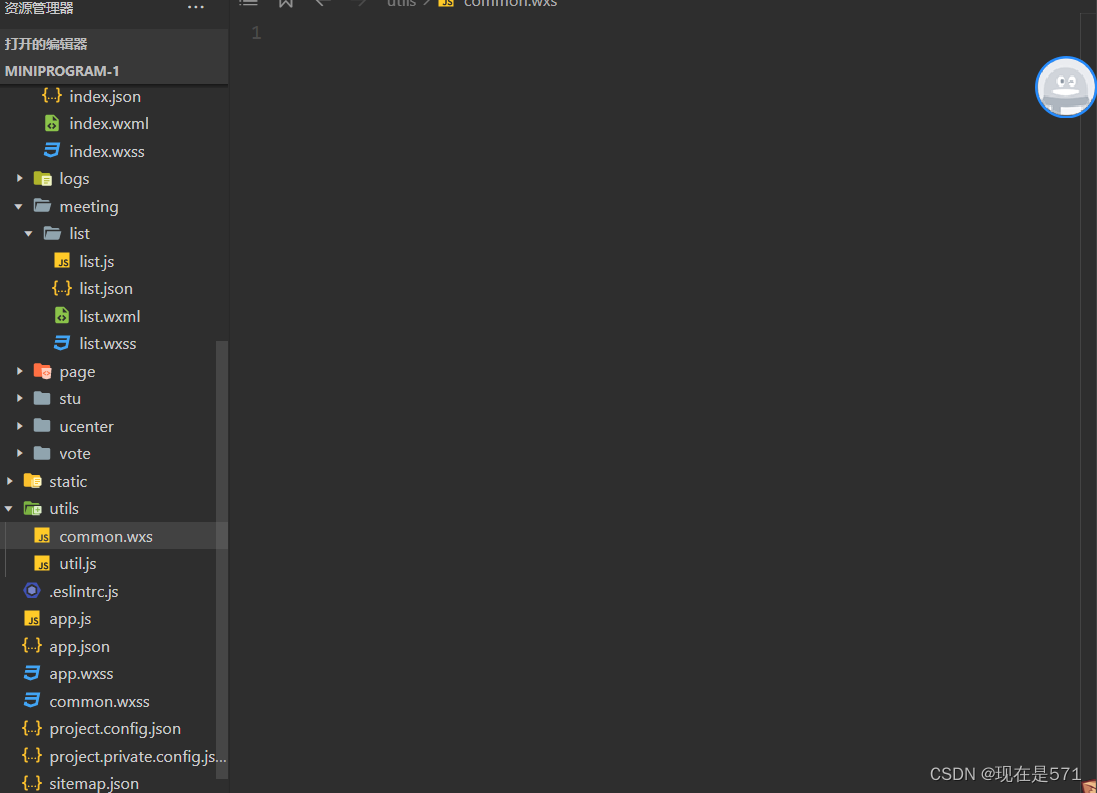

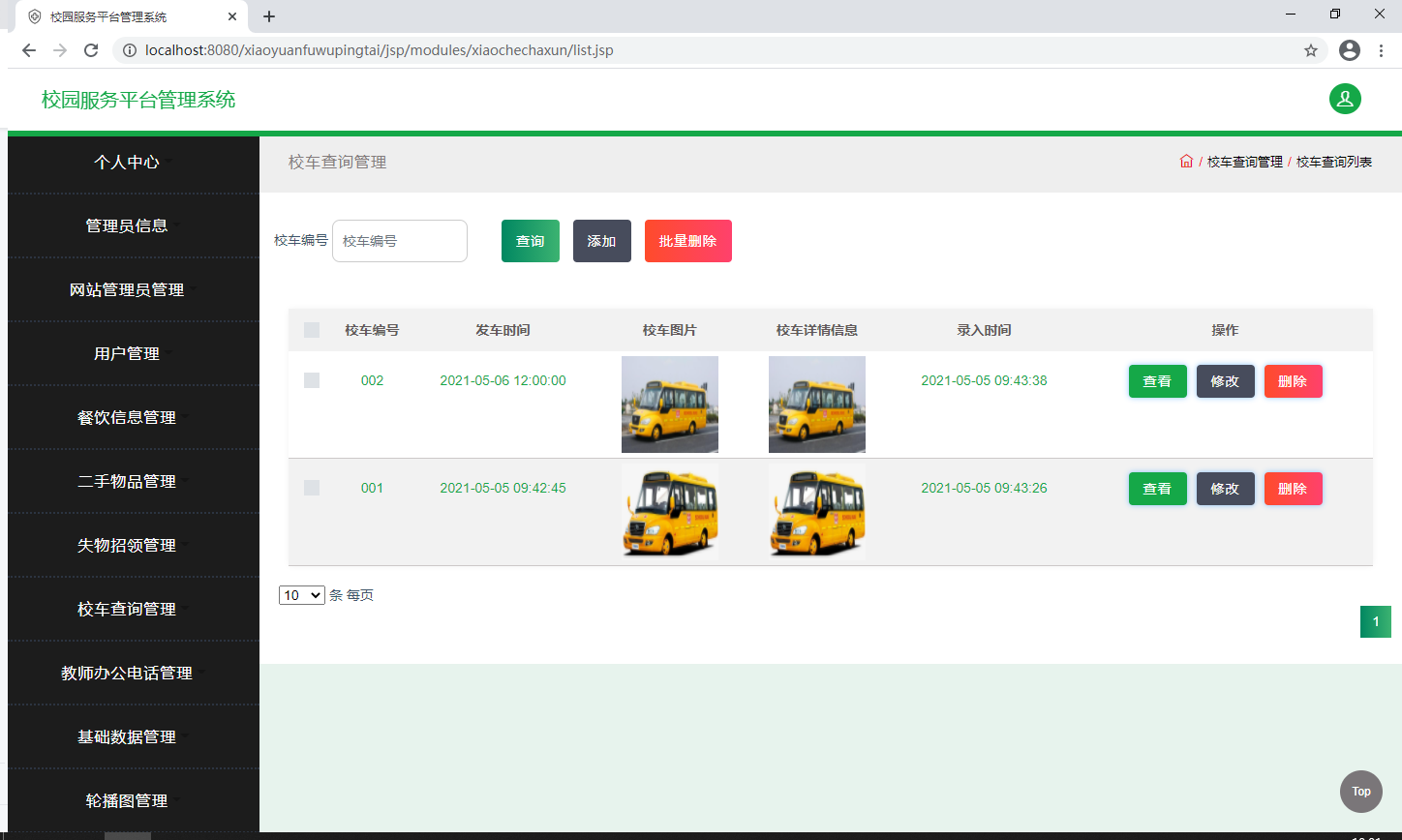

ssm351校园服务平台管理系统+jsp

项目名称:ssm351校园服务平台管理系统jsp 点击这里进入源码目录 声明:

适用范围: 本文档适用于广泛的学术和教育用途,包括但不限于个人学习、毕业设计和课程设计。免责声明: 特此声明,本文仅供参考学习之用…

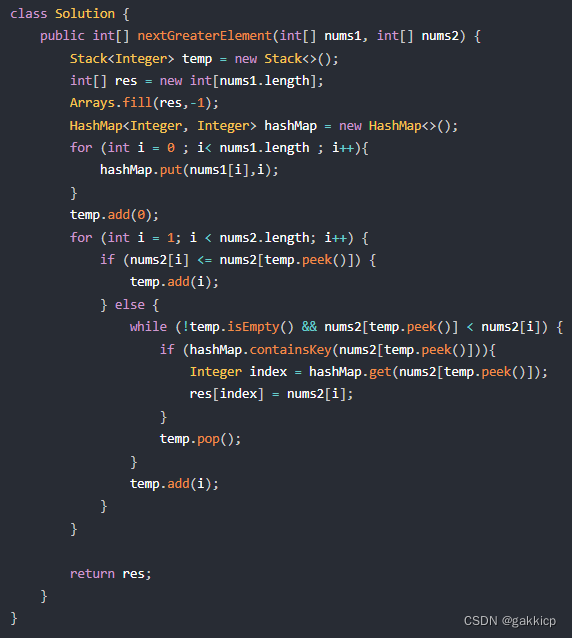

代码随想录算法训练营第六十天 | 739. 每日温度、496.下一个更大元素 I

739. 每日温度 链接: 代码随想录 (1)代码 496.下一个更大元素 I 链接: 代码随想录 (1)代码