AI大模型技术是指使用超大规模的深度学习模型来解决各种复杂的人工智能问题,如自然语言处理、计算机视觉、多模态交互等。AI大模型技术具有强大的学习能力和泛化能力,可以在多种任务上取得优异的性能,但也面临着计算、存储、通信等方面的挑战。

本文将从以下五个方面浅谈AI大模型技术的概念、发展和应用:

-

AI大模型技术的起源和发展历程

-

AI大模型技术的特点

-

AI大模型技术的构建和训练方法

-

AI大模型技术的基础资源和关键技术

-

AI大模型技术的应用领域和探索方向

01

—

AI大模型技术的起源和发展历程

AI大模型技术的起源可以追溯到深度学习的兴起。深度学习是一种基于多层神经网络的机器学习方法,可以从海量数据中自动学习特征和规律,实现对复杂数据的建模和理解。深度学习在2006年由Hinton等人提出,并在2012年由Krizhevsky等人在ImageNet图像识别竞赛中取得突破性的成果,引发了人工智能领域的热潮。

随着深度学习的发展,人们发现神经网络的规模和性能有着密切的关系。一般来说,神经网络的规模越大,即参数数量越多,表示能力越强,性能越好。因此,人们开始尝试构建更大规模的神经网络,并使用更多的数据来训练它们。这就催生了AI大模型技术。

AI大模型技术最早出现在自然语言处理领域。自然语言处理是指让计算机理解和生成自然语言(如中文、英文等)的技术,涉及到语音识别、机器翻译、文本分类、情感分析、对话系统等多种任务。自然语言处理面临着两个主要的挑战:一是自然语言本身具有复杂的结构和语义,难以用简单的规则或统计方法来描述;二是不同任务之间存在差异和联系,难以用单一的模型来适应。

为了解决这些挑战,人们提出了预训练语言模型(Pre-trained Language Model, PLM)的概念。预训练语言模型是指使用无标注或少标注的大规模文本语料来训练一个通用的语言表示模型,然后将该模型迁移到不同的下游任务上,并通过微调(Fine-tuning)或其他方法来适应具体任务。预训练语言模型可以有效地利用海量数据中蕴含的语言知识,并提高不同任务之间的迁移学习能力。

预训练语言模型最早由Collobert等人于2008年提出,并在2013年由Mikolov等人进一步发展。这些早期的预训练语言模型主要基于词向量(Word Embedding)的方法,即将每个词映射为一个固定长度的实数向量,以表示词的语义信息。然而,这些方法存在一些局限性,如无法处理一词多义、上下文相关等现象,以及无法捕获句子或文档级别的信息。

为了克服这些局限性,人们开始尝试使用更复杂的神经网络结构来构建预训练语言模型,如循环神经网络(Recurrent Neural Network, RNN)、长短期记忆网络(Long Short-Term Memory, LSTM)、门控循环单元(Gated Recurrent Unit, GRU)等。这些网络可以处理变长的序列输入,并具有记忆和注意力机制,可以更好地建模语言的时序和上下文信息。代表性的工作有ELMo、ULMFiT等。

然而,这些基于循环神经网络的预训练语言模型仍然存在一些问题,如无法并行计算、难以捕获长距离依赖、难以扩展到大规模数据和模型等。为了解决这些问题,人们开始使用基于自注意力机制(Self-Attention)的Transformer结构来构建预训练语言模型。Transformer是一种全新的神经网络结构,它摒弃了循环神经网络中的递归操作,而是使用自注意力机制来建模序列中任意两个位置之间的关系。Transformer具有以下优点:一是可以并行计算,提高训练效率;二是可以捕获长距离依赖,提高表示能力;三是可以扩展到大规模数据和模型,提高泛化能力。

基于Transformer结构的预训练语言模型开启了AI大模型技术的新篇章。2018年,OpenAI推出了GPT,这是第一个基于Transformer结构的预训练语言模型,它使用了1.1亿个参数,并在12种自然语言处理任务上取得了当时最好的结果。同年,Google推出了BERT,这是第一个使用双向Transformer结构的预训练语言模型,它使用了3.4亿个参数,并在11种自然语言处理任务上刷新了记录。此后,各大科研机构和公司纷纷推出了各自的预训练语言模型,如XLNet、RoBERTa、ALBERT、ELECTRA等,不断提升模型的规模和性能。

2020年,OpenAI推出了GPT-3,这是目前最大规模的预训练语言模型之一,它使用了1750亿个参数,并在多种自然语言处理任务上取得了惊人的效果。GPT-3引发了全球范围内对AI大模型技术的关注和讨论,也催生了许多基于GPT-3的应用和创新。例如,有人利用GPT-3生成了诗歌、歌词、代码、故事、对话等内容;有人利用GPT-3实现了问答、摘要、翻译、分类等功能;有人利用GPT-3探索了教育、医疗、金融、法律等领域的可能性。

2023年3月14日,ChatGPT的开发机构OpenAI正式发布其里程碑之作GPT-4。GPT-4是一个多模态大模型(接受图像和文本输入,生成文本)。相比上一代的GPT-3,GPT-4可以更准确地解决难题,具有更广泛的常识和解决问题的能力:更具创造性和协作性;能够处理超过25000个单词的文本,允许长文内容创建、扩展对话以及文档搜索和分析等用例。

除了自然语言处理领域外,AI大模型技术也开始在计算机视觉、多模态交互等领域发挥作用。计算机视觉是指让计算机理解和生成图像和视频的技术,涉及到人脸识别、目标检测、图像分割、风格迁移、视频理解等多种任务。多模态交互是指让计算机同时处理和融合不同类型的信息,如图像、文本、语音、音乐等,实现更自然和智能的人机交互。

在计算机视觉领域,AI大模型技术主要体现在两个方面:一是使用大规模的图像数据来训练一个通用的视觉表示模型,然后将该模型迁移到不同的下游任务上,并通过微调或其他方法来适应具体任务。二是使用大规模的图像和文本数据来训练一个跨模态的视觉-语言表示模型,然后将该模型用于生成或理解图像和文本之间的关系。这些AI大模型技术可以有效地提高计算机视觉的性能和泛化能力,同时也为多模态交互提供了基础。

在多模态交互领域,AI大模型技术主要体现在三个方面:一是使用大规模的多模态数据来训练一个统一的多模态表示模型,然后将该模型用于理解或生成不同类型的信息。二是使用大规模的语言数据来训练一个强大的语言生成模型,然后将该模型用于控制或指导不同类型的信息的生成 。三是使用大规模的强化学习数据来训练一个智能的多模态智能体,然后将该智能体用于与人类进行自然和智能的对话或协作 。这些AI大模型技术可以有效地提高多模态交互的效率和质量,同时也为通用人工智能提供了可能。

02

—

AI大模型技术的特点

AI大模型技术是一种利用海量数据和强大算力训练出具有高度泛化和通用能力的人工智能模型的技术。AI大模型技术有以下几个特点:

-

它使用了预训练和微调的方法,即先在大规模的通用数据上进行预训练,再根据不同的下游任务进行微调,提高了模型的泛用性和适应性。

-

它采用了自监督学习的方式,即利用无标注或少标注的数据进行训练,降低了数据标注的成本和难度。

-

它突破了传统的神经网络结构,使用了Transformer模型作为特征提取器,利用自注意力机制捕捉输入数据中不同部分之间的相关性,提高了模型的精度和效率。

-

它具有突现能力(Emergent Ability),即能够从数据中学习到一些隐含的知识和规则,实现类似人类的复杂推理和知识推导能力。

03

—

AI大模型技术的构建和训练方法

AI大模型技术的构建和训练需要解决计算、存储、通信等方面的挑战,以及提高模型的效率、质量和可扩展性。AI大模型技术的构建和训练方法主要包括以下几个方面:

-

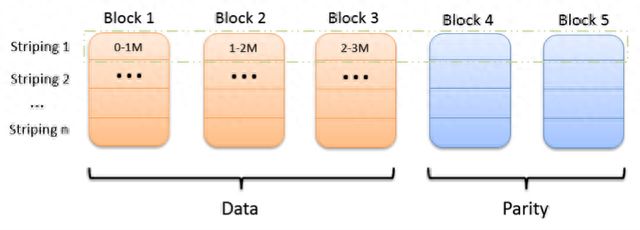

分布式训练:这是一种利用多个计算设备(如GPU、TPU等)来并行地训练一个大模型的方法,可以加速训练过程,同时也可以容纳更大规模的模型和数据。分布式训练有多种方式,如数据并行、模型并行、流水线并行等,它们各有优缺点,需要根据具体的场景和需求来选择合适的方式。

-

内存节省:这是一种减少训练过程中内存消耗的方法,可以提高训练效率,同时也可以降低训练成本。内存节省有多种技术,如激活重计算、混合精度训练、零冗余优化器等,它们各有原理和适用范围,需要根据具体的模型和硬件来选择合适的技术。

-

模型稀疏:这是一种减少模型参数数量和复杂度的方法,可以提高模型性能,同时也可以降低推理成本。模型稀疏有多种技术,如剪枝、量化、低秩分解等,它们各有目标和效果,需要根据具体的任务和指标来选择合适的技术。

04

—

AI大模型技术的基础资源和关键技术

AI大模型技术的应用和发展需要依赖于一些基础的数据、知识、计算系统、推理能力等资源,同时也需要解决一些可解释性、安全性、治理、评测等方面的问题。

AI大模型技术的基础资源和关键技术主要包括以下几个方面:

-

数据:这是AI大模型技术的核心资源,也是训练和应用大模型的前提条件。数据的质量、规模、多样性、可用性等都会影响大模型的效果和价值。因此,需要构建高质量、高覆盖、高效率的数据生态,包括数据采集、清洗、标注、存储、共享等环节,以及数据隐私保护、数据安全管理等措施。

-

知识:这是AI大模型技术的重要资源,也是提升大模型能力和泛化性的关键因素。知识可以帮助大模型理解数据背后的逻辑和规律,以及不同领域和场景的特点和需求。因此,需要构建丰富、准确、动态的知识体系,包括知识图谱、知识库、本体库等形式,以及知识获取、表示、融合、推理等技术。

-

计算系统:这是AI大模型技术的基础设施,也是支撑大模型训练和应用的硬件平台。计算系统需要具备高性能、高可靠、高可扩展等特点,以满足大模型对计算资源和效率的需求。因此,需要构建先进、灵活、智能的计算系统,包括芯片、服务器、集群等设备,以及操作系统、编程框架、调度系统等软件。

-

推理能力:这是AI大模型技术的核心能力,也是实现大模型应用和创新的主要手段。推理能力可以帮助大模型根据输入数据和任务目标生成合理和有效的输出结果,以及解释和评估输出结果的过程和依据。因此,需要构建强大、灵活、智能的推理能力,包括生成式推理、逻辑推理、常识推理等类型,以及推理优化、推理加速、推理验证等技术。

-

可解释性:这是AI大模型技术的重要特性,也是提高大模型可信度和可接受度的必要条件。可解释性可以帮助大模型向用户或开发者展示其内部结构和工作原理,以及输出结果的依据和意义。因此,需要构建有效、直观、友好的可解释性方法,包括可视化分析、注意力机制分析、对比实验分析等方式,以及可解释性评估、可解释性改进等策略。

-

安全性:这是AI大模型技术的关键特性,也是保障大模型正常运行和避免风险的必要条件。安全性可以帮助大模型防止或抵御各种可能造成损害或威胁的因素,如数据泄露、模型攻击、模型偏差等。因此,需要构建严格、全面、动态的安全性机制,包括数据加密、模型加密、模型防御、模型校准等措施,以及安全性监测、安全性修复等技术。

-

治理:这是AI大模型技术的重要环节,也是规范大模型行为和责任的必要手段。治理可以帮助大模型遵守一些法律、伦理、社会等方面的规则和原则,以及明确大模型的权利和义务。因此,需要构建合理、公正、透明的治理框架,包括治理目标、治理主体、治理流程、治理机制等要素,以及治理评估、治理改进等方法。

-

评测:这是AI大模型技术的重要环节,也是衡量大模型效果和价值的必要手段。评测可以帮助大模型检验其在不同任务和场景下的表现和水平,以及与其他模型或方法的优劣和差异。因此,需要构建科学、客观、多维的评测体系,包括评测数据集、评测指标、评测方法、评测平台等组成,以及评测分析、评测反馈等功能。

05

—

AI大模型技术的应用领域和探索方向

AI大模型技术已经在多个领域展现出了强大的潜力和价值,同时也面临着一些新的机遇和挑战。

AI大模型技术的应用领域和探索方向主要包括以下几个方面:

-

知识搜索:这是一种利用AI大模型技术来提供更智能、更全面、更准确的信息检索和问答服务的应用领域,可以帮助用户快速地获取所需的知识和答案。知识搜索有多种形式,如语义搜索、对话搜索、图像搜索、视频搜索等,它们可以根据用户的输入和意图,从海量的数据源中检索出最相关的信息,并以友好的方式呈现给用户。知识搜索的典型应用有百度智能云的文心一言、阿里达摩院的PLUG、微软必应的ChatGPT等。

-

城市运维:这是一种利用AI大模型技术来提升城市管理和服务水平的应用领域,可以帮助城市实现智慧化、数字化、可持续化的发展。城市运维涉及到多个方面,如交通管理、环境监测、公共安全、社会治理等,它们需要处理和分析大量的多模态数据,如图像、视频、语音、文本等,并根据不同的场景和需求,提供合适的决策和响应。城市运维的典型应用有商汤科技的书生(INTERN)、华为云的盘古NLP、浪潮信息的源1.0等。

-

广告营销:这是一种利用AI大模型技术来优化广告投放和提升营销效果的应用领域,可以帮助广告主和营销人员更好地理解用户需求和行为,以及创造更有吸引力和影响力的广告内容。广告营销需要利用大量的用户数据和行业数据,如用户画像、用户行为、市场趋势等,并根据不同的目标和策略,生成或推荐最合适的广告素材、广告渠道、广告时机等。广告营销的典型应用有创新奇智的Diffusion、第四范式的4Paradigm、腾讯AI Lab的Tencent AI Lab等。

-

智能客服:AI大模型可以实现自然语言理解、对话管理、情感分析、文本生成等功能,提高客户满意度和服务效率。

-

智能家居:AI大模型可以实现语音识别、语音合成、语义理解、多轮对话等功能,实现与用户的自然交互和智能控制。

-

自动驾驶:AI大模型可以实现图像识别、目标检测、场景分割、路径规划等功能,提高驾驶安全性和舒适性。

AI大模型技术是人工智能领域的一种重要的技术趋势,它利用海量数据和强大计算资源来构建超大规模的深度学习模型,从而实现对复杂数据和问题的建模和解决。AI大模型技术已经在自然语言处理、计算机视觉、多模态交互等领域取得了显著的进展和成果,同时也引发了一系列新的挑战和问题,如数据质量、计算效率、知识可解释性、安全可靠性等。因此,AI大模型技术需要不断地创新和完善,以适应不断变化和增长的人工智能需求。