3D 生成重建008-zero123让扩散模型了解空间信息zero-shot 单图生3d

文章目录

- 0

- 0 论文工作

- 1 论文方法

- 1.1 条件生成微调

- 1.2 维护3d表示

- 2 效果

0

0 论文工作

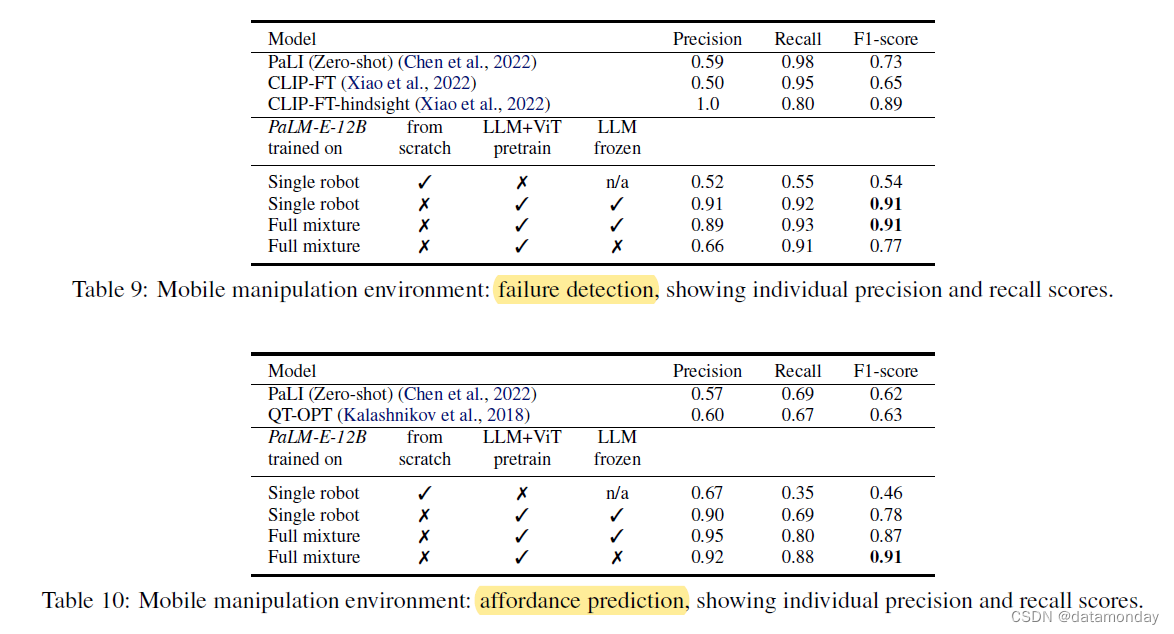

之前分享的工作主要尝试是从一个pre-trained 文生图的diffusion模型中去蒸馏知识,从而去维护一个3d的表示形式。这种方法固然能够进行一个文生3d的任务,但是一个比较重要的问题就是细节确实,细节问题一方面和分辨率有关系,另外一个方面可能和通过蒸馏去强势维护一个3d表示有关,当视图之间一致性存在差异的时候,势必会造成通过均值的形式进行表达,maybe这也是细节模糊的一个因素。

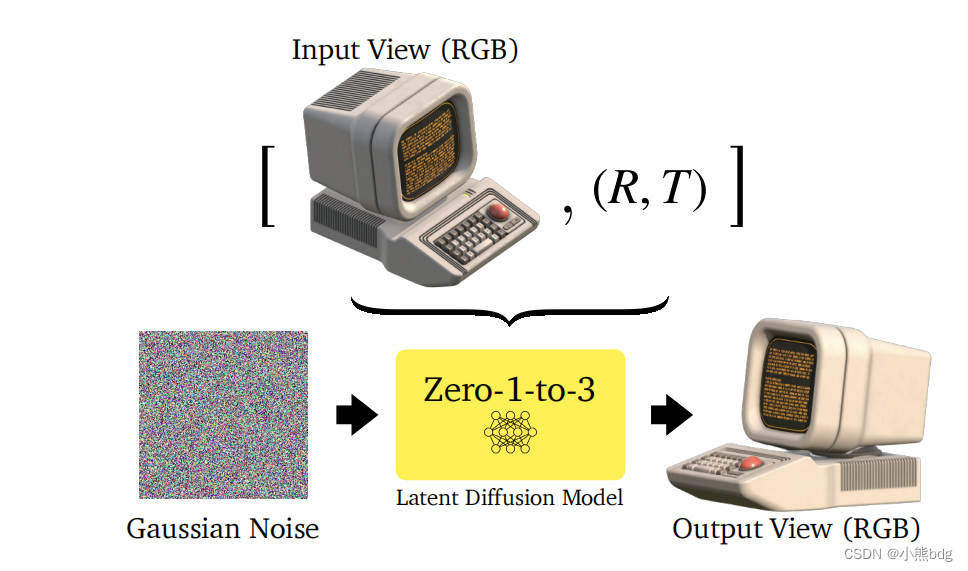

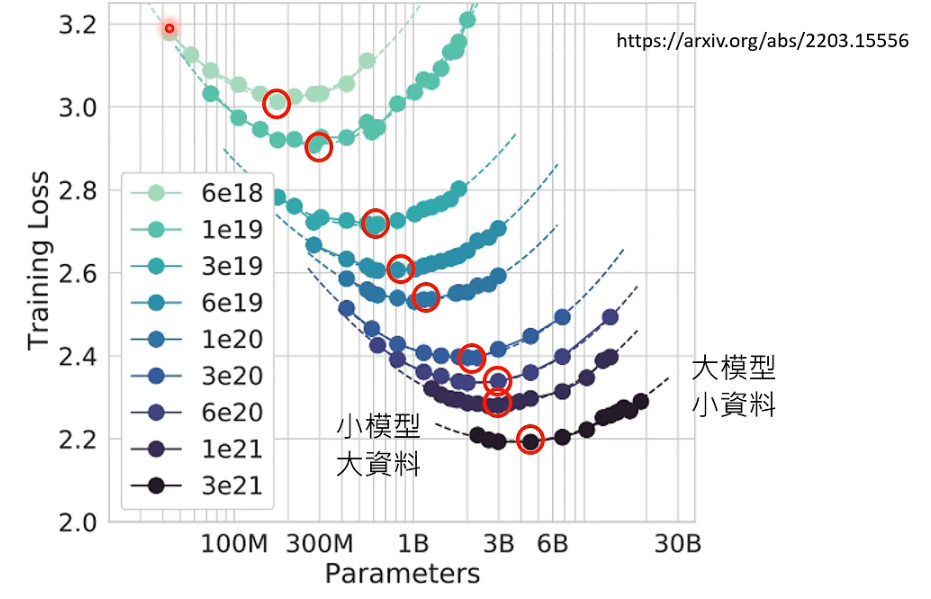

zero-1-to-3,是一个单图生成3d的任务。核心的思想就是在一个大型的3d数据集objaverse上对一个扩散模型进行微调,从而将3d数据集中视角相关的信息注入到2d的扩散模型,让扩散模型能够生成不同视角的图像。相比2d数据集,这个3d数据集中的数据量已经很小了,但是这依然是一个很消耗资源的任务。

参考

zero123

1 论文方法

1.1 条件生成微调

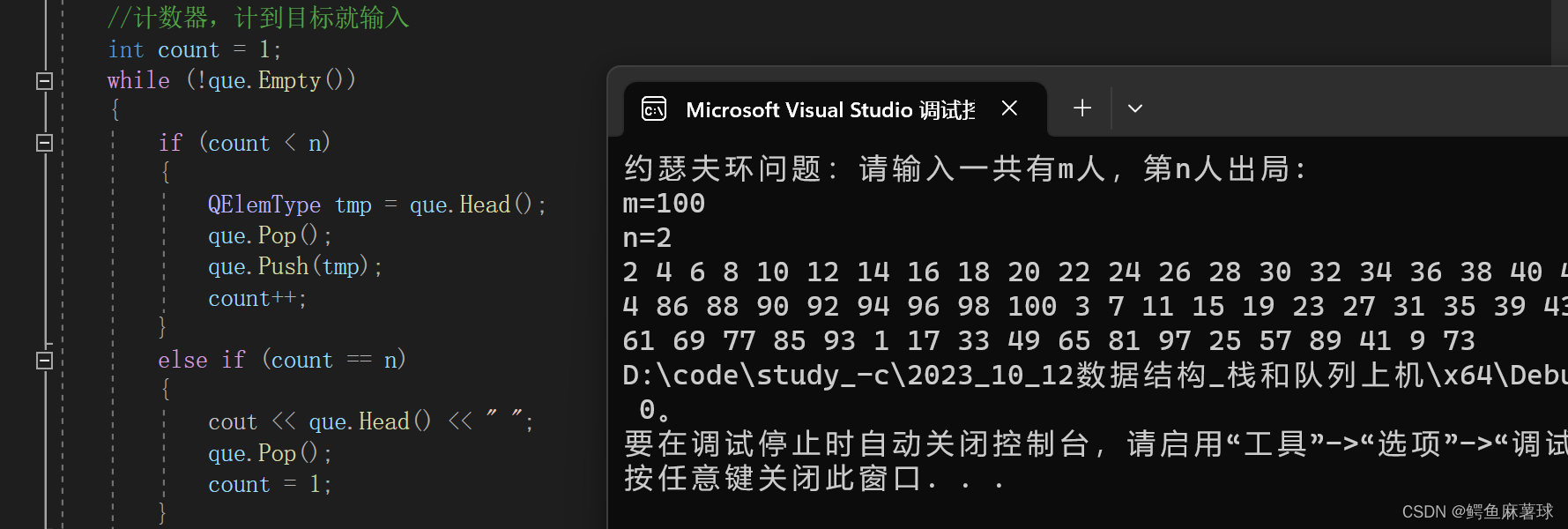

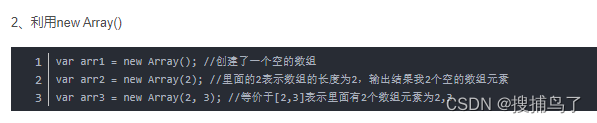

如上图所示 ,论文的核心贡献是尝试优化了一个latent diffusion模型,将原图和视角信息作为输入进行训练。简单的理解可以拿congtrolnet做对比,controlnet允许轮廓,深度,法线等条件作为输入,不同的是zero123是用原图和相机信息联合起来作为输入。

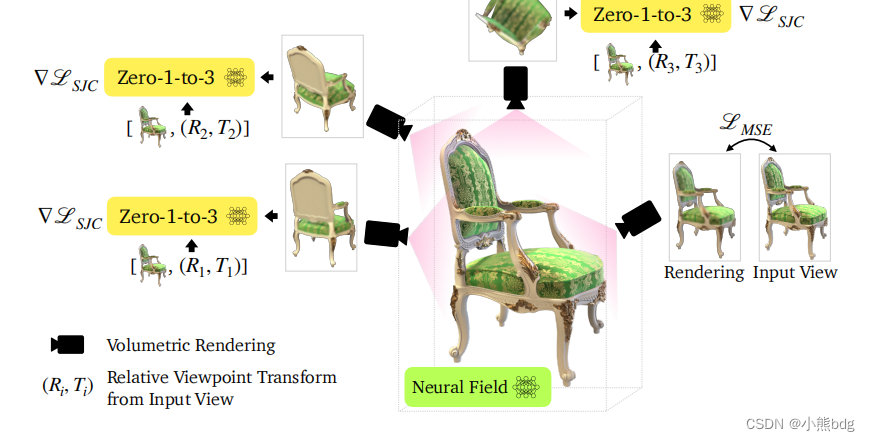

1.2 维护3d表示

在这个地方他采用的SJC的那一套策略去优化nerfdreamfusion and SJC中提到扰动平均得分策略。

2 效果

![[cpp primer随笔] 11. 内联函数与constexpr函数](https://img-blog.csdnimg.cn/img_convert/c8395f15cdd43169426332c33b764ec6.png)

![[开源]基于Vue+ElementUI+G2Plot+Echarts的仪表盘设计器](https://img-blog.csdnimg.cn/img_convert/ba16656a7f59c266e90251a1f7b8d20f.png)