本项目I2VGen-XL旨在解决根据输入图像生成高清视频任务。I2VGen-XL由达摩院研发的高清视频生成基础模型之一,其核心部分包含两个阶段,分别解决语义一致性和清晰度的问题,参数量共计约37亿,模型经过在大规模视频和图像数据混合预训练,并在少量精品数据上微调得到,该数据分布广泛、类别多样化,模型对不同的数据均有良好的泛化性。项目相比于现有视频生成模型,I2VGen-XL在清晰度、质感、语义、时序连续性等方面均具有明显的优势。

此外,I2VGen-XL的许多设计理念和设计细节(比如核心的UNet部分)都继承于我们已经公开的工作VideoComposer,您可以参考我们的VideoComposer和本项目ModelScope的了解详细细节。

https://modelscope.cn/models/damo/Image-to-Video/summary

模型介绍 (Introduction):

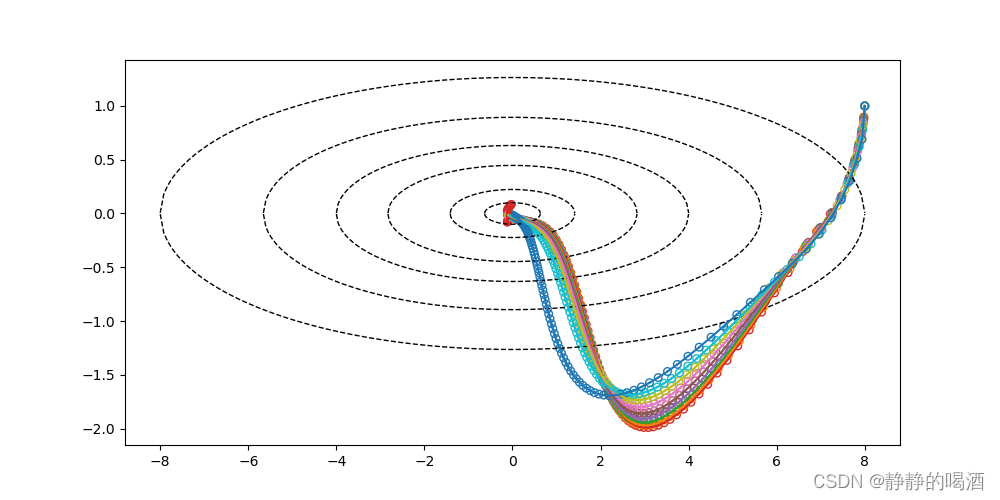

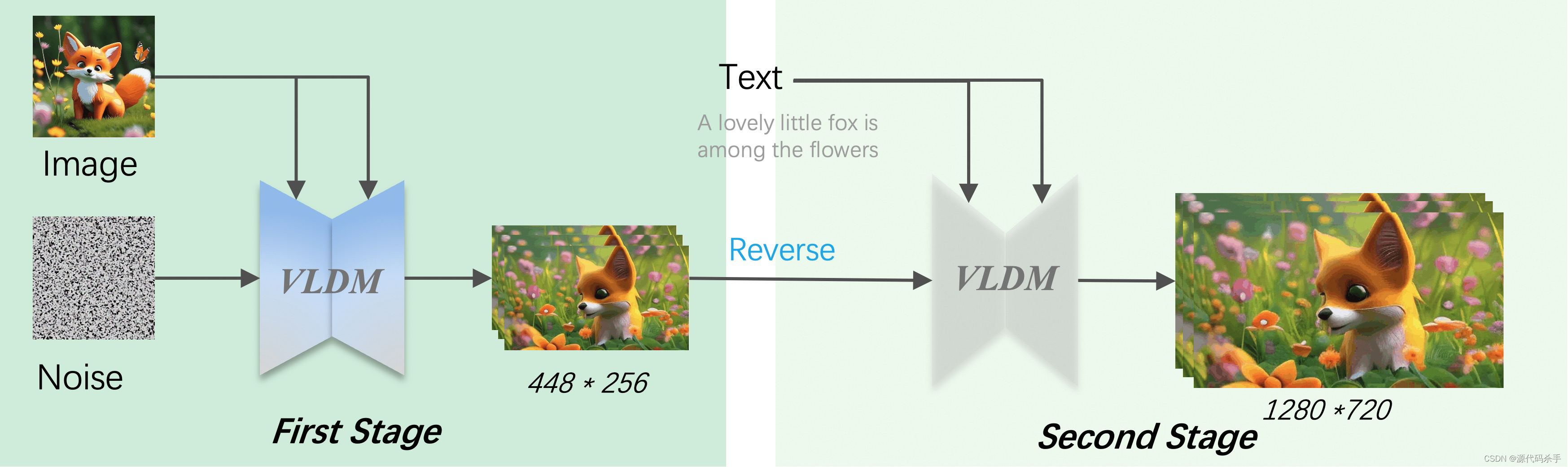

如图Fig.2所示,I2VGen-XL是一种基于隐空间的视频扩散模型(VLDM),其通过我们专门设计的时空UNet(ST-UNet)在隐空间中进行时空建模,然后通过解码器重建出最终视频(具体模型结构可以参考VideoComposer)。为能够生成720P视频,我们将I2VGen-XL分为两个阶段,第一阶段是在低分辨率条件下保证语义一致性,第二阶是利用新的VLDM进行去噪以提高视频分辨率以及同时提升时间和空间上的一致性。通过在模型、数据和训练上的联合优化,I2VGen-XL主要具有以下几个特点:

高清&宽屏,可以直接生成720P(1280*720)分辨率的视频,且相比于现有的开源项目,不仅分辨率得到有效提高,其生产的宽屏视频可以适合更多的场景

连续性,通过特定训练和推理策略,在视频的细节生成的稳定性上(时间和空间维度)有明显提高

质感好,通过收集特定的风格的视频数据训练,使得生成的视频在质感上得到明显提升,可以生成科技感、电影色、卡通风格和素描等类型视频

无水印,模型通过我们内部大规模无水印视频/图像训练,并在高质量数据微调得到,生成的无水印视频可适用更多视频平台,减少许多限制。

![skywalking动态配置[集成nacos/apollo/consul]](https://img-blog.csdnimg.cn/fa78c3d555b44bd9b4e28f07c562cc9a.png)