一、客户端Kibana安装

Kibana是一个开源分析和可视化平台,旨在与Elasticsearch协同工作。参考文档

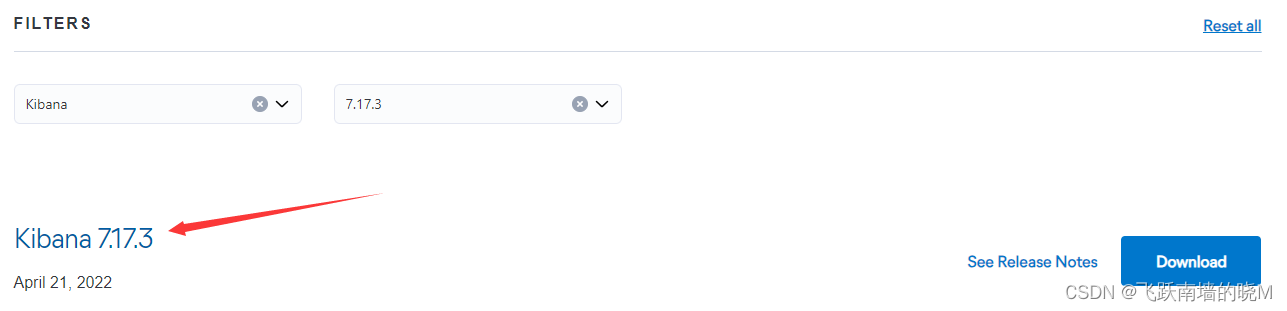

1. 下载并解压缩Kibana

下载路径 选择的版本是和 ElasticSearch 对应(7.17.3)

下载后上传到Linux 系统中,并放在 /root/ 下,进行解压:

tar -zxvf kibana-7.17.3-linux-x86_64.tar.gz

2. 修改Kibana.yml

cd /root/kibana-7.17.3-linux-x86_64

vim config/kibana.yml

#指定Kibana服务器监听的端口号

server.port: 5601

#指定Kibana服务器绑定的主机地址

server.host: "localhost"

#指定Kibana连接到的Elasticsearch实例的访问地址

elasticsearch.hosts: ["http://localhost:9200"]

#将 Kibana 的界面语言设置为简体中文

i18n.locale: "zh-CN"

3. 运行Kibana

Kibana 不允许使用root账号启动服务,如果你当前账号是root,则需要创建一个专有账户

创建 es 用户来启动es:

adduser es

passwd es

chown es:es -R /root/kibana-7.17.3-linux-x86_64

# 切换用户

su es

#输入对应的密码

#启动 kibana

nohup bin/kibana &

#查询kibana进程

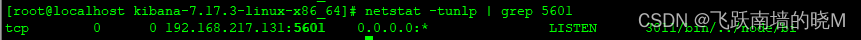

netstat -tunlp | grep 5601

显示如下,表示 Kibana 启动成功:

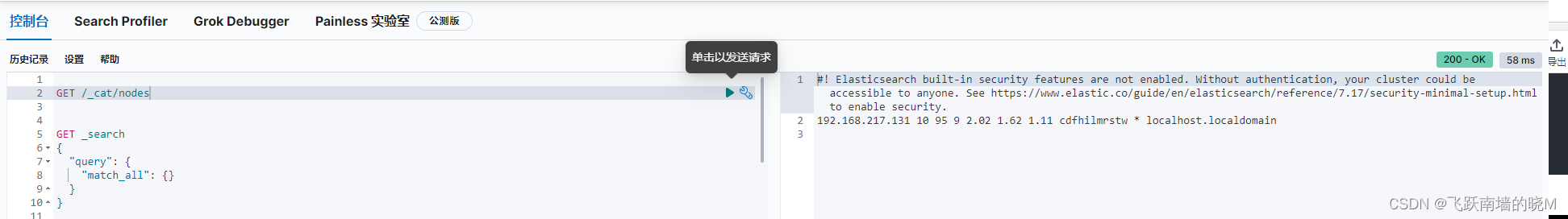

访问:http://ip:5601/app/dev_tools#/console 成功如下:

也可以查看对应的日志:

tail -fn 500 nohup.out

二、Elasticsearch安装分词插件

1. 在线安装analysis-icu分词插件

cd /root/elasticsearch-7.17.3

#查看已安装插件

bin/elasticsearch-plugin list

#安装插件

bin/elasticsearch-plugin install analysis-icu

#删除插件

bin/elasticsearch-plugin remove analysis-icu

注意:安装和删除完插件后,需要重启ES服务才能生效。

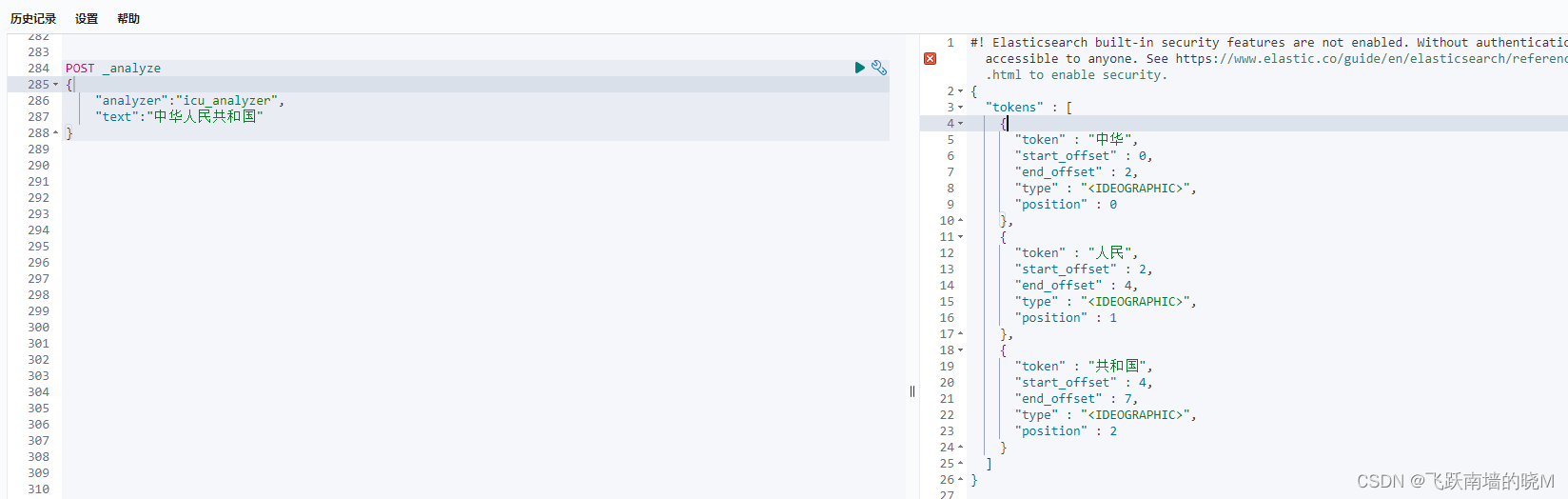

测试分词效果:

# _analyzer API可以用来查看指定分词器的分词结果

POST _analyze

{

"analyzer":"icu_analyzer",

"text":"中华人民共和国"

}

2. 离线安装ik中文分词插件

本地下载 elasticsearch-analysis-ik-7.17.3.zip 插件,解压,然后手动上传到elasticsearch的plugins目录,然后重启ES就可以了。

ik中文分词插件:https://github.com/medcl/elasticsearch-analysis-ik

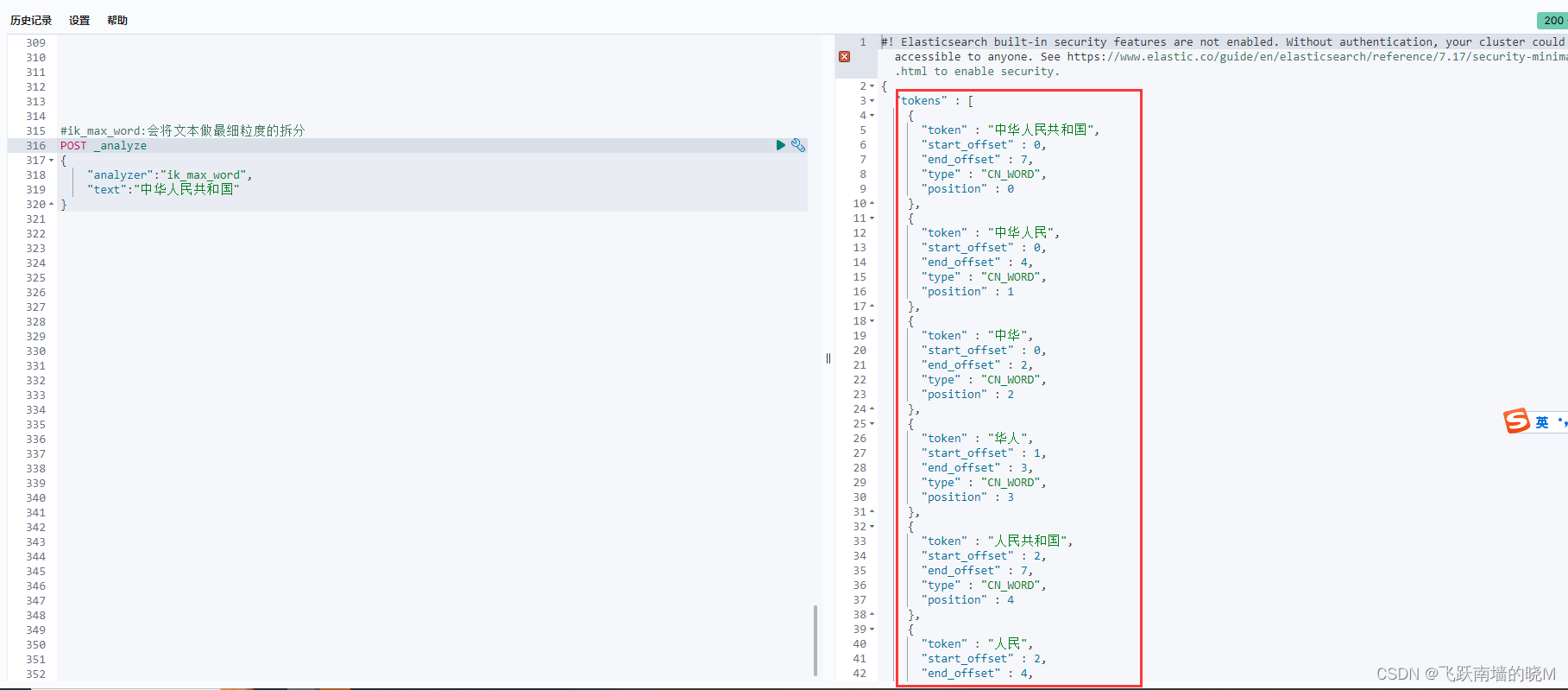

测试分词效果:

#ik_max_word:会将文本做最细粒度的拆分

POST _analyze

{

"analyzer":"ik_max_word",

"text":"中华人民共和国"

}

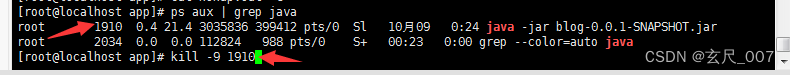

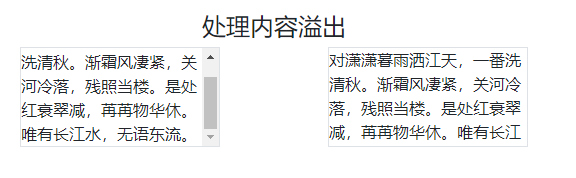

分词效果如下:

![2023年中国烹饪机器人市场发展概况分析:整体规模较小,市场仍处于培育期[图]](https://img-blog.csdnimg.cn/img_convert/a53112d922a5cda06a4ce0edd20cae4b.png)