ABSTRACT

在这项工作中,我们使用一种新颖的风格特征表示学习方法来解决任意图像风格转移的挑战性问题。合适的风格表示作为图像风格化任务的关键组成部分,对于获得满意的结果至关重要。

现有的基于深度神经网络的方法在内容特征的Gram矩阵等二阶统计量的指导下取得了合理的结果。然而,它们没有利用足够的风格信息,这会导致诸如局部失真和风格不一致之类的伪影。为解决这个问题,我们通过分析多种风格之间的异同,并考虑风格分布,提出直接从图像特征中学习风格表征,而不是从图像特征的二阶统计中学习。具体而言,我们提出了对比任意风格迁移(CAST),这是一种通过对比学习的新的风格表征学习和风格迁移方法。我们的框架由三个关键组件组成,即用于风格代码编码的多层风格投影仪、用于有效学习风格分布的领域增强模块和用于图像风格转移的生成网络。我们进行了全面的定性和定量评估,以证明与通过最先进的方法获得的结果相比,我们的方法取得了明显更好的结果。

Code and models are available at https://github.com/zyxElsa/CAST_pytorch.

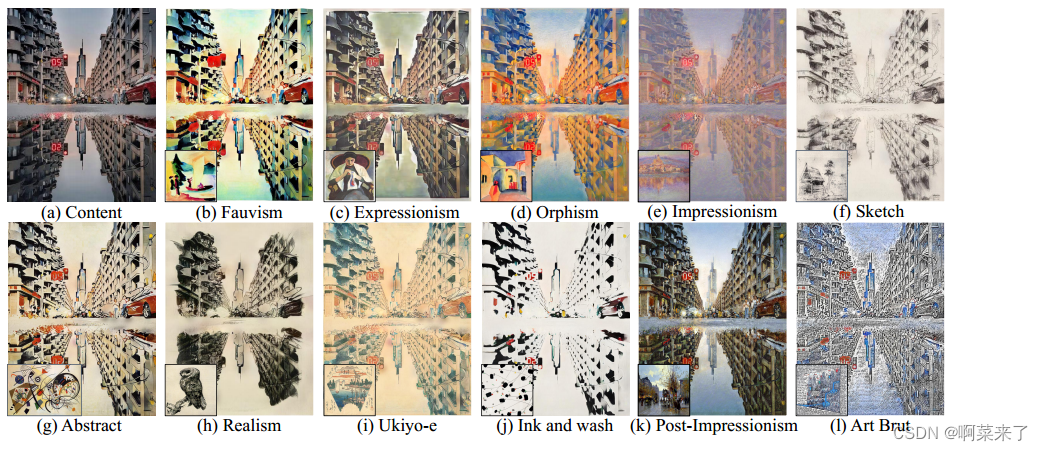

图1:使用我们的方法的风格迁移结果,可以稳健有效地处理各种绘画风格。输入内容图像位于左上角,样式引用作为每个结果的插页显示。我们的方法可以忠实地捕捉每幅画的风格,并产生具有独特艺术视觉外观的结果。风格图像艺术家:(b)奥古斯特·马克,©奥古斯特·马克,(d)奥古斯特·马克,(e)克劳德·莫奈,(f)文森特·梵高,(g)瓦西里·康定斯基,(h)文森特·梵高,(i)广重,(j)吴冠中,(k)爱德华·科尔特斯,(l)霍华德·芬斯特。

1 INTRODUCTION

如果一张图片胜过千言万语,那么一件艺术品就告诉了整个故事。艺术风格描述了艺术品的外观,是艺术家描绘其主题的方式以及艺术家表达其视觉的方式。风格是由描述艺术品的特征决定的,比如艺术家采用形式、颜色和构图的方式。艺术风格转移作为一种将自然图像的内容与现有绘画图像的风格相结合来创造新绘画的有效方式,是计算机图形学和计算机视觉领域的一个主要研究课题[Jing et al2020b;廖等人2017],其中风格表征是最重要的问题。

由于Gatys等人[2016]提出使用Gram矩阵作为艺术风格表示,因此通过高级神经风格传递网络生成高质量的视觉结果。尽管在任意图像风格转移领域取得了显著进展,但二阶特征统计(Gram矩阵或均值/方差)风格表示限制了其进一步的发展和应用。如图1所示,不同艺术风格的外观不仅在颜色和局部纹理方面存在很大差异,而且在布局和构图方面也存在很大差异。图2d和2e显示了最近提出的两种最先进的风格转换方法的结果。我们认为,使用二阶统计来对齐图像之间的神经激活分布会导致难以捕捉颜色分布或特殊布局,或模仿不同风格的特定细节画笔效果。

在本文中,我们重新审视了神经风格转移的核心问题,即正确的艺术风格表达。广泛使用的二阶统计量作为全局风格描述符可以在一定程度上区分风格,但它们并不是表示风格的最佳方式。通过二阶统计,任意风格化通过人工设计的图像特征和损失函数以启发式的方式形成风格。换句话说,网络学习拟合风格图像和生成图像的二阶统计量,而不是风格本身。直接从艺术图像中探索风格的关系和分布,而不是使用预定义的风格表示是值得的。

为此,我们建议通过基于对比学习的优化,用一种新的风格表示来改进任意风格的转移。我们的关键见解是,如果只给出一个艺术形象,一个没有艺术知识的人很难定义风格,但识别不同风格之间的差异相对容易。具体而言,我们提出了一种新颖的对比任意风格转移(CAST)框架,用于图像风格表示和风格转移。CAST由基于编码器-变换-解码器结构、多层式投影仪(MSP)模块和域增强(DE)模块。

我们的贡献可以总结如下:

•我们提出了一个用于风格编码的MSP模块,以及一个新的基于编码器-变换-解码器的任意风格转移的CAST模型,而不使用二阶统计量作为风格表示。

•我们通过考虑正反两个例子之间的关系以及风格的全局分布,引入了对比学习和领域增强,解决了现有风格转移模型无法充分利用大量风格信息的问题。

•实验表明,我们的方法在视觉质量方面实现了最先进的风格转换结果。受图灵测试的启发,进行了一项具有挑战性的主观调查,以表明CAST的输出可能会误导参与者,使其无法区分假绘画图像和真实绘画图像。

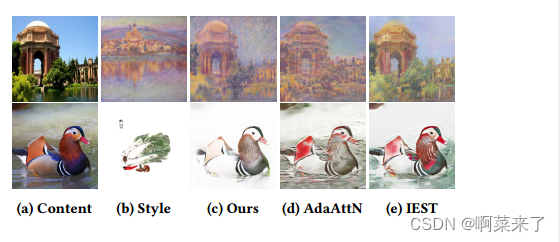

图2:与依赖二阶统计量的AdaAttnN [Liu et al . 2021b]和est [Chen et al . 2021a]相比,我们的方法可以忠实地传递风格,同时保证与内容图像的结构一致性。风格形象艺术家:莫奈、石觉力。

2 RELATED WORK

图像样式传输。传统的风格转换方法,如基于笔划的渲染[Fišer等人2016]和图像过滤[Wang等人2004],通常使用低级别的手工制作功能。Gatys等人[2016]和后续变体[Gatys等人2017;Kolkin等人2019]证明,从预先训练的深度卷积神经网络中提取的特征的统计分布可以有效地捕捉风格模式。尽管结果很显著,但这些方法将任务表述为一个复杂的优化问题,这导致了高昂的计算成本。最近的一些方法依赖于可学习的神经网络来匹配特征空间中的统计信息以提高效率。每种风格的排列模型方法[Gao等人2020;Johnson等人2016;Puy和Pérez 2019]为每种风格训练一个特定的网络。每个模型的多重风格方法[Chen等人2017;Dumoulin等人2017;Ulyanov等人2016;张和Dana 2018]使用一个模型代表多种风格。

任意风格的转移方法[Deng等2022020;李等 2017年;Svoboda等人2020;Wu等人2021a]使用统一模型构建更灵活的前馈架构来处理任意风格。AdaIN[Huang和Belongie 2017]和DIN[Jing等人2020a]直接将内容特征的总体统计与风格特征的统计对齐,并采用条件实例规范化。然而,实例归一化层中仿射参数的动态生成可能导致失真伪影。

相反,有几种方法遵循编码器-解码器的方式,其中特征变换和/或融合被引入到基于自动编码器的框架中。例如,李等人[199]学习跨域特征线性变换矩阵(LST),以实现通用风格转移,并通过从变换后的特征中解码来生成所需的风格化结果。Park等人【2019】引入SANet,将语义上最接近的风格特征灵活地匹配到内容特征上。邓等人[2021]提出MCCNet通过多通道相关性融合样本风格特征和输入内容特征,实现高效的风格传递。An等人[2021]提出了可逆神经流和无偏特征转移模块(ArtFlow),以防止通用风格转移过程中的内容泄漏。刘等人[2021b]提出了一种自适应注意力归一化模块(AdaAttN),用于计算注意力得分,同时考虑浅特征和深特征。基于GAN的方法[Kotovenko et al 2019a,b;Sanakoyeu et al 2018a;Svoboda et al 2020;Zhu et al 2017]已成功用于集合风格转移,该方法将集合中的风格图像视为一个域[Chen et al 2021b;Lin et al 2021年;徐等2021]。

对比学习。对比学习已被用于许多应用,如图像去模糊[Wu等人2021b]、上下文预测[Santa Cruz等人2019]、几何预测[Liu等人2019]和图像翻译。在图像翻译中引入对比学习,以保留输入的内容[Han等人2021]并减少模式崩溃[Jeong和Shin 2021;Kang和Park 2020;刘等人2021a]。CUT[Park等人2020]提出了通过将输入和输出图像裁剪成块并最大化块之间的互信息来进行逐块对比学习。继CUT之后,TUNIT[Baek等人2021]对具有相似语义结构的图像进行对比学习。然而,语义相似性假设不适用于任意风格转移任务,这导致学习的风格表示的性能显著下降。IEST[Chen等人2021a]将对比学习应用于基于特征统计(均值和标准差)作为风格先验的图像风格转移。对比损失仅在生成的结果中计算。IEST中的对比学习是将具有相同风格的风格化图像关联起来的一种辅助方法,其能力来自于预训练的VGG的特征统计。不同的是,我们通过提出一个新的框架来引入风格表示的对比学习,该框架综合利用视觉特征来表示任意图像风格转移任务的风格。

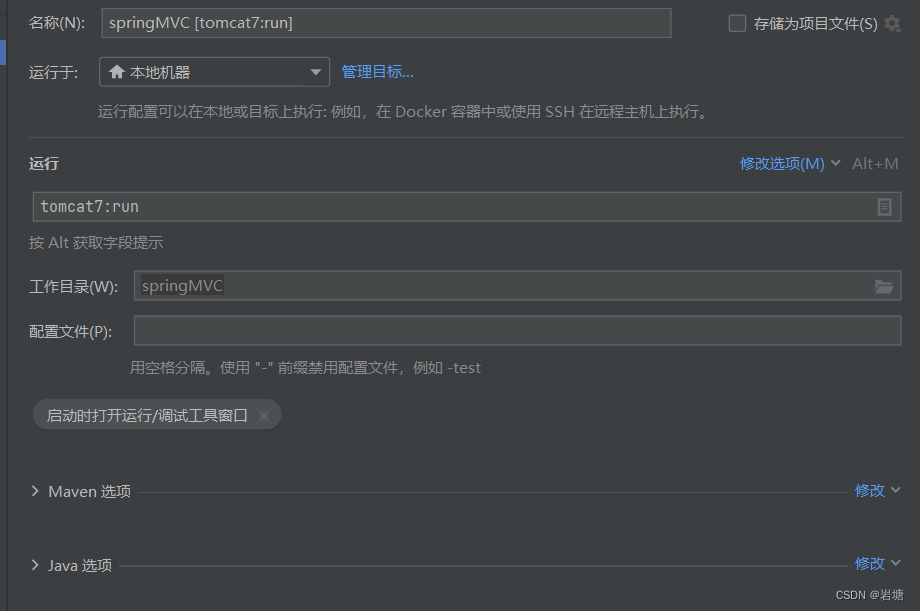

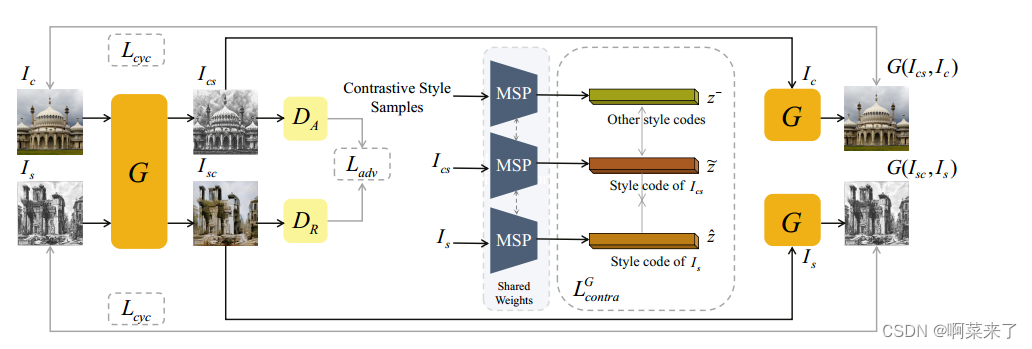

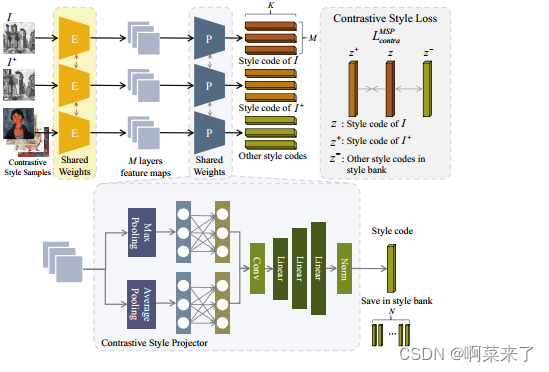

图3:CAST由一个基于编码器-变换-解码器的生成器𝐺、一个多层风格的投影仪(MSP)模块和一个域增强模块组成。我们首先使用生成器从内容图像𝐼𝑐和样式图像𝐼𝑠生成图像𝐼𝑐𝑠和𝐼𝑠𝑐。然后,将𝐼𝑐𝑠和𝐼𝑠输入到MSP模块中,生成相应的风格代码z ~和z ~,作为风格对比学习过程中的正样本。样式库中其他艺术图像的样式代码z -将用作负样本。我们基于这些风格代码计算对比风格损失L𝐺𝑐𝑜𝑛𝑡𝑟𝑎。DE模块是基于对抗损失L𝑎𝑑𝑣和周期一致性损失L𝑐yc风格形象艺术家:乔瓦尼巴蒂斯塔皮拉内西。

3 METHOD

如图3所示,我们的框架由三个关键组件组成:(1)多层风格投影仪,它被训练为将艺术图像的特征投影到风格代码中;(2) 对比风格学习模块,用于指导多层风格投影仪的训练和风格图像的生成;以及(3)领域增强方案,以进一步帮助学习艺术图像领域的分布。所有这些组件都用于学习风格表示,以测量输入的艺术图像和生成的结果之间的差异,因此,它们可以应用于不同类型的任意风格传递网络。

3.1 Multi-layer Style Projector

我们的目标是开发一个任意风格转换框架,可以捕捉和转移局部笔触特征和艺术图像的整体外观到自然图像。一个关键的组成部分是找到一个合适的风格表示,可以用来区分不同的风格,进一步指导风格图像的生成。为此,我们设计了一个MSP模块,该模块包括一个风格特征提取器和一个多层投影仪。我们的MSP不是使用来自特定层或多层融合的特征,而是将不同层的特征投射到单独的潜在风格空间中,以编码局部和全局风格线索。

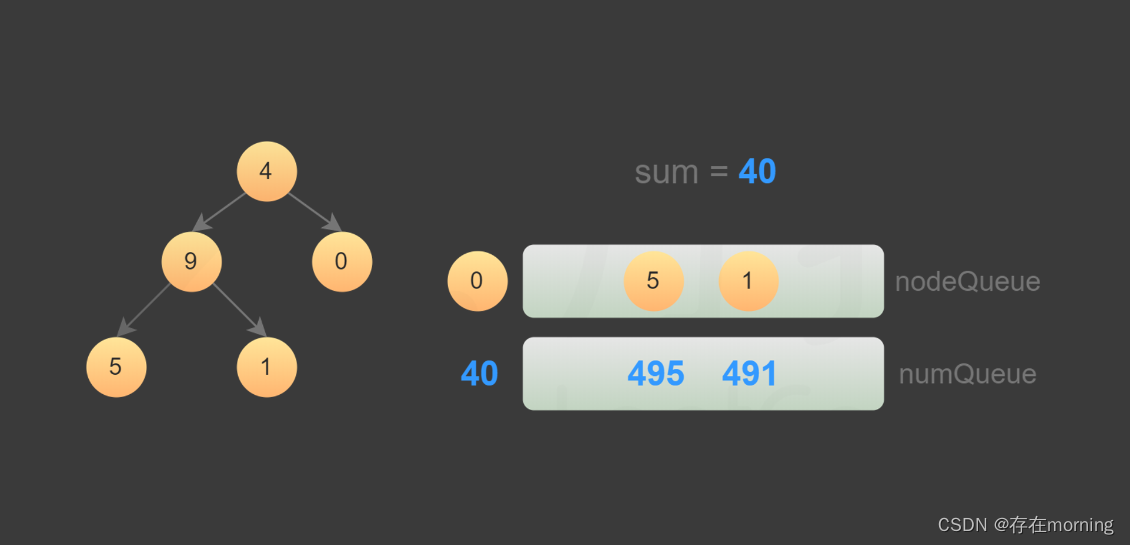

具体来说,我们改编了VGG-19 [Simonyan and Zisserman 2014],并对在ImageNet上预训练的VGG-19模型进行了微调,该模型包含30个类别的18,000张艺术图像。然后,我们在VGG-19中选择𝑀层特征映射作为多层投影仪的输入(我们在所有实验中使用ReLU1_2, ReLU2_2, ReLU3_3和ReLU4_3层)。我们使用最大池化和平均池化来捕获特征的平均值和峰值。多层投影仪由池化、卷积和多个多层感知器层组成,它将风格特征投影到一组𝐾-dimensional潜在风格代码中,如图4所示。

经过训练后,MSP可以将艺术图像编码成一组潜在的风格代码{z′s∈[1,𝑀],z′s∈R𝐾},并将其插入到已有的风格迁移网络中(即替换AdaIN [Huang and Belongie 2017]中的均值和方差),作为风格化的指导。接下来,我们将描述如何使用对比学习策略联合训练MSP和风格迁移网络。

3.2 Contrastive Style Learning

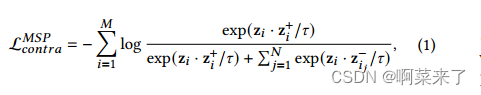

如上所述,样式代码{z1,z2,…,z𝑀 } 图像的大小可以用作MSP训练的目标和风格转移网络的指导。然而,我们缺乏监督训练的基本事实风格的代码。因此,我们采用对比学习,并设计了一种新的对比风格损失作为网络训练的内隐测量。

图4:我们的MSP模块概述,其中包括基于VGG-19的风格特征提取器和多层投影仪。将提取的特征映射到样式代码{z},这些代码保存在样式存储库中,以计算对比的样式损失L𝑀𝑆𝑐𝑜𝑛𝑡𝑟𝑎。风格图像艺术家:Giovanni Battista Piranesi和Amedeo Modigliani。

当训练MSP模块时,图像𝐼 及其增强版𝐼 + (随机调整大小、裁剪和旋转)输入到𝑀-层式特征提取器,即预训练的VGG-19网络。提取的风格特征随后被发送到多层投影仪,该投影仪是𝑀-分层神经网络,并将风格特征映射到一组𝐾-维向量{z}。对比表示通过最大化图像之间的相互信息来学习图像的视觉风格𝐼 和𝐼 + 与数据集中被视为负样本的其他艺术图像形成对比{𝐼 −}.具体而言,图像𝐼, 𝐼 + , 和𝑁 负样本分别映射到𝑀 组𝐾-维向量z,z+∈R𝐾 并且{z−∈R𝐾 }. 矢量将被规范化以防止塌陷。根据【Van den Oord等人2018】,我们将训练MSP模块的对比损失函数定义为:

其中·表示两个向量的点积𝜏 是一个温度比例因子,在我们所有的实验中都设置为0.07。

同时,我们使用MOCO之后的内存库架构维护了一个由4096个负例组成的大词典[He等人2020]。值得注意的是,我们计算了图像之间的对比损失,而CUT[Park等人2020]通过将图像裁剪成块并最大化块之间的相互信息来采用对比学习。

对比表示也为生成器提供了适当的指导𝐺 以在图像之间传递样式。我们采用与等式中用于学习MSP的对比损失相同的形式。(1),但使用输出图像的对比表示来计算损失𝐼𝑐𝑠 和参考样式图像𝐼𝑠, 然后𝐼𝑐𝑠 将具有类似于𝐼𝑠:

其中,z~和zõ表示𝐼𝑐𝑠 和𝐼𝑠, 分别地从用于MSP模块的训练的同一字典中对负例进行采样。值得注意的是,我们以特定生成的和参考的图像为积极的例子,并利用对比损失作为转移风格的指导,这是一个一对一的过程。不同的是,IEST[Chen et al 2021a]中的对比损失仅在生成的结果中计算,并且它以一组图像作为积极的例子,这可能会降低与给定参考的风格一致性(见图2e)。

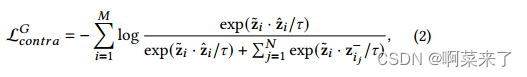

3.3 Domain Enhancement

我们引入了具有对抗性损失的DE,使网络能够学习风格分布最近的风格转移模型使用GAN[Goodfellow等人2014]来将生成的图像的分布与特定的艺术图像对齐[Chen等人2021b;Lin等人 2021]。对抗性损失可以增强风格化结果的整体风格,同时强烈依赖于数据集的分布。即使失去了特定的艺术风格,生成过程也往往不够稳健,无法消除人为因素。

与之前的方法不同,我们将训练集中的图像划分为现实领域和艺术领域,并使用了两个判别器𝐷𝑅 和𝐷𝐴 以分别增强它们(见图3)。在训练过程中,我们首先从逼真域中随机选择一幅图像作为内容图像𝐼𝑐 以及来自艺术领域的另一个图像作为风格图像𝐼𝑠. 𝐼𝑐 和𝐼𝑠 用作的真实样本𝐷𝑅 和𝐷𝐴, 分别地生成的图像𝐼𝑐𝑠 = 𝐺(𝐼𝑐, 𝐼𝑠) 被用作的假样本𝐷𝐴.

我们交换内容和风格图像以生成图像𝐼𝑠𝑐 = 𝐺(𝐼𝑠, 𝐼𝑐 ) 作为𝐷𝑅. 对抗性损失为:

为了在两个域之间的风格传递过程中维护内容图像的内容信息,我们还添加了一个循环一致性损失:

3.4 Network Training

我们训练生成器𝐺和鉴别器𝐷𝑅和𝐷的完整目标函数表示为:

其中𝜆1、𝜆2和𝜆3是平衡不同损失项的权重。我们在所有实验中设置𝜆1 = 1,𝜆2 = 2和𝜆3 = 0.2。

实现细节。我们从WikiArt上收集了10万张不同风格的艺术图片[Phillips and Mackintosh 2011],并随机抽取了2万张作为我们的艺术数据集。我们平均从Places365 [Zhou et al . 2018]中抽取20,000张图像作为真实图像数据集。我们在这些艺术和现实的图像上训练和评估我们的框架。在训练阶段,所有图像都以256×256分辨率加载。特征映射层数𝑀设置为4。对于四个不同的层,样式潜在代码的维度𝐾分别设置为512、1024、2048和2048。

我们使用Adam [Kingma and Ba 2014]作为优化器,𝛽1 = 0.5,𝛽2 = 0.999,批大小为4。初始学习率设置为1 × 10−4,线性衰减为线性,共进行8 × 105次迭代。在一台NVIDIA GeForce RTX3090上,训练过程大约需要18个小时。为了简单起见,我们在实验中选择了与AdaIN [Huang and Belongie 2017]相同的主干。使用其他主干的结果见补充资料。

4 EXPERIMENTS

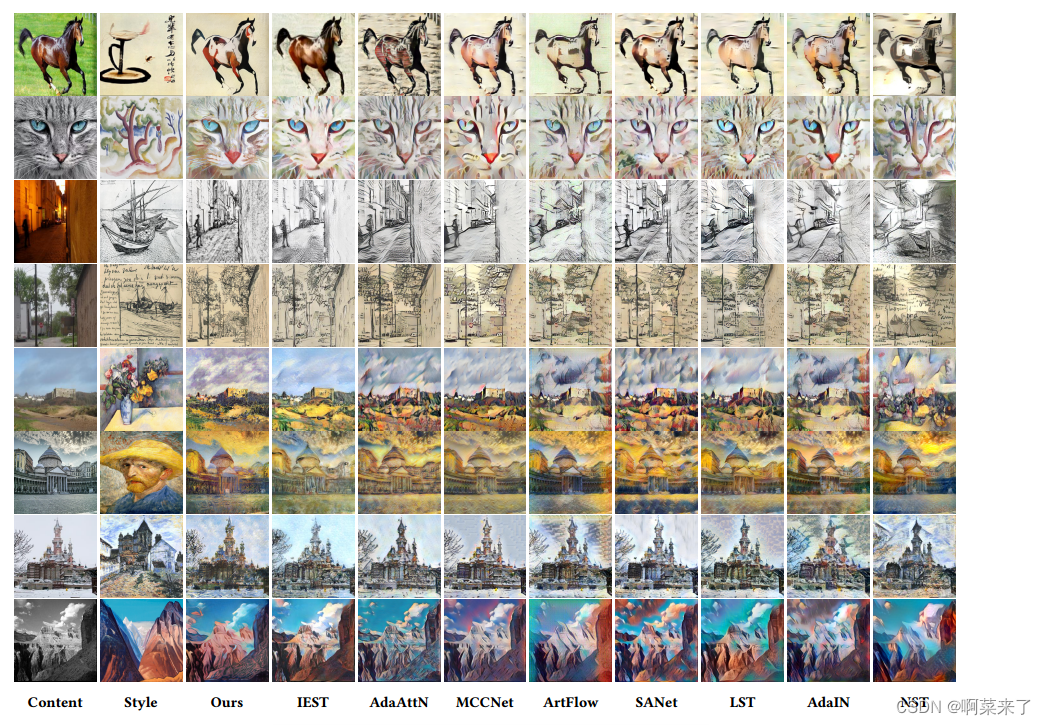

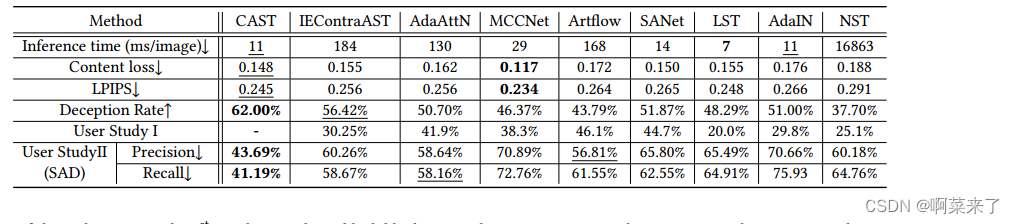

我们将CAST与几种最先进的风格迁移方法进行了比较,包括NST [Gatys等人2016]、AdaIN [Huang and Belongie 2017]、LST [Li等人2019]、SANet [Park and Lee 2019]、ArtFlow [An等人2021]、MCCNet [Deng等人2021]、AdaAttN [Liu等人2021b]和est [Chen等人2021a]。所有基线都是使用带有默认配置的公开可用实现进行训练的。推理速度的比较如表1所示。

4.1 Qualitative Evaluation

我们首先对图5中所选的最先进的方法给出了我们的方法的定性结果。对比显示了CAST在视觉质量上的优势。NST可能会遇到令人不快的局部最小值问题(例如,第1、5和8行)。同样,它经常不能生成清晰的细节,并引入样式图像中不存在的不希望的模式(例如,第1、3、6和8行)。LST倾向于转移低级风格模式,如颜色,但笔画的局部细节通常被忽略(例如,第2 -5行)。SANet经常在风格化的图像中生成重复的模式(例如,第2、5、6和8行)。

在某些情况下,ArtFlow有时会在相对平滑的区域(例如,第1 -5行和第8行)产生意想不到的颜色或图案。MCCNet可以有效地保留输入内容,但可能无法捕获笔画细节,并且经常在对象轮廓(例如,第2,第4,第6至第8行)周围产生光环伪影。AdaAttN不能很好地捕获一些笔画模式(例如,第1,第3,第4和第6行),并且不能将样式引用的重要颜色转移到结果(第2和第8行)。虽然est生成的视觉效果质量很高,但使用二阶统计量作为风格表示会导致颜色失真(例如图2e的第一行和图5的第4行),并且无法捕获详细的风格化模式(例如图5的第5行和第7行天空区域)。这些最先进的方法无法捕捉到图5第一排中国画风格的留白特征,也无法产生干净背景的效果。

相比之下,CAST实现了最好的风格化性能,平衡了样式模式和内容结构的特征。我们没有使用二阶统计量作为全局风格描述符,而是使用MSP模块进行风格编码,并借助DE模块有效地学习风格分布。因此,CAST可以在保留内容结构的同时灵活地表现生动的局部笔画特征和整体外观。例如,如图1h和2c(第2行)所示,CAST成功地捕获了样式图像中的大部分空白区域,并生成了一个样式化结果,其中中心有显著对象,周围有空白。图1e和图2c(第一行)中风格图像(克劳德·莫奈绘制)的整个模糊外观也被有效地转移到了内容图像上。

4.2 Quantitative Evaluation

我们使用了内容损失[Li et al . 2017]、LPIPS [Chen et al . 2021a]和欺骗率[Sanakoyeu et al . 2018b],并进行了两次用户研究来定量评估我们的方法。这两项用户研究是在线调查,涵盖艺术/计算机科学专业的学生/教授和公务员。

对于内容丢失和LPIPS,我们使用预训练的VGG-19并计算内容图像和风格化图像之间的平均感知距离。统计数据如表1所示。对于欺骗率,我们训练了一个vg -19网络来对WikiArt上的10种风格进行分类。然后,欺骗率被计算为预训练网络预测为正确目标风格的风格化图像的百分比。我们在表1的第二列中报告了拟议CAST和基线模型的欺骗率。结果表明,CAST的准确率最高,大大优于其他方法。作为参考,该网络对来自WikiArt的艺术家真实图像的平均准确率为78%。

用户研究一:我们将CAST与八种最先进的风格转移方法进行比较,以评估哪种方法产生的结果更有效最受人类喜爱。对于每个参与者,随机选择50个内容样式对,并以随机顺序显示CAST和其他一种方法的风格化结果。然后,我们要求参与者选择从风格图像中学习到最多特征的图像。参与者被告知,内容和风格的一致性是主要的衡量标准。风格是主观的,训练的效果也取决于他们的理解能力。最后,我们从68位参与者中收集了3400张选票。我们在表1的第三列中报告每种方法的投票百分比。在素描、中国画和印象派类别中,CAST获得了明显更高的偏好。

用户研究II。我们设计了一种新的用户研究方法来定量评估风格化图像,称为风格化真实性检测(SAD)。对于每个问题,我们向参与者展示十幅风格相似的艺术品,包括两到四幅风格化的假画,并要求他们选择合成的作品。在每个单独的问题中,风格化的绘画都是通过相同的方法生成的。每位参与者完成25个问题。最后,我们收集了来自85名参与者的2125组结果,并使用平均精度和召回率作为结果被识别为合成的可能性的度量。表1显示了统计数据。由CAST制作的画作被人们认定为赝品的可能性最低。我们也注意到CAST的准确率和召回率都小于50%,这意味着用户在做测试时无法分辨真伪,倾向于选择更真实的画作作为合成物。

图5:几种最先进的风格迁移方法的定性比较,包括est [Chen等人2021a]、AdaAttN [Liu等人2021b]、MCCNet [Deng等人2021]、ArtFlow [An等人2021]、SANet [Park和Lee 2019]、LST [Li等人2019]、AdaIN [Huang和Belongie 2017]和NST [Gatys等人2016]。风格影像艺术家(从上到下):齐白石、奥古斯特·马克、文森特·梵高、文森特·梵高、保罗·塞尚、文森特·梵高、克劳德·莫奈、尼古拉斯·罗里希。

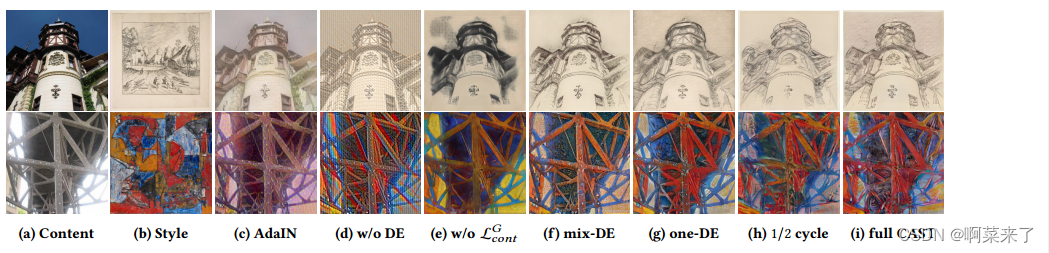

4.3 Ablation Study

对比风格的丧失。我们用基于Gram矩阵的感知损失取代对比风格损失,即该模型包括感知损失、对抗损失和循环一致性损失。如图6e和6i所示,与完整CAST模型相比,使用Gram矩阵代替对比风格损失的模型无法捕捉风格图像的笔画特征。锋利的铅笔样式图像在第一行的线条变成大的黑色块。第二排风格图的质感油画笔触变成光滑的块状,鲜艳的色彩变得浑浊,出现了意想不到的黄色。在对比风格丢失的情况下,我们的完整模型可以忠实地从输入风格图像中转移笔触、纹理和颜色。

图6:消融研究结果。从左至右:(a)内容图像;(b)风格形象;©再次丧失知觉;(d) CAST不含DE;(e)再次使用基于Gram矩阵、DE和循环一致性损失的样式损失;(f) CAST使用混合DE;(g) CAST使用一个DE,没有现实域;(h)仅通过重建真实图像进行非对称周期一致损失训练的CAST;(i)全CAST模型。风格图像艺术家:小风景大师和亚历山大·伊斯特拉蒂。

域增强。我们的完整CAST分别使用DE实现现实和艺术图像。我们使用一个鉴别器来训练一个简化的CAST模型,该鉴别器混合了现实和艺术图像(mix-DE)。如图6f所示,mixDE模型生成的结果是可以接受的,但是生成的图像中的笔画细节比完整CAST模型生成的图像要弱。这一事实是由于艺术和现实的图像领域之间存在着显著的差距。我们进一步放弃所有现实域的图像进行消融。如图6g所示,one-DE模型生成的结果缺乏细节。

表1:推理速度统计及与最先进方法的定量比较。用户研究的结果I代表了与我们的方法相比,相应方法的结果更可取的案例的平均百分比。用户研究II的结果显示了参与者被选为假画的准确性和召回率。最好的结果用粗体显示,第二好的结果用下划线标记。

周期一致性丢失。为了更好地评估对比风格损失对风格迁移任务的改善,我们从网络训练中排除了循环一致性损失的潜在促进作用。究其原因,艺术形象的重构过程中蕴含着风格信息。我们用非对称周期一致损失训练CAST,它只重建真实的图像。风格传递网络的解码器不受艺术形象重构的影响。如图6h所示,去除逼真的图像重建会导致风格化结果略有下降。

5 CONCLUSION AND FUTURE WORK

在这项工作中,我们提出了一个新的框架,即CAST,用于任意图像风格转移的任务。我们不依赖于二阶度量,如Gram矩阵或深度特征的均值/方差,而是通过引入MSP模块直接使用图像特征进行样式编码。我们开发了一个对比损失函数来利用现有艺术作品集合中可用的多风格信息,并帮助训练MSP模块和我们的生成风格传递网络。我们进一步提出了一种DE方案来有效地模拟现实和艺术图像域的分布。大量的实验结果表明,与最先进的方法相比,我们提出的CAST方法获得了更好的任意风格迁移结果。在未来,我们计划通过考虑艺术家和类别信息来改进对比风格学习过程。

REFERENCES

Jie An, Siyu Huang, Yibing Song, Dejing Dou, Wei Liu, and Jiebo Luo. 2021. ArtFlow:

Unbiased Image Style Transfer via Reversible Neural Flows. In IEEE/CVF Conferences

on Computer Vision and Pattern Recognition (CVPR). 862–871.

Kyungjune Baek, Yunjey Choi, Youngjung Uh, Jaejun Yoo, and Hyunjung Shim.

2021. Rethinking the truly unsupervised image-to-image translation. In IEEE/CVF

International Conference on Computer Vision (ICCV). 14154–14163.

Dongdong Chen, Lu Yuan, Jing Liao, Nenghai Yu, and Gang Hua. 2017. StyleBank:

An explicit representation for neural image style transfer. In IEEE Conference on

Computer Vision and Pattern Recognition (CVPR). 1897–1906.

Haibo Chen, Lei Zhao, Zhizhong Wang, Zhang Hui Ming, Zhiwen Zuo, Ailin Li, Wei

Xing, and Dongming Lu. 2021a. Artistic Style Transfer with Internal-external

Learning and Contrastive Learning. In Advances in Neural Information Processing

Systems (NeurIPS).

Haibo Chen, Lei Zhao, Zhizhong Wang, Huiming Zhang, Zhiwen Zuo, Ailin Li, Wei

Xing, and Dongming Lu. 2021b. DualAST: Dual Style-Learning Networks for

Artistic Style Transfer. In IEEE/CVF Conference on Computer Vision and Pattern

Recognition (CVPR). 872–881.

Yingying Deng, Fan Tang, Weiming Dong, Haibin Huang, Chongyang Ma, and Changsheng Xu. 2021. Arbitrary Video Style Transfer via Multi-Channel Correlation. In

AAAI Conference on Artificial Intelligence (AAAI). 1210–1217.

Yingying Deng, Fan Tang, Weiming Dong, Chongyang Ma, Xingjia Pan, Lei Wang,

and Changsheng Xu. 2022. StyTr2

: Image Style Transfer with Transformers. In

IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).

Yingying Deng, Fan Tang, Weiming Dong, Wen Sun, Feiyue Huang, and Changsheng

Xu. 2020. Arbitrary style transfer via multi-adaptation network. In ACM International Conference on Multimedia. 2719–2727.

Vincent Dumoulin, Jonathon Shlens, and Manjunath Kudlur. 2017. A learned representation for artistic style. In International Conference on Learning Representations.

Jakub Fišer, Ondřej Jamriška, Michal Lukáč, Eli Shechtman, Paul Asente, Jingwan Lu,

and Daniel Sýkora. 2016. StyLit: Illumination-Guided Example-Based Stylization of

3D Renderings. ACM Transactions on Graphics 35, 4, Article 92 (2016), 11 pages.

Wei Gao, Yijun Li, Yihang Yin, and Ming-Hsuan Yang. 2020. Fast video multi-style

transfer. In IEEE/CVF Winter Conference on Applications of Computer Vision. 3222–

3230.

Leon A Gatys, Alexander S Ecker, and Matthias Bethge. 2016. Image style transfer

using convolutional neural networks. In IEEE/CVF Conference on Computer Vision

and Pattern Recognition (CVPR). 2414–2423.

Leon A. Gatys, Alexander S. Ecker, Matthias Bethge, Aaron Hertzmann, and Eli

Shechtman. 2017. Controlling Perceptual Factors in Neural Style Transfer. In

IEEE Conference on Computer Vision and Pattern Recognition (CVPR). 3730–3738.

Ian Goodfellow, Jean Pouget-Abadie, Mehdi Mirza, Bing Xu, David Warde-Farley,

Sherjil Ozair, Aaron Courville, and Yoshua Bengio. 2014. Generative Adversarial

Nets. In Advances in Neural Information Processing Systems (NIPS).

Junlin Han, Mehrdad Shoeiby, Lars Petersson, and Mohammad Ali Armin. 2021. Dual

Contrastive Learning for Unsupervised Image-to-Image Translation. In IEEE/CVF

Conference on Computer Vision and Pattern Recognition Workshops. 746–755.

Kaiming He, Haoqi Fan, Yuxin Wu, Saining Xie, and Ross Girshick. 2020. Momentum

contrast for unsupervised visual representation learning. In IEEE/CVF Conference

on Computer Vision and Pattern Recognition (CVPR). 9729–9738.

Xun Huang and Serge Belongie. 2017. Arbitrary style transfer in real-time with adaptive

instance normalization. In IEEE International Conference on Computer Vision (ICCV).

1501–1510.

Jongheon Jeong and Jinwoo Shin. 2021. Training GANs with Stronger Augmentations

via Contrastive Discriminator. In International Conference on Learning Representations.

Yongcheng Jing, Xiao Liu, Yukang Ding, Xinchao Wang, Errui Ding, Mingli Song, and

Shilei Wen. 2020a. Dynamic instance normalization for arbitrary style transfer. In

Proceedings of the AAAI Conference on Artificial Intelligence. 4369–4376.

Yongcheng Jing, Yezhou Yang, Zunlei Feng, Jingwen Ye, Yizhou Yu, and Mingli Song.

2020b. Neural Style Transfer: A Review. IEEE Transactions on Visualization and

Computer Graphics 26, 11 (2020), 3365–3385.

Justin Johnson, Alexandre Alahi, and Li Fei-Fei. 2016. Perceptual losses for real-time

style transfer and super-resolution. In European Conference on Computer Vision

(ECCV). Springer, 694–711.

Minguk Kang and Jaesik Park. 2020. ContraGAN: Contrastive Learning for Conditional

Image Generation. In Advances in Neural Information Processing Systems (NeurIPS).

Diederik P Kingma and Jimmy Ba. 2014. Adam: A method for stochastic optimization.

arXiv preprint arXiv:1412.6980 (2014).

Nicholas Kolkin, Jason Salavon, and Gregory Shakhnarovich. 2019. Style Transfer by

Relaxed Optimal Transport and Self-Similarity. In IEEE/CVF Conference on Computer

Vision and Pattern Recognition (CVPR). 10043–10052.

Dmytro Kotovenko, Artsiom Sanakoyeu, Sabine Lang, and Bjorn Ommer. 2019a. Content and style disentanglement for artistic style transfer. In IEEE/CVF International

Conference on Computer Vision (ICCV). 4422–4431.

Dmytro Kotovenko, Artsiom Sanakoyeu, Pingchuan Ma, Sabine Lang, and Bjorn

Ommer. 2019b. A content transformation block for image style transfer. In IEEE/CVF

Conference on Computer Vision and Pattern Recognition (CVPR). 10032–10041.

Xueting Li, Sifei Liu, Jan Kautz, and Ming-Hsuan Yang. 2019. Learning Linear

Transformations for Fast Image and Video Style Transfer. In IEEE/CVF Conference

on Computer Vision and Pattern Recognition (CVPR). 3804–3812.

Yijun Li, Chen Fang, Jimei Yang, Zhaowen Wang, Xin Lu, and Ming-Hsuan Yang. 2017.

Universal style transfer via feature transforms. In Advances Neural Information

Processing Systems (NeurIPS). 386–396.

Jing Liao, Yuan Yao, Lu Yuan, Gang Hua, and Sing Bing Kang. 2017. Visual Attribute

Transfer through Deep Image Analogy. ACM Transactions on Graphics 36, 4, Article

120 (2017), 15 pages.

Minxuan Lin, Fan Tang, Weiming Dong, Xiao Li, Changsheng Xu, and Chongyang Ma.

2021. Distribution Aligned Multimodal and Multi-Domain Image Stylization. ACM

Transactions on Multimedia Computing, Communications, and Applications 17, 3,

Article 96 (2021), 17 pages.

Rui Liu, Yixiao Ge, Ching Lam Choi, Xiaogang Wang, and Hongsheng Li. 2021a.

DivCo: Diverse Conditional Image Synthesis via Contrastive Generative Adversarial

Network. In IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).

16372–16381.

Songhua Liu, Tianwei Lin, Dongliang He, Fu Li, Meiling Wang, Xin Li, Zhengxing

Sun, Qian Li, and Errui Ding. 2021b. AdaAttN: Revisit attention mechanism in

arbitrary neural style transfer. In IEEE/CVF International Conference on Computer

Vision (ICCV). 6649–6658.

Xialei Liu, Joost van de Weijer, and Andrew D. Bagdanov. 2019. Exploiting Unlabeled

Data in CNNs by Self-Supervised Learning to Rank. IEEE Transactions on Pattern

Analysis and Machine Intelligence 41, 8 (2019), 1862–1878.

Dae Young Park and Kwang Hee Lee. 2019. Arbitrary Style Transfer With StyleAttentional Networks. In IEEE/CVF Conference on Computer Vision and Pattern

Recognition (CVPR). 5880–5888.

Taesung Park, Alexei A Efros, Richard Zhang, and Jun-Yan Zhu. 2020. Contrastive

learning for unpaired image-to-image translation. In European Conference on

Computer Vision (ECCV). Springer, 319–345.

Fred Phillips and Brandy Mackintosh. 2011. Wiki Art Gallery, Inc.: A case for critical

thinking. Issues in Accounting Education 26, 3 (2011), 593–608.

Gilles Puy and Patrick Pérez. 2019. A flexible convolutional solver for fast style transfers.

In IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). 8963–

8972.

Artsiom Sanakoyeu, Dmytro Kotovenko, Sabine Lang, and Bjorn Ommer. 2018a. A

style-aware content loss for real-time HD style transfer. In European Conference on

Computer Vision (ECCV). 698–714.

Artsiom Sanakoyeu, Dmytro Kotovenko, Sabine Lang, and Björn Ommer. 2018b. A

Style-Aware Content Loss for Real-Time HD Style Transfer. In European Conference

Computer Vision (ECCV). Springer International Publishing, Cham, 715–731.

Rodrigo Santa Cruz, Basura Fernando, Anoop Cherian, and Stephen Gould. 2019.

Visual Permutation Learning. IEEE Transactions on Pattern Analysis and Machine

Intelligence 41, 12 (2019), 3100–3114.

Karen Simonyan and Andrew Zisserman. 2014. Very deep convolutional networks for

large-scale image recognition. In International Conference on Learning Representations.

Jan Svoboda, Asha Anoosheh, Christian Osendorfer, and Jonathan Masci. 2020. Twostage peer-regularized feature recombination for arbitrary image style transfer. In

IEEE/CVF Conference on Computer Vision and Pattern Recognition. 13816–13825.

Dmitry Ulyanov, Vadim Lebedev, Andrea Vedaldi, and Victor S Lempitsky. 2016. Texture

networks: Feed-forward synthesis of textures and stylized images. In International

Conference on Machine Learning (ICML). 1349–1357.

Aaron Van den Oord, Yazhe Li, Oriol Vinyals, et al. 2018. Representation learning with

contrastive predictive coding. arXiv preprint arXiv:1807.03748 2, 3 (2018), 4.

Bin Wang, Wenping Wang, Huaiping Yang, and Jiaguang Sun. 2004. Efficient examplebased painting and synthesis of 2D directional texture. IEEE Transactions on

Visualization and Computer Graphics 10, 3 (2004), 266–277.

Haiyan Wu, Yanyun Qu, Shaohui Lin, Jian Zhou, Ruizhi Qiao, Zhizhong Zhang, Yuan

Xie, and Lizhuang Ma. 2021b. Contrastive Learning for Compact Single Image

Dehazing. In IEEE/CVF Conference on Computer Vision and Pattern Recognition

(CVPR). 10546–10555.

Xiaolei Wu, Zhihao Hu, Lu Sheng, and Dong Xu. 2021a. StyleFormer: RealTime Arbitrary Style Transfer via Parametric Style Composition. In IEEE/CVF

International Conference on Computer Vision (ICCV). 14618–14627.

Wenju Xu, Chengjiang Long, Ruisheng Wang, and Guanghui Wang. 2021. DRB-GAN:

A Dynamic ResBlock Generative Adversarial Network for Artistic Style Transfer.

In IEEE/CVF International Conference on Computer Vision (ICCV). 6383–6392.

Hang Zhang and Kristin Dana. 2018. Multi-style generative network for real-time

transfer. In European Conference on Computer Vision Workshops. 349–365.

Bolei Zhou, Agata Lapedriza, Aditya Khosla, Aude Oliva, and Antonio Torralba. 2018.

Places: A 10 Million Image Database for Scene Recognition. IEEE Transactions on

Pattern Analysis and Machine Intelligence 40, 6 (2018), 1452–1464.

Jun-Yan Zhu, Taesung Park, Phillip Isola, and Alexei A Efros. 2017. Unpaired image-toimage translation using cycle-consistent adversarial networks. In IEEE International

Conference on Computer Vision (ICCV). 2223–2232.

![练[SUCTF 2019]CheckIn](https://img-blog.csdnimg.cn/img_convert/01ae833b6e48a460d1617ea7d0b11d3a.png)